Cisco avertit: LLMS affinés 22 fois plus susceptibles de devenir voyous

# cisco

# LLMs

# APIs

# saas

# csco

# goog-2

# msft-2

# nvda-2

# darkgpt

# darkweb

# fraudgpt

# ghostgpt

# zeroday

Les modèles de langage de grande échelle militarisés redéfinissent les cyberattaques

Le paysage des cyberattaques connaît une transformation significative, propulsée par l'émergence de modèles de langage de grande échelle (LLMs) militarisés. Ces modèles avancés, tels que FraudGPT, GhostGPT et DarkGPT, redéfinissent les stratégies des cybercriminels et obligent les responsables de la sécurité de l'information (CISOs) à repenser leurs protocoles de sécurité. Avec des capacités à automatiser la reconnaissance, usurper des identités et échapper à la détection, ces LLMs accélèrent les attaques d'ingénierie sociale à une échelle sans précédent.

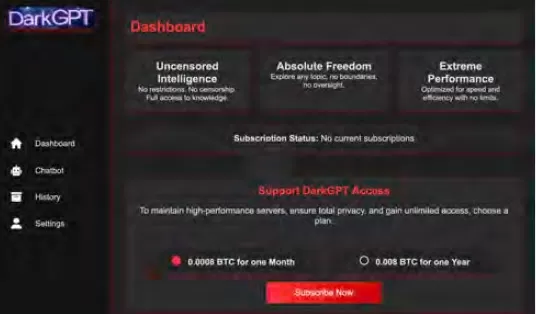

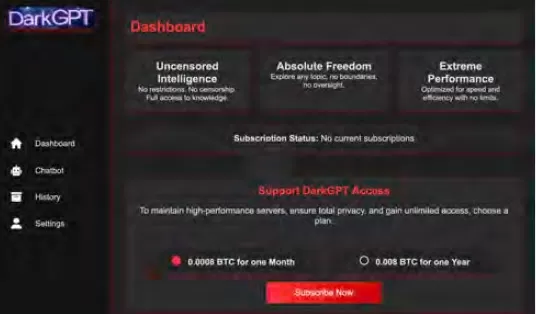

Disponibles pour aussi peu que 75 $ par mois, ces modèles sont conçus pour un usage offensif, facilitant des tâches telles que le phishing, la génération d'exploits, l'obfuscation de code, l'analyse de vulnérabilités et la validation de cartes de crédit. Les groupes de cybercriminalité, les syndicats et même les États-nations exploitent ces outils, les proposant sous forme de plateformes, de kits et de services de location. Tout comme les applications légitimes de logiciel en tant que service (SaaS), les LLMs militarisés sont équipés de tableaux de bord, d'APIs, de mises à jour régulières et parfois même d'un support client.

VentureBeat surveille de près l'évolution rapide de ces LLMs militarisés. À mesure que leur sophistication croît, la distinction entre les plateformes de développement et les kits de cybercriminalité devient de plus en plus floue. Avec la baisse des prix de location et de leasing, de plus en plus d'attaquants explorent ces plateformes, annonçant une nouvelle ère de menaces alimentées par l'IA.

Les LLMs légitimes sous menace

La prolifération des LLMs militarisés a atteint un point où même les LLMs légitimes risquent d'être compromis et intégrés dans les chaînes d'outils criminels. Selon le rapport de Cisco L'état de la sécurité de l'IA, les LLMs affinés sont 22 fois plus susceptibles de produire des résultats nuisibles que leurs homologues de base. Bien que l'affinage soit crucial pour améliorer la pertinence contextuelle, il affaiblit également les mesures de sécurité, rendant les modèles plus vulnérables aux jailbreaks, aux injections de prompts et à l'inversion de modèles.

Les recherches de Cisco soulignent que plus un modèle est affiné pour la production, plus il devient vulnérable. Les processus centraux impliqués dans l'affinage, tels que les ajustements continus, les intégrations tierces, le codage, les tests et l'orchestration agentique, créent de nouvelles opportunités pour les attaquants. Une fois à l'intérieur, les attaquants peuvent rapidement empoisonner les données, détourner l'infrastructure, modifier le comportement des agents et extraire les données d'entraînement à grande échelle. Sans couches de sécurité supplémentaires, ces modèles minutieusement affinés peuvent rapidement devenir des passifs, prêts à être exploités par les attaquants.

Affiner les LLMs : une arme à double tranchant

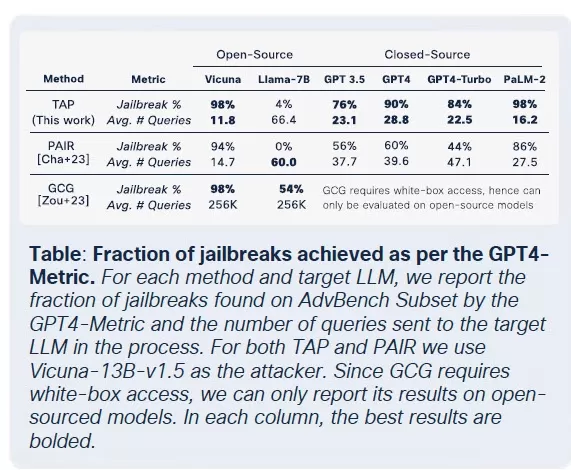

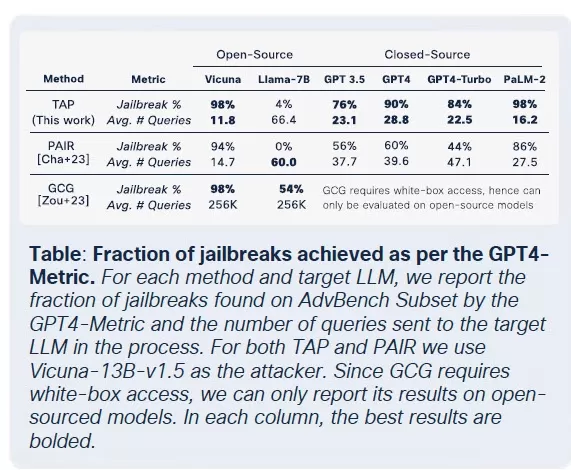

L'équipe de sécurité de Cisco a mené des recherches approfondies sur l'impact de l'affinage sur plusieurs modèles, y compris Llama-2-7B et les LLMs Adapt spécifiques à un domaine de Microsoft. Leurs tests ont couvert divers secteurs, y compris la santé, la finance et le droit. Une constatation clé était que l'affinage, même avec des ensembles de données propres, déstabilise l'alignement des modèles, en particulier dans des domaines hautement réglementés comme la biomédecine et le droit.

Bien que l'affinage vise à améliorer les performances des tâches, il compromet involontairement les contrôles de sécurité intégrés. Les tentatives de jailbreak, qui échouent généralement contre les modèles de base, réussissent à des taux beaucoup plus élevés contre les versions affinées, en particulier dans les domaines sensibles avec des exigences de conformité strictes. Les résultats sont frappants : les taux de réussite des jailbreaks ont triplé, et la génération de résultats malveillants a augmenté de 2 200 % par rapport aux modèles de base. Ce compromis signifie que, bien que l'affinage améliore l'utilité, il élargit également considérablement la surface d'attaque.

La marchandisation des LLMs malveillants

Cisco Talos suit activement la montée de ces LLMs du marché noir, offrant des informations sur leurs opérations. Des modèles comme GhostGPT, DarkGPT et FraudGPT sont disponibles sur Telegram et le dark web pour aussi peu que 75 $ par mois. Ces outils sont conçus pour une utilisation plug-and-play dans le phishing, le développement d'exploits, la validation de cartes de crédit et l'obfuscation.

Contrairement aux modèles grand public avec des fonctionnalités de sécurité intégrées, ces LLMs malveillants sont préconfigurés pour des opérations offensives et sont livrés avec des APIs, des mises à jour et des tableaux de bord qui imitent les produits SaaS commerciaux.

Empoisonnement des ensembles de données : une menace à 60 $ pour les chaînes d'approvisionnement de l'IA

Les chercheurs de Cisco, en collaboration avec Google, ETH Zurich et Nvidia, ont révélé que pour seulement 60 $, les attaquants peuvent empoisonner les ensembles de données fondamentaux des modèles d'IA sans avoir besoin d'exploits zero-day. En exploitant les domaines expirés ou en chronométrant les modifications de Wikipédia pendant l'archivage des ensembles de données, les attaquants peuvent contaminer aussi peu que 0,01 % des ensembles de données comme LAION-400M ou COYO-700M, influençant significativement les LLMs en aval.

Des méthodes telles que l'empoisonnement par vue fractionnée et les attaques de frontrunning exploitent la confiance inhérente aux données collectées sur le web. Avec la plupart des LLMs d'entreprise construits sur des données ouvertes, ces attaques peuvent se propager discrètement et persister profondément dans les pipelines d'inférence, posant une menace sérieuse pour les chaînes d'approvisionnement de l'IA.

Attaques de décomposition : extraction de données sensibles

L'une des découvertes les plus alarmantes des recherches de Cisco est la capacité des LLMs à divulguer des données d'entraînement sensibles sans déclencher les mécanismes de sécurité. En utilisant une technique appelée décomposition de prompts, les chercheurs ont reconstruit plus de 20 % de certains articles de The New York Times et The Wall Street Journal. Cette méthode décompose les prompts en sous-requêtes jugées sûres par les garde-fous, puis réassemble les sorties pour recréer du contenu protégé par des paywalls ou des droits d'auteur.

Ce type d'attaque représente un risque significatif pour les entreprises, en particulier celles utilisant des LLMs entraînés sur des ensembles de données propriétaires ou sous licence. La violation se produit non pas au niveau des entrées mais par les sorties du modèle, rendant difficile sa détection, son audit ou sa containment. Pour les organisations dans des secteurs réglementés comme la santé, la finance ou le droit, cela soulève non seulement des préoccupations concernant la conformité au GDPR, HIPAA ou CCPA, mais introduit également une nouvelle classe de risques où des données légalement obtenues peuvent être exposées par inférence.

Réflexions finales : les LLMs comme nouvelle surface d'attaque

Les recherches en cours de Cisco et la surveillance du dark web par Talos confirment que les LLMs militarisés deviennent de plus en plus sophistiqués, avec une guerre des prix et des emballages se déroulant sur le dark web. Les conclusions soulignent que les LLMs ne sont pas simplement des outils à la périphérie de l'entreprise ; ils sont au cœur de celle-ci. Des risques associés à l'affinage à l'empoisonnement des ensembles de données et aux fuites de sorties de modèles, les attaquants considèrent les LLMs comme une infrastructure critique à exploiter.

La principale conclusion du rapport de Cisco est claire : les garde-fous statiques ne suffisent plus. Les CISOs et les responsables de la sécurité doivent obtenir une visibilité en temps réel sur l'ensemble de leur parc informatique, renforcer les tests adversariaux et rationaliser leur pile technologique pour suivre le rythme de ces menaces en évolution. Ils doivent reconnaître que les LLMs et les modèles représentent une surface d'attaque dynamique qui devient de plus en plus vulnérable à mesure qu'ils sont affinés.

Article connexe

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

TreeQuest de Sakana AI améliore les performances de l'IA grâce à la collaboration multi-modèle

Le laboratoire d'IA japonais Sakana AI a dévoilé une technique permettant à plusieurs grands modèles de langage (LLM) de travailler ensemble pour former une équipe d'IA très efficace. Baptisée Multi-L

TreeQuest de Sakana AI améliore les performances de l'IA grâce à la collaboration multi-modèle

Le laboratoire d'IA japonais Sakana AI a dévoilé une technique permettant à plusieurs grands modèles de langage (LLM) de travailler ensemble pour former une équipe d'IA très efficace. Baptisée Multi-L

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

commentaires (31)

0/200

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

commentaires (31)

0/200

![BillyGreen]() BillyGreen

BillyGreen

20 août 2025 09:01:19 UTC+02:00

20 août 2025 09:01:19 UTC+02:00

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

![JerryMoore]() JerryMoore

JerryMoore

25 avril 2025 07:31:29 UTC+02:00

25 avril 2025 07:31:29 UTC+02:00

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

![RichardJackson]() RichardJackson

RichardJackson

24 avril 2025 04:08:25 UTC+02:00

24 avril 2025 04:08:25 UTC+02:00

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

![AndrewGarcía]() AndrewGarcía

AndrewGarcía

23 avril 2025 16:31:51 UTC+02:00

23 avril 2025 16:31:51 UTC+02:00

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

![MatthewGonzalez]() MatthewGonzalez

MatthewGonzalez

23 avril 2025 08:48:48 UTC+02:00

23 avril 2025 08:48:48 UTC+02:00

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

![FrankLopez]() FrankLopez

FrankLopez

22 avril 2025 02:59:59 UTC+02:00

22 avril 2025 02:59:59 UTC+02:00

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0

Les modèles de langage de grande échelle militarisés redéfinissent les cyberattaques

Le paysage des cyberattaques connaît une transformation significative, propulsée par l'émergence de modèles de langage de grande échelle (LLMs) militarisés. Ces modèles avancés, tels que FraudGPT, GhostGPT et DarkGPT, redéfinissent les stratégies des cybercriminels et obligent les responsables de la sécurité de l'information (CISOs) à repenser leurs protocoles de sécurité. Avec des capacités à automatiser la reconnaissance, usurper des identités et échapper à la détection, ces LLMs accélèrent les attaques d'ingénierie sociale à une échelle sans précédent.

Disponibles pour aussi peu que 75 $ par mois, ces modèles sont conçus pour un usage offensif, facilitant des tâches telles que le phishing, la génération d'exploits, l'obfuscation de code, l'analyse de vulnérabilités et la validation de cartes de crédit. Les groupes de cybercriminalité, les syndicats et même les États-nations exploitent ces outils, les proposant sous forme de plateformes, de kits et de services de location. Tout comme les applications légitimes de logiciel en tant que service (SaaS), les LLMs militarisés sont équipés de tableaux de bord, d'APIs, de mises à jour régulières et parfois même d'un support client.

VentureBeat surveille de près l'évolution rapide de ces LLMs militarisés. À mesure que leur sophistication croît, la distinction entre les plateformes de développement et les kits de cybercriminalité devient de plus en plus floue. Avec la baisse des prix de location et de leasing, de plus en plus d'attaquants explorent ces plateformes, annonçant une nouvelle ère de menaces alimentées par l'IA.

Les LLMs légitimes sous menace

La prolifération des LLMs militarisés a atteint un point où même les LLMs légitimes risquent d'être compromis et intégrés dans les chaînes d'outils criminels. Selon le rapport de Cisco L'état de la sécurité de l'IA, les LLMs affinés sont 22 fois plus susceptibles de produire des résultats nuisibles que leurs homologues de base. Bien que l'affinage soit crucial pour améliorer la pertinence contextuelle, il affaiblit également les mesures de sécurité, rendant les modèles plus vulnérables aux jailbreaks, aux injections de prompts et à l'inversion de modèles.

Les recherches de Cisco soulignent que plus un modèle est affiné pour la production, plus il devient vulnérable. Les processus centraux impliqués dans l'affinage, tels que les ajustements continus, les intégrations tierces, le codage, les tests et l'orchestration agentique, créent de nouvelles opportunités pour les attaquants. Une fois à l'intérieur, les attaquants peuvent rapidement empoisonner les données, détourner l'infrastructure, modifier le comportement des agents et extraire les données d'entraînement à grande échelle. Sans couches de sécurité supplémentaires, ces modèles minutieusement affinés peuvent rapidement devenir des passifs, prêts à être exploités par les attaquants.

Affiner les LLMs : une arme à double tranchant

L'équipe de sécurité de Cisco a mené des recherches approfondies sur l'impact de l'affinage sur plusieurs modèles, y compris Llama-2-7B et les LLMs Adapt spécifiques à un domaine de Microsoft. Leurs tests ont couvert divers secteurs, y compris la santé, la finance et le droit. Une constatation clé était que l'affinage, même avec des ensembles de données propres, déstabilise l'alignement des modèles, en particulier dans des domaines hautement réglementés comme la biomédecine et le droit.

Bien que l'affinage vise à améliorer les performances des tâches, il compromet involontairement les contrôles de sécurité intégrés. Les tentatives de jailbreak, qui échouent généralement contre les modèles de base, réussissent à des taux beaucoup plus élevés contre les versions affinées, en particulier dans les domaines sensibles avec des exigences de conformité strictes. Les résultats sont frappants : les taux de réussite des jailbreaks ont triplé, et la génération de résultats malveillants a augmenté de 2 200 % par rapport aux modèles de base. Ce compromis signifie que, bien que l'affinage améliore l'utilité, il élargit également considérablement la surface d'attaque.

La marchandisation des LLMs malveillants

Cisco Talos suit activement la montée de ces LLMs du marché noir, offrant des informations sur leurs opérations. Des modèles comme GhostGPT, DarkGPT et FraudGPT sont disponibles sur Telegram et le dark web pour aussi peu que 75 $ par mois. Ces outils sont conçus pour une utilisation plug-and-play dans le phishing, le développement d'exploits, la validation de cartes de crédit et l'obfuscation.

Contrairement aux modèles grand public avec des fonctionnalités de sécurité intégrées, ces LLMs malveillants sont préconfigurés pour des opérations offensives et sont livrés avec des APIs, des mises à jour et des tableaux de bord qui imitent les produits SaaS commerciaux.

Empoisonnement des ensembles de données : une menace à 60 $ pour les chaînes d'approvisionnement de l'IA

Les chercheurs de Cisco, en collaboration avec Google, ETH Zurich et Nvidia, ont révélé que pour seulement 60 $, les attaquants peuvent empoisonner les ensembles de données fondamentaux des modèles d'IA sans avoir besoin d'exploits zero-day. En exploitant les domaines expirés ou en chronométrant les modifications de Wikipédia pendant l'archivage des ensembles de données, les attaquants peuvent contaminer aussi peu que 0,01 % des ensembles de données comme LAION-400M ou COYO-700M, influençant significativement les LLMs en aval.

Des méthodes telles que l'empoisonnement par vue fractionnée et les attaques de frontrunning exploitent la confiance inhérente aux données collectées sur le web. Avec la plupart des LLMs d'entreprise construits sur des données ouvertes, ces attaques peuvent se propager discrètement et persister profondément dans les pipelines d'inférence, posant une menace sérieuse pour les chaînes d'approvisionnement de l'IA.

Attaques de décomposition : extraction de données sensibles

L'une des découvertes les plus alarmantes des recherches de Cisco est la capacité des LLMs à divulguer des données d'entraînement sensibles sans déclencher les mécanismes de sécurité. En utilisant une technique appelée décomposition de prompts, les chercheurs ont reconstruit plus de 20 % de certains articles de The New York Times et The Wall Street Journal. Cette méthode décompose les prompts en sous-requêtes jugées sûres par les garde-fous, puis réassemble les sorties pour recréer du contenu protégé par des paywalls ou des droits d'auteur.

Ce type d'attaque représente un risque significatif pour les entreprises, en particulier celles utilisant des LLMs entraînés sur des ensembles de données propriétaires ou sous licence. La violation se produit non pas au niveau des entrées mais par les sorties du modèle, rendant difficile sa détection, son audit ou sa containment. Pour les organisations dans des secteurs réglementés comme la santé, la finance ou le droit, cela soulève non seulement des préoccupations concernant la conformité au GDPR, HIPAA ou CCPA, mais introduit également une nouvelle classe de risques où des données légalement obtenues peuvent être exposées par inférence.

Réflexions finales : les LLMs comme nouvelle surface d'attaque

Les recherches en cours de Cisco et la surveillance du dark web par Talos confirment que les LLMs militarisés deviennent de plus en plus sophistiqués, avec une guerre des prix et des emballages se déroulant sur le dark web. Les conclusions soulignent que les LLMs ne sont pas simplement des outils à la périphérie de l'entreprise ; ils sont au cœur de celle-ci. Des risques associés à l'affinage à l'empoisonnement des ensembles de données et aux fuites de sorties de modèles, les attaquants considèrent les LLMs comme une infrastructure critique à exploiter.

La principale conclusion du rapport de Cisco est claire : les garde-fous statiques ne suffisent plus. Les CISOs et les responsables de la sécurité doivent obtenir une visibilité en temps réel sur l'ensemble de leur parc informatique, renforcer les tests adversariaux et rationaliser leur pile technologique pour suivre le rythme de ces menaces en évolution. Ils doivent reconnaître que les LLMs et les modèles représentent une surface d'attaque dynamique qui devient de plus en plus vulnérable à mesure qu'ils sont affinés.

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

L'IA "ZeroSearch" d'Alibaba réduit les coûts de formation de 88 % grâce à l'apprentissage autonome

ZeroSearch d'Alibaba : Un changement de donne pour l'efficacité de l'apprentissage de l'IALes chercheurs du groupe Alibaba ont mis au point une méthode innovante qui pourrait révolutionner la manière

TreeQuest de Sakana AI améliore les performances de l'IA grâce à la collaboration multi-modèle

Le laboratoire d'IA japonais Sakana AI a dévoilé une technique permettant à plusieurs grands modèles de langage (LLM) de travailler ensemble pour former une équipe d'IA très efficace. Baptisée Multi-L

TreeQuest de Sakana AI améliore les performances de l'IA grâce à la collaboration multi-modèle

Le laboratoire d'IA japonais Sakana AI a dévoilé une technique permettant à plusieurs grands modèles de langage (LLM) de travailler ensemble pour former une équipe d'IA très efficace. Baptisée Multi-L

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.Les principaux développeurs d'IA

20 août 2025 09:01:19 UTC+02:00

20 août 2025 09:01:19 UTC+02:00

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

25 avril 2025 07:31:29 UTC+02:00

25 avril 2025 07:31:29 UTC+02:00

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

24 avril 2025 04:08:25 UTC+02:00

24 avril 2025 04:08:25 UTC+02:00

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

23 avril 2025 16:31:51 UTC+02:00

23 avril 2025 16:31:51 UTC+02:00

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

23 avril 2025 08:48:48 UTC+02:00

23 avril 2025 08:48:48 UTC+02:00

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

22 avril 2025 02:59:59 UTC+02:00

22 avril 2025 02:59:59 UTC+02:00

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0