Cisco警告:微調整されたLLMSが22倍不正になる可能性が高い

# cisco

# LLMs

# APIs

# saas

# csco

# goog-2

# msft-2

# nvda-2

# darkgpt

# darkweb

# fraudgpt

# ghostgpt

# zeroday

武器化された大規模言語モデルがサイバー攻撃を再構築

サイバー攻撃の状況は、武器化された大規模言語モデル(LLMs)の出現によって大きな変革を遂げています。FraudGPT、GhostGPT、DarkGPTなどの先進的なモデルは、サイバー犯罪者の戦略を再構築し、最高情報セキュリティ責任者(CISOs)にセキュリティプロトコルの再考を迫っています。偵察の自動化、身元のなりすまし、検知の回避といった能力を持つこれらのLLMは、前例のない規模でソーシャルエンジニアリング攻撃を加速させています。

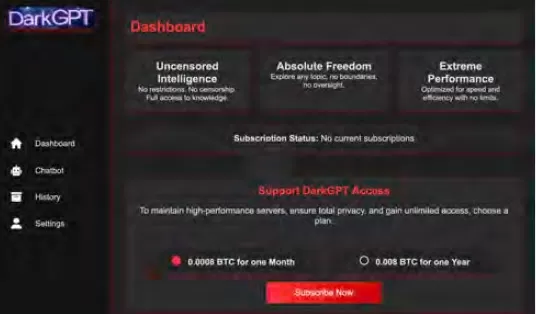

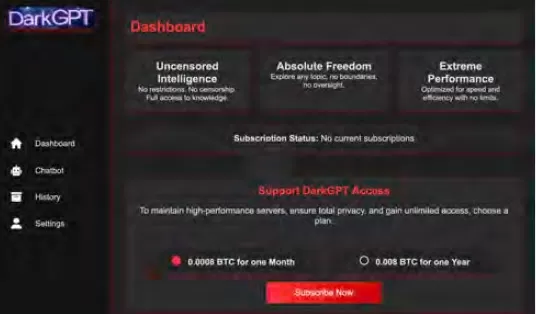

月額わずか75ドルで利用可能なこれらのモデルは、攻撃用途に特化しており、フィッシング、悪用コード生成、コード難読化、脆弱性スキャン、クレジットカード検証などのタスクを容易にします。サイバー犯罪グループ、シンジケート、さらには国家までもがこれらのツールを活用し、プラットフォーム、キット、リースサービスとして提供しています。正規のソフトウェア・アズ・ア・サービス(SaaS)アプリケーションと同様に、武器化されたLLMにはダッシュボード、API、定期的なアップデート、さらにはカスタマーサポートが付属しています。

VentureBeatは、これらの武器化されたLLMの急速な進化を注視しています。その洗練度が増すにつれ、開発者プラットフォームとサイバー犯罪キットの境界がますます曖昧になっています。リースやレンタル価格の低下に伴い、さらなる攻撃者がこれらのプラットフォームを探索し、AI駆動の脅威の新時代を告げています。

正規のLLMが脅威にさらされる

武器化されたLLMの急増は、正規のLLMでさえ犯罪ツールチェーンに組み込まれ、侵害されるリスクに直面する段階に達しています。CiscoのAIセキュリティの現状レポートによると、微調整されたLLMは、ベースモデルに比べて有害な出力を生成する可能性が22倍高いとされています。微調整は文脈の関連性を高めるために重要ですが、安全対策を弱め、モデルをジェイルブレイク、プロンプトインジェクション、モデル反転に対して脆弱にします。

Ciscoの研究では、モデルが本番用に精緻化されるほど脆弱性が増すことが強調されています。微調整に含まれる継続的な調整、サードパーティ統合、コーディング、テスト、エージェントオーケストレーションなどのコアプロセスは、攻撃者に悪用される新たな道を開きます。一旦侵入されると、攻撃者は迅速にデータを汚染し、インフラを乗っ取り、エージェントの動作を変更し、大規模に訓練データを抽出できます。追加のセキュリティ層がなければ、これらの慎重に微調整されたモデルは、攻撃者による悪用に適した負債となり得ます。

LLMの微調整:両刃の剣

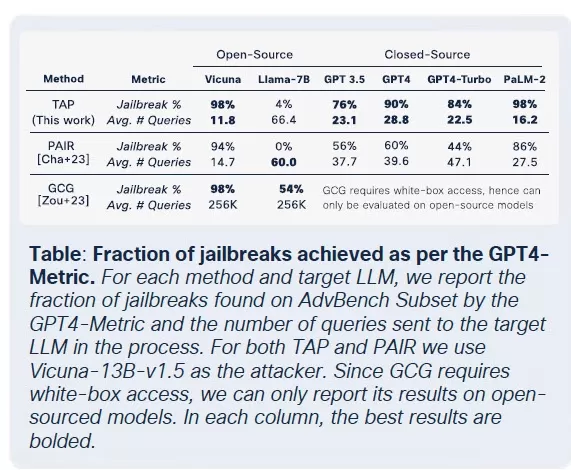

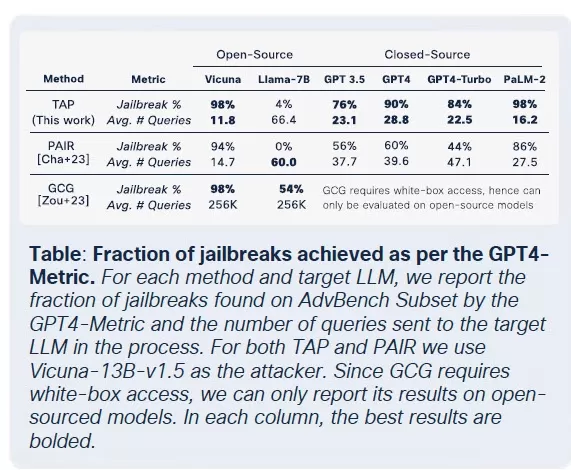

Ciscoのセキュリティチームは、Llama-2-7BやMicrosoftのドメイン特化型Adapt LLMなど、複数のモデルに対する微調整の影響について広範な研究を行いました。テストは医療、金融、法律などさまざまな分野に及びました。主な発見は、クリーンデータセットを使用した微調整であっても、特に生物医学や法律などの厳格に規制された分野で、モデルの整合性を不安定にするというものでした。

微調整はタスクのパフォーマンス向上を目指していますが、組み込みの安全制御を意図せず損ないます。基盤モデルに対して通常失敗するジェイルブレイクの試みは、微調整されたバージョン、特に厳格なコンプライアンス要件がある敏感な領域で、はるかに高い成功率で成功します。結果は顕著で、ジェイルブレイクの成功率は3倍になり、悪意のある出力生成は基盤モデルに比べて2,200%増加しました。このトレードオフは、微調整が有用性を高める一方で、攻撃対象領域を大幅に広げることを意味します。

悪意のあるLLMの商品化

Cisco Talosは、ブラックマーケットのLLMの台頭を積極的に追跡し、その運用に関する洞察を提供しています。GhostGPT、DarkGPT、FraudGPTなどのモデルは、Telegramやダークウェブで月額わずか75ドルで入手可能です。これらのツールは、フィッシング、悪用開発、クレジットカード検証、難読化のためのプラグアンドプレイ用途に設計されています。

安全機能を備えた主流のモデルとは異なり、これらの悪意のあるLLMは攻撃的な操作用に事前設定されており、商用SaaS製品を模倣したAPI、アップデート、ダッシュボードが付属しています。

データセット汚染:AIサプライチェーンへの60ドルの脅威

Ciscoの研究者たちは、Google、ETH Zurich、Nvidiaと協力して、わずか60ドルで攻撃者がゼロデイ攻撃を必要とせずにAIモデルの基盤データセットを汚染できることを明らかにしました。期限切れのドメインを悪用したり、データセットのアーカイブ中にWikipediaの編集をタイミングよく行うことで、攻撃者はLAION-400MやCOYO-700Mなどのデータセットのわずか0.01%を汚染し、下流のLLMに大きな影響を与えることができます。

スプリットビュー汚染やフロントランニング攻撃などの手法は、ウェブクロールデータへの固有の信頼を悪用します。ほとんどの企業向けLLMがオープンデータに基づいて構築されているため、これらの攻撃は静かにスケールし、推論パイプラインの奥深くまで持続し、AIサプライチェーンに深刻な脅威をもたらします。

分解攻撃:機密データの抽出

Ciscoの研究から最も懸念される発見の一つは、LLMが安全メカニズムをトリガーせずに機密性の高い訓練データを漏洩する能力です。分解プロンプティングと呼ばれる技術を使用し、研究者はThe New York TimesやThe Wall Street Journalから選ばれた記事の20%以上を再構築しました。この手法は、プロンプトをガードレールが安全とみなすサブクエリに分解し、出力結果を再組み立てしてペイウォールや著作権で保護されたコンテンツを再作成します。

この種の攻撃は、独自またはライセンスされたデータセットで訓練されたLLMを使用する企業にとって重大なリスクをもたらします。侵害は入力レベルではなく、モデルの出力を通じて発生するため、検知、監査、封じ込めが困難です。医療、金融、法律などの規制されたセクターの組織にとって、これはGDPR、HIPAA、CCPAのコンプライアンスに関する懸念だけでなく、合法的に取得されたデータが推論を通じて暴露される新たなリスククラスを導入します。

最終的な考察:新たな攻撃対象としてのLLM

Ciscoの継続的な研究とTalosのダークウェブ監視により、武器化されたLLMがますます洗練され、ダークウェブ上で価格とパッケージングの競争が展開されていることが確認されています。この発見は、LLMが企業の端にあるツールにとどまらず、その中核に不可欠であることを強調しています。微調整に伴うリスクからデータセット汚染、モデル出力漏洩に至るまで、攻撃者はLLMを悪用すべき重要なインフラと見なしています。

Ciscoのレポートの主なポイントは明らかです:静的なガードレールはもはや十分ではありません。CISOとセキュリティリーダーは、IT全体でリアルタイムの可視性を獲得し、敵対的テストを強化し、進化する脅威に対応するために技術スタックを合理化する必要があります。LLMとモデルは、微調整されるにつれてますます脆弱になる動的な攻撃対象であることを認識しなければなりません。

関連記事

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が

コメント (31)

0/200

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が

コメント (31)

0/200

![BillyGreen]() BillyGreen

BillyGreen

2025年8月20日 16:01:19 JST

2025年8月20日 16:01:19 JST

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

![JerryMoore]() JerryMoore

JerryMoore

2025年4月25日 14:31:29 JST

2025年4月25日 14:31:29 JST

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

![RichardJackson]() RichardJackson

RichardJackson

2025年4月24日 11:08:25 JST

2025年4月24日 11:08:25 JST

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

![AndrewGarcía]() AndrewGarcía

AndrewGarcía

2025年4月23日 23:31:51 JST

2025年4月23日 23:31:51 JST

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

![MatthewGonzalez]() MatthewGonzalez

MatthewGonzalez

2025年4月23日 15:48:48 JST

2025年4月23日 15:48:48 JST

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

![FrankLopez]() FrankLopez

FrankLopez

2025年4月22日 9:59:59 JST

2025年4月22日 9:59:59 JST

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0

武器化された大規模言語モデルがサイバー攻撃を再構築

サイバー攻撃の状況は、武器化された大規模言語モデル(LLMs)の出現によって大きな変革を遂げています。FraudGPT、GhostGPT、DarkGPTなどの先進的なモデルは、サイバー犯罪者の戦略を再構築し、最高情報セキュリティ責任者(CISOs)にセキュリティプロトコルの再考を迫っています。偵察の自動化、身元のなりすまし、検知の回避といった能力を持つこれらのLLMは、前例のない規模でソーシャルエンジニアリング攻撃を加速させています。

月額わずか75ドルで利用可能なこれらのモデルは、攻撃用途に特化しており、フィッシング、悪用コード生成、コード難読化、脆弱性スキャン、クレジットカード検証などのタスクを容易にします。サイバー犯罪グループ、シンジケート、さらには国家までもがこれらのツールを活用し、プラットフォーム、キット、リースサービスとして提供しています。正規のソフトウェア・アズ・ア・サービス(SaaS)アプリケーションと同様に、武器化されたLLMにはダッシュボード、API、定期的なアップデート、さらにはカスタマーサポートが付属しています。

VentureBeatは、これらの武器化されたLLMの急速な進化を注視しています。その洗練度が増すにつれ、開発者プラットフォームとサイバー犯罪キットの境界がますます曖昧になっています。リースやレンタル価格の低下に伴い、さらなる攻撃者がこれらのプラットフォームを探索し、AI駆動の脅威の新時代を告げています。

正規のLLMが脅威にさらされる

武器化されたLLMの急増は、正規のLLMでさえ犯罪ツールチェーンに組み込まれ、侵害されるリスクに直面する段階に達しています。CiscoのAIセキュリティの現状レポートによると、微調整されたLLMは、ベースモデルに比べて有害な出力を生成する可能性が22倍高いとされています。微調整は文脈の関連性を高めるために重要ですが、安全対策を弱め、モデルをジェイルブレイク、プロンプトインジェクション、モデル反転に対して脆弱にします。

Ciscoの研究では、モデルが本番用に精緻化されるほど脆弱性が増すことが強調されています。微調整に含まれる継続的な調整、サードパーティ統合、コーディング、テスト、エージェントオーケストレーションなどのコアプロセスは、攻撃者に悪用される新たな道を開きます。一旦侵入されると、攻撃者は迅速にデータを汚染し、インフラを乗っ取り、エージェントの動作を変更し、大規模に訓練データを抽出できます。追加のセキュリティ層がなければ、これらの慎重に微調整されたモデルは、攻撃者による悪用に適した負債となり得ます。

LLMの微調整:両刃の剣

Ciscoのセキュリティチームは、Llama-2-7BやMicrosoftのドメイン特化型Adapt LLMなど、複数のモデルに対する微調整の影響について広範な研究を行いました。テストは医療、金融、法律などさまざまな分野に及びました。主な発見は、クリーンデータセットを使用した微調整であっても、特に生物医学や法律などの厳格に規制された分野で、モデルの整合性を不安定にするというものでした。

微調整はタスクのパフォーマンス向上を目指していますが、組み込みの安全制御を意図せず損ないます。基盤モデルに対して通常失敗するジェイルブレイクの試みは、微調整されたバージョン、特に厳格なコンプライアンス要件がある敏感な領域で、はるかに高い成功率で成功します。結果は顕著で、ジェイルブレイクの成功率は3倍になり、悪意のある出力生成は基盤モデルに比べて2,200%増加しました。このトレードオフは、微調整が有用性を高める一方で、攻撃対象領域を大幅に広げることを意味します。

悪意のあるLLMの商品化

Cisco Talosは、ブラックマーケットのLLMの台頭を積極的に追跡し、その運用に関する洞察を提供しています。GhostGPT、DarkGPT、FraudGPTなどのモデルは、Telegramやダークウェブで月額わずか75ドルで入手可能です。これらのツールは、フィッシング、悪用開発、クレジットカード検証、難読化のためのプラグアンドプレイ用途に設計されています。

安全機能を備えた主流のモデルとは異なり、これらの悪意のあるLLMは攻撃的な操作用に事前設定されており、商用SaaS製品を模倣したAPI、アップデート、ダッシュボードが付属しています。

データセット汚染:AIサプライチェーンへの60ドルの脅威

Ciscoの研究者たちは、Google、ETH Zurich、Nvidiaと協力して、わずか60ドルで攻撃者がゼロデイ攻撃を必要とせずにAIモデルの基盤データセットを汚染できることを明らかにしました。期限切れのドメインを悪用したり、データセットのアーカイブ中にWikipediaの編集をタイミングよく行うことで、攻撃者はLAION-400MやCOYO-700Mなどのデータセットのわずか0.01%を汚染し、下流のLLMに大きな影響を与えることができます。

スプリットビュー汚染やフロントランニング攻撃などの手法は、ウェブクロールデータへの固有の信頼を悪用します。ほとんどの企業向けLLMがオープンデータに基づいて構築されているため、これらの攻撃は静かにスケールし、推論パイプラインの奥深くまで持続し、AIサプライチェーンに深刻な脅威をもたらします。

分解攻撃:機密データの抽出

Ciscoの研究から最も懸念される発見の一つは、LLMが安全メカニズムをトリガーせずに機密性の高い訓練データを漏洩する能力です。分解プロンプティングと呼ばれる技術を使用し、研究者はThe New York TimesやThe Wall Street Journalから選ばれた記事の20%以上を再構築しました。この手法は、プロンプトをガードレールが安全とみなすサブクエリに分解し、出力結果を再組み立てしてペイウォールや著作権で保護されたコンテンツを再作成します。

この種の攻撃は、独自またはライセンスされたデータセットで訓練されたLLMを使用する企業にとって重大なリスクをもたらします。侵害は入力レベルではなく、モデルの出力を通じて発生するため、検知、監査、封じ込めが困難です。医療、金融、法律などの規制されたセクターの組織にとって、これはGDPR、HIPAA、CCPAのコンプライアンスに関する懸念だけでなく、合法的に取得されたデータが推論を通じて暴露される新たなリスククラスを導入します。

最終的な考察:新たな攻撃対象としてのLLM

Ciscoの継続的な研究とTalosのダークウェブ監視により、武器化されたLLMがますます洗練され、ダークウェブ上で価格とパッケージングの競争が展開されていることが確認されています。この発見は、LLMが企業の端にあるツールにとどまらず、その中核に不可欠であることを強調しています。微調整に伴うリスクからデータセット汚染、モデル出力漏洩に至るまで、攻撃者はLLMを悪用すべき重要なインフラと見なしています。

Ciscoのレポートの主なポイントは明らかです:静的なガードレールはもはや十分ではありません。CISOとセキュリティリーダーは、IT全体でリアルタイムの可視性を獲得し、敵対的テストを強化し、進化する脅威に対応するために技術スタックを合理化する必要があります。LLMとモデルは、微調整されるにつれてますます脆弱になる動的な攻撃対象であることを認識しなければなりません。

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらすアリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が

2025年8月20日 16:01:19 JST

2025年8月20日 16:01:19 JST

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

2025年4月25日 14:31:29 JST

2025年4月25日 14:31:29 JST

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

2025年4月24日 11:08:25 JST

2025年4月24日 11:08:25 JST

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

2025年4月23日 23:31:51 JST

2025年4月23日 23:31:51 JST

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

2025年4月23日 15:48:48 JST

2025年4月23日 15:48:48 JST

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

2025年4月22日 9:59:59 JST

2025年4月22日 9:59:59 JST

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0