ByteDance Dévoile le Modèle d'IA Seed-Thinking-v1.5 pour Améliorer les Capacités de Raisonnement

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.

Les principaux développeurs d'IA rivalisent maintenant pour créer des modèles d'IA de raisonnement plus rapides et plus économiques, offrant des réponses précises et bien réfléchies grâce à des processus de chaîne de pensée, garantissant l'exactitude avant de répondre.

ByteDance, la société mère de TikTok, entre dans la compétition avec Seed-Thinking-v1.5, un nouveau grand modèle de langage (LLM) décrit dans un article technique, visant à améliorer le raisonnement dans les domaines STEM et généraux.

Le modèle n'est pas encore disponible, et sa licence — qu'elle soit propriétaire, open-source ou hybride — reste non divulguée. L'article offre cependant des perspectives clés à explorer avant sa sortie.

Exploiter le Cadre Mixture-of-Experts (MoE)

Suivant Llama 4 de Meta et Mixtral de Mistral, Seed-Thinking-v1.5 adopte l'architecture Mixture-of-Experts (MoE).

Cette approche améliore l'efficacité en intégrant plusieurs modèles spécialisés dans un seul, chacun se concentrant sur des domaines distincts.

Seed-Thinking-v1.5 utilise seulement 20 milliards de ses 200 milliards de paramètres à la fois, optimisant les performances.

L'article publié sur GitHub par ByteDance met en avant l'accent du modèle sur le raisonnement structuré et la génération de réponses délibérées.

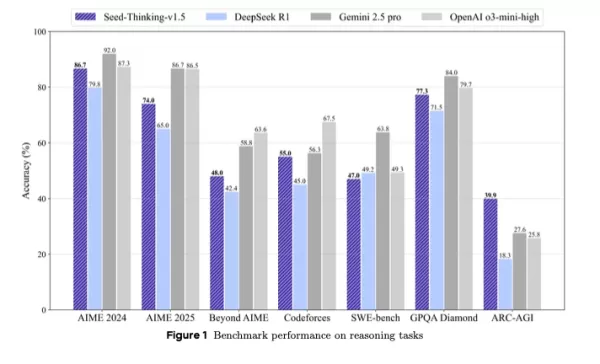

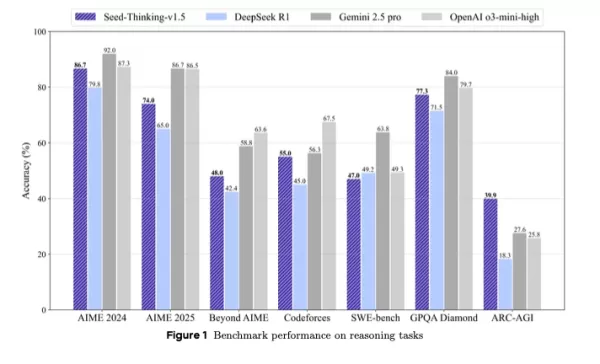

Il surpasse DeepSeek R1 et rivalise avec Gemini 2.5 Pro de Google et o3-mini-high d'OpenAI dans les benchmarks tiers, dépassant même ces derniers sur le benchmark ARC-AGI, une mesure clé du progrès vers l'intelligence artificielle générale, dépassant les performances humaines dans des tâches économiquement précieuses, selon les normes d'OpenAI.

Positionné comme une alternative compacte mais puissante aux modèles plus grands, Seed-Thinking-v1.5 offre de solides résultats de benchmark grâce à un apprentissage par renforcement innovant, des données d'entraînement soigneusement sélectionnées et une infrastructure d'IA avancée.

Performance des Benchmarks et Forces Principales

Seed-Thinking-v1.5 excelle dans les tâches difficiles, obtenant 86,7 % sur AIME 2024, 55,0 % de pass@8 sur Codeforces, et 77,3 % sur le benchmark scientifique GPQA, se rapprochant ou dépassant des modèles comme o3-mini-high d'OpenAI et Gemini 2.5 Pro de Google dans les métriques de raisonnement.

Dans les tâches non liées au raisonnement, il a atteint un taux de préférence humaine 8,0 % supérieur à DeepSeek R1, montrant une polyvalence au-delà de la logique et des mathématiques.

Pour contrer la saturation des benchmarks, ByteDance a créé BeyondAIME, un benchmark mathématique plus difficile pour résister à la mémorisation et mieux évaluer les performances du modèle. Celui-ci, ainsi que l'ensemble Codeforces, sera publié pour aider la recherche future.

Approche des Données d'Entraînement

La qualité des données a été cruciale dans le développement de Seed-Thinking-v1.5. Pour l'ajustement supervisé, 400 000 échantillons ont été soigneusement sélectionnés : 300 000 tâches STEM, logiques et de codage vérifiables, et 100 000 tâches non vérifiables comme l'écriture créative.

Pour l'apprentissage par renforcement, les données ont été divisées en :

- Problèmes vérifiables : 100 000 questions STEM et puzzles logiques soigneusement sélectionnés issus de compétitions d'élite, validés par des experts.

- Tâches non vérifiables : Ensembles de données de préférence humaine pour des prompts ouverts, évalués via des modèles de récompense par paires.

Plus de 80 % des données STEM se concentraient sur les mathématiques avancées, avec des tâches logiques comme le Sudoku et les puzzles de 24 points adaptés pour correspondre aux progrès du modèle.

Innovations en Apprentissage par Renforcement

Seed-Thinking-v1.5 utilise des cadres personnalisés actor-critic (VAPO) et de gradient de politique (DAPO) pour stabiliser l'apprentissage par renforcement, résolvant les problèmes dans les scénarios de chaîne de pensée longue.

Deux modèles de récompense améliorent la supervision RL :

- Seed-Verifier : Un LLM basé sur des règles assurant l'équivalence mathématique entre les réponses générées et les références.

- Seed-Thinking-Verifier : Un juge basé sur le raisonnement pour une évaluation cohérente, résistant à la manipulation des récompenses.

Ce système dual soutient une évaluation précise pour les tâches simples et complexes.

Conception d'Infrastructure Évolutive

Le cadre HybridFlow de ByteDance, alimenté par des clusters Ray, soutient un entraînement à grande échelle efficace avec un entraînement et une inférence co-localisés pour minimiser le temps d'inactivité des GPU.

Le Streaming Rollout System (SRS) sépare l'évolution du modèle de l'exécution, accélérant les itérations jusqu'à trois fois grâce à une gestion asynchrone des générations partielles.

Les techniques supplémentaires incluent :

- Précision mixte (FP8) pour l'efficacité de la mémoire

- Parallélisme d'experts et auto-ajustement de kernel pour l'optimisation MoE

- ByteCheckpoint pour un point de contrôle robuste

- AutoTuner pour des paramètres optimisés de parallélisme et de mémoire

Évaluation Centrée sur l'Humain et Applications

Les tests humains sur l'écriture créative, les humanités et la conversation générale ont montré que Seed-Thinking-v1.5 surpasse DeepSeek R1, prouvant sa pertinence dans le monde réel.

L'équipe note que l'entraînement sur des tâches vérifiables a amélioré la généralisation aux domaines créatifs, grâce à des flux de travail mathématiques rigoureux.

Implications pour les Équipes Techniques et les Entreprises

Pour les leaders techniques supervisant les cycles de vie des LLM, Seed-Thinking-v1.5 offre un modèle pour intégrer un raisonnement avancé dans les systèmes d'IA d'entreprise.

Son entraînement modulaire, avec des ensembles de données vérifiables et un apprentissage par renforcement multi-phases, convient aux équipes qui développent des LLM avec un contrôle précis.

Seed-Verifier et Seed-Thinking-Verifier améliorent la modélisation de récompenses fiables, essentielle pour les environnements orientés clients ou réglementés.

Pour les équipes aux plannings serrés, VAPO et l'échantillonnage dynamique réduisent les cycles d'itération, simplifiant l'ajustement spécifique aux tâches.

L'infrastructure hybride, incluant SRS et l'optimisation FP8, augmente le débit d'entraînement et l'efficacité matérielle, idéale pour les systèmes cloud et sur site.

La rétroaction adaptative des récompenses du modèle répond aux défis de la gestion de pipelines de données divers, assurant une cohérence entre les domaines.

Pour les ingénieurs de données, l'accent sur le filtrage rigoureux des données et la vérification par des experts souligne l'importance des ensembles de données de haute qualité pour améliorer les performances du modèle.

Perspectives Futures

Développé par l'équipe Seed LLM Systems de ByteDance, dirigée par Yonghui Wu et représentée publiquement par Haibin Lin, Seed-Thinking-v1.5 s'appuie sur des efforts comme Doubao 1.5 Pro, utilisant des techniques partagées de RLHF et de curation de données.

L'équipe vise à affiner l'apprentissage par renforcement, en se concentrant sur l'efficacité de l'entraînement et la modélisation des récompenses pour les tâches non vérifiables. La publication de benchmarks comme BeyondAIME favorisera les progrès dans la recherche sur l'IA axée sur le raisonnement.

Article connexe

Google Dévoile le Protocole A2A pour Améliorer l'Interopérabilité des Agents AI

Les agents AI s'attaquent à des tâches complexes et répétitives comme la gestion de la chaîne d'approvisionnement et l'acquisition d'équipements. Alors que les organisations adoptent des agents de div

Google Dévoile le Protocole A2A pour Améliorer l'Interopérabilité des Agents AI

Les agents AI s'attaquent à des tâches complexes et répétitives comme la gestion de la chaîne d'approvisionnement et l'acquisition d'équipements. Alors que les organisations adoptent des agents de div

Qodo s'associe à Google Cloud pour offrir des outils gratuits d'examen de code par IA aux développeurs

Qodo, une startup israélienne spécialisée dans le codage par IA et axée sur la qualité du code, a lancé un partenariat avec Google Cloud pour améliorer l'intégrité des logiciels générés par IA.À mesur

Qodo s'associe à Google Cloud pour offrir des outils gratuits d'examen de code par IA aux développeurs

Qodo, une startup israélienne spécialisée dans le codage par IA et axée sur la qualité du code, a lancé un partenariat avec Google Cloud pour améliorer l'intégrité des logiciels générés par IA.À mesur

Salesforce Dévoile des Coéquipiers Numériques IA dans Slack pour Rivaliser avec Microsoft Copilot

Le nouvel outil, Agentforce dans Slack, permet aux entreprises de créer et de déployer des agents IA spécifiques à des tâches qui recherchent dans les discussions professionnelles, accèdent aux donnée

commentaires (0)

0/200

Salesforce Dévoile des Coéquipiers Numériques IA dans Slack pour Rivaliser avec Microsoft Copilot

Le nouvel outil, Agentforce dans Slack, permet aux entreprises de créer et de déployer des agents IA spécifiques à des tâches qui recherchent dans les discussions professionnelles, accèdent aux donnée

commentaires (0)

0/200

La course à l'IA avancée en raisonnement a commencé avec le modèle o1 d'OpenAI en septembre 2024, gagnant en élan avec le lancement de R1 par DeepSeek en janvier 2025.

Les principaux développeurs d'IA rivalisent maintenant pour créer des modèles d'IA de raisonnement plus rapides et plus économiques, offrant des réponses précises et bien réfléchies grâce à des processus de chaîne de pensée, garantissant l'exactitude avant de répondre.

ByteDance, la société mère de TikTok, entre dans la compétition avec Seed-Thinking-v1.5, un nouveau grand modèle de langage (LLM) décrit dans un article technique, visant à améliorer le raisonnement dans les domaines STEM et généraux.

Le modèle n'est pas encore disponible, et sa licence — qu'elle soit propriétaire, open-source ou hybride — reste non divulguée. L'article offre cependant des perspectives clés à explorer avant sa sortie.

Exploiter le Cadre Mixture-of-Experts (MoE)

Suivant Llama 4 de Meta et Mixtral de Mistral, Seed-Thinking-v1.5 adopte l'architecture Mixture-of-Experts (MoE).

Cette approche améliore l'efficacité en intégrant plusieurs modèles spécialisés dans un seul, chacun se concentrant sur des domaines distincts.

Seed-Thinking-v1.5 utilise seulement 20 milliards de ses 200 milliards de paramètres à la fois, optimisant les performances.

L'article publié sur GitHub par ByteDance met en avant l'accent du modèle sur le raisonnement structuré et la génération de réponses délibérées.

Il surpasse DeepSeek R1 et rivalise avec Gemini 2.5 Pro de Google et o3-mini-high d'OpenAI dans les benchmarks tiers, dépassant même ces derniers sur le benchmark ARC-AGI, une mesure clé du progrès vers l'intelligence artificielle générale, dépassant les performances humaines dans des tâches économiquement précieuses, selon les normes d'OpenAI.

Positionné comme une alternative compacte mais puissante aux modèles plus grands, Seed-Thinking-v1.5 offre de solides résultats de benchmark grâce à un apprentissage par renforcement innovant, des données d'entraînement soigneusement sélectionnées et une infrastructure d'IA avancée.

Performance des Benchmarks et Forces Principales

Seed-Thinking-v1.5 excelle dans les tâches difficiles, obtenant 86,7 % sur AIME 2024, 55,0 % de pass@8 sur Codeforces, et 77,3 % sur le benchmark scientifique GPQA, se rapprochant ou dépassant des modèles comme o3-mini-high d'OpenAI et Gemini 2.5 Pro de Google dans les métriques de raisonnement.

Dans les tâches non liées au raisonnement, il a atteint un taux de préférence humaine 8,0 % supérieur à DeepSeek R1, montrant une polyvalence au-delà de la logique et des mathématiques.

Pour contrer la saturation des benchmarks, ByteDance a créé BeyondAIME, un benchmark mathématique plus difficile pour résister à la mémorisation et mieux évaluer les performances du modèle. Celui-ci, ainsi que l'ensemble Codeforces, sera publié pour aider la recherche future.

Approche des Données d'Entraînement

La qualité des données a été cruciale dans le développement de Seed-Thinking-v1.5. Pour l'ajustement supervisé, 400 000 échantillons ont été soigneusement sélectionnés : 300 000 tâches STEM, logiques et de codage vérifiables, et 100 000 tâches non vérifiables comme l'écriture créative.

Pour l'apprentissage par renforcement, les données ont été divisées en :

- Problèmes vérifiables : 100 000 questions STEM et puzzles logiques soigneusement sélectionnés issus de compétitions d'élite, validés par des experts.

- Tâches non vérifiables : Ensembles de données de préférence humaine pour des prompts ouverts, évalués via des modèles de récompense par paires.

Plus de 80 % des données STEM se concentraient sur les mathématiques avancées, avec des tâches logiques comme le Sudoku et les puzzles de 24 points adaptés pour correspondre aux progrès du modèle.

Innovations en Apprentissage par Renforcement

Seed-Thinking-v1.5 utilise des cadres personnalisés actor-critic (VAPO) et de gradient de politique (DAPO) pour stabiliser l'apprentissage par renforcement, résolvant les problèmes dans les scénarios de chaîne de pensée longue.

Deux modèles de récompense améliorent la supervision RL :

- Seed-Verifier : Un LLM basé sur des règles assurant l'équivalence mathématique entre les réponses générées et les références.

- Seed-Thinking-Verifier : Un juge basé sur le raisonnement pour une évaluation cohérente, résistant à la manipulation des récompenses.

Ce système dual soutient une évaluation précise pour les tâches simples et complexes.

Conception d'Infrastructure Évolutive

Le cadre HybridFlow de ByteDance, alimenté par des clusters Ray, soutient un entraînement à grande échelle efficace avec un entraînement et une inférence co-localisés pour minimiser le temps d'inactivité des GPU.

Le Streaming Rollout System (SRS) sépare l'évolution du modèle de l'exécution, accélérant les itérations jusqu'à trois fois grâce à une gestion asynchrone des générations partielles.

Les techniques supplémentaires incluent :

- Précision mixte (FP8) pour l'efficacité de la mémoire

- Parallélisme d'experts et auto-ajustement de kernel pour l'optimisation MoE

- ByteCheckpoint pour un point de contrôle robuste

- AutoTuner pour des paramètres optimisés de parallélisme et de mémoire

Évaluation Centrée sur l'Humain et Applications

Les tests humains sur l'écriture créative, les humanités et la conversation générale ont montré que Seed-Thinking-v1.5 surpasse DeepSeek R1, prouvant sa pertinence dans le monde réel.

L'équipe note que l'entraînement sur des tâches vérifiables a amélioré la généralisation aux domaines créatifs, grâce à des flux de travail mathématiques rigoureux.

Implications pour les Équipes Techniques et les Entreprises

Pour les leaders techniques supervisant les cycles de vie des LLM, Seed-Thinking-v1.5 offre un modèle pour intégrer un raisonnement avancé dans les systèmes d'IA d'entreprise.

Son entraînement modulaire, avec des ensembles de données vérifiables et un apprentissage par renforcement multi-phases, convient aux équipes qui développent des LLM avec un contrôle précis.

Seed-Verifier et Seed-Thinking-Verifier améliorent la modélisation de récompenses fiables, essentielle pour les environnements orientés clients ou réglementés.

Pour les équipes aux plannings serrés, VAPO et l'échantillonnage dynamique réduisent les cycles d'itération, simplifiant l'ajustement spécifique aux tâches.

L'infrastructure hybride, incluant SRS et l'optimisation FP8, augmente le débit d'entraînement et l'efficacité matérielle, idéale pour les systèmes cloud et sur site.

La rétroaction adaptative des récompenses du modèle répond aux défis de la gestion de pipelines de données divers, assurant une cohérence entre les domaines.

Pour les ingénieurs de données, l'accent sur le filtrage rigoureux des données et la vérification par des experts souligne l'importance des ensembles de données de haute qualité pour améliorer les performances du modèle.

Perspectives Futures

Développé par l'équipe Seed LLM Systems de ByteDance, dirigée par Yonghui Wu et représentée publiquement par Haibin Lin, Seed-Thinking-v1.5 s'appuie sur des efforts comme Doubao 1.5 Pro, utilisant des techniques partagées de RLHF et de curation de données.

L'équipe vise à affiner l'apprentissage par renforcement, en se concentrant sur l'efficacité de l'entraînement et la modélisation des récompenses pour les tâches non vérifiables. La publication de benchmarks comme BeyondAIME favorisera les progrès dans la recherche sur l'IA axée sur le raisonnement.

Qodo s'associe à Google Cloud pour offrir des outils gratuits d'examen de code par IA aux développeurs

Qodo, une startup israélienne spécialisée dans le codage par IA et axée sur la qualité du code, a lancé un partenariat avec Google Cloud pour améliorer l'intégrité des logiciels générés par IA.À mesur

Qodo s'associe à Google Cloud pour offrir des outils gratuits d'examen de code par IA aux développeurs

Qodo, une startup israélienne spécialisée dans le codage par IA et axée sur la qualité du code, a lancé un partenariat avec Google Cloud pour améliorer l'intégrité des logiciels générés par IA.À mesur

Salesforce Dévoile des Coéquipiers Numériques IA dans Slack pour Rivaliser avec Microsoft Copilot

Le nouvel outil, Agentforce dans Slack, permet aux entreprises de créer et de déployer des agents IA spécifiques à des tâches qui recherchent dans les discussions professionnelles, accèdent aux donnée

Salesforce Dévoile des Coéquipiers Numériques IA dans Slack pour Rivaliser avec Microsoft Copilot

Le nouvel outil, Agentforce dans Slack, permet aux entreprises de créer et de déployer des agents IA spécifiques à des tâches qui recherchent dans les discussions professionnelles, accèdent aux donnée