思科警告:流氓的微調LLMS的可能性高22倍

# cisco

# LLMs

# APIs

# saas

# csco

# goog-2

# msft-2

# nvda-2

# darkgpt

# darkweb

# fraudgpt

# ghostgpt

# zeroday

武器化大型語言模型重塑網路攻擊

網路攻擊的格局正在發生重大變革,這是由武器化大型語言模型(LLMs)的出現所驅動的。這些先進模型,如 FraudGPT、GhostGPT 和 DarkGPT,正在重塑網路犯罪分子的策略,並迫使首席資訊安全官(CISOs)重新思考其安全協議。憑藉自動化偵察、冒充身份和規避檢測的能力,這些 LLMs 正以前所未有的規模加速社交工程攻擊。

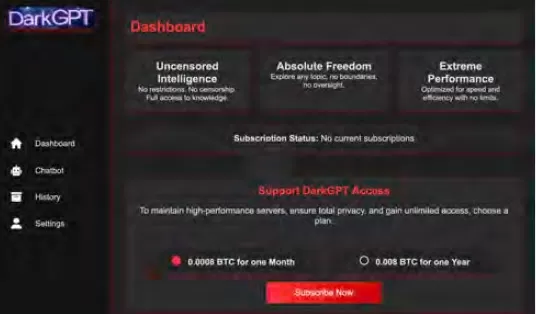

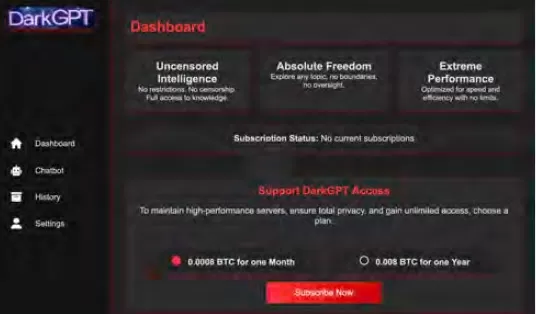

這些模型每月僅需 75 美元即可使用,專為攻擊性用途量身定制,支援如釣魚攻擊、漏洞生成、程式碼混淆、漏洞掃描和信用卡驗證等任務。網路犯罪團體、犯罪集團甚至國家正在利用這些工具,將其作為平台、套件和租賃服務提供。與合法的軟體即服務(SaaS)應用程式類似,武器化 LLMs 配備儀表板、API、定期更新,甚至有時提供客戶支援。

VentureBeat 正在密切關注這些武器化 LLMs 的快速演變。隨著其複雜性增加,開發者平台與網路犯罪套件之間的界限日益模糊。隨著租賃和租用價格的下降,越來越多的攻擊者正在探索這些平台,預示著 AI 驅動威脅的新時代。

合法 LLMs 面臨威脅

武器化 LLMs 的擴散已達到一個程度,甚至合法 LLMs 也有被入侵並整合進犯罪工具鏈的風險。根據 Cisco 的《AI 安全狀況報告》,經過微調的 LLMs 產生有害輸出的可能性是其基礎模型的 22 倍。雖然微調對於提升上下文相關性至關重要,但它也削弱了安全措施,使模型更容易受到越獄、提示注入和模型反轉的攻擊。

Cisco 的研究顯示,模型越是為生產環境進行精煉,越容易受到攻擊。微調過程中的核心流程,如持續調整、第三方整合、程式碼編寫、測試和代理編排,為攻擊者創造了新的利用途徑。一旦入侵,攻擊者可以迅速毒害資料、劫持基礎設施、改變代理行為並大規模提取訓練資料。若無額外的安全層,這些精心微調的模型很快就會成為攻擊者可利用的負債。

微調 LLMs:一把雙刃劍

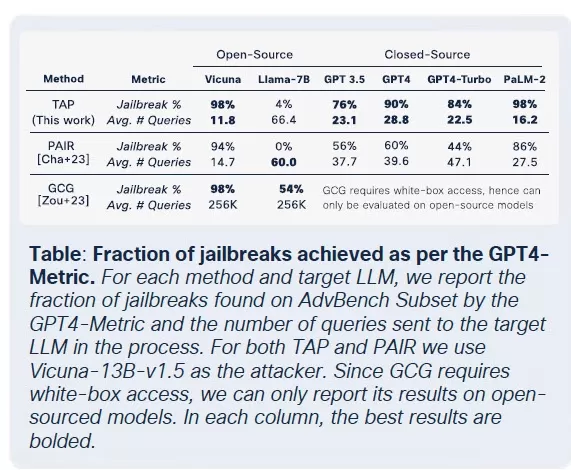

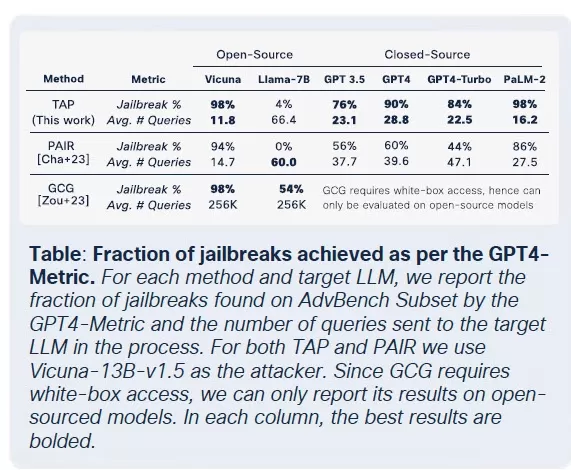

Cisco 的安全團隊對多個模型的微調影響進行了廣泛研究,包括 Llama-2-7B 和 Microsoft 的特定領域 Adapt LLMs。他們的測試涵蓋醫療、金融和法律等多個行業。一個關鍵發現是,即使使用乾淨的數據集進行微調,也會破壞模型的對齊,特別是在生物醫學和法律等高度監管的領域。

雖然微調旨在提高任務性能,但它無意中削弱了內建的安全控制。針對基礎模型通常失敗的越獄嘗試,在微調版本上成功率大幅提高,特別是在具有嚴格合規要求的敏感領域。結果顯而易見:越獄成功率增加了三倍,惡意輸出生成量比基礎模型增加了 2,200%。這種權衡意味著,雖然微調提高了實用性,但也顯著擴大了攻擊面。

惡意 LLMs 的商品化

Cisco Talos 一直在積極追蹤這些黑市 LLMs 的興起,提供了對其運作的洞察。GhostGPT、DarkGPT 和 FraudGPT 等模型在 Telegram 和暗網上以每月 75 美元的價格出售。這些工具專為即插即用設計,用於釣魚攻擊、漏洞開發、信用卡驗證和混淆。

與具有內建安全功能的主流模型不同,這些惡意 LLMs 預先配置為攻擊性操作,配備 API、更新和模擬商業 SaaS 產品的儀表板。

數據集毒害:60 美元對 AI 供應鏈的威脅

Cisco 研究人員與 Google、ETH Zurich 和 Nvidia 合作,揭示攻擊者僅需 60 美元即可毒害 AI 模型的基礎數據集,無需零日漏洞。通過利用過期域名或在數據集歸檔期間定時編輯維基百科,攻擊者可以污染僅 0.01% 的數據集,如 LAION-400M 或 COYO-700M,從而顯著影響下游 LLMs。

分裂視圖毒害和搶先攻擊等方法利用了對網絡爬取數據的固有信任。由於大多數企業 LLMs 建立在公開數據之上,這些攻擊可以悄無聲息地擴展並深入推理管道,對 AI 供應鏈構成嚴重威脅。

分解攻擊:提取敏感數據

Cisco 研究中最令人震驚的發現之一是 LLMs 能在不觸發安全機制的的情況下洩漏敏感訓練數據。使用一種稱為分解提示的技術,研究人員重建了來自《紐約時報》和《華爾街日報》的超過 20% 的選定文章。這種方法將提示分解為被護欄認為安全的子查詢,然後重新組裝輸出以重現付費牆或版權內容。

這種攻擊對使用基於專有或許可數據集訓練的 LLMs 的企業構成重大風險。違規不是發生在輸入層面,而是通過模型的輸出,使其難以檢測、審計或遏制。對於醫療、金融或法律等受監管行業的組織,這不僅引發了 GDPR、HIPAA 或 CCPA 合規性的擔憂,還引入了一類新的風險,即合法來源的數據可能通過推理暴露。

最終思考:LLMs 作為新攻擊面

Cisco 的持續研究和 Talos 的暗網監控證實,武器化 LLMs 變得越來越複雜,暗網上正在展開價格和包裝戰。研究結果強調,LLMs 不僅是企業邊緣的工具;它們是企業核心的組成部分。從微調相關風險到數據集毒害和模型輸出洩漏,攻擊者將 LLMs 視為可利用的關鍵基礎設施。

Cisco 報告的主要結論很明確:靜態護欄已不足以應對威脅。首席資訊安全官和安全領導者必須獲得整個 IT 資產的即時可視性,增強對抗性測試,並簡化其技術堆棧,以跟上這些不斷演變的威脅。他們必須認識到,LLMs 和模型代表了一個動態攻擊面,隨著微調而變得越來越脆弱。

相關文章

阿里巴巴的「ZeroSearch」AI 透過自主學習將訓練成本降低 88

阿里巴巴的 ZeroSearch:改變人工智能訓練效率的遊戲規則阿里巴巴集團的研究人員開創了一種突破性的方法,有可能徹底改變人工智能系統學習信息檢索的方式,完全繞過成本高昂的商業搜索引擎 API。他們的 ZeroSearch 技術可讓大型語言模型在訓練階段透過模擬環境培養複雜的搜尋能力,而非傳統的搜尋引擎互動。"研究人員在最新發表的 arXiv 論文中解釋說:「傳統的強化學習需要大量的搜尋要求,累

阿里巴巴的「ZeroSearch」AI 透過自主學習將訓練成本降低 88

阿里巴巴的 ZeroSearch:改變人工智能訓練效率的遊戲規則阿里巴巴集團的研究人員開創了一種突破性的方法,有可能徹底改變人工智能系統學習信息檢索的方式,完全繞過成本高昂的商業搜索引擎 API。他們的 ZeroSearch 技術可讓大型語言模型在訓練階段透過模擬環境培養複雜的搜尋能力,而非傳統的搜尋引擎互動。"研究人員在最新發表的 arXiv 論文中解釋說:「傳統的強化學習需要大量的搜尋要求,累

Sakana AI 的 TreeQuest 透過多模型協作提升 AI 效能

日本 AI 實驗室 Sakana AI 發表了一項技術,可讓多個大型語言模型 (LLM) 合作,組成一個高效率的 AI 團隊。此方法命名為 Multi-LLM AB-MCTS,可讓模型進行試誤,利用其獨特優勢來處理任何單一模型無法處理的複雜任務。對於企業而言,這種方法提供了建立更強大人工智慧系統的方法。企業可以動態地利用各種前沿模型的優勢,為每個任務區段分配最佳的人工智能,以達到最佳結果,而不是依

Sakana AI 的 TreeQuest 透過多模型協作提升 AI 效能

日本 AI 實驗室 Sakana AI 發表了一項技術,可讓多個大型語言模型 (LLM) 合作,組成一個高效率的 AI 團隊。此方法命名為 Multi-LLM AB-MCTS,可讓模型進行試誤,利用其獨特優勢來處理任何單一模型無法處理的複雜任務。對於企業而言,這種方法提供了建立更強大人工智慧系統的方法。企業可以動態地利用各種前沿模型的優勢,為每個任務區段分配最佳的人工智能,以達到最佳結果,而不是依

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

評論 (31)

0/200

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

評論 (31)

0/200

![BillyGreen]() BillyGreen

BillyGreen

2025-08-20 15:01:19

2025-08-20 15:01:19

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

![JerryMoore]() JerryMoore

JerryMoore

2025-04-25 13:31:29

2025-04-25 13:31:29

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

![RichardJackson]() RichardJackson

RichardJackson

2025-04-24 10:08:25

2025-04-24 10:08:25

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

![AndrewGarcía]() AndrewGarcía

AndrewGarcía

2025-04-23 22:31:51

2025-04-23 22:31:51

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

![MatthewGonzalez]() MatthewGonzalez

MatthewGonzalez

2025-04-23 14:48:48

2025-04-23 14:48:48

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

![FrankLopez]() FrankLopez

FrankLopez

2025-04-22 08:59:59

2025-04-22 08:59:59

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0

武器化大型語言模型重塑網路攻擊

網路攻擊的格局正在發生重大變革,這是由武器化大型語言模型(LLMs)的出現所驅動的。這些先進模型,如 FraudGPT、GhostGPT 和 DarkGPT,正在重塑網路犯罪分子的策略,並迫使首席資訊安全官(CISOs)重新思考其安全協議。憑藉自動化偵察、冒充身份和規避檢測的能力,這些 LLMs 正以前所未有的規模加速社交工程攻擊。

這些模型每月僅需 75 美元即可使用,專為攻擊性用途量身定制,支援如釣魚攻擊、漏洞生成、程式碼混淆、漏洞掃描和信用卡驗證等任務。網路犯罪團體、犯罪集團甚至國家正在利用這些工具,將其作為平台、套件和租賃服務提供。與合法的軟體即服務(SaaS)應用程式類似,武器化 LLMs 配備儀表板、API、定期更新,甚至有時提供客戶支援。

VentureBeat 正在密切關注這些武器化 LLMs 的快速演變。隨著其複雜性增加,開發者平台與網路犯罪套件之間的界限日益模糊。隨著租賃和租用價格的下降,越來越多的攻擊者正在探索這些平台,預示著 AI 驅動威脅的新時代。

合法 LLMs 面臨威脅

武器化 LLMs 的擴散已達到一個程度,甚至合法 LLMs 也有被入侵並整合進犯罪工具鏈的風險。根據 Cisco 的《AI 安全狀況報告》,經過微調的 LLMs 產生有害輸出的可能性是其基礎模型的 22 倍。雖然微調對於提升上下文相關性至關重要,但它也削弱了安全措施,使模型更容易受到越獄、提示注入和模型反轉的攻擊。

Cisco 的研究顯示,模型越是為生產環境進行精煉,越容易受到攻擊。微調過程中的核心流程,如持續調整、第三方整合、程式碼編寫、測試和代理編排,為攻擊者創造了新的利用途徑。一旦入侵,攻擊者可以迅速毒害資料、劫持基礎設施、改變代理行為並大規模提取訓練資料。若無額外的安全層,這些精心微調的模型很快就會成為攻擊者可利用的負債。

微調 LLMs:一把雙刃劍

Cisco 的安全團隊對多個模型的微調影響進行了廣泛研究,包括 Llama-2-7B 和 Microsoft 的特定領域 Adapt LLMs。他們的測試涵蓋醫療、金融和法律等多個行業。一個關鍵發現是,即使使用乾淨的數據集進行微調,也會破壞模型的對齊,特別是在生物醫學和法律等高度監管的領域。

雖然微調旨在提高任務性能,但它無意中削弱了內建的安全控制。針對基礎模型通常失敗的越獄嘗試,在微調版本上成功率大幅提高,特別是在具有嚴格合規要求的敏感領域。結果顯而易見:越獄成功率增加了三倍,惡意輸出生成量比基礎模型增加了 2,200%。這種權衡意味著,雖然微調提高了實用性,但也顯著擴大了攻擊面。

惡意 LLMs 的商品化

Cisco Talos 一直在積極追蹤這些黑市 LLMs 的興起,提供了對其運作的洞察。GhostGPT、DarkGPT 和 FraudGPT 等模型在 Telegram 和暗網上以每月 75 美元的價格出售。這些工具專為即插即用設計,用於釣魚攻擊、漏洞開發、信用卡驗證和混淆。

與具有內建安全功能的主流模型不同,這些惡意 LLMs 預先配置為攻擊性操作,配備 API、更新和模擬商業 SaaS 產品的儀表板。

數據集毒害:60 美元對 AI 供應鏈的威脅

Cisco 研究人員與 Google、ETH Zurich 和 Nvidia 合作,揭示攻擊者僅需 60 美元即可毒害 AI 模型的基礎數據集,無需零日漏洞。通過利用過期域名或在數據集歸檔期間定時編輯維基百科,攻擊者可以污染僅 0.01% 的數據集,如 LAION-400M 或 COYO-700M,從而顯著影響下游 LLMs。

分裂視圖毒害和搶先攻擊等方法利用了對網絡爬取數據的固有信任。由於大多數企業 LLMs 建立在公開數據之上,這些攻擊可以悄無聲息地擴展並深入推理管道,對 AI 供應鏈構成嚴重威脅。

分解攻擊:提取敏感數據

Cisco 研究中最令人震驚的發現之一是 LLMs 能在不觸發安全機制的的情況下洩漏敏感訓練數據。使用一種稱為分解提示的技術,研究人員重建了來自《紐約時報》和《華爾街日報》的超過 20% 的選定文章。這種方法將提示分解為被護欄認為安全的子查詢,然後重新組裝輸出以重現付費牆或版權內容。

這種攻擊對使用基於專有或許可數據集訓練的 LLMs 的企業構成重大風險。違規不是發生在輸入層面,而是通過模型的輸出,使其難以檢測、審計或遏制。對於醫療、金融或法律等受監管行業的組織,這不僅引發了 GDPR、HIPAA 或 CCPA 合規性的擔憂,還引入了一類新的風險,即合法來源的數據可能通過推理暴露。

最終思考:LLMs 作為新攻擊面

Cisco 的持續研究和 Talos 的暗網監控證實,武器化 LLMs 變得越來越複雜,暗網上正在展開價格和包裝戰。研究結果強調,LLMs 不僅是企業邊緣的工具;它們是企業核心的組成部分。從微調相關風險到數據集毒害和模型輸出洩漏,攻擊者將 LLMs 視為可利用的關鍵基礎設施。

Cisco 報告的主要結論很明確:靜態護欄已不足以應對威脅。首席資訊安全官和安全領導者必須獲得整個 IT 資產的即時可視性,增強對抗性測試,並簡化其技術堆棧,以跟上這些不斷演變的威脅。他們必須認識到,LLMs 和模型代表了一個動態攻擊面,隨著微調而變得越來越脆弱。

阿里巴巴的「ZeroSearch」AI 透過自主學習將訓練成本降低 88

阿里巴巴的 ZeroSearch:改變人工智能訓練效率的遊戲規則阿里巴巴集團的研究人員開創了一種突破性的方法,有可能徹底改變人工智能系統學習信息檢索的方式,完全繞過成本高昂的商業搜索引擎 API。他們的 ZeroSearch 技術可讓大型語言模型在訓練階段透過模擬環境培養複雜的搜尋能力,而非傳統的搜尋引擎互動。"研究人員在最新發表的 arXiv 論文中解釋說:「傳統的強化學習需要大量的搜尋要求,累

阿里巴巴的「ZeroSearch」AI 透過自主學習將訓練成本降低 88

阿里巴巴的 ZeroSearch:改變人工智能訓練效率的遊戲規則阿里巴巴集團的研究人員開創了一種突破性的方法,有可能徹底改變人工智能系統學習信息檢索的方式,完全繞過成本高昂的商業搜索引擎 API。他們的 ZeroSearch 技術可讓大型語言模型在訓練階段透過模擬環境培養複雜的搜尋能力,而非傳統的搜尋引擎互動。"研究人員在最新發表的 arXiv 論文中解釋說:「傳統的強化學習需要大量的搜尋要求,累

Sakana AI 的 TreeQuest 透過多模型協作提升 AI 效能

日本 AI 實驗室 Sakana AI 發表了一項技術,可讓多個大型語言模型 (LLM) 合作,組成一個高效率的 AI 團隊。此方法命名為 Multi-LLM AB-MCTS,可讓模型進行試誤,利用其獨特優勢來處理任何單一模型無法處理的複雜任務。對於企業而言,這種方法提供了建立更強大人工智慧系統的方法。企業可以動態地利用各種前沿模型的優勢,為每個任務區段分配最佳的人工智能,以達到最佳結果,而不是依

Sakana AI 的 TreeQuest 透過多模型協作提升 AI 效能

日本 AI 實驗室 Sakana AI 發表了一項技術,可讓多個大型語言模型 (LLM) 合作,組成一個高效率的 AI 團隊。此方法命名為 Multi-LLM AB-MCTS,可讓模型進行試誤,利用其獨特優勢來處理任何單一模型無法處理的複雜任務。對於企業而言,這種方法提供了建立更強大人工智慧系統的方法。企業可以動態地利用各種前沿模型的優勢,為每個任務區段分配最佳的人工智能,以達到最佳結果,而不是依

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

字節跳動推出Seed-Thinking-v1.5 AI模型以提升推理能力

先進推理AI的競賽始於2024年9月OpenAI的o1模型,隨著2025年1月DeepSeek的R1推出而加速。主要AI開發商現正競相打造更快、更具成本效益的推理AI模型,通過思維鏈過程提供精確、深思熟慮的回應,確保回答前的準確性。字節跳動,TikTok的母公司,推出Seed-Thinking-v1.5,一款在技術論文中概述的新大型語言模型(LLM),旨在增強STEM及一般領域的推理能力。該模型尚

2025-08-20 15:01:19

2025-08-20 15:01:19

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

2025-04-25 13:31:29

2025-04-25 13:31:29

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

2025-04-24 10:08:25

2025-04-24 10:08:25

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

2025-04-23 22:31:51

2025-04-23 22:31:51

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

2025-04-23 14:48:48

2025-04-23 14:48:48

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

2025-04-22 08:59:59

2025-04-22 08:59:59

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0