Cisco advierte: LLMS ajustados 22 veces más probabilidades de volverse pícaros

# cisco

# LLMs

# APIs

# saas

# csco

# goog-2

# msft-2

# nvda-2

# darkgpt

# darkweb

# fraudgpt

# ghostgpt

# zeroday

Modelos de Lenguaje de Gran Escala Armados Transforman los Ciberataques

El panorama de los ciberataques está experimentando una transformación significativa, impulsada por la aparición de modelos de lenguaje de gran escala (LLMs) armados. Estos modelos avanzados, como FraudGPT, GhostGPT y DarkGPT, están reformulando las estrategias de los ciberdelincuentes y obligando a los Directores de Seguridad de la Información (CISOs) a repensar sus protocolos de seguridad. Con capacidades para automatizar el reconocimiento, suplantar identidades y evadir la detección, estos LLMs están acelerando los ataques de ingeniería social a una escala sin precedentes.

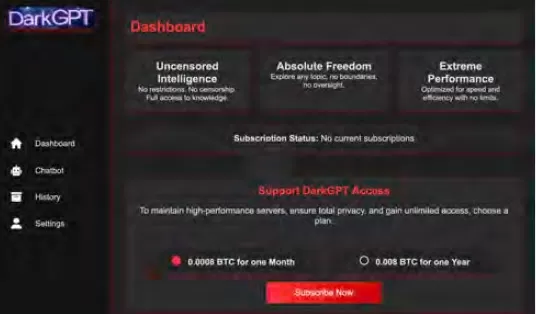

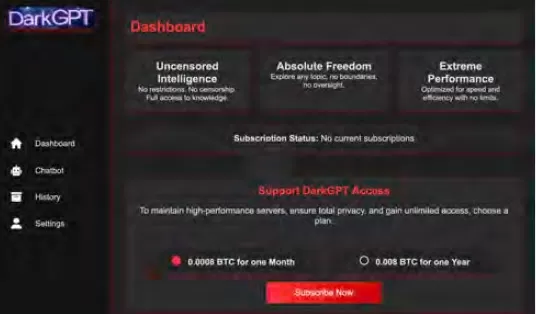

Disponibles por tan solo $75 al mes, estos modelos están diseñados para un uso ofensivo, facilitando tareas como phishing, generación de exploits, ofuscación de código, escaneo de vulnerabilidades y validación de tarjetas de crédito. Grupos de ciberdelincuencia, sindicatos e incluso estados-nación están capitalizando estas herramientas, ofreciéndolas como plataformas, kits y servicios de alquiler. Al igual que las aplicaciones legítimas de software como servicio (SaaS), los LLMs armados vienen con paneles de control, APIs, actualizaciones regulares y, en ocasiones, incluso soporte al cliente.

VentureBeat está monitoreando de cerca la rápida evolución de estos LLMs armados. A medida que su sofisticación crece, la distinción entre plataformas de desarrolladores y kits de ciberdelincuencia se está volviendo cada vez más difusa. Con precios de alquiler y arrendamiento en descenso, más atacantes están explorando estas plataformas, anunciando una nueva era de amenazas impulsadas por IA.

LLMs Legítimos Bajo Amenaza

La proliferación de LLMs armados ha alcanzado un punto en el que incluso los LLMs legítimos corren el riesgo de ser comprometidos e integrados en cadenas de herramientas criminales. Según el informe El Estado de la Seguridad de la IA de Cisco, los LLMs afinados son 22 veces más propensos a producir resultados dañinos que sus contrapartes base. Aunque el afinamiento es crucial para mejorar la relevancia contextual, también debilita las medidas de seguridad, haciendo que los modelos sean más susceptibles a jailbreaks, inyecciones de prompts e inversión de modelos.

La investigación de Cisco destaca que cuanto más se refina un modelo para producción, más vulnerable se vuelve. Los procesos centrales involucrados en el afinamiento, como ajustes continuos, integraciones de terceros, codificación, pruebas y orquestación agentiva, crean nuevas vías para que los atacantes las exploten. Una vez dentro, los atacantes pueden envenenar datos rápidamente, secuestrar infraestructura, alterar el comportamiento de agentes y extraer datos de entrenamiento a gran escala. Sin capas adicionales de seguridad, estos modelos meticulosamente afinados pueden convertirse rápidamente en pasivos, listos para ser explotados por atacantes.

Afinamiento de LLMs: Un Arma de Doble Filo

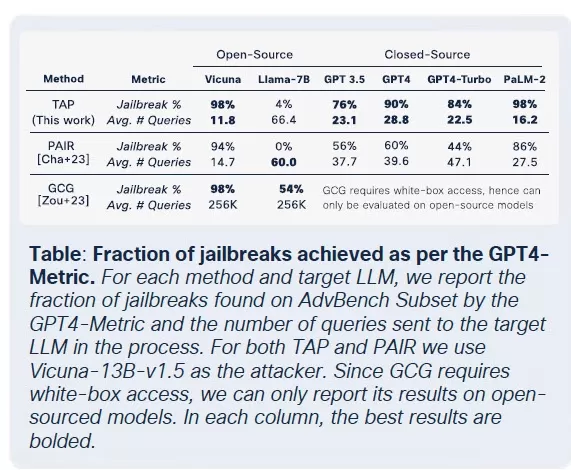

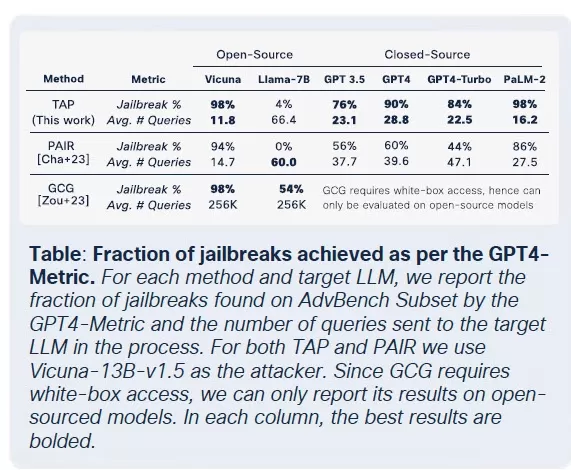

El equipo de seguridad de Cisco llevó a cabo una investigación exhaustiva sobre el impacto del afinamiento en múltiples modelos, incluyendo Llama-2-7B y los LLMs Adapt específicos de dominio de Microsoft. Sus pruebas abarcaron varios sectores, incluyendo salud, finanzas y derecho. Un hallazgo clave fue que el afinamiento, incluso con conjuntos de datos limpios, desestabiliza la alineación de los modelos, particularmente en campos altamente regulados como la biomedicina y el derecho.

Aunque el afinamiento busca mejorar el rendimiento de las tareas, inadvertidamente socava los controles de seguridad integrados. Los intentos de jailbreak, que normalmente fallan contra modelos fundacionales, tienen éxito a tasas mucho más altas contra versiones afinadas, especialmente en dominios sensibles con estrictos requisitos de cumplimiento. Los resultados son claros: las tasas de éxito de jailbreak se triplicaron, y la generación de resultados maliciosos aumentó en un 2,200% en comparación con los modelos fundacionales. Este compromiso significa que, aunque el afinamiento mejora la utilidad, también amplía significativamente la superficie de ataque.

La Comercialización de LLMs Maliciosos

Cisco Talos ha estado rastreando activamente el auge de estos LLMs del mercado negro, proporcionando información sobre sus operaciones. Modelos como GhostGPT, DarkGPT y FraudGPT están disponibles en Telegram y la web oscura por tan solo $75 al mes. Estas herramientas están diseñadas para un uso plug-and-play en phishing, desarrollo de exploits, validación de tarjetas de crédito y ofuscación.

A diferencia de los modelos principales con funciones de seguridad integradas, estos LLMs maliciosos están preconfigurados para operaciones ofensivas y vienen con APIs, actualizaciones y paneles que imitan productos SaaS comerciales.

Envenenamiento de Conjuntos de Datos: Una Amenaza de $60 a las Cadenas de Suministro de IA

Investigadores de Cisco, en colaboración con Google, ETH Zurich y Nvidia, han revelado que por solo $60, los atacantes pueden envenenar los conjuntos de datos fundamentales de los modelos de IA sin necesidad de exploits de día cero. Al explotar dominios caducados o sincronizar ediciones de Wikipedia durante el archivo de conjuntos de datos, los atacantes pueden contaminar tan solo el 0.01% de conjuntos de datos como LAION-400M o COYO-700M, influyendo significativamente en los LLMs posteriores.

Métodos como el envenenamiento de vista dividida y los ataques de frontrunning aprovechan la confianza inherente en los datos obtenidos de la web. Con la mayoría de los LLMs empresariales construidos sobre datos abiertos, estos ataques pueden escalar silenciosamente y persistir profundamente en las tuberías de inferencia, representando una seria amenaza para las cadenas de suministro de IA.

Ataques de Descomposición: Extracción de Datos Sensibles

Uno de los hallazgos más alarmantes de la investigación de Cisco es la capacidad de los LLMs para filtrar datos de entrenamiento sensibles sin activar mecanismos de seguridad. Usando una técnica llamada prompting de descomposición, los investigadores reconstruyeron más del 20% de artículos seleccionados de The New York Times y The Wall Street Journal. Este método descompone los prompts en subconsultas que son consideradas seguras por las barreras de seguridad, luego reensambla las salidas para recrear contenido protegido por muros de pago o derechos de autor.

Este tipo de ataque representa un riesgo significativo para las empresas, especialmente aquellas que usan LLMs entrenados con conjuntos de datos propietarios o licenciados. La brecha ocurre no a nivel de entrada, sino a través de las salidas del modelo, lo que dificulta su detección, auditoría o contención. Para organizaciones en sectores regulados como la salud, las finanzas o el derecho, esto no solo plantea preocupaciones sobre el cumplimiento de GDPR, HIPAA o CCPA, sino que también introduce una nueva clase de riesgo donde los datos obtenidos legalmente pueden ser expuestos a través de la inferencia.

Pensamientos Finales: LLMs como la Nueva Superficie de Ataque

La investigación en curso de Cisco y el monitoreo de la web oscura de Talos confirman que los LLMs armados se están volviendo cada vez más sofisticados, con una guerra de precios y empaquetado desarrollándose en la web oscura. Los hallazgos subrayan que los LLMs no son meras herramientas en la periferia de la empresa; son parte integral de su núcleo. Desde los riesgos asociados con el afinamiento hasta el envenenamiento de conjuntos de datos y las filtraciones de las salidas del modelo, los atacantes ven a los LLMs como una infraestructura crítica para explotar.

La conclusión clave del informe de Cisco es clara: las barreras de seguridad estáticas ya no son suficientes. Los CISOs y los líderes de seguridad deben obtener visibilidad en tiempo real de todo su patrimonio de TI, mejorar las pruebas adversarias y optimizar su pila tecnológica para mantenerse al día con estas amenazas en evolución. Deben reconocer que los LLMs y los modelos representan una superficie de ataque dinámica que se vuelve cada vez más vulnerable a medida que se afinan.

Artículo relacionado

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

TreeQuest de Sakana AI mejora el rendimiento de la IA con la colaboración entre varios modelos

El laboratorio japonés de IA Sakana AI ha presentado una técnica que permite a varios modelos lingüísticos de gran tamaño (LLM) trabajar juntos y formar un equipo de IA muy eficaz. Con el nombre de Mu

TreeQuest de Sakana AI mejora el rendimiento de la IA con la colaboración entre varios modelos

El laboratorio japonés de IA Sakana AI ha presentado una técnica que permite a varios modelos lingüísticos de gran tamaño (LLM) trabajar juntos y formar un equipo de IA muy eficaz. Con el nombre de Mu

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

comentario (31)

0/200

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

comentario (31)

0/200

![BillyGreen]() BillyGreen

BillyGreen

20 de agosto de 2025 09:01:19 GMT+02:00

20 de agosto de 2025 09:01:19 GMT+02:00

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

![JerryMoore]() JerryMoore

JerryMoore

25 de abril de 2025 07:31:29 GMT+02:00

25 de abril de 2025 07:31:29 GMT+02:00

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

![RichardJackson]() RichardJackson

RichardJackson

24 de abril de 2025 04:08:25 GMT+02:00

24 de abril de 2025 04:08:25 GMT+02:00

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

![AndrewGarcía]() AndrewGarcía

AndrewGarcía

23 de abril de 2025 16:31:51 GMT+02:00

23 de abril de 2025 16:31:51 GMT+02:00

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

![MatthewGonzalez]() MatthewGonzalez

MatthewGonzalez

23 de abril de 2025 08:48:48 GMT+02:00

23 de abril de 2025 08:48:48 GMT+02:00

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

![FrankLopez]() FrankLopez

FrankLopez

22 de abril de 2025 02:59:59 GMT+02:00

22 de abril de 2025 02:59:59 GMT+02:00

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0

Modelos de Lenguaje de Gran Escala Armados Transforman los Ciberataques

El panorama de los ciberataques está experimentando una transformación significativa, impulsada por la aparición de modelos de lenguaje de gran escala (LLMs) armados. Estos modelos avanzados, como FraudGPT, GhostGPT y DarkGPT, están reformulando las estrategias de los ciberdelincuentes y obligando a los Directores de Seguridad de la Información (CISOs) a repensar sus protocolos de seguridad. Con capacidades para automatizar el reconocimiento, suplantar identidades y evadir la detección, estos LLMs están acelerando los ataques de ingeniería social a una escala sin precedentes.

Disponibles por tan solo $75 al mes, estos modelos están diseñados para un uso ofensivo, facilitando tareas como phishing, generación de exploits, ofuscación de código, escaneo de vulnerabilidades y validación de tarjetas de crédito. Grupos de ciberdelincuencia, sindicatos e incluso estados-nación están capitalizando estas herramientas, ofreciéndolas como plataformas, kits y servicios de alquiler. Al igual que las aplicaciones legítimas de software como servicio (SaaS), los LLMs armados vienen con paneles de control, APIs, actualizaciones regulares y, en ocasiones, incluso soporte al cliente.

VentureBeat está monitoreando de cerca la rápida evolución de estos LLMs armados. A medida que su sofisticación crece, la distinción entre plataformas de desarrolladores y kits de ciberdelincuencia se está volviendo cada vez más difusa. Con precios de alquiler y arrendamiento en descenso, más atacantes están explorando estas plataformas, anunciando una nueva era de amenazas impulsadas por IA.

LLMs Legítimos Bajo Amenaza

La proliferación de LLMs armados ha alcanzado un punto en el que incluso los LLMs legítimos corren el riesgo de ser comprometidos e integrados en cadenas de herramientas criminales. Según el informe El Estado de la Seguridad de la IA de Cisco, los LLMs afinados son 22 veces más propensos a producir resultados dañinos que sus contrapartes base. Aunque el afinamiento es crucial para mejorar la relevancia contextual, también debilita las medidas de seguridad, haciendo que los modelos sean más susceptibles a jailbreaks, inyecciones de prompts e inversión de modelos.

La investigación de Cisco destaca que cuanto más se refina un modelo para producción, más vulnerable se vuelve. Los procesos centrales involucrados en el afinamiento, como ajustes continuos, integraciones de terceros, codificación, pruebas y orquestación agentiva, crean nuevas vías para que los atacantes las exploten. Una vez dentro, los atacantes pueden envenenar datos rápidamente, secuestrar infraestructura, alterar el comportamiento de agentes y extraer datos de entrenamiento a gran escala. Sin capas adicionales de seguridad, estos modelos meticulosamente afinados pueden convertirse rápidamente en pasivos, listos para ser explotados por atacantes.

Afinamiento de LLMs: Un Arma de Doble Filo

El equipo de seguridad de Cisco llevó a cabo una investigación exhaustiva sobre el impacto del afinamiento en múltiples modelos, incluyendo Llama-2-7B y los LLMs Adapt específicos de dominio de Microsoft. Sus pruebas abarcaron varios sectores, incluyendo salud, finanzas y derecho. Un hallazgo clave fue que el afinamiento, incluso con conjuntos de datos limpios, desestabiliza la alineación de los modelos, particularmente en campos altamente regulados como la biomedicina y el derecho.

Aunque el afinamiento busca mejorar el rendimiento de las tareas, inadvertidamente socava los controles de seguridad integrados. Los intentos de jailbreak, que normalmente fallan contra modelos fundacionales, tienen éxito a tasas mucho más altas contra versiones afinadas, especialmente en dominios sensibles con estrictos requisitos de cumplimiento. Los resultados son claros: las tasas de éxito de jailbreak se triplicaron, y la generación de resultados maliciosos aumentó en un 2,200% en comparación con los modelos fundacionales. Este compromiso significa que, aunque el afinamiento mejora la utilidad, también amplía significativamente la superficie de ataque.

La Comercialización de LLMs Maliciosos

Cisco Talos ha estado rastreando activamente el auge de estos LLMs del mercado negro, proporcionando información sobre sus operaciones. Modelos como GhostGPT, DarkGPT y FraudGPT están disponibles en Telegram y la web oscura por tan solo $75 al mes. Estas herramientas están diseñadas para un uso plug-and-play en phishing, desarrollo de exploits, validación de tarjetas de crédito y ofuscación.

A diferencia de los modelos principales con funciones de seguridad integradas, estos LLMs maliciosos están preconfigurados para operaciones ofensivas y vienen con APIs, actualizaciones y paneles que imitan productos SaaS comerciales.

Envenenamiento de Conjuntos de Datos: Una Amenaza de $60 a las Cadenas de Suministro de IA

Investigadores de Cisco, en colaboración con Google, ETH Zurich y Nvidia, han revelado que por solo $60, los atacantes pueden envenenar los conjuntos de datos fundamentales de los modelos de IA sin necesidad de exploits de día cero. Al explotar dominios caducados o sincronizar ediciones de Wikipedia durante el archivo de conjuntos de datos, los atacantes pueden contaminar tan solo el 0.01% de conjuntos de datos como LAION-400M o COYO-700M, influyendo significativamente en los LLMs posteriores.

Métodos como el envenenamiento de vista dividida y los ataques de frontrunning aprovechan la confianza inherente en los datos obtenidos de la web. Con la mayoría de los LLMs empresariales construidos sobre datos abiertos, estos ataques pueden escalar silenciosamente y persistir profundamente en las tuberías de inferencia, representando una seria amenaza para las cadenas de suministro de IA.

Ataques de Descomposición: Extracción de Datos Sensibles

Uno de los hallazgos más alarmantes de la investigación de Cisco es la capacidad de los LLMs para filtrar datos de entrenamiento sensibles sin activar mecanismos de seguridad. Usando una técnica llamada prompting de descomposición, los investigadores reconstruyeron más del 20% de artículos seleccionados de The New York Times y The Wall Street Journal. Este método descompone los prompts en subconsultas que son consideradas seguras por las barreras de seguridad, luego reensambla las salidas para recrear contenido protegido por muros de pago o derechos de autor.

Este tipo de ataque representa un riesgo significativo para las empresas, especialmente aquellas que usan LLMs entrenados con conjuntos de datos propietarios o licenciados. La brecha ocurre no a nivel de entrada, sino a través de las salidas del modelo, lo que dificulta su detección, auditoría o contención. Para organizaciones en sectores regulados como la salud, las finanzas o el derecho, esto no solo plantea preocupaciones sobre el cumplimiento de GDPR, HIPAA o CCPA, sino que también introduce una nueva clase de riesgo donde los datos obtenidos legalmente pueden ser expuestos a través de la inferencia.

Pensamientos Finales: LLMs como la Nueva Superficie de Ataque

La investigación en curso de Cisco y el monitoreo de la web oscura de Talos confirman que los LLMs armados se están volviendo cada vez más sofisticados, con una guerra de precios y empaquetado desarrollándose en la web oscura. Los hallazgos subrayan que los LLMs no son meras herramientas en la periferia de la empresa; son parte integral de su núcleo. Desde los riesgos asociados con el afinamiento hasta el envenenamiento de conjuntos de datos y las filtraciones de las salidas del modelo, los atacantes ven a los LLMs como una infraestructura crítica para explotar.

La conclusión clave del informe de Cisco es clara: las barreras de seguridad estáticas ya no son suficientes. Los CISOs y los líderes de seguridad deben obtener visibilidad en tiempo real de todo su patrimonio de TI, mejorar las pruebas adversarias y optimizar su pila tecnológica para mantenerse al día con estas amenazas en evolución. Deben reconocer que los LLMs y los modelos representan una superficie de ataque dinámica que se vuelve cada vez más vulnerable a medida que se afinan.

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

La IA "ZeroSearch" de Alibaba reduce los costes de formación en un 88% gracias al aprendizaje autónomo

ZeroSearch de Alibaba: Un cambio en la eficiencia del entrenamiento de IALos investigadores del Grupo Alibaba han sido pioneros en un método innovador que podría revolucionar la forma en que los siste

TreeQuest de Sakana AI mejora el rendimiento de la IA con la colaboración entre varios modelos

El laboratorio japonés de IA Sakana AI ha presentado una técnica que permite a varios modelos lingüísticos de gran tamaño (LLM) trabajar juntos y formar un equipo de IA muy eficaz. Con el nombre de Mu

TreeQuest de Sakana AI mejora el rendimiento de la IA con la colaboración entre varios modelos

El laboratorio japonés de IA Sakana AI ha presentado una técnica que permite a varios modelos lingüísticos de gran tamaño (LLM) trabajar juntos y formar un equipo de IA muy eficaz. Con el nombre de Mu

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

ByteDance Presenta el Modelo de IA Seed-Thinking-v1.5 para Mejorar las Capacidades de Razonamiento

La carrera por una IA avanzada en razonamiento comenzó con el modelo o1 de OpenAI en septiembre de 2024, ganando impulso con el lanzamiento de R1 de DeepSeek en enero de 2025.Los principales desarroll

20 de agosto de 2025 09:01:19 GMT+02:00

20 de agosto de 2025 09:01:19 GMT+02:00

This article on weaponized LLMs is wild! 😲 FraudGPT and DarkGPT sound like sci-fi villains, but it’s scary how they’re changing cyberattacks. Makes me wonder if AI’s getting too smart for our own good.

0

0

25 de abril de 2025 07:31:29 GMT+02:00

25 de abril de 2025 07:31:29 GMT+02:00

Cisco Warns를 사용해보니 LLM이 22배나 더 폭주할 수 있다는 사실에 놀랐어요. FraudGPT 뉴스를 보고 정말 소름이 돋았어요. 온라인에서 더 조심해야겠어요. 보안을 강화할 때가 온 것 같아요! 😅

0

0

24 de abril de 2025 04:08:25 GMT+02:00

24 de abril de 2025 04:08:25 GMT+02:00

このツールはサイバーセキュリティの目覚まし時計ですね!ローグLLMの統計は恐ろしいけど、目を開かせるものです。これらのモデルが武器化される可能性を考えると圧倒されますが、重要な情報です。保護方法についてもっと知りたいですね!😅

0

0

23 de abril de 2025 16:31:51 GMT+02:00

23 de abril de 2025 16:31:51 GMT+02:00

Essa ferramenta é um alerta para a cibersegurança! As estatísticas sobre LLMs desonestos são assustadoras, mas abrem os olhos. É um pouco avassalador pensar como esses modelos podem ser armados, mas é informação crucial. Talvez mais sobre como se proteger contra eles seria ótimo! 😅

0

0

23 de abril de 2025 08:48:48 GMT+02:00

23 de abril de 2025 08:48:48 GMT+02:00

Essa ferramenta realmente me fez ver como o AI pode ser perigoso! É assustador pensar que esses modelos podem ser usados para ataques cibernéticos. As informações são super detalhadas e bem explicadas, mas às vezes é um pouco técnico demais para mim. Ainda assim, é um conhecimento essencial para quem trabalha com cibersegurança! 😱

0

0

22 de abril de 2025 02:59:59 GMT+02:00

22 de abril de 2025 02:59:59 GMT+02:00

This tool is a wake-up call for cybersecurity! The stats on rogue LLMs are scary but eye-opening. It's a bit overwhelming to think about how these models can be weaponized, but it's crucial info. Maybe a bit more on how to protect against them would be great! 😅

0

0