TreeQuest de Sakana AI améliore les performances de l'IA grâce à la collaboration multi-modèle

Le laboratoire d'IA japonais Sakana AI a dévoilé une technique permettant à plusieurs grands modèles de langage (LLM) de travailler ensemble pour former une équipe d'IA très efficace. Baptisée Multi-LLM AB-MCTS, cette méthode permet aux modèles de faire des essais et des erreurs, en tirant parti de leurs forces uniques pour s'attaquer à des tâches complexes qui dépassent la portée d'un seul modèle.

Pour les entreprises, cette approche offre un moyen de construire des systèmes d'IA plus puissants. Au lieu de s'appuyer sur un seul fournisseur ou modèle, les entreprises peuvent exploiter de manière dynamique les forces de différents modèles frontières, en affectant la meilleure IA à chaque segment de tâche afin d'obtenir des résultats optimaux.

Exploiter l'intelligence collective

Les modèles d'IA d'avant-garde progressent rapidement, chacun présentant des forces et des faiblesses distinctes en fonction de ses données de formation et de sa conception. Un modèle peut briller en codage, un autre en écriture créative. L'équipe de Sakana AI considère ces différences comme des atouts et non comme des défauts.

"Nous considérons ces capacités uniques comme des outils précieux pour construire l'intelligence collective", indiquent les chercheurs dans leur blog. Selon eux, à l'instar des équipes humaines qui réalisent des percées grâce à la diversité, les systèmes d'IA peuvent accomplir davantage en collaborant. "En combinant leurs forces, les systèmes d'IA peuvent relever des défis qu'aucun modèle individuel ne pourrait surmonter.

Améliorer les performances en matière d'inférence

L'algorithme de Sakana AI, une technique de "mise à l'échelle du temps d'inférence" (également appelée "mise à l'échelle du temps de test"), gagne du terrain dans la recherche sur l'IA. Contrairement à la "mise à l'échelle du temps d'apprentissage", qui se concentre sur des modèles et des ensembles de données plus importants, la mise à l'échelle du temps d'inférence augmente les performances en optimisant les ressources informatiques après l'apprentissage.

Une méthode utilise l'apprentissage par renforcement pour encourager les modèles à produire des séquences détaillées de la chaîne de pensée (CoT), comme le montrent des modèles tels que OpenAI o3 et DeepSeek-R1. Une autre approche, l'échantillonnage répété, incite le modèle à générer plusieurs fois des solutions diverses, un peu comme un brainstorming. La méthode de Sakana AI affine ces concepts.

"Notre cadre améliore l'échantillonnage Best-of-N", a déclaré Takuya Akiba, chercheur chez Sakana AI et coauteur de l'article, dans une interview accordée à VentureBeat. "Il améliore les techniques de raisonnement telles que le CoT étendu via l'apprentissage par renforcement. En choisissant stratégiquement l'approche de recherche et le bon LLM, il optimise les performances dans des appels limités, excellant dans les tâches complexes."

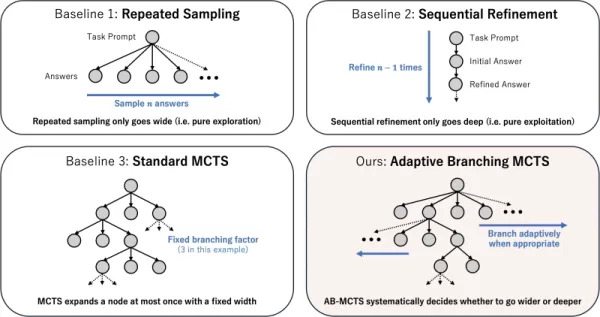

Fonctionnement de la recherche adaptative par branchement

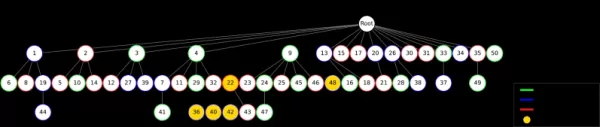

Le cœur de la technique est l'algorithme AB-MCTS (Adaptive Branching Monte Carlo Tree Search). Il permet aux LLM d'effectuer des essais et erreurs intelligents en équilibrant la "recherche en profondeur" (affiner une solution prometteuse) et la "recherche en largeur" (générer de nouvelles solutions). AB-MCTS combine ces stratégies, ce qui permet au système d'affiner les idées ou d'en trouver de nouvelles si nécessaire.

Il s'appuie sur la recherche arborescente de Monte Carlo (MCTS), un algorithme de prise de décision utilisé dans AlphaGo de DeepMind. AB-MCTS utilise des modèles de probabilité pour décider s'il faut affiner ou redémarrer à chaque étape.

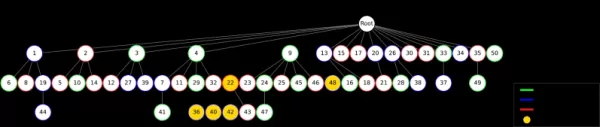

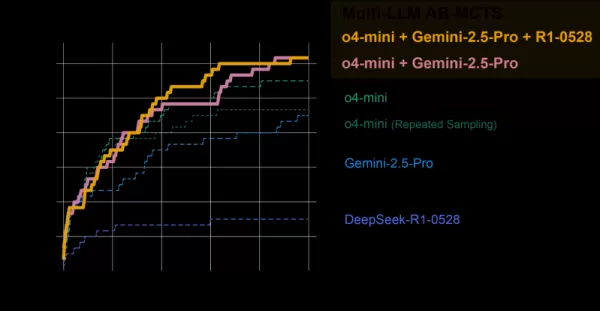

Différentes stratégies de mise à l'échelle du temps de test Source : Sakana AI Multi-LLM AB-MCTS va plus loin en décidant non seulement "quoi" faire (affiner ou générer) mais aussi "quel" LLM utiliser. Ignorant initialement quel est le meilleur modèle pour une tâche, le système teste un mélange de LLM, apprenant au fil du temps lesquels sont les plus performants et leur assignant plus de travail.

Test de l'équipe d'IA

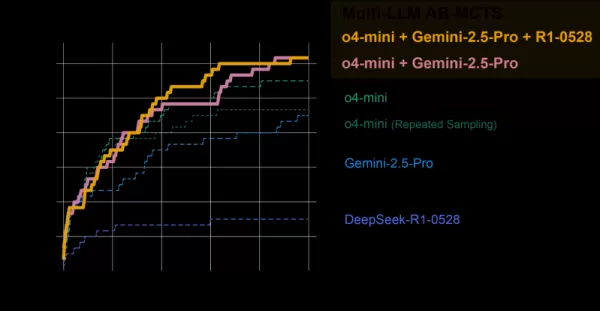

Le système AB-MCTS Multi-LLM a été évalué sur le benchmark ARC-AGI-2, qui teste le raisonnement visuel de type humain sur des problèmes nouveaux, un défi difficile à relever pour l'IA.

L'équipe a combiné des modèles d'avant-garde tels que o4-mini, Gemini 2.5 Pro et DeepSeek-R1.

Le groupe de modèles a résolu plus de 30 % des 120 problèmes testés, surpassant de loin les performances de n'importe quel modèle individuel. Le système a affecté dynamiquement le meilleur modèle pour chaque tâche, en identifiant rapidement le LLM le plus efficace lorsqu'il existe un chemin de solution clair.

AB-MCTS vs modèles individuels Source : Sakana AI De manière remarquable, le système a résolu des problèmes jusqu'alors insolubles avec un seul modèle. Dans un cas, une solution incorrecte de o4-mini a été affinée par DeepSeek-R1 et Gemini-2.5 Pro, qui ont corrigé l'erreur et fourni la bonne réponse.

"Cela montre que Multi-LLM AB-MCTS peut combiner des modèles d'avant-garde pour relever des défis auparavant insolubles, repoussant ainsi les limites de l'intelligence collective de l'IA", affirment les chercheurs.

AB-MTCS peut sélectionner différents modèles à différentes étapes de la résolution d'un problème Source : Sakana AI "Les forces et les tendances à l'hallucination de chaque modèle varient", note Akiba. "En associant des modèles dont les risques d'hallucination sont moindres, nous pouvons obtenir un raisonnement puissant et fiable, ce qui répond à une préoccupation essentielle des entreprises.

De la recherche à l'utilisation pratique

Sakana AI a publié TreeQuest, un cadre open-source sous licence Apache 2.0, qui permet aux développeurs et aux entreprises de mettre en œuvre Multi-LLM AB-MCTS. Son API flexible prend en charge la notation et la logique personnalisées pour diverses tâches.

"Nous sommes encore en train d'explorer AB-MCTS pour des défis commerciaux spécifiques, mais son potentiel est évident", a déclaré M. Akiba.

Au-delà du benchmark ARC-AGI-2, AB-MCTS a réussi dans des tâches telles que le codage complexe et l'amélioration de la précision des modèles d'apprentissage automatique.

"AB-MCTS excelle dans les tâches itératives d'essai et d'erreur, telles que l'optimisation des paramètres de performance des logiciels", a ajouté M. Akiba. "Par exemple, il pourrait réduire automatiquement le temps de réponse des services web.

Cet outil open-source pourrait permettre la création d'une nouvelle génération d'applications d'IA d'entreprise robustes et fiables.

Article connexe

Le MIT dévoile un cadre d'auto-apprentissage de l'IA qui va au-delà des modèles statiques

Des chercheurs du MIT à l'origine d'un cadre d'auto-apprentissage de l'IAUne équipe du MIT a mis au point un système innovant appelé SEAL (Self-Adapting Language Models) qui permet à de grands modèles

Le MIT dévoile un cadre d'auto-apprentissage de l'IA qui va au-delà des modèles statiques

Des chercheurs du MIT à l'origine d'un cadre d'auto-apprentissage de l'IAUne équipe du MIT a mis au point un système innovant appelé SEAL (Self-Adapting Language Models) qui permet à de grands modèles

Multiverse AI lance des modèles miniatures haute performance révolutionnaires

Une startup européenne pionnière dans le domaine de l'intelligence artificielle a dévoilé des modèles d'intelligence artificielle révolutionnaires de très petite taille, nommés d'après des cerveaux d'

Multiverse AI lance des modèles miniatures haute performance révolutionnaires

Une startup européenne pionnière dans le domaine de l'intelligence artificielle a dévoilé des modèles d'intelligence artificielle révolutionnaires de très petite taille, nommés d'après des cerveaux d'

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa

commentaires (0)

0/200

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa

commentaires (0)

0/200

Le laboratoire d'IA japonais Sakana AI a dévoilé une technique permettant à plusieurs grands modèles de langage (LLM) de travailler ensemble pour former une équipe d'IA très efficace. Baptisée Multi-LLM AB-MCTS, cette méthode permet aux modèles de faire des essais et des erreurs, en tirant parti de leurs forces uniques pour s'attaquer à des tâches complexes qui dépassent la portée d'un seul modèle.

Pour les entreprises, cette approche offre un moyen de construire des systèmes d'IA plus puissants. Au lieu de s'appuyer sur un seul fournisseur ou modèle, les entreprises peuvent exploiter de manière dynamique les forces de différents modèles frontières, en affectant la meilleure IA à chaque segment de tâche afin d'obtenir des résultats optimaux.

Exploiter l'intelligence collective

Les modèles d'IA d'avant-garde progressent rapidement, chacun présentant des forces et des faiblesses distinctes en fonction de ses données de formation et de sa conception. Un modèle peut briller en codage, un autre en écriture créative. L'équipe de Sakana AI considère ces différences comme des atouts et non comme des défauts.

"Nous considérons ces capacités uniques comme des outils précieux pour construire l'intelligence collective", indiquent les chercheurs dans leur blog. Selon eux, à l'instar des équipes humaines qui réalisent des percées grâce à la diversité, les systèmes d'IA peuvent accomplir davantage en collaborant. "En combinant leurs forces, les systèmes d'IA peuvent relever des défis qu'aucun modèle individuel ne pourrait surmonter.

Améliorer les performances en matière d'inférence

L'algorithme de Sakana AI, une technique de "mise à l'échelle du temps d'inférence" (également appelée "mise à l'échelle du temps de test"), gagne du terrain dans la recherche sur l'IA. Contrairement à la "mise à l'échelle du temps d'apprentissage", qui se concentre sur des modèles et des ensembles de données plus importants, la mise à l'échelle du temps d'inférence augmente les performances en optimisant les ressources informatiques après l'apprentissage.

Une méthode utilise l'apprentissage par renforcement pour encourager les modèles à produire des séquences détaillées de la chaîne de pensée (CoT), comme le montrent des modèles tels que OpenAI o3 et DeepSeek-R1. Une autre approche, l'échantillonnage répété, incite le modèle à générer plusieurs fois des solutions diverses, un peu comme un brainstorming. La méthode de Sakana AI affine ces concepts.

"Notre cadre améliore l'échantillonnage Best-of-N", a déclaré Takuya Akiba, chercheur chez Sakana AI et coauteur de l'article, dans une interview accordée à VentureBeat. "Il améliore les techniques de raisonnement telles que le CoT étendu via l'apprentissage par renforcement. En choisissant stratégiquement l'approche de recherche et le bon LLM, il optimise les performances dans des appels limités, excellant dans les tâches complexes."

Fonctionnement de la recherche adaptative par branchement

Le cœur de la technique est l'algorithme AB-MCTS (Adaptive Branching Monte Carlo Tree Search). Il permet aux LLM d'effectuer des essais et erreurs intelligents en équilibrant la "recherche en profondeur" (affiner une solution prometteuse) et la "recherche en largeur" (générer de nouvelles solutions). AB-MCTS combine ces stratégies, ce qui permet au système d'affiner les idées ou d'en trouver de nouvelles si nécessaire.

Il s'appuie sur la recherche arborescente de Monte Carlo (MCTS), un algorithme de prise de décision utilisé dans AlphaGo de DeepMind. AB-MCTS utilise des modèles de probabilité pour décider s'il faut affiner ou redémarrer à chaque étape.

Multi-LLM AB-MCTS va plus loin en décidant non seulement "quoi" faire (affiner ou générer) mais aussi "quel" LLM utiliser. Ignorant initialement quel est le meilleur modèle pour une tâche, le système teste un mélange de LLM, apprenant au fil du temps lesquels sont les plus performants et leur assignant plus de travail.

Test de l'équipe d'IA

Le système AB-MCTS Multi-LLM a été évalué sur le benchmark ARC-AGI-2, qui teste le raisonnement visuel de type humain sur des problèmes nouveaux, un défi difficile à relever pour l'IA.

L'équipe a combiné des modèles d'avant-garde tels que o4-mini, Gemini 2.5 Pro et DeepSeek-R1.

Le groupe de modèles a résolu plus de 30 % des 120 problèmes testés, surpassant de loin les performances de n'importe quel modèle individuel. Le système a affecté dynamiquement le meilleur modèle pour chaque tâche, en identifiant rapidement le LLM le plus efficace lorsqu'il existe un chemin de solution clair.

De manière remarquable, le système a résolu des problèmes jusqu'alors insolubles avec un seul modèle. Dans un cas, une solution incorrecte de o4-mini a été affinée par DeepSeek-R1 et Gemini-2.5 Pro, qui ont corrigé l'erreur et fourni la bonne réponse.

"Cela montre que Multi-LLM AB-MCTS peut combiner des modèles d'avant-garde pour relever des défis auparavant insolubles, repoussant ainsi les limites de l'intelligence collective de l'IA", affirment les chercheurs.

"Les forces et les tendances à l'hallucination de chaque modèle varient", note Akiba. "En associant des modèles dont les risques d'hallucination sont moindres, nous pouvons obtenir un raisonnement puissant et fiable, ce qui répond à une préoccupation essentielle des entreprises.

De la recherche à l'utilisation pratique

Sakana AI a publié TreeQuest, un cadre open-source sous licence Apache 2.0, qui permet aux développeurs et aux entreprises de mettre en œuvre Multi-LLM AB-MCTS. Son API flexible prend en charge la notation et la logique personnalisées pour diverses tâches.

"Nous sommes encore en train d'explorer AB-MCTS pour des défis commerciaux spécifiques, mais son potentiel est évident", a déclaré M. Akiba.

Au-delà du benchmark ARC-AGI-2, AB-MCTS a réussi dans des tâches telles que le codage complexe et l'amélioration de la précision des modèles d'apprentissage automatique.

"AB-MCTS excelle dans les tâches itératives d'essai et d'erreur, telles que l'optimisation des paramètres de performance des logiciels", a ajouté M. Akiba. "Par exemple, il pourrait réduire automatiquement le temps de réponse des services web.

Cet outil open-source pourrait permettre la création d'une nouvelle génération d'applications d'IA d'entreprise robustes et fiables.

Le MIT dévoile un cadre d'auto-apprentissage de l'IA qui va au-delà des modèles statiques

Des chercheurs du MIT à l'origine d'un cadre d'auto-apprentissage de l'IAUne équipe du MIT a mis au point un système innovant appelé SEAL (Self-Adapting Language Models) qui permet à de grands modèles

Le MIT dévoile un cadre d'auto-apprentissage de l'IA qui va au-delà des modèles statiques

Des chercheurs du MIT à l'origine d'un cadre d'auto-apprentissage de l'IAUne équipe du MIT a mis au point un système innovant appelé SEAL (Self-Adapting Language Models) qui permet à de grands modèles

Multiverse AI lance des modèles miniatures haute performance révolutionnaires

Une startup européenne pionnière dans le domaine de l'intelligence artificielle a dévoilé des modèles d'intelligence artificielle révolutionnaires de très petite taille, nommés d'après des cerveaux d'

Multiverse AI lance des modèles miniatures haute performance révolutionnaires

Une startup européenne pionnière dans le domaine de l'intelligence artificielle a dévoilé des modèles d'intelligence artificielle révolutionnaires de très petite taille, nommés d'après des cerveaux d'

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa

Une étude de Microsoft révèle qu'un plus grand nombre de jetons d'IA augmente les erreurs de raisonnement

Nouvelles perspectives sur l'efficacité du raisonnement dans les LLMDe nouvelles recherches menées par Microsoft démontrent que les techniques de raisonnement avancées dans les grands modèles de langa