AI Computing para consumir la potencia de múltiples NYC para 2026, dice el fundador

Nvidia y socios amplían centros de datos de IA a nivel mundial

Nvidia, junto con sus socios y clientes, ha estado expandiendo activamente el tamaño de las instalaciones informáticas en todo el mundo para satisfacer las altas demandas computacionales de entrenar modelos masivos de inteligencia artificial (IA) como GPT-4. Esta expansión se volverá aún más crucial a medida que se implementen más modelos de IA en producción, según Thomas Graham, cofundador de la startup de computación óptica Lightmatter. En una reciente entrevista en Nueva York con Mandeep Singh, analista senior de tecnología de Bloomberg Intelligence, Graham destacó la creciente necesidad de recursos computacionales.

"La demanda de más capacidad de cómputo no se trata solo de leyes de escalado; también se trata de implementar estos modelos de IA ahora," explicó Graham. Singh preguntó sobre el futuro de los modelos de lenguaje de gran escala (LLMs) como GPT-4 y si seguirían creciendo en tamaño. En respuesta, Graham cambió el enfoque hacia la aplicación práctica de la IA, enfatizando la importancia de la inferencia, o la fase de implementación, que requiere un poder computacional sustancial.

"Si consideras el entrenamiento como I+D, la inferencia es esencialmente la implementación. A medida que implementas, necesitarás computadoras de gran escala para ejecutar tus modelos," afirmó Graham durante la conferencia "Gen AI: ¿Puede cumplir con la promesa de productividad?" organizada por Bloomberg Intelligence.

La perspectiva de Graham coincide con la del CEO de Nvidia, Jensen Huang, quien ha enfatizado a Wall Street que avanzar en formas de IA "agentic" requerirá no solo un entrenamiento más sofisticado, sino también capacidades de inferencia significativamente mejoradas, lo que resultará en un aumento exponencial en los requisitos de cómputo.

"Si ves el entrenamiento como I+D, la inferencia es realmente la implementación, y a medida que implementas eso, vas a necesitar computadoras grandes para ejecutar tus modelos," dijo Graham. Foto: Bloomberg, cortesía de Craig Warga El papel de Lightmatter en la infraestructura de IA

Fundada en 2018, Lightmatter está a la vanguardia del desarrollo de tecnología de chips que utiliza conexiones ópticas para vincular múltiples procesadores en un solo dado semiconductor. Estas interconexiones ópticas pueden transferir datos de manera más eficiente que los cables de cobre tradicionales, utilizando menos energía. Esta tecnología puede optimizar las conexiones dentro y entre los racks de los centros de datos, mejorando la eficiencia general y la economía del centro de datos, según Graham.

"Al reemplazar las trazas de cobre en los centros de datos, tanto en la placa de circuito impreso del servidor como en el cableado entre racks, con fibra óptica, podemos aumentar drásticamente el ancho de banda," dijo Graham a Singh. Lightmatter está colaborando actualmente con varias empresas tecnológicas en el diseño de nuevos centros de datos, y Graham señaló que estas instalaciones se están construyendo desde cero. La compañía ya ha establecido una asociación con Global Foundries, un fabricante de semiconductores por contrato con operaciones en el norte de Nueva York, que atiende a clientes como Advanced Micro Devices.

Aunque Graham no reveló socios ni clientes específicos más allá de esta colaboración, insinuó que Lightmatter trabaja con proveedores de silicio como Broadcom o Marvell para crear componentes personalizados para gigantes tecnológicos como Google, Amazon y Microsoft, que diseñan sus propios procesadores para centros de datos.

La escala y el futuro de los centros de datos de IA

Para ilustrar la magnitud de la implementación de IA, Graham señaló que al menos una docena de nuevos centros de datos de IA están planificados o en construcción, cada uno requiriendo un gigavatio de energía. "Para contextualizar, la ciudad de Nueva York usa alrededor de cinco gigavatios de energía en un día promedio. Así que, estamos hablando del consumo de energía de múltiples ciudades de Nueva York," dijo. Predice que para 2026, el procesamiento global de IA demandará 40 gigavatios de energía, equivalente a ocho ciudades de Nueva York, específicamente para centros de datos de IA.

Lightmatter recientemente aseguró una inversión de capital de riesgo de $400 millones, valorando a la compañía en $4.4 mil millones. Graham mencionó que la compañía planea comenzar la producción "en los próximos años."

Cuando se le preguntó sobre posibles interrupciones en los planes de Lightmatter, Graham expresó confianza en la necesidad continua de expandir la infraestructura de cómputo de IA. Sin embargo, reconoció que un avance en los algoritmos de IA que requiera significativamente menos cómputo o que logre una inteligencia general artificial (AGI) más rápidamente podría desafiar las suposiciones actuales sobre la necesidad de un crecimiento exponencial del cómputo.

Artículo relacionado

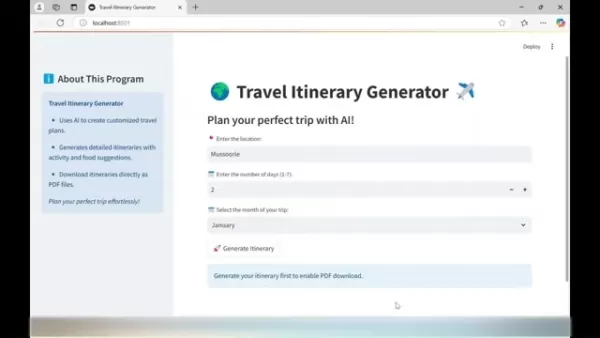

Un generador de itinerarios de viaje basado en inteligencia artificial le ayuda a planificar el viaje perfecto

Planificar viajes inolvidables es ahora más sencillo gracias a la avanzada tecnología de IA. El generador de itinerarios de viaje revoluciona la planificación de las vacaciones creando guías de viaje

Un generador de itinerarios de viaje basado en inteligencia artificial le ayuda a planificar el viaje perfecto

Planificar viajes inolvidables es ahora más sencillo gracias a la avanzada tecnología de IA. El generador de itinerarios de viaje revoluciona la planificación de las vacaciones creando guías de viaje

Apple Vision Pro debuta como revolucionario en realidad aumentada

Apple da un gran salto hacia la computación espacial con sus revolucionarios auriculares Vision Pro, que redefinen las posibilidades de las experiencias de realidad virtual y aumentada gracias a una i

Apple Vision Pro debuta como revolucionario en realidad aumentada

Apple da un gran salto hacia la computación espacial con sus revolucionarios auriculares Vision Pro, que redefinen las posibilidades de las experiencias de realidad virtual y aumentada gracias a una i

Perplexity AI Shopping Assistant transforma la experiencia de compra en línea

Perplexity AI está causando sensación en el comercio electrónico con su revolucionario asistente de compras de IA, preparado para transformar la forma en que los consumidores descubren y compran produ

comentario (31)

0/200

Perplexity AI Shopping Assistant transforma la experiencia de compra en línea

Perplexity AI está causando sensación en el comercio electrónico con su revolucionario asistente de compras de IA, preparado para transformar la forma en que los consumidores descubren y compran produ

comentario (31)

0/200

![ScottMitchell]() ScottMitchell

ScottMitchell

18 de agosto de 2025 03:01:03 GMT+02:00

18 de agosto de 2025 03:01:03 GMT+02:00

Mind-blowing how AI's eating up power like a sci-fi monster! 😱 By 2026, it'll need multiple NYCs' worth of electricity? Hope they figure out sustainable energy fast, or we’re all in for a wild ride.

0

0

![BillyEvans]() BillyEvans

BillyEvans

20 de abril de 2025 11:23:59 GMT+02:00

20 de abril de 2025 11:23:59 GMT+02:00

¡Para 2026, la IA consumirá energía como varias ciudades de Nueva York! ¡Es una locura! 😱 Me encanta el progreso tecnológico, pero también tenemos que pensar en el medio ambiente. ¡Ojalá encuentren una forma más ecológica! 🌿

0

0

![PeterRodriguez]() PeterRodriguez

PeterRodriguez

20 de abril de 2025 08:07:12 GMT+02:00

20 de abril de 2025 08:07:12 GMT+02:00

Wow, AI data centers eating up that much power by 2026? 😲 That’s wild! Makes me wonder if we’re ready for the energy bill or if renewables can keep up.

0

0

![JackAllen]() JackAllen

JackAllen

20 de abril de 2025 07:11:07 GMT+02:00

20 de abril de 2025 07:11:07 GMT+02:00

AI所需的计算能力真是令人难以置信。到2026年,它将相当于多个纽约市的总和。这太疯狂了!希望我们能找到更有效的能源管理方式。

0

0

![GeorgeJones]() GeorgeJones

GeorgeJones

20 de abril de 2025 06:57:20 GMT+02:00

20 de abril de 2025 06:57:20 GMT+02:00

AI가 여러 뉴욕 시의 전력을 소비한다는 생각은 좀 무섭네요! 하지만 진보를 위한 대가라고 생각해요. Nvidia의 확장은 인상적이지만, 에너지 수요에 따라갈 수 있을까요? 🤔 더 많은 태양광 패널이 필요할지도 모르겠어요!

0

0

![TerryYoung]() TerryYoung

TerryYoung

20 de abril de 2025 02:05:08 GMT+02:00

20 de abril de 2025 02:05:08 GMT+02:00

This AI expansion sounds insane! By 2026, the power consumption could match multiple New York Cities? That's wild! I'm excited to see what kind of AI models they'll be training, but also kinda worried about the environmental impact. Can't wait to see how this pans out! 🤯

0

0

Nvidia y socios amplían centros de datos de IA a nivel mundial

Nvidia, junto con sus socios y clientes, ha estado expandiendo activamente el tamaño de las instalaciones informáticas en todo el mundo para satisfacer las altas demandas computacionales de entrenar modelos masivos de inteligencia artificial (IA) como GPT-4. Esta expansión se volverá aún más crucial a medida que se implementen más modelos de IA en producción, según Thomas Graham, cofundador de la startup de computación óptica Lightmatter. En una reciente entrevista en Nueva York con Mandeep Singh, analista senior de tecnología de Bloomberg Intelligence, Graham destacó la creciente necesidad de recursos computacionales.

"La demanda de más capacidad de cómputo no se trata solo de leyes de escalado; también se trata de implementar estos modelos de IA ahora," explicó Graham. Singh preguntó sobre el futuro de los modelos de lenguaje de gran escala (LLMs) como GPT-4 y si seguirían creciendo en tamaño. En respuesta, Graham cambió el enfoque hacia la aplicación práctica de la IA, enfatizando la importancia de la inferencia, o la fase de implementación, que requiere un poder computacional sustancial.

"Si consideras el entrenamiento como I+D, la inferencia es esencialmente la implementación. A medida que implementas, necesitarás computadoras de gran escala para ejecutar tus modelos," afirmó Graham durante la conferencia "Gen AI: ¿Puede cumplir con la promesa de productividad?" organizada por Bloomberg Intelligence.

La perspectiva de Graham coincide con la del CEO de Nvidia, Jensen Huang, quien ha enfatizado a Wall Street que avanzar en formas de IA "agentic" requerirá no solo un entrenamiento más sofisticado, sino también capacidades de inferencia significativamente mejoradas, lo que resultará en un aumento exponencial en los requisitos de cómputo.

El papel de Lightmatter en la infraestructura de IA

Fundada en 2018, Lightmatter está a la vanguardia del desarrollo de tecnología de chips que utiliza conexiones ópticas para vincular múltiples procesadores en un solo dado semiconductor. Estas interconexiones ópticas pueden transferir datos de manera más eficiente que los cables de cobre tradicionales, utilizando menos energía. Esta tecnología puede optimizar las conexiones dentro y entre los racks de los centros de datos, mejorando la eficiencia general y la economía del centro de datos, según Graham.

"Al reemplazar las trazas de cobre en los centros de datos, tanto en la placa de circuito impreso del servidor como en el cableado entre racks, con fibra óptica, podemos aumentar drásticamente el ancho de banda," dijo Graham a Singh. Lightmatter está colaborando actualmente con varias empresas tecnológicas en el diseño de nuevos centros de datos, y Graham señaló que estas instalaciones se están construyendo desde cero. La compañía ya ha establecido una asociación con Global Foundries, un fabricante de semiconductores por contrato con operaciones en el norte de Nueva York, que atiende a clientes como Advanced Micro Devices.

Aunque Graham no reveló socios ni clientes específicos más allá de esta colaboración, insinuó que Lightmatter trabaja con proveedores de silicio como Broadcom o Marvell para crear componentes personalizados para gigantes tecnológicos como Google, Amazon y Microsoft, que diseñan sus propios procesadores para centros de datos.

La escala y el futuro de los centros de datos de IA

Para ilustrar la magnitud de la implementación de IA, Graham señaló que al menos una docena de nuevos centros de datos de IA están planificados o en construcción, cada uno requiriendo un gigavatio de energía. "Para contextualizar, la ciudad de Nueva York usa alrededor de cinco gigavatios de energía en un día promedio. Así que, estamos hablando del consumo de energía de múltiples ciudades de Nueva York," dijo. Predice que para 2026, el procesamiento global de IA demandará 40 gigavatios de energía, equivalente a ocho ciudades de Nueva York, específicamente para centros de datos de IA.

Lightmatter recientemente aseguró una inversión de capital de riesgo de $400 millones, valorando a la compañía en $4.4 mil millones. Graham mencionó que la compañía planea comenzar la producción "en los próximos años."

Cuando se le preguntó sobre posibles interrupciones en los planes de Lightmatter, Graham expresó confianza en la necesidad continua de expandir la infraestructura de cómputo de IA. Sin embargo, reconoció que un avance en los algoritmos de IA que requiera significativamente menos cómputo o que logre una inteligencia general artificial (AGI) más rápidamente podría desafiar las suposiciones actuales sobre la necesidad de un crecimiento exponencial del cómputo.

Un generador de itinerarios de viaje basado en inteligencia artificial le ayuda a planificar el viaje perfecto

Planificar viajes inolvidables es ahora más sencillo gracias a la avanzada tecnología de IA. El generador de itinerarios de viaje revoluciona la planificación de las vacaciones creando guías de viaje

Un generador de itinerarios de viaje basado en inteligencia artificial le ayuda a planificar el viaje perfecto

Planificar viajes inolvidables es ahora más sencillo gracias a la avanzada tecnología de IA. El generador de itinerarios de viaje revoluciona la planificación de las vacaciones creando guías de viaje

Apple Vision Pro debuta como revolucionario en realidad aumentada

Apple da un gran salto hacia la computación espacial con sus revolucionarios auriculares Vision Pro, que redefinen las posibilidades de las experiencias de realidad virtual y aumentada gracias a una i

Apple Vision Pro debuta como revolucionario en realidad aumentada

Apple da un gran salto hacia la computación espacial con sus revolucionarios auriculares Vision Pro, que redefinen las posibilidades de las experiencias de realidad virtual y aumentada gracias a una i

Perplexity AI Shopping Assistant transforma la experiencia de compra en línea

Perplexity AI está causando sensación en el comercio electrónico con su revolucionario asistente de compras de IA, preparado para transformar la forma en que los consumidores descubren y compran produ

Perplexity AI Shopping Assistant transforma la experiencia de compra en línea

Perplexity AI está causando sensación en el comercio electrónico con su revolucionario asistente de compras de IA, preparado para transformar la forma en que los consumidores descubren y compran produ

18 de agosto de 2025 03:01:03 GMT+02:00

18 de agosto de 2025 03:01:03 GMT+02:00

Mind-blowing how AI's eating up power like a sci-fi monster! 😱 By 2026, it'll need multiple NYCs' worth of electricity? Hope they figure out sustainable energy fast, or we’re all in for a wild ride.

0

0

20 de abril de 2025 11:23:59 GMT+02:00

20 de abril de 2025 11:23:59 GMT+02:00

¡Para 2026, la IA consumirá energía como varias ciudades de Nueva York! ¡Es una locura! 😱 Me encanta el progreso tecnológico, pero también tenemos que pensar en el medio ambiente. ¡Ojalá encuentren una forma más ecológica! 🌿

0

0

20 de abril de 2025 08:07:12 GMT+02:00

20 de abril de 2025 08:07:12 GMT+02:00

Wow, AI data centers eating up that much power by 2026? 😲 That’s wild! Makes me wonder if we’re ready for the energy bill or if renewables can keep up.

0

0

20 de abril de 2025 07:11:07 GMT+02:00

20 de abril de 2025 07:11:07 GMT+02:00

AI所需的计算能力真是令人难以置信。到2026年,它将相当于多个纽约市的总和。这太疯狂了!希望我们能找到更有效的能源管理方式。

0

0

20 de abril de 2025 06:57:20 GMT+02:00

20 de abril de 2025 06:57:20 GMT+02:00

AI가 여러 뉴욕 시의 전력을 소비한다는 생각은 좀 무섭네요! 하지만 진보를 위한 대가라고 생각해요. Nvidia의 확장은 인상적이지만, 에너지 수요에 따라갈 수 있을까요? 🤔 더 많은 태양광 패널이 필요할지도 모르겠어요!

0

0

20 de abril de 2025 02:05:08 GMT+02:00

20 de abril de 2025 02:05:08 GMT+02:00

This AI expansion sounds insane! By 2026, the power consumption could match multiple New York Cities? That's wild! I'm excited to see what kind of AI models they'll be training, but also kinda worried about the environmental impact. Can't wait to see how this pans out! 🤯

0

0