ByteDance представляет модель ИИ Seed-Thinking-v1.5 для усиления способностей к рассуждению

Гонка за продвинутыми ИИ с функцией рассуждения началась с модели o1 от OpenAI в сентябре 2024 года, набрав обороты с запуском R1 от DeepSeek в январе 2025 года.

Крупные разработчики ИИ соревнуются в создании более быстрых и экономичных моделей ИИ с функцией рассуждения, обеспечивающих точные, продуманные ответы через процессы цепочки мыслей, гарантируя точность перед ответом.

ByteDance, материнская компания TikTok, вступила в борьбу с Seed-Thinking-v1.5, новой большой языковой моделью (LLM), описанной в техническом документе, направленной на улучшение рассуждений в STEM и общих областях.

Модель пока недоступна, а её лицензирование — проприетарное, с открытым исходным кодом или гибридное — остаётся нераскрытым. Однако документ предоставляет ключевые идеи, которые стоит изучить перед её выпуском.

Использование архитектуры Mixture-of-Experts (MoE)

Следуя за Llama 4 от Meta и Mixtral от Mistral, Seed-Thinking-v1.5 использует архитектуру Mixture-of-Experts (MoE).

Этот подход повышает эффективность за счёт интеграции нескольких специализированных моделей в одну, каждая из которых сосредоточена на отдельных областях.

Seed-Thinking-v1.5 использует только 20 миллиардов из своих 200 миллиардов параметров одновременно, оптимизируя производительность.

Документ, опубликованный ByteDance на GitHub, подчёркивает фокус модели на структурированном рассуждении и осознанном создании ответов.

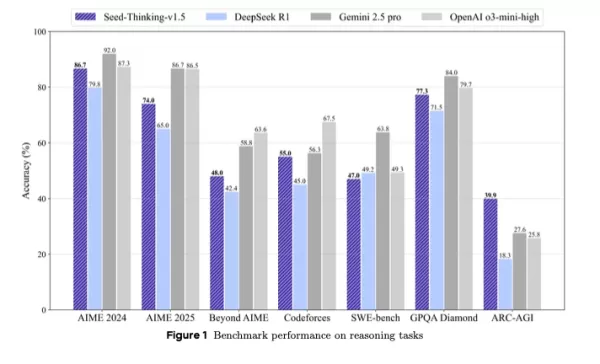

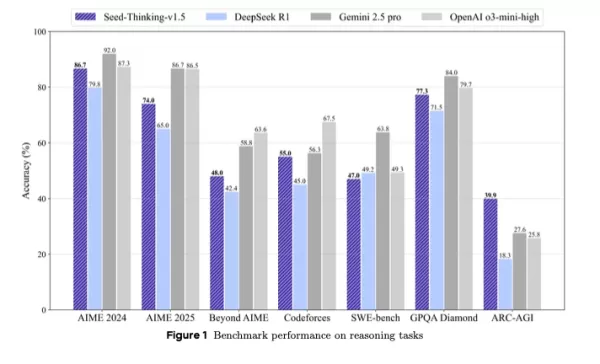

Она превосходит DeepSeek R1 и конкурирует с Gemini 2.5 Pro от Google и o3-mini-high от OpenAI в сторонних тестах, даже опережая их в тесте ARC-AGI, ключевом показателе прогресса к искусственному общему интеллекту, превышающем человеческую производительность в экономически ценных задачах, согласно стандартам OpenAI.

Позиционируемая как компактная, но мощная альтернатива крупным моделям, Seed-Thinking-v1.5 демонстрирует высокие результаты в тестах благодаря инновационному обучению с подкреплением, тщательно подобранным обучающим данным и передовой инфраструктуре ИИ.

Производительность в тестах и ключевые сильные стороны

Seed-Thinking-v1.5 превосходит в сложных задачах, набирая 86,7% на AIME 2024, 55,0% pass@8 на Codeforces и 77,3% на научном тесте GPQA, почти соответствуя или превосходя модели, такие как o3-mini-high от OpenAI и Gemini 2.5 Pro от Google, в метриках рассуждения.

В задачах, не связанных с рассуждением, она достигла на 8,0% более высокого уровня предпочтения людей по сравнению с DeepSeek R1, демонстрируя универсальность за пределами логики и математики.

Для борьбы с насыщением тестов ByteDance создала BeyondAIME, более сложный математический тест, устойчивый к запоминанию и лучше оценивающий производительность модели. Этот тест, вместе с набором Codeforces, будет публично выпущен для поддержки будущих исследований.

Подход к обучающим данным

Качество данных сыграло ключевую роль в разработке Seed-Thinking-v1.5. Для контролируемой тонкой настройки было отобрано 400 000 образцов: 300 000 проверяемых задач по STEM, логике и программированию и 100 000 непроверяемых задач, таких как творческое письмо.

Для обучения с подкреплением данные были разделены на:

- Проверяемые задачи: 100 000 тщательно отобранных вопросов по STEM и логических головоломок из элитных соревнований, проверенных экспертами.

- Непроверяемые задачи: Наборы данных с предпочтениями людей для открытых запросов, оценённых через парные модели вознаграждения.

Более 80% данных STEM сосредоточены на продвинутой математике, с логическими задачами, такими как судоку и головоломки на 24 очка, масштабированными для соответствия прогрессу модели.

Инновации в обучении с подкреплением

Seed-Thinking-v1.5 использует пользовательские фреймворки actor-critic (VAPO) и policy-gradient (DAPO) для стабилизации обучения с подкреплением, решая проблемы в длинных сценариях цепочки мыслей.

Две модели вознаграждения улучшают контроль RL:

- Seed-Verifier: Основанная на правилах LLM, обеспечивающая математическую эквивалентность между сгенерированными и эталонными ответами.

- Seed-Thinking-Verifier: Судья, основанный на рассуждениях, для последовательной оценки, устойчивый к манипуляциям с вознаграждением.

Эта двойная система поддерживает точную оценку как простых, так и сложных задач.

Масштабируемая инфраструктура

Фреймворк HybridFlow от ByteDance, работающий на кластерах Ray, поддерживает эффективное крупномасштабное обучение с совместным размещением обучения и вывода для минимизации простоя GPU.

Система Streaming Rollout System (SRS) разделяет эволюцию модели и выполнение, ускоряя итерации до трёх раз через асинхронное управление частичными генерациями.

Дополнительные техники включают:

- Смешанную точность (FP8) для эффективности памяти

- Параллелизм экспертов и автонастройку ядра для оптимизации MoE

- ByteCheckpoint для надёжного сохранения контрольных точек

- AutoTuner для оптимизированных настроек параллелизма и памяти

Оценка с участием людей и практическое применение

Тестирование людьми в области творческого письма, гуманитарных наук и общего диалога показало, что Seed-Thinking-v1.5 превосходит DeepSeek R1, доказывая свою актуальность в реальном мире.

Команда отмечает, что обучение на проверяемых задачах улучшило обобщение на творческие области благодаря строгим математическим рабочим процессам.

Значение для технических команд и предприятий

Для технических лидеров, управляющих жизненным циклом LLM, Seed-Thinking-v1.5 предлагает модель для интеграции продвинутого рассуждения в корпоративные системы ИИ.

Её модульное обучение с проверяемыми наборами данных и многофазным обучением с подкреплением подходит командам, масштабирующим разработку LLM с точным контролем.

Seed-Verifier и Seed-Thinking-Verifier улучшают надёжное моделирование вознаграждений, что важно для клиентских или регулируемых сред.

Для команд с плотным графиком VAPO и динамическая выборка сокращают циклы итераций, упрощая тонкую настройку для конкретных задач.

Гибридная инфраструктура, включая SRS и оптимизацию FP8, повышает производительность обучения и эффективность оборудования, идеально для облачных и локальных систем.

Адаптивная обратная связь по вознаграждениям решает проблемы управления разнообразными данными, обеспечивая согласованность между областями.

Для инженеров данных акцент на строгой фильтрации данных и экспертной проверке подчёркивает ценность качественных наборов данных для повышения производительности модели.

Взгляд в будущее

Разработанная командой Seed LLM Systems от ByteDance под руководством Yonghui Wu и представленная публично Haibin Lin, Seed-Thinking-v1.5 опирается на такие усилия, как Doubao 1.5 Pro, используя общие техники RLHF и курации данных.

Команда стремится усовершенствовать обучение с подкреплением, сосредоточившись на эффективности обучения и моделировании вознаграждений для непроверяемых задач. Выпуск тестов, таких как BeyondAIME, будет способствовать дальнейшему прогрессу в исследованиях ИИ, ориентированных на рассуждение.

Связанная статья

Google представляет протокол A2A для повышения совместимости агентов ИИ

Агенты ИИ решают сложные, повторяющиеся задачи, такие как управление цепочками поставок и закупка оборудования. Поскольку организации используют агентов от различных поставщиков и платформ, эти агенты

Google представляет протокол A2A для повышения совместимости агентов ИИ

Агенты ИИ решают сложные, повторяющиеся задачи, такие как управление цепочками поставок и закупка оборудования. Поскольку организации используют агентов от различных поставщиков и платформ, эти агенты

Qodo сотрудничает с Google Cloud для предоставления бесплатных инструментов AI для проверки кода разработчикам

Qodo, израильский стартап в области AI-кодирования, ориентированный на качество кода, начал сотрудничество с Google Cloud для повышения целостности программного обеспечения, созданного AI.По мере рост

Qodo сотрудничает с Google Cloud для предоставления бесплатных инструментов AI для проверки кода разработчикам

Qodo, израильский стартап в области AI-кодирования, ориентированный на качество кода, начал сотрудничество с Google Cloud для повышения целостности программного обеспечения, созданного AI.По мере рост

Salesforce представляет цифровых помощников с ИИ в Slack для конкуренции с Microsoft Copilot

Salesforce запустила новую стратегию ИИ для рабочего места, представив специализированных «цифровых помощников», интегрированных в беседы Slack, сообщила компания в понедельник.Новый инструмент, Agent

Комментарии (0)

Salesforce представляет цифровых помощников с ИИ в Slack для конкуренции с Microsoft Copilot

Salesforce запустила новую стратегию ИИ для рабочего места, представив специализированных «цифровых помощников», интегрированных в беседы Slack, сообщила компания в понедельник.Новый инструмент, Agent

Комментарии (0)

Гонка за продвинутыми ИИ с функцией рассуждения началась с модели o1 от OpenAI в сентябре 2024 года, набрав обороты с запуском R1 от DeepSeek в январе 2025 года.

Крупные разработчики ИИ соревнуются в создании более быстрых и экономичных моделей ИИ с функцией рассуждения, обеспечивающих точные, продуманные ответы через процессы цепочки мыслей, гарантируя точность перед ответом.

ByteDance, материнская компания TikTok, вступила в борьбу с Seed-Thinking-v1.5, новой большой языковой моделью (LLM), описанной в техническом документе, направленной на улучшение рассуждений в STEM и общих областях.

Модель пока недоступна, а её лицензирование — проприетарное, с открытым исходным кодом или гибридное — остаётся нераскрытым. Однако документ предоставляет ключевые идеи, которые стоит изучить перед её выпуском.

Использование архитектуры Mixture-of-Experts (MoE)

Следуя за Llama 4 от Meta и Mixtral от Mistral, Seed-Thinking-v1.5 использует архитектуру Mixture-of-Experts (MoE).

Этот подход повышает эффективность за счёт интеграции нескольких специализированных моделей в одну, каждая из которых сосредоточена на отдельных областях.

Seed-Thinking-v1.5 использует только 20 миллиардов из своих 200 миллиардов параметров одновременно, оптимизируя производительность.

Документ, опубликованный ByteDance на GitHub, подчёркивает фокус модели на структурированном рассуждении и осознанном создании ответов.

Она превосходит DeepSeek R1 и конкурирует с Gemini 2.5 Pro от Google и o3-mini-high от OpenAI в сторонних тестах, даже опережая их в тесте ARC-AGI, ключевом показателе прогресса к искусственному общему интеллекту, превышающем человеческую производительность в экономически ценных задачах, согласно стандартам OpenAI.

Позиционируемая как компактная, но мощная альтернатива крупным моделям, Seed-Thinking-v1.5 демонстрирует высокие результаты в тестах благодаря инновационному обучению с подкреплением, тщательно подобранным обучающим данным и передовой инфраструктуре ИИ.

Производительность в тестах и ключевые сильные стороны

Seed-Thinking-v1.5 превосходит в сложных задачах, набирая 86,7% на AIME 2024, 55,0% pass@8 на Codeforces и 77,3% на научном тесте GPQA, почти соответствуя или превосходя модели, такие как o3-mini-high от OpenAI и Gemini 2.5 Pro от Google, в метриках рассуждения.

В задачах, не связанных с рассуждением, она достигла на 8,0% более высокого уровня предпочтения людей по сравнению с DeepSeek R1, демонстрируя универсальность за пределами логики и математики.

Для борьбы с насыщением тестов ByteDance создала BeyondAIME, более сложный математический тест, устойчивый к запоминанию и лучше оценивающий производительность модели. Этот тест, вместе с набором Codeforces, будет публично выпущен для поддержки будущих исследований.

Подход к обучающим данным

Качество данных сыграло ключевую роль в разработке Seed-Thinking-v1.5. Для контролируемой тонкой настройки было отобрано 400 000 образцов: 300 000 проверяемых задач по STEM, логике и программированию и 100 000 непроверяемых задач, таких как творческое письмо.

Для обучения с подкреплением данные были разделены на:

- Проверяемые задачи: 100 000 тщательно отобранных вопросов по STEM и логических головоломок из элитных соревнований, проверенных экспертами.

- Непроверяемые задачи: Наборы данных с предпочтениями людей для открытых запросов, оценённых через парные модели вознаграждения.

Более 80% данных STEM сосредоточены на продвинутой математике, с логическими задачами, такими как судоку и головоломки на 24 очка, масштабированными для соответствия прогрессу модели.

Инновации в обучении с подкреплением

Seed-Thinking-v1.5 использует пользовательские фреймворки actor-critic (VAPO) и policy-gradient (DAPO) для стабилизации обучения с подкреплением, решая проблемы в длинных сценариях цепочки мыслей.

Две модели вознаграждения улучшают контроль RL:

- Seed-Verifier: Основанная на правилах LLM, обеспечивающая математическую эквивалентность между сгенерированными и эталонными ответами.

- Seed-Thinking-Verifier: Судья, основанный на рассуждениях, для последовательной оценки, устойчивый к манипуляциям с вознаграждением.

Эта двойная система поддерживает точную оценку как простых, так и сложных задач.

Масштабируемая инфраструктура

Фреймворк HybridFlow от ByteDance, работающий на кластерах Ray, поддерживает эффективное крупномасштабное обучение с совместным размещением обучения и вывода для минимизации простоя GPU.

Система Streaming Rollout System (SRS) разделяет эволюцию модели и выполнение, ускоряя итерации до трёх раз через асинхронное управление частичными генерациями.

Дополнительные техники включают:

- Смешанную точность (FP8) для эффективности памяти

- Параллелизм экспертов и автонастройку ядра для оптимизации MoE

- ByteCheckpoint для надёжного сохранения контрольных точек

- AutoTuner для оптимизированных настроек параллелизма и памяти

Оценка с участием людей и практическое применение

Тестирование людьми в области творческого письма, гуманитарных наук и общего диалога показало, что Seed-Thinking-v1.5 превосходит DeepSeek R1, доказывая свою актуальность в реальном мире.

Команда отмечает, что обучение на проверяемых задачах улучшило обобщение на творческие области благодаря строгим математическим рабочим процессам.

Значение для технических команд и предприятий

Для технических лидеров, управляющих жизненным циклом LLM, Seed-Thinking-v1.5 предлагает модель для интеграции продвинутого рассуждения в корпоративные системы ИИ.

Её модульное обучение с проверяемыми наборами данных и многофазным обучением с подкреплением подходит командам, масштабирующим разработку LLM с точным контролем.

Seed-Verifier и Seed-Thinking-Verifier улучшают надёжное моделирование вознаграждений, что важно для клиентских или регулируемых сред.

Для команд с плотным графиком VAPO и динамическая выборка сокращают циклы итераций, упрощая тонкую настройку для конкретных задач.

Гибридная инфраструктура, включая SRS и оптимизацию FP8, повышает производительность обучения и эффективность оборудования, идеально для облачных и локальных систем.

Адаптивная обратная связь по вознаграждениям решает проблемы управления разнообразными данными, обеспечивая согласованность между областями.

Для инженеров данных акцент на строгой фильтрации данных и экспертной проверке подчёркивает ценность качественных наборов данных для повышения производительности модели.

Взгляд в будущее

Разработанная командой Seed LLM Systems от ByteDance под руководством Yonghui Wu и представленная публично Haibin Lin, Seed-Thinking-v1.5 опирается на такие усилия, как Doubao 1.5 Pro, используя общие техники RLHF и курации данных.

Команда стремится усовершенствовать обучение с подкреплением, сосредоточившись на эффективности обучения и моделировании вознаграждений для непроверяемых задач. Выпуск тестов, таких как BeyondAIME, будет способствовать дальнейшему прогрессу в исследованиях ИИ, ориентированных на рассуждение.

Qodo сотрудничает с Google Cloud для предоставления бесплатных инструментов AI для проверки кода разработчикам

Qodo, израильский стартап в области AI-кодирования, ориентированный на качество кода, начал сотрудничество с Google Cloud для повышения целостности программного обеспечения, созданного AI.По мере рост

Qodo сотрудничает с Google Cloud для предоставления бесплатных инструментов AI для проверки кода разработчикам

Qodo, израильский стартап в области AI-кодирования, ориентированный на качество кода, начал сотрудничество с Google Cloud для повышения целостности программного обеспечения, созданного AI.По мере рост

Salesforce представляет цифровых помощников с ИИ в Slack для конкуренции с Microsoft Copilot

Salesforce запустила новую стратегию ИИ для рабочего места, представив специализированных «цифровых помощников», интегрированных в беседы Slack, сообщила компания в понедельник.Новый инструмент, Agent

Salesforce представляет цифровых помощников с ИИ в Slack для конкуренции с Microsoft Copilot

Salesforce запустила новую стратегию ИИ для рабочего места, представив специализированных «цифровых помощников», интегрированных в беседы Slack, сообщила компания в понедельник.Новый инструмент, Agent