L'informatique de l'IA pour consommer la puissance de plusieurs New York d'ici 2026, explique le fondateur

Nvidia et ses partenaires étendent les centres de données IA à travers le monde

Nvidia, en collaboration avec ses partenaires et clients, a activement élargi la taille des installations informatiques à travers le globe pour répondre aux exigences computationnelles élevées de l'entraînement de modèles d'intelligence artificielle (IA) massifs comme GPT-4. Cette expansion deviendra encore plus cruciale à mesure que d'autres modèles d'IA seront déployés en production, selon Thomas Graham, co-fondateur de la startup d'informatique optique Lightmatter. Dans une récente interview à New York avec Mandeep Singh, analyste technologique senior chez Bloomberg Intelligence, Graham a souligné le besoin croissant de ressources computationnelles.

« La demande de plus de calcul ne concerne pas seulement les lois de mise à l'échelle ; il s'agit aussi de déployer ces modèles d'IA maintenant », a expliqué Graham. Singh a interrogé sur l'avenir des grands modèles de langage (LLMs) comme GPT-4 et s'ils continueront à croître en taille. En réponse, Graham a recentré la discussion sur l'application pratique de l'IA, soulignant l'importance de l'inférence, ou phase de déploiement, qui nécessite une puissance computationnelle considérable.

« Si vous considérez l'entraînement comme de la R&D, l'inférence est essentiellement le déploiement. En déployant, vous aurez besoin d'ordinateurs à grande échelle pour exécuter vos modèles », a déclaré Graham lors de la conférence « Gen AI : Peut-elle tenir sa promesse de productivité ? » organisée par Bloomberg Intelligence.

La perspective de Graham s'aligne sur celle de Jensen Huang, PDG de Nvidia, qui a souligné auprès de Wall Street que l'avancement des formes d'IA « agentiques » nécessitera non seulement un entraînement plus sophistiqué, mais aussi des capacités d'inférence considérablement renforcées, entraînant une augmentation exponentielle des besoins en calcul.

« Si vous considérez l'entraînement comme de la R&D, l'inférence est vraiment le déploiement, et en déployant cela, vous aurez besoin de grands ordinateurs pour exécuter vos modèles », a déclaré Graham. Photo : Bloomberg, avec l'aimable autorisation de Craig Warga Le rôle de Lightmatter dans l'infrastructure de l'IA

Fondée en 2018, Lightmatter est à la pointe du développement de technologies de puces utilisant des connexions optiques pour relier plusieurs processeurs sur une seule puce semi-conductrice. Ces interconnexions optiques peuvent transférer des données plus efficacement que les fils de cuivre traditionnels, en utilisant moins d'énergie. Cette technologie peut simplifier les connexions au sein et entre les racks des centres de données, améliorant l'efficacité et l'économie globales des centres de données, selon Graham.

« En remplaçant les traces de cuivre dans les centres de données — à la fois sur la carte de circuit imprimé du serveur et dans le câblage entre les racks — par de la fibre optique, nous pouvons augmenter considérablement la bande passante », a déclaré Graham à Singh. Lightmatter collabore actuellement avec diverses entreprises technologiques sur la conception de nouveaux centres de données, et Graham a noté que ces installations sont construites de toutes pièces. L'entreprise a déjà établi un partenariat avec Global Foundries, un fabricant de semi-conducteurs sous contrat opérant dans le nord de l'État de New York, qui sert des clients comme Advanced Micro Devices.

Bien que Graham n'ait pas divulgué de partenaires et clients spécifiques au-delà de cette collaboration, il a laissé entendre que Lightmatter travaille avec des fournisseurs de silicium comme Broadcom ou Marvell pour créer des composants personnalisés pour des géants technologiques comme Google, Amazon et Microsoft, qui conçoivent leurs propres processeurs pour centres de données.

L'ampleur et l'avenir des centres de données IA

Pour illustrer l'ampleur du déploiement de l'IA, Graham a souligné qu'au moins une douzaine de nouveaux centres de données IA sont soit planifiés, soit en construction, chacun nécessitant un gigawatt de puissance. « Pour donner un contexte, New York City consomme environ cinq gigawatts de puissance par jour en moyenne. Donc, nous parlons de la consommation énergétique de plusieurs New York City », a-t-il déclaré. Il prévoit que d'ici 2026, le traitement mondial de l'IA nécessitera 40 gigawatts de puissance, équivalent à huit New York City, spécifiquement pour les centres de données IA.

Lightmatter a récemment obtenu un investissement de capital-risque de 400 millions de dollars, valorisant l'entreprise à 4,4 milliards de dollars. Graham a mentionné que l'entreprise vise à démarrer la production « au cours des prochaines années ».

Lorsqu'on lui a demandé s'il y avait des perturbations potentielles aux plans de Lightmatter, Graham a exprimé sa confiance dans le besoin continu d'expansion de l'infrastructure informatique de l'IA. Cependant, il a reconnu qu'une percée dans les algorithmes d'IA nécessitant beaucoup moins de calcul ou atteignant l'intelligence artificielle générale (AGI) plus rapidement pourrait remettre en question les hypothèses actuelles sur le besoin de croissance exponentielle du calcul.

Article connexe

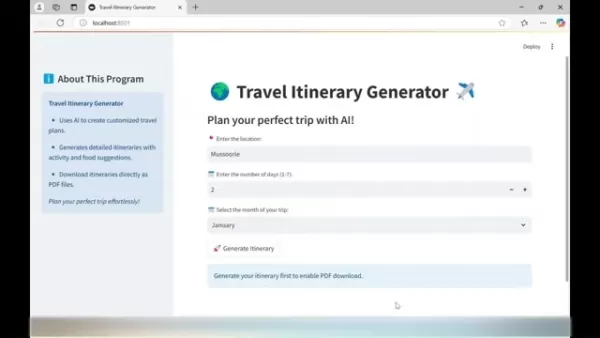

Un générateur d'itinéraires de voyage alimenté par l'IA vous aide à planifier le voyage parfait

La planification de voyages inoubliables vient d'être simplifiée grâce à une technologie d'IA de pointe. Le générateur d'itinéraires de voyage révolutionne la planification des vacances en créant des

Un générateur d'itinéraires de voyage alimenté par l'IA vous aide à planifier le voyage parfait

La planification de voyages inoubliables vient d'être simplifiée grâce à une technologie d'IA de pointe. Le générateur d'itinéraires de voyage révolutionne la planification des vacances en créant des

Apple Vision Pro change la donne en matière de réalité augmentée

Apple fait un saut audacieux dans l'informatique spatiale avec son casque Vision Pro révolutionnaire, redéfinissant ce qui est possible en matière d'expériences de réalité augmentée et virtuelle grâce

Apple Vision Pro change la donne en matière de réalité augmentée

Apple fait un saut audacieux dans l'informatique spatiale avec son casque Vision Pro révolutionnaire, redéfinissant ce qui est possible en matière d'expériences de réalité augmentée et virtuelle grâce

L'assistant d'achat Perplexity AI transforme l'expérience d'achat en ligne

Perplexity AI fait des vagues dans le commerce électronique avec son assistant d'achat révolutionnaire, prêt à transformer la façon dont les consommateurs découvrent et achètent des produits en ligne.

commentaires (31)

0/200

L'assistant d'achat Perplexity AI transforme l'expérience d'achat en ligne

Perplexity AI fait des vagues dans le commerce électronique avec son assistant d'achat révolutionnaire, prêt à transformer la façon dont les consommateurs découvrent et achètent des produits en ligne.

commentaires (31)

0/200

![ScottMitchell]() ScottMitchell

ScottMitchell

18 août 2025 03:01:03 UTC+02:00

18 août 2025 03:01:03 UTC+02:00

Mind-blowing how AI's eating up power like a sci-fi monster! 😱 By 2026, it'll need multiple NYCs' worth of electricity? Hope they figure out sustainable energy fast, or we’re all in for a wild ride.

0

0

![BillyEvans]() BillyEvans

BillyEvans

20 avril 2025 11:23:59 UTC+02:00

20 avril 2025 11:23:59 UTC+02:00

¡Para 2026, la IA consumirá energía como varias ciudades de Nueva York! ¡Es una locura! 😱 Me encanta el progreso tecnológico, pero también tenemos que pensar en el medio ambiente. ¡Ojalá encuentren una forma más ecológica! 🌿

0

0

![PeterRodriguez]() PeterRodriguez

PeterRodriguez

20 avril 2025 08:07:12 UTC+02:00

20 avril 2025 08:07:12 UTC+02:00

Wow, AI data centers eating up that much power by 2026? 😲 That’s wild! Makes me wonder if we’re ready for the energy bill or if renewables can keep up.

0

0

![JackAllen]() JackAllen

JackAllen

20 avril 2025 07:11:07 UTC+02:00

20 avril 2025 07:11:07 UTC+02:00

AI所需的计算能力真是令人难以置信。到2026年,它将相当于多个纽约市的总和。这太疯狂了!希望我们能找到更有效的能源管理方式。

0

0

![GeorgeJones]() GeorgeJones

GeorgeJones

20 avril 2025 06:57:20 UTC+02:00

20 avril 2025 06:57:20 UTC+02:00

AI가 여러 뉴욕 시의 전력을 소비한다는 생각은 좀 무섭네요! 하지만 진보를 위한 대가라고 생각해요. Nvidia의 확장은 인상적이지만, 에너지 수요에 따라갈 수 있을까요? 🤔 더 많은 태양광 패널이 필요할지도 모르겠어요!

0

0

![TerryYoung]() TerryYoung

TerryYoung

20 avril 2025 02:05:08 UTC+02:00

20 avril 2025 02:05:08 UTC+02:00

This AI expansion sounds insane! By 2026, the power consumption could match multiple New York Cities? That's wild! I'm excited to see what kind of AI models they'll be training, but also kinda worried about the environmental impact. Can't wait to see how this pans out! 🤯

0

0

Nvidia et ses partenaires étendent les centres de données IA à travers le monde

Nvidia, en collaboration avec ses partenaires et clients, a activement élargi la taille des installations informatiques à travers le globe pour répondre aux exigences computationnelles élevées de l'entraînement de modèles d'intelligence artificielle (IA) massifs comme GPT-4. Cette expansion deviendra encore plus cruciale à mesure que d'autres modèles d'IA seront déployés en production, selon Thomas Graham, co-fondateur de la startup d'informatique optique Lightmatter. Dans une récente interview à New York avec Mandeep Singh, analyste technologique senior chez Bloomberg Intelligence, Graham a souligné le besoin croissant de ressources computationnelles.

« La demande de plus de calcul ne concerne pas seulement les lois de mise à l'échelle ; il s'agit aussi de déployer ces modèles d'IA maintenant », a expliqué Graham. Singh a interrogé sur l'avenir des grands modèles de langage (LLMs) comme GPT-4 et s'ils continueront à croître en taille. En réponse, Graham a recentré la discussion sur l'application pratique de l'IA, soulignant l'importance de l'inférence, ou phase de déploiement, qui nécessite une puissance computationnelle considérable.

« Si vous considérez l'entraînement comme de la R&D, l'inférence est essentiellement le déploiement. En déployant, vous aurez besoin d'ordinateurs à grande échelle pour exécuter vos modèles », a déclaré Graham lors de la conférence « Gen AI : Peut-elle tenir sa promesse de productivité ? » organisée par Bloomberg Intelligence.

La perspective de Graham s'aligne sur celle de Jensen Huang, PDG de Nvidia, qui a souligné auprès de Wall Street que l'avancement des formes d'IA « agentiques » nécessitera non seulement un entraînement plus sophistiqué, mais aussi des capacités d'inférence considérablement renforcées, entraînant une augmentation exponentielle des besoins en calcul.

Le rôle de Lightmatter dans l'infrastructure de l'IA

Fondée en 2018, Lightmatter est à la pointe du développement de technologies de puces utilisant des connexions optiques pour relier plusieurs processeurs sur une seule puce semi-conductrice. Ces interconnexions optiques peuvent transférer des données plus efficacement que les fils de cuivre traditionnels, en utilisant moins d'énergie. Cette technologie peut simplifier les connexions au sein et entre les racks des centres de données, améliorant l'efficacité et l'économie globales des centres de données, selon Graham.

« En remplaçant les traces de cuivre dans les centres de données — à la fois sur la carte de circuit imprimé du serveur et dans le câblage entre les racks — par de la fibre optique, nous pouvons augmenter considérablement la bande passante », a déclaré Graham à Singh. Lightmatter collabore actuellement avec diverses entreprises technologiques sur la conception de nouveaux centres de données, et Graham a noté que ces installations sont construites de toutes pièces. L'entreprise a déjà établi un partenariat avec Global Foundries, un fabricant de semi-conducteurs sous contrat opérant dans le nord de l'État de New York, qui sert des clients comme Advanced Micro Devices.

Bien que Graham n'ait pas divulgué de partenaires et clients spécifiques au-delà de cette collaboration, il a laissé entendre que Lightmatter travaille avec des fournisseurs de silicium comme Broadcom ou Marvell pour créer des composants personnalisés pour des géants technologiques comme Google, Amazon et Microsoft, qui conçoivent leurs propres processeurs pour centres de données.

L'ampleur et l'avenir des centres de données IA

Pour illustrer l'ampleur du déploiement de l'IA, Graham a souligné qu'au moins une douzaine de nouveaux centres de données IA sont soit planifiés, soit en construction, chacun nécessitant un gigawatt de puissance. « Pour donner un contexte, New York City consomme environ cinq gigawatts de puissance par jour en moyenne. Donc, nous parlons de la consommation énergétique de plusieurs New York City », a-t-il déclaré. Il prévoit que d'ici 2026, le traitement mondial de l'IA nécessitera 40 gigawatts de puissance, équivalent à huit New York City, spécifiquement pour les centres de données IA.

Lightmatter a récemment obtenu un investissement de capital-risque de 400 millions de dollars, valorisant l'entreprise à 4,4 milliards de dollars. Graham a mentionné que l'entreprise vise à démarrer la production « au cours des prochaines années ».

Lorsqu'on lui a demandé s'il y avait des perturbations potentielles aux plans de Lightmatter, Graham a exprimé sa confiance dans le besoin continu d'expansion de l'infrastructure informatique de l'IA. Cependant, il a reconnu qu'une percée dans les algorithmes d'IA nécessitant beaucoup moins de calcul ou atteignant l'intelligence artificielle générale (AGI) plus rapidement pourrait remettre en question les hypothèses actuelles sur le besoin de croissance exponentielle du calcul.

Un générateur d'itinéraires de voyage alimenté par l'IA vous aide à planifier le voyage parfait

La planification de voyages inoubliables vient d'être simplifiée grâce à une technologie d'IA de pointe. Le générateur d'itinéraires de voyage révolutionne la planification des vacances en créant des

Un générateur d'itinéraires de voyage alimenté par l'IA vous aide à planifier le voyage parfait

La planification de voyages inoubliables vient d'être simplifiée grâce à une technologie d'IA de pointe. Le générateur d'itinéraires de voyage révolutionne la planification des vacances en créant des

Apple Vision Pro change la donne en matière de réalité augmentée

Apple fait un saut audacieux dans l'informatique spatiale avec son casque Vision Pro révolutionnaire, redéfinissant ce qui est possible en matière d'expériences de réalité augmentée et virtuelle grâce

Apple Vision Pro change la donne en matière de réalité augmentée

Apple fait un saut audacieux dans l'informatique spatiale avec son casque Vision Pro révolutionnaire, redéfinissant ce qui est possible en matière d'expériences de réalité augmentée et virtuelle grâce

L'assistant d'achat Perplexity AI transforme l'expérience d'achat en ligne

Perplexity AI fait des vagues dans le commerce électronique avec son assistant d'achat révolutionnaire, prêt à transformer la façon dont les consommateurs découvrent et achètent des produits en ligne.

L'assistant d'achat Perplexity AI transforme l'expérience d'achat en ligne

Perplexity AI fait des vagues dans le commerce électronique avec son assistant d'achat révolutionnaire, prêt à transformer la façon dont les consommateurs découvrent et achètent des produits en ligne.

18 août 2025 03:01:03 UTC+02:00

18 août 2025 03:01:03 UTC+02:00

Mind-blowing how AI's eating up power like a sci-fi monster! 😱 By 2026, it'll need multiple NYCs' worth of electricity? Hope they figure out sustainable energy fast, or we’re all in for a wild ride.

0

0

20 avril 2025 11:23:59 UTC+02:00

20 avril 2025 11:23:59 UTC+02:00

¡Para 2026, la IA consumirá energía como varias ciudades de Nueva York! ¡Es una locura! 😱 Me encanta el progreso tecnológico, pero también tenemos que pensar en el medio ambiente. ¡Ojalá encuentren una forma más ecológica! 🌿

0

0

20 avril 2025 08:07:12 UTC+02:00

20 avril 2025 08:07:12 UTC+02:00

Wow, AI data centers eating up that much power by 2026? 😲 That’s wild! Makes me wonder if we’re ready for the energy bill or if renewables can keep up.

0

0

20 avril 2025 07:11:07 UTC+02:00

20 avril 2025 07:11:07 UTC+02:00

AI所需的计算能力真是令人难以置信。到2026年,它将相当于多个纽约市的总和。这太疯狂了!希望我们能找到更有效的能源管理方式。

0

0

20 avril 2025 06:57:20 UTC+02:00

20 avril 2025 06:57:20 UTC+02:00

AI가 여러 뉴욕 시의 전력을 소비한다는 생각은 좀 무섭네요! 하지만 진보를 위한 대가라고 생각해요. Nvidia의 확장은 인상적이지만, 에너지 수요에 따라갈 수 있을까요? 🤔 더 많은 태양광 패널이 필요할지도 모르겠어요!

0

0

20 avril 2025 02:05:08 UTC+02:00

20 avril 2025 02:05:08 UTC+02:00

This AI expansion sounds insane! By 2026, the power consumption could match multiple New York Cities? That's wild! I'm excited to see what kind of AI models they'll be training, but also kinda worried about the environmental impact. Can't wait to see how this pans out! 🤯

0

0