ByteDance Revela o Modelo de IA Seed-Thinking-v1.5 para Impulsionar Capacidades de Raciocínio

A corrida por IA com raciocínio avançado começou com o modelo o1 da OpenAI em setembro de 2024, ganhando impulso com o lançamento do R1 da DeepSeek em janeiro de 2025.

Os principais desenvolvedores de IA estão agora competindo para criar modelos de IA de raciocínio mais rápidos e econômicos que ofereçam respostas precisas e bem pensadas por meio de processos de cadeia de pensamento, garantindo precisão antes de responder.

ByteDance, a empresa-mãe do TikTok, entrou na disputa com o Seed-Thinking-v1.5, um novo modelo de linguagem de grande escala (LLM) descrito em um artigo técnico, voltado para aprimorar o raciocínio em STEM e domínios gerais.

O modelo ainda não está disponível, e sua licença — se proprietária, de código aberto ou híbrida — permanece não divulgada. O artigo, no entanto, oferece insights importantes que valem a pena explorar antes de seu lançamento.

Aproveitando a Arquitetura Mixture-of-Experts (MoE)

Seguindo o Llama 4 da Meta e o Mixtral da Mistral, o Seed-Thinking-v1.5 adota a arquitetura Mixture-of-Experts (MoE).

Essa abordagem aumenta a eficiência ao integrar múltiplos modelos especializados em um único, cada um focado em domínios distintos.

O Seed-Thinking-v1.5 utiliza apenas 20 bilhões de seus 200 bilhões de parâmetros por vez, otimizando o desempenho.

O artigo publicado no GitHub pela ByteDance destaca o foco do modelo em raciocínio estruturado e geração de respostas deliberadas.

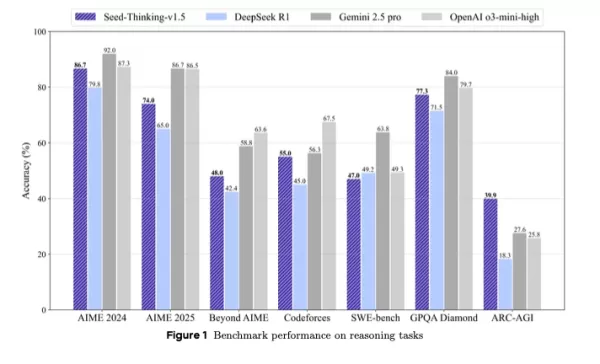

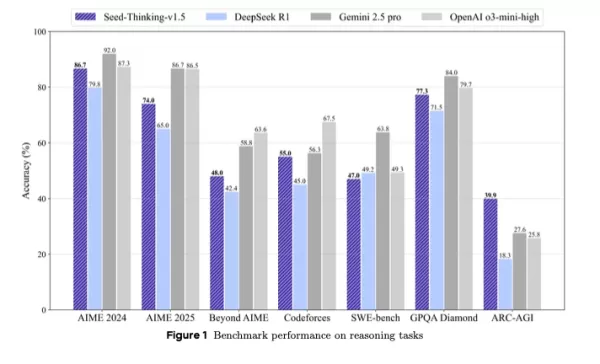

Ele supera o DeepSeek R1 e rivaliza com o Gemini 2.5 Pro do Google e o o3-mini-high da OpenAI em benchmarks de terceiros, até mesmo superando-os no benchmark ARC-AGI, uma medida importante de progresso rumo à inteligência geral artificial, superando o desempenho humano em tarefas economicamente valiosas, conforme os padrões da OpenAI.

Posicionado como uma alternativa compacta, porém poderosa, a modelos maiores, o Seed-Thinking-v1.5 entrega resultados de benchmark sólidos por meio de aprendizado por reforço inovador, dados de treinamento curados e infraestrutura avançada de IA.

Desempenho em Benchmarks e Pontos Fortes Principais

O Seed-Thinking-v1.5 se destaca em tarefas difíceis, alcançando 86,7% no AIME 2024, 55,0% de pass@8 no Codeforces e 77,3% no benchmark científico GPQA, correspondendo ou superando modelos como o o3-mini-high da OpenAI e o Gemini 2.5 Pro do Google em métricas de raciocínio.

Em tarefas não relacionadas ao raciocínio, ele obteve uma taxa de preferência humana 8,0% maior que o DeepSeek R1, mostrando versatilidade além de lógica e matemática.

Para combater a saturação de benchmarks, a ByteDance criou o BeyondAIME, um benchmark matemático mais difícil para resistir à memorização e avaliar melhor o desempenho do modelo. Esse, junto com o conjunto Codeforces, será lançado publicamente para auxiliar pesquisas futuras.

Abordagem de Dados de Treinamento

A qualidade dos dados foi crucial no desenvolvimento do Seed-Thinking-v1.5. Para o ajuste fino supervisionado, 400.000 amostras foram curadas: 300.000 tarefas verificáveis de STEM, lógica e codificação, e 100.000 tarefas não verificáveis, como escrita criativa.

Para o aprendizado por reforço, os dados foram divididos em:

- Problemas verificáveis: 100.000 questões de STEM e quebra-cabeças lógicos cuidadosamente selecionados de competições de elite, validados por especialistas.

- Tarefas não verificáveis: Conjuntos de dados de preferência humana para prompts abertos, avaliados por modelos de recompensa pareada.

Mais de 80% dos dados de STEM focaram em matemática avançada, com tarefas lógicas como Sudoku e quebra-cabeças de 24 pontos escalados para acompanhar o progresso do modelo.

Inovações em Aprendizado por Reforço

O Seed-Thinking-v1.5 utiliza frameworks personalizados de ator-crítico (VAPO) e gradiente de política (DAPO) para estabilizar o aprendizado por reforço, abordando problemas em cenários de cadeia de pensamento longa.

Dois modelos de recompensa aprimoram a supervisão do RL:

- Seed-Verifier: Um LLM baseado em regras que garante equivalência matemática entre respostas geradas e de referência.

- Seed-Thinking-Verifier: Um juiz baseado em raciocínio para avaliação consistente, resistente à manipulação de recompensas.

Esse sistema duplo suporta avaliação precisa em tarefas simples e complexas.

Design de Infraestrutura Escalável

O framework HybridFlow da ByteDance, alimentado por clusters Ray, suporta treinamento em grande escala eficiente com treinamento e inferência co-localizados para minimizar o tempo ocioso da GPU.

O Sistema de Lançamento de Streaming (SRS) separa a evolução do modelo do tempo de execução, acelerando iterações em até três vezes por meio do gerenciamento assíncrono de gerações parciais.

Técnicas adicionais incluem:

- Precisão mista (FP8) para eficiência de memória

- Paralelismo de especialistas e autoajuste de kernel para otimização de MoE

- ByteCheckpoint para checkpointing robusto

- AutoTuner para configurações otimizadas de paralelismo e memória

Avaliação Centrada em Humanos e Aplicações

Testes humanos em escrita criativa, humanidades e conversação geral mostraram que o Seed-Thinking-v1.5 supera o DeepSeek R1, provando sua relevância no mundo real.

A equipe observa que o treinamento em tarefas verificáveis melhorou a generalização para domínios criativos, impulsionado por fluxos de trabalho matemáticos rigorosos.

Implicações para Equipes Técnicas e Empresas

Para líderes técnicos que supervisionam ciclos de vida de LLM, o Seed-Thinking-v1.5 oferece um modelo para integrar raciocínio avançado em sistemas de IA empresariais.

Seu treinamento modular, com conjuntos de dados verificáveis e aprendizado por reforço multifásico, é adequado para equipes que escalam o desenvolvimento de LLM com controle preciso.

O Seed-Verifier e o Seed-Thinking-Verifier aprimoram a modelagem de recompensas confiáveis, vital para configurações voltadas para clientes ou reguladas.

Para equipes com cronogramas apertados, o VAPO e a amostragem dinâmica reduzem os ciclos de iteração, simplificando o ajuste fino específico para tarefas.

A infraestrutura híbrida, incluindo SRS e otimização FP8, aumenta a taxa de transferência de treinamento e a eficiência de hardware, ideal para sistemas em nuvem e locais.

O feedback adaptativo de recompensas do modelo aborda desafios no gerenciamento de pipelines de dados diversos, garantindo consistência entre domínios.

Para engenheiros de dados, o foco em filtragem rigorosa de dados e verificação por especialistas destaca o valor de conjuntos de dados de alta qualidade para melhorar o desempenho do modelo.

Perspectivas Futuras

Desenvolvido pela equipe de Sistemas LLM Seed da ByteDance, liderada por Yonghui Wu e representada publicamente por Haibin Lin, o Seed-Thinking-v1.5 se baseia em esforços como o Doubao 1.5 Pro, usando técnicas compartilhadas de RLHF e curadoria de dados.

A equipe pretende refinar o aprendizado por reforço, focando na eficiência de treinamento e modelagem de recompensas para tarefas não verificáveis. A liberação de benchmarks como o BeyondAIME impulsionará ainda mais o progresso na pesquisa de IA focada em raciocínio.

Artigo relacionado

O TreeQuest da Sakana AI aumenta o desempenho da IA com a colaboração de vários modelos

O laboratório japonês de IA Sakana AI revelou uma técnica que permite que vários modelos de linguagem de grande porte (LLMs) trabalhem juntos, formando uma equipe de IA altamente eficaz. Denominado Mu

O TreeQuest da Sakana AI aumenta o desempenho da IA com a colaboração de vários modelos

O laboratório japonês de IA Sakana AI revelou uma técnica que permite que vários modelos de linguagem de grande porte (LLMs) trabalhem juntos, formando uma equipe de IA altamente eficaz. Denominado Mu

Google Revela Protocolo A2A para Melhorar a Interoperabilidade de Agentes de IA

Agentes de IA lidam com tarefas complexas e repetitivas, como gerenciamento de cadeia de suprimentos e aquisição de equipamentos. À medida que as organizações adotam agentes de vários fornecedores e e

Google Revela Protocolo A2A para Melhorar a Interoperabilidade de Agentes de IA

Agentes de IA lidam com tarefas complexas e repetitivas, como gerenciamento de cadeia de suprimentos e aquisição de equipamentos. À medida que as organizações adotam agentes de vários fornecedores e e

Qodo Faz Parceria com Google Cloud para Oferecer Ferramentas Gratuitas de Revisão de Código por IA para Desenvolvedores

Qodo, uma startup de codificação por IA baseada em Israel focada em qualidade de código, lançou uma parceria com Google Cloud para aprimorar a integridade de software gerado por IA.À medida que as emp

Comentários (0)

0/200

Qodo Faz Parceria com Google Cloud para Oferecer Ferramentas Gratuitas de Revisão de Código por IA para Desenvolvedores

Qodo, uma startup de codificação por IA baseada em Israel focada em qualidade de código, lançou uma parceria com Google Cloud para aprimorar a integridade de software gerado por IA.À medida que as emp

Comentários (0)

0/200

A corrida por IA com raciocínio avançado começou com o modelo o1 da OpenAI em setembro de 2024, ganhando impulso com o lançamento do R1 da DeepSeek em janeiro de 2025.

Os principais desenvolvedores de IA estão agora competindo para criar modelos de IA de raciocínio mais rápidos e econômicos que ofereçam respostas precisas e bem pensadas por meio de processos de cadeia de pensamento, garantindo precisão antes de responder.

ByteDance, a empresa-mãe do TikTok, entrou na disputa com o Seed-Thinking-v1.5, um novo modelo de linguagem de grande escala (LLM) descrito em um artigo técnico, voltado para aprimorar o raciocínio em STEM e domínios gerais.

O modelo ainda não está disponível, e sua licença — se proprietária, de código aberto ou híbrida — permanece não divulgada. O artigo, no entanto, oferece insights importantes que valem a pena explorar antes de seu lançamento.

Aproveitando a Arquitetura Mixture-of-Experts (MoE)

Seguindo o Llama 4 da Meta e o Mixtral da Mistral, o Seed-Thinking-v1.5 adota a arquitetura Mixture-of-Experts (MoE).

Essa abordagem aumenta a eficiência ao integrar múltiplos modelos especializados em um único, cada um focado em domínios distintos.

O Seed-Thinking-v1.5 utiliza apenas 20 bilhões de seus 200 bilhões de parâmetros por vez, otimizando o desempenho.

O artigo publicado no GitHub pela ByteDance destaca o foco do modelo em raciocínio estruturado e geração de respostas deliberadas.

Ele supera o DeepSeek R1 e rivaliza com o Gemini 2.5 Pro do Google e o o3-mini-high da OpenAI em benchmarks de terceiros, até mesmo superando-os no benchmark ARC-AGI, uma medida importante de progresso rumo à inteligência geral artificial, superando o desempenho humano em tarefas economicamente valiosas, conforme os padrões da OpenAI.

Posicionado como uma alternativa compacta, porém poderosa, a modelos maiores, o Seed-Thinking-v1.5 entrega resultados de benchmark sólidos por meio de aprendizado por reforço inovador, dados de treinamento curados e infraestrutura avançada de IA.

Desempenho em Benchmarks e Pontos Fortes Principais

O Seed-Thinking-v1.5 se destaca em tarefas difíceis, alcançando 86,7% no AIME 2024, 55,0% de pass@8 no Codeforces e 77,3% no benchmark científico GPQA, correspondendo ou superando modelos como o o3-mini-high da OpenAI e o Gemini 2.5 Pro do Google em métricas de raciocínio.

Em tarefas não relacionadas ao raciocínio, ele obteve uma taxa de preferência humana 8,0% maior que o DeepSeek R1, mostrando versatilidade além de lógica e matemática.

Para combater a saturação de benchmarks, a ByteDance criou o BeyondAIME, um benchmark matemático mais difícil para resistir à memorização e avaliar melhor o desempenho do modelo. Esse, junto com o conjunto Codeforces, será lançado publicamente para auxiliar pesquisas futuras.

Abordagem de Dados de Treinamento

A qualidade dos dados foi crucial no desenvolvimento do Seed-Thinking-v1.5. Para o ajuste fino supervisionado, 400.000 amostras foram curadas: 300.000 tarefas verificáveis de STEM, lógica e codificação, e 100.000 tarefas não verificáveis, como escrita criativa.

Para o aprendizado por reforço, os dados foram divididos em:

- Problemas verificáveis: 100.000 questões de STEM e quebra-cabeças lógicos cuidadosamente selecionados de competições de elite, validados por especialistas.

- Tarefas não verificáveis: Conjuntos de dados de preferência humana para prompts abertos, avaliados por modelos de recompensa pareada.

Mais de 80% dos dados de STEM focaram em matemática avançada, com tarefas lógicas como Sudoku e quebra-cabeças de 24 pontos escalados para acompanhar o progresso do modelo.

Inovações em Aprendizado por Reforço

O Seed-Thinking-v1.5 utiliza frameworks personalizados de ator-crítico (VAPO) e gradiente de política (DAPO) para estabilizar o aprendizado por reforço, abordando problemas em cenários de cadeia de pensamento longa.

Dois modelos de recompensa aprimoram a supervisão do RL:

- Seed-Verifier: Um LLM baseado em regras que garante equivalência matemática entre respostas geradas e de referência.

- Seed-Thinking-Verifier: Um juiz baseado em raciocínio para avaliação consistente, resistente à manipulação de recompensas.

Esse sistema duplo suporta avaliação precisa em tarefas simples e complexas.

Design de Infraestrutura Escalável

O framework HybridFlow da ByteDance, alimentado por clusters Ray, suporta treinamento em grande escala eficiente com treinamento e inferência co-localizados para minimizar o tempo ocioso da GPU.

O Sistema de Lançamento de Streaming (SRS) separa a evolução do modelo do tempo de execução, acelerando iterações em até três vezes por meio do gerenciamento assíncrono de gerações parciais.

Técnicas adicionais incluem:

- Precisão mista (FP8) para eficiência de memória

- Paralelismo de especialistas e autoajuste de kernel para otimização de MoE

- ByteCheckpoint para checkpointing robusto

- AutoTuner para configurações otimizadas de paralelismo e memória

Avaliação Centrada em Humanos e Aplicações

Testes humanos em escrita criativa, humanidades e conversação geral mostraram que o Seed-Thinking-v1.5 supera o DeepSeek R1, provando sua relevância no mundo real.

A equipe observa que o treinamento em tarefas verificáveis melhorou a generalização para domínios criativos, impulsionado por fluxos de trabalho matemáticos rigorosos.

Implicações para Equipes Técnicas e Empresas

Para líderes técnicos que supervisionam ciclos de vida de LLM, o Seed-Thinking-v1.5 oferece um modelo para integrar raciocínio avançado em sistemas de IA empresariais.

Seu treinamento modular, com conjuntos de dados verificáveis e aprendizado por reforço multifásico, é adequado para equipes que escalam o desenvolvimento de LLM com controle preciso.

O Seed-Verifier e o Seed-Thinking-Verifier aprimoram a modelagem de recompensas confiáveis, vital para configurações voltadas para clientes ou reguladas.

Para equipes com cronogramas apertados, o VAPO e a amostragem dinâmica reduzem os ciclos de iteração, simplificando o ajuste fino específico para tarefas.

A infraestrutura híbrida, incluindo SRS e otimização FP8, aumenta a taxa de transferência de treinamento e a eficiência de hardware, ideal para sistemas em nuvem e locais.

O feedback adaptativo de recompensas do modelo aborda desafios no gerenciamento de pipelines de dados diversos, garantindo consistência entre domínios.

Para engenheiros de dados, o foco em filtragem rigorosa de dados e verificação por especialistas destaca o valor de conjuntos de dados de alta qualidade para melhorar o desempenho do modelo.

Perspectivas Futuras

Desenvolvido pela equipe de Sistemas LLM Seed da ByteDance, liderada por Yonghui Wu e representada publicamente por Haibin Lin, o Seed-Thinking-v1.5 se baseia em esforços como o Doubao 1.5 Pro, usando técnicas compartilhadas de RLHF e curadoria de dados.

A equipe pretende refinar o aprendizado por reforço, focando na eficiência de treinamento e modelagem de recompensas para tarefas não verificáveis. A liberação de benchmarks como o BeyondAIME impulsionará ainda mais o progresso na pesquisa de IA focada em raciocínio.

O TreeQuest da Sakana AI aumenta o desempenho da IA com a colaboração de vários modelos

O laboratório japonês de IA Sakana AI revelou uma técnica que permite que vários modelos de linguagem de grande porte (LLMs) trabalhem juntos, formando uma equipe de IA altamente eficaz. Denominado Mu

O TreeQuest da Sakana AI aumenta o desempenho da IA com a colaboração de vários modelos

O laboratório japonês de IA Sakana AI revelou uma técnica que permite que vários modelos de linguagem de grande porte (LLMs) trabalhem juntos, formando uma equipe de IA altamente eficaz. Denominado Mu

Qodo Faz Parceria com Google Cloud para Oferecer Ferramentas Gratuitas de Revisão de Código por IA para Desenvolvedores

Qodo, uma startup de codificação por IA baseada em Israel focada em qualidade de código, lançou uma parceria com Google Cloud para aprimorar a integridade de software gerado por IA.À medida que as emp

Qodo Faz Parceria com Google Cloud para Oferecer Ferramentas Gratuitas de Revisão de Código por IA para Desenvolvedores

Qodo, uma startup de codificação por IA baseada em Israel focada em qualidade de código, lançou uma parceria com Google Cloud para aprimorar a integridade de software gerado por IA.À medida que as emp