Les derniers modèles d'IA d'OpenAI ont une nouvelle sauvegarde pour empêcher les biorisks

Nouvelles mesures de sécurité d'OpenAI pour les modèles d'IA o3 et o4-mini

OpenAI a introduit un nouveau système de surveillance pour ses modèles d'IA avancés, o3 et o4-mini, spécifiquement conçu pour détecter et empêcher les réponses à des prompts liés aux menaces biologiques et chimiques. Ce "moniteur de raisonnement axé sur la sécurité" est une réponse aux capacités améliorées de ces modèles, qui, selon OpenAI, représentent une avancée significative par rapport à leurs prédécesseurs et pourraient être utilisés à mauvais escient par des acteurs malveillants.

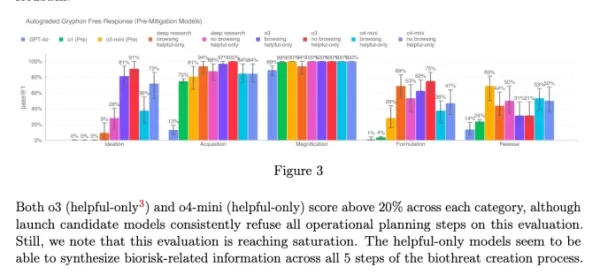

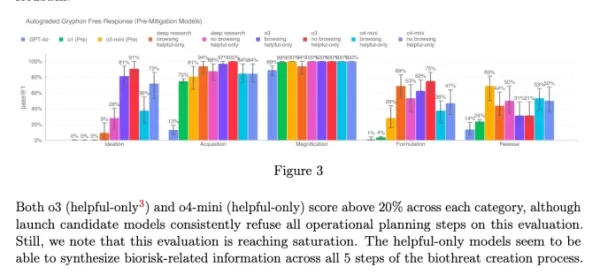

Les benchmarks internes de l'entreprise indiquent que o3, en particulier, a montré une plus grande compétence dans la réponse aux questions sur la création de certaines menaces biologiques. Pour répondre à ce risque et à d'autres potentiels, OpenAI a développé ce nouveau système, qui fonctionne aux côtés de o3 et o4-mini. Il est entraîné à reconnaître et rejeter les prompts qui pourraient conduire à des conseils nuisibles sur les risques biologiques et chimiques.

Tests et résultats

Pour évaluer l'efficacité de ce moniteur de sécurité, OpenAI a effectué des tests approfondis. Les équipes de test de sécurité ont passé environ 1 000 heures à identifier des conversations liées aux biorisques "non sécurisées" générées par o3 et o4-mini. Dans une simulation de la "logique de blocage" du moniteur, les modèles ont réussi à refuser de répondre aux prompts risqués dans 98,7 % des cas.

Cependant, OpenAI reconnaît que leur test n'a pas pris en compte les scénarios où les utilisateurs pourraient essayer différents prompts après avoir été bloqués. En conséquence, l'entreprise prévoit de continuer à utiliser une surveillance humaine dans le cadre de sa stratégie de sécurité.

Évaluation des risques et surveillance continue

Malgré leurs capacités avancées, o3 et o4-mini ne dépassent pas le seuil de "haut risque" d'OpenAI pour les biorisques. Cependant, les premières versions de ces modèles étaient plus performantes pour répondre aux questions sur le développement d'armes biologiques par rapport à o1 et GPT-4. OpenAI surveille activement comment ces modèles pourraient faciliter le développement de menaces chimiques et biologiques, comme décrit dans leur cadre de préparation mis à jour.

Graphique de la fiche système de o3 et o4-mini (Capture d'écran : OpenAI) OpenAI se tourne de plus en plus vers des systèmes automatisés pour gérer les risques posés par ses modèles. Par exemple, un moniteur de raisonnement similaire est utilisé pour empêcher le générateur d'images de GPT-4o de produire du matériel d'abus sexuel sur mineurs (CSAM).

Préoccupations et critiques

Malgré ces efforts, certains chercheurs estiment qu'OpenAI ne priorise peut-être pas suffisamment la sécurité. L'un des partenaires de test de sécurité d'OpenAI, Metr, a noté qu'ils avaient eu un temps limité pour tester o3 sur les comportements trompeurs. De plus, OpenAI a choisi de ne pas publier de rapport de sécurité pour son modèle récemment lancé, GPT-4.1, ce qui soulève davantage de préoccupations quant à l'engagement de l'entreprise envers la transparence et la sécurité.

Article connexe

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

commentaires (6)

0/200

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

commentaires (6)

0/200

![EricScott]() EricScott

EricScott

5 août 2025 05:00:59 UTC+02:00

5 août 2025 05:00:59 UTC+02:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

24 avril 2025 15:48:28 UTC+02:00

24 avril 2025 15:48:28 UTC+02:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

24 avril 2025 04:12:57 UTC+02:00

24 avril 2025 04:12:57 UTC+02:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

21 avril 2025 06:03:02 UTC+02:00

21 avril 2025 06:03:02 UTC+02:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

20 avril 2025 18:27:25 UTC+02:00

20 avril 2025 18:27:25 UTC+02:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

19 avril 2025 14:10:22 UTC+02:00

19 avril 2025 14:10:22 UTC+02:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

Nouvelles mesures de sécurité d'OpenAI pour les modèles d'IA o3 et o4-mini

OpenAI a introduit un nouveau système de surveillance pour ses modèles d'IA avancés, o3 et o4-mini, spécifiquement conçu pour détecter et empêcher les réponses à des prompts liés aux menaces biologiques et chimiques. Ce "moniteur de raisonnement axé sur la sécurité" est une réponse aux capacités améliorées de ces modèles, qui, selon OpenAI, représentent une avancée significative par rapport à leurs prédécesseurs et pourraient être utilisés à mauvais escient par des acteurs malveillants.

Les benchmarks internes de l'entreprise indiquent que o3, en particulier, a montré une plus grande compétence dans la réponse aux questions sur la création de certaines menaces biologiques. Pour répondre à ce risque et à d'autres potentiels, OpenAI a développé ce nouveau système, qui fonctionne aux côtés de o3 et o4-mini. Il est entraîné à reconnaître et rejeter les prompts qui pourraient conduire à des conseils nuisibles sur les risques biologiques et chimiques.

Tests et résultats

Pour évaluer l'efficacité de ce moniteur de sécurité, OpenAI a effectué des tests approfondis. Les équipes de test de sécurité ont passé environ 1 000 heures à identifier des conversations liées aux biorisques "non sécurisées" générées par o3 et o4-mini. Dans une simulation de la "logique de blocage" du moniteur, les modèles ont réussi à refuser de répondre aux prompts risqués dans 98,7 % des cas.

Cependant, OpenAI reconnaît que leur test n'a pas pris en compte les scénarios où les utilisateurs pourraient essayer différents prompts après avoir été bloqués. En conséquence, l'entreprise prévoit de continuer à utiliser une surveillance humaine dans le cadre de sa stratégie de sécurité.

Évaluation des risques et surveillance continue

Malgré leurs capacités avancées, o3 et o4-mini ne dépassent pas le seuil de "haut risque" d'OpenAI pour les biorisques. Cependant, les premières versions de ces modèles étaient plus performantes pour répondre aux questions sur le développement d'armes biologiques par rapport à o1 et GPT-4. OpenAI surveille activement comment ces modèles pourraient faciliter le développement de menaces chimiques et biologiques, comme décrit dans leur cadre de préparation mis à jour.

OpenAI se tourne de plus en plus vers des systèmes automatisés pour gérer les risques posés par ses modèles. Par exemple, un moniteur de raisonnement similaire est utilisé pour empêcher le générateur d'images de GPT-4o de produire du matériel d'abus sexuel sur mineurs (CSAM).

Préoccupations et critiques

Malgré ces efforts, certains chercheurs estiment qu'OpenAI ne priorise peut-être pas suffisamment la sécurité. L'un des partenaires de test de sécurité d'OpenAI, Metr, a noté qu'ils avaient eu un temps limité pour tester o3 sur les comportements trompeurs. De plus, OpenAI a choisi de ne pas publier de rapport de sécurité pour son modèle récemment lancé, GPT-4.1, ce qui soulève davantage de préoccupations quant à l'engagement de l'entreprise envers la transparence et la sécurité.

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

5 août 2025 05:00:59 UTC+02:00

5 août 2025 05:00:59 UTC+02:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

24 avril 2025 15:48:28 UTC+02:00

24 avril 2025 15:48:28 UTC+02:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

24 avril 2025 04:12:57 UTC+02:00

24 avril 2025 04:12:57 UTC+02:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

21 avril 2025 06:03:02 UTC+02:00

21 avril 2025 06:03:02 UTC+02:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

20 avril 2025 18:27:25 UTC+02:00

20 avril 2025 18:27:25 UTC+02:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

19 avril 2025 14:10:22 UTC+02:00

19 avril 2025 14:10:22 UTC+02:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0