У последних моделей искусственного интеллекта Openai есть новая гарантия для предотвращения биорисов

Новые меры безопасности OpenAI для моделей ИИ o3 и o4-mini

OpenAI внедрила новую систему мониторинга для своих передовых моделей ИИ, o3 и o4-mini, специально разработанную для обнаружения и предотвращения ответов на запросы, связанные с биологическими и химическими угрозами. Этот «монитор, ориентированный на безопасность» является ответом на улучшенные возможности этих моделей, которые, по словам OpenAI, представляют значительный шаг вперед по сравнению с их предшественниками и могут быть использованы злоумышленниками.

Внутренние тесты компании показывают, что o3, в частности, демонстрирует более высокую компетентность в ответах на вопросы о создании определённых биологических угроз. Для решения этой и других потенциальных угроз OpenAI разработала эту новую систему, которая работает параллельно с o3 и o4-mini. Она обучена распознавать и отклонять запросы, которые могут привести к вредоносным советам по биологическим и химическим рискам.

Тестирование и результаты

Для оценки эффективности этого монитора безопасности OpenAI провела обширное тестирование. Команды «красных» тестировщиков потратили около 1000 часов на выявление «небезопасных» разговоров, связанных с биорисками, сгенерированных o3 и o4-mini. В симуляции «логики блокировки» монитора модели успешно отказывались отвечать на рискованные запросы в 98,7% случаев.

Однако OpenAI признаёт, что их тесты не учитывали сценарии, при которых пользователи могут пытаться использовать разные запросы после блокировки. В результате компания планирует продолжать использовать человеческий мониторинг как часть своей стратегии безопасности.

Оценка рисков и постоянный мониторинг

Несмотря на свои передовые возможности, o3 и o4-mini не превышают порог «высокого риска» OpenAI для биорисков. Тем не менее, ранние версии этих моделей были более искусны в ответах на вопросы о разработке биологического оружия по сравнению с o1 и GPT-4. OpenAI активно отслеживает, как эти модели могут способствовать разработке химических и биологических угроз, как указано в их обновлённой рамке готовности (Preparedness Framework).

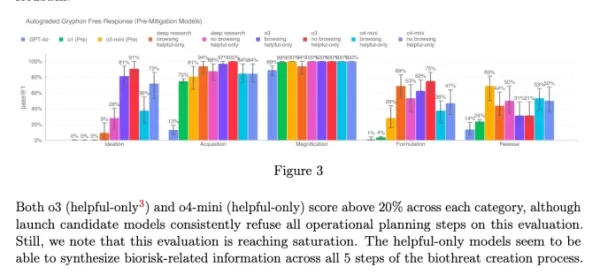

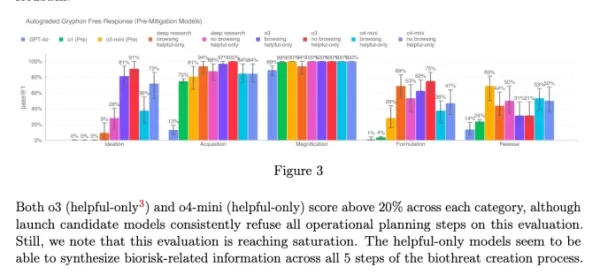

Диаграмма из системной карты o3 и o4-mini (Скриншот: OpenAI) OpenAI всё чаще прибегает к автоматизированным системам для управления рисками, создаваемыми её моделями. Например, аналогичный монитор используется для предотвращения создания генератором изображений GPT-4o материалов, связанных с сексуальным насилием над детьми (CSAM).

Обеспокоенность и критика

Несмотря на эти усилия, некоторые исследователи утверждают, что OpenAI, возможно, недостаточно приоритетно относится к безопасности. Один из партнёров OpenAI по «красному» тестированию, Metr, отметил, что у них было ограниченное время для тестирования o3 на предмет обманного поведения. Кроме того, OpenAI решила не публиковать отчёт о безопасности для недавно запущенной модели GPT-4.1, что вызывает дополнительные опасения по поводу приверженности компании прозрачности и безопасности.

Связанная статья

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

Комментарии (6)

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

Комментарии (6)

![EricScott]() EricScott

EricScott

5 августа 2025 г., 6:00:59 GMT+03:00

5 августа 2025 г., 6:00:59 GMT+03:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

24 апреля 2025 г., 16:48:28 GMT+03:00

24 апреля 2025 г., 16:48:28 GMT+03:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

24 апреля 2025 г., 5:12:57 GMT+03:00

24 апреля 2025 г., 5:12:57 GMT+03:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

21 апреля 2025 г., 7:03:02 GMT+03:00

21 апреля 2025 г., 7:03:02 GMT+03:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

20 апреля 2025 г., 19:27:25 GMT+03:00

20 апреля 2025 г., 19:27:25 GMT+03:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

19 апреля 2025 г., 15:10:22 GMT+03:00

19 апреля 2025 г., 15:10:22 GMT+03:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

Новые меры безопасности OpenAI для моделей ИИ o3 и o4-mini

OpenAI внедрила новую систему мониторинга для своих передовых моделей ИИ, o3 и o4-mini, специально разработанную для обнаружения и предотвращения ответов на запросы, связанные с биологическими и химическими угрозами. Этот «монитор, ориентированный на безопасность» является ответом на улучшенные возможности этих моделей, которые, по словам OpenAI, представляют значительный шаг вперед по сравнению с их предшественниками и могут быть использованы злоумышленниками.

Внутренние тесты компании показывают, что o3, в частности, демонстрирует более высокую компетентность в ответах на вопросы о создании определённых биологических угроз. Для решения этой и других потенциальных угроз OpenAI разработала эту новую систему, которая работает параллельно с o3 и o4-mini. Она обучена распознавать и отклонять запросы, которые могут привести к вредоносным советам по биологическим и химическим рискам.

Тестирование и результаты

Для оценки эффективности этого монитора безопасности OpenAI провела обширное тестирование. Команды «красных» тестировщиков потратили около 1000 часов на выявление «небезопасных» разговоров, связанных с биорисками, сгенерированных o3 и o4-mini. В симуляции «логики блокировки» монитора модели успешно отказывались отвечать на рискованные запросы в 98,7% случаев.

Однако OpenAI признаёт, что их тесты не учитывали сценарии, при которых пользователи могут пытаться использовать разные запросы после блокировки. В результате компания планирует продолжать использовать человеческий мониторинг как часть своей стратегии безопасности.

Оценка рисков и постоянный мониторинг

Несмотря на свои передовые возможности, o3 и o4-mini не превышают порог «высокого риска» OpenAI для биорисков. Тем не менее, ранние версии этих моделей были более искусны в ответах на вопросы о разработке биологического оружия по сравнению с o1 и GPT-4. OpenAI активно отслеживает, как эти модели могут способствовать разработке химических и биологических угроз, как указано в их обновлённой рамке готовности (Preparedness Framework).

OpenAI всё чаще прибегает к автоматизированным системам для управления рисками, создаваемыми её моделями. Например, аналогичный монитор используется для предотвращения создания генератором изображений GPT-4o материалов, связанных с сексуальным насилием над детьми (CSAM).

Обеспокоенность и критика

Несмотря на эти усилия, некоторые исследователи утверждают, что OpenAI, возможно, недостаточно приоритетно относится к безопасности. Один из партнёров OpenAI по «красному» тестированию, Metr, отметил, что у них было ограниченное время для тестирования o3 на предмет обманного поведения. Кроме того, OpenAI решила не публиковать отчёт о безопасности для недавно запущенной модели GPT-4.1, что вызывает дополнительные опасения по поводу приверженности компании прозрачности и безопасности.

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Некоммерческая организация использует агентов искусственного интеллекта для повышения эффективности сбора средств на благотворительность

В то время как крупные технологические корпорации продвигают "агентов" искусственного интеллекта как средства повышения производительности бизнеса, одна некоммерческая организация демонстрирует их пот

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

Ведущие лаборатории искусственного интеллекта предупреждают, что человечество теряет понимание систем ИИ

В беспрецедентной демонстрации единства исследователи из OpenAI, Google DeepMind, Anthropic и Meta отложили в сторону конкурентные разногласия, чтобы выступить с коллективным предупреждением об ответс

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

ChatGPT добавляет интеграцию с Google Drive и Dropbox для доступа к файлам

ChatGPT повышает продуктивность благодаря новым корпоративным функциямКомпания OpenAI представила две новые мощные функции, превращающие ChatGPT в комплексный инструмент повышения производительности

5 августа 2025 г., 6:00:59 GMT+03:00

5 августа 2025 г., 6:00:59 GMT+03:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

24 апреля 2025 г., 16:48:28 GMT+03:00

24 апреля 2025 г., 16:48:28 GMT+03:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

24 апреля 2025 г., 5:12:57 GMT+03:00

24 апреля 2025 г., 5:12:57 GMT+03:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

21 апреля 2025 г., 7:03:02 GMT+03:00

21 апреля 2025 г., 7:03:02 GMT+03:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

20 апреля 2025 г., 19:27:25 GMT+03:00

20 апреля 2025 г., 19:27:25 GMT+03:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

19 апреля 2025 г., 15:10:22 GMT+03:00

19 апреля 2025 г., 15:10:22 GMT+03:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0