Openai的最新AI型號具有新的保障措施,以防止生物風格

OpenAI對AI模型o3與o4-mini的新安全措施

OpenAI為其進階AI模型o3與o4-mini引入了一套新的監控系統,專為檢測並防止回應與生物和化學威脅相關的提示而設計。這種「以安全為核心的推理監控器」是針對這些模型增強功能所做出的回應,根據OpenAI的說法,這些模型相較於其前代產品有了顯著進步,且可能被惡意行為者濫用。

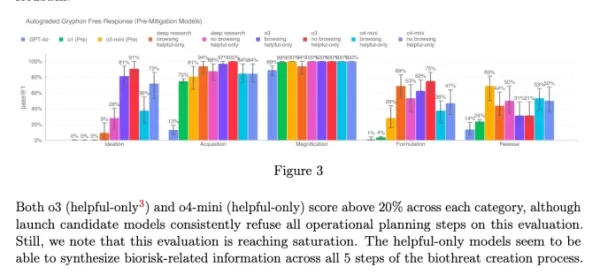

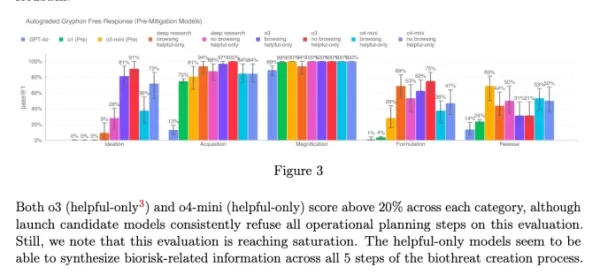

該公司的內部基準顯示,特別是o3在回答關於製造某些生物威脅的問題時表現出更高的熟練度。為了解決這一問題及其他潛在風險,OpenAI開發了這套新系統,與o3及o4-mini一同運作。該系統經過訓練,能識別並拒絕可能導致有害生物和化學風險建議的提示。

測試與結果

為了評估此安全監控器的有效性,OpenAI進行了廣泛的測試。紅隊成員花費大約1,000小時識別由o3及o4-mini生成的「不安全」生物風險相關對話。在模擬監控器的「阻斷邏輯」中,這些模型成功拒絕回應風險提示的比率達98.7%。

然而,OpenAI承認其測試未考慮用戶在被阻斷後可能嘗試不同提示的情況。因此,該公司計劃繼續使用人工監控作為其安全策略的一部分。

風險評估與持續監控

儘管具有進階功能,o3與o4-mini並未超過OpenAI對生物風險的「高風險」門檻。然而,這些模型的早期版本在回答關於開發生物武器的問題時,與o1及GPT-4相比更為熟練。OpenAI正積極監控這些模型可能如何促進化學和生物威脅的發展,如其更新的準備框架所述。

來自o3與o4-mini系統卡的圖表(截圖:OpenAI) OpenAI日益依賴自動化系統來管理其模型帶來的風險。例如,類似的推理監控器被用於防止GPT-4o的圖像生成器產生兒童性虐待材料(CSAM)。

關注與批評

儘管有這些努力,一些研究人員認為OpenAI可能未足夠重視安全。OpenAI的紅隊合作夥伴之一Metr指出,他們測試o3的欺騙行為的時間有限。此外,OpenAI選擇不為其最近推出的GPT-4.1模型發布安全報告,這進一步引發了對該公司透明度與安全承諾的關注。

相關文章

非營利組織利用 AI 代理提升慈善募款工作

當各大科技公司將人工智慧「代理」推廣為企業生產力的助推器時,一家非營利組織正在展示人工智慧在社會公益方面的潛力。由 Open Philanthropy 支持的慈善研究組織 Sage Future 最近進行了一項創新實驗,展示 AI 模型如何協同進行慈善募款。該非營利組織將 OpenAI 的 GPT-4o 與 o1,以及 Anthropic 的 Claude 3.6 與 3.7 Sonnet 等

非營利組織利用 AI 代理提升慈善募款工作

當各大科技公司將人工智慧「代理」推廣為企業生產力的助推器時,一家非營利組織正在展示人工智慧在社會公益方面的潛力。由 Open Philanthropy 支持的慈善研究組織 Sage Future 最近進行了一項創新實驗,展示 AI 模型如何協同進行慈善募款。該非營利組織將 OpenAI 的 GPT-4o 與 o1,以及 Anthropic 的 Claude 3.6 與 3.7 Sonnet 等

頂尖 AI 實驗室警告人類正在失去理解 AI 系統的能力

來自 OpenAI、Google DeepMind、Anthropic 和 Meta 的研究人員,史無前例地展現團結,擱置競爭分歧,就負責任的 AI 開發發出集體警告。來自這些典型競爭組織的 40 多位頂尖科學家共同撰寫了一份突破性的研究論文,強調確保 AI 決策過程透明化的窗口正在快速關閉。此次合作的重點在於現代人工智能系統的一項關鍵發展 - 在產生最終輸出之前,以人類可讀的語言闡明推理過程的新

頂尖 AI 實驗室警告人類正在失去理解 AI 系統的能力

來自 OpenAI、Google DeepMind、Anthropic 和 Meta 的研究人員,史無前例地展現團結,擱置競爭分歧,就負責任的 AI 開發發出集體警告。來自這些典型競爭組織的 40 多位頂尖科學家共同撰寫了一份突破性的研究論文,強調確保 AI 決策過程透明化的窗口正在快速關閉。此次合作的重點在於現代人工智能系統的一項關鍵發展 - 在產生最終輸出之前,以人類可讀的語言闡明推理過程的新

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

評論 (6)

0/200

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

評論 (6)

0/200

![EricScott]() EricScott

EricScott

2025-08-05 11:00:59

2025-08-05 11:00:59

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

2025-04-24 21:48:28

2025-04-24 21:48:28

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

2025-04-24 10:12:57

2025-04-24 10:12:57

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

2025-04-21 12:03:02

2025-04-21 12:03:02

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

2025-04-21 00:27:25

2025-04-21 00:27:25

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

2025-04-19 20:10:22

2025-04-19 20:10:22

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

OpenAI對AI模型o3與o4-mini的新安全措施

OpenAI為其進階AI模型o3與o4-mini引入了一套新的監控系統,專為檢測並防止回應與生物和化學威脅相關的提示而設計。這種「以安全為核心的推理監控器」是針對這些模型增強功能所做出的回應,根據OpenAI的說法,這些模型相較於其前代產品有了顯著進步,且可能被惡意行為者濫用。

該公司的內部基準顯示,特別是o3在回答關於製造某些生物威脅的問題時表現出更高的熟練度。為了解決這一問題及其他潛在風險,OpenAI開發了這套新系統,與o3及o4-mini一同運作。該系統經過訓練,能識別並拒絕可能導致有害生物和化學風險建議的提示。

測試與結果

為了評估此安全監控器的有效性,OpenAI進行了廣泛的測試。紅隊成員花費大約1,000小時識別由o3及o4-mini生成的「不安全」生物風險相關對話。在模擬監控器的「阻斷邏輯」中,這些模型成功拒絕回應風險提示的比率達98.7%。

然而,OpenAI承認其測試未考慮用戶在被阻斷後可能嘗試不同提示的情況。因此,該公司計劃繼續使用人工監控作為其安全策略的一部分。

風險評估與持續監控

儘管具有進階功能,o3與o4-mini並未超過OpenAI對生物風險的「高風險」門檻。然而,這些模型的早期版本在回答關於開發生物武器的問題時,與o1及GPT-4相比更為熟練。OpenAI正積極監控這些模型可能如何促進化學和生物威脅的發展,如其更新的準備框架所述。

OpenAI日益依賴自動化系統來管理其模型帶來的風險。例如,類似的推理監控器被用於防止GPT-4o的圖像生成器產生兒童性虐待材料(CSAM)。

關注與批評

儘管有這些努力,一些研究人員認為OpenAI可能未足夠重視安全。OpenAI的紅隊合作夥伴之一Metr指出,他們測試o3的欺騙行為的時間有限。此外,OpenAI選擇不為其最近推出的GPT-4.1模型發布安全報告,這進一步引發了對該公司透明度與安全承諾的關注。

非營利組織利用 AI 代理提升慈善募款工作

當各大科技公司將人工智慧「代理」推廣為企業生產力的助推器時,一家非營利組織正在展示人工智慧在社會公益方面的潛力。由 Open Philanthropy 支持的慈善研究組織 Sage Future 最近進行了一項創新實驗,展示 AI 模型如何協同進行慈善募款。該非營利組織將 OpenAI 的 GPT-4o 與 o1,以及 Anthropic 的 Claude 3.6 與 3.7 Sonnet 等

非營利組織利用 AI 代理提升慈善募款工作

當各大科技公司將人工智慧「代理」推廣為企業生產力的助推器時,一家非營利組織正在展示人工智慧在社會公益方面的潛力。由 Open Philanthropy 支持的慈善研究組織 Sage Future 最近進行了一項創新實驗,展示 AI 模型如何協同進行慈善募款。該非營利組織將 OpenAI 的 GPT-4o 與 o1,以及 Anthropic 的 Claude 3.6 與 3.7 Sonnet 等

頂尖 AI 實驗室警告人類正在失去理解 AI 系統的能力

來自 OpenAI、Google DeepMind、Anthropic 和 Meta 的研究人員,史無前例地展現團結,擱置競爭分歧,就負責任的 AI 開發發出集體警告。來自這些典型競爭組織的 40 多位頂尖科學家共同撰寫了一份突破性的研究論文,強調確保 AI 決策過程透明化的窗口正在快速關閉。此次合作的重點在於現代人工智能系統的一項關鍵發展 - 在產生最終輸出之前,以人類可讀的語言闡明推理過程的新

頂尖 AI 實驗室警告人類正在失去理解 AI 系統的能力

來自 OpenAI、Google DeepMind、Anthropic 和 Meta 的研究人員,史無前例地展現團結,擱置競爭分歧,就負責任的 AI 開發發出集體警告。來自這些典型競爭組織的 40 多位頂尖科學家共同撰寫了一份突破性的研究論文,強調確保 AI 決策過程透明化的窗口正在快速關閉。此次合作的重點在於現代人工智能系統的一項關鍵發展 - 在產生最終輸出之前,以人類可讀的語言闡明推理過程的新

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

ChatGPT 新增 Google Drive 和 Dropbox 整合功能以存取檔案

ChatGPT 利用新的企業功能增強生產力OpenAI 發表了兩項強大的新功能,將 ChatGPT 轉型為全面的企業生產力工具:自動化會議記錄和無縫雲儲存整合。革命性的錄音功能新推出的 「記錄模式 」可自動轉錄和分析以下內容:重要的商務會議有創意的腦力激盪會議 個人思考過程此優質功能目前為 ChatGPT 團隊訂閱者專屬 (每位使用者每月 $25),可提供:精確、有時

2025-08-05 11:00:59

2025-08-05 11:00:59

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

2025-04-24 21:48:28

2025-04-24 21:48:28

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

2025-04-24 10:12:57

2025-04-24 10:12:57

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

2025-04-21 12:03:02

2025-04-21 12:03:02

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

2025-04-21 00:27:25

2025-04-21 00:27:25

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

2025-04-19 20:10:22

2025-04-19 20:10:22

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0