OpenAi의 최신 AI 모델에는 생물을 방지하기위한 새로운 보호 장치가 있습니다.

OpenAI의 AI 모델 o3 및 o4-mini를 위한 새로운 안전 조치

OpenAI는 고급 AI 모델인 o3 및 o4-mini를 위해 새로운 모니터링 시스템을 도입했으며, 이 시스템은 생물학적 및 화학적 위협과 관련된 프롬프트에 대한 응답을 탐지하고 방지하도록 특별히 설계되었습니다. 이 "안전 중심 추론 모니터"는 OpenAI에 따르면 이전 모델들보다 상당한 발전을 이룬 이러한 모델들의 향상된 능력에 대응하며, 악의적인 행위자들에 의해 오용될 가능성을 염두에 둔 것입니다.

회사 내부 벤치마크에 따르면 특히 o3는 특정 생물학적 위협 생성에 관한 질문에 답하는 데 더 높은 숙련도를 보여주었습니다. 이러한 잠재적 위험과 기타 위험을 해결하기 위해 OpenAI는 o3 및 o4-mini와 함께 작동하는 새로운 시스템을 개발했습니다. 이 시스템은 생물학적 및 화학적 위험에 대한 해로운 조언으로 이어질 수 있는 프롬프트를 인식하고 거부하도록 훈련되었습니다.

테스트 및 결과

이 안전 모니터의 효과를 평가하기 위해 OpenAI는 광범위한 테스트를 수행했습니다. 레드 팀은 약 1,000시간 동안 o3 및 o4-mini에서 생성된 "안전하지 않은" 바이오리스크 관련 대화를 식별했습니다. 모니터의 "차단 로직" 시뮬레이션에서 모델은 위험한 프롬프트에 98.7%의 비율로 응답을 거부했습니다.

그러나 OpenAI는 사용자가 차단된 후 다른 프롬프트를 시도할 수 있는 시나리오를 테스트에서 고려하지 않았다고 인정했습니다. 이에 따라 회사는 안전 전략의 일환으로 인간 모니터링을 계속 사용할 계획입니다.

위험 평가 및 지속적인 모니터링

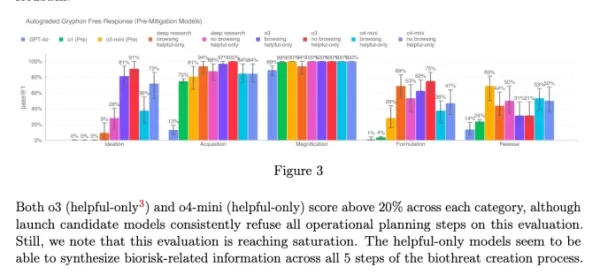

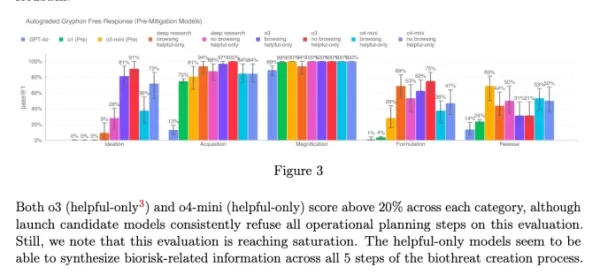

고급 기능에도 불구하고 o3 및 o4-mini는 OpenAI의 "고위험" 바이오리스크 기준을 초과하지 않습니다. 그러나 이러한 모델의 초기 버전은 o1 및 GPT-4에 비해 생물학적 무기 개발에 관한 질문에 답하는 데 더 뛰어났습니다. OpenAI는 업데이트된 준비 프레임워크에 명시된 대로 이러한 모델이 화학 및 생물학적 위협 개발을 촉진할 가능성을 적극적으로 모니터링하고 있습니다.

o3 및 o4-mini의 시스템 카드 차트 (스크린샷: OpenAI) OpenAI는 모델이 초래하는 위험을 관리하기 위해 점점 더 자동화된 시스템에 의존하고 있습니다. 예를 들어, 유사한 추론 모니터는 GPT-4o의 이미지 생성기가 아동 성 학대 자료(CSAM)를 생성하지 않도록 방지하는 데 사용됩니다.

우려와 비판

이러한 노력에도 불구하고 일부 연구자들은 OpenAI가 안전을 충분히 우선순위에 두지 않는다고 주장합니다. OpenAI의 레드 팀 파트너 중 하나인 Metr은 o3의 기만적 행동을 테스트할 시간이 제한적이었다고 언급했습니다. 또한 OpenAI는 최근 출시된 GPT-4.1 모델에 대한 안전 보고서를 공개하지 않기로 결정하여 회사의 투명성과 안전에 대한 헌신에 대한 추가적인 우려를 불러일으켰습니다.

관련 기사

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

AI 에이전트를 활용하여 자선 기금 모금 활동을 강화하는 비영리 단체

주요 기술 기업들이 AI '에이전트'를 기업의 생산성을 높여주는 도구로 홍보하는 가운데, 한 비영리 단체는 사회적 공익을 위한 AI의 잠재력을 입증하고 있습니다. 오픈 필란트로피의 지원을 받는 자선 연구 단체인 세이지 퓨처는 최근 AI 모델이 자선 기금 모금에 어떻게 협력할 수 있는지 보여주는 혁신적인 실험을 진행했습니다.이 비영리 단체는 자선 단체를

AI 에이전트를 활용하여 자선 기금 모금 활동을 강화하는 비영리 단체

주요 기술 기업들이 AI '에이전트'를 기업의 생산성을 높여주는 도구로 홍보하는 가운데, 한 비영리 단체는 사회적 공익을 위한 AI의 잠재력을 입증하고 있습니다. 오픈 필란트로피의 지원을 받는 자선 연구 단체인 세이지 퓨처는 최근 AI 모델이 자선 기금 모금에 어떻게 협력할 수 있는지 보여주는 혁신적인 실험을 진행했습니다.이 비영리 단체는 자선 단체를

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

의견 (6)

0/200

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

의견 (6)

0/200

![EricScott]() EricScott

EricScott

2025년 8월 5일 오후 12시 0분 59초 GMT+09:00

2025년 8월 5일 오후 12시 0분 59초 GMT+09:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

2025년 4월 24일 오후 10시 48분 28초 GMT+09:00

2025년 4월 24일 오후 10시 48분 28초 GMT+09:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

2025년 4월 24일 오전 11시 12분 57초 GMT+09:00

2025년 4월 24일 오전 11시 12분 57초 GMT+09:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

2025년 4월 21일 오후 1시 3분 2초 GMT+09:00

2025년 4월 21일 오후 1시 3분 2초 GMT+09:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

2025년 4월 21일 오전 1시 27분 25초 GMT+09:00

2025년 4월 21일 오전 1시 27분 25초 GMT+09:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

2025년 4월 19일 오후 9시 10분 22초 GMT+09:00

2025년 4월 19일 오후 9시 10분 22초 GMT+09:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

OpenAI의 AI 모델 o3 및 o4-mini를 위한 새로운 안전 조치

OpenAI는 고급 AI 모델인 o3 및 o4-mini를 위해 새로운 모니터링 시스템을 도입했으며, 이 시스템은 생물학적 및 화학적 위협과 관련된 프롬프트에 대한 응답을 탐지하고 방지하도록 특별히 설계되었습니다. 이 "안전 중심 추론 모니터"는 OpenAI에 따르면 이전 모델들보다 상당한 발전을 이룬 이러한 모델들의 향상된 능력에 대응하며, 악의적인 행위자들에 의해 오용될 가능성을 염두에 둔 것입니다.

회사 내부 벤치마크에 따르면 특히 o3는 특정 생물학적 위협 생성에 관한 질문에 답하는 데 더 높은 숙련도를 보여주었습니다. 이러한 잠재적 위험과 기타 위험을 해결하기 위해 OpenAI는 o3 및 o4-mini와 함께 작동하는 새로운 시스템을 개발했습니다. 이 시스템은 생물학적 및 화학적 위험에 대한 해로운 조언으로 이어질 수 있는 프롬프트를 인식하고 거부하도록 훈련되었습니다.

테스트 및 결과

이 안전 모니터의 효과를 평가하기 위해 OpenAI는 광범위한 테스트를 수행했습니다. 레드 팀은 약 1,000시간 동안 o3 및 o4-mini에서 생성된 "안전하지 않은" 바이오리스크 관련 대화를 식별했습니다. 모니터의 "차단 로직" 시뮬레이션에서 모델은 위험한 프롬프트에 98.7%의 비율로 응답을 거부했습니다.

그러나 OpenAI는 사용자가 차단된 후 다른 프롬프트를 시도할 수 있는 시나리오를 테스트에서 고려하지 않았다고 인정했습니다. 이에 따라 회사는 안전 전략의 일환으로 인간 모니터링을 계속 사용할 계획입니다.

위험 평가 및 지속적인 모니터링

고급 기능에도 불구하고 o3 및 o4-mini는 OpenAI의 "고위험" 바이오리스크 기준을 초과하지 않습니다. 그러나 이러한 모델의 초기 버전은 o1 및 GPT-4에 비해 생물학적 무기 개발에 관한 질문에 답하는 데 더 뛰어났습니다. OpenAI는 업데이트된 준비 프레임워크에 명시된 대로 이러한 모델이 화학 및 생물학적 위협 개발을 촉진할 가능성을 적극적으로 모니터링하고 있습니다.

OpenAI는 모델이 초래하는 위험을 관리하기 위해 점점 더 자동화된 시스템에 의존하고 있습니다. 예를 들어, 유사한 추론 모니터는 GPT-4o의 이미지 생성기가 아동 성 학대 자료(CSAM)를 생성하지 않도록 방지하는 데 사용됩니다.

우려와 비판

이러한 노력에도 불구하고 일부 연구자들은 OpenAI가 안전을 충분히 우선순위에 두지 않는다고 주장합니다. OpenAI의 레드 팀 파트너 중 하나인 Metr은 o3의 기만적 행동을 테스트할 시간이 제한적이었다고 언급했습니다. 또한 OpenAI는 최근 출시된 GPT-4.1 모델에 대한 안전 보고서를 공개하지 않기로 결정하여 회사의 투명성과 안전에 대한 헌신에 대한 추가적인 우려를 불러일으켰습니다.

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

OpenAI, ChatGPT Pro를 o3로 업그레이드하고 월 구독료 $200로 가치 증대

이번 주에는 마이크로소프트, 구글, 앤트로픽을 비롯한 거대 기술 기업들의 중요한 AI 개발이 있었습니다. OpenAI는 코드명 "io"라는 야심찬 하드웨어 이니셔티브를 위해 65억 달러에 인수한 조니 아이브의 디자인 회사를 넘어서는 획기적인 업데이트를 발표하며 활발한 발표를 마무리했습니다.이 회사는 이전의 GPT-4o 프레임워크에서 고급 추론 모델인 o3로

AI 에이전트를 활용하여 자선 기금 모금 활동을 강화하는 비영리 단체

주요 기술 기업들이 AI '에이전트'를 기업의 생산성을 높여주는 도구로 홍보하는 가운데, 한 비영리 단체는 사회적 공익을 위한 AI의 잠재력을 입증하고 있습니다. 오픈 필란트로피의 지원을 받는 자선 연구 단체인 세이지 퓨처는 최근 AI 모델이 자선 기금 모금에 어떻게 협력할 수 있는지 보여주는 혁신적인 실험을 진행했습니다.이 비영리 단체는 자선 단체를

AI 에이전트를 활용하여 자선 기금 모금 활동을 강화하는 비영리 단체

주요 기술 기업들이 AI '에이전트'를 기업의 생산성을 높여주는 도구로 홍보하는 가운데, 한 비영리 단체는 사회적 공익을 위한 AI의 잠재력을 입증하고 있습니다. 오픈 필란트로피의 지원을 받는 자선 연구 단체인 세이지 퓨처는 최근 AI 모델이 자선 기금 모금에 어떻게 협력할 수 있는지 보여주는 혁신적인 실험을 진행했습니다.이 비영리 단체는 자선 단체를

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

최고의 AI 연구소, 인류가 AI 시스템에 대한 이해력을 잃어가고 있다고 경고하다

전례 없는 단결력을 보여준 OpenAI, Google DeepMind, Anthropic, Meta의 연구원들은 경쟁적 차이를 제쳐두고 책임감 있는 AI 개발에 대한 공동의 경고를 발표했습니다. 일반적으로 라이벌 관계에 있는 이들 조직의 40여 명의 선도적인 과학자들은 AI 의사결정 과정의 투명성을 보장하기 위해 빠르게 닫혀가는 창을 강조하는 획기적인 연구

2025년 8월 5일 오후 12시 0분 59초 GMT+09:00

2025년 8월 5일 오후 12시 0분 59초 GMT+09:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

2025년 4월 24일 오후 10시 48분 28초 GMT+09:00

2025년 4월 24일 오후 10시 48분 28초 GMT+09:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

2025년 4월 24일 오전 11시 12분 57초 GMT+09:00

2025년 4월 24일 오전 11시 12분 57초 GMT+09:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

2025년 4월 21일 오후 1시 3분 2초 GMT+09:00

2025년 4월 21일 오후 1시 3분 2초 GMT+09:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

2025년 4월 21일 오전 1시 27분 25초 GMT+09:00

2025년 4월 21일 오전 1시 27분 25초 GMT+09:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

2025년 4월 19일 오후 9시 10분 22초 GMT+09:00

2025년 4월 19일 오후 9시 10분 22초 GMT+09:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0