Openai的最新AI型号具有新的保障措施,以防止生物风格

OpenAI为AI模型o3和o4-mini推出的新安全措施

OpenAI为其先进AI模型o3和o4-mini引入了新的监控系统,专门设计用于检测和防止回应与生物和化学威胁相关的提示。这种“以安全为重点的推理监控器”是针对这些模型增强功能的回应,据OpenAI称,这些模型相较于其前代产品有了显著提升,可能被恶意行为者滥用。

公司内部基准测试表明,特别是o3在回答关于制造某些生物威胁的问题时表现出更高的熟练度。为了应对这一风险及其他潜在风险,OpenAI开发了这一新系统,该系统与o3和o4-mini一同运行。它被训练来识别并拒绝可能导致有害生物和化学风险建议的提示。

测试与结果

为了评估这一安全监控器的有效性,OpenAI进行了广泛的测试。红队成员花费大约1000小时识别由o3和o4-mini生成的“非安全”生物风险相关对话。在监控器的“阻止逻辑”模拟中,模型成功拒绝了98.7%的风险提示。

然而,OpenAI承认,他们的测试并未考虑用户在被阻止后可能尝试不同提示的场景。因此,公司计划继续将人工监控作为其安全策略的一部分。

风险评估与持续监控

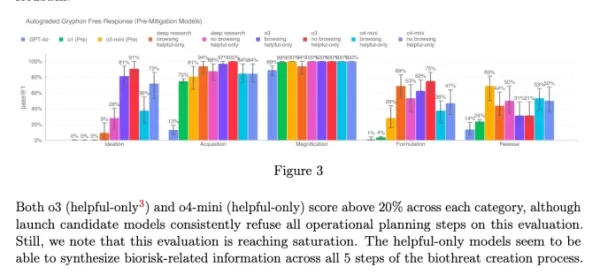

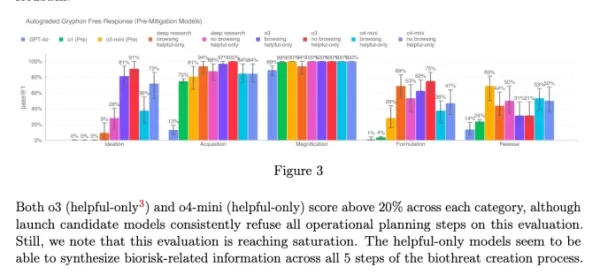

尽管具备先进功能,o3和o4-mini并未超过OpenAI对生物风险的“高风险”阈值。然而,这些模型的早期版本在回答关于开发生物武器的问题时,相比o1和GPT-4表现出更强的能力。OpenAI正在积极监控这些模型可能如何促进化学和生物威胁的发展,正如其更新的准备框架中所概述。

o3和o4-mini系统卡中的图表(截图:OpenAI) OpenAI越来越倾向于使用自动化系统来管理其模型带来的风险。例如,类似的推理监控器被用于防止GPT-4o的图像生成器产生儿童性虐待材料(CSAM)。

担忧与批评

尽管做出了这些努力,一些研究人员认为OpenAI可能未足够重视安全。OpenAI的红队合作伙伴之一Metr指出,他们测试o3的欺骗行为时间有限。此外,OpenAI选择不为其最近推出的GPT-4.1模型发布安全报告,这进一步引发了对其透明度和安全承诺的担忧。

相关文章

非营利组织利用人工智能代理促进慈善筹款工作

当大型科技公司将人工智能 "代理 "作为企业生产力的助推器进行推广时,一家非营利组织正在展示它们在社会公益方面的潜力。由开放慈善组织(Open Philanthropy)支持的慈善研究机构赛智未来(Sage Future)最近进行了一项创新实验,展示了人工智能模型如何在慈善筹款方面进行合作。该非营利组织在一个模拟数字环境中设置了四个先进的人工智能模型--OpenAI 的 GPT-4o 和 o1

非营利组织利用人工智能代理促进慈善筹款工作

当大型科技公司将人工智能 "代理 "作为企业生产力的助推器进行推广时,一家非营利组织正在展示它们在社会公益方面的潜力。由开放慈善组织(Open Philanthropy)支持的慈善研究机构赛智未来(Sage Future)最近进行了一项创新实验,展示了人工智能模型如何在慈善筹款方面进行合作。该非营利组织在一个模拟数字环境中设置了四个先进的人工智能模型--OpenAI 的 GPT-4o 和 o1

顶级人工智能实验室警告人类正在失去理解人工智能系统的能力

来自 OpenAI、谷歌 DeepMind、Anthropic 和 Meta 的研究人员前所未有地团结起来,搁置竞争分歧,就负责任的人工智能发展发出集体警告。来自这些通常相互竞争的组织的 40 多名顶尖科学家共同撰写了一篇开创性的研究论文,强调确保人工智能决策过程透明度的窗口正在迅速关闭。这次合作的重点是现代人工智能系统的一个关键发展--它们在生成最终输出之前,能够以人类可读的语言阐明推理过程的新

顶级人工智能实验室警告人类正在失去理解人工智能系统的能力

来自 OpenAI、谷歌 DeepMind、Anthropic 和 Meta 的研究人员前所未有地团结起来,搁置竞争分歧,就负责任的人工智能发展发出集体警告。来自这些通常相互竞争的组织的 40 多名顶尖科学家共同撰写了一篇开创性的研究论文,强调确保人工智能决策过程透明度的窗口正在迅速关闭。这次合作的重点是现代人工智能系统的一个关键发展--它们在生成最终输出之前,能够以人类可读的语言阐明推理过程的新

ChatGPT 添加了 Google Drive 和 Dropbox 集成,用于文件访问

ChatGPT 通过新的企业功能提高生产力OpenAI 推出两项强大的新功能,将 ChatGPT 转变为全面的企业生产力工具:自动会议记录和无缝云存储集成。革命性的记录功能新推出的 "记录模式 "可自动转录和分析以下内容:重要的商务会议创造性的头脑风暴会议 个人思维过程这一高级功能目前仅面向 ChatGPT 团队用户(每用户每月 25 美元),可提供准确、有时间戳的记

评论 (6)

0/200

ChatGPT 添加了 Google Drive 和 Dropbox 集成,用于文件访问

ChatGPT 通过新的企业功能提高生产力OpenAI 推出两项强大的新功能,将 ChatGPT 转变为全面的企业生产力工具:自动会议记录和无缝云存储集成。革命性的记录功能新推出的 "记录模式 "可自动转录和分析以下内容:重要的商务会议创造性的头脑风暴会议 个人思维过程这一高级功能目前仅面向 ChatGPT 团队用户(每用户每月 25 美元),可提供准确、有时间戳的记

评论 (6)

0/200

![EricScott]() EricScott

EricScott

2025-08-05 11:00:59

2025-08-05 11:00:59

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

2025-04-24 21:48:28

2025-04-24 21:48:28

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

2025-04-24 10:12:57

2025-04-24 10:12:57

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

2025-04-21 12:03:02

2025-04-21 12:03:02

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

2025-04-21 00:27:25

2025-04-21 00:27:25

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

2025-04-19 20:10:22

2025-04-19 20:10:22

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

OpenAI为AI模型o3和o4-mini推出的新安全措施

OpenAI为其先进AI模型o3和o4-mini引入了新的监控系统,专门设计用于检测和防止回应与生物和化学威胁相关的提示。这种“以安全为重点的推理监控器”是针对这些模型增强功能的回应,据OpenAI称,这些模型相较于其前代产品有了显著提升,可能被恶意行为者滥用。

公司内部基准测试表明,特别是o3在回答关于制造某些生物威胁的问题时表现出更高的熟练度。为了应对这一风险及其他潜在风险,OpenAI开发了这一新系统,该系统与o3和o4-mini一同运行。它被训练来识别并拒绝可能导致有害生物和化学风险建议的提示。

测试与结果

为了评估这一安全监控器的有效性,OpenAI进行了广泛的测试。红队成员花费大约1000小时识别由o3和o4-mini生成的“非安全”生物风险相关对话。在监控器的“阻止逻辑”模拟中,模型成功拒绝了98.7%的风险提示。

然而,OpenAI承认,他们的测试并未考虑用户在被阻止后可能尝试不同提示的场景。因此,公司计划继续将人工监控作为其安全策略的一部分。

风险评估与持续监控

尽管具备先进功能,o3和o4-mini并未超过OpenAI对生物风险的“高风险”阈值。然而,这些模型的早期版本在回答关于开发生物武器的问题时,相比o1和GPT-4表现出更强的能力。OpenAI正在积极监控这些模型可能如何促进化学和生物威胁的发展,正如其更新的准备框架中所概述。

OpenAI越来越倾向于使用自动化系统来管理其模型带来的风险。例如,类似的推理监控器被用于防止GPT-4o的图像生成器产生儿童性虐待材料(CSAM)。

担忧与批评

尽管做出了这些努力,一些研究人员认为OpenAI可能未足够重视安全。OpenAI的红队合作伙伴之一Metr指出,他们测试o3的欺骗行为时间有限。此外,OpenAI选择不为其最近推出的GPT-4.1模型发布安全报告,这进一步引发了对其透明度和安全承诺的担忧。

非营利组织利用人工智能代理促进慈善筹款工作

当大型科技公司将人工智能 "代理 "作为企业生产力的助推器进行推广时,一家非营利组织正在展示它们在社会公益方面的潜力。由开放慈善组织(Open Philanthropy)支持的慈善研究机构赛智未来(Sage Future)最近进行了一项创新实验,展示了人工智能模型如何在慈善筹款方面进行合作。该非营利组织在一个模拟数字环境中设置了四个先进的人工智能模型--OpenAI 的 GPT-4o 和 o1

非营利组织利用人工智能代理促进慈善筹款工作

当大型科技公司将人工智能 "代理 "作为企业生产力的助推器进行推广时,一家非营利组织正在展示它们在社会公益方面的潜力。由开放慈善组织(Open Philanthropy)支持的慈善研究机构赛智未来(Sage Future)最近进行了一项创新实验,展示了人工智能模型如何在慈善筹款方面进行合作。该非营利组织在一个模拟数字环境中设置了四个先进的人工智能模型--OpenAI 的 GPT-4o 和 o1

顶级人工智能实验室警告人类正在失去理解人工智能系统的能力

来自 OpenAI、谷歌 DeepMind、Anthropic 和 Meta 的研究人员前所未有地团结起来,搁置竞争分歧,就负责任的人工智能发展发出集体警告。来自这些通常相互竞争的组织的 40 多名顶尖科学家共同撰写了一篇开创性的研究论文,强调确保人工智能决策过程透明度的窗口正在迅速关闭。这次合作的重点是现代人工智能系统的一个关键发展--它们在生成最终输出之前,能够以人类可读的语言阐明推理过程的新

顶级人工智能实验室警告人类正在失去理解人工智能系统的能力

来自 OpenAI、谷歌 DeepMind、Anthropic 和 Meta 的研究人员前所未有地团结起来,搁置竞争分歧,就负责任的人工智能发展发出集体警告。来自这些通常相互竞争的组织的 40 多名顶尖科学家共同撰写了一篇开创性的研究论文,强调确保人工智能决策过程透明度的窗口正在迅速关闭。这次合作的重点是现代人工智能系统的一个关键发展--它们在生成最终输出之前,能够以人类可读的语言阐明推理过程的新

ChatGPT 添加了 Google Drive 和 Dropbox 集成,用于文件访问

ChatGPT 通过新的企业功能提高生产力OpenAI 推出两项强大的新功能,将 ChatGPT 转变为全面的企业生产力工具:自动会议记录和无缝云存储集成。革命性的记录功能新推出的 "记录模式 "可自动转录和分析以下内容:重要的商务会议创造性的头脑风暴会议 个人思维过程这一高级功能目前仅面向 ChatGPT 团队用户(每用户每月 25 美元),可提供准确、有时间戳的记

ChatGPT 添加了 Google Drive 和 Dropbox 集成,用于文件访问

ChatGPT 通过新的企业功能提高生产力OpenAI 推出两项强大的新功能,将 ChatGPT 转变为全面的企业生产力工具:自动会议记录和无缝云存储集成。革命性的记录功能新推出的 "记录模式 "可自动转录和分析以下内容:重要的商务会议创造性的头脑风暴会议 个人思维过程这一高级功能目前仅面向 ChatGPT 团队用户(每用户每月 25 美元),可提供准确、有时间戳的记

2025-08-05 11:00:59

2025-08-05 11:00:59

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

2025-04-24 21:48:28

2025-04-24 21:48:28

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

2025-04-24 10:12:57

2025-04-24 10:12:57

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

2025-04-21 12:03:02

2025-04-21 12:03:02

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

2025-04-21 00:27:25

2025-04-21 00:27:25

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

2025-04-19 20:10:22

2025-04-19 20:10:22

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0