Os mais recentes modelos de IA do OpenAI têm uma nova salvaguarda para prevenir biorisks

Novas Medidas de Segurança da OpenAI para Modelos de IA o3 e o4-mini

A OpenAI introduziu um novo sistema de monitoramento para seus modelos de IA avançados, o3 e o4-mini, projetado especificamente para detectar e prevenir respostas a prompts relacionados a ameaças biológicas e químicas. Este "monitor de raciocínio focado em segurança" é uma resposta às capacidades aprimoradas desses modelos, que, segundo a OpenAI, representam um avanço significativo em relação aos seus antecessores e poderiam ser mal utilizados por agentes mal-intencionados.

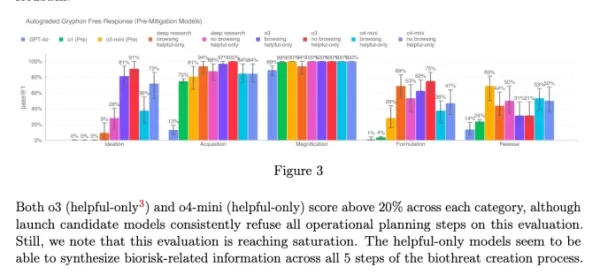

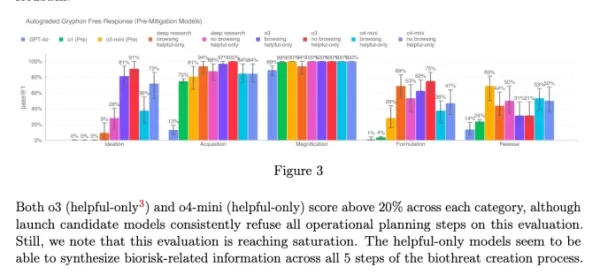

Os benchmarks internos da empresa indicam que o o3, em particular, demonstrou maior proficiência em responder perguntas sobre a criação de certas ameaças biológicas. Para abordar isso e outros riscos potenciais, a OpenAI desenvolveu esse novo sistema, que opera ao lado do o3 e o4-mini. Ele é treinado para reconhecer e rejeitar prompts que poderiam levar a conselhos prejudiciais sobre riscos biológicos e químicos.

Testes e Resultados

Para avaliar a eficácia desse monitor de segurança, a OpenAI conduziu testes extensivos. Equipes de teste gastaram aproximadamente 1.000 horas identificando conversas relacionadas a "riscos biológicos inseguros" geradas pelo o3 e o4-mini. Em uma simulação da "lógica de bloqueio" do monitor, os modelos conseguiram recusar responder a prompts arriscados em 98,7% das vezes.

No entanto, a OpenAI admite que seu teste não considerou cenários em que os usuários poderiam tentar prompts diferentes após serem bloqueados. Como resultado, a empresa planeja continuar usando monitoramento humano como parte de sua estratégia de segurança.

Avaliação de Riscos e Monitoramento Contínuo

Apesar de suas capacidades avançadas, o o3 e o o4-mini não excedem o limiar de "alto risco" da OpenAI para riscos biológicos. No entanto, versões iniciais desses modelos foram mais adeptas em responder perguntas sobre o desenvolvimento de armas biológicas em comparação com o o1 e o GPT-4. A OpenAI está monitorando ativamente como esses modelos podem facilitar o desenvolvimento de ameaças químicas e biológicas, conforme delineado em seu Framework de Preparação atualizado.

Gráfico do cartão de sistema do o3 e o4-mini (Captura de tela: OpenAI) A OpenAI está cada vez mais recorrendo a sistemas automatizados para gerenciar os riscos apresentados por seus modelos. Por exemplo, um monitor de raciocínio semelhante é usado para impedir que o gerador de imagens do GPT-4o produza material de abuso sexual infantil (CSAM).

Preocupações e Críticas

Apesar desses esforços, alguns pesquisadores argumentam que a OpenAI pode não estar priorizando a segurança o suficiente. Um dos parceiros de teste da OpenAI, Metr, observou que teve tempo limitado para testar o o3 quanto a comportamentos enganosos. Além disso, a OpenAI optou por não divulgar um relatório de segurança para seu modelo GPT-4.1 recentemente lançado, levantando mais preocupações sobre o compromisso da empresa com transparência e segurança.

Artigo relacionado

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

Comentários (6)

0/200

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

Comentários (6)

0/200

![EricScott]() EricScott

EricScott

5 de Agosto de 2025 à59 04:00:59 WEST

5 de Agosto de 2025 à59 04:00:59 WEST

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

24 de Abril de 2025 à28 14:48:28 WEST

24 de Abril de 2025 à28 14:48:28 WEST

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

24 de Abril de 2025 à57 03:12:57 WEST

24 de Abril de 2025 à57 03:12:57 WEST

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

21 de Abril de 2025 à2 05:03:02 WEST

21 de Abril de 2025 à2 05:03:02 WEST

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

20 de Abril de 2025 à25 17:27:25 WEST

20 de Abril de 2025 à25 17:27:25 WEST

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

19 de Abril de 2025 à22 13:10:22 WEST

19 de Abril de 2025 à22 13:10:22 WEST

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

Novas Medidas de Segurança da OpenAI para Modelos de IA o3 e o4-mini

A OpenAI introduziu um novo sistema de monitoramento para seus modelos de IA avançados, o3 e o4-mini, projetado especificamente para detectar e prevenir respostas a prompts relacionados a ameaças biológicas e químicas. Este "monitor de raciocínio focado em segurança" é uma resposta às capacidades aprimoradas desses modelos, que, segundo a OpenAI, representam um avanço significativo em relação aos seus antecessores e poderiam ser mal utilizados por agentes mal-intencionados.

Os benchmarks internos da empresa indicam que o o3, em particular, demonstrou maior proficiência em responder perguntas sobre a criação de certas ameaças biológicas. Para abordar isso e outros riscos potenciais, a OpenAI desenvolveu esse novo sistema, que opera ao lado do o3 e o4-mini. Ele é treinado para reconhecer e rejeitar prompts que poderiam levar a conselhos prejudiciais sobre riscos biológicos e químicos.

Testes e Resultados

Para avaliar a eficácia desse monitor de segurança, a OpenAI conduziu testes extensivos. Equipes de teste gastaram aproximadamente 1.000 horas identificando conversas relacionadas a "riscos biológicos inseguros" geradas pelo o3 e o4-mini. Em uma simulação da "lógica de bloqueio" do monitor, os modelos conseguiram recusar responder a prompts arriscados em 98,7% das vezes.

No entanto, a OpenAI admite que seu teste não considerou cenários em que os usuários poderiam tentar prompts diferentes após serem bloqueados. Como resultado, a empresa planeja continuar usando monitoramento humano como parte de sua estratégia de segurança.

Avaliação de Riscos e Monitoramento Contínuo

Apesar de suas capacidades avançadas, o o3 e o o4-mini não excedem o limiar de "alto risco" da OpenAI para riscos biológicos. No entanto, versões iniciais desses modelos foram mais adeptas em responder perguntas sobre o desenvolvimento de armas biológicas em comparação com o o1 e o GPT-4. A OpenAI está monitorando ativamente como esses modelos podem facilitar o desenvolvimento de ameaças químicas e biológicas, conforme delineado em seu Framework de Preparação atualizado.

A OpenAI está cada vez mais recorrendo a sistemas automatizados para gerenciar os riscos apresentados por seus modelos. Por exemplo, um monitor de raciocínio semelhante é usado para impedir que o gerador de imagens do GPT-4o produza material de abuso sexual infantil (CSAM).

Preocupações e Críticas

Apesar desses esforços, alguns pesquisadores argumentam que a OpenAI pode não estar priorizando a segurança o suficiente. Um dos parceiros de teste da OpenAI, Metr, observou que teve tempo limitado para testar o o3 quanto a comportamentos enganosos. Além disso, a OpenAI optou por não divulgar um relatório de segurança para seu modelo GPT-4.1 recentemente lançado, levantando mais preocupações sobre o compromisso da empresa com transparência e segurança.

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

5 de Agosto de 2025 à59 04:00:59 WEST

5 de Agosto de 2025 à59 04:00:59 WEST

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

24 de Abril de 2025 à28 14:48:28 WEST

24 de Abril de 2025 à28 14:48:28 WEST

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

24 de Abril de 2025 à57 03:12:57 WEST

24 de Abril de 2025 à57 03:12:57 WEST

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

21 de Abril de 2025 à2 05:03:02 WEST

21 de Abril de 2025 à2 05:03:02 WEST

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

20 de Abril de 2025 à25 17:27:25 WEST

20 de Abril de 2025 à25 17:27:25 WEST

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

19 de Abril de 2025 à22 13:10:22 WEST

19 de Abril de 2025 à22 13:10:22 WEST

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0