Los últimos modelos de IA de OpenAI tienen una nueva salvaguardia para evitar biorisks

Nuevas medidas de seguridad de OpenAI para los modelos de IA o3 y o4-mini

OpenAI ha introducido un nuevo sistema de monitoreo para sus modelos de IA avanzados, o3 y o4-mini, diseñado específicamente para detectar y prevenir respuestas a prompts relacionados con amenazas biológicas y químicas. Este "monitor de razonamiento enfocado en la seguridad" es una respuesta a las capacidades mejoradas de estos modelos, que, según OpenAI, representan un avance significativo respecto a sus predecesores y podrían ser utilizados de manera indebida por actores malintencionados.

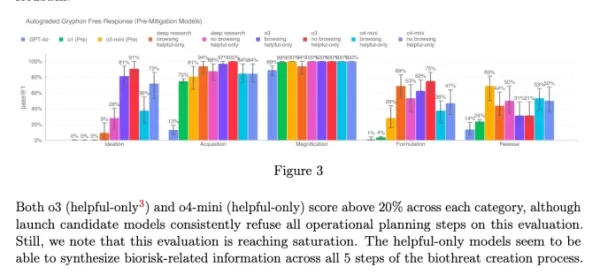

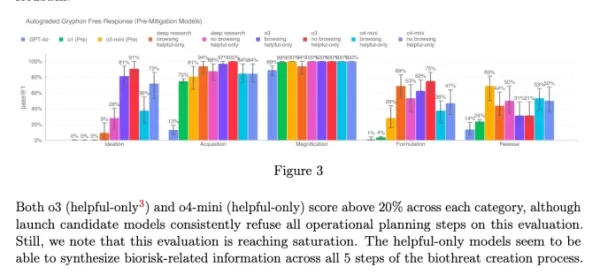

Los puntos de referencia internos de la compañía indican que o3, en particular, ha mostrado una mayor competencia en responder preguntas sobre la creación de ciertas amenazas biológicas. Para abordar este y otros riesgos potenciales, OpenAI desarrolló este nuevo sistema, que opera junto con o3 y o4-mini. Está entrenado para reconocer y rechazar prompts que podrían conducir a consejos perjudiciales sobre riesgos biológicos y químicos.

Pruebas y resultados

Para evaluar la efectividad de este monitor de seguridad, OpenAI realizó pruebas exhaustivas. Los equipos de red teaming dedicaron aproximadamente 1,000 horas a identificar conversaciones relacionadas con "riesgos biល>biológicos no seguros generadas por o3 y o4-mini. En una simulación de la "lógica de bloqueo" del monitor, los modelos lograron rechazar responder a prompts arriesgados el 98.7% de las veces.

Sin embargo, OpenAI admite que su prueba no consideró escenarios en los que los usuarios podrían intentar diferentes prompts después de ser bloqueados. Como resultado, la compañía planea seguir utilizando el monitoreo humano como parte de su estrategia de seguridad.

Evaluación de riesgos y monitoreo continuo

A pesar de sus capacidades avanzadas, o3 y o4-mini no superan el umbral de "alto riesgo" de OpenAI para biorriesgos. Sin embargo, las versiones iniciales de estos modelos eran más hábiles para responder preguntas sobre el desarrollo de armas biológicas en comparación con o1 y GPT-4. OpenAI está monitoreando activamente cómo estos modelos podrían facilitar el desarrollo de amenazas químicas y biológicas, como se detalla en su Marco de Preparación actualizado.

Gráfico de la tarjeta de sistema de o3 y o4-mini (Captura de pantalla: OpenAI) OpenAI está recurriendo cada vez más a sistemas automatizados para gestionar los riesgos que presentan sus modelos. Por ejemplo, un monitor de razonamiento similar se utiliza para evitar que el generador de imágenes de GPT-4o produzca material de abuso sexual infantil (CSAM).

Preocupaciones y críticas

A pesar de estos esfuerzos, algunos investigadores argumentan que OpenAI podría no estar priorizando suficientemente la seguridad. Uno de los socios de red teaming de OpenAI, Metr, señaló que tuvieron un tiempo limitado para probar o3 en busca de comportamientos engañosos. Además, OpenAI decidió no publicar un informe de seguridad para su modelo GPT-4.1 recientemente lanzado, lo que genera más preocupaciones sobre el compromiso de la compañía con la transparencia y la seguridad.

Artículo relacionado

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

comentario (6)

0/200

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

comentario (6)

0/200

![EricScott]() EricScott

EricScott

5 de agosto de 2025 05:00:59 GMT+02:00

5 de agosto de 2025 05:00:59 GMT+02:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

24 de abril de 2025 15:48:28 GMT+02:00

24 de abril de 2025 15:48:28 GMT+02:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

24 de abril de 2025 04:12:57 GMT+02:00

24 de abril de 2025 04:12:57 GMT+02:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

21 de abril de 2025 06:03:02 GMT+02:00

21 de abril de 2025 06:03:02 GMT+02:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

20 de abril de 2025 18:27:25 GMT+02:00

20 de abril de 2025 18:27:25 GMT+02:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

19 de abril de 2025 14:10:22 GMT+02:00

19 de abril de 2025 14:10:22 GMT+02:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

Nuevas medidas de seguridad de OpenAI para los modelos de IA o3 y o4-mini

OpenAI ha introducido un nuevo sistema de monitoreo para sus modelos de IA avanzados, o3 y o4-mini, diseñado específicamente para detectar y prevenir respuestas a prompts relacionados con amenazas biológicas y químicas. Este "monitor de razonamiento enfocado en la seguridad" es una respuesta a las capacidades mejoradas de estos modelos, que, según OpenAI, representan un avance significativo respecto a sus predecesores y podrían ser utilizados de manera indebida por actores malintencionados.

Los puntos de referencia internos de la compañía indican que o3, en particular, ha mostrado una mayor competencia en responder preguntas sobre la creación de ciertas amenazas biológicas. Para abordar este y otros riesgos potenciales, OpenAI desarrolló este nuevo sistema, que opera junto con o3 y o4-mini. Está entrenado para reconocer y rechazar prompts que podrían conducir a consejos perjudiciales sobre riesgos biológicos y químicos.

Pruebas y resultados

Para evaluar la efectividad de este monitor de seguridad, OpenAI realizó pruebas exhaustivas. Los equipos de red teaming dedicaron aproximadamente 1,000 horas a identificar conversaciones relacionadas con "riesgos biល>biológicos no seguros generadas por o3 y o4-mini. En una simulación de la "lógica de bloqueo" del monitor, los modelos lograron rechazar responder a prompts arriesgados el 98.7% de las veces.

Sin embargo, OpenAI admite que su prueba no consideró escenarios en los que los usuarios podrían intentar diferentes prompts después de ser bloqueados. Como resultado, la compañía planea seguir utilizando el monitoreo humano como parte de su estrategia de seguridad.

Evaluación de riesgos y monitoreo continuo

A pesar de sus capacidades avanzadas, o3 y o4-mini no superan el umbral de "alto riesgo" de OpenAI para biorriesgos. Sin embargo, las versiones iniciales de estos modelos eran más hábiles para responder preguntas sobre el desarrollo de armas biológicas en comparación con o1 y GPT-4. OpenAI está monitoreando activamente cómo estos modelos podrían facilitar el desarrollo de amenazas químicas y biológicas, como se detalla en su Marco de Preparación actualizado.

OpenAI está recurriendo cada vez más a sistemas automatizados para gestionar los riesgos que presentan sus modelos. Por ejemplo, un monitor de razonamiento similar se utiliza para evitar que el generador de imágenes de GPT-4o produzca material de abuso sexual infantil (CSAM).

Preocupaciones y críticas

A pesar de estos esfuerzos, algunos investigadores argumentan que OpenAI podría no estar priorizando suficientemente la seguridad. Uno de los socios de red teaming de OpenAI, Metr, señaló que tuvieron un tiempo limitado para probar o3 en busca de comportamientos engañosos. Además, OpenAI decidió no publicar un informe de seguridad para su modelo GPT-4.1 recientemente lanzado, lo que genera más preocupaciones sobre el compromiso de la compañía con la transparencia y la seguridad.

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Una organización sin ánimo de lucro aprovecha los agentes de IA para impulsar la recaudación de fondos benéficos

Mientras las grandes corporaciones tecnológicas promueven los "agentes" de IA como potenciadores de la productividad para las empresas, una organización sin ánimo de lucro está demostrando su potencia

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

Los principales laboratorios de IA advierten de que la humanidad está perdiendo el control sobre la comprensión de los sistemas de IA

En una muestra de unidad sin precedentes, investigadores de OpenAI, Google DeepMind, Anthropic y Meta han dejado de lado sus diferencias competitivas para lanzar una advertencia colectiva sobre el des

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

ChatGPT integra Google Drive y Dropbox para acceder a los archivos

ChatGPT mejora la productividad con nuevas funciones empresarialesOpenAI ha presentado dos nuevas y potentes funciones que transforman ChatGPT en una completa herramienta de productividad empresaria

5 de agosto de 2025 05:00:59 GMT+02:00

5 de agosto de 2025 05:00:59 GMT+02:00

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

24 de abril de 2025 15:48:28 GMT+02:00

24 de abril de 2025 15:48:28 GMT+02:00

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

24 de abril de 2025 04:12:57 GMT+02:00

24 de abril de 2025 04:12:57 GMT+02:00

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

21 de abril de 2025 06:03:02 GMT+02:00

21 de abril de 2025 06:03:02 GMT+02:00

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

20 de abril de 2025 18:27:25 GMT+02:00

20 de abril de 2025 18:27:25 GMT+02:00

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

19 de abril de 2025 14:10:22 GMT+02:00

19 de abril de 2025 14:10:22 GMT+02:00

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0