Die neuesten KI -Modelle von Openai haben einen neuen Schutz, um Bioritäten zu verhindern

Neue Sicherheitsmaßnahmen von OpenAI für die KI-Modelle o3 und o4-mini

OpenAI hat ein neues Überwachungssystem für seine fortschrittlichen KI-Modelle o3 und o4-mini eingeführt, das speziell darauf ausgelegt ist, Antworten auf Eingaben zu erkennen und zu verhindern, die mit biologischen und chemischen Bedrohungen in Verbindung stehen. Dieser „sicherheitsorientierte Reasoning-Monitor“ ist eine Reaktion auf die erweiterten Fähigkeiten dieser Modelle, die laut OpenAI einen bedeutenden Fortschritt gegenüber ihren Vorgängern darstellen und von böswilligen Akteuren missbraucht werden könnten.

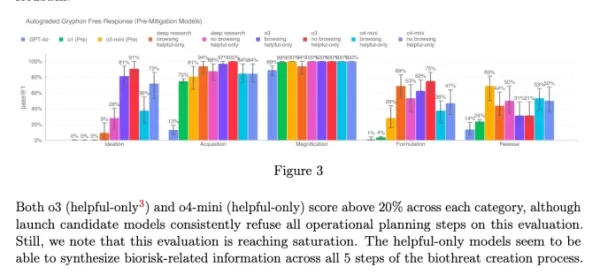

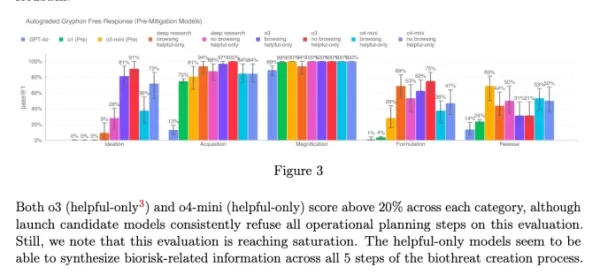

Die internen Benchmarks des Unternehmens zeigen, dass insbesondere o3 eine höhere Kompetenz bei der Beantwortung von Fragen zur Herstellung bestimmter biologischer Bedrohungen aufweist. Um dieses und andere potenzielle Risiken anzugehen, hat OpenAI dieses neue System entwickelt, das parallel zu o3 und o4-mini arbeitet. Es ist darauf trainiert, Eingaben zu erkennen und abzulehnen, die zu schädlichen Ratschlägen in Bezug auf biologische und chemische Risiken führen könnten.

Testen und Ergebnisse

Um die Wirksamkeit dieses Sicherheitsmonitors zu bewerten, führte OpenAI umfangreiche Tests durch. Red-Teamer verbrachten etwa 1.000 Stunden damit, „unsichere“ Gespräche zu Biorisiken zu identifizieren, die von o3 und o4-mini generiert wurden. In einer Simulation der „Blockierlogik“ des Monitors lehnten die Modelle in 98,7 % der Fälle riskante Eingaben erfolgreich ab.

OpenAI gibt jedoch zu, dass der Test Szenarien, in denen Nutzer nach einer Blockierung andere Eingaben versuchen könnten, nicht berücksichtigt hat. Daher plant das Unternehmen, weiterhin menschliche Überwachung als Teil seiner Sicherheitsstrategie einzusetzen.

Risikobewertung und fortlaufende Überwachung

Trotz ihrer fortschrittlichen Fähigkeiten überschreiten o3 und o4-mini nicht die „hohe Risiko“-Schwelle von OpenAI für Biorisiken. Dennoch waren frühe Versionen dieser Modelle im Vergleich zu o1 und GPT-4 besser in der Lage, Fragen zur Entwicklung biologischer Waffen zu beantworten. OpenAI überwacht aktiv, wie diese Modelle die Entwicklung chemischer und biologischer Bedrohungen erleichtern könnten, wie im aktualisierten Preparedness Framework beschrieben.

Diagramm aus der Systemkarte von o3 und o4-mini (Screenshot: OpenAI) OpenAI setzt zunehmend auf automatisierte Systeme, um die Risiken zu managen, die von seinen Modellen ausgehen. Zum Beispiel wird ein ähnlicher Reasoning-Monitor verwendet, um zu verhindern, dass der Bildgenerator von GPT-4o Material zu sexuellem Kindesmissbrauch (CSAM) erstellt.

Bedenken und Kritik

Trotz dieser Bemühungen argumentieren einige Forscher, dass OpenAI der Sicherheit möglicherweise nicht genügend Priorität einräumt. Einer der Red-Teaming-Partner von OpenAI, Metr, stellte fest, dass sie nur begrenzte Zeit hatten, um o3 auf täuschendes Verhalten zu testen. Zudem entschied sich OpenAI, keinen Sicherheitsbericht für das kürzlich eingeführte GPT-4.1-Modell zu veröffentlichen, was weitere Bedenken hinsichtlich des Engagements des Unternehmens für Transparenz und Sicherheit aufwirft.

Verwandter Artikel

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Kommentare (6)

0/200

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Kommentare (6)

0/200

![EricScott]() EricScott

EricScott

5. August 2025 05:00:59 MESZ

5. August 2025 05:00:59 MESZ

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

24. April 2025 15:48:28 MESZ

24. April 2025 15:48:28 MESZ

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

24. April 2025 04:12:57 MESZ

24. April 2025 04:12:57 MESZ

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

21. April 2025 06:03:02 MESZ

21. April 2025 06:03:02 MESZ

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

20. April 2025 18:27:25 MESZ

20. April 2025 18:27:25 MESZ

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

19. April 2025 14:10:22 MESZ

19. April 2025 14:10:22 MESZ

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

Neue Sicherheitsmaßnahmen von OpenAI für die KI-Modelle o3 und o4-mini

OpenAI hat ein neues Überwachungssystem für seine fortschrittlichen KI-Modelle o3 und o4-mini eingeführt, das speziell darauf ausgelegt ist, Antworten auf Eingaben zu erkennen und zu verhindern, die mit biologischen und chemischen Bedrohungen in Verbindung stehen. Dieser „sicherheitsorientierte Reasoning-Monitor“ ist eine Reaktion auf die erweiterten Fähigkeiten dieser Modelle, die laut OpenAI einen bedeutenden Fortschritt gegenüber ihren Vorgängern darstellen und von böswilligen Akteuren missbraucht werden könnten.

Die internen Benchmarks des Unternehmens zeigen, dass insbesondere o3 eine höhere Kompetenz bei der Beantwortung von Fragen zur Herstellung bestimmter biologischer Bedrohungen aufweist. Um dieses und andere potenzielle Risiken anzugehen, hat OpenAI dieses neue System entwickelt, das parallel zu o3 und o4-mini arbeitet. Es ist darauf trainiert, Eingaben zu erkennen und abzulehnen, die zu schädlichen Ratschlägen in Bezug auf biologische und chemische Risiken führen könnten.

Testen und Ergebnisse

Um die Wirksamkeit dieses Sicherheitsmonitors zu bewerten, führte OpenAI umfangreiche Tests durch. Red-Teamer verbrachten etwa 1.000 Stunden damit, „unsichere“ Gespräche zu Biorisiken zu identifizieren, die von o3 und o4-mini generiert wurden. In einer Simulation der „Blockierlogik“ des Monitors lehnten die Modelle in 98,7 % der Fälle riskante Eingaben erfolgreich ab.

OpenAI gibt jedoch zu, dass der Test Szenarien, in denen Nutzer nach einer Blockierung andere Eingaben versuchen könnten, nicht berücksichtigt hat. Daher plant das Unternehmen, weiterhin menschliche Überwachung als Teil seiner Sicherheitsstrategie einzusetzen.

Risikobewertung und fortlaufende Überwachung

Trotz ihrer fortschrittlichen Fähigkeiten überschreiten o3 und o4-mini nicht die „hohe Risiko“-Schwelle von OpenAI für Biorisiken. Dennoch waren frühe Versionen dieser Modelle im Vergleich zu o1 und GPT-4 besser in der Lage, Fragen zur Entwicklung biologischer Waffen zu beantworten. OpenAI überwacht aktiv, wie diese Modelle die Entwicklung chemischer und biologischer Bedrohungen erleichtern könnten, wie im aktualisierten Preparedness Framework beschrieben.

OpenAI setzt zunehmend auf automatisierte Systeme, um die Risiken zu managen, die von seinen Modellen ausgehen. Zum Beispiel wird ein ähnlicher Reasoning-Monitor verwendet, um zu verhindern, dass der Bildgenerator von GPT-4o Material zu sexuellem Kindesmissbrauch (CSAM) erstellt.

Bedenken und Kritik

Trotz dieser Bemühungen argumentieren einige Forscher, dass OpenAI der Sicherheit möglicherweise nicht genügend Priorität einräumt. Einer der Red-Teaming-Partner von OpenAI, Metr, stellte fest, dass sie nur begrenzte Zeit hatten, um o3 auf täuschendes Verhalten zu testen. Zudem entschied sich OpenAI, keinen Sicherheitsbericht für das kürzlich eingeführte GPT-4.1-Modell zu veröffentlichen, was weitere Bedenken hinsichtlich des Engagements des Unternehmens für Transparenz und Sicherheit aufwirft.

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Gemeinnützige Organisation setzt KI-Agenten ein, um Spendenaktionen für wohltätige Zwecke zu fördern

Während große Technologieunternehmen KI-"Agenten" als Produktivitätssteigerer für Unternehmen anpreisen, demonstriert eine gemeinnützige Organisation ihr Potenzial für den sozialen Bereich. Sage Futur

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

Führende KI-Labors warnen, dass die Menschheit das Verständnis für KI-Systeme verliert

In einem beispiellosen Akt der Einigkeit haben Forscher von OpenAI, Google DeepMind, Anthropic und Meta ihre konkurrierenden Differenzen beiseite geschoben, um eine gemeinsame Warnung zur verantwortun

5. August 2025 05:00:59 MESZ

5. August 2025 05:00:59 MESZ

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

24. April 2025 15:48:28 MESZ

24. April 2025 15:48:28 MESZ

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

24. April 2025 04:12:57 MESZ

24. April 2025 04:12:57 MESZ

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

21. April 2025 06:03:02 MESZ

21. April 2025 06:03:02 MESZ

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

20. April 2025 18:27:25 MESZ

20. April 2025 18:27:25 MESZ

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

19. April 2025 14:10:22 MESZ

19. April 2025 14:10:22 MESZ

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0