Openaiの最新のAIモデルには、生物学を防ぐための新しいセーフガードがあります

OpenAIのAIモデルo3およびo4-mini向けの新たな安全対策

OpenAIは、高度なAIモデルであるo3およびo4-mini向けに新しい監視システムを導入しました。このシステムは、生物学的および化学的脅威に関連するプロンプトへの応答を検出し、防止するために特別に設計されています。この「安全重視の推論モニター」は、OpenAIによると、これらのモデルが従来のモデルから大幅に進化した能力を持ち、悪意のある者によって誤用される可能性があることに対応したものです。

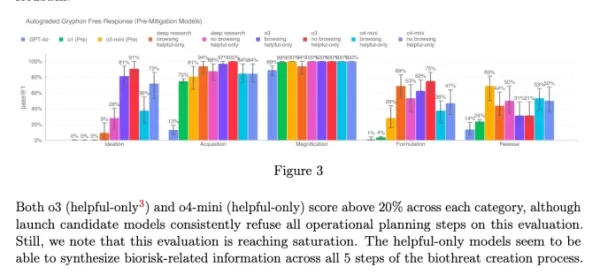

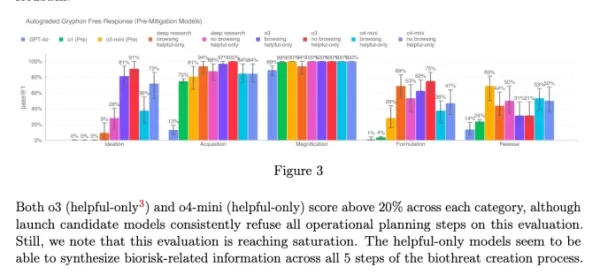

同社の内部ベンチマークによると、特にo3は、特定の生物学的脅威の作成に関する質問に高い熟練度を示しています。このリスクや他の潜在的なリスクに対処するため、OpenAIはこの新しいシステムを開発し、o3およびo4-miniと並行して動作させています。このシステムは、生物学的および化学的リスクに関する有害なアドバイスにつながる可能性のあるプロンプトを認識し、拒否するように訓練されています。

テストと結果

この安全モニターの有効性を評価するため、OpenAIは広範なテストを実施しました。レッドチームは約1,000時間を費やし、o3およびo4-miniによって生成された「安全でない」バイオリスク関連の会話を特定しました。モニターの「ブロックロジック」のシミュレーションでは、モデルはリスクの高いプロンプトに対して98.7%の確率で応答を拒否することに成功しました。

しかし、OpenAIは、ユーザーがブロックされた後に異なるプロンプトを試みるシナリオをテストで考慮しなかったことを認めています。そのため、同社は安全戦略の一環として、引き続き人間による監視を使用する予定です。

リスク評価と継続的な監視

高度な能力にもかかわらず、o3およびo4-miniはOpenAIの「高リスク」バイオリスクの閾値を超えていません。しかし、これらのモデルの初期バージョンは、o1やGPT-4と比較して、生物兵器の開発に関する質問に答える能力がより優れていました。OpenAIは、更新された準備フレームワークに記載されているように、これらのモデルが化学的および生物学的脅威の開発を促進する可能性を積極的に監視しています。

o3およびo4-miniのシステムカードのチャート(スクリーンショット:OpenAI) OpenAIは、モデルがもたらすリスクを管理するために、ますます自動化システムに依存しています。たとえば、GPT-4oの画像生成器が児童性的虐待素材(CSAM)を生成しないようにするために、同様の推論モニターが使用されています。

懸念と批判

これらの取り組みにもかかわらず、一部の研究者は、OpenAIが安全性を十分に優先していないと主張しています。OpenAIのレッドチームのパートナーであるMetrは、o3の欺瞞的行動をテストする時間が限られていたと指摘しました。さらに、OpenAIは最近リリースしたGPT-4.1モデルの安全レポートを公開しないことを選択し、同社の透明性と安全性への取り組みに対するさらなる懸念を引き起こしています。

関連記事

非営利団体、AIエージェントを活用してチャリティ募金活動を強化

大手テック企業がAIの "エージェント "をビジネスの生産性向上剤として推進する一方で、ある非営利団体はAIが社会的利益に貢献する可能性を実証している。オープン・フィランソロピーが支援する慈善研究グループ、セージ・フューチャーは最近、AIモデルが慈善活動の資金調達にどのように協力できるかを示す革新的な実験を行った。この非営利団体は、OpenAIのGPT-4oとo1、AnthropicのClau

非営利団体、AIエージェントを活用してチャリティ募金活動を強化

大手テック企業がAIの "エージェント "をビジネスの生産性向上剤として推進する一方で、ある非営利団体はAIが社会的利益に貢献する可能性を実証している。オープン・フィランソロピーが支援する慈善研究グループ、セージ・フューチャーは最近、AIモデルが慈善活動の資金調達にどのように協力できるかを示す革新的な実験を行った。この非営利団体は、OpenAIのGPT-4oとo1、AnthropicのClau

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

ChatGPT、ファイルアクセスにGoogle DriveとDropboxの統合を追加

ChatGPTが企業向け新機能で生産性を向上OpenAIは、ChatGPTを包括的なビジネス生産性ツールに変える2つの強力な新機能を発表しました:自動会議文書化とシームレスなクラウドストレージ統合です。革命的な録音機能新しく導入された "記録モード "は、自動テープ起こしや分析を可能にします:重要なビジネス会議創造的なブレーンストーミングセッション 個人の思考プロセスこの

コメント (6)

0/200

ChatGPT、ファイルアクセスにGoogle DriveとDropboxの統合を追加

ChatGPTが企業向け新機能で生産性を向上OpenAIは、ChatGPTを包括的なビジネス生産性ツールに変える2つの強力な新機能を発表しました:自動会議文書化とシームレスなクラウドストレージ統合です。革命的な録音機能新しく導入された "記録モード "は、自動テープ起こしや分析を可能にします:重要なビジネス会議創造的なブレーンストーミングセッション 個人の思考プロセスこの

コメント (6)

0/200

![EricScott]() EricScott

EricScott

2025年8月5日 12:00:59 JST

2025年8月5日 12:00:59 JST

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

![StephenGreen]() StephenGreen

StephenGreen

2025年4月24日 22:48:28 JST

2025年4月24日 22:48:28 JST

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

![JamesWilliams]() JamesWilliams

JamesWilliams

2025年4月24日 11:12:57 JST

2025年4月24日 11:12:57 JST

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

2025年4月21日 13:03:02 JST

2025年4月21日 13:03:02 JST

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

2025年4月21日 1:27:25 JST

2025年4月21日 1:27:25 JST

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

![LarryMartin]() LarryMartin

LarryMartin

2025年4月19日 21:10:22 JST

2025年4月19日 21:10:22 JST

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0

OpenAIのAIモデルo3およびo4-mini向けの新たな安全対策

OpenAIは、高度なAIモデルであるo3およびo4-mini向けに新しい監視システムを導入しました。このシステムは、生物学的および化学的脅威に関連するプロンプトへの応答を検出し、防止するために特別に設計されています。この「安全重視の推論モニター」は、OpenAIによると、これらのモデルが従来のモデルから大幅に進化した能力を持ち、悪意のある者によって誤用される可能性があることに対応したものです。

同社の内部ベンチマークによると、特にo3は、特定の生物学的脅威の作成に関する質問に高い熟練度を示しています。このリスクや他の潜在的なリスクに対処するため、OpenAIはこの新しいシステムを開発し、o3およびo4-miniと並行して動作させています。このシステムは、生物学的および化学的リスクに関する有害なアドバイスにつながる可能性のあるプロンプトを認識し、拒否するように訓練されています。

テストと結果

この安全モニターの有効性を評価するため、OpenAIは広範なテストを実施しました。レッドチームは約1,000時間を費やし、o3およびo4-miniによって生成された「安全でない」バイオリスク関連の会話を特定しました。モニターの「ブロックロジック」のシミュレーションでは、モデルはリスクの高いプロンプトに対して98.7%の確率で応答を拒否することに成功しました。

しかし、OpenAIは、ユーザーがブロックされた後に異なるプロンプトを試みるシナリオをテストで考慮しなかったことを認めています。そのため、同社は安全戦略の一環として、引き続き人間による監視を使用する予定です。

リスク評価と継続的な監視

高度な能力にもかかわらず、o3およびo4-miniはOpenAIの「高リスク」バイオリスクの閾値を超えていません。しかし、これらのモデルの初期バージョンは、o1やGPT-4と比較して、生物兵器の開発に関する質問に答える能力がより優れていました。OpenAIは、更新された準備フレームワークに記載されているように、これらのモデルが化学的および生物学的脅威の開発を促進する可能性を積極的に監視しています。

OpenAIは、モデルがもたらすリスクを管理するために、ますます自動化システムに依存しています。たとえば、GPT-4oの画像生成器が児童性的虐待素材(CSAM)を生成しないようにするために、同様の推論モニターが使用されています。

懸念と批判

これらの取り組みにもかかわらず、一部の研究者は、OpenAIが安全性を十分に優先していないと主張しています。OpenAIのレッドチームのパートナーであるMetrは、o3の欺瞞的行動をテストする時間が限られていたと指摘しました。さらに、OpenAIは最近リリースしたGPT-4.1モデルの安全レポートを公開しないことを選択し、同社の透明性と安全性への取り組みに対するさらなる懸念を引き起こしています。

非営利団体、AIエージェントを活用してチャリティ募金活動を強化

大手テック企業がAIの "エージェント "をビジネスの生産性向上剤として推進する一方で、ある非営利団体はAIが社会的利益に貢献する可能性を実証している。オープン・フィランソロピーが支援する慈善研究グループ、セージ・フューチャーは最近、AIモデルが慈善活動の資金調達にどのように協力できるかを示す革新的な実験を行った。この非営利団体は、OpenAIのGPT-4oとo1、AnthropicのClau

非営利団体、AIエージェントを活用してチャリティ募金活動を強化

大手テック企業がAIの "エージェント "をビジネスの生産性向上剤として推進する一方で、ある非営利団体はAIが社会的利益に貢献する可能性を実証している。オープン・フィランソロピーが支援する慈善研究グループ、セージ・フューチャーは最近、AIモデルが慈善活動の資金調達にどのように協力できるかを示す革新的な実験を行った。この非営利団体は、OpenAIのGPT-4oとo1、AnthropicのClau

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

トップAI研究所は、人類はAIシステムを理解する力を失いつつあると警告する

OpenAI、Google DeepMind、Anthropic、Metaの研究者は、前例のない団結を示し、競争上の相違を脇に置いて、責任あるAI開発について集団で警告を発した。これらの通常ライバル関係にある組織から40人以上の一流の科学者が、AIの意思決定プロセスの透明性を確保するための窓が急速に狭まっていることを強調する画期的な研究論文を共同執筆した。この共同研究は、現代のAIシステムにおける

ChatGPT、ファイルアクセスにGoogle DriveとDropboxの統合を追加

ChatGPTが企業向け新機能で生産性を向上OpenAIは、ChatGPTを包括的なビジネス生産性ツールに変える2つの強力な新機能を発表しました:自動会議文書化とシームレスなクラウドストレージ統合です。革命的な録音機能新しく導入された "記録モード "は、自動テープ起こしや分析を可能にします:重要なビジネス会議創造的なブレーンストーミングセッション 個人の思考プロセスこの

ChatGPT、ファイルアクセスにGoogle DriveとDropboxの統合を追加

ChatGPTが企業向け新機能で生産性を向上OpenAIは、ChatGPTを包括的なビジネス生産性ツールに変える2つの強力な新機能を発表しました:自動会議文書化とシームレスなクラウドストレージ統合です。革命的な録音機能新しく導入された "記録モード "は、自動テープ起こしや分析を可能にします:重要なビジネス会議創造的なブレーンストーミングセッション 個人の思考プロセスこの

2025年8月5日 12:00:59 JST

2025年8月5日 12:00:59 JST

Wow, OpenAI's new safety measures for o3 and o4-mini sound like a big step! It's reassuring to see them tackling biorisks head-on. But I wonder, how foolproof is this monitoring system? 🤔 Could it catch every sneaky prompt?

0

0

2025年4月24日 22:48:28 JST

2025年4月24日 22:48:28 JST

OpenAIの新しい安全機能は素晴らしいですね!生物学的リスクを防ぐための監視システムがあるのは安心です。ただ、無害な質問までブロックされることがあるのが少し気になります。でも、安全第一ですからね。引き続き頑張ってください、OpenAI!😊

0

0

2025年4月24日 11:12:57 JST

2025年4月24日 11:12:57 JST

OpenAI's new safety feature is a game-changer! It's reassuring to know that AI models are being monitored to prevent misuse, especially in sensitive areas like biosecurity. But sometimes it feels a bit too cautious, blocking harmless queries. Still, better safe than sorry, right? Keep up the good work, OpenAI! 😊

0

0

2025年4月21日 13:03:02 JST

2025年4月21日 13:03:02 JST

¡La nueva función de seguridad de OpenAI es un cambio de juego! Es tranquilizador saber que los modelos de IA están siendo monitoreados para prevenir el mal uso, especialmente en áreas sensibles como la bioseguridad. Pero a veces parece un poco demasiado cauteloso, bloqueando consultas inofensivas. Aún así, más vale prevenir que lamentar, ¿verdad? ¡Sigue el buen trabajo, OpenAI! 😊

0

0

2025年4月21日 1:27:25 JST

2025年4月21日 1:27:25 JST

A nova função de segurança da OpenAI é incrível! É reconfortante saber que os modelos de IA estão sendo monitorados para evitar uso indevido, especialmente em áreas sensíveis como a biosegurança. Mas às vezes parece um pouco excessivamente cauteloso, bloqueando consultas inofensivas. Ainda assim, melhor prevenir do que remediar, certo? Continue o bom trabalho, OpenAI! 😊

0

0

2025年4月19日 21:10:22 JST

2025年4月19日 21:10:22 JST

OpenAI의 새로운 안전 기능 정말 대단해요! 생물학적 위험을 방지하기 위한 모니터링 시스템이 있다는 게 안심되네요. 다만, 무해한 질문까지 차단되는 경우가 있어서 조금 아쉽습니다. 그래도 안전이 최우선이죠. 계속해서 좋은 일 하세요, OpenAI! 😊

0

0