Gaia introduit une nouvelle référence dans la quête de la véritable intelligence au-delà de l'ARC-AGI

L'intelligence est omniprésente, mais la mesurer précisément revient à essayer d'attraper un nuage à mains nues. Nous utilisons des tests et des benchmarks, comme les examens d'entrée à l'université, pour en avoir une idée approximative. Chaque année, les étudiants se préparent intensément pour ces tests, certains obtenant même un score parfait de 100 %. Mais ce score parfait signifie-t-il qu'ils possèdent tous le même niveau d'intelligence ou qu'ils ont atteint le sommet de leur potentiel mental ? Bien sûr que non. Ces benchmarks ne sont que des estimations approximatives, pas des indicateurs précis des véritables capacités de quelqu'un.

Dans le monde de l'IA générative, des benchmarks comme le MMLU (Massive Multitask Language Understanding) sont devenus la référence pour évaluer les modèles à travers des questions à choix multiples couvrant divers domaines académiques. Bien qu'ils permettent des comparaisons faciles, ils ne capturent pas vraiment l'ensemble des capacités intelligentes.

Prenez Claude 3.5 Sonnet et GPT-4.5, par exemple. Ils pourraient obtenir des scores similaires au MMLU, suggérant qu'ils sont à égalité. Mais quiconque a réellement utilisé ces modèles sait que leurs performances dans le monde réel peuvent être très différentes.

Que signifie mesurer l'« intelligence » dans l'IA ?

Avec le lancement récent du benchmark ARC-AGI, conçu pour tester les modèles sur le raisonnement général et la résolution créative de problèmes, une nouvelle vague de discussions a émergé sur ce que signifie mesurer l'« intelligence » dans l'IA. Tout le monde n'a pas encore eu l'occasion d'explorer ARC-AGI, mais l'industrie est en effervescence à propos de cette approche et d'autres nouvelles méthodes de test. Chaque benchmark a sa place, et ARC-AGI est un pas dans la bonne direction.

Un autre développement passionnant est « Humanity's Last Exam », un benchmark complet comprenant 3 000 questions en plusieurs étapes, validées par des pairs, couvrant différentes disciplines. C'est un effort ambitieux pour pousser les systèmes d'IA à un raisonnement de niveau expert. Les premiers résultats montrent des progrès rapides, avec OpenAI atteignant un score de 26,6 % juste un mois après sa sortie. Mais comme d'autres benchmarks, il se concentre principalement sur la connaissance et le raisonnement dans un vide, et non sur les compétences pratiques d'utilisation d'outils, essentielles pour les applications d'IA dans le monde réel.

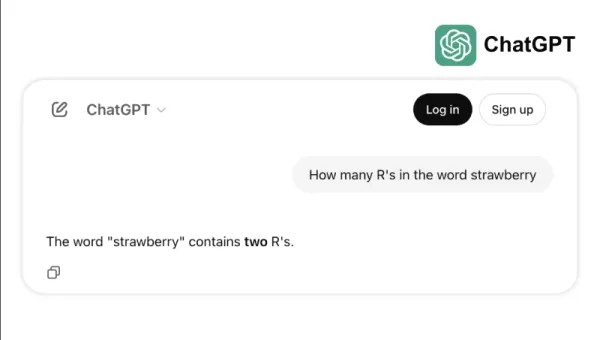

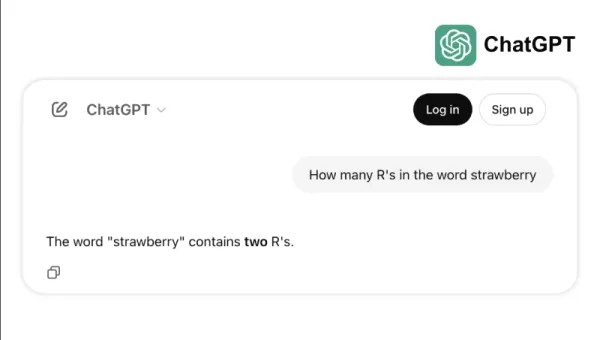

Prenez, par exemple, la difficulté de certains modèles de pointe à accomplir des tâches simples comme compter les « r » dans « strawberry » ou comparer 3,8 à 3,1111. Ces erreurs, qu'un enfant ou une calculatrice basique pourrait éviter, mettent en lumière l'écart entre le succès aux benchmarks et la fiabilité dans le monde réel. Cela rappelle que l'intelligence ne se résume pas à réussir des tests ; il s'agit de naviguer dans la logique quotidienne avec aisance.

La nouvelle norme pour mesurer les capacités de l'IA

À mesure que les modèles d'IA ont évolué, les limites des benchmarks traditionnels sont devenues plus évidentes. Par exemple, GPT-4, lorsqu'il est équipé d'outils, n'obtient qu'environ 15 % sur les tâches plus complexes du monde réel dans le benchmark GAIA, malgré ses scores élevés aux tests à choix multiples.

Cet écart entre les performances aux benchmarks et les capacités pratiques devient de plus en plus problématique à mesure que les systèmes d'IA passent des laboratoires de recherche aux applications commerciales. Les benchmarks traditionnels testent la capacité d'un modèle à se souvenir d'informations, mais négligent souvent des aspects clés de l'intelligence, comme la capacité à collecter des données, exécuter du code, analyser des informations et créer des solutions dans divers domaines.

Voici GAIA, un nouveau benchmark qui marque un changement significatif dans l'évaluation de l'IA. Développé grâce à une collaboration entre les équipes de Meta-FAIR, Meta-GenAI, HuggingFace et AutoGPT, GAIA comprend 466 questions soigneusement conçues, réparties sur trois niveaux de difficulté. Ces questions testent un large éventail de compétences essentielles pour les applications d'IA dans le monde réel, y compris la navigation sur le web, la compréhension multimodale, l'exécution de code, la gestion de fichiers et le raisonnement complexe.

Les questions de niveau 1 nécessitent généralement environ 5 étapes et un outil pour être résolues par des humains. Les questions de niveau 2 nécessitent de 5 à 10 étapes et plusieurs outils, tandis que les questions de niveau 3 peuvent exiger jusqu'à 50 étapes et un nombre quelconque d'outils. Cette structure reflète la complexité des problèmes commerciaux réels, où les solutions impliquent souvent plusieurs actions et outils.

En se concentrant sur la flexibilité plutôt que sur la simple complexité, un modèle d'IA a atteint un taux de précision de 75 % sur GAIA, surpassant les leaders de l'industrie comme Microsoft's Magnetic-1 (38 %) et Google's Langfun Agent (49 %). Ce succès provient de l'utilisation d'un mélange de modèles spécialisés pour la compréhension audiovisuelle et le raisonnement, avec Anthropic's Sonnet 3.5 comme modèle principal.

Ce changement dans l'évaluation de l'IA reflète une tendance plus large dans l'industrie : nous nous éloignons des applications SaaS autonomes vers des agents d'IA capables de gérer plusieurs outils et flux de travail. À mesure que les entreprises dépendent de plus en plus de l'IA pour relever des défis complexes et multi-étapes, des benchmarks comme GAIA offrent une mesure plus pertinente des capacités que les tests à choix multiples traditionnels.

L'avenir de l'évaluation de l'IA ne repose pas sur des tests de connaissances isolés ; il s'agit d'évaluations complètes des capacités de résolution de problèmes. GAIA établit une nouvelle norme pour mesurer les capacités de l'IA, une norme qui s'aligne mieux avec les défis et opportunités réels du déploiement de l'IA.

Sri Ambati est le fondateur et PDG de H2O.ai.

Article connexe

Le PDG de Replit prédit l'avenir des logiciels : "Des agents à tous les étages".

Les plateformes collaboratives de développement de l'IA pourraient-elles permettre aux entreprises de s'affranchir des coûteux abonnements SaaS ? Le PDG visionnaire de Replit, Amjad Masad, pense que c

Le PDG de Replit prédit l'avenir des logiciels : "Des agents à tous les étages".

Les plateformes collaboratives de développement de l'IA pourraient-elles permettre aux entreprises de s'affranchir des coûteux abonnements SaaS ? Le PDG visionnaire de Replit, Amjad Masad, pense que c

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

Manus lance l'outil d'IA "Wide Research" avec plus de 100 agents pour l'exploration du Web

L'innovateur chinois Manus, qui a déjà attiré l'attention sur sa plateforme d'orchestration multi-agents destinée à la fois aux consommateurs et aux utilisateurs professionnels, a dévoilé une applicat

commentaires (2)

0/200

Manus lance l'outil d'IA "Wide Research" avec plus de 100 agents pour l'exploration du Web

L'innovateur chinois Manus, qui a déjà attiré l'attention sur sa plateforme d'orchestration multi-agents destinée à la fois aux consommateurs et aux utilisateurs professionnels, a dévoilé une applicat

commentaires (2)

0/200

![BillyAdams]() BillyAdams

BillyAdams

26 août 2025 10:25:46 UTC+02:00

26 août 2025 10:25:46 UTC+02:00

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

![GaryThomas]() GaryThomas

GaryThomas

8 août 2025 06:01:29 UTC+02:00

8 août 2025 06:01:29 UTC+02:00

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0

L'intelligence est omniprésente, mais la mesurer précisément revient à essayer d'attraper un nuage à mains nues. Nous utilisons des tests et des benchmarks, comme les examens d'entrée à l'université, pour en avoir une idée approximative. Chaque année, les étudiants se préparent intensément pour ces tests, certains obtenant même un score parfait de 100 %. Mais ce score parfait signifie-t-il qu'ils possèdent tous le même niveau d'intelligence ou qu'ils ont atteint le sommet de leur potentiel mental ? Bien sûr que non. Ces benchmarks ne sont que des estimations approximatives, pas des indicateurs précis des véritables capacités de quelqu'un.

Dans le monde de l'IA générative, des benchmarks comme le MMLU (Massive Multitask Language Understanding) sont devenus la référence pour évaluer les modèles à travers des questions à choix multiples couvrant divers domaines académiques. Bien qu'ils permettent des comparaisons faciles, ils ne capturent pas vraiment l'ensemble des capacités intelligentes.

Prenez Claude 3.5 Sonnet et GPT-4.5, par exemple. Ils pourraient obtenir des scores similaires au MMLU, suggérant qu'ils sont à égalité. Mais quiconque a réellement utilisé ces modèles sait que leurs performances dans le monde réel peuvent être très différentes.

Que signifie mesurer l'« intelligence » dans l'IA ?

Avec le lancement récent du benchmark ARC-AGI, conçu pour tester les modèles sur le raisonnement général et la résolution créative de problèmes, une nouvelle vague de discussions a émergé sur ce que signifie mesurer l'« intelligence » dans l'IA. Tout le monde n'a pas encore eu l'occasion d'explorer ARC-AGI, mais l'industrie est en effervescence à propos de cette approche et d'autres nouvelles méthodes de test. Chaque benchmark a sa place, et ARC-AGI est un pas dans la bonne direction.

Un autre développement passionnant est « Humanity's Last Exam », un benchmark complet comprenant 3 000 questions en plusieurs étapes, validées par des pairs, couvrant différentes disciplines. C'est un effort ambitieux pour pousser les systèmes d'IA à un raisonnement de niveau expert. Les premiers résultats montrent des progrès rapides, avec OpenAI atteignant un score de 26,6 % juste un mois après sa sortie. Mais comme d'autres benchmarks, il se concentre principalement sur la connaissance et le raisonnement dans un vide, et non sur les compétences pratiques d'utilisation d'outils, essentielles pour les applications d'IA dans le monde réel.

Prenez, par exemple, la difficulté de certains modèles de pointe à accomplir des tâches simples comme compter les « r » dans « strawberry » ou comparer 3,8 à 3,1111. Ces erreurs, qu'un enfant ou une calculatrice basique pourrait éviter, mettent en lumière l'écart entre le succès aux benchmarks et la fiabilité dans le monde réel. Cela rappelle que l'intelligence ne se résume pas à réussir des tests ; il s'agit de naviguer dans la logique quotidienne avec aisance.

La nouvelle norme pour mesurer les capacités de l'IA

À mesure que les modèles d'IA ont évolué, les limites des benchmarks traditionnels sont devenues plus évidentes. Par exemple, GPT-4, lorsqu'il est équipé d'outils, n'obtient qu'environ 15 % sur les tâches plus complexes du monde réel dans le benchmark GAIA, malgré ses scores élevés aux tests à choix multiples.

Cet écart entre les performances aux benchmarks et les capacités pratiques devient de plus en plus problématique à mesure que les systèmes d'IA passent des laboratoires de recherche aux applications commerciales. Les benchmarks traditionnels testent la capacité d'un modèle à se souvenir d'informations, mais négligent souvent des aspects clés de l'intelligence, comme la capacité à collecter des données, exécuter du code, analyser des informations et créer des solutions dans divers domaines.

Voici GAIA, un nouveau benchmark qui marque un changement significatif dans l'évaluation de l'IA. Développé grâce à une collaboration entre les équipes de Meta-FAIR, Meta-GenAI, HuggingFace et AutoGPT, GAIA comprend 466 questions soigneusement conçues, réparties sur trois niveaux de difficulté. Ces questions testent un large éventail de compétences essentielles pour les applications d'IA dans le monde réel, y compris la navigation sur le web, la compréhension multimodale, l'exécution de code, la gestion de fichiers et le raisonnement complexe.

Les questions de niveau 1 nécessitent généralement environ 5 étapes et un outil pour être résolues par des humains. Les questions de niveau 2 nécessitent de 5 à 10 étapes et plusieurs outils, tandis que les questions de niveau 3 peuvent exiger jusqu'à 50 étapes et un nombre quelconque d'outils. Cette structure reflète la complexité des problèmes commerciaux réels, où les solutions impliquent souvent plusieurs actions et outils.

En se concentrant sur la flexibilité plutôt que sur la simple complexité, un modèle d'IA a atteint un taux de précision de 75 % sur GAIA, surpassant les leaders de l'industrie comme Microsoft's Magnetic-1 (38 %) et Google's Langfun Agent (49 %). Ce succès provient de l'utilisation d'un mélange de modèles spécialisés pour la compréhension audiovisuelle et le raisonnement, avec Anthropic's Sonnet 3.5 comme modèle principal.

Ce changement dans l'évaluation de l'IA reflète une tendance plus large dans l'industrie : nous nous éloignons des applications SaaS autonomes vers des agents d'IA capables de gérer plusieurs outils et flux de travail. À mesure que les entreprises dépendent de plus en plus de l'IA pour relever des défis complexes et multi-étapes, des benchmarks comme GAIA offrent une mesure plus pertinente des capacités que les tests à choix multiples traditionnels.

L'avenir de l'évaluation de l'IA ne repose pas sur des tests de connaissances isolés ; il s'agit d'évaluations complètes des capacités de résolution de problèmes. GAIA établit une nouvelle norme pour mesurer les capacités de l'IA, une norme qui s'aligne mieux avec les défis et opportunités réels du déploiement de l'IA.

Sri Ambati est le fondateur et PDG de H2O.ai.

Le PDG de Replit prédit l'avenir des logiciels : "Des agents à tous les étages".

Les plateformes collaboratives de développement de l'IA pourraient-elles permettre aux entreprises de s'affranchir des coûteux abonnements SaaS ? Le PDG visionnaire de Replit, Amjad Masad, pense que c

Le PDG de Replit prédit l'avenir des logiciels : "Des agents à tous les étages".

Les plateformes collaboratives de développement de l'IA pourraient-elles permettre aux entreprises de s'affranchir des coûteux abonnements SaaS ? Le PDG visionnaire de Replit, Amjad Masad, pense que c

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

Manus lance l'outil d'IA "Wide Research" avec plus de 100 agents pour l'exploration du Web

L'innovateur chinois Manus, qui a déjà attiré l'attention sur sa plateforme d'orchestration multi-agents destinée à la fois aux consommateurs et aux utilisateurs professionnels, a dévoilé une applicat

Manus lance l'outil d'IA "Wide Research" avec plus de 100 agents pour l'exploration du Web

L'innovateur chinois Manus, qui a déjà attiré l'attention sur sa plateforme d'orchestration multi-agents destinée à la fois aux consommateurs et aux utilisateurs professionnels, a dévoilé une applicat

26 août 2025 10:25:46 UTC+02:00

26 août 2025 10:25:46 UTC+02:00

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

8 août 2025 06:01:29 UTC+02:00

8 août 2025 06:01:29 UTC+02:00

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0