蓋亞(Gaia

智能無處不在,但要精確衡量卻像徒手捕捉雲朵。我們使用考試和基準測試,例如大學入學考試,來粗略估計。每年,學生們為這些考試刻苦準備,有些甚至獲得滿分100%。但滿分是否意味著他們擁有相同的智能水平,或已達到心智潛能的頂峰?當然不是。這些基準只是粗略估計,並非某人真實能力的精確指標。

在生成式AI的世界中,MMLU(大規模多任務語言理解)等基準一直是通過多選題評估模型的首選,涵蓋多個學術領域。雖然它們便於比較,但無法完全捕捉智能能力的全部範圍。

以Claude 3.5 Sonnet和GPT-4.5為例,它們在MMLU上的得分可能相近,顯示它們不相上下。但實際使用這些模型的人都知道,它們在現實世界的表現可能大不相同。

衡量AI的「智能」意味著什麼?

隨著ARC-AGI基準的近期推出,旨在測試模型的通用推理和創意問題解決能力,關於AI「智能」測量的討論掀起新熱潮。雖然還不是每個人都體驗過ARC-AGI,但業界對此及其他新測試方法的討論熱烈。每個基準都有其價值,ARC-AGI是朝正確方向邁出的一步。

另一個令人興奮的發展是「人類的最後考試」,這是一個包含3,000道經過同行評審的多步驟問題的綜合基準,涵蓋不同學科。這是推動AI系統達到專家級推理的雄心勃勃努力。早期結果顯示進展迅速,據報導OpenAI在發布一個月後達到26.6%的得分。但與其他基準一樣,它主要聚焦於知識和孤立環境中的推理,而非對現實世界AI應用至關重要的實用工具使用技能。

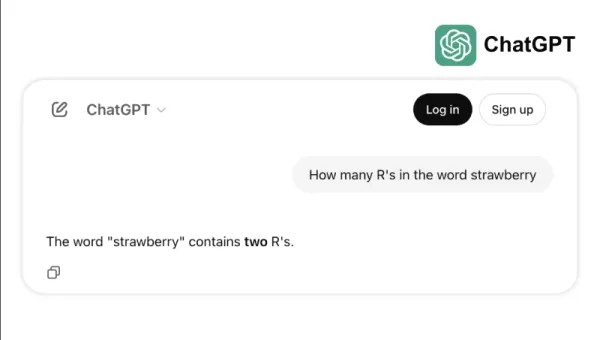

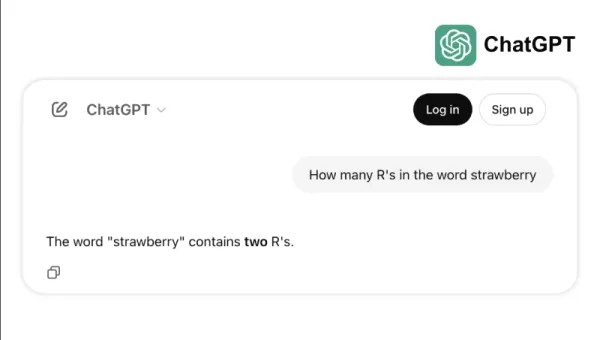

例如,一些頂尖模型在簡單任務上表現不佳,例如數「strawberry」中的「r」或比較3.8與3.1111。這些錯誤,即便是孩子或基本計算器也能避免,凸顯了基準成功與現實世界可靠性的差距。這提醒我們,智能不僅僅是考試得高分,而是輕鬆應對日常邏輯。

衡量AI能力的新標準

隨著AI模型的發展,傳統基準的局限性日益顯現。例如,GPT-4在配備工具時,於GAIA基準的更複雜現實世界任務中僅得分約15%,儘管其在多選題測試中得分很高。

基準表現與實際能力之間的差距在AI系統從研究實驗室轉向商業應用時愈發成問題。傳統基準測試模型的知識回憶能力,但常忽略智能的關鍵面向,例如收集數據、執行程式碼、分析資訊及跨領域創造解決方案的能力。

GAIA的出現標誌著AI評估的重大轉變。該基準由Meta-FAIR、Meta-GenAI、HuggingFace和AutoGPT團隊合作開發,包含466道精心設計的問題,分為三個難度等級。這些問題測試現實世界AI應用所需的多種技能,包括網頁瀏覽、多模態理解、程式碼執行、檔案處理和複雜推理。

第一級問題通常需要人類約5個步驟和一種工具來解決。第二級問題需要5至10個步驟和多種工具,而第三級問題可能需要多達50個步驟和任意數量的工具。這種結構反映了實際商業問題的複雜性,解決方案通常涉及多個動作和工具。

通過專注於靈活性而非僅僅複雜性,一個AI模型在GAIA上達到了75%的準確率,超越了業界領先者如Microsoft的Magnetic-1(38%)和Google的Langfun Agent(49%)。這一成功來自於使用專門的視聽理解和推理模型組合,以Anthropic的Sonnet 3.5為主要模型。

AI評估的轉變反映了業界的更廣泛趨勢:我們正從獨立的SaaS應用轉向能夠管理多種工具和工作流程的AI代理。隨著企業越來越依賴AI處理複雜的多步驟任務,GAIA等基準提供了比傳統多選題測試更相關的能力衡量標準。

AI評估的未來不再是孤立的知識測試,而是對問題解決能力的全面評估。GAIA為衡量AI能力設立了新標準——一個更符合AI部署現實挑戰與機遇的基準。

Sri Ambati 是 H2O.ai 的創始人兼首席執行官。

相關文章

TensorZero 獲得 730 萬美元種子基金以簡化企業 LLM 開發

TensorZero 是一家新興的人工智能應用程式開放原始碼基礎設施供應商,已獲得 730 萬美元的種子資金,由 FirstMark Capital 領投,Bessemer Venture Partners、Bedrock、DRW、Coalition 及眾多業界天使投資人參與。TensorZero 的 GitHub 資源庫在近幾個月內獲得全球「第一熱門」的地位,同時星級數從 3,000 個增加

TensorZero 獲得 730 萬美元種子基金以簡化企業 LLM 開發

TensorZero 是一家新興的人工智能應用程式開放原始碼基礎設施供應商,已獲得 730 萬美元的種子資金,由 FirstMark Capital 領投,Bessemer Venture Partners、Bedrock、DRW、Coalition 及眾多業界天使投資人參與。TensorZero 的 GitHub 資源庫在近幾個月內獲得全球「第一熱門」的地位,同時星級數從 3,000 個增加

Replit 執行長預測軟體未來:「代理商一路下滑

協同式 AI 開發平台能否讓企業擺脫昂貴的 SaaS 訂閱?Replit 有遠見的首席執行官 Amjad Masad 認為這種轉變已經在進行中,他描述了一個「代理以遞歸方式處理一切」的生態系統。在 VB Transform 的主題演講中,Masad 示範了 Replit 的 AI 代理如何讓非技術使用者在短短 15 分鐘內,開發出功能完整的投票應用程式 - 從簡單的文字提示,自動產生資料庫、驗證系

Replit 執行長預測軟體未來:「代理商一路下滑

協同式 AI 開發平台能否讓企業擺脫昂貴的 SaaS 訂閱?Replit 有遠見的首席執行官 Amjad Masad 認為這種轉變已經在進行中,他描述了一個「代理以遞歸方式處理一切」的生態系統。在 VB Transform 的主題演講中,Masad 示範了 Replit 的 AI 代理如何讓非技術使用者在短短 15 分鐘內,開發出功能完整的投票應用程式 - 從簡單的文字提示,自動產生資料庫、驗證系

OpenAI 將 ChatGPT Pro 升級至 o3,提升每月 200 美元訂閱的價值

本週,包括 Microsoft、Google 和 Anthropic 在內的科技巨擘都發表了重要的 AI 發展。OpenAI 以自己的突破性更新結束了這一連串的公告 - 除了高調地以 65 億美元收購 Jony Ive 的設計公司,推出代號為「io」的雄心勃勃的硬體計畫之外。該公司已大幅強化 ChatGPT 內的 Operator 自主網頁導覽系統,從先前的 GPT-4o 架構過渡到先進的 o3

評論 (2)

0/200

OpenAI 將 ChatGPT Pro 升級至 o3,提升每月 200 美元訂閱的價值

本週,包括 Microsoft、Google 和 Anthropic 在內的科技巨擘都發表了重要的 AI 發展。OpenAI 以自己的突破性更新結束了這一連串的公告 - 除了高調地以 65 億美元收購 Jony Ive 的設計公司,推出代號為「io」的雄心勃勃的硬體計畫之外。該公司已大幅強化 ChatGPT 內的 Operator 自主網頁導覽系統,從先前的 GPT-4o 架構過渡到先進的 o3

評論 (2)

0/200

![BillyAdams]() BillyAdams

BillyAdams

2025-08-26 16:25:46

2025-08-26 16:25:46

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

![GaryThomas]() GaryThomas

GaryThomas

2025-08-08 12:01:29

2025-08-08 12:01:29

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0

智能無處不在,但要精確衡量卻像徒手捕捉雲朵。我們使用考試和基準測試,例如大學入學考試,來粗略估計。每年,學生們為這些考試刻苦準備,有些甚至獲得滿分100%。但滿分是否意味著他們擁有相同的智能水平,或已達到心智潛能的頂峰?當然不是。這些基準只是粗略估計,並非某人真實能力的精確指標。

在生成式AI的世界中,MMLU(大規模多任務語言理解)等基準一直是通過多選題評估模型的首選,涵蓋多個學術領域。雖然它們便於比較,但無法完全捕捉智能能力的全部範圍。

以Claude 3.5 Sonnet和GPT-4.5為例,它們在MMLU上的得分可能相近,顯示它們不相上下。但實際使用這些模型的人都知道,它們在現實世界的表現可能大不相同。

衡量AI的「智能」意味著什麼?

隨著ARC-AGI基準的近期推出,旨在測試模型的通用推理和創意問題解決能力,關於AI「智能」測量的討論掀起新熱潮。雖然還不是每個人都體驗過ARC-AGI,但業界對此及其他新測試方法的討論熱烈。每個基準都有其價值,ARC-AGI是朝正確方向邁出的一步。

另一個令人興奮的發展是「人類的最後考試」,這是一個包含3,000道經過同行評審的多步驟問題的綜合基準,涵蓋不同學科。這是推動AI系統達到專家級推理的雄心勃勃努力。早期結果顯示進展迅速,據報導OpenAI在發布一個月後達到26.6%的得分。但與其他基準一樣,它主要聚焦於知識和孤立環境中的推理,而非對現實世界AI應用至關重要的實用工具使用技能。

例如,一些頂尖模型在簡單任務上表現不佳,例如數「strawberry」中的「r」或比較3.8與3.1111。這些錯誤,即便是孩子或基本計算器也能避免,凸顯了基準成功與現實世界可靠性的差距。這提醒我們,智能不僅僅是考試得高分,而是輕鬆應對日常邏輯。

衡量AI能力的新標準

隨著AI模型的發展,傳統基準的局限性日益顯現。例如,GPT-4在配備工具時,於GAIA基準的更複雜現實世界任務中僅得分約15%,儘管其在多選題測試中得分很高。

基準表現與實際能力之間的差距在AI系統從研究實驗室轉向商業應用時愈發成問題。傳統基準測試模型的知識回憶能力,但常忽略智能的關鍵面向,例如收集數據、執行程式碼、分析資訊及跨領域創造解決方案的能力。

GAIA的出現標誌著AI評估的重大轉變。該基準由Meta-FAIR、Meta-GenAI、HuggingFace和AutoGPT團隊合作開發,包含466道精心設計的問題,分為三個難度等級。這些問題測試現實世界AI應用所需的多種技能,包括網頁瀏覽、多模態理解、程式碼執行、檔案處理和複雜推理。

第一級問題通常需要人類約5個步驟和一種工具來解決。第二級問題需要5至10個步驟和多種工具,而第三級問題可能需要多達50個步驟和任意數量的工具。這種結構反映了實際商業問題的複雜性,解決方案通常涉及多個動作和工具。

通過專注於靈活性而非僅僅複雜性,一個AI模型在GAIA上達到了75%的準確率,超越了業界領先者如Microsoft的Magnetic-1(38%)和Google的Langfun Agent(49%)。這一成功來自於使用專門的視聽理解和推理模型組合,以Anthropic的Sonnet 3.5為主要模型。

AI評估的轉變反映了業界的更廣泛趨勢:我們正從獨立的SaaS應用轉向能夠管理多種工具和工作流程的AI代理。隨著企業越來越依賴AI處理複雜的多步驟任務,GAIA等基準提供了比傳統多選題測試更相關的能力衡量標準。

AI評估的未來不再是孤立的知識測試,而是對問題解決能力的全面評估。GAIA為衡量AI能力設立了新標準——一個更符合AI部署現實挑戰與機遇的基準。

Sri Ambati 是 H2O.ai 的創始人兼首席執行官。

TensorZero 獲得 730 萬美元種子基金以簡化企業 LLM 開發

TensorZero 是一家新興的人工智能應用程式開放原始碼基礎設施供應商,已獲得 730 萬美元的種子資金,由 FirstMark Capital 領投,Bessemer Venture Partners、Bedrock、DRW、Coalition 及眾多業界天使投資人參與。TensorZero 的 GitHub 資源庫在近幾個月內獲得全球「第一熱門」的地位,同時星級數從 3,000 個增加

TensorZero 獲得 730 萬美元種子基金以簡化企業 LLM 開發

TensorZero 是一家新興的人工智能應用程式開放原始碼基礎設施供應商,已獲得 730 萬美元的種子資金,由 FirstMark Capital 領投,Bessemer Venture Partners、Bedrock、DRW、Coalition 及眾多業界天使投資人參與。TensorZero 的 GitHub 資源庫在近幾個月內獲得全球「第一熱門」的地位,同時星級數從 3,000 個增加

Replit 執行長預測軟體未來:「代理商一路下滑

協同式 AI 開發平台能否讓企業擺脫昂貴的 SaaS 訂閱?Replit 有遠見的首席執行官 Amjad Masad 認為這種轉變已經在進行中,他描述了一個「代理以遞歸方式處理一切」的生態系統。在 VB Transform 的主題演講中,Masad 示範了 Replit 的 AI 代理如何讓非技術使用者在短短 15 分鐘內,開發出功能完整的投票應用程式 - 從簡單的文字提示,自動產生資料庫、驗證系

Replit 執行長預測軟體未來:「代理商一路下滑

協同式 AI 開發平台能否讓企業擺脫昂貴的 SaaS 訂閱?Replit 有遠見的首席執行官 Amjad Masad 認為這種轉變已經在進行中,他描述了一個「代理以遞歸方式處理一切」的生態系統。在 VB Transform 的主題演講中,Masad 示範了 Replit 的 AI 代理如何讓非技術使用者在短短 15 分鐘內,開發出功能完整的投票應用程式 - 從簡單的文字提示,自動產生資料庫、驗證系

OpenAI 將 ChatGPT Pro 升級至 o3,提升每月 200 美元訂閱的價值

本週,包括 Microsoft、Google 和 Anthropic 在內的科技巨擘都發表了重要的 AI 發展。OpenAI 以自己的突破性更新結束了這一連串的公告 - 除了高調地以 65 億美元收購 Jony Ive 的設計公司,推出代號為「io」的雄心勃勃的硬體計畫之外。該公司已大幅強化 ChatGPT 內的 Operator 自主網頁導覽系統,從先前的 GPT-4o 架構過渡到先進的 o3

OpenAI 將 ChatGPT Pro 升級至 o3,提升每月 200 美元訂閱的價值

本週,包括 Microsoft、Google 和 Anthropic 在內的科技巨擘都發表了重要的 AI 發展。OpenAI 以自己的突破性更新結束了這一連串的公告 - 除了高調地以 65 億美元收購 Jony Ive 的設計公司,推出代號為「io」的雄心勃勃的硬體計畫之外。該公司已大幅強化 ChatGPT 內的 Operator 自主網頁導覽系統,從先前的 GPT-4o 架構過渡到先進的 o3

2025-08-26 16:25:46

2025-08-26 16:25:46

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

2025-08-08 12:01:29

2025-08-08 12:01:29

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0