Gaia presenta un nuevo punto de referencia en busca de la verdadera inteligencia más allá de Arc-Agi

La inteligencia está en todas partes, pero medirla con precisión parece como intentar atrapar una nube con las manos. Usamos pruebas y estándares, como los exámenes de ingreso a la universidad, para tener una idea aproximada. Cada año, los estudiantes se preparan intensamente para estas pruebas, a veces logrando un puntaje perfecto del 100%. Pero, ¿ese puntaje perfecto significa que todos tienen el mismo nivel de inteligencia o que han alcanzado el máximo de su potencial mental? Por supuesto que no. Estos estándares son solo estimaciones aproximadas, no indicadores precisos de las verdaderas habilidades de alguien.

En el mundo de la IA generativa, estándares como MMLU (Comprensión Masiva de Tareas Múltiples) han sido los preferidos para evaluar modelos mediante preguntas de opción múltiple en diversas áreas académicas. Aunque permiten comparaciones fáciles, no capturan realmente el espectro completo de las capacidades inteligentes.

Tomemos, por ejemplo, a Claude 3.5 Sonnet y GPT-4.5. Podrían obtener puntajes similares en MMLU, sugiriendo que están a la par. Pero cualquiera que haya usado estos modelos sabe que su desempeño en el mundo real puede ser bastante diferente.

¿Qué significa medir la 'inteligencia' en la IA?

Con el reciente lanzamiento del estándar ARC-AGI, diseñado para probar modelos en razonamiento general y resolución creativa de problemas, ha surgido una nueva ola de discusión sobre qué significa medir la "inteligencia" en la IA. No todos han tenido la oportunidad de explorar ARC-AGI aún, pero la industria está emocionada con este y otros nuevos enfoques de evaluación. Cada estándar tiene su lugar, y ARC-AGI es un paso en la dirección correcta.

Otro desarrollo emocionante es 'El Último Examen de la Humanidad', un estándar integral con 3,000 preguntas revisadas por pares, de múltiples pasos, que abarcan diferentes disciplinas. Es un esfuerzo ambicioso para empujar a los sistemas de IA al razonamiento de nivel experto. Los primeros resultados muestran un progreso rápido, con OpenAI alcanzando un puntaje del 26.6% apenas un mes después de su lanzamiento. Pero, como otros estándares, se centra principalmente en el conocimiento y el razonamiento en un vacío, no en las habilidades prácticas de uso de herramientas que son vitales para las aplicaciones de IA en el mundo real.

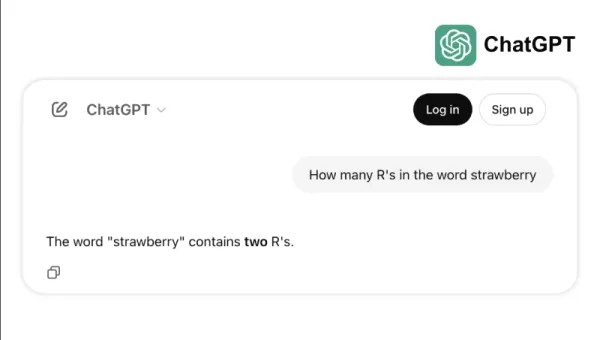

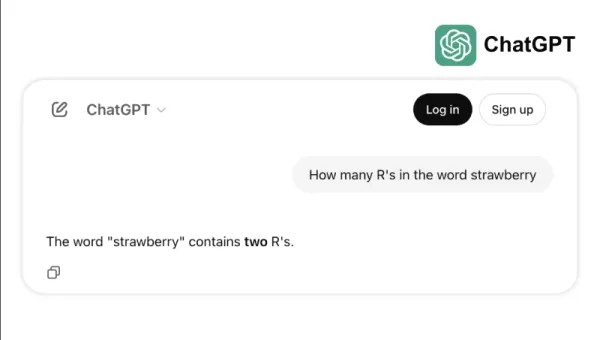

Por ejemplo, algunos modelos líderes tienen dificultades con tareas simples como contar las "r" en "strawberry" o comparar 3.8 con 3.1111. Estos errores, que incluso un niño o una calculadora básica podrían evitar, destacan la brecha entre el éxito en los estándares y la fiabilidad en el mundo real. Es un recordatorio de que la inteligencia no se trata solo de aprobar pruebas; se trata de navegar por la lógica cotidiana con facilidad.

El Nuevo Estándar para Medir la Capacidad de la IA

A medida que los modelos de IA han evolucionado, las limitaciones de los estándares tradicionales se han vuelto más evidentes. Por ejemplo, GPT-4, cuando está equipado con herramientas, solo logra un 15% en las tareas más complejas del mundo real en el estándar GAIA, a pesar de sus altos puntajes en pruebas de opción múltiple.

Esta discrepancia entre el rendimiento en estándares y la capacidad práctica es cada vez más problemática a medida que los sistemas de IA pasan de los laboratorios de investigación a las aplicaciones empresariales. Los estándares tradicionales evalúan qué tan bien un modelo puede recordar información, pero a menudo pasan por alto aspectos clave de la inteligencia, como la capacidad de recopilar datos, ejecutar código, analizar información y crear soluciones en diversos dominios.

Entra GAIA, un nuevo estándar que marca un cambio significativo en la evaluación de la IA. Desarrollado a través de una colaboración entre equipos de Meta-FAIR, Meta-GenAI, HuggingFace y AutoGPT, GAIA incluye 466 preguntas cuidadosamente elaboradas en tres niveles de dificultad. Estas preguntas evalúan una amplia gama de habilidades esenciales para las aplicaciones de IA en el mundo real, incluyendo navegación web, comprensión multimodal, ejecución de código, manejo de archivos y razonamiento complejo.

Las preguntas de nivel 1 generalmente requieren unos 5 pasos y una herramienta para que los humanos las resuelvan. Las preguntas de nivel 2 necesitan de 5 a 10 pasos y múltiples herramientas, mientras que las preguntas de nivel 3 podrían exigir hasta 50 pasos y cualquier cantidad de herramientas. Esta estructura refleja la complejidad de los problemas empresariales reales, donde las soluciones a menudo involucran múltiples acciones y herramientas.

Al centrarse en la flexibilidad en lugar de solo la complejidad, un modelo de IA logró una tasa de precisión del 75% en GAIA, superando a líderes de la industria como Microsoft's Magnetic-1 (38%) y Google's Langfun Agent (49%). Este éxito proviene del uso de una combinación de modelos especializados para la comprensión audiovisual y el razonamiento, con Anthropic's Sonnet 3.5 como el modelo principal.

Este cambio en la evaluación de la IA refleja una tendencia más amplia en la industria: Nos estamos alejando de las aplicaciones SaaS independientes hacia agentes de IA que pueden gestionar múltiples herramientas y flujos de trabajo. A medida que las empresas dependen cada vez más de la IA para abordar tareas complejas de múltiples pasos, estándares como GAIA ofrecen una medida más relevante de la capacidad que las pruebas tradicionales de opción múltiple.

El futuro de la evaluación de la IA no se trata de pruebas de conocimiento aisladas; se trata de evaluaciones integrales de la capacidad de resolución de problemas. GAIA establece un nuevo estándar para medir la capacidad de la IA, uno que se alinea mejor con los desafíos y oportunidades del mundo real en la implementación de la IA.

Sri Ambati es el fundador y CEO de H2O.ai.

Artículo relacionado

TensorZero obtiene una financiación inicial de 7,3 millones de dólares para simplificar el desarrollo de LLM empresariales

TensorZero, un proveedor emergente de infraestructura de código abierto para aplicaciones de IA, ha conseguido 7,3 millones de dólares en financiación inicial liderada por FirstMark Capital, con la pa

TensorZero obtiene una financiación inicial de 7,3 millones de dólares para simplificar el desarrollo de LLM empresariales

TensorZero, un proveedor emergente de infraestructura de código abierto para aplicaciones de IA, ha conseguido 7,3 millones de dólares en financiación inicial liderada por FirstMark Capital, con la pa

El CEO de Replit predice el futuro del software: "Agentes hasta el final

¿Podrían las plataformas de desarrollo colaborativo de IA permitir a las empresas liberarse de las costosas suscripciones SaaS? El visionario CEO de Replit, Amjad Masad, cree que esta transformación y

El CEO de Replit predice el futuro del software: "Agentes hasta el final

¿Podrían las plataformas de desarrollo colaborativo de IA permitir a las empresas liberarse de las costosas suscripciones SaaS? El visionario CEO de Replit, Amjad Masad, cree que esta transformación y

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

comentario (2)

0/200

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

comentario (2)

0/200

![BillyAdams]() BillyAdams

BillyAdams

26 de agosto de 2025 10:25:46 GMT+02:00

26 de agosto de 2025 10:25:46 GMT+02:00

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

![GaryThomas]() GaryThomas

GaryThomas

8 de agosto de 2025 06:01:29 GMT+02:00

8 de agosto de 2025 06:01:29 GMT+02:00

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0

La inteligencia está en todas partes, pero medirla con precisión parece como intentar atrapar una nube con las manos. Usamos pruebas y estándares, como los exámenes de ingreso a la universidad, para tener una idea aproximada. Cada año, los estudiantes se preparan intensamente para estas pruebas, a veces logrando un puntaje perfecto del 100%. Pero, ¿ese puntaje perfecto significa que todos tienen el mismo nivel de inteligencia o que han alcanzado el máximo de su potencial mental? Por supuesto que no. Estos estándares son solo estimaciones aproximadas, no indicadores precisos de las verdaderas habilidades de alguien.

En el mundo de la IA generativa, estándares como MMLU (Comprensión Masiva de Tareas Múltiples) han sido los preferidos para evaluar modelos mediante preguntas de opción múltiple en diversas áreas académicas. Aunque permiten comparaciones fáciles, no capturan realmente el espectro completo de las capacidades inteligentes.

Tomemos, por ejemplo, a Claude 3.5 Sonnet y GPT-4.5. Podrían obtener puntajes similares en MMLU, sugiriendo que están a la par. Pero cualquiera que haya usado estos modelos sabe que su desempeño en el mundo real puede ser bastante diferente.

¿Qué significa medir la 'inteligencia' en la IA?

Con el reciente lanzamiento del estándar ARC-AGI, diseñado para probar modelos en razonamiento general y resolución creativa de problemas, ha surgido una nueva ola de discusión sobre qué significa medir la "inteligencia" en la IA. No todos han tenido la oportunidad de explorar ARC-AGI aún, pero la industria está emocionada con este y otros nuevos enfoques de evaluación. Cada estándar tiene su lugar, y ARC-AGI es un paso en la dirección correcta.

Otro desarrollo emocionante es 'El Último Examen de la Humanidad', un estándar integral con 3,000 preguntas revisadas por pares, de múltiples pasos, que abarcan diferentes disciplinas. Es un esfuerzo ambicioso para empujar a los sistemas de IA al razonamiento de nivel experto. Los primeros resultados muestran un progreso rápido, con OpenAI alcanzando un puntaje del 26.6% apenas un mes después de su lanzamiento. Pero, como otros estándares, se centra principalmente en el conocimiento y el razonamiento en un vacío, no en las habilidades prácticas de uso de herramientas que son vitales para las aplicaciones de IA en el mundo real.

Por ejemplo, algunos modelos líderes tienen dificultades con tareas simples como contar las "r" en "strawberry" o comparar 3.8 con 3.1111. Estos errores, que incluso un niño o una calculadora básica podrían evitar, destacan la brecha entre el éxito en los estándares y la fiabilidad en el mundo real. Es un recordatorio de que la inteligencia no se trata solo de aprobar pruebas; se trata de navegar por la lógica cotidiana con facilidad.

El Nuevo Estándar para Medir la Capacidad de la IA

A medida que los modelos de IA han evolucionado, las limitaciones de los estándares tradicionales se han vuelto más evidentes. Por ejemplo, GPT-4, cuando está equipado con herramientas, solo logra un 15% en las tareas más complejas del mundo real en el estándar GAIA, a pesar de sus altos puntajes en pruebas de opción múltiple.

Esta discrepancia entre el rendimiento en estándares y la capacidad práctica es cada vez más problemática a medida que los sistemas de IA pasan de los laboratorios de investigación a las aplicaciones empresariales. Los estándares tradicionales evalúan qué tan bien un modelo puede recordar información, pero a menudo pasan por alto aspectos clave de la inteligencia, como la capacidad de recopilar datos, ejecutar código, analizar información y crear soluciones en diversos dominios.

Entra GAIA, un nuevo estándar que marca un cambio significativo en la evaluación de la IA. Desarrollado a través de una colaboración entre equipos de Meta-FAIR, Meta-GenAI, HuggingFace y AutoGPT, GAIA incluye 466 preguntas cuidadosamente elaboradas en tres niveles de dificultad. Estas preguntas evalúan una amplia gama de habilidades esenciales para las aplicaciones de IA en el mundo real, incluyendo navegación web, comprensión multimodal, ejecución de código, manejo de archivos y razonamiento complejo.

Las preguntas de nivel 1 generalmente requieren unos 5 pasos y una herramienta para que los humanos las resuelvan. Las preguntas de nivel 2 necesitan de 5 a 10 pasos y múltiples herramientas, mientras que las preguntas de nivel 3 podrían exigir hasta 50 pasos y cualquier cantidad de herramientas. Esta estructura refleja la complejidad de los problemas empresariales reales, donde las soluciones a menudo involucran múltiples acciones y herramientas.

Al centrarse en la flexibilidad en lugar de solo la complejidad, un modelo de IA logró una tasa de precisión del 75% en GAIA, superando a líderes de la industria como Microsoft's Magnetic-1 (38%) y Google's Langfun Agent (49%). Este éxito proviene del uso de una combinación de modelos especializados para la comprensión audiovisual y el razonamiento, con Anthropic's Sonnet 3.5 como el modelo principal.

Este cambio en la evaluación de la IA refleja una tendencia más amplia en la industria: Nos estamos alejando de las aplicaciones SaaS independientes hacia agentes de IA que pueden gestionar múltiples herramientas y flujos de trabajo. A medida que las empresas dependen cada vez más de la IA para abordar tareas complejas de múltiples pasos, estándares como GAIA ofrecen una medida más relevante de la capacidad que las pruebas tradicionales de opción múltiple.

El futuro de la evaluación de la IA no se trata de pruebas de conocimiento aisladas; se trata de evaluaciones integrales de la capacidad de resolución de problemas. GAIA establece un nuevo estándar para medir la capacidad de la IA, uno que se alinea mejor con los desafíos y oportunidades del mundo real en la implementación de la IA.

Sri Ambati es el fundador y CEO de H2O.ai.

TensorZero obtiene una financiación inicial de 7,3 millones de dólares para simplificar el desarrollo de LLM empresariales

TensorZero, un proveedor emergente de infraestructura de código abierto para aplicaciones de IA, ha conseguido 7,3 millones de dólares en financiación inicial liderada por FirstMark Capital, con la pa

TensorZero obtiene una financiación inicial de 7,3 millones de dólares para simplificar el desarrollo de LLM empresariales

TensorZero, un proveedor emergente de infraestructura de código abierto para aplicaciones de IA, ha conseguido 7,3 millones de dólares en financiación inicial liderada por FirstMark Capital, con la pa

El CEO de Replit predice el futuro del software: "Agentes hasta el final

¿Podrían las plataformas de desarrollo colaborativo de IA permitir a las empresas liberarse de las costosas suscripciones SaaS? El visionario CEO de Replit, Amjad Masad, cree que esta transformación y

El CEO de Replit predice el futuro del software: "Agentes hasta el final

¿Podrían las plataformas de desarrollo colaborativo de IA permitir a las empresas liberarse de las costosas suscripciones SaaS? El visionario CEO de Replit, Amjad Masad, cree que esta transformación y

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

26 de agosto de 2025 10:25:46 GMT+02:00

26 de agosto de 2025 10:25:46 GMT+02:00

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

8 de agosto de 2025 06:01:29 GMT+02:00

8 de agosto de 2025 06:01:29 GMT+02:00

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0