ガイアは、Arc-Agiを超えた真の知性を求めて新しいベンチマークを紹介します

知性はどこにでも存在しますが、それを正確に測定するのは、素手で雲をつかむようなものです。私たちは大学入試のようなテストやベンチマークを使って大まかな見当をつけます。毎年、学生たちはこれらのテストのために詰め込み勉強をし、時には100%の完璧なスコアを獲得します。しかし、その完璧なスコアは、彼らがみな同じレベルの知性を持っていること、あるいは彼らの精神的潜在能力のピークに達したことを意味するのでしょうか?もちろん違います。これらのベンチマークは、誰かの本当の能力を正確に示すものではなく、粗い推定にすぎません。

生成AIの世界では、MMLU(Massive Multitask Language Understanding)のようなベンチマークが、さまざまな学術分野にわたる多肢選択問題を通じてモデルを評価するための標準でした。これらは簡単な比較を可能にしますが、知的能力の全範囲を本当に捉えているわけではありません。

たとえば、Claude 3.5 SonnetとGPT-4.5を取り上げてみましょう。MMLUでのスコアが似ているため、同等の性能を持つように見えます。しかし、これらのモデルを実際に使ったことがある人なら、実世界でのパフォーマンスがかなり異なることを知っています。

AIにおける「知性」の測定とは何か?

最近、ARC-AGIベンチマークが開始され、一般的な推論や創造的な問題解決をテストするために設計されたことで、AIにおける「知性」の測定とは何かをめぐる新たな議論が巻き起こっています。まだ誰もがARC-AGIに深く取り組んだわけではありませんが、業界はこの新しいテストアプローチや他の新しい方法について盛り上がっています。すべてのベンチマークにはそれぞれの役割があり、ARC-AGIは正しい方向への一歩です。

もう一つのエキサイティングな進展は、「Humanity's Last Exam」です。これは、さまざまな分野にわたる3,000の査読済み多段階質問からなる包括的なベンチマークです。AIシステムを専門家レベルの推論に挑戦させる野心的な試みです。初期の結果は急速な進歩を示しており、OpenAIはリリースからわずか1か月で26.6%のスコアを記録したとされています。しかし、他のベンチマークと同様に、これは主に知識と真空状態での推論に焦点を当てており、実世界のAIアプリケーションに不可欠な実際のツール使用スキルには焦点を当てていません。

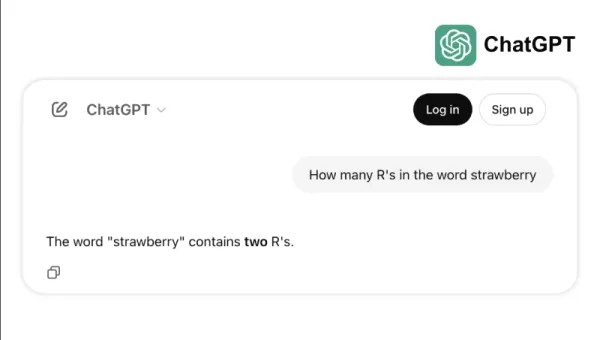

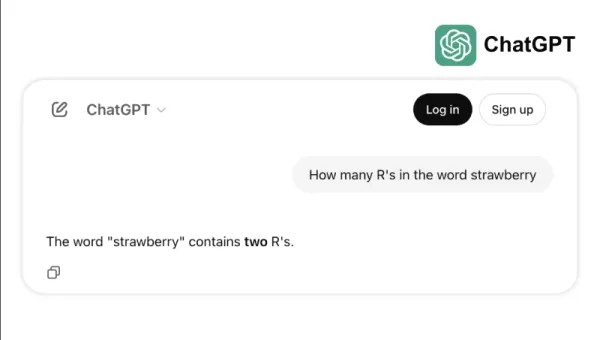

たとえば、トップモデルの一部が「strawberry」の「r」の数を数えるような簡単なタスクや、3.8と3.1111の比較で苦戦する様子を見てみましょう。これらのエラーは、子供や基本的な電卓でも避けられるものであり、ベンチマークの成功と実世界の信頼性の間のギャップを浮き彫りにします。知性とは、テストで高得点を出すことだけでなく、日常の論理を容易に操ることであるということを思い出させます。

AI能力を測定する新しい基準

AIモデルが進化するにつれて、従来のベンチマークの限界がより明らかになってきました。たとえば、ツールを備えたGPT-4は、多肢選択テストで高得点を記録しているにもかかわらず、GAIAベンチマークのより複雑な実世界のタスクでは約15%しかスコアを獲得できません。

ベンチマークのパフォーマンスと実際の能力の間のこの乖離は、AIシステムが研究室からビジネスアプリケーションに移行するにつれてますます問題となっています。従来のベンチマークは、モデルが情報をどれだけ正確に思い出すかをテストしますが、データを収集し、コードを実行し、情報を分析し、さまざまな領域でソリューションを作成する能力など、知性の重要な側面をしばしば見落とします。

そこで登場するのがGAIAです。これはAI評価における大きな変化を示す新しいベンチマークです。Meta-FAIR、Meta-GenAI、HuggingFace、AutoGPTのチームによる協力で開発されたGAIAは、3つの難易度レベルにわたる466の慎重に作成された質問を含んでいます。これらの質問は、ウェブブラウジング、マルチモーダル理解、コード実行、ファイル処理、複雑な推論など、実世界のAIアプリケーションに不可欠な幅広いスキルをテストします。

レベル1の質問は通常、5ステップと1つのツールで人間が解決する必要があります。レベル2の質問は5~10ステップと複数のツールが必要で、レベル3の質問は最大50ステップと任意の数のツールを要求する可能性があります。この構造は、実際のビジネス問題の複雑さを反映しており、解決策にはしばしば複数のアクションとツールが関与します。

複雑さだけでなく柔軟性に焦点を当てることで、あるAIモデルはGAIAで75%の正確率を達成し、MicrosoftのMagnetic-1(38%)やGoogleのLangfun Agent(49%)などの業界リーダーを上回りました。この成功は、オーディオビジュアル理解と推論のための専門モデルの組み合わせを使用し、AnthropicのSonnet 3.5を主要モデルとして採用した結果です。

AI評価のこの変化は、業界全体のより大きなトレンドを反映しています。スタンドアローンのSaaSアプリケーションから、複数のツールとワークフローを管理できるAIエージェントへと移行しています。ビジネスが複雑な多段階タスクを処理するためにAIにますます依存する中、GAIAのようなベンチマークは、従来の多肢選択テストよりも関連性の高い能力の尺度を提供します。

AI評価の未来は、孤立した知識テストではなく、問題解決能力の包括的な評価に関するものです。GAIAは、AI能力を測定するための新しい基準を設定し、AI展開の実世界の課題と機会により良く適合します。

Sri AmbatiはH2O.aiの創設者兼CEOです。

関連記事

TensorZero、エンタープライズLLM開発を簡素化するために730万ドルのシード資金を獲得

AIアプリケーションのオープンソース・インフラストラクチャ・プロバイダーとして台頭するTensorZeroは、FirstMark Capitalを筆頭に、Bessemer Venture Partners、Bedrock、DRW、Coalition、多数の業界エンジェルが参加し、730万ドルのシード資金を確保した。TensorZeroのGitHubリポジトリは、ここ数カ月でスター数が3,000

TensorZero、エンタープライズLLM開発を簡素化するために730万ドルのシード資金を獲得

AIアプリケーションのオープンソース・インフラストラクチャ・プロバイダーとして台頭するTensorZeroは、FirstMark Capitalを筆頭に、Bessemer Venture Partners、Bedrock、DRW、Coalition、多数の業界エンジェルが参加し、730万ドルのシード資金を確保した。TensorZeroのGitHubリポジトリは、ここ数カ月でスター数が3,000

リプリットCEOが予測するソフトウェアの未来:「エージェントはずっと下」。

共同AI開発プラットフォームによって、企業は高価なSaaSサブスクリプションから脱却できるだろうか?Replitの先見的なCEOであるAmjad Masadは、この変革はすでに進行中であると考えており、"エージェントが再帰的にすべてを処理する "エコシステムについて説明している。VB Transformの基調講演でマサド氏は、ReplitのAIエージェントが、技術者でないユーザーに、わずか15分で

リプリットCEOが予測するソフトウェアの未来:「エージェントはずっと下」。

共同AI開発プラットフォームによって、企業は高価なSaaSサブスクリプションから脱却できるだろうか?Replitの先見的なCEOであるAmjad Masadは、この変革はすでに進行中であると考えており、"エージェントが再帰的にすべてを処理する "エコシステムについて説明している。VB Transformの基調講演でマサド氏は、ReplitのAIエージェントが、技術者でないユーザーに、わずか15分で

OpenAIがChatGPT Proをo3にアップグレード。

今週は、マイクロソフト、グーグル、Anthropicを含むハイテク大手から重要なAIの開発が目撃された。OpenAIは、コードネーム "io "と呼ばれる野心的なハードウェア構想のために、注目されたジョニー・アイブのデザイン会社を65億ドルで買収したことにとどまらず、独自の画期的なアップデートで発表の慌ただしさを締めくくった。同社は、ChatGPT内のOperator自律ウェブ・ナビゲーション・シ

コメント (2)

0/200

OpenAIがChatGPT Proをo3にアップグレード。

今週は、マイクロソフト、グーグル、Anthropicを含むハイテク大手から重要なAIの開発が目撃された。OpenAIは、コードネーム "io "と呼ばれる野心的なハードウェア構想のために、注目されたジョニー・アイブのデザイン会社を65億ドルで買収したことにとどまらず、独自の画期的なアップデートで発表の慌ただしさを締めくくった。同社は、ChatGPT内のOperator自律ウェブ・ナビゲーション・シ

コメント (2)

0/200

![BillyAdams]() BillyAdams

BillyAdams

2025年8月26日 17:25:46 JST

2025年8月26日 17:25:46 JST

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

![GaryThomas]() GaryThomas

GaryThomas

2025年8月8日 13:01:29 JST

2025年8月8日 13:01:29 JST

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0

知性はどこにでも存在しますが、それを正確に測定するのは、素手で雲をつかむようなものです。私たちは大学入試のようなテストやベンチマークを使って大まかな見当をつけます。毎年、学生たちはこれらのテストのために詰め込み勉強をし、時には100%の完璧なスコアを獲得します。しかし、その完璧なスコアは、彼らがみな同じレベルの知性を持っていること、あるいは彼らの精神的潜在能力のピークに達したことを意味するのでしょうか?もちろん違います。これらのベンチマークは、誰かの本当の能力を正確に示すものではなく、粗い推定にすぎません。

生成AIの世界では、MMLU(Massive Multitask Language Understanding)のようなベンチマークが、さまざまな学術分野にわたる多肢選択問題を通じてモデルを評価するための標準でした。これらは簡単な比較を可能にしますが、知的能力の全範囲を本当に捉えているわけではありません。

たとえば、Claude 3.5 SonnetとGPT-4.5を取り上げてみましょう。MMLUでのスコアが似ているため、同等の性能を持つように見えます。しかし、これらのモデルを実際に使ったことがある人なら、実世界でのパフォーマンスがかなり異なることを知っています。

AIにおける「知性」の測定とは何か?

最近、ARC-AGIベンチマークが開始され、一般的な推論や創造的な問題解決をテストするために設計されたことで、AIにおける「知性」の測定とは何かをめぐる新たな議論が巻き起こっています。まだ誰もがARC-AGIに深く取り組んだわけではありませんが、業界はこの新しいテストアプローチや他の新しい方法について盛り上がっています。すべてのベンチマークにはそれぞれの役割があり、ARC-AGIは正しい方向への一歩です。

もう一つのエキサイティングな進展は、「Humanity's Last Exam」です。これは、さまざまな分野にわたる3,000の査読済み多段階質問からなる包括的なベンチマークです。AIシステムを専門家レベルの推論に挑戦させる野心的な試みです。初期の結果は急速な進歩を示しており、OpenAIはリリースからわずか1か月で26.6%のスコアを記録したとされています。しかし、他のベンチマークと同様に、これは主に知識と真空状態での推論に焦点を当てており、実世界のAIアプリケーションに不可欠な実際のツール使用スキルには焦点を当てていません。

たとえば、トップモデルの一部が「strawberry」の「r」の数を数えるような簡単なタスクや、3.8と3.1111の比較で苦戦する様子を見てみましょう。これらのエラーは、子供や基本的な電卓でも避けられるものであり、ベンチマークの成功と実世界の信頼性の間のギャップを浮き彫りにします。知性とは、テストで高得点を出すことだけでなく、日常の論理を容易に操ることであるということを思い出させます。

AI能力を測定する新しい基準

AIモデルが進化するにつれて、従来のベンチマークの限界がより明らかになってきました。たとえば、ツールを備えたGPT-4は、多肢選択テストで高得点を記録しているにもかかわらず、GAIAベンチマークのより複雑な実世界のタスクでは約15%しかスコアを獲得できません。

ベンチマークのパフォーマンスと実際の能力の間のこの乖離は、AIシステムが研究室からビジネスアプリケーションに移行するにつれてますます問題となっています。従来のベンチマークは、モデルが情報をどれだけ正確に思い出すかをテストしますが、データを収集し、コードを実行し、情報を分析し、さまざまな領域でソリューションを作成する能力など、知性の重要な側面をしばしば見落とします。

そこで登場するのがGAIAです。これはAI評価における大きな変化を示す新しいベンチマークです。Meta-FAIR、Meta-GenAI、HuggingFace、AutoGPTのチームによる協力で開発されたGAIAは、3つの難易度レベルにわたる466の慎重に作成された質問を含んでいます。これらの質問は、ウェブブラウジング、マルチモーダル理解、コード実行、ファイル処理、複雑な推論など、実世界のAIアプリケーションに不可欠な幅広いスキルをテストします。

レベル1の質問は通常、5ステップと1つのツールで人間が解決する必要があります。レベル2の質問は5~10ステップと複数のツールが必要で、レベル3の質問は最大50ステップと任意の数のツールを要求する可能性があります。この構造は、実際のビジネス問題の複雑さを反映しており、解決策にはしばしば複数のアクションとツールが関与します。

複雑さだけでなく柔軟性に焦点を当てることで、あるAIモデルはGAIAで75%の正確率を達成し、MicrosoftのMagnetic-1(38%)やGoogleのLangfun Agent(49%)などの業界リーダーを上回りました。この成功は、オーディオビジュアル理解と推論のための専門モデルの組み合わせを使用し、AnthropicのSonnet 3.5を主要モデルとして採用した結果です。

AI評価のこの変化は、業界全体のより大きなトレンドを反映しています。スタンドアローンのSaaSアプリケーションから、複数のツールとワークフローを管理できるAIエージェントへと移行しています。ビジネスが複雑な多段階タスクを処理するためにAIにますます依存する中、GAIAのようなベンチマークは、従来の多肢選択テストよりも関連性の高い能力の尺度を提供します。

AI評価の未来は、孤立した知識テストではなく、問題解決能力の包括的な評価に関するものです。GAIAは、AI能力を測定するための新しい基準を設定し、AI展開の実世界の課題と機会により良く適合します。

Sri AmbatiはH2O.aiの創設者兼CEOです。

TensorZero、エンタープライズLLM開発を簡素化するために730万ドルのシード資金を獲得

AIアプリケーションのオープンソース・インフラストラクチャ・プロバイダーとして台頭するTensorZeroは、FirstMark Capitalを筆頭に、Bessemer Venture Partners、Bedrock、DRW、Coalition、多数の業界エンジェルが参加し、730万ドルのシード資金を確保した。TensorZeroのGitHubリポジトリは、ここ数カ月でスター数が3,000

TensorZero、エンタープライズLLM開発を簡素化するために730万ドルのシード資金を獲得

AIアプリケーションのオープンソース・インフラストラクチャ・プロバイダーとして台頭するTensorZeroは、FirstMark Capitalを筆頭に、Bessemer Venture Partners、Bedrock、DRW、Coalition、多数の業界エンジェルが参加し、730万ドルのシード資金を確保した。TensorZeroのGitHubリポジトリは、ここ数カ月でスター数が3,000

リプリットCEOが予測するソフトウェアの未来:「エージェントはずっと下」。

共同AI開発プラットフォームによって、企業は高価なSaaSサブスクリプションから脱却できるだろうか?Replitの先見的なCEOであるAmjad Masadは、この変革はすでに進行中であると考えており、"エージェントが再帰的にすべてを処理する "エコシステムについて説明している。VB Transformの基調講演でマサド氏は、ReplitのAIエージェントが、技術者でないユーザーに、わずか15分で

リプリットCEOが予測するソフトウェアの未来:「エージェントはずっと下」。

共同AI開発プラットフォームによって、企業は高価なSaaSサブスクリプションから脱却できるだろうか?Replitの先見的なCEOであるAmjad Masadは、この変革はすでに進行中であると考えており、"エージェントが再帰的にすべてを処理する "エコシステムについて説明している。VB Transformの基調講演でマサド氏は、ReplitのAIエージェントが、技術者でないユーザーに、わずか15分で

OpenAIがChatGPT Proをo3にアップグレード。

今週は、マイクロソフト、グーグル、Anthropicを含むハイテク大手から重要なAIの開発が目撃された。OpenAIは、コードネーム "io "と呼ばれる野心的なハードウェア構想のために、注目されたジョニー・アイブのデザイン会社を65億ドルで買収したことにとどまらず、独自の画期的なアップデートで発表の慌ただしさを締めくくった。同社は、ChatGPT内のOperator自律ウェブ・ナビゲーション・シ

OpenAIがChatGPT Proをo3にアップグレード。

今週は、マイクロソフト、グーグル、Anthropicを含むハイテク大手から重要なAIの開発が目撃された。OpenAIは、コードネーム "io "と呼ばれる野心的なハードウェア構想のために、注目されたジョニー・アイブのデザイン会社を65億ドルで買収したことにとどまらず、独自の画期的なアップデートで発表の慌ただしさを締めくくった。同社は、ChatGPT内のOperator自律ウェブ・ナビゲーション・シ

2025年8月26日 17:25:46 JST

2025年8月26日 17:25:46 JST

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

2025年8月8日 13:01:29 JST

2025年8月8日 13:01:29 JST

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0