Gaia apresenta um novo benchmark em busca por verdadeira inteligência além do Arc-Agi

A inteligência está em toda parte, mas avaliá-la com precisão é como tentar agarrar uma nuvem com as mãos. Usamos testes e benchmarks, como exames de admissão universitária, para ter uma ideia aproximada. A cada ano, estudantes se preparam intensamente para esses testes, às vezes alcançando uma pontuação perfeita de 100%. Mas essa pontuação perfeita significa que todos possuem o mesmo nível de inteligência ou que atingiram o auge de seu potencial mental? Claro que não. Esses benchmarks são apenas estimativas aproximadas, não indicadores precisos das verdadeiras habilidades de alguém.

No mundo da IA generativa, benchmarks como o MMLU (Massive Multitask Language Understanding) têm sido a referência para avaliar modelos por meio de questões de múltipla escolha em várias áreas acadêmicas. Embora permitam comparações fáceis, eles não capturam realmente o espectro completo das capacidades inteligentes.

Tomemos como exemplo Claude 3.5 Sonnet e GPT-4.5. Eles podem ter pontuações semelhantes no MMLU, sugerindo que estão no mesmo nível. Mas qualquer pessoa que tenha usado esses modelos sabe que seu desempenho no mundo real pode ser bastante diferente.

O que significa medir 'inteligência' em IA?

Com o recente lançamento do benchmark ARC-AGI, projetado para testar modelos em raciocínio geral e resolução criativa de problemas, houve uma nova onda de discussões sobre o que significa medir "inteligência" em IA. Nem todos tiveram a chance de explorar o ARC-AGI ainda, mas a indústria está agitada com esse e outros novos métodos de teste. Cada benchmark tem seu lugar, e o ARC-AGI é um passo na direção certa.

Outro desenvolvimento empolgante é o 'Humanity's Last Exam', um benchmark abrangente com 3.000 questões revisadas por pares, em várias etapas, abrangendo diferentes disciplinas. É um esforço ambicioso para levar os sistemas de IA ao raciocínio em nível de especialista. Resultados iniciais mostram progresso rápido, com a OpenAI supostamente alcançando uma pontuação de 26,6% apenas um mês após seu lançamento. Mas, como outros benchmarks, ele foca principalmente em conhecimento e raciocínio em um vácuo, não nas habilidades práticas de uso de ferramentas, vitais para aplicações de IA no mundo real.

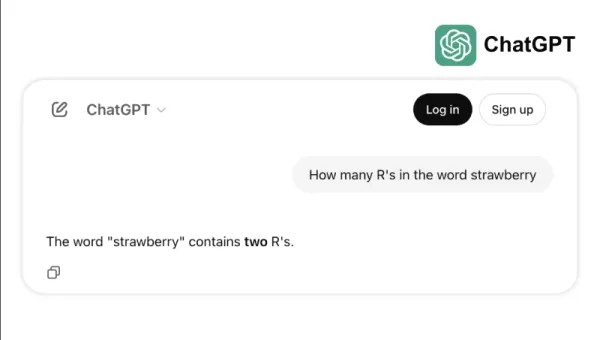

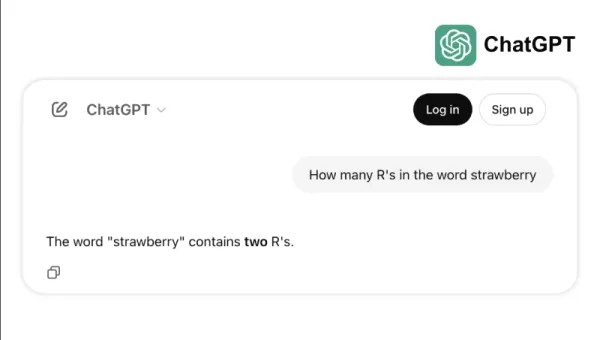

Por exemplo, alguns modelos de ponta têm dificuldade com tarefas simples, como contar os "r"s em "strawberry" ou comparar 3,8 com 3,1111. Esses erros, que até uma criança ou uma calculadora básica poderiam evitar, destacam a lacuna entre o sucesso em benchmarks e a confiabilidade no mundo real. É um lembrete de que inteligência não se trata apenas de passar em testes; é sobre navegar pela lógica cotidiana com facilidade.

O novo padrão para medir a capacidade da IA

À medida que os modelos de IA evoluíram, as limitações dos benchmarks tradicionais tornaram-se mais evidentes. Por exemplo, o GPT-4, quando equipado com ferramentas, pontua apenas cerca de 15% nas tarefas mais complexas do mundo real no benchmark GAIA, apesar de suas altas pontuações em testes de múltipla escolha.

Essa discrepância entre o desempenho em benchmarks e a capacidade prática é cada vez mais problemática à medida que os sistemas de IA passam de laboratórios de pesquisa para aplicações empresariais. Benchmarks tradicionais testam o quão bem um modelo pode recordar informações, mas muitas vezes ignoram aspectos-chave da inteligência, como a capacidade de coletar dados, executar código, analisar informações e criar soluções em vários domínios.

Entra em cena o GAIA, um novo benchmark que marca uma mudança significativa na avaliação de IA. Desenvolvido por meio de uma colaboração entre equipes da Meta-FAIR, Meta-GenAI, HuggingFace e AutoGPT, o GAIA inclui 466 questões cuidadosamente elaboradas em três níveis de dificuldade. Essas questões testam uma ampla gama de habilidades essenciais para aplicações de IA no mundo real, incluindo navegação na web, entendimento multimodal, execução de código, manipulação de arquivos e raciocínio complexo.

As questões de Nível 1 geralmente requerem cerca de 5 etapas e uma ferramenta para serem resolvidas por humanos. As questões de Nível 2 exigem de 5 a 10 etapas e várias ferramentas, enquanto as questões de Nível 3 podem exigir até 50 etapas e qualquer número de ferramentas. Essa estrutura reflete a complexidade dos problemas empresariais reais, onde as soluções muitas vezes envolvem múltiplas ações e ferramentas.

Ao focar na flexibilidade, em vez de apenas na complexidade, um modelo de IA alcançou uma taxa de precisão de 75% no GAIA, superando líderes da indústria como o Magnetic-1 da Microsoft (38%) e o Langfun Agent do Google (49%). Esse sucesso vem do uso de uma combinação de modelos especializados para entendimento audiovisual e raciocínio, com o Sonnet 3.5 da Anthropic como o modelo principal.

Essa mudança na avaliação de IA reflete uma tendência mais ampla na indústria: estamos nos afastando de aplicações SaaS autônomas em direção a agentes de IA que podem gerenciar várias ferramentas e fluxos de trabalho. À medida que as empresas dependem cada vez mais da IA para enfrentar tarefas complexas em várias etapas, benchmarks como o GAIA oferecem uma medida mais relevante de capacidade do que os testes tradicionais de múltipla escolha.

O futuro da avaliação de IA não está em testes de conhecimento isolados; está em avaliações abrangentes da capacidade de resolução de problemas. O GAIA estabelece um novo padrão para medir a capacidade da IA — um que se alinha melhor com os desafios e oportunidades do mundo real na implementação de IA.

Sri Ambati é o fundador e CEO da H2O.ai.

Artigo relacionado

TensorZero obtém financiamento inicial de US$ 7,3 milhões para simplificar o desenvolvimento de LLMs empresariais

A TensorZero, um provedor emergente de infraestrutura de código aberto para aplicativos de IA, garantiu US$ 7,3 milhões em financiamento inicial liderado pela FirstMark Capital, com a participação da

TensorZero obtém financiamento inicial de US$ 7,3 milhões para simplificar o desenvolvimento de LLMs empresariais

A TensorZero, um provedor emergente de infraestrutura de código aberto para aplicativos de IA, garantiu US$ 7,3 milhões em financiamento inicial liderado pela FirstMark Capital, com a participação da

O CEO da Replit prevê o futuro do software: "Agentes até o fim

As plataformas colaborativas de desenvolvimento de IA poderiam permitir que as empresas se libertassem das caras assinaturas de SaaS? O visionário CEO da Replit, Amjad Masad, acredita que essa transfo

O CEO da Replit prevê o futuro do software: "Agentes até o fim

As plataformas colaborativas de desenvolvimento de IA poderiam permitir que as empresas se libertassem das caras assinaturas de SaaS? O visionário CEO da Replit, Amjad Masad, acredita que essa transfo

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

Comentários (2)

0/200

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

Comentários (2)

0/200

![BillyAdams]() BillyAdams

BillyAdams

26 de Agosto de 2025 à46 09:25:46 WEST

26 de Agosto de 2025 à46 09:25:46 WEST

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

![GaryThomas]() GaryThomas

GaryThomas

8 de Agosto de 2025 à29 05:01:29 WEST

8 de Agosto de 2025 à29 05:01:29 WEST

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0

A inteligência está em toda parte, mas avaliá-la com precisão é como tentar agarrar uma nuvem com as mãos. Usamos testes e benchmarks, como exames de admissão universitária, para ter uma ideia aproximada. A cada ano, estudantes se preparam intensamente para esses testes, às vezes alcançando uma pontuação perfeita de 100%. Mas essa pontuação perfeita significa que todos possuem o mesmo nível de inteligência ou que atingiram o auge de seu potencial mental? Claro que não. Esses benchmarks são apenas estimativas aproximadas, não indicadores precisos das verdadeiras habilidades de alguém.

No mundo da IA generativa, benchmarks como o MMLU (Massive Multitask Language Understanding) têm sido a referência para avaliar modelos por meio de questões de múltipla escolha em várias áreas acadêmicas. Embora permitam comparações fáceis, eles não capturam realmente o espectro completo das capacidades inteligentes.

Tomemos como exemplo Claude 3.5 Sonnet e GPT-4.5. Eles podem ter pontuações semelhantes no MMLU, sugerindo que estão no mesmo nível. Mas qualquer pessoa que tenha usado esses modelos sabe que seu desempenho no mundo real pode ser bastante diferente.

O que significa medir 'inteligência' em IA?

Com o recente lançamento do benchmark ARC-AGI, projetado para testar modelos em raciocínio geral e resolução criativa de problemas, houve uma nova onda de discussões sobre o que significa medir "inteligência" em IA. Nem todos tiveram a chance de explorar o ARC-AGI ainda, mas a indústria está agitada com esse e outros novos métodos de teste. Cada benchmark tem seu lugar, e o ARC-AGI é um passo na direção certa.

Outro desenvolvimento empolgante é o 'Humanity's Last Exam', um benchmark abrangente com 3.000 questões revisadas por pares, em várias etapas, abrangendo diferentes disciplinas. É um esforço ambicioso para levar os sistemas de IA ao raciocínio em nível de especialista. Resultados iniciais mostram progresso rápido, com a OpenAI supostamente alcançando uma pontuação de 26,6% apenas um mês após seu lançamento. Mas, como outros benchmarks, ele foca principalmente em conhecimento e raciocínio em um vácuo, não nas habilidades práticas de uso de ferramentas, vitais para aplicações de IA no mundo real.

Por exemplo, alguns modelos de ponta têm dificuldade com tarefas simples, como contar os "r"s em "strawberry" ou comparar 3,8 com 3,1111. Esses erros, que até uma criança ou uma calculadora básica poderiam evitar, destacam a lacuna entre o sucesso em benchmarks e a confiabilidade no mundo real. É um lembrete de que inteligência não se trata apenas de passar em testes; é sobre navegar pela lógica cotidiana com facilidade.

O novo padrão para medir a capacidade da IA

À medida que os modelos de IA evoluíram, as limitações dos benchmarks tradicionais tornaram-se mais evidentes. Por exemplo, o GPT-4, quando equipado com ferramentas, pontua apenas cerca de 15% nas tarefas mais complexas do mundo real no benchmark GAIA, apesar de suas altas pontuações em testes de múltipla escolha.

Essa discrepância entre o desempenho em benchmarks e a capacidade prática é cada vez mais problemática à medida que os sistemas de IA passam de laboratórios de pesquisa para aplicações empresariais. Benchmarks tradicionais testam o quão bem um modelo pode recordar informações, mas muitas vezes ignoram aspectos-chave da inteligência, como a capacidade de coletar dados, executar código, analisar informações e criar soluções em vários domínios.

Entra em cena o GAIA, um novo benchmark que marca uma mudança significativa na avaliação de IA. Desenvolvido por meio de uma colaboração entre equipes da Meta-FAIR, Meta-GenAI, HuggingFace e AutoGPT, o GAIA inclui 466 questões cuidadosamente elaboradas em três níveis de dificuldade. Essas questões testam uma ampla gama de habilidades essenciais para aplicações de IA no mundo real, incluindo navegação na web, entendimento multimodal, execução de código, manipulação de arquivos e raciocínio complexo.

As questões de Nível 1 geralmente requerem cerca de 5 etapas e uma ferramenta para serem resolvidas por humanos. As questões de Nível 2 exigem de 5 a 10 etapas e várias ferramentas, enquanto as questões de Nível 3 podem exigir até 50 etapas e qualquer número de ferramentas. Essa estrutura reflete a complexidade dos problemas empresariais reais, onde as soluções muitas vezes envolvem múltiplas ações e ferramentas.

Ao focar na flexibilidade, em vez de apenas na complexidade, um modelo de IA alcançou uma taxa de precisão de 75% no GAIA, superando líderes da indústria como o Magnetic-1 da Microsoft (38%) e o Langfun Agent do Google (49%). Esse sucesso vem do uso de uma combinação de modelos especializados para entendimento audiovisual e raciocínio, com o Sonnet 3.5 da Anthropic como o modelo principal.

Essa mudança na avaliação de IA reflete uma tendência mais ampla na indústria: estamos nos afastando de aplicações SaaS autônomas em direção a agentes de IA que podem gerenciar várias ferramentas e fluxos de trabalho. À medida que as empresas dependem cada vez mais da IA para enfrentar tarefas complexas em várias etapas, benchmarks como o GAIA oferecem uma medida mais relevante de capacidade do que os testes tradicionais de múltipla escolha.

O futuro da avaliação de IA não está em testes de conhecimento isolados; está em avaliações abrangentes da capacidade de resolução de problemas. O GAIA estabelece um novo padrão para medir a capacidade da IA — um que se alinha melhor com os desafios e oportunidades do mundo real na implementação de IA.

Sri Ambati é o fundador e CEO da H2O.ai.

TensorZero obtém financiamento inicial de US$ 7,3 milhões para simplificar o desenvolvimento de LLMs empresariais

A TensorZero, um provedor emergente de infraestrutura de código aberto para aplicativos de IA, garantiu US$ 7,3 milhões em financiamento inicial liderado pela FirstMark Capital, com a participação da

TensorZero obtém financiamento inicial de US$ 7,3 milhões para simplificar o desenvolvimento de LLMs empresariais

A TensorZero, um provedor emergente de infraestrutura de código aberto para aplicativos de IA, garantiu US$ 7,3 milhões em financiamento inicial liderado pela FirstMark Capital, com a participação da

O CEO da Replit prevê o futuro do software: "Agentes até o fim

As plataformas colaborativas de desenvolvimento de IA poderiam permitir que as empresas se libertassem das caras assinaturas de SaaS? O visionário CEO da Replit, Amjad Masad, acredita que essa transfo

O CEO da Replit prevê o futuro do software: "Agentes até o fim

As plataformas colaborativas de desenvolvimento de IA poderiam permitir que as empresas se libertassem das caras assinaturas de SaaS? O visionário CEO da Replit, Amjad Masad, acredita que essa transfo

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

A OpenAI atualiza o ChatGPT Pro para o3, aumentando o valor da assinatura mensal de US$ 200

Esta semana testemunhou desenvolvimentos significativos de IA de gigantes da tecnologia, incluindo Microsoft, Google e Anthropic. A OpenAI conclui a enxurrada de anúncios com suas próprias atualizaçõe

26 de Agosto de 2025 à46 09:25:46 WEST

26 de Agosto de 2025 à46 09:25:46 WEST

This GAIA benchmark sounds intriguing! Makes me wonder if we’re finally getting closer to measuring true intelligence or just chasing fancier numbers. 🤔 What’s next, AI acing philosophy exams?

0

0

8 de Agosto de 2025 à29 05:01:29 WEST

8 de Agosto de 2025 à29 05:01:29 WEST

This GAIA benchmark sounds intriguing! 🤔 It’s like trying to measure a rainbow with a ruler—cool concept, but can it really capture true intelligence? I wonder how it compares to ARC-AGI in practical applications.

0

0