Application Ollama d'IA Locale Simplifie l'Utilisation sur MacOS

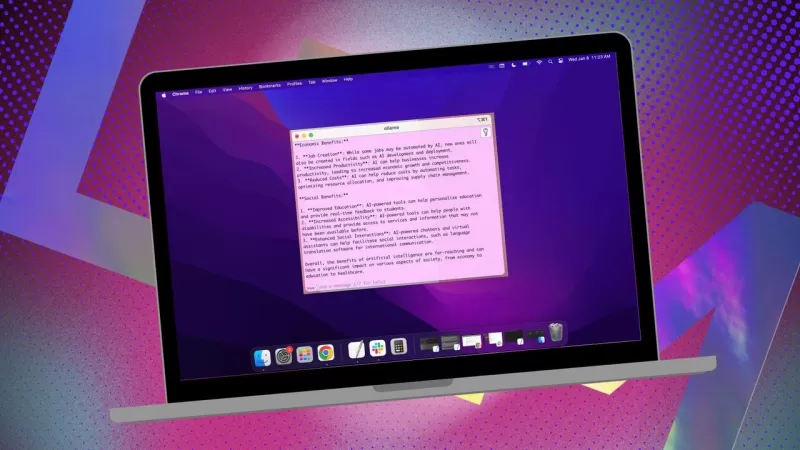

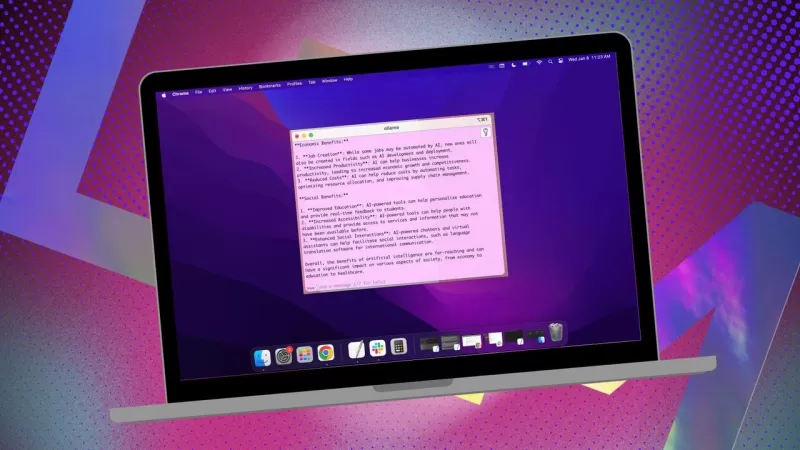

Si vous cherchez à garder vos données privées et à éviter de contribuer à des profils tiers ou à des ensembles d'entraînement, utiliser une IA installée localement pour vos recherches est une décision judicieuse. J'utilise l'open-source Ollama sur mon système Linux, amélioré par une extension de navigateur pratique pour une expérience plus fluide. Mais lorsque je passe à mon MacOS, je préfère une application gratuite et simple appelée Msty.

Également : Comment transformer Ollama d'un outil de terminal en une IA basée sur navigateur avec cette extension gratuite

Msty est polyvalent, vous permettant d'exploiter à la fois des modèles d'IA installés localement et en ligne. Personnellement, je privilégie l'option locale pour une confidentialité maximale. Ce qui distingue Msty des autres outils Ollama, c'est sa simplicité : pas besoin de conteneurs, de terminaux ou d'onglets de navigateur supplémentaires.

L'application est dotée de fonctionnalités qui la rendent facile à utiliser. Vous pouvez exécuter plusieurs requêtes simultanément avec des chats fractionnés, régénérer les réponses des modèles, cloner des chats et même ajouter plusieurs modèles. Il y a une invocation de données en temps réel (bien que spécifique au modèle), et vous pouvez créer des Knowledge Stacks pour entraîner votre modèle local avec des fichiers, dossiers, coffres Obsidian, notes, et plus encore. De plus, il y a une bibliothèque de prompts pour vous aider à tirer le meilleur parti de vos requêtes.

Msty est sans conteste l'un des meilleurs moyens d'interagir avec Ollama. Voici comment commencer :

Installation de Msty

Ce dont vous aurez besoin : Juste un appareil MacOS et Ollama installé et opérationnel. Si vous n'avez pas encore configuré Ollama, suivez les étapes ici. N'oubliez pas de télécharger également un modèle local.

Télécharger l'installateur

Rendez-vous sur le site web de Msty, cliquez sur le menu déroulant Télécharger Msty, choisissez Mac, puis sélectionnez soit Apple Silicon soit Intel en fonction de votre appareil.

Installer Msty

Une fois le téléchargement terminé, double-cliquez sur le fichier et faites glisser l'icône Msty dans le dossier Applications lorsque cela vous est demandé.

Utilisation de Msty

Ouvrir Msty

Lancez Msty depuis Launchpad sur votre MacOS.

Connecter votre modèle Ollama local

Lorsque vous ouvrez Msty pour la première fois, cliquez sur Configurer l'IA locale. Il téléchargera les composants nécessaires et configurera tout pour vous, y compris le téléchargement d'un modèle local autre qu'Ollama.

Pour lier Msty à Ollama, accédez à Modèles IA locaux dans la barre latérale et cliquez sur le bouton de téléchargement à côté de Llama 3.2. Une fois téléchargé, sélectionnez-le dans le menu déroulant des modèles. Pour d'autres modèles, vous aurez besoin d'une clé API de votre compte pour ce modèle spécifique. Maintenant, Msty devrait être connecté à votre LLM Ollama local.

Je préfère rester avec le modèle local Ollama pour mes requêtes.

Instructions du modèle

L'une de mes fonctionnalités préférées dans Msty est la possibilité de personnaliser les instructions du modèle. Que vous ayez besoin que l'IA agisse comme un médecin, un écrivain, un comptable, un anthropologue extraterrestre ou un conseiller artistique, Msty vous couvre.

Pour ajuster les instructions du modèle, cliquez sur Modifier les instructions du modèle au centre de l'application, puis appuyez sur le petit bouton de chat à gauche de l'icône de balai. Dans le menu contextuel, choisissez les instructions souhaitées et cliquez sur "Appliquer à ce chat" avant de lancer votre première requête.

Il y a de nombreuses instructions de modèle parmi lesquelles choisir, vous aidant à affiner vos requêtes pour des besoins spécifiques.

Ce guide devrait vous aider à démarrer rapidement avec Msty. Commencez par les bases et, à mesure que vous vous familiarisez avec l'application, explorez ses fonctionnalités plus avancées. C'est un outil puissant qui peut vraiment améliorer votre expérience d'IA locale sur MacOS.

Article connexe

Master Emerald Kaizo Nuzlocke : Guide ultime de survie et de stratégie

Emerald Kaizo est l'un des plus formidables hacks de ROM Pokémon jamais conçus. Bien que tenter une course Nuzlocke augmente exponentiellement le défi, la victoire reste possible grâce à une planifica

Master Emerald Kaizo Nuzlocke : Guide ultime de survie et de stratégie

Emerald Kaizo est l'un des plus formidables hacks de ROM Pokémon jamais conçus. Bien que tenter une course Nuzlocke augmente exponentiellement le défi, la victoire reste possible grâce à une planifica

Lettres de motivation alimentées par l'IA : Guide d'experts pour les soumissions à des revues

Dans l'environnement compétitif de l'édition universitaire d'aujourd'hui, l'élaboration d'une lettre de motivation efficace peut faire la différence cruciale dans l'acceptation de votre manuscrit. Déc

Lettres de motivation alimentées par l'IA : Guide d'experts pour les soumissions à des revues

Dans l'environnement compétitif de l'édition universitaire d'aujourd'hui, l'élaboration d'une lettre de motivation efficace peut faire la différence cruciale dans l'acceptation de votre manuscrit. Déc

Les États-Unis vont sanctionner des fonctionnaires étrangers en raison de la réglementation sur les médias sociaux

Les États-Unis prennent position contre les réglementations mondiales en matière de contenu numériqueCette semaine, le département d'État américain a émis un blâme diplomatique sévère à l'encontre d

commentaires (2)

0/200

Les États-Unis vont sanctionner des fonctionnaires étrangers en raison de la réglementation sur les médias sociaux

Les États-Unis prennent position contre les réglementations mondiales en matière de contenu numériqueCette semaine, le département d'État américain a émis un blâme diplomatique sévère à l'encontre d

commentaires (2)

0/200

![PaulHill]() PaulHill

PaulHill

12 août 2025 08:50:10 UTC+02:00

12 août 2025 08:50:10 UTC+02:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

28 juillet 2025 03:20:21 UTC+02:00

28 juillet 2025 03:20:21 UTC+02:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

Si vous cherchez à garder vos données privées et à éviter de contribuer à des profils tiers ou à des ensembles d'entraînement, utiliser une IA installée localement pour vos recherches est une décision judicieuse. J'utilise l'open-source Ollama sur mon système Linux, amélioré par une extension de navigateur pratique pour une expérience plus fluide. Mais lorsque je passe à mon MacOS, je préfère une application gratuite et simple appelée Msty.

Également : Comment transformer Ollama d'un outil de terminal en une IA basée sur navigateur avec cette extension gratuite

Msty est polyvalent, vous permettant d'exploiter à la fois des modèles d'IA installés localement et en ligne. Personnellement, je privilégie l'option locale pour une confidentialité maximale. Ce qui distingue Msty des autres outils Ollama, c'est sa simplicité : pas besoin de conteneurs, de terminaux ou d'onglets de navigateur supplémentaires.

L'application est dotée de fonctionnalités qui la rendent facile à utiliser. Vous pouvez exécuter plusieurs requêtes simultanément avec des chats fractionnés, régénérer les réponses des modèles, cloner des chats et même ajouter plusieurs modèles. Il y a une invocation de données en temps réel (bien que spécifique au modèle), et vous pouvez créer des Knowledge Stacks pour entraîner votre modèle local avec des fichiers, dossiers, coffres Obsidian, notes, et plus encore. De plus, il y a une bibliothèque de prompts pour vous aider à tirer le meilleur parti de vos requêtes.

Msty est sans conteste l'un des meilleurs moyens d'interagir avec Ollama. Voici comment commencer :

Installation de Msty

Ce dont vous aurez besoin : Juste un appareil MacOS et Ollama installé et opérationnel. Si vous n'avez pas encore configuré Ollama, suivez les étapes ici. N'oubliez pas de télécharger également un modèle local.

Télécharger l'installateur

Rendez-vous sur le site web de Msty, cliquez sur le menu déroulant Télécharger Msty, choisissez Mac, puis sélectionnez soit Apple Silicon soit Intel en fonction de votre appareil.

Installer Msty

Une fois le téléchargement terminé, double-cliquez sur le fichier et faites glisser l'icône Msty dans le dossier Applications lorsque cela vous est demandé.

Utilisation de Msty

Ouvrir Msty

Lancez Msty depuis Launchpad sur votre MacOS.

Connecter votre modèle Ollama local

Lorsque vous ouvrez Msty pour la première fois, cliquez sur Configurer l'IA locale. Il téléchargera les composants nécessaires et configurera tout pour vous, y compris le téléchargement d'un modèle local autre qu'Ollama.

Pour lier Msty à Ollama, accédez à Modèles IA locaux dans la barre latérale et cliquez sur le bouton de téléchargement à côté de Llama 3.2. Une fois téléchargé, sélectionnez-le dans le menu déroulant des modèles. Pour d'autres modèles, vous aurez besoin d'une clé API de votre compte pour ce modèle spécifique. Maintenant, Msty devrait être connecté à votre LLM Ollama local.

Je préfère rester avec le modèle local Ollama pour mes requêtes.

Instructions du modèle

L'une de mes fonctionnalités préférées dans Msty est la possibilité de personnaliser les instructions du modèle. Que vous ayez besoin que l'IA agisse comme un médecin, un écrivain, un comptable, un anthropologue extraterrestre ou un conseiller artistique, Msty vous couvre.

Pour ajuster les instructions du modèle, cliquez sur Modifier les instructions du modèle au centre de l'application, puis appuyez sur le petit bouton de chat à gauche de l'icône de balai. Dans le menu contextuel, choisissez les instructions souhaitées et cliquez sur "Appliquer à ce chat" avant de lancer votre première requête.

Il y a de nombreuses instructions de modèle parmi lesquelles choisir, vous aidant à affiner vos requêtes pour des besoins spécifiques.

Ce guide devrait vous aider à démarrer rapidement avec Msty. Commencez par les bases et, à mesure que vous vous familiarisez avec l'application, explorez ses fonctionnalités plus avancées. C'est un outil puissant qui peut vraiment améliorer votre expérience d'IA locale sur MacOS.

Master Emerald Kaizo Nuzlocke : Guide ultime de survie et de stratégie

Emerald Kaizo est l'un des plus formidables hacks de ROM Pokémon jamais conçus. Bien que tenter une course Nuzlocke augmente exponentiellement le défi, la victoire reste possible grâce à une planifica

Master Emerald Kaizo Nuzlocke : Guide ultime de survie et de stratégie

Emerald Kaizo est l'un des plus formidables hacks de ROM Pokémon jamais conçus. Bien que tenter une course Nuzlocke augmente exponentiellement le défi, la victoire reste possible grâce à une planifica

Lettres de motivation alimentées par l'IA : Guide d'experts pour les soumissions à des revues

Dans l'environnement compétitif de l'édition universitaire d'aujourd'hui, l'élaboration d'une lettre de motivation efficace peut faire la différence cruciale dans l'acceptation de votre manuscrit. Déc

Lettres de motivation alimentées par l'IA : Guide d'experts pour les soumissions à des revues

Dans l'environnement compétitif de l'édition universitaire d'aujourd'hui, l'élaboration d'une lettre de motivation efficace peut faire la différence cruciale dans l'acceptation de votre manuscrit. Déc

Les États-Unis vont sanctionner des fonctionnaires étrangers en raison de la réglementation sur les médias sociaux

Les États-Unis prennent position contre les réglementations mondiales en matière de contenu numériqueCette semaine, le département d'État américain a émis un blâme diplomatique sévère à l'encontre d

Les États-Unis vont sanctionner des fonctionnaires étrangers en raison de la réglementation sur les médias sociaux

Les États-Unis prennent position contre les réglementations mondiales en matière de contenu numériqueCette semaine, le département d'État américain a émis un blâme diplomatique sévère à l'encontre d

12 août 2025 08:50:10 UTC+02:00

12 août 2025 08:50:10 UTC+02:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

28 juillet 2025 03:20:21 UTC+02:00

28 juillet 2025 03:20:21 UTC+02:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0