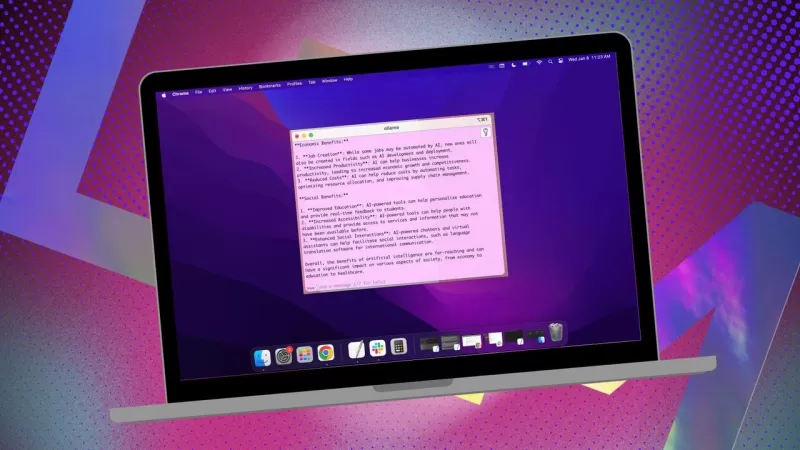

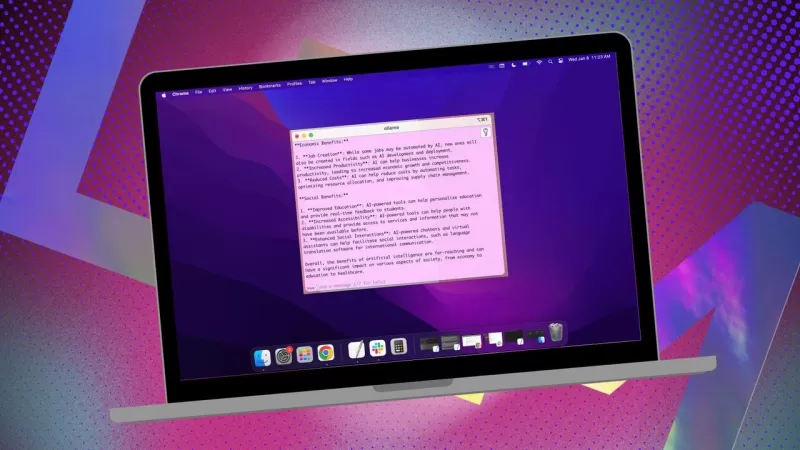

Ollama 로컬 AI 앱, MacOS 사용 간소화

데이터를 비공개로 유지하고 제3자 프로필이나 학습 데이터 세트에 제공하지 않으려면, 로컬에 설치된 AI를 연구에 사용하는 것이 현명한 선택입니다. 저는 리눅스 시스템에서 오픈소스 Ollama를 사용하고 있으며, 더 원활한 경험을 위해 편리한 브라우저 확장 프로그램을 추가했습니다. 하지만 MacOS로 전환할 때는 간단하고 무료인 Msty 앱을 선택합니다.

또한: 터미널 도구인 Ollama를 브라우저 기반 AI로 전환하는 방법(무료 확장 프로그램 사용)

Msty는 다재다능하여 로컬에 설치된 AI 모델과 온라인 AI 모델을 모두 활용할 수 있습니다. 개인적으로 저는 최대한의 프라이버시를 위해 로컬 옵션을 고수합니다. Msty를 다른 Ollama 도구와 차별화하는 점은 단순함입니다—컨테이너, 터미널, 추가 브라우저 탭이 필요 없습니다.

이 앱은 사용하기 편리한 다양한 기능을 갖추고 있습니다. 분할 채팅으로 여러 쿼리를 동시에 실행하고, 모델 응답을 재생성하거나, 채팅을 복제하고, 여러 모델을 추가할 수도 있습니다. 실시간 데이터 호출 기능(모델에 따라 다름)도 있으며, 파일, 폴더, Obsidian 저장소, 노트 등을 사용해 로컬 모델을 학습시키기 위한 Knowledge Stacks를 만들 수 있습니다. 또한 쿼리를 최대한 활용할 수 있도록 프롬프트 라이브러리도 제공됩니다.

Msty는 단연코 Ollama와 상호작용하는 가장 좋은 방법 중 하나입니다. 시작하는 방법은 다음과 같습니다:

Msty 설치

필요한 것: MacOS 장치와 설치 및 실행 중인 Ollama만 있으면 됩니다. 아직 Ollama를 설정하지 않았다면, 여기에서 단계를 따르세요. 로컬 모델도 다운로드하는 것을 잊지 마세요.

설치 프로그램 다운로드

Msty 웹사이트로 이동하여 Download Msty 드롭다운을 클릭하고, Mac을 선택한 뒤 장치에 따라 Apple Silicon 또는 Intel을 선택하세요.

Msty 설치

다운로드가 완료되면 파일을 더블 클릭하고, 안내에 따라 Msty 아이콘을 응용 프로그램 폴더로 드래그하세요.

Msty 사용

Msty 열기

MacOS의 Launchpad에서 Msty를 실행하세요.

로컬 Ollama 모델 연결

Msty를 처음 열 때 Setup Local AI를 클릭하세요. 필요한 구성 요소를 다운로드하고 Ollama 이외의 로컬 모델을 포함해 모든 것을 자동으로 구성해줍니다.

Msty를 Ollama와 연결하려면 사이드바에서 Local AI Models로 이동하여 Llama 3.2 옆의 다운로드 버튼을 클릭하세요. 다운로드가 완료되면 모델 드롭다운에서 이를 선택하세요. 다른 모델의 경우, 해당 모델에 대한 계정의 API 키가 필요합니다. 이제 Msty가 로컬 Ollama LLM에 연결되었을 것입니다.

저는 쿼리에 Ollama 로컬 모델을 사용하는 것을 선호합니다.

모델 지침

Msty에서 제가 가장 좋아하는 기능 중 하나는 모델 지침을 사용자 지정할 수 있다는 점입니다. AI가 의사, 작가, 회계사, 외계인 인류학자, 또는 예술 고문 역할을 해야 할 때, Msty는 이를 지원합니다.

모델 지침을 수정하려면 앱 중앙의 Edit Model Instructions를 클릭한 뒤, 빗자루 아이콘 왼쪽의 작은 채팅 버튼을 누르세요. 팝업 메뉴에서 원하는 지침을 선택하고 첫 쿼리를 실행하기 전에 "Apply to this chat"을 클릭하세요.

다양한 모델 지침이 제공되어 특정 요구에 맞게 쿼리를 정교화할 수 있습니다.

이 가이드를 통해 Msty를 빠르게 시작하고 실행할 수 있을 것입니다. 기본부터 시작하여 앱에 익숙해지면 더 고급 기능을 탐색해보세요. 이는 MacOS에서 로컬 AI 경험을 크게 향상시킬 수 있는 강력한 도구입니다.

관련 기사

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

토파즈 디노이즈 AI: 2025년 최고의 노이즈 감소 도구 - 전체 가이드

경쟁이 치열한 디지털 사진의 세계에서 이미지 선명도는 여전히 가장 중요한 요소입니다. 모든 수준의 사진가들은 뛰어난 사진을 손상시키는 디지털 노이즈와 싸우고 있습니다. 토파즈 디노이즈 AI는 인공 지능을 활용하여 중요한 디테일을 보존하면서 노이즈 감소 문제를 해결하는 최첨단 솔루션으로 떠오르고 있습니다. 이 심층 리뷰에서는 이 혁신적인 소프트웨어가 2025

토파즈 디노이즈 AI: 2025년 최고의 노이즈 감소 도구 - 전체 가이드

경쟁이 치열한 디지털 사진의 세계에서 이미지 선명도는 여전히 가장 중요한 요소입니다. 모든 수준의 사진가들은 뛰어난 사진을 손상시키는 디지털 노이즈와 싸우고 있습니다. 토파즈 디노이즈 AI는 인공 지능을 활용하여 중요한 디테일을 보존하면서 노이즈 감소 문제를 해결하는 최첨단 솔루션으로 떠오르고 있습니다. 이 심층 리뷰에서는 이 혁신적인 소프트웨어가 2025

마스터 에메랄드 카이조 누즐로크: 궁극의 생존 & 전략 가이드

에메랄드 카이조는 지금까지 고안된 가장 강력한 포켓몬 ROM 해킹 중 하나입니다. 누즈락을 시도하면 난이도가 기하급수적으로 증가하지만, 세심한 계획과 전략적인 실행을 통해 승리를 거둘 수 있습니다. 이 최종 가이드는 하드코어 누즐로크 규칙에 따라 에메랄드 카이조를 정복하기 위한 필수 도구, 실전 테스트를 거친 전술, 심층적인 AI 분석을 제공합니다. 포켓몬

의견 (2)

0/200

마스터 에메랄드 카이조 누즐로크: 궁극의 생존 & 전략 가이드

에메랄드 카이조는 지금까지 고안된 가장 강력한 포켓몬 ROM 해킹 중 하나입니다. 누즈락을 시도하면 난이도가 기하급수적으로 증가하지만, 세심한 계획과 전략적인 실행을 통해 승리를 거둘 수 있습니다. 이 최종 가이드는 하드코어 누즐로크 규칙에 따라 에메랄드 카이조를 정복하기 위한 필수 도구, 실전 테스트를 거친 전술, 심층적인 AI 분석을 제공합니다. 포켓몬

의견 (2)

0/200

![PaulHill]() PaulHill

PaulHill

2025년 8월 12일 오후 3시 50분 10초 GMT+09:00

2025년 8월 12일 오후 3시 50분 10초 GMT+09:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

데이터를 비공개로 유지하고 제3자 프로필이나 학습 데이터 세트에 제공하지 않으려면, 로컬에 설치된 AI를 연구에 사용하는 것이 현명한 선택입니다. 저는 리눅스 시스템에서 오픈소스 Ollama를 사용하고 있으며, 더 원활한 경험을 위해 편리한 브라우저 확장 프로그램을 추가했습니다. 하지만 MacOS로 전환할 때는 간단하고 무료인 Msty 앱을 선택합니다.

또한: 터미널 도구인 Ollama를 브라우저 기반 AI로 전환하는 방법(무료 확장 프로그램 사용)

Msty는 다재다능하여 로컬에 설치된 AI 모델과 온라인 AI 모델을 모두 활용할 수 있습니다. 개인적으로 저는 최대한의 프라이버시를 위해 로컬 옵션을 고수합니다. Msty를 다른 Ollama 도구와 차별화하는 점은 단순함입니다—컨테이너, 터미널, 추가 브라우저 탭이 필요 없습니다.

이 앱은 사용하기 편리한 다양한 기능을 갖추고 있습니다. 분할 채팅으로 여러 쿼리를 동시에 실행하고, 모델 응답을 재생성하거나, 채팅을 복제하고, 여러 모델을 추가할 수도 있습니다. 실시간 데이터 호출 기능(모델에 따라 다름)도 있으며, 파일, 폴더, Obsidian 저장소, 노트 등을 사용해 로컬 모델을 학습시키기 위한 Knowledge Stacks를 만들 수 있습니다. 또한 쿼리를 최대한 활용할 수 있도록 프롬프트 라이브러리도 제공됩니다.

Msty는 단연코 Ollama와 상호작용하는 가장 좋은 방법 중 하나입니다. 시작하는 방법은 다음과 같습니다:

Msty 설치

필요한 것: MacOS 장치와 설치 및 실행 중인 Ollama만 있으면 됩니다. 아직 Ollama를 설정하지 않았다면, 여기에서 단계를 따르세요. 로컬 모델도 다운로드하는 것을 잊지 마세요.

설치 프로그램 다운로드

Msty 웹사이트로 이동하여 Download Msty 드롭다운을 클릭하고, Mac을 선택한 뒤 장치에 따라 Apple Silicon 또는 Intel을 선택하세요.

Msty 설치

다운로드가 완료되면 파일을 더블 클릭하고, 안내에 따라 Msty 아이콘을 응용 프로그램 폴더로 드래그하세요.

Msty 사용

Msty 열기

MacOS의 Launchpad에서 Msty를 실행하세요.

로컬 Ollama 모델 연결

Msty를 처음 열 때 Setup Local AI를 클릭하세요. 필요한 구성 요소를 다운로드하고 Ollama 이외의 로컬 모델을 포함해 모든 것을 자동으로 구성해줍니다.

Msty를 Ollama와 연결하려면 사이드바에서 Local AI Models로 이동하여 Llama 3.2 옆의 다운로드 버튼을 클릭하세요. 다운로드가 완료되면 모델 드롭다운에서 이를 선택하세요. 다른 모델의 경우, 해당 모델에 대한 계정의 API 키가 필요합니다. 이제 Msty가 로컬 Ollama LLM에 연결되었을 것입니다.

저는 쿼리에 Ollama 로컬 모델을 사용하는 것을 선호합니다.

모델 지침

Msty에서 제가 가장 좋아하는 기능 중 하나는 모델 지침을 사용자 지정할 수 있다는 점입니다. AI가 의사, 작가, 회계사, 외계인 인류학자, 또는 예술 고문 역할을 해야 할 때, Msty는 이를 지원합니다.

모델 지침을 수정하려면 앱 중앙의 Edit Model Instructions를 클릭한 뒤, 빗자루 아이콘 왼쪽의 작은 채팅 버튼을 누르세요. 팝업 메뉴에서 원하는 지침을 선택하고 첫 쿼리를 실행하기 전에 "Apply to this chat"을 클릭하세요.

다양한 모델 지침이 제공되어 특정 요구에 맞게 쿼리를 정교화할 수 있습니다.

이 가이드를 통해 Msty를 빠르게 시작하고 실행할 수 있을 것입니다. 기본부터 시작하여 앱에 익숙해지면 더 고급 기능을 탐색해보세요. 이는 MacOS에서 로컬 AI 경험을 크게 향상시킬 수 있는 강력한 도구입니다.

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

토파즈 디노이즈 AI: 2025년 최고의 노이즈 감소 도구 - 전체 가이드

경쟁이 치열한 디지털 사진의 세계에서 이미지 선명도는 여전히 가장 중요한 요소입니다. 모든 수준의 사진가들은 뛰어난 사진을 손상시키는 디지털 노이즈와 싸우고 있습니다. 토파즈 디노이즈 AI는 인공 지능을 활용하여 중요한 디테일을 보존하면서 노이즈 감소 문제를 해결하는 최첨단 솔루션으로 떠오르고 있습니다. 이 심층 리뷰에서는 이 혁신적인 소프트웨어가 2025

토파즈 디노이즈 AI: 2025년 최고의 노이즈 감소 도구 - 전체 가이드

경쟁이 치열한 디지털 사진의 세계에서 이미지 선명도는 여전히 가장 중요한 요소입니다. 모든 수준의 사진가들은 뛰어난 사진을 손상시키는 디지털 노이즈와 싸우고 있습니다. 토파즈 디노이즈 AI는 인공 지능을 활용하여 중요한 디테일을 보존하면서 노이즈 감소 문제를 해결하는 최첨단 솔루션으로 떠오르고 있습니다. 이 심층 리뷰에서는 이 혁신적인 소프트웨어가 2025

마스터 에메랄드 카이조 누즐로크: 궁극의 생존 & 전략 가이드

에메랄드 카이조는 지금까지 고안된 가장 강력한 포켓몬 ROM 해킹 중 하나입니다. 누즈락을 시도하면 난이도가 기하급수적으로 증가하지만, 세심한 계획과 전략적인 실행을 통해 승리를 거둘 수 있습니다. 이 최종 가이드는 하드코어 누즐로크 규칙에 따라 에메랄드 카이조를 정복하기 위한 필수 도구, 실전 테스트를 거친 전술, 심층적인 AI 분석을 제공합니다. 포켓몬

마스터 에메랄드 카이조 누즐로크: 궁극의 생존 & 전략 가이드

에메랄드 카이조는 지금까지 고안된 가장 강력한 포켓몬 ROM 해킹 중 하나입니다. 누즈락을 시도하면 난이도가 기하급수적으로 증가하지만, 세심한 계획과 전략적인 실행을 통해 승리를 거둘 수 있습니다. 이 최종 가이드는 하드코어 누즐로크 규칙에 따라 에메랄드 카이조를 정복하기 위한 필수 도구, 실전 테스트를 거친 전술, 심층적인 AI 분석을 제공합니다. 포켓몬

2025년 8월 12일 오후 3시 50분 10초 GMT+09:00

2025년 8월 12일 오후 3시 50분 10초 GMT+09:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

2025년 7월 28일 오전 10시 20분 21초 GMT+09:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0