OllamaローカルAIアプリ、MacOS使用を簡素化

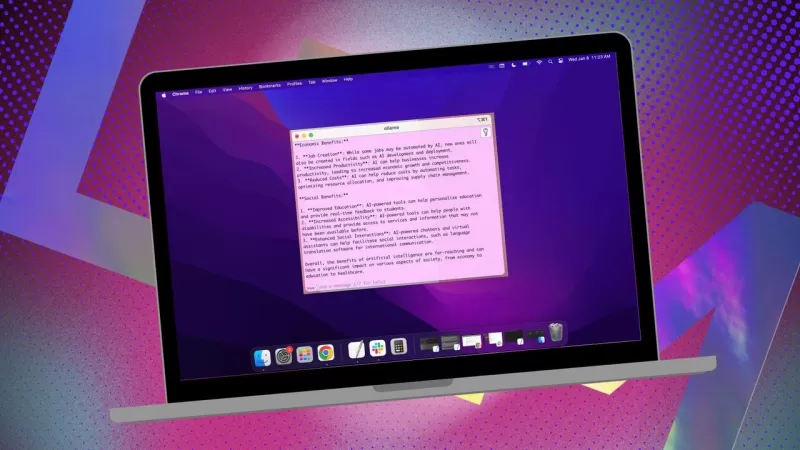

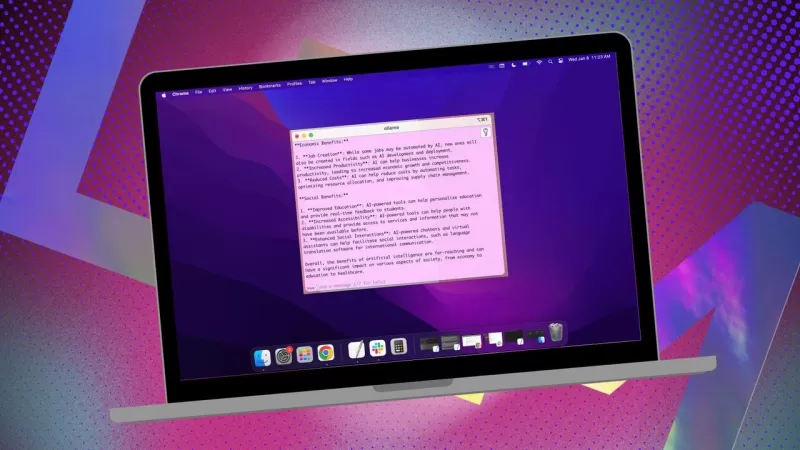

データをプライベートに保ち、第三者のプロフィールやトレーニングセットへの提供を避けたい場合、ローカルにインストールされたAIを研究に使用するのは賢い選択です。私はLinuxシステムでオープンソースのOllamaを使用しており、ブラウザ拡張機能で使い勝手を向上させています。しかし、MacOSに切り替えるときは、シンプルで無料のアプリMstyを選びます。

また:OllamaをターミナルツールからブラウザベースのAIに変える無料拡張機能の使い方

Mstyは多機能で、ローカルにインストールされたAIモデルとオンラインモデルの両方を利用できます。私はプライバシーを最大限に保つため、ローカルオプションを主に使用します。Mstyが他のOllamaツールと異なる点は、そのシンプルさにあります。コンテナやターミナル、追加のブラウザタブは不要です。

このアプリは使いやすい機能が満載です。分割チャットで複数のクエリを同時に実行したり、モデルの応答を再生成したり、チャットを複製したり、複数のモデルを追加したりできます。リアルタイムデータ呼び出し(モデル固有)や、ファイル、フォルダ、Obsidianボルト、ノートなどでローカルモデルをトレーニングするKnowledge Stacksの作成も可能です。さらに、クエリを最大限に活用するためのプロンプトライブラリもあります。

MstyはOllamaと対話する最良の方法の一つです。以下は始め方です:

Mstyのインストール

必要なもの: MacOSデバイスと、インストール済みで動作中のOllama。Ollamaをまだ設定していない場合、こちらの手順に従ってください。ローカルモデルのダウンロードもお忘れなく。

インストーラーのダウンロード

Mstyのウェブサイトにアクセスし、Download MstyドロップダウンをクリックしてMacを選択し、デバイスの種類に応じてApple SiliconまたはIntelを選びます。

Mstyのインストール

ダウンロードが完了したら、ファイルをダブルクリックし、指示に従ってMstyアイコンをApplicationsフォルダにドラッグします。

Mstyの使用

Mstyを開く

MacOSのLaunchpadからMstyを起動します。

ローカルのOllamaモデルを接続

Mstyを初めて開いたとき、Setup Local AIをクリックします。必要なコンポーネントがダウンロードされ、Ollama以外のローカルモデルも含めてすべてが設定されます。

MstyをOllamaとリンクするには、サイドバーのLocal AI Modelsに移動し、Llama 3.2の横にあるダウンロードボタンをクリックします。ダウンロード後、モデルドロップダウンから選択します。他のモデルを使用する場合、そのモデル専用のアカウントからAPIキーが必要です。これでMstyがローカルのOllama LLMに接続されるはずです。

私はクエリにOllamaのローカルモデルを使うことを好みます。

モデル指示

Mstyの好きな機能の一つは、モデル指示をカスタマイズできることです。AIに医者、ライター、会計士、宇宙人類学者、アートアドバイザーなどとして動作させたい場合、Mstyが対応します。

モデル指示を調整するには、アプリ中央のEdit Model Instructionsをクリックし、ほうきアイコンの左にある小さなチャットボタンを押します。ポップアップメニューから必要な指示を選び、最初のクエリを実行する前に「Apply to this chat」をクリックします。

特定のニーズに合わせてクエリを調整できるモデル指示が豊富に用意されています。

このガイドでMstyをすぐに使い始められるはずです。基本から始めて、アプリに慣れたら高度な機能を探索してください。MacOSでのローカルAI体験を大きく向上させる強力なツールです。

関連記事

教育用インフォグラフィックの作成に最適なAIツール - デザインのヒントとテクニック

デジタル化が進む今日の教育現場において、インフォグラフィックは、複雑な情報を視覚的に魅力的で理解しやすい形式に変換する、革新的なコミュニケーションメディアとして登場しました。AIテクノロジーは、教育者がこのような視覚的な学習教材を作成する方法に革命をもたらし、制作時間を劇的に短縮しながら、プロ級のデザインを誰でも利用できるようにしています。この調査では、合理化されたワークフロー、クリエイティブな自

教育用インフォグラフィックの作成に最適なAIツール - デザインのヒントとテクニック

デジタル化が進む今日の教育現場において、インフォグラフィックは、複雑な情報を視覚的に魅力的で理解しやすい形式に変換する、革新的なコミュニケーションメディアとして登場しました。AIテクノロジーは、教育者がこのような視覚的な学習教材を作成する方法に革命をもたらし、制作時間を劇的に短縮しながら、プロ級のデザインを誰でも利用できるようにしています。この調査では、合理化されたワークフロー、クリエイティブな自

Topaz DeNoise AI:2025年のベストノイズリダクションツール-完全ガイド

競争の激しいデジタル写真の世界では、画像の鮮明さが最も重要です。あらゆるレベルのフォトグラファーが、デジタルノイズに悩まされています。Topaz DeNoise AIは、人工知能を活用し、重要なディテールを維持しながらノイズ除去に取り組む最先端のソリューションとして登場しました。この詳細なレビューでは、この革新的なソフトウェアが2025年の写真ワークフローをどのように変えることができるのか、その主

Topaz DeNoise AI:2025年のベストノイズリダクションツール-完全ガイド

競争の激しいデジタル写真の世界では、画像の鮮明さが最も重要です。あらゆるレベルのフォトグラファーが、デジタルノイズに悩まされています。Topaz DeNoise AIは、人工知能を活用し、重要なディテールを維持しながらノイズ除去に取り組む最先端のソリューションとして登場しました。この詳細なレビューでは、この革新的なソフトウェアが2025年の写真ワークフローをどのように変えることができるのか、その主

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

コメント (2)

0/200

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

コメント (2)

0/200

![PaulHill]() PaulHill

PaulHill

2025年8月12日 15:50:10 JST

2025年8月12日 15:50:10 JST

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

2025年7月28日 10:20:21 JST

2025年7月28日 10:20:21 JST

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

データをプライベートに保ち、第三者のプロフィールやトレーニングセットへの提供を避けたい場合、ローカルにインストールされたAIを研究に使用するのは賢い選択です。私はLinuxシステムでオープンソースのOllamaを使用しており、ブラウザ拡張機能で使い勝手を向上させています。しかし、MacOSに切り替えるときは、シンプルで無料のアプリMstyを選びます。

また:OllamaをターミナルツールからブラウザベースのAIに変える無料拡張機能の使い方

Mstyは多機能で、ローカルにインストールされたAIモデルとオンラインモデルの両方を利用できます。私はプライバシーを最大限に保つため、ローカルオプションを主に使用します。Mstyが他のOllamaツールと異なる点は、そのシンプルさにあります。コンテナやターミナル、追加のブラウザタブは不要です。

このアプリは使いやすい機能が満載です。分割チャットで複数のクエリを同時に実行したり、モデルの応答を再生成したり、チャットを複製したり、複数のモデルを追加したりできます。リアルタイムデータ呼び出し(モデル固有)や、ファイル、フォルダ、Obsidianボルト、ノートなどでローカルモデルをトレーニングするKnowledge Stacksの作成も可能です。さらに、クエリを最大限に活用するためのプロンプトライブラリもあります。

MstyはOllamaと対話する最良の方法の一つです。以下は始め方です:

Mstyのインストール

必要なもの: MacOSデバイスと、インストール済みで動作中のOllama。Ollamaをまだ設定していない場合、こちらの手順に従ってください。ローカルモデルのダウンロードもお忘れなく。

インストーラーのダウンロード

Mstyのウェブサイトにアクセスし、Download MstyドロップダウンをクリックしてMacを選択し、デバイスの種類に応じてApple SiliconまたはIntelを選びます。

Mstyのインストール

ダウンロードが完了したら、ファイルをダブルクリックし、指示に従ってMstyアイコンをApplicationsフォルダにドラッグします。

Mstyの使用

Mstyを開く

MacOSのLaunchpadからMstyを起動します。

ローカルのOllamaモデルを接続

Mstyを初めて開いたとき、Setup Local AIをクリックします。必要なコンポーネントがダウンロードされ、Ollama以外のローカルモデルも含めてすべてが設定されます。

MstyをOllamaとリンクするには、サイドバーのLocal AI Modelsに移動し、Llama 3.2の横にあるダウンロードボタンをクリックします。ダウンロード後、モデルドロップダウンから選択します。他のモデルを使用する場合、そのモデル専用のアカウントからAPIキーが必要です。これでMstyがローカルのOllama LLMに接続されるはずです。

私はクエリにOllamaのローカルモデルを使うことを好みます。

モデル指示

Mstyの好きな機能の一つは、モデル指示をカスタマイズできることです。AIに医者、ライター、会計士、宇宙人類学者、アートアドバイザーなどとして動作させたい場合、Mstyが対応します。

モデル指示を調整するには、アプリ中央のEdit Model Instructionsをクリックし、ほうきアイコンの左にある小さなチャットボタンを押します。ポップアップメニューから必要な指示を選び、最初のクエリを実行する前に「Apply to this chat」をクリックします。

特定のニーズに合わせてクエリを調整できるモデル指示が豊富に用意されています。

このガイドでMstyをすぐに使い始められるはずです。基本から始めて、アプリに慣れたら高度な機能を探索してください。MacOSでのローカルAI体験を大きく向上させる強力なツールです。

教育用インフォグラフィックの作成に最適なAIツール - デザインのヒントとテクニック

デジタル化が進む今日の教育現場において、インフォグラフィックは、複雑な情報を視覚的に魅力的で理解しやすい形式に変換する、革新的なコミュニケーションメディアとして登場しました。AIテクノロジーは、教育者がこのような視覚的な学習教材を作成する方法に革命をもたらし、制作時間を劇的に短縮しながら、プロ級のデザインを誰でも利用できるようにしています。この調査では、合理化されたワークフロー、クリエイティブな自

教育用インフォグラフィックの作成に最適なAIツール - デザインのヒントとテクニック

デジタル化が進む今日の教育現場において、インフォグラフィックは、複雑な情報を視覚的に魅力的で理解しやすい形式に変換する、革新的なコミュニケーションメディアとして登場しました。AIテクノロジーは、教育者がこのような視覚的な学習教材を作成する方法に革命をもたらし、制作時間を劇的に短縮しながら、プロ級のデザインを誰でも利用できるようにしています。この調査では、合理化されたワークフロー、クリエイティブな自

Topaz DeNoise AI:2025年のベストノイズリダクションツール-完全ガイド

競争の激しいデジタル写真の世界では、画像の鮮明さが最も重要です。あらゆるレベルのフォトグラファーが、デジタルノイズに悩まされています。Topaz DeNoise AIは、人工知能を活用し、重要なディテールを維持しながらノイズ除去に取り組む最先端のソリューションとして登場しました。この詳細なレビューでは、この革新的なソフトウェアが2025年の写真ワークフローをどのように変えることができるのか、その主

Topaz DeNoise AI:2025年のベストノイズリダクションツール-完全ガイド

競争の激しいデジタル写真の世界では、画像の鮮明さが最も重要です。あらゆるレベルのフォトグラファーが、デジタルノイズに悩まされています。Topaz DeNoise AIは、人工知能を活用し、重要なディテールを維持しながらノイズ除去に取り組む最先端のソリューションとして登場しました。この詳細なレビューでは、この革新的なソフトウェアが2025年の写真ワークフローをどのように変えることができるのか、その主

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

2025年8月12日 15:50:10 JST

2025年8月12日 15:50:10 JST

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

2025年7月28日 10:20:21 JST

2025年7月28日 10:20:21 JST

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0