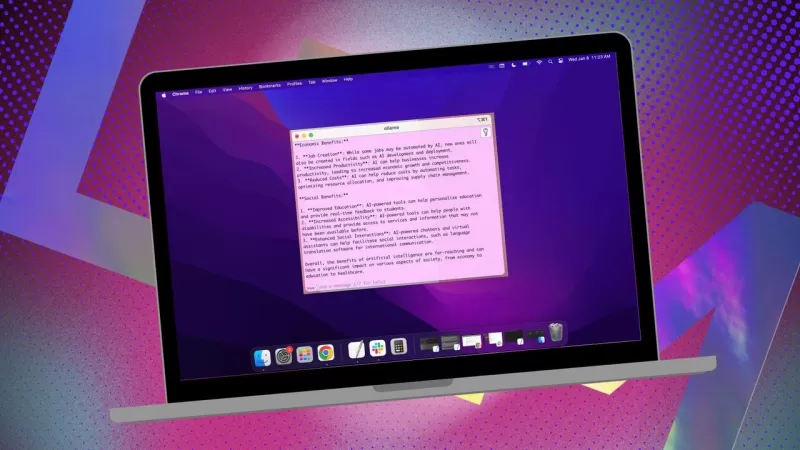

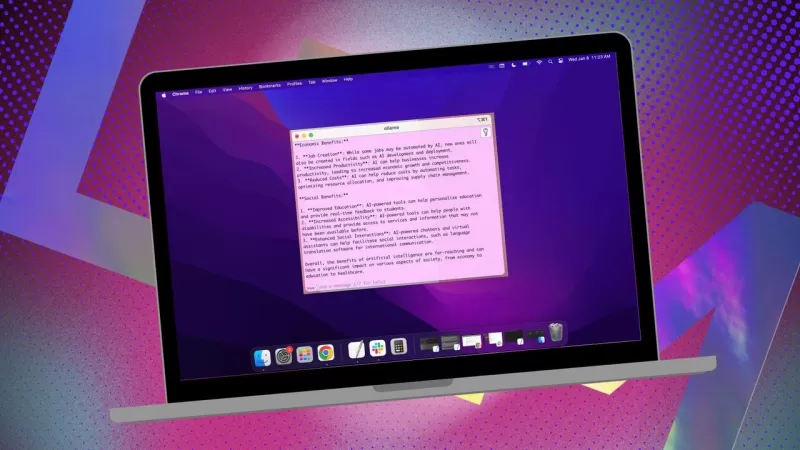

Ollama本地AI應用簡化MacOS使用

如果您希望保持數據隱私,避免將數據提供給第三方配置文件或訓練集,使用本地安裝的AI進行研究是一個明智的選擇。我一直在我的Linux系統上使用開源的Ollama,並搭配一個方便的瀏覽器擴展程式以提升使用體驗。但當我切換到MacOS時,我會選擇一個簡單且免費的應用程式Msty。

另見:如何將Ollama從終端工具轉變為基於瀏覽器的AI,使用這個免費擴展程式

Msty功能多樣,允許您使用本地安裝的AI模型或線上AI模型。就我個人而言,我偏好本地選項以確保最大隱私。Msty與其他Ollama工具的區別在於其簡單性——無需容器、終端機或額外的瀏覽器標籤。

這個應用程式功能豐富,使用起來非常方便。您可以同時運行多個查詢,使用分割聊天視窗,重生成模型回應,複製聊天,甚至添加多個模型。還有即時數據召喚功能(雖然這取決於具體模型),您還可以創建知識堆疊,使用文件、資料夾、Obsidian儲存庫、筆記等來訓練您的本地模型。此外,還有一個提示庫,幫助您充分利用您的查詢。

Msty無疑是與Ollama互動的最佳方式之一。以下是開始使用的方法:

安裝Msty

您需要什麼:僅需一台MacOS設備並已安裝並運行Ollama。如果您尚未設置Ollama,請在此處按照步驟操作。別忘了也下載一個本地模型。

下載安裝程式

前往Msty網站,點擊「下載Msty」下拉選單,選擇Mac,然後根據您的設備選擇Apple Silicon或Intel版本。

安裝Msty

下載完成後,雙擊文件,然後在提示時將Msty圖標拖到應用程式資料夾中。

使用Msty

開啟Msty

從MacOS的Launchpad啟動Msty。

連接您的本地Ollama模型

首次開啟Msty時,點擊「設置本地AI」。它會下載必要的組件並為您配置一切,包括下載除Ollama之外的其他本地模型。

要將Msty與Ollama連接,在側邊欄中導航到「本地AI模型」,然後點擊Llama 3.2旁邊的下載按鈕。下載完成後,從模型下拉選單中選擇它。對於其他模型,您需要從該模型的帳戶中獲取API密鑰。現在,Msty應該已連接到您的本地Ollama LLM。

我更喜歡堅持使用Ollama本地模型進行查詢。

模型指令

Msty中最喜歡的功能之一是能夠自訂模型指令。無論您需要AI扮演醫生、作家、會計師、外星人類學家還是藝術顧問,Msty都能滿足您的需求。

要調整模型指令,點擊應用程式中央的「編輯模型指令」,然後點擊掃帚圖標左側的小聊天按鈕。從彈出選單中選擇您想要的指令,然後在執行第一次查詢前點擊「應用於此聊天」。

有許多模型指令可供選擇,幫助您針對特定需求優化查詢。

本指南應能幫助您快速上手Msty。從基礎開始,隨著您對應用程式越來越熟悉,可以探索其更高級的功能。這是一個強大的工具,能真正提升您在MacOS上的本地AI體驗。

相關文章

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

評論 (2)

0/200

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

評論 (2)

0/200

![PaulHill]() PaulHill

PaulHill

2025-08-12 14:50:10

2025-08-12 14:50:10

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

2025-07-28 09:20:21

2025-07-28 09:20:21

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

如果您希望保持數據隱私,避免將數據提供給第三方配置文件或訓練集,使用本地安裝的AI進行研究是一個明智的選擇。我一直在我的Linux系統上使用開源的Ollama,並搭配一個方便的瀏覽器擴展程式以提升使用體驗。但當我切換到MacOS時,我會選擇一個簡單且免費的應用程式Msty。

另見:如何將Ollama從終端工具轉變為基於瀏覽器的AI,使用這個免費擴展程式

Msty功能多樣,允許您使用本地安裝的AI模型或線上AI模型。就我個人而言,我偏好本地選項以確保最大隱私。Msty與其他Ollama工具的區別在於其簡單性——無需容器、終端機或額外的瀏覽器標籤。

這個應用程式功能豐富,使用起來非常方便。您可以同時運行多個查詢,使用分割聊天視窗,重生成模型回應,複製聊天,甚至添加多個模型。還有即時數據召喚功能(雖然這取決於具體模型),您還可以創建知識堆疊,使用文件、資料夾、Obsidian儲存庫、筆記等來訓練您的本地模型。此外,還有一個提示庫,幫助您充分利用您的查詢。

Msty無疑是與Ollama互動的最佳方式之一。以下是開始使用的方法:

安裝Msty

您需要什麼:僅需一台MacOS設備並已安裝並運行Ollama。如果您尚未設置Ollama,請在此處按照步驟操作。別忘了也下載一個本地模型。

下載安裝程式

前往Msty網站,點擊「下載Msty」下拉選單,選擇Mac,然後根據您的設備選擇Apple Silicon或Intel版本。

安裝Msty

下載完成後,雙擊文件,然後在提示時將Msty圖標拖到應用程式資料夾中。

使用Msty

開啟Msty

從MacOS的Launchpad啟動Msty。

連接您的本地Ollama模型

首次開啟Msty時,點擊「設置本地AI」。它會下載必要的組件並為您配置一切,包括下載除Ollama之外的其他本地模型。

要將Msty與Ollama連接,在側邊欄中導航到「本地AI模型」,然後點擊Llama 3.2旁邊的下載按鈕。下載完成後,從模型下拉選單中選擇它。對於其他模型,您需要從該模型的帳戶中獲取API密鑰。現在,Msty應該已連接到您的本地Ollama LLM。

我更喜歡堅持使用Ollama本地模型進行查詢。

模型指令

Msty中最喜歡的功能之一是能夠自訂模型指令。無論您需要AI扮演醫生、作家、會計師、外星人類學家還是藝術顧問,Msty都能滿足您的需求。

要調整模型指令,點擊應用程式中央的「編輯模型指令」,然後點擊掃帚圖標左側的小聊天按鈕。從彈出選單中選擇您想要的指令,然後在執行第一次查詢前點擊「應用於此聊天」。

有許多模型指令可供選擇,幫助您針對特定需求優化查詢。

本指南應能幫助您快速上手Msty。從基礎開始,隨著您對應用程式越來越熟悉,可以探索其更高級的功能。這是一個強大的工具,能真正提升您在MacOS上的本地AI體驗。

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

Master Emerald Kaizo Nuzlocke:終極生存與策略指南

Emerald Kaizo 是有史以來最強大的 Pokémon ROM hacks 之一。雖然嘗試執行 Nuzlocke 會使挑戰成倍增加,但透過縝密的規劃和策略執行,勝利仍然是可以實現的。這本權威指南提供在 Hardcore Nuzlocke 規則下征服 Emerald Kaizo 的必要工具、經過實戰考驗的戰術以及深入的 AI 分析。準備好迎接 Pokémon 精通的終極考驗吧!基本策略收集關

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

2025-08-12 14:50:10

2025-08-12 14:50:10

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

2025-07-28 09:20:21

2025-07-28 09:20:21

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0