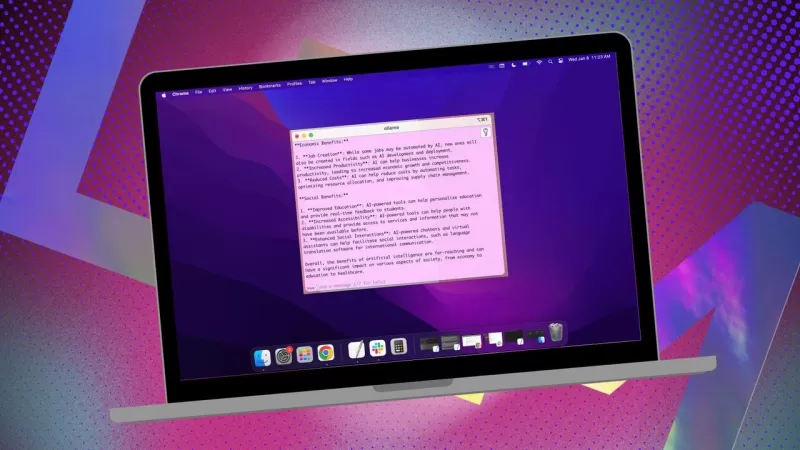

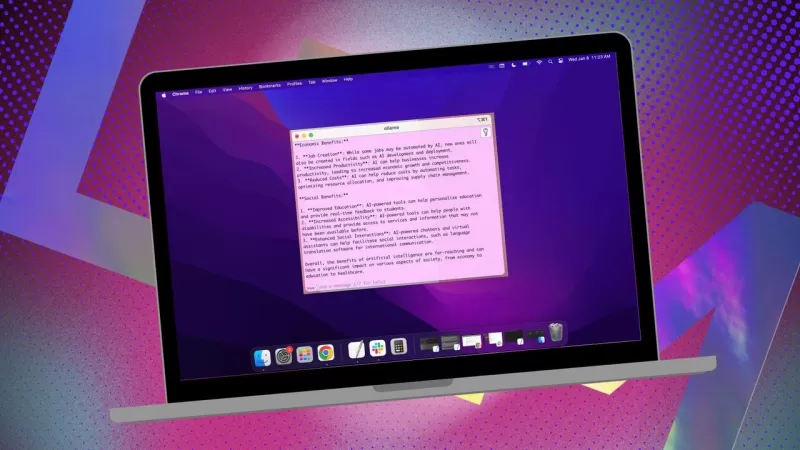

Ollama本地AI应用简化MacOS使用

如果您希望保护数据隐私,避免数据被第三方配置文件或训练集使用,在本地安装AI进行研究是一个明智选择。我在Linux系统上使用开源Ollama,并搭配一个方便的浏览器扩展以提升体验。但在MacOS上,我选择了一个简单免费的应用程序Msty。

另见:如何将Ollama从终端工具转变为基于浏览器的AI,使用这个免费扩展

Msty用途广泛,可连接本地安装和在线AI模型。我个人偏好本地选项以确保最大隐私。Msty与其他Ollama工具的区别在于其简洁性——无需容器、终端或额外浏览器标签。

该应用程序功能丰富,使用起来非常方便。您可以同时运行多个查询通过分屏聊天、重新生成模型响应、克隆聊天,甚至添加多个模型。支持实时数据调用(视模型而定),您还可以创建知识堆栈,用文件、文件夹、Obsidian库、笔记等训练本地模型。此外,还有提示库帮助您优化查询。

Msty无疑是与Ollama交互的最佳方式之一。以下是入门方法:

安装Msty

您需要准备:仅需一台MacOS设备并安装运行Ollama。如果尚未设置Ollama,请在此处按照步骤操作。别忘了下载一个本地模型。

下载安装程序

访问Msty网站,点击“下载Msty”下拉菜单,选择Mac,然后根据您的设备选择Apple Silicon或Intel。

安装Msty

下载完成后,双击文件,按提示将Msty图标拖到应用程序文件夹。

使用Msty

打开Msty

从MacOS的Launchpad启动Msty。

连接本地Ollama模型

首次打开Msty,点击“设置本地AI”。它会下载必要组件并为您配置一切,包括下载除Ollama外的其他本地模型。

要将Msty与Ollama连接,在侧边栏中导航到本地AI模型,点击Llama 3.2旁边的下载按钮。下载完成后,从模型下拉菜单中选择它。对于其他模型,您需要从对应模型账户获取API密钥。现在Msty应已连接到您的本地Ollama LLM。

我更喜欢使用Ollama本地模型进行查询。

模型指令

Msty的一个亮点功能是可自定义模型指令。无论您需要AI扮演医生、作家、会计师、外星人类学家还是艺术顾问,Msty都能满足。

要调整模型指令,点击应用中心处的“编辑模型指令”,然后点击扫帚图标左侧的聊天按钮。从弹出的菜单中选择您需要的指令,在运行首次查询前点击“应用到此聊天”。

模型指令种类繁多,可帮助您针对特定需求优化查询。

本指南能帮助您快速上手Msty。从基础开始,随着对应用的熟悉,探索其更高级功能。这是一个强大的工具,能显著提升您在MacOS上的本地AI体验。

相关文章

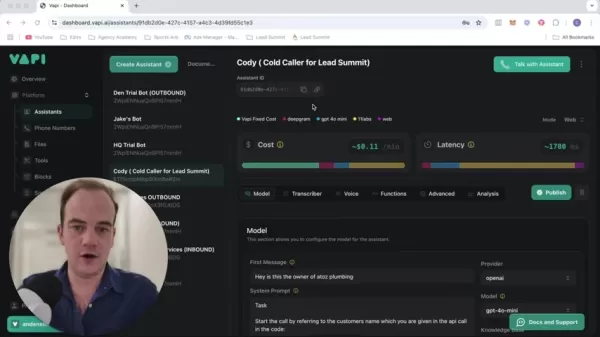

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

评论 (2)

0/200

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

评论 (2)

0/200

![PaulHill]() PaulHill

PaulHill

2025-08-12 14:50:10

2025-08-12 14:50:10

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

2025-07-28 09:20:21

2025-07-28 09:20:21

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

如果您希望保护数据隐私,避免数据被第三方配置文件或训练集使用,在本地安装AI进行研究是一个明智选择。我在Linux系统上使用开源Ollama,并搭配一个方便的浏览器扩展以提升体验。但在MacOS上,我选择了一个简单免费的应用程序Msty。

另见:如何将Ollama从终端工具转变为基于浏览器的AI,使用这个免费扩展

Msty用途广泛,可连接本地安装和在线AI模型。我个人偏好本地选项以确保最大隐私。Msty与其他Ollama工具的区别在于其简洁性——无需容器、终端或额外浏览器标签。

该应用程序功能丰富,使用起来非常方便。您可以同时运行多个查询通过分屏聊天、重新生成模型响应、克隆聊天,甚至添加多个模型。支持实时数据调用(视模型而定),您还可以创建知识堆栈,用文件、文件夹、Obsidian库、笔记等训练本地模型。此外,还有提示库帮助您优化查询。

Msty无疑是与Ollama交互的最佳方式之一。以下是入门方法:

安装Msty

您需要准备:仅需一台MacOS设备并安装运行Ollama。如果尚未设置Ollama,请在此处按照步骤操作。别忘了下载一个本地模型。

下载安装程序

访问Msty网站,点击“下载Msty”下拉菜单,选择Mac,然后根据您的设备选择Apple Silicon或Intel。

安装Msty

下载完成后,双击文件,按提示将Msty图标拖到应用程序文件夹。

使用Msty

打开Msty

从MacOS的Launchpad启动Msty。

连接本地Ollama模型

首次打开Msty,点击“设置本地AI”。它会下载必要组件并为您配置一切,包括下载除Ollama外的其他本地模型。

要将Msty与Ollama连接,在侧边栏中导航到本地AI模型,点击Llama 3.2旁边的下载按钮。下载完成后,从模型下拉菜单中选择它。对于其他模型,您需要从对应模型账户获取API密钥。现在Msty应已连接到您的本地Ollama LLM。

我更喜欢使用Ollama本地模型进行查询。

模型指令

Msty的一个亮点功能是可自定义模型指令。无论您需要AI扮演医生、作家、会计师、外星人类学家还是艺术顾问,Msty都能满足。

要调整模型指令,点击应用中心处的“编辑模型指令”,然后点击扫帚图标左侧的聊天按钮。从弹出的菜单中选择您需要的指令,在运行首次查询前点击“应用到此聊天”。

模型指令种类繁多,可帮助您针对特定需求优化查询。

本指南能帮助您快速上手Msty。从基础开始,随着对应用的熟悉,探索其更高级功能。这是一个强大的工具,能显著提升您在MacOS上的本地AI体验。

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

2025-08-12 14:50:10

2025-08-12 14:50:10

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

2025-07-28 09:20:21

2025-07-28 09:20:21

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0