Приложение Ollama для локального ИИ упрощает использование на MacOS

Если вы хотите сохранить конфиденциальность данных и избежать передачи их в сторонние профили или наборы для обучения, использование локально установленного ИИ для исследований — умный выбор. Я использую open-source Ollama на своей системе Linux с удобным расширением для браузера для более комфортной работы. Но на MacOS я предпочитаю простое бесплатное приложение Msty.

Также: Как превратить Ollama из терминального инструмента в браузерный ИИ с помощью этого бесплатного расширения

Msty универсален, позволяет использовать как локально установленные, так и онлайн-модели ИИ. Я лично выбираю локальный вариант для максимальной конфиденциальности. Msty отличается от других инструментов Ollama простотой — никаких контейнеров, терминалов или дополнительных вкладок в браузере.

Приложение полно функций, упрощающих использование. Вы можете выполнять несколько запросов одновременно с разделёнными чатами, перегенерировать ответы модели, клонировать чаты и добавлять несколько моделей. Есть вызов данных в реальном времени (зависит от модели), а также возможность создавать Knowledge Stacks для обучения локальной модели с помощью файлов, папок, хранилищ Obsidian, заметок и прочего. Плюс, есть библиотека подсказок, чтобы максимально эффективно использовать запросы.

Msty — один из лучших способов взаимодействия с Ollama. Вот как начать:

Установка Msty

Что понадобится: Устройство с MacOS и установленным Ollama. Если Ollama ещё не настроен, следуйте инструкциям здесь. Не забудьте скачать локальную модель.

Скачивание установщика

Перейдите на сайт Msty, нажмите на выпадающее меню Download Msty, выберите Mac, затем Apple Silicon или Intel в зависимости от устройства.

Установка Msty

После завершения загрузки дважды щёлкните по файлу и перетащите иконку Msty в папку Applications, когда появится запрос.

Использование Msty

Запуск Msty

Откройте Msty из Launchpad на MacOS.

Подключение локальной модели Ollama

При первом открытии Msty нажмите на Setup Local AI. Приложение скачает необходимые компоненты и настроит всё, включая загрузку локальной модели, отличной от Ollama.

Чтобы связать Msty с Ollama, перейдите в Local AI Models в боковой панели и нажмите кнопку загрузки рядом с Llama 3.2. После загрузки выберите её в выпадающем меню моделей. Для других моделей потребуется API-ключ от вашей учётной записи для конкретной модели. Теперь Msty должен быть подключён к вашему локальному Ollama LLM.

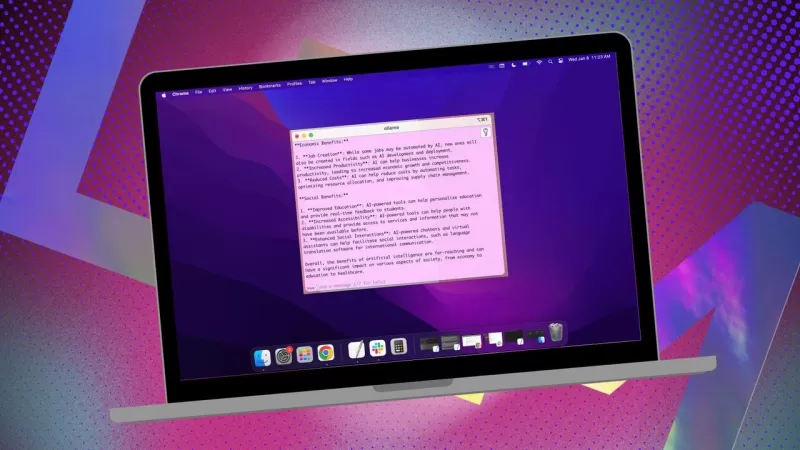

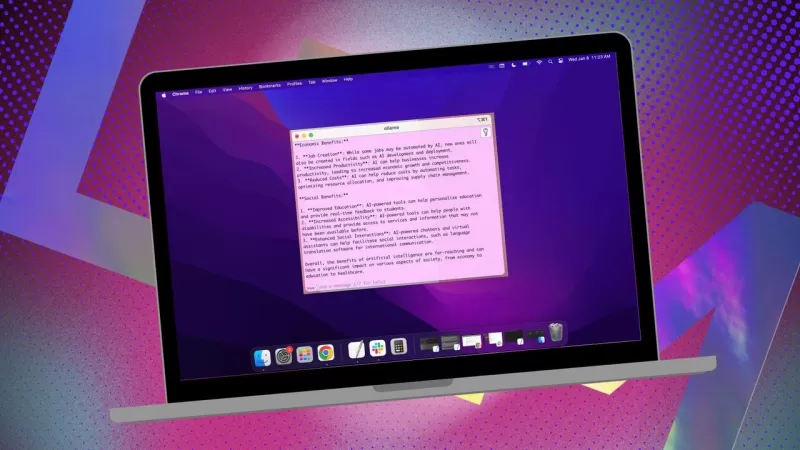

Я предпочитаю использовать локальную модель Ollama для своих запросов.

Инструкции для модели

Одна из моих любимых функций в Msty — возможность настраивать инструкции для модели. Нужен ИИ в роли врача, писателя, бухгалтера, инопланетного антрополога или художественного консультанта? Msty справится.

Чтобы изменить инструкции модели, нажмите на Edit Model Instructions в центре приложения, затем на маленькую кнопку чата слева от иконки метлы. В выпадающем меню выберите нужные инструкции и нажмите "Apply to this chat" перед первым запросом.

Доступно множество инструкций для моделей, чтобы уточнить запросы под конкретные нужды.

Это руководство поможет быстро начать работу с Msty. Начните с основ, а по мере знакомства с приложением изучайте его продвинутые функции. Это мощный инструмент, который значительно улучшит ваш опыт работы с локальным ИИ на MacOS.

Связанная статья

Master Emerald Kaizo Nuzlocke: Ultimate Survival & Strategy Guide

Emerald Kaizo - один из самых грозных хаков для Pokémon ROM, которые когда-либо были придуманы. Несмотря на то, что попытка запустить Nuzlocke в разы увеличивает сложность игры, победа остается достиж

Master Emerald Kaizo Nuzlocke: Ultimate Survival & Strategy Guide

Emerald Kaizo - один из самых грозных хаков для Pokémon ROM, которые когда-либо были придуманы. Несмотря на то, что попытка запустить Nuzlocke в разы увеличивает сложность игры, победа остается достиж

Сопроводительные письма на основе искусственного интеллекта: Экспертное руководство по подаче документов в журнал

В сегодняшней конкурентной среде научных изданий составление эффективного сопроводительного письма может сыграть решающую роль в принятии вашей рукописи. Узнайте, как инструменты с искусственным интел

Сопроводительные письма на основе искусственного интеллекта: Экспертное руководство по подаче документов в журнал

В сегодняшней конкурентной среде научных изданий составление эффективного сопроводительного письма может сыграть решающую роль в принятии вашей рукописи. Узнайте, как инструменты с искусственным интел

США введут санкции против иностранных чиновников из-за правил пользования социальными сетями

США выступают против глобального регулирования цифрового контентаНа этой неделе Государственный департамент США выступил с резким дипломатическим обвинением в адрес европейской политики управления ц

Комментарии (2)

США введут санкции против иностранных чиновников из-за правил пользования социальными сетями

США выступают против глобального регулирования цифрового контентаНа этой неделе Государственный департамент США выступил с резким дипломатическим обвинением в адрес европейской политики управления ц

Комментарии (2)

![PaulHill]() PaulHill

PaulHill

12 августа 2025 г., 9:50:10 GMT+03:00

12 августа 2025 г., 9:50:10 GMT+03:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

28 июля 2025 г., 4:20:21 GMT+03:00

28 июля 2025 г., 4:20:21 GMT+03:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

Если вы хотите сохранить конфиденциальность данных и избежать передачи их в сторонние профили или наборы для обучения, использование локально установленного ИИ для исследований — умный выбор. Я использую open-source Ollama на своей системе Linux с удобным расширением для браузера для более комфортной работы. Но на MacOS я предпочитаю простое бесплатное приложение Msty.

Также: Как превратить Ollama из терминального инструмента в браузерный ИИ с помощью этого бесплатного расширения

Msty универсален, позволяет использовать как локально установленные, так и онлайн-модели ИИ. Я лично выбираю локальный вариант для максимальной конфиденциальности. Msty отличается от других инструментов Ollama простотой — никаких контейнеров, терминалов или дополнительных вкладок в браузере.

Приложение полно функций, упрощающих использование. Вы можете выполнять несколько запросов одновременно с разделёнными чатами, перегенерировать ответы модели, клонировать чаты и добавлять несколько моделей. Есть вызов данных в реальном времени (зависит от модели), а также возможность создавать Knowledge Stacks для обучения локальной модели с помощью файлов, папок, хранилищ Obsidian, заметок и прочего. Плюс, есть библиотека подсказок, чтобы максимально эффективно использовать запросы.

Msty — один из лучших способов взаимодействия с Ollama. Вот как начать:

Установка Msty

Что понадобится: Устройство с MacOS и установленным Ollama. Если Ollama ещё не настроен, следуйте инструкциям здесь. Не забудьте скачать локальную модель.

Скачивание установщика

Перейдите на сайт Msty, нажмите на выпадающее меню Download Msty, выберите Mac, затем Apple Silicon или Intel в зависимости от устройства.

Установка Msty

После завершения загрузки дважды щёлкните по файлу и перетащите иконку Msty в папку Applications, когда появится запрос.

Использование Msty

Запуск Msty

Откройте Msty из Launchpad на MacOS.

Подключение локальной модели Ollama

При первом открытии Msty нажмите на Setup Local AI. Приложение скачает необходимые компоненты и настроит всё, включая загрузку локальной модели, отличной от Ollama.

Чтобы связать Msty с Ollama, перейдите в Local AI Models в боковой панели и нажмите кнопку загрузки рядом с Llama 3.2. После загрузки выберите её в выпадающем меню моделей. Для других моделей потребуется API-ключ от вашей учётной записи для конкретной модели. Теперь Msty должен быть подключён к вашему локальному Ollama LLM.

Я предпочитаю использовать локальную модель Ollama для своих запросов.

Инструкции для модели

Одна из моих любимых функций в Msty — возможность настраивать инструкции для модели. Нужен ИИ в роли врача, писателя, бухгалтера, инопланетного антрополога или художественного консультанта? Msty справится.

Чтобы изменить инструкции модели, нажмите на Edit Model Instructions в центре приложения, затем на маленькую кнопку чата слева от иконки метлы. В выпадающем меню выберите нужные инструкции и нажмите "Apply to this chat" перед первым запросом.

Доступно множество инструкций для моделей, чтобы уточнить запросы под конкретные нужды.

Это руководство поможет быстро начать работу с Msty. Начните с основ, а по мере знакомства с приложением изучайте его продвинутые функции. Это мощный инструмент, который значительно улучшит ваш опыт работы с локальным ИИ на MacOS.

Master Emerald Kaizo Nuzlocke: Ultimate Survival & Strategy Guide

Emerald Kaizo - один из самых грозных хаков для Pokémon ROM, которые когда-либо были придуманы. Несмотря на то, что попытка запустить Nuzlocke в разы увеличивает сложность игры, победа остается достиж

Master Emerald Kaizo Nuzlocke: Ultimate Survival & Strategy Guide

Emerald Kaizo - один из самых грозных хаков для Pokémon ROM, которые когда-либо были придуманы. Несмотря на то, что попытка запустить Nuzlocke в разы увеличивает сложность игры, победа остается достиж

Сопроводительные письма на основе искусственного интеллекта: Экспертное руководство по подаче документов в журнал

В сегодняшней конкурентной среде научных изданий составление эффективного сопроводительного письма может сыграть решающую роль в принятии вашей рукописи. Узнайте, как инструменты с искусственным интел

Сопроводительные письма на основе искусственного интеллекта: Экспертное руководство по подаче документов в журнал

В сегодняшней конкурентной среде научных изданий составление эффективного сопроводительного письма может сыграть решающую роль в принятии вашей рукописи. Узнайте, как инструменты с искусственным интел

США введут санкции против иностранных чиновников из-за правил пользования социальными сетями

США выступают против глобального регулирования цифрового контентаНа этой неделе Государственный департамент США выступил с резким дипломатическим обвинением в адрес европейской политики управления ц

США введут санкции против иностранных чиновников из-за правил пользования социальными сетями

США выступают против глобального регулирования цифрового контентаНа этой неделе Государственный департамент США выступил с резким дипломатическим обвинением в адрес европейской политики управления ц

12 августа 2025 г., 9:50:10 GMT+03:00

12 августа 2025 г., 9:50:10 GMT+03:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

28 июля 2025 г., 4:20:21 GMT+03:00

28 июля 2025 г., 4:20:21 GMT+03:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0