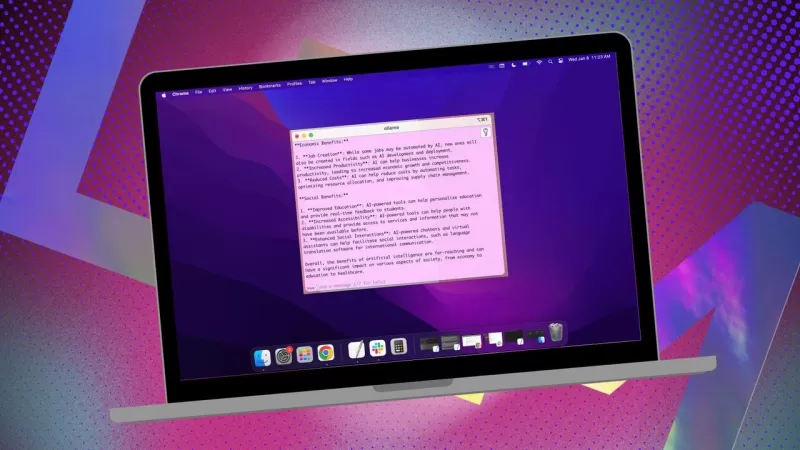

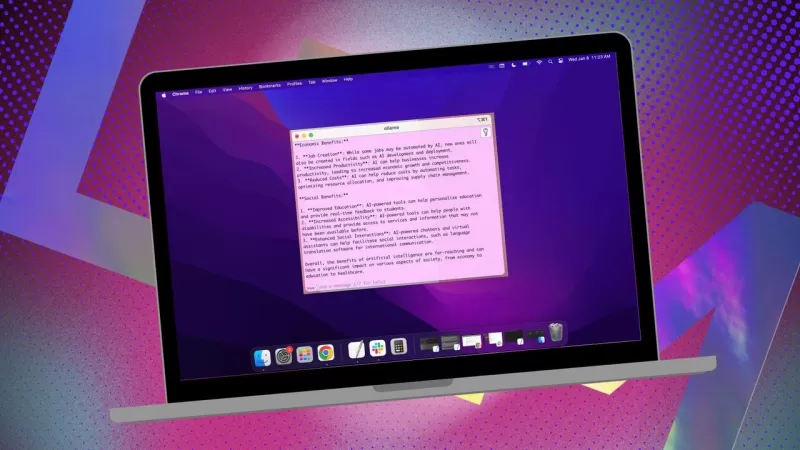

Ollama-Lokale-AI-App vereinfacht die Nutzung auf MacOS

Wenn du deine Daten privat halten und vermeiden möchtest, dass sie in Drittanbieterprofile oder Trainingsdatensätze einfließen, ist die Verwendung eines lokal installierten AI für deine Forschung eine kluge Entscheidung. Ich verwende die Open-Source-Software Ollama auf meinem Linux-System, ergänzt durch eine praktische Browsererweiterung für ein reibungsloseres Erlebnis. Auf meinem MacOS greife ich jedoch auf eine unkomplizierte, kostenlose App namens Msty zurück.

Außerdem: Wie man Ollama von einem Terminal-Tool in ein browserbasiertes AI mit dieser kostenlosen Erweiterung umwandelt

Msty ist vielseitig und ermöglicht es dir, sowohl lokal installierte als auch Online-AI-Modelle zu nutzen. Ich persönlich bleibe bei der lokalen Option für maximale Privatsphäre. Was Msty von anderen Ollama-Tools abhebt, ist seine Einfachheit – keine Notwendigkeit für Container, Terminals oder zusätzliche Browser-Tabs.

Die App ist vollgepackt mit Funktionen, die sie unglaublich benutzerfreundlich machen. Du kannst mehrere Anfragen gleichzeitig mit geteilten Chats ausführen, Modellantworten neu generieren, Chats klonen und sogar mehrere Modelle hinzufügen. Es gibt eine Echtzeit-Datenabfrage (modellspezifisch) und du kannst Knowledge Stacks erstellen, um dein lokales Modell mit Dateien, Ordnern, Obsidian-Vaults, Notizen und mehr zu trainieren. Außerdem gibt es eine Eingabeaufforderungsbibliothek, die dir hilft, das Beste aus deinen Anfragen herauszuholen.

Msty ist zweifellos eine der besten Möglichkeiten, mit Ollama zu interagieren. So kannst du beginnen:

Msty installieren

Was du brauchst: Nur ein MacOS-Gerät und Ollama, das installiert und ausgeführt wird. Wenn du Ollama noch nicht eingerichtet hast, folge den Schritten hier. Vergiss nicht, auch ein lokales Modell herunterzuladen.

Den Installer herunterladen

Besuche die Msty-Website, klicke auf das Dropdown-Menü „Msty herunterladen“, wähle Mac und dann entweder Apple Silicon oder Intel, je nach deinem Gerät.

Msty installieren

Sobald der Download abgeschlossen ist, doppelt klicke auf die Datei und ziehe das Msty-Symbol in den Anwendungsordner, wenn du dazu aufgefordert wirst.

Msty verwenden

Msty öffnen

Starte Msty vom Launchpad auf deinem MacOS.

Dein lokales Ollama-Modell verbinden

Beim ersten Öffnen von Msty klicke auf „Lokales AI einrichten“. Die App lädt die notwendigen Komponenten herunter und konfiguriert alles für dich, einschließlich des Downloads eines lokalen Modells außer Ollama.

Um Msty mit Ollama zu verknüpfen, navigiere in der Seitenleiste zu „Lokale AI-Modelle“ und klicke auf den Download-Button neben Llama 3.2. Nach dem Download wähle es aus dem Modell-Dropdown aus. Für andere Modelle benötigst du einen API-Schlüssel von deinem Konto für dieses spezifische Modell. Nun sollte Msty mit deinem lokalen Ollama LLM verbunden sein.

Ich bevorzuge es, bei meinen Anfragen beim lokalen Ollama-Modell zu bleiben.

Modellanweisungen

Eine meiner Lieblingsfunktionen in Msty ist die Möglichkeit, Modellanweisungen anzupassen. Egal, ob du möchtest, dass das AI als Arzt, Schriftsteller, Buchhalter, außerirdischer Anthropologe oder künstlerischer Berater agiert, Msty bietet dir alle Möglichkeiten.

Um die Modellanweisungen anzupassen, klicke in der Mitte der App auf „Modellanweisungen bearbeiten“ und dann auf den kleinen Chat-Button links neben dem Besen-Symbol. Wähle im Popup-Menü die gewünschten Anweisungen aus und klicke auf „Auf diesen Chat anwenden“, bevor du deine erste Anfrage startest.

Es gibt viele Modellanweisungen zur Auswahl, die dir helfen, deine Anfragen für spezifische Bedürfnisse zu optimieren.

Diese Anleitung sollte dir helfen, Msty schnell einzurichten und zu nutzen. Beginne mit den Grundlagen und erkunde die fortgeschrittenen Funktionen, sobald du dich mit der App wohler fühlst. Es ist ein leistungsstarkes Werkzeug, das dein lokales AI-Erlebnis auf MacOS wirklich verbessern kann.

Verwandter Artikel

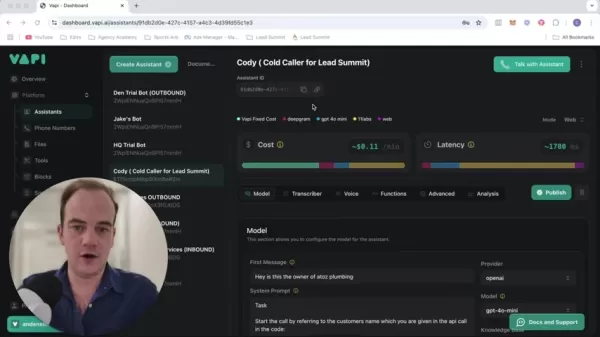

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Kommentare (2)

0/200

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Kommentare (2)

0/200

![PaulHill]() PaulHill

PaulHill

12. August 2025 08:50:10 MESZ

12. August 2025 08:50:10 MESZ

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

28. Juli 2025 03:20:21 MESZ

28. Juli 2025 03:20:21 MESZ

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

Wenn du deine Daten privat halten und vermeiden möchtest, dass sie in Drittanbieterprofile oder Trainingsdatensätze einfließen, ist die Verwendung eines lokal installierten AI für deine Forschung eine kluge Entscheidung. Ich verwende die Open-Source-Software Ollama auf meinem Linux-System, ergänzt durch eine praktische Browsererweiterung für ein reibungsloseres Erlebnis. Auf meinem MacOS greife ich jedoch auf eine unkomplizierte, kostenlose App namens Msty zurück.

Außerdem: Wie man Ollama von einem Terminal-Tool in ein browserbasiertes AI mit dieser kostenlosen Erweiterung umwandelt

Msty ist vielseitig und ermöglicht es dir, sowohl lokal installierte als auch Online-AI-Modelle zu nutzen. Ich persönlich bleibe bei der lokalen Option für maximale Privatsphäre. Was Msty von anderen Ollama-Tools abhebt, ist seine Einfachheit – keine Notwendigkeit für Container, Terminals oder zusätzliche Browser-Tabs.

Die App ist vollgepackt mit Funktionen, die sie unglaublich benutzerfreundlich machen. Du kannst mehrere Anfragen gleichzeitig mit geteilten Chats ausführen, Modellantworten neu generieren, Chats klonen und sogar mehrere Modelle hinzufügen. Es gibt eine Echtzeit-Datenabfrage (modellspezifisch) und du kannst Knowledge Stacks erstellen, um dein lokales Modell mit Dateien, Ordnern, Obsidian-Vaults, Notizen und mehr zu trainieren. Außerdem gibt es eine Eingabeaufforderungsbibliothek, die dir hilft, das Beste aus deinen Anfragen herauszuholen.

Msty ist zweifellos eine der besten Möglichkeiten, mit Ollama zu interagieren. So kannst du beginnen:

Msty installieren

Was du brauchst: Nur ein MacOS-Gerät und Ollama, das installiert und ausgeführt wird. Wenn du Ollama noch nicht eingerichtet hast, folge den Schritten hier. Vergiss nicht, auch ein lokales Modell herunterzuladen.

Den Installer herunterladen

Besuche die Msty-Website, klicke auf das Dropdown-Menü „Msty herunterladen“, wähle Mac und dann entweder Apple Silicon oder Intel, je nach deinem Gerät.

Msty installieren

Sobald der Download abgeschlossen ist, doppelt klicke auf die Datei und ziehe das Msty-Symbol in den Anwendungsordner, wenn du dazu aufgefordert wirst.

Msty verwenden

Msty öffnen

Starte Msty vom Launchpad auf deinem MacOS.

Dein lokales Ollama-Modell verbinden

Beim ersten Öffnen von Msty klicke auf „Lokales AI einrichten“. Die App lädt die notwendigen Komponenten herunter und konfiguriert alles für dich, einschließlich des Downloads eines lokalen Modells außer Ollama.

Um Msty mit Ollama zu verknüpfen, navigiere in der Seitenleiste zu „Lokale AI-Modelle“ und klicke auf den Download-Button neben Llama 3.2. Nach dem Download wähle es aus dem Modell-Dropdown aus. Für andere Modelle benötigst du einen API-Schlüssel von deinem Konto für dieses spezifische Modell. Nun sollte Msty mit deinem lokalen Ollama LLM verbunden sein.

Ich bevorzuge es, bei meinen Anfragen beim lokalen Ollama-Modell zu bleiben.

Modellanweisungen

Eine meiner Lieblingsfunktionen in Msty ist die Möglichkeit, Modellanweisungen anzupassen. Egal, ob du möchtest, dass das AI als Arzt, Schriftsteller, Buchhalter, außerirdischer Anthropologe oder künstlerischer Berater agiert, Msty bietet dir alle Möglichkeiten.

Um die Modellanweisungen anzupassen, klicke in der Mitte der App auf „Modellanweisungen bearbeiten“ und dann auf den kleinen Chat-Button links neben dem Besen-Symbol. Wähle im Popup-Menü die gewünschten Anweisungen aus und klicke auf „Auf diesen Chat anwenden“, bevor du deine erste Anfrage startest.

Es gibt viele Modellanweisungen zur Auswahl, die dir helfen, deine Anfragen für spezifische Bedürfnisse zu optimieren.

Diese Anleitung sollte dir helfen, Msty schnell einzurichten und zu nutzen. Beginne mit den Grundlagen und erkunde die fortgeschrittenen Funktionen, sobald du dich mit der App wohler fühlst. Es ist ein leistungsstarkes Werkzeug, das dein lokales AI-Erlebnis auf MacOS wirklich verbessern kann.

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

12. August 2025 08:50:10 MESZ

12. August 2025 08:50:10 MESZ

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

28. Juli 2025 03:20:21 MESZ

28. Juli 2025 03:20:21 MESZ

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0