Aplicativo Ollama Local AI Simplifica Uso no MacOS

Se você deseja manter seus dados privados e evitar contribuir para perfis de terceiros ou conjuntos de treinamento, usar uma IA instalada localmente para sua pesquisa é uma escolha inteligente. Eu tenho usado o Ollama de código aberto no meu sistema Linux, aprimorado com uma extensão de navegador prática para uma experiência mais fluida. Mas quando mudo para o meu MacOS, opto por um aplicativo gratuito e direto chamado Msty.

Também: Como transformar o Ollama de uma ferramenta de terminal em uma IA baseada em navegador com esta extensão gratuita

Msty é versátil, permitindo que você utilize tanto modelos de IA instalados localmente quanto online. Pessoalmente, eu prefiro a opção local para máxima privacidade. O que diferencia o Msty de outras ferramentas do Ollama é sua simplicidade — sem necessidade de contêineres, terminais ou abas adicionais no navegador.

O aplicativo é repleto de recursos que tornam seu uso muito fácil. Você pode executar várias consultas simultaneamente com chats divididos, regenerar respostas do modelo, clonar chats e até adicionar vários modelos. Há uma convocação de dados em tempo real (embora específica do modelo), e você pode criar Pilhas de Conhecimento para treinar seu modelo local com arquivos, pastas, cofres do Obsidian, notas e mais. Além disso, há uma biblioteca de prompts para ajudá-lo a tirar o máximo proveito de suas consultas.

Msty é, sem dúvida, uma das melhores maneiras de interagir com o Ollama. Veja como você pode começar:

Instalando o Msty

O que você vai precisar: Apenas um dispositivo MacOS e o Ollama instalado e em execução. Se você ainda não configurou o Ollama, siga os passos aqui. Não se esqueça de baixar um modelo local também.

Baixe o Instalador

Acesse o site do Msty, clique no menu suspenso Baixar Msty, escolha Mac e, em seguida, selecione Apple Silicon ou Intel com base no seu dispositivo.

Instale o Msty

Assim que o download terminar, clique duas vezes no arquivo e arraste o ícone do Msty para a pasta Aplicativos quando solicitado.

Usando o Msty

Abra o Msty

Inicie o Msty a partir do Launchpad no seu MacOS.

Conecte seu Modelo Local do Ollama

Ao abrir o Msty pela primeira vez, clique em Configurar IA Local. Ele baixará os componentes necessários e configurará tudo para você, incluindo o download de um modelo local diferente do Ollama.

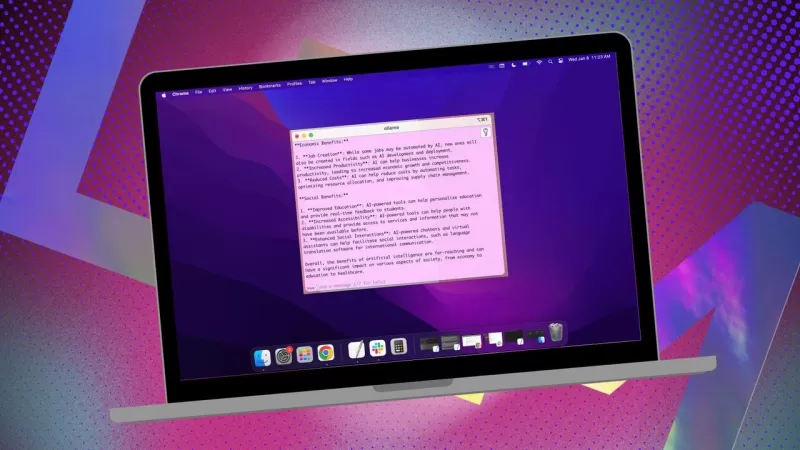

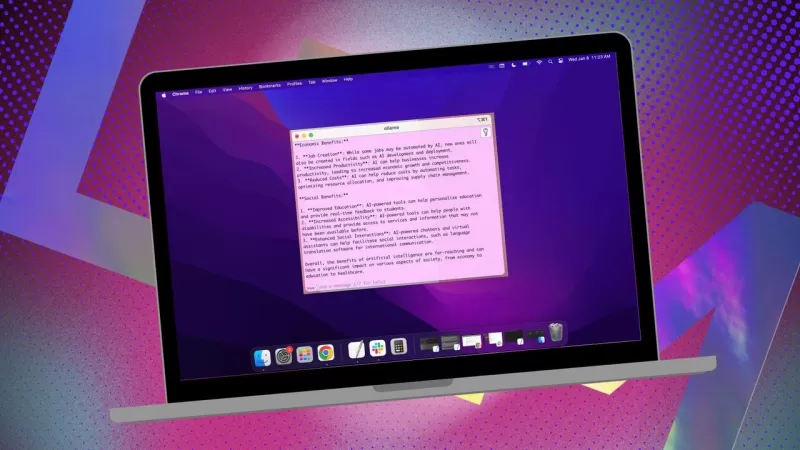

Para vincular o Msty ao Ollama, navegue até Modelos de IA Locais na barra lateral e clique no botão de download ao lado do Llama 3.2. Após o download, selecione-o no menu suspenso de modelos. Para outros modelos, você precisará de uma chave API da sua conta para esse modelo específico. Agora o Msty deve estar conectado ao seu LLM local do Ollama.

Eu prefiro manter o modelo local do Ollama para minhas consultas.

Instruções do Modelo

Um dos meus recursos favoritos no Msty é a capacidade de personalizar as instruções do modelo. Se você precisa que a IA atue como médico, escritor, contador, antropólogo alienígena ou consultor artístico, o Msty tem você coberto.

Para ajustar as instruções do modelo, clique em Editar Instruções do Modelo no centro do aplicativo e, em seguida, clique no pequeno botão de chat à esquerda do ícone de vassoura. No menu suspenso, escolha as instruções que deseja e clique em "Aplicar a este chat" antes de executar sua primeira consulta.

Há muitas instruções de modelo para escolher, ajudando você a refinar suas consultas para necessidades específicas.

Este guia deve ajudá-lo a começar a usar o Msty rapidamente. Comece com o básico e, à medida que se sentir mais confortável com o aplicativo, explore seus recursos mais avançados. É uma ferramenta poderosa que pode realmente aprimorar sua experiência com IA local no MacOS.

Artigo relacionado

Melhores ferramentas de IA para criar infográficos educacionais - Dicas e técnicas de design

No cenário educacional atual, impulsionado pelo digital, os infográficos surgiram como um meio de comunicação transformador que converte informações complexas em formatos visualmente atraentes e facil

Melhores ferramentas de IA para criar infográficos educacionais - Dicas e técnicas de design

No cenário educacional atual, impulsionado pelo digital, os infográficos surgiram como um meio de comunicação transformador que converte informações complexas em formatos visualmente atraentes e facil

Topaz DeNoise AI: a melhor ferramenta de redução de ruído em 2025 - Guia completo

No competitivo mundo da fotografia digital, a nitidez da imagem continua sendo fundamental. Fotógrafos de todos os níveis de habilidade enfrentam o ruído digital que compromete fotos que, de outra for

Topaz DeNoise AI: a melhor ferramenta de redução de ruído em 2025 - Guia completo

No competitivo mundo da fotografia digital, a nitidez da imagem continua sendo fundamental. Fotógrafos de todos os níveis de habilidade enfrentam o ruído digital que compromete fotos que, de outra for

Master Emerald Kaizo Nuzlocke: Guia definitivo de sobrevivência e estratégia

O Emerald Kaizo é um dos mais formidáveis hacks de ROM de Pokémon já concebidos. Embora a tentativa de executar um Nuzlocke aumente exponencialmente o desafio, a vitória continua sendo possível por me

Comentários (2)

0/200

Master Emerald Kaizo Nuzlocke: Guia definitivo de sobrevivência e estratégia

O Emerald Kaizo é um dos mais formidáveis hacks de ROM de Pokémon já concebidos. Embora a tentativa de executar um Nuzlocke aumente exponencialmente o desafio, a vitória continua sendo possível por me

Comentários (2)

0/200

![PaulHill]() PaulHill

PaulHill

12 de Agosto de 2025 à10 07:50:10 WEST

12 de Agosto de 2025 à10 07:50:10 WEST

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

28 de Julho de 2025 à21 02:20:21 WEST

28 de Julho de 2025 à21 02:20:21 WEST

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

Se você deseja manter seus dados privados e evitar contribuir para perfis de terceiros ou conjuntos de treinamento, usar uma IA instalada localmente para sua pesquisa é uma escolha inteligente. Eu tenho usado o Ollama de código aberto no meu sistema Linux, aprimorado com uma extensão de navegador prática para uma experiência mais fluida. Mas quando mudo para o meu MacOS, opto por um aplicativo gratuito e direto chamado Msty.

Também: Como transformar o Ollama de uma ferramenta de terminal em uma IA baseada em navegador com esta extensão gratuita

Msty é versátil, permitindo que você utilize tanto modelos de IA instalados localmente quanto online. Pessoalmente, eu prefiro a opção local para máxima privacidade. O que diferencia o Msty de outras ferramentas do Ollama é sua simplicidade — sem necessidade de contêineres, terminais ou abas adicionais no navegador.

O aplicativo é repleto de recursos que tornam seu uso muito fácil. Você pode executar várias consultas simultaneamente com chats divididos, regenerar respostas do modelo, clonar chats e até adicionar vários modelos. Há uma convocação de dados em tempo real (embora específica do modelo), e você pode criar Pilhas de Conhecimento para treinar seu modelo local com arquivos, pastas, cofres do Obsidian, notas e mais. Além disso, há uma biblioteca de prompts para ajudá-lo a tirar o máximo proveito de suas consultas.

Msty é, sem dúvida, uma das melhores maneiras de interagir com o Ollama. Veja como você pode começar:

Instalando o Msty

O que você vai precisar: Apenas um dispositivo MacOS e o Ollama instalado e em execução. Se você ainda não configurou o Ollama, siga os passos aqui. Não se esqueça de baixar um modelo local também.

Baixe o Instalador

Acesse o site do Msty, clique no menu suspenso Baixar Msty, escolha Mac e, em seguida, selecione Apple Silicon ou Intel com base no seu dispositivo.

Instale o Msty

Assim que o download terminar, clique duas vezes no arquivo e arraste o ícone do Msty para a pasta Aplicativos quando solicitado.

Usando o Msty

Abra o Msty

Inicie o Msty a partir do Launchpad no seu MacOS.

Conecte seu Modelo Local do Ollama

Ao abrir o Msty pela primeira vez, clique em Configurar IA Local. Ele baixará os componentes necessários e configurará tudo para você, incluindo o download de um modelo local diferente do Ollama.

Para vincular o Msty ao Ollama, navegue até Modelos de IA Locais na barra lateral e clique no botão de download ao lado do Llama 3.2. Após o download, selecione-o no menu suspenso de modelos. Para outros modelos, você precisará de uma chave API da sua conta para esse modelo específico. Agora o Msty deve estar conectado ao seu LLM local do Ollama.

Eu prefiro manter o modelo local do Ollama para minhas consultas.

Instruções do Modelo

Um dos meus recursos favoritos no Msty é a capacidade de personalizar as instruções do modelo. Se você precisa que a IA atue como médico, escritor, contador, antropólogo alienígena ou consultor artístico, o Msty tem você coberto.

Para ajustar as instruções do modelo, clique em Editar Instruções do Modelo no centro do aplicativo e, em seguida, clique no pequeno botão de chat à esquerda do ícone de vassoura. No menu suspenso, escolha as instruções que deseja e clique em "Aplicar a este chat" antes de executar sua primeira consulta.

Há muitas instruções de modelo para escolher, ajudando você a refinar suas consultas para necessidades específicas.

Este guia deve ajudá-lo a começar a usar o Msty rapidamente. Comece com o básico e, à medida que se sentir mais confortável com o aplicativo, explore seus recursos mais avançados. É uma ferramenta poderosa que pode realmente aprimorar sua experiência com IA local no MacOS.

Melhores ferramentas de IA para criar infográficos educacionais - Dicas e técnicas de design

No cenário educacional atual, impulsionado pelo digital, os infográficos surgiram como um meio de comunicação transformador que converte informações complexas em formatos visualmente atraentes e facil

Melhores ferramentas de IA para criar infográficos educacionais - Dicas e técnicas de design

No cenário educacional atual, impulsionado pelo digital, os infográficos surgiram como um meio de comunicação transformador que converte informações complexas em formatos visualmente atraentes e facil

Topaz DeNoise AI: a melhor ferramenta de redução de ruído em 2025 - Guia completo

No competitivo mundo da fotografia digital, a nitidez da imagem continua sendo fundamental. Fotógrafos de todos os níveis de habilidade enfrentam o ruído digital que compromete fotos que, de outra for

Topaz DeNoise AI: a melhor ferramenta de redução de ruído em 2025 - Guia completo

No competitivo mundo da fotografia digital, a nitidez da imagem continua sendo fundamental. Fotógrafos de todos os níveis de habilidade enfrentam o ruído digital que compromete fotos que, de outra for

Master Emerald Kaizo Nuzlocke: Guia definitivo de sobrevivência e estratégia

O Emerald Kaizo é um dos mais formidáveis hacks de ROM de Pokémon já concebidos. Embora a tentativa de executar um Nuzlocke aumente exponencialmente o desafio, a vitória continua sendo possível por me

Master Emerald Kaizo Nuzlocke: Guia definitivo de sobrevivência e estratégia

O Emerald Kaizo é um dos mais formidáveis hacks de ROM de Pokémon já concebidos. Embora a tentativa de executar um Nuzlocke aumente exponencialmente o desafio, a vitória continua sendo possível por me

12 de Agosto de 2025 à10 07:50:10 WEST

12 de Agosto de 2025 à10 07:50:10 WEST

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

28 de Julho de 2025 à21 02:20:21 WEST

28 de Julho de 2025 à21 02:20:21 WEST

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0