Aplicación Ollama Local AI Simplifica el Uso en MacOS

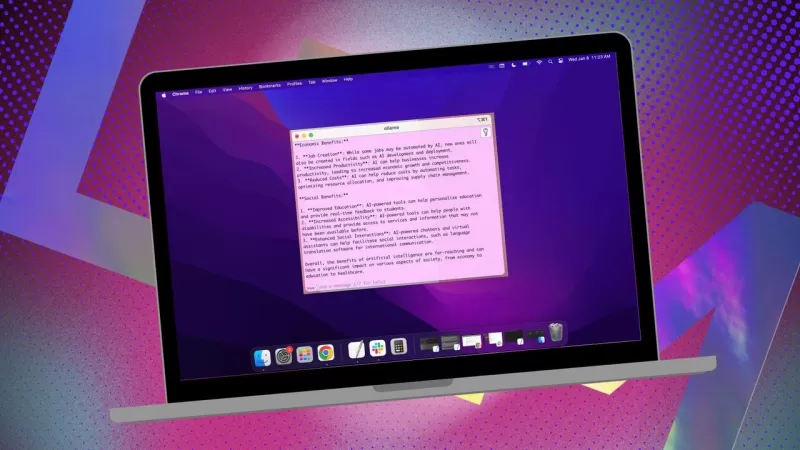

Si buscas mantener tus datos privados y evitar contribuir a perfiles de terceros o conjuntos de entrenamiento, usar una IA instalada localmente para tu investigación es una decisión inteligente. He estado usando Ollama de código abierto en mi sistema Linux, mejorado con una práctica extensión para navegador que hace la experiencia más fluida. Pero cuando cambio a mi MacOS, opto por una aplicación gratuita y sencilla llamada Msty.

También: Cómo convertir Ollama de una herramienta de terminal en una IA basada en navegador con esta extensión gratuita

Msty es versátil, ya que permite aprovechar tanto modelos de IA instalados localmente como en línea. Personalmente, me mantengo con la opción local para máxima privacidad. Lo que distingue a Msty de otras herramientas de Ollama es su simplicidad: no se necesitan contenedores, terminales ni pestañas adicionales en el navegador.

La aplicación está repleta de funciones que la hacen muy fácil de usar. Puedes ejecutar múltiples consultas simultáneamente con chats divididos, regenerar respuestas del modelo, clonar chats e incluso agregar varios modelos. Hay una invocación de datos en tiempo real (aunque es específica del modelo), y puedes crear Knowledge Stacks para entrenar tu modelo local con archivos, carpetas, bóvedas de Obsidian, notas y más. Además, hay una biblioteca de prompts para ayudarte a sacar el máximo provecho de tus consultas.

Msty es, sin duda, una de las mejores formas de interactuar con Ollama. Aquí te explico cómo puedes empezar:

Instalando Msty

Lo que necesitarás: Solo un dispositivo MacOS y Ollama instalado y en ejecución. Si aún no has configurado Ollama, sigue los pasos aquí. No olvides descargar también un modelo local.

Descarga el instalador

Dirígete al sitio web de Msty, haz clic en el desplegable de Descargar Msty, elige Mac y luego selecciona entre Apple Silicon o Intel según tu dispositivo.

Instala Msty

Una vez que termine la descarga, haz doble clic en el archivo y arrastra el ícono de Msty a la carpeta de Aplicaciones cuando se te indique.

Usando Msty

Abre Msty

Inicia Msty desde Launchpad en tu MacOS.

Conecta tu modelo local de Ollama

Cuando abras Msty por primera vez, haz clic en Configurar IA Local. Descargará los componentes necesarios y configurará todo por ti, incluyendo la descarga de un modelo local distinto a Ollama.

Para vincular Msty con Ollama, ve a Modelos de IA Local en la barra lateral y haz clic en el botón de descarga junto a Llama 3.2. Una vez descargado, selecciónalo en el desplegable de modelos. Para otros modelos, necesitarás una clave API de tu cuenta para ese modelo en particular. Ahora Msty debería estar conectado a tu LLM local de Ollama.

Prefiero seguir usando el modelo local de Ollama para mis consultas.

Instrucciones del modelo

Una de mis funciones favoritas en Msty es la capacidad de personalizar las instrucciones del modelo. Ya sea que necesites que la IA actúe como médico, escritor, contador, antropólogo alienígena o asesor artístico, Msty te tiene cubierto.

Para ajustar las instrucciones del modelo, haz clic en Editar Instrucciones del Modelo en el centro de la aplicación, luego presiona el pequeño botón de chat a la izquierda del ícono de la escoba. Desde el menú emergente, elige las instrucciones que deseas y haz clic en "Aplicar a este chat" antes de ejecutar tu primera consulta.

Hay muchas instrucciones de modelo para elegir, lo que te ayuda a refinar tus consultas para necesidades específicas.

Esta guía debería ayudarte a empezar con Msty rápidamente. Comienza con lo básico y, a medida que te sientas más cómodo con la aplicación, explora sus funciones más avanzadas. Es una herramienta poderosa que realmente puede mejorar tu experiencia con IA local en MacOS.

Artículo relacionado

Topaz DeNoise AI: Mejor herramienta de reducción de ruido en 2025 - Guía completa

En el competitivo mundo de la fotografía digital, la claridad de imagen sigue siendo primordial. Fotógrafos de todos los niveles se enfrentan al ruido digital que compromete tomas que de otro modo ser

Topaz DeNoise AI: Mejor herramienta de reducción de ruido en 2025 - Guía completa

En el competitivo mundo de la fotografía digital, la claridad de imagen sigue siendo primordial. Fotógrafos de todos los niveles se enfrentan al ruido digital que compromete tomas que de otro modo ser

Maestro Esmeralda Kaizo Nuzlocke: Guía definitiva de supervivencia y estrategia

Kaizo Esmeralda se erige como uno de los hacks de ROMs de Pokémon más formidables jamás concebidos. Aunque intentar una ejecución Nuzlocke aumenta exponencialmente el desafío, la victoria sigue siendo

Maestro Esmeralda Kaizo Nuzlocke: Guía definitiva de supervivencia y estrategia

Kaizo Esmeralda se erige como uno de los hacks de ROMs de Pokémon más formidables jamás concebidos. Aunque intentar una ejecución Nuzlocke aumenta exponencialmente el desafío, la victoria sigue siendo

Cartas de presentación con IA: Guía de expertos para la presentación de trabajos a revistas

En el competitivo entorno actual de las publicaciones académicas, la elaboración de una carta de presentación eficaz puede marcar la diferencia decisiva en la aceptación de su manuscrito. Descubra cóm

comentario (2)

0/200

Cartas de presentación con IA: Guía de expertos para la presentación de trabajos a revistas

En el competitivo entorno actual de las publicaciones académicas, la elaboración de una carta de presentación eficaz puede marcar la diferencia decisiva en la aceptación de su manuscrito. Descubra cóm

comentario (2)

0/200

![PaulHill]() PaulHill

PaulHill

12 de agosto de 2025 08:50:10 GMT+02:00

12 de agosto de 2025 08:50:10 GMT+02:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

![DouglasMartin]() DouglasMartin

DouglasMartin

28 de julio de 2025 03:20:21 GMT+02:00

28 de julio de 2025 03:20:21 GMT+02:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0

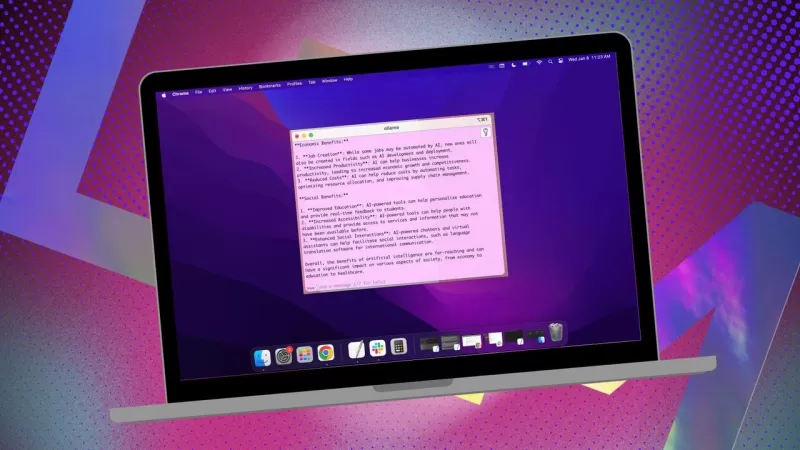

Si buscas mantener tus datos privados y evitar contribuir a perfiles de terceros o conjuntos de entrenamiento, usar una IA instalada localmente para tu investigación es una decisión inteligente. He estado usando Ollama de código abierto en mi sistema Linux, mejorado con una práctica extensión para navegador que hace la experiencia más fluida. Pero cuando cambio a mi MacOS, opto por una aplicación gratuita y sencilla llamada Msty.

También: Cómo convertir Ollama de una herramienta de terminal en una IA basada en navegador con esta extensión gratuita

Msty es versátil, ya que permite aprovechar tanto modelos de IA instalados localmente como en línea. Personalmente, me mantengo con la opción local para máxima privacidad. Lo que distingue a Msty de otras herramientas de Ollama es su simplicidad: no se necesitan contenedores, terminales ni pestañas adicionales en el navegador.

La aplicación está repleta de funciones que la hacen muy fácil de usar. Puedes ejecutar múltiples consultas simultáneamente con chats divididos, regenerar respuestas del modelo, clonar chats e incluso agregar varios modelos. Hay una invocación de datos en tiempo real (aunque es específica del modelo), y puedes crear Knowledge Stacks para entrenar tu modelo local con archivos, carpetas, bóvedas de Obsidian, notas y más. Además, hay una biblioteca de prompts para ayudarte a sacar el máximo provecho de tus consultas.

Msty es, sin duda, una de las mejores formas de interactuar con Ollama. Aquí te explico cómo puedes empezar:

Instalando Msty

Lo que necesitarás: Solo un dispositivo MacOS y Ollama instalado y en ejecución. Si aún no has configurado Ollama, sigue los pasos aquí. No olvides descargar también un modelo local.

Descarga el instalador

Dirígete al sitio web de Msty, haz clic en el desplegable de Descargar Msty, elige Mac y luego selecciona entre Apple Silicon o Intel según tu dispositivo.

Instala Msty

Una vez que termine la descarga, haz doble clic en el archivo y arrastra el ícono de Msty a la carpeta de Aplicaciones cuando se te indique.

Usando Msty

Abre Msty

Inicia Msty desde Launchpad en tu MacOS.

Conecta tu modelo local de Ollama

Cuando abras Msty por primera vez, haz clic en Configurar IA Local. Descargará los componentes necesarios y configurará todo por ti, incluyendo la descarga de un modelo local distinto a Ollama.

Para vincular Msty con Ollama, ve a Modelos de IA Local en la barra lateral y haz clic en el botón de descarga junto a Llama 3.2. Una vez descargado, selecciónalo en el desplegable de modelos. Para otros modelos, necesitarás una clave API de tu cuenta para ese modelo en particular. Ahora Msty debería estar conectado a tu LLM local de Ollama.

Prefiero seguir usando el modelo local de Ollama para mis consultas.

Instrucciones del modelo

Una de mis funciones favoritas en Msty es la capacidad de personalizar las instrucciones del modelo. Ya sea que necesites que la IA actúe como médico, escritor, contador, antropólogo alienígena o asesor artístico, Msty te tiene cubierto.

Para ajustar las instrucciones del modelo, haz clic en Editar Instrucciones del Modelo en el centro de la aplicación, luego presiona el pequeño botón de chat a la izquierda del ícono de la escoba. Desde el menú emergente, elige las instrucciones que deseas y haz clic en "Aplicar a este chat" antes de ejecutar tu primera consulta.

Hay muchas instrucciones de modelo para elegir, lo que te ayuda a refinar tus consultas para necesidades específicas.

Esta guía debería ayudarte a empezar con Msty rápidamente. Comienza con lo básico y, a medida que te sientas más cómodo con la aplicación, explora sus funciones más avanzadas. Es una herramienta poderosa que realmente puede mejorar tu experiencia con IA local en MacOS.

Topaz DeNoise AI: Mejor herramienta de reducción de ruido en 2025 - Guía completa

En el competitivo mundo de la fotografía digital, la claridad de imagen sigue siendo primordial. Fotógrafos de todos los niveles se enfrentan al ruido digital que compromete tomas que de otro modo ser

Topaz DeNoise AI: Mejor herramienta de reducción de ruido en 2025 - Guía completa

En el competitivo mundo de la fotografía digital, la claridad de imagen sigue siendo primordial. Fotógrafos de todos los niveles se enfrentan al ruido digital que compromete tomas que de otro modo ser

Maestro Esmeralda Kaizo Nuzlocke: Guía definitiva de supervivencia y estrategia

Kaizo Esmeralda se erige como uno de los hacks de ROMs de Pokémon más formidables jamás concebidos. Aunque intentar una ejecución Nuzlocke aumenta exponencialmente el desafío, la victoria sigue siendo

Maestro Esmeralda Kaizo Nuzlocke: Guía definitiva de supervivencia y estrategia

Kaizo Esmeralda se erige como uno de los hacks de ROMs de Pokémon más formidables jamás concebidos. Aunque intentar una ejecución Nuzlocke aumenta exponencialmente el desafío, la victoria sigue siendo

Cartas de presentación con IA: Guía de expertos para la presentación de trabajos a revistas

En el competitivo entorno actual de las publicaciones académicas, la elaboración de una carta de presentación eficaz puede marcar la diferencia decisiva en la aceptación de su manuscrito. Descubra cóm

Cartas de presentación con IA: Guía de expertos para la presentación de trabajos a revistas

En el competitivo entorno actual de las publicaciones académicas, la elaboración de una carta de presentación eficaz puede marcar la diferencia decisiva en la aceptación de su manuscrito. Descubra cóm

12 de agosto de 2025 08:50:10 GMT+02:00

12 de agosto de 2025 08:50:10 GMT+02:00

This app sounds like a game-changer for Mac users! I love the idea of keeping my data local with Ollama—privacy is everything these days. 😎 Anyone tried it yet? How’s the setup?

0

0

28 de julio de 2025 03:20:21 GMT+02:00

28 de julio de 2025 03:20:21 GMT+02:00

This app sounds like a game-changer for Mac users wanting to keep their AI local! 😎 I love how it simplifies using Ollama—definitely gonna try it out to keep my data private.

0

0