Resumen y clasificación del artículo de noticias: una inmersión profunda

27 de abril de 2025

27 de abril de 2025

LucasNelson

LucasNelson

0

0

En el mundo de ritmo rápido de hoy, donde la información nos llega desde todas las direcciones, la capacidad de resumir y clasificar los artículos de noticias es más importante que nunca. Este artículo se sumerge en el fascinante mundo de las noticias resumen y clasificación del artículo, explorando las razones comerciales detrás de él, las técnicas utilizadas para preparar datos y los modelos utilizados para lograr resultados precisos y eficientes.

Puntos clave

- Comprender el problema comercial detrás del resumen y clasificación del artículo de noticias.

- Técnicas para recopilar y preprocesar datos de artículos de noticias.

- Uso de modelos de aprendizaje automático para análisis de sentimientos y resumen de texto.

- Implementación del modelo en una aplicación optimista para uso en tiempo real.

- Evaluar el rendimiento del modelo con métricas como las puntuaciones de Bleu y Rouge.

- Utilizando bibliotecas como hermosa sopa, periódico3k y nltk.

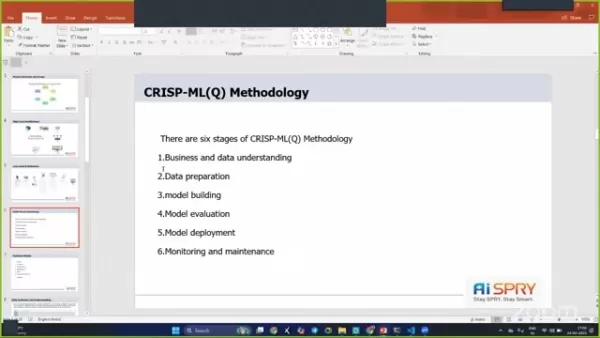

- Implementación de la metodología CRISP-ML (Q) para optimizar el flujo de trabajo del proyecto.

Comprender el resumen y clasificación del artículo de noticias

El problema comercial

El esfuerzo manual requerido para procesar y clasificar los artículos de noticias puede ser abrumador. Imagine esto: estás sentado en tu escritorio, examinando los artículos interminables, tratando de escribir resúmenes únicos y clasificarlos como positivos, negativos o neutrales. Es lento e intensivo en recursos.

Aquí es donde la automatización es útil. Al automatizar el proceso, no solo ahorramos tiempo, sino que también reducimos nuestra dependencia de la mano de obra manual, liberando recursos para otras tareas. El aprendizaje automático interviene para ofrecer soluciones a través de técnicas de resumen de texto y análisis de sentimientos.

Objetivos y limitaciones comerciales

El objetivo principal es minimizar el tiempo dedicado a escribir nuevos artículos y reducir la intervención manual. Esto es crucial para las organizaciones de noticias que necesitan obtener información rápidamente.

Una restricción importante es garantizar la precisión y calidad de los resúmenes y clasificaciones. El sistema automatizado debe capturar la esencia del artículo original mientras clasifica con precisión los sentimientos. El objetivo es crear un sistema que minimice el esfuerzo manual mientras mantiene altos estándares de calidad y confiabilidad.

Al comprender el problema comercial, los objetivos y las limitaciones, podemos abordar el proyecto con un enfoque claro en ofrecer soluciones impactantes. El resumen y la clasificación del artículo de noticias pueden mejorar significativamente la eficiencia y la asignación de recursos.

Arquitectura y descripción general del proyecto

Flujo de proyecto

El proyecto sigue un enfoque estructurado, incorporando varios pasos clave.

- Comprensión del negocio: Comprender las necesidades y objetivos comerciales es la base.

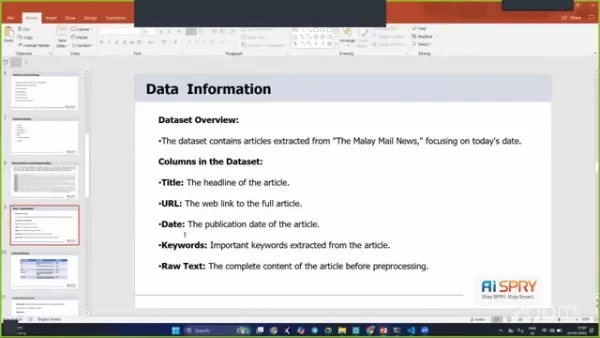

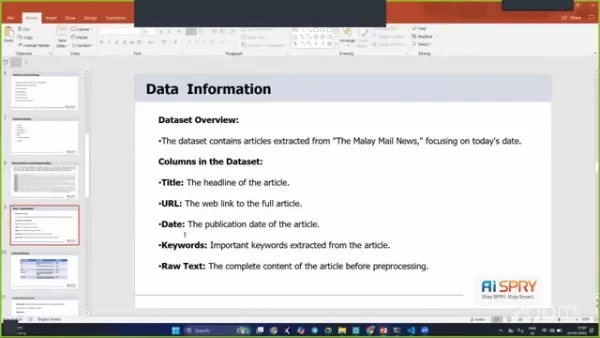

- Recopilación de datos: los datos se obtienen directamente de las URL, centrándose principalmente en artículos de correo malayo y otras fuentes de noticias.

- Preparación de datos: el preprocesamiento de datos es esencial para limpiar y preparar los datos de texto para una capacitación de modelos efectiva.

- Análisis de datos exploratorios (EDA): EDA ayuda a obtener información sobre los datos, identificar patrones y refinar el enfoque.

- Evaluación del modelo: la evaluación rigurosa asegura que los modelos cumplan con los estándares de rendimiento requeridos.

- Implementación del modelo: el paso final implica implementar el modelo, lo que lo hace accesible para el uso en tiempo real.

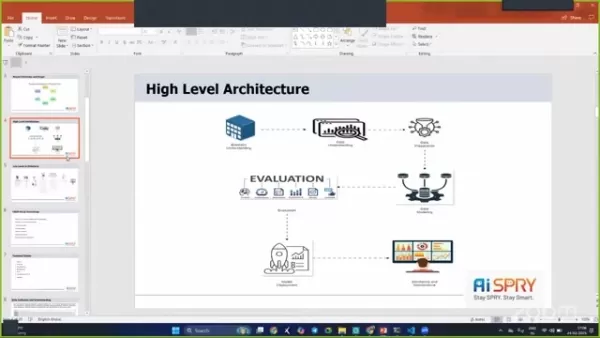

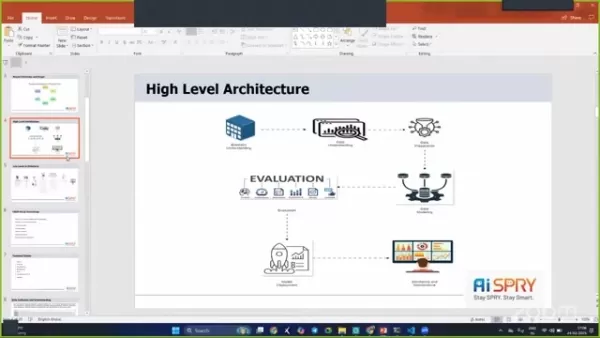

Arquitectura de alto nivel

La arquitectura del proyecto está diseñada para ser robusta y eficiente, incorporando varias etapas para garantizar un funcionamiento sin problemas.

Las etapas incluyen comprensión comercial, comprensión de datos, preparación de datos, modelado de datos, evaluación e implementación.

Pilas y herramientas técnicas utilizadas

Para implementar el proyecto con éxito, se utilizaron varias pilas y herramientas técnicas:

- Python: utilizado para secuencias de comandos y construcción de modelos.

- Streamlit: utilizado para crear la aplicación web.

- Hermosa sopa: utilizado para el raspado web para extraer datos de HTML.

- Periódico3k: una biblioteca avanzada para extraer y analizar artículos de noticias.

- NLTK (Kit de herramientas de lenguaje natural): un conjunto de bibliotecas y programas para el procesamiento simbólico y estadístico del lenguaje natural (PNL) para inglés.

- Transformers (GPT-2): utilizado para tareas de resumen de texto.

- Distilbert: utilizado para el análisis de sentimientos debido a su eficiencia y precisión.

Cómo usar la aplicación de optimización implementada

Raspando y cargando datos

La aplicación desplegada de transmisión permite la interacción directa y el análisis de artículos de noticias.

- Rastreo web: puede iniciar el proceso raspando los datos directamente de Malay Mail u otras fuentes. Esta característica utiliza una hermosa sopa y periódico3k para extraer texto relevante de las URL especificadas.

- Carga de datos: después de raspar, los datos se cargan en la aplicación para su posterior procesamiento.

Realización de resumen de texto y análisis de sentimientos

Una vez que se cargan los datos, puede realizar resumen de texto y otras tareas para obtener el mejor modelo:

- Elija una tarea NLP: dependiendo de sus necesidades, se pueden elegir varias tareas. Las opciones incluyen resumen de texto, modelado de temas y clasificación de texto. El resumen de texto se realiza utilizando GPT-2, proporcionando resúmenes concisos y coherentes.

- Análisis de sentimientos: Los artículos se clasifican en función del sentimiento, positivo, negativo o neutral) utilizando a Distilbert para verificar y determinar la mejor solución para lograr el mejor resultado.

Pros y contras

Pros

- Reduce el esfuerzo manual y el tiempo en el procesamiento de artículos de noticias.

- Proporciona un análisis de sentimiento preciso y resumen de texto.

- Mejora la eficiencia de las organizaciones de noticias.

- Utiliza una arquitectura robusta y modelos avanzados de aprendizaje automático.

Contras

- Requiere recursos computacionales para raspado web, procesamiento de datos y capacitación en modelos.

- La precisión del análisis de sentimientos puede variar según la complejidad del texto.

- Se necesita mantenimiento.

Preguntas frecuentes

¿Cuál es el objetivo principal del resumen y la clasificación del artículo de noticias?

El objetivo principal es reducir el esfuerzo manual y el tiempo involucrado en resumir y clasificar artículos de noticias.

¿Cuáles son las principales herramientas técnicas utilizadas en este proyecto?

Se utilizan Python, Streamlit, Hermosa Sopa, Periódico3K, NLTK, Transformers (GPT-2) y Distilbert.

¿Para qué se usa Distilbert en el proyecto?

Distilbert se usa para el análisis de sentimientos debido a su eficiencia y precisión en la clasificación de artículos como positivos, negativos o neutrales.

¿Cómo se implementa el modelo para uso en tiempo real?

El modelo se implementa en una aplicación a paso a luz, lo que permite a los usuarios interactuar con las herramientas de resumen y clasificación en tiempo real.

¿Cuál es el propósito del preprocesamiento de datos en este proyecto?

El preprocesamiento de datos implica limpiar y preparar datos de texto eliminando caracteres innecesarios, espacios y palabras de parada para mejorar la precisión de los modelos de aprendizaje automático.

Preguntas relacionadas

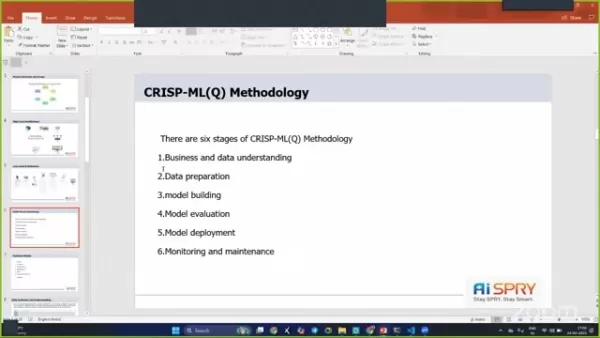

¿Cómo mejora la metodología CRISP-ML (Q) los resultados del proyecto?

La metodología CRISP-ML (Q) garantiza un enfoque estructurado para los proyectos de minería de datos y aprendizaje automático. Ayuda en una mejor comprensión de negocios y datos, una preparación efectiva de datos y una evaluación exhaustiva del modelo, lo que lleva a resultados de proyecto más exitosos. Siguiendo las seis fases, este proyecto está bien organizado y está alineado con los objetivos comerciales.

Artículo relacionado

Master InDesign: use Paste en la función para el diseño gráfico optimizado

Adobe InDesign es una potencia para diseñadores gráficos, repleto de características que pueden transformar sus diseños en obras de arte. Una característica que a menudo es subestimada pero increíblemente potente es la función 'Pegar en'. Esta herramienta le permite soltar imágenes, texto u otros objetos directamente en un pre-E

Master InDesign: use Paste en la función para el diseño gráfico optimizado

Adobe InDesign es una potencia para diseñadores gráficos, repleto de características que pueden transformar sus diseños en obras de arte. Una característica que a menudo es subestimada pero increíblemente potente es la función 'Pegar en'. Esta herramienta le permite soltar imágenes, texto u otros objetos directamente en un pre-E

Presidencia de pato cojo de Biden: ¿Sabotaje o estadista?

A medida que el presidente Joe Biden se acerca al final de su mandato, el panorama político está lleno de especulaciones sobre lo que podría hacer en sus últimas semanas. Etiquetado como un presidente de 'pato cojo', Biden todavía tiene una influencia significativa sobre los asuntos nacionales e internacionales. Esta pieza explora lo crítico

Presidencia de pato cojo de Biden: ¿Sabotaje o estadista?

A medida que el presidente Joe Biden se acerca al final de su mandato, el panorama político está lleno de especulaciones sobre lo que podría hacer en sus últimas semanas. Etiquetado como un presidente de 'pato cojo', Biden todavía tiene una influencia significativa sobre los asuntos nacionales e internacionales. Esta pieza explora lo crítico

AI Generadores de libros electrónicos: las 5 mejores herramientas para el éxito de Amazon KDP

¿Estás ansioso por sumergirte en el mundo de los ingresos en línea creando y vendiendo libros electrónicos? Con el advenimiento de la tecnología AI, el proceso se ha convertido no solo en eficiente sino también increíblemente accesible. Este artículo profundiza en los cinco principales generadores de libros electrónicos de IA que pueden ayudarlo a aprovechar el ingreso pasivo OP

Comentario (0)

0/200

AI Generadores de libros electrónicos: las 5 mejores herramientas para el éxito de Amazon KDP

¿Estás ansioso por sumergirte en el mundo de los ingresos en línea creando y vendiendo libros electrónicos? Con el advenimiento de la tecnología AI, el proceso se ha convertido no solo en eficiente sino también increíblemente accesible. Este artículo profundiza en los cinco principales generadores de libros electrónicos de IA que pueden ayudarlo a aprovechar el ingreso pasivo OP

Comentario (0)

0/200

27 de abril de 2025

27 de abril de 2025

LucasNelson

LucasNelson

0

0

En el mundo de ritmo rápido de hoy, donde la información nos llega desde todas las direcciones, la capacidad de resumir y clasificar los artículos de noticias es más importante que nunca. Este artículo se sumerge en el fascinante mundo de las noticias resumen y clasificación del artículo, explorando las razones comerciales detrás de él, las técnicas utilizadas para preparar datos y los modelos utilizados para lograr resultados precisos y eficientes.

Puntos clave

- Comprender el problema comercial detrás del resumen y clasificación del artículo de noticias.

- Técnicas para recopilar y preprocesar datos de artículos de noticias.

- Uso de modelos de aprendizaje automático para análisis de sentimientos y resumen de texto.

- Implementación del modelo en una aplicación optimista para uso en tiempo real.

- Evaluar el rendimiento del modelo con métricas como las puntuaciones de Bleu y Rouge.

- Utilizando bibliotecas como hermosa sopa, periódico3k y nltk.

- Implementación de la metodología CRISP-ML (Q) para optimizar el flujo de trabajo del proyecto.

Comprender el resumen y clasificación del artículo de noticias

El problema comercial

El esfuerzo manual requerido para procesar y clasificar los artículos de noticias puede ser abrumador. Imagine esto: estás sentado en tu escritorio, examinando los artículos interminables, tratando de escribir resúmenes únicos y clasificarlos como positivos, negativos o neutrales. Es lento e intensivo en recursos.

Aquí es donde la automatización es útil. Al automatizar el proceso, no solo ahorramos tiempo, sino que también reducimos nuestra dependencia de la mano de obra manual, liberando recursos para otras tareas. El aprendizaje automático interviene para ofrecer soluciones a través de técnicas de resumen de texto y análisis de sentimientos.

Objetivos y limitaciones comerciales

El objetivo principal es minimizar el tiempo dedicado a escribir nuevos artículos y reducir la intervención manual. Esto es crucial para las organizaciones de noticias que necesitan obtener información rápidamente.

Una restricción importante es garantizar la precisión y calidad de los resúmenes y clasificaciones. El sistema automatizado debe capturar la esencia del artículo original mientras clasifica con precisión los sentimientos. El objetivo es crear un sistema que minimice el esfuerzo manual mientras mantiene altos estándares de calidad y confiabilidad.

Al comprender el problema comercial, los objetivos y las limitaciones, podemos abordar el proyecto con un enfoque claro en ofrecer soluciones impactantes. El resumen y la clasificación del artículo de noticias pueden mejorar significativamente la eficiencia y la asignación de recursos.

Arquitectura y descripción general del proyecto

Flujo de proyecto

El proyecto sigue un enfoque estructurado, incorporando varios pasos clave.

- Comprensión del negocio: Comprender las necesidades y objetivos comerciales es la base.

- Recopilación de datos: los datos se obtienen directamente de las URL, centrándose principalmente en artículos de correo malayo y otras fuentes de noticias.

- Preparación de datos: el preprocesamiento de datos es esencial para limpiar y preparar los datos de texto para una capacitación de modelos efectiva.

- Análisis de datos exploratorios (EDA): EDA ayuda a obtener información sobre los datos, identificar patrones y refinar el enfoque.

- Evaluación del modelo: la evaluación rigurosa asegura que los modelos cumplan con los estándares de rendimiento requeridos.

- Implementación del modelo: el paso final implica implementar el modelo, lo que lo hace accesible para el uso en tiempo real.

Arquitectura de alto nivel

La arquitectura del proyecto está diseñada para ser robusta y eficiente, incorporando varias etapas para garantizar un funcionamiento sin problemas.

Las etapas incluyen comprensión comercial, comprensión de datos, preparación de datos, modelado de datos, evaluación e implementación.

Pilas y herramientas técnicas utilizadas

Para implementar el proyecto con éxito, se utilizaron varias pilas y herramientas técnicas:

- Python: utilizado para secuencias de comandos y construcción de modelos.

- Streamlit: utilizado para crear la aplicación web.

- Hermosa sopa: utilizado para el raspado web para extraer datos de HTML.

- Periódico3k: una biblioteca avanzada para extraer y analizar artículos de noticias.

- NLTK (Kit de herramientas de lenguaje natural): un conjunto de bibliotecas y programas para el procesamiento simbólico y estadístico del lenguaje natural (PNL) para inglés.

- Transformers (GPT-2): utilizado para tareas de resumen de texto.

- Distilbert: utilizado para el análisis de sentimientos debido a su eficiencia y precisión.

Cómo usar la aplicación de optimización implementada

Raspando y cargando datos

La aplicación desplegada de transmisión permite la interacción directa y el análisis de artículos de noticias.

- Rastreo web: puede iniciar el proceso raspando los datos directamente de Malay Mail u otras fuentes. Esta característica utiliza una hermosa sopa y periódico3k para extraer texto relevante de las URL especificadas.

- Carga de datos: después de raspar, los datos se cargan en la aplicación para su posterior procesamiento.

Realización de resumen de texto y análisis de sentimientos

Una vez que se cargan los datos, puede realizar resumen de texto y otras tareas para obtener el mejor modelo:

- Elija una tarea NLP: dependiendo de sus necesidades, se pueden elegir varias tareas. Las opciones incluyen resumen de texto, modelado de temas y clasificación de texto. El resumen de texto se realiza utilizando GPT-2, proporcionando resúmenes concisos y coherentes.

- Análisis de sentimientos: Los artículos se clasifican en función del sentimiento, positivo, negativo o neutral) utilizando a Distilbert para verificar y determinar la mejor solución para lograr el mejor resultado.

Pros y contras

Pros

- Reduce el esfuerzo manual y el tiempo en el procesamiento de artículos de noticias.

- Proporciona un análisis de sentimiento preciso y resumen de texto.

- Mejora la eficiencia de las organizaciones de noticias.

- Utiliza una arquitectura robusta y modelos avanzados de aprendizaje automático.

Contras

- Requiere recursos computacionales para raspado web, procesamiento de datos y capacitación en modelos.

- La precisión del análisis de sentimientos puede variar según la complejidad del texto.

- Se necesita mantenimiento.

Preguntas frecuentes

¿Cuál es el objetivo principal del resumen y la clasificación del artículo de noticias?

El objetivo principal es reducir el esfuerzo manual y el tiempo involucrado en resumir y clasificar artículos de noticias.

¿Cuáles son las principales herramientas técnicas utilizadas en este proyecto?

Se utilizan Python, Streamlit, Hermosa Sopa, Periódico3K, NLTK, Transformers (GPT-2) y Distilbert.

¿Para qué se usa Distilbert en el proyecto?

Distilbert se usa para el análisis de sentimientos debido a su eficiencia y precisión en la clasificación de artículos como positivos, negativos o neutrales.

¿Cómo se implementa el modelo para uso en tiempo real?

El modelo se implementa en una aplicación a paso a luz, lo que permite a los usuarios interactuar con las herramientas de resumen y clasificación en tiempo real.

¿Cuál es el propósito del preprocesamiento de datos en este proyecto?

El preprocesamiento de datos implica limpiar y preparar datos de texto eliminando caracteres innecesarios, espacios y palabras de parada para mejorar la precisión de los modelos de aprendizaje automático.

Preguntas relacionadas

¿Cómo mejora la metodología CRISP-ML (Q) los resultados del proyecto?

La metodología CRISP-ML (Q) garantiza un enfoque estructurado para los proyectos de minería de datos y aprendizaje automático. Ayuda en una mejor comprensión de negocios y datos, una preparación efectiva de datos y una evaluación exhaustiva del modelo, lo que lleva a resultados de proyecto más exitosos. Siguiendo las seis fases, este proyecto está bien organizado y está alineado con los objetivos comerciales.

Master InDesign: use Paste en la función para el diseño gráfico optimizado

Adobe InDesign es una potencia para diseñadores gráficos, repleto de características que pueden transformar sus diseños en obras de arte. Una característica que a menudo es subestimada pero increíblemente potente es la función 'Pegar en'. Esta herramienta le permite soltar imágenes, texto u otros objetos directamente en un pre-E

Master InDesign: use Paste en la función para el diseño gráfico optimizado

Adobe InDesign es una potencia para diseñadores gráficos, repleto de características que pueden transformar sus diseños en obras de arte. Una característica que a menudo es subestimada pero increíblemente potente es la función 'Pegar en'. Esta herramienta le permite soltar imágenes, texto u otros objetos directamente en un pre-E

Presidencia de pato cojo de Biden: ¿Sabotaje o estadista?

A medida que el presidente Joe Biden se acerca al final de su mandato, el panorama político está lleno de especulaciones sobre lo que podría hacer en sus últimas semanas. Etiquetado como un presidente de 'pato cojo', Biden todavía tiene una influencia significativa sobre los asuntos nacionales e internacionales. Esta pieza explora lo crítico

Presidencia de pato cojo de Biden: ¿Sabotaje o estadista?

A medida que el presidente Joe Biden se acerca al final de su mandato, el panorama político está lleno de especulaciones sobre lo que podría hacer en sus últimas semanas. Etiquetado como un presidente de 'pato cojo', Biden todavía tiene una influencia significativa sobre los asuntos nacionales e internacionales. Esta pieza explora lo crítico

AI Generadores de libros electrónicos: las 5 mejores herramientas para el éxito de Amazon KDP

¿Estás ansioso por sumergirte en el mundo de los ingresos en línea creando y vendiendo libros electrónicos? Con el advenimiento de la tecnología AI, el proceso se ha convertido no solo en eficiente sino también increíblemente accesible. Este artículo profundiza en los cinco principales generadores de libros electrónicos de IA que pueden ayudarlo a aprovechar el ingreso pasivo OP

AI Generadores de libros electrónicos: las 5 mejores herramientas para el éxito de Amazon KDP

¿Estás ansioso por sumergirte en el mundo de los ingresos en línea creando y vendiendo libros electrónicos? Con el advenimiento de la tecnología AI, el proceso se ha convertido no solo en eficiente sino también increíblemente accesible. Este artículo profundiza en los cinco principales generadores de libros electrónicos de IA que pueden ayudarlo a aprovechar el ingreso pasivo OP