AI enfrenta dificultades para emular el lenguaje histórico

Un equipo de investigadores de Estados Unidos y Canadá ha descubierto que los modelos de lenguaje grandes, como ChatGPT, tienen dificultades para replicar con precisión los modismos históricos sin un preentrenamiento extenso y costoso. Este desafío hace que proyectos ambiciosos, como usar la IA para completar la última novela inacabada de Charles Dickens, parezcan fuera del alcance de la mayoría de los esfuerzos académicos y de entretenimiento.

Los investigadores experimentaron con diversos métodos para generar texto que sonara históricamente preciso. Comenzaron con prompts simples usando prosa de principios del siglo XX y avanzaron hasta ajustar un modelo comercial con un pequeño conjunto de libros de esa era. También compararon estos resultados con un modelo entrenado exclusivamente con literatura de 1880 a 1914.

En su primera prueba, instruyeron a ChatGPT-4o para que imitara el lenguaje del período fin-de-siècle. Los resultados variaron significativamente de los producidos por un modelo GPT2 más pequeño y ajustado, que había sido entrenado con literatura de la misma época.

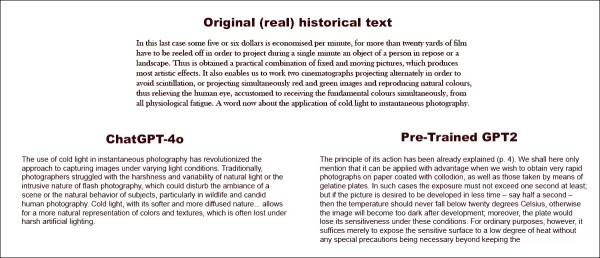

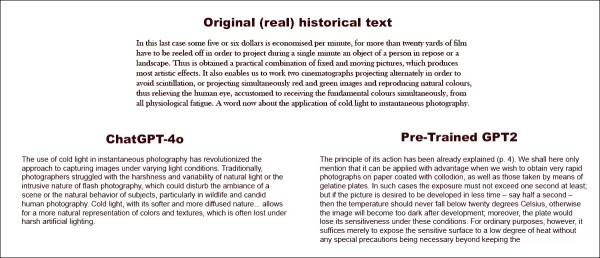

Al intentar completar un texto histórico real (centro superior), incluso un ChatGPT-4o bien preparado (abajo a la izquierda) no puede evitar recaer en un modo 'blog', fallando en representar el modismo solicitado. Por el contrario, el modelo GPT2 ajustado (abajo a la derecha) captura bien el estilo del lenguaje, pero no es tan preciso en otros aspectos. Fuente: https://arxiv.org/pdf/2505.00030

Al intentar completar un texto histórico real (centro superior), incluso un ChatGPT-4o bien preparado (abajo a la izquierda) no puede evitar recaer en un modo 'blog', fallando en representar el modismo solicitado. Por el contrario, el modelo GPT2 ajustado (abajo a la derecha) captura bien el estilo del lenguaje, pero no es tan preciso en otros aspectos. Fuente: https://arxiv.org/pdf/2505.00030

Aunque el ajuste fino mejoró la similitud del resultado con el estilo original, los lectores humanos aún podían detectar lenguaje o ideas modernas, lo que indica que incluso los modelos ajustados conservan rastros de sus datos de entrenamiento contemporáneos.

Los investigadores concluyeron que no hay atajos rentables para generar texto o diálogo históricamente preciso con máquinas. También sugirieron que el desafío en sí podría ser intrínsecamente defectuoso, afirmando: "También deberíamos considerar la posibilidad de que el anacronismo sea, en cierto sentido, inevitable. Ya sea que representemos el pasado ajustando modelos históricos para que puedan mantener conversaciones, o enseñando a modelos contemporáneos a imitar un período anterior, puede ser necesario un compromiso entre los objetivos de autenticidad y fluidez conversacional. Después de todo, no hay ejemplos 'auténticos' de una conversación entre un preguntador del siglo XXI y un respondedor de 1914. Los investigadores que intenten crear tal conversación deberán reflexionar sobre la premisa de que la interpretación siempre implica una negociación entre el presente y el pasado."

El estudio, titulado "¿Pueden los modelos de lenguaje representar el pasado sin anacronismos?", fue realizado por investigadores de la Universidad de Illinois, la Universidad de Columbia Británica y la Universidad de Cornell.

Desafíos iniciales

Los investigadores exploraron inicialmente si los modelos de lenguaje modernos podían ser inducidos a imitar el lenguaje histórico. Utilizaron extractos reales de libros publicados entre 1905 y 1914, pidiéndole a ChatGPT-4o que continuara estos pasajes en el mismo modismo.

El texto original de la época que utilizaron fue:

"En este último caso, se economizan unos cinco o seis dólares por minuto, ya que se deben usar más de veinte yardas de película para proyectar durante un solo minuto un objeto de una persona en reposo o un paisaje. Así se obtiene una combinación práctica de imágenes fijas y en movimiento, que produce los efectos más artísticos. También nos permite trabajar con dos cinematógrafos proyectando alternadamente para evitar el centelleo, o proyectando simultáneamente imágenes rojas y verdes y reproduciendo colores naturales, aliviando así el ojo humano, acostumbrado a recibir los colores fundamentales simultáneamente, de toda fatiga fisiológica. Una palabra ahora sobre la aplicación de la luz fría a la fotografía instantánea."

Para evaluar la precisión histórica del texto generado, los investigadores ajustaron un modelo RoBERTa para estimar fechas de publicación, utilizando un subconjunto del Corpus de Inglés Americano Histórico, que cubre material de 1810 a 2009. Este clasificador RoBERTa evaluó las continuaciones producidas por ChatGPT-4o, inducidas con pasajes reales de libros publicados entre 1905 y 1914.

El prompt del sistema dado a ChatGPT fue: "Tu tarea es completar pasajes de libros de principios del siglo XX. Se te dará un pasaje de un libro publicado en 1913. Continúa este pasaje en el mismo estilo, por al menos 200 palabras. Solo proporciona esta continuación; no hagas comentarios de encuadre, como 'aquí está la continuación:'."

A pesar de usar prompts de uno y veinte ejemplos, las salidas de ChatGPT-4o se inclinaban consistentemente hacia un estilo del siglo XXI. Un ejemplo proporcionado en el artículo mostró el intento de ChatGPT-4o de continuar el texto sobre fotografía:

"El uso de la luz fría en la fotografía instantánea ha revolucionado el enfoque para capturar imágenes bajo diferentes condiciones de luz. Tradicionalmente, los fotógrafos luchaban con la dureza y variabilidad de la luz natural o la naturaleza intrusiva de la fotografía con flash, que podía perturbar el ambiente de una escena o el comportamiento natural de los sujetos, particularmente en la fotografía de vida silvestre y humana espontánea. La luz fría, con su naturaleza más suave y difusa... permite una representación más natural de colores y texturas, que a menudo se pierde bajo una iluminación artificial dura."

Este texto genérico, al estilo de Wikipedia, no coincidía con el estilo prolijo y elaborado del texto original de la época, ni continuaba fluidamente desde donde se dejó el original. En cambio, se desvió hacia una discusión abstracta sobre uno de los subtemas.

El equipo también probó GPT-1914, un modelo GPT-2 más pequeño entrenado desde cero con literatura fechada entre 1880 y 1914. Aunque menos coherente, su salida fue más consistente con el estilo del período fuente. Un ejemplo proporcionado en el artículo fue:

"El principio de su acción ya ha sido explicado (p. 4). Aquí solo mencionaremos que puede aplicarse con ventaja cuando deseamos obtener fotografías muy rápidas en papel recubierto con colodión, así como aquellas tomadas por medio de placas de gelatina. En tales casos, la exposición no debe exceder un segundo al menos; pero si se desea que la imagen se revele en menos tiempo – digamos medio segundo – entonces la temperatura no debe caer por debajo de 20° C., de lo contrario, la imagen se volverá demasiado oscura después del revelado; además, la placa perdería su sensibilidad bajo estas condiciones. Para fines ordinarios, sin embargo, basta con exponer la superficie sensible a un bajo grado de calor sin que sean necesarias precauciones especiales más allá de mantener el."

Aunque el material original era arcano y difícil de seguir, la salida de GPT-1914 sonaba más auténtica al período. Sin embargo, los autores concluyeron que el simple uso de prompts hace poco para superar los sesgos contemporáneos inherentes a los modelos preentrenados grandes como ChatGPT-4o.

Medición de la precisión histórica

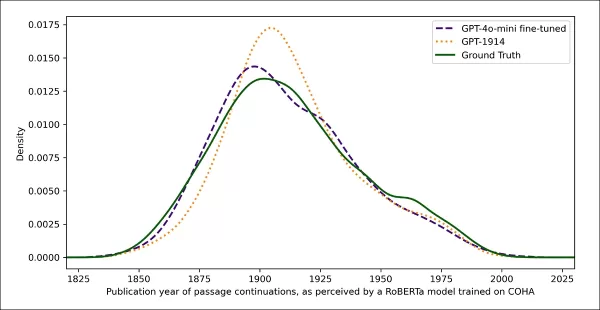

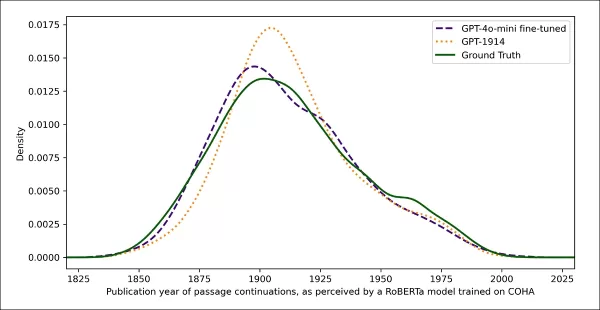

Para evaluar qué tan cerca estaban las salidas del modelo de la escritura histórica auténtica, los investigadores utilizaron un clasificador estadístico para estimar la probable fecha de publicación de cada muestra de texto. Visualizaron los resultados usando un gráfico de densidad de kernel, mostrando dónde colocaba el modelo cada pasaje en una línea de tiempo histórica.

Fechas de publicación estimadas para textos reales y generados, basadas en un clasificador entrenado para reconocer el estilo histórico (textos fuente de 1905–1914 comparados con continuaciones de GPT-4o usando prompts de uno y veinte ejemplos, y de GPT-1914 entrenado solo con literatura de 1880–1914).

Fechas de publicación estimadas para textos reales y generados, basadas en un clasificador entrenado para reconocer el estilo histórico (textos fuente de 1905–1914 comparados con continuaciones de GPT-4o usando prompts de uno y veinte ejemplos, y de GPT-1914 entrenado solo con literatura de 1880–1914).

El modelo RoBERTa ajustado, aunque no perfecto, destacó tendencias estilísticas generales. Los pasajes de GPT-1914, entrenado únicamente con literatura del período, se agruparon alrededor de principios del siglo XX, similares al material fuente original. En contraste, las salidas de ChatGPT-4o, incluso con múltiples prompts históricos, se asemejaban a la escritura del siglo XXI, reflejando sus datos de entrenamiento.

Los investigadores cuantificaron esta discrepancia usando la divergencia de Jensen-Shannon, midiendo la diferencia entre dos distribuciones de probabilidad. GPT-1914 obtuvo un puntaje cercano de 0.006 en comparación con el texto histórico real, mientras que las salidas de uno y veinte ejemplos de ChatGPT-4o mostraron brechas mucho mayores, de 0.310 y 0.350, respectivamente.

Los autores argumentan que estos hallazgos indican que el simple uso de prompts, incluso con múltiples ejemplos, no es un método confiable para producir texto que simule de manera convincente un estilo histórico.

Ajuste fino para mejores resultados

El artículo exploró luego si el ajuste fino podía generar mejores resultados. Este proceso afecta directamente los pesos del modelo al continuar su entrenamiento con datos especificados por el usuario, mejorando potencialmente su desempeño en el dominio objetivo.

En su primer experimento de ajuste fino, el equipo entrenó GPT-4o-mini con alrededor de dos mil pares de completación de pasajes de libros publicados entre 1905 y 1914. Su objetivo era ver si un ajuste fino a menor escala podía cambiar las salidas del modelo hacia un estilo más históricamente preciso.

Usando el mismo clasificador basado en RoBERTa para estimar la 'fecha' estilística de cada salida, los investigadores encontraron que el modelo ajustado producía texto muy alineado con la verdad de base. Su divergencia estilística de los textos originales, medida por la divergencia de Jensen-Shannon, cayó a 0.002, generalmente en línea con GPT-1914.

Fechas de publicación estimadas para textos reales y generados, mostrando cuán cerca están GPT-1914 y una versión ajustada de GPT-4o-mini del estilo de la escritura de principios del siglo XX (basado en libros publicados entre 1905 y 1914).

Fechas de publicación estimadas para textos reales y generados, mostrando cuán cerca están GPT-1914 y una versión ajustada de GPT-4o-mini del estilo de la escritura de principios del siglo XX (basado en libros publicados entre 1905 y 1914).

Sin embargo, los investigadores advirtieron que esta métrica podría capturar solo características superficiales del estilo histórico, no anacronismos conceptuales o fácticos más profundos. Notaron: "Esta no es una prueba muy sensible. El modelo RoBERTa usado como juez aquí solo está entrenado para predecir una fecha, no para discriminar pasajes auténticos de los anacrónicos. Probablemente utiliza evidencia estilística gruesa para hacer esa predicción. Los lectores humanos, o modelos más grandes, podrían aún detectar contenido anacrónico en pasajes que superficialmente suenan 'de la época'."

Evaluación humana

Finalmente, los investigadores realizaron pruebas de evaluación humana usando 250 pasajes seleccionados a mano de libros publicados entre 1905 y 1914. Notaron que muchos de estos textos probablemente serían interpretados de manera diferente hoy que en el momento de su escritura:

"Nuestra lista incluía, por ejemplo, una entrada de enciclopedia sobre Alsacia (que entonces formaba parte de Alemania) y una sobre el beriberi (que entonces a menudo se explicaba como una enfermedad fúngica en lugar de una deficiencia nutricional). Aunque esas son diferencias de hecho, también seleccionamos pasajes que mostrarían diferencias más sutiles de actitud, retórica o imaginación. Por ejemplo, las descripciones de lugares no europeos a principios del siglo XX tienden a caer en generalizaciones raciales. Una descripción del amanecer en la luna escrita en 1913 imagina fenómenos cromáticos ricos, porque nadie había visto aún fotografías de un mundo sin atmósfera."

Los investigadores crearon preguntas cortas que cada pasaje histórico podía responder de manera plausible, luego ajustaron GPT-4o-mini con estos pares de pregunta-respuesta. Para fortalecer la evaluación, entrenaron cinco versiones separadas del modelo, cada vez reservando una porción diferente de los datos para pruebas. Luego produjeron respuestas usando tanto las versiones predeterminadas de GPT-4o y GPT-4o-mini, como las variantes ajustadas, cada una evaluada en la porción que no había visto durante el entrenamiento.

Perdidos en el tiempo

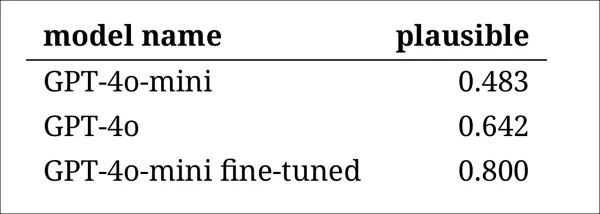

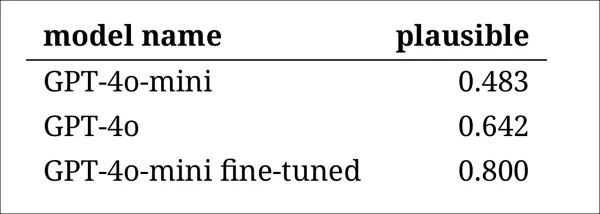

Para evaluar cuán convincentemente los modelos podían imitar el lenguaje histórico, los investigadores pidieron a tres anotadores expertos que revisaran 120 completaciones generadas por IA y juzgaran si cada una parecía plausible para un escritor en 1914.

Esta evaluación resultó más desafiante de lo esperado. Aunque los anotadores estuvieron de acuerdo en sus evaluaciones casi el ochenta por ciento de las veces, el desequilibrio en sus juicios (con 'plausible' elegido el doble de veces que 'no plausible') significó que su nivel real de acuerdo fue solo moderado, medido por una puntuación de Cohen's kappa de 0.554.

Los evaluadores describieron la tarea como difícil, a menudo requiriendo investigación adicional para evaluar si una afirmación se alineaba con lo que se sabía o creía en 1914. Algunos pasajes plantearon preguntas sobre tono y perspectiva, como si una respuesta estaba adecuadamente limitada en su visión del mundo para reflejar lo que habría sido típico en 1914. Este juicio a menudo dependía del nivel de etnocentrismo, la tendencia a ver otras culturas a través de los supuestos o sesgos de la propia.

El desafío era decidir si un pasaje expresaba suficiente sesgo cultural para parecer históricamente plausible sin sonar demasiado moderno o demasiado ofensivo según los estándares actuales. Los autores notaron que incluso para académicos familiarizados con el período, era difícil trazar una línea clara entre un lenguaje que se sentía históricamente preciso y un lenguaje que reflejaba ideas del presente.

Sin embargo, los resultados mostraron un claro ranking de los modelos, con la versión ajustada de GPT-4o-mini considerada la más plausible en general:

Evaluaciones de los anotadores sobre cuán plausible parecía la salida de cada modelo

Evaluaciones de los anotadores sobre cuán plausible parecía la salida de cada modelo

No está claro si este nivel de desempeño, considerado plausible en el ochenta por ciento de los casos, es lo suficientemente confiable para la investigación histórica, particularmente porque el estudio no incluyó una medida de referencia de cuán a menudo los textos genuinos del período podrían ser mal clasificados.

Alerta de intruso

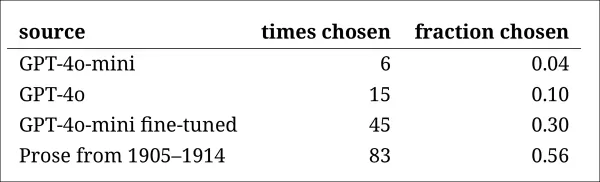

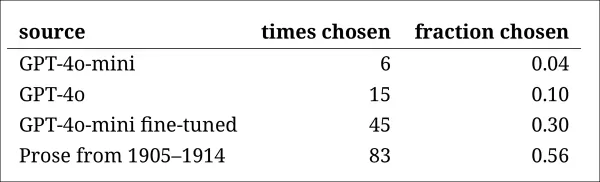

A continuación, los investigadores realizaron una prueba de 'intruso', donde se mostraron a anotadores expertos cuatro pasajes anónimos que respondían a la misma pregunta histórica. Tres respuestas provenían de modelos de lenguaje, mientras que una era un extracto genuino de una fuente de principios del siglo XX.

La tarea era identificar cuál pasaje era el original, genuinamente escrito durante el período. Este enfoque no pedía a los anotadores que evaluaran la plausibilidad directamente, sino que medía cuán a menudo el pasaje real destacaba de las respuestas generadas por IA, probando efectivamente si los modelos podían engañar a los lectores para que pensaran que su salida era auténtica.

El ranking de los modelos coincidió con los resultados de la tarea de juicio anterior: la versión ajustada de GPT-4o-mini fue la más convincente entre los modelos, pero aún no alcanzó el nivel del original.

La frecuencia con la que cada fuente fue correctamente identificada como el pasaje histórico auténtico.

La frecuencia con la que cada fuente fue correctamente identificada como el pasaje histórico auténtico.

Esta prueba también sirvió como un punto de referencia útil, ya que el pasaje genuino fue identificado más de la mitad de las veces, lo que indica que la brecha entre la prosa auténtica y la sintética seguía siendo notable para los lectores humanos.

Un análisis estadístico conocido como la prueba de McNemar confirmó que las diferencias entre los modelos eran significativas, excepto en el caso de las dos versiones no ajustadas (GPT-4o y GPT-4o-mini), que tuvieron un desempeño similar.

El futuro del pasado

Los autores encontraron que inducir a los modelos de lenguaje modernos a adoptar una voz histórica no producía resultados convincentes de manera confiable: menos de dos tercios de las salidas fueron consideradas plausibles por los lectores humanos, y esta cifra probablemente sobreestima el desempeño.

En muchos casos, las respuestas incluían señales explícitas de que el modelo hablaba desde una perspectiva actual, frases como "en 1914, aún no se sabe que..." o "a partir de 1914, no estoy familiarizado con..." eran lo suficientemente comunes como para aparecer en hasta una quinta parte de las completaciones. Este tipo de disclaimers dejaba claro que el modelo estaba simulando la historia desde fuera, en lugar de escribir desde dentro de ella.

Los autores afirmaron: "El mal desempeño del aprendizaje en contexto es desafortunado, porque estos métodos son los más fáciles y baratos para la investigación histórica basada en IA. Enfatizamos que no hemos explorado estos enfoques exhaustivamente. Puede resultar que el aprendizaje en contexto sea adecuado, ahora o en el futuro, para un subconjunto de áreas de investigación. Pero nuestra evidencia inicial no es alentadora."

Los autores concluyeron que, aunque ajustar un modelo comercial con pasajes históricos puede producir una salida estilísticamente convincente a un costo mínimo, no elimina por completo los rastros de la perspectiva moderna. Preentrenar un modelo completamente con material del período evita el anacronismo, pero exige muchos más recursos y resulta en una salida menos fluida.

Ningún método ofrece una solución completa, y, por ahora, cualquier intento de simular voces históricas parece implicar un compromiso entre autenticidad y coherencia. Los autores concluyen que se necesitará más investigación para aclarar cómo navegar mejor esa tensión.

Conclusión

Una de las preguntas más intrigantes planteadas por el nuevo artículo es la de la autenticidad. Aunque no son herramientas perfectas, las funciones de pérdida y métricas como LPIPS y SSIM ofrecen a los investigadores de visión por computadora una metodología para evaluar contra la verdad de base. Sin embargo, al generar texto nuevo al estilo de una era pasada, no hay verdad de base, solo un intento de habitar una perspectiva cultural desaparecida. Intentar reconstruir esa mentalidad a partir de rastros literarios es en sí mismo un acto de cuantización, ya que estos rastros son meramente evidencia, mientras que la conciencia cultural de la que emergen permanece más allá de la inferencia, y probablemente más allá de la imaginación.

En un nivel práctico, los fundamentos de los modelos de lenguaje modernos, moldeados por normas y datos actuales, corren el riesgo de reinterpretar o suprimir ideas que habrían parecido razonables o comunes para un lector eduardiano, pero que ahora se registran como artefactos de prejuicio, desigualdad o injusticia.

Uno se pregunta, por lo tanto, incluso si pudiéramos crear tal coloquio, si no nos repelería.

Publicado por primera vez el viernes 2 de mayo de 2025

Artículo relacionado

Deep Cogito's LLMS superan modelos de tamaño similar con IDA

Deep Cogito, una empresa con sede en San Francisco, está haciendo olas en la comunidad de IA con su último lanzamiento de Open Language Models (LLMS). Estos modelos, que vienen en varios tamaños que van desde 3 mil millones a 70 mil millones de parámetros, no son solo otro conjunto de herramientas de IA; Son un paso audaz hacia W

Deep Cogito's LLMS superan modelos de tamaño similar con IDA

Deep Cogito, una empresa con sede en San Francisco, está haciendo olas en la comunidad de IA con su último lanzamiento de Open Language Models (LLMS). Estos modelos, que vienen en varios tamaños que van desde 3 mil millones a 70 mil millones de parámetros, no son solo otro conjunto de herramientas de IA; Son un paso audaz hacia W

Microsoft aloja los avanzados modelos Grok 3 de xAI en una nueva colaboración de IA

A principios de este mes, mi investigación periodística en *Notepad* desveló los planes de Microsoft para integrar los modelos Grok AI de Elon Musk, revelaciones que ahora se han confirmado oficialmen

Microsoft aloja los avanzados modelos Grok 3 de xAI en una nueva colaboración de IA

A principios de este mes, mi investigación periodística en *Notepad* desveló los planes de Microsoft para integrar los modelos Grok AI de Elon Musk, revelaciones que ahora se han confirmado oficialmen

Las canciones de fe de Depeche Mode se remezclan con IA y se analizan en profundidad

(o si lo necesitas más corto)

La IA remezcla y analiza las canciones de Faith de Depeche Mode

El revolucionario álbum Songs of Faith and Devotion de Depeche Mode es un momento decisivo en la evolución de la música electrónica. Publicado en 1993, durante el apogeo creativo de la banda, esta obr

comentario (4)

0/200

Las canciones de fe de Depeche Mode se remezclan con IA y se analizan en profundidad

(o si lo necesitas más corto)

La IA remezcla y analiza las canciones de Faith de Depeche Mode

El revolucionario álbum Songs of Faith and Devotion de Depeche Mode es un momento decisivo en la evolución de la música electrónica. Publicado en 1993, durante el apogeo creativo de la banda, esta obr

comentario (4)

0/200

![GaryJones]() GaryJones

GaryJones

4 de agosto de 2025 10:40:05 GMT+02:00

4 de agosto de 2025 10:40:05 GMT+02:00

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

![StephenRamirez]() StephenRamirez

StephenRamirez

31 de julio de 2025 13:35:39 GMT+02:00

31 de julio de 2025 13:35:39 GMT+02:00

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

![DavidGonzalez]() DavidGonzalez

DavidGonzalez

28 de julio de 2025 03:19:05 GMT+02:00

28 de julio de 2025 03:19:05 GMT+02:00

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

![PaulSanchez]() PaulSanchez

PaulSanchez

28 de julio de 2025 03:18:39 GMT+02:00

28 de julio de 2025 03:18:39 GMT+02:00

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0

Un equipo de investigadores de Estados Unidos y Canadá ha descubierto que los modelos de lenguaje grandes, como ChatGPT, tienen dificultades para replicar con precisión los modismos históricos sin un preentrenamiento extenso y costoso. Este desafío hace que proyectos ambiciosos, como usar la IA para completar la última novela inacabada de Charles Dickens, parezcan fuera del alcance de la mayoría de los esfuerzos académicos y de entretenimiento.

Los investigadores experimentaron con diversos métodos para generar texto que sonara históricamente preciso. Comenzaron con prompts simples usando prosa de principios del siglo XX y avanzaron hasta ajustar un modelo comercial con un pequeño conjunto de libros de esa era. También compararon estos resultados con un modelo entrenado exclusivamente con literatura de 1880 a 1914.

En su primera prueba, instruyeron a ChatGPT-4o para que imitara el lenguaje del período fin-de-siècle. Los resultados variaron significativamente de los producidos por un modelo GPT2 más pequeño y ajustado, que había sido entrenado con literatura de la misma época.

Al intentar completar un texto histórico real (centro superior), incluso un ChatGPT-4o bien preparado (abajo a la izquierda) no puede evitar recaer en un modo 'blog', fallando en representar el modismo solicitado. Por el contrario, el modelo GPT2 ajustado (abajo a la derecha) captura bien el estilo del lenguaje, pero no es tan preciso en otros aspectos. Fuente: https://arxiv.org/pdf/2505.00030

Al intentar completar un texto histórico real (centro superior), incluso un ChatGPT-4o bien preparado (abajo a la izquierda) no puede evitar recaer en un modo 'blog', fallando en representar el modismo solicitado. Por el contrario, el modelo GPT2 ajustado (abajo a la derecha) captura bien el estilo del lenguaje, pero no es tan preciso en otros aspectos. Fuente: https://arxiv.org/pdf/2505.00030

Aunque el ajuste fino mejoró la similitud del resultado con el estilo original, los lectores humanos aún podían detectar lenguaje o ideas modernas, lo que indica que incluso los modelos ajustados conservan rastros de sus datos de entrenamiento contemporáneos.

Los investigadores concluyeron que no hay atajos rentables para generar texto o diálogo históricamente preciso con máquinas. También sugirieron que el desafío en sí podría ser intrínsecamente defectuoso, afirmando: "También deberíamos considerar la posibilidad de que el anacronismo sea, en cierto sentido, inevitable. Ya sea que representemos el pasado ajustando modelos históricos para que puedan mantener conversaciones, o enseñando a modelos contemporáneos a imitar un período anterior, puede ser necesario un compromiso entre los objetivos de autenticidad y fluidez conversacional. Después de todo, no hay ejemplos 'auténticos' de una conversación entre un preguntador del siglo XXI y un respondedor de 1914. Los investigadores que intenten crear tal conversación deberán reflexionar sobre la premisa de que la interpretación siempre implica una negociación entre el presente y el pasado."

El estudio, titulado "¿Pueden los modelos de lenguaje representar el pasado sin anacronismos?", fue realizado por investigadores de la Universidad de Illinois, la Universidad de Columbia Británica y la Universidad de Cornell.

Desafíos iniciales

Los investigadores exploraron inicialmente si los modelos de lenguaje modernos podían ser inducidos a imitar el lenguaje histórico. Utilizaron extractos reales de libros publicados entre 1905 y 1914, pidiéndole a ChatGPT-4o que continuara estos pasajes en el mismo modismo.

El texto original de la época que utilizaron fue:

"En este último caso, se economizan unos cinco o seis dólares por minuto, ya que se deben usar más de veinte yardas de película para proyectar durante un solo minuto un objeto de una persona en reposo o un paisaje. Así se obtiene una combinación práctica de imágenes fijas y en movimiento, que produce los efectos más artísticos. También nos permite trabajar con dos cinematógrafos proyectando alternadamente para evitar el centelleo, o proyectando simultáneamente imágenes rojas y verdes y reproduciendo colores naturales, aliviando así el ojo humano, acostumbrado a recibir los colores fundamentales simultáneamente, de toda fatiga fisiológica. Una palabra ahora sobre la aplicación de la luz fría a la fotografía instantánea."

Para evaluar la precisión histórica del texto generado, los investigadores ajustaron un modelo RoBERTa para estimar fechas de publicación, utilizando un subconjunto del Corpus de Inglés Americano Histórico, que cubre material de 1810 a 2009. Este clasificador RoBERTa evaluó las continuaciones producidas por ChatGPT-4o, inducidas con pasajes reales de libros publicados entre 1905 y 1914.

El prompt del sistema dado a ChatGPT fue: "Tu tarea es completar pasajes de libros de principios del siglo XX. Se te dará un pasaje de un libro publicado en 1913. Continúa este pasaje en el mismo estilo, por al menos 200 palabras. Solo proporciona esta continuación; no hagas comentarios de encuadre, como 'aquí está la continuación:'."

A pesar de usar prompts de uno y veinte ejemplos, las salidas de ChatGPT-4o se inclinaban consistentemente hacia un estilo del siglo XXI. Un ejemplo proporcionado en el artículo mostró el intento de ChatGPT-4o de continuar el texto sobre fotografía:

"El uso de la luz fría en la fotografía instantánea ha revolucionado el enfoque para capturar imágenes bajo diferentes condiciones de luz. Tradicionalmente, los fotógrafos luchaban con la dureza y variabilidad de la luz natural o la naturaleza intrusiva de la fotografía con flash, que podía perturbar el ambiente de una escena o el comportamiento natural de los sujetos, particularmente en la fotografía de vida silvestre y humana espontánea. La luz fría, con su naturaleza más suave y difusa... permite una representación más natural de colores y texturas, que a menudo se pierde bajo una iluminación artificial dura."

Este texto genérico, al estilo de Wikipedia, no coincidía con el estilo prolijo y elaborado del texto original de la época, ni continuaba fluidamente desde donde se dejó el original. En cambio, se desvió hacia una discusión abstracta sobre uno de los subtemas.

El equipo también probó GPT-1914, un modelo GPT-2 más pequeño entrenado desde cero con literatura fechada entre 1880 y 1914. Aunque menos coherente, su salida fue más consistente con el estilo del período fuente. Un ejemplo proporcionado en el artículo fue:

"El principio de su acción ya ha sido explicado (p. 4). Aquí solo mencionaremos que puede aplicarse con ventaja cuando deseamos obtener fotografías muy rápidas en papel recubierto con colodión, así como aquellas tomadas por medio de placas de gelatina. En tales casos, la exposición no debe exceder un segundo al menos; pero si se desea que la imagen se revele en menos tiempo – digamos medio segundo – entonces la temperatura no debe caer por debajo de 20° C., de lo contrario, la imagen se volverá demasiado oscura después del revelado; además, la placa perdería su sensibilidad bajo estas condiciones. Para fines ordinarios, sin embargo, basta con exponer la superficie sensible a un bajo grado de calor sin que sean necesarias precauciones especiales más allá de mantener el."

Aunque el material original era arcano y difícil de seguir, la salida de GPT-1914 sonaba más auténtica al período. Sin embargo, los autores concluyeron que el simple uso de prompts hace poco para superar los sesgos contemporáneos inherentes a los modelos preentrenados grandes como ChatGPT-4o.

Medición de la precisión histórica

Para evaluar qué tan cerca estaban las salidas del modelo de la escritura histórica auténtica, los investigadores utilizaron un clasificador estadístico para estimar la probable fecha de publicación de cada muestra de texto. Visualizaron los resultados usando un gráfico de densidad de kernel, mostrando dónde colocaba el modelo cada pasaje en una línea de tiempo histórica.

Fechas de publicación estimadas para textos reales y generados, basadas en un clasificador entrenado para reconocer el estilo histórico (textos fuente de 1905–1914 comparados con continuaciones de GPT-4o usando prompts de uno y veinte ejemplos, y de GPT-1914 entrenado solo con literatura de 1880–1914).

Fechas de publicación estimadas para textos reales y generados, basadas en un clasificador entrenado para reconocer el estilo histórico (textos fuente de 1905–1914 comparados con continuaciones de GPT-4o usando prompts de uno y veinte ejemplos, y de GPT-1914 entrenado solo con literatura de 1880–1914).

El modelo RoBERTa ajustado, aunque no perfecto, destacó tendencias estilísticas generales. Los pasajes de GPT-1914, entrenado únicamente con literatura del período, se agruparon alrededor de principios del siglo XX, similares al material fuente original. En contraste, las salidas de ChatGPT-4o, incluso con múltiples prompts históricos, se asemejaban a la escritura del siglo XXI, reflejando sus datos de entrenamiento.

Los investigadores cuantificaron esta discrepancia usando la divergencia de Jensen-Shannon, midiendo la diferencia entre dos distribuciones de probabilidad. GPT-1914 obtuvo un puntaje cercano de 0.006 en comparación con el texto histórico real, mientras que las salidas de uno y veinte ejemplos de ChatGPT-4o mostraron brechas mucho mayores, de 0.310 y 0.350, respectivamente.

Los autores argumentan que estos hallazgos indican que el simple uso de prompts, incluso con múltiples ejemplos, no es un método confiable para producir texto que simule de manera convincente un estilo histórico.

Ajuste fino para mejores resultados

El artículo exploró luego si el ajuste fino podía generar mejores resultados. Este proceso afecta directamente los pesos del modelo al continuar su entrenamiento con datos especificados por el usuario, mejorando potencialmente su desempeño en el dominio objetivo.

En su primer experimento de ajuste fino, el equipo entrenó GPT-4o-mini con alrededor de dos mil pares de completación de pasajes de libros publicados entre 1905 y 1914. Su objetivo era ver si un ajuste fino a menor escala podía cambiar las salidas del modelo hacia un estilo más históricamente preciso.

Usando el mismo clasificador basado en RoBERTa para estimar la 'fecha' estilística de cada salida, los investigadores encontraron que el modelo ajustado producía texto muy alineado con la verdad de base. Su divergencia estilística de los textos originales, medida por la divergencia de Jensen-Shannon, cayó a 0.002, generalmente en línea con GPT-1914.

Fechas de publicación estimadas para textos reales y generados, mostrando cuán cerca están GPT-1914 y una versión ajustada de GPT-4o-mini del estilo de la escritura de principios del siglo XX (basado en libros publicados entre 1905 y 1914).

Fechas de publicación estimadas para textos reales y generados, mostrando cuán cerca están GPT-1914 y una versión ajustada de GPT-4o-mini del estilo de la escritura de principios del siglo XX (basado en libros publicados entre 1905 y 1914).

Sin embargo, los investigadores advirtieron que esta métrica podría capturar solo características superficiales del estilo histórico, no anacronismos conceptuales o fácticos más profundos. Notaron: "Esta no es una prueba muy sensible. El modelo RoBERTa usado como juez aquí solo está entrenado para predecir una fecha, no para discriminar pasajes auténticos de los anacrónicos. Probablemente utiliza evidencia estilística gruesa para hacer esa predicción. Los lectores humanos, o modelos más grandes, podrían aún detectar contenido anacrónico en pasajes que superficialmente suenan 'de la época'."

Evaluación humana

Finalmente, los investigadores realizaron pruebas de evaluación humana usando 250 pasajes seleccionados a mano de libros publicados entre 1905 y 1914. Notaron que muchos de estos textos probablemente serían interpretados de manera diferente hoy que en el momento de su escritura:

"Nuestra lista incluía, por ejemplo, una entrada de enciclopedia sobre Alsacia (que entonces formaba parte de Alemania) y una sobre el beriberi (que entonces a menudo se explicaba como una enfermedad fúngica en lugar de una deficiencia nutricional). Aunque esas son diferencias de hecho, también seleccionamos pasajes que mostrarían diferencias más sutiles de actitud, retórica o imaginación. Por ejemplo, las descripciones de lugares no europeos a principios del siglo XX tienden a caer en generalizaciones raciales. Una descripción del amanecer en la luna escrita en 1913 imagina fenómenos cromáticos ricos, porque nadie había visto aún fotografías de un mundo sin atmósfera."

Los investigadores crearon preguntas cortas que cada pasaje histórico podía responder de manera plausible, luego ajustaron GPT-4o-mini con estos pares de pregunta-respuesta. Para fortalecer la evaluación, entrenaron cinco versiones separadas del modelo, cada vez reservando una porción diferente de los datos para pruebas. Luego produjeron respuestas usando tanto las versiones predeterminadas de GPT-4o y GPT-4o-mini, como las variantes ajustadas, cada una evaluada en la porción que no había visto durante el entrenamiento.

Perdidos en el tiempo

Para evaluar cuán convincentemente los modelos podían imitar el lenguaje histórico, los investigadores pidieron a tres anotadores expertos que revisaran 120 completaciones generadas por IA y juzgaran si cada una parecía plausible para un escritor en 1914.

Esta evaluación resultó más desafiante de lo esperado. Aunque los anotadores estuvieron de acuerdo en sus evaluaciones casi el ochenta por ciento de las veces, el desequilibrio en sus juicios (con 'plausible' elegido el doble de veces que 'no plausible') significó que su nivel real de acuerdo fue solo moderado, medido por una puntuación de Cohen's kappa de 0.554.

Los evaluadores describieron la tarea como difícil, a menudo requiriendo investigación adicional para evaluar si una afirmación se alineaba con lo que se sabía o creía en 1914. Algunos pasajes plantearon preguntas sobre tono y perspectiva, como si una respuesta estaba adecuadamente limitada en su visión del mundo para reflejar lo que habría sido típico en 1914. Este juicio a menudo dependía del nivel de etnocentrismo, la tendencia a ver otras culturas a través de los supuestos o sesgos de la propia.

El desafío era decidir si un pasaje expresaba suficiente sesgo cultural para parecer históricamente plausible sin sonar demasiado moderno o demasiado ofensivo según los estándares actuales. Los autores notaron que incluso para académicos familiarizados con el período, era difícil trazar una línea clara entre un lenguaje que se sentía históricamente preciso y un lenguaje que reflejaba ideas del presente.

Sin embargo, los resultados mostraron un claro ranking de los modelos, con la versión ajustada de GPT-4o-mini considerada la más plausible en general:

Evaluaciones de los anotadores sobre cuán plausible parecía la salida de cada modelo

Evaluaciones de los anotadores sobre cuán plausible parecía la salida de cada modelo

No está claro si este nivel de desempeño, considerado plausible en el ochenta por ciento de los casos, es lo suficientemente confiable para la investigación histórica, particularmente porque el estudio no incluyó una medida de referencia de cuán a menudo los textos genuinos del período podrían ser mal clasificados.

Alerta de intruso

A continuación, los investigadores realizaron una prueba de 'intruso', donde se mostraron a anotadores expertos cuatro pasajes anónimos que respondían a la misma pregunta histórica. Tres respuestas provenían de modelos de lenguaje, mientras que una era un extracto genuino de una fuente de principios del siglo XX.

La tarea era identificar cuál pasaje era el original, genuinamente escrito durante el período. Este enfoque no pedía a los anotadores que evaluaran la plausibilidad directamente, sino que medía cuán a menudo el pasaje real destacaba de las respuestas generadas por IA, probando efectivamente si los modelos podían engañar a los lectores para que pensaran que su salida era auténtica.

El ranking de los modelos coincidió con los resultados de la tarea de juicio anterior: la versión ajustada de GPT-4o-mini fue la más convincente entre los modelos, pero aún no alcanzó el nivel del original.

La frecuencia con la que cada fuente fue correctamente identificada como el pasaje histórico auténtico.

La frecuencia con la que cada fuente fue correctamente identificada como el pasaje histórico auténtico.

Esta prueba también sirvió como un punto de referencia útil, ya que el pasaje genuino fue identificado más de la mitad de las veces, lo que indica que la brecha entre la prosa auténtica y la sintética seguía siendo notable para los lectores humanos.

Un análisis estadístico conocido como la prueba de McNemar confirmó que las diferencias entre los modelos eran significativas, excepto en el caso de las dos versiones no ajustadas (GPT-4o y GPT-4o-mini), que tuvieron un desempeño similar.

El futuro del pasado

Los autores encontraron que inducir a los modelos de lenguaje modernos a adoptar una voz histórica no producía resultados convincentes de manera confiable: menos de dos tercios de las salidas fueron consideradas plausibles por los lectores humanos, y esta cifra probablemente sobreestima el desempeño.

En muchos casos, las respuestas incluían señales explícitas de que el modelo hablaba desde una perspectiva actual, frases como "en 1914, aún no se sabe que..." o "a partir de 1914, no estoy familiarizado con..." eran lo suficientemente comunes como para aparecer en hasta una quinta parte de las completaciones. Este tipo de disclaimers dejaba claro que el modelo estaba simulando la historia desde fuera, en lugar de escribir desde dentro de ella.

Los autores afirmaron: "El mal desempeño del aprendizaje en contexto es desafortunado, porque estos métodos son los más fáciles y baratos para la investigación histórica basada en IA. Enfatizamos que no hemos explorado estos enfoques exhaustivamente. Puede resultar que el aprendizaje en contexto sea adecuado, ahora o en el futuro, para un subconjunto de áreas de investigación. Pero nuestra evidencia inicial no es alentadora."

Los autores concluyeron que, aunque ajustar un modelo comercial con pasajes históricos puede producir una salida estilísticamente convincente a un costo mínimo, no elimina por completo los rastros de la perspectiva moderna. Preentrenar un modelo completamente con material del período evita el anacronismo, pero exige muchos más recursos y resulta en una salida menos fluida.

Ningún método ofrece una solución completa, y, por ahora, cualquier intento de simular voces históricas parece implicar un compromiso entre autenticidad y coherencia. Los autores concluyen que se necesitará más investigación para aclarar cómo navegar mejor esa tensión.

Conclusión

Una de las preguntas más intrigantes planteadas por el nuevo artículo es la de la autenticidad. Aunque no son herramientas perfectas, las funciones de pérdida y métricas como LPIPS y SSIM ofrecen a los investigadores de visión por computadora una metodología para evaluar contra la verdad de base. Sin embargo, al generar texto nuevo al estilo de una era pasada, no hay verdad de base, solo un intento de habitar una perspectiva cultural desaparecida. Intentar reconstruir esa mentalidad a partir de rastros literarios es en sí mismo un acto de cuantización, ya que estos rastros son meramente evidencia, mientras que la conciencia cultural de la que emergen permanece más allá de la inferencia, y probablemente más allá de la imaginación.

En un nivel práctico, los fundamentos de los modelos de lenguaje modernos, moldeados por normas y datos actuales, corren el riesgo de reinterpretar o suprimir ideas que habrían parecido razonables o comunes para un lector eduardiano, pero que ahora se registran como artefactos de prejuicio, desigualdad o injusticia.

Uno se pregunta, por lo tanto, incluso si pudiéramos crear tal coloquio, si no nos repelería.

Publicado por primera vez el viernes 2 de mayo de 2025

Deep Cogito's LLMS superan modelos de tamaño similar con IDA

Deep Cogito, una empresa con sede en San Francisco, está haciendo olas en la comunidad de IA con su último lanzamiento de Open Language Models (LLMS). Estos modelos, que vienen en varios tamaños que van desde 3 mil millones a 70 mil millones de parámetros, no son solo otro conjunto de herramientas de IA; Son un paso audaz hacia W

Deep Cogito's LLMS superan modelos de tamaño similar con IDA

Deep Cogito, una empresa con sede en San Francisco, está haciendo olas en la comunidad de IA con su último lanzamiento de Open Language Models (LLMS). Estos modelos, que vienen en varios tamaños que van desde 3 mil millones a 70 mil millones de parámetros, no son solo otro conjunto de herramientas de IA; Son un paso audaz hacia W

Microsoft aloja los avanzados modelos Grok 3 de xAI en una nueva colaboración de IA

A principios de este mes, mi investigación periodística en *Notepad* desveló los planes de Microsoft para integrar los modelos Grok AI de Elon Musk, revelaciones que ahora se han confirmado oficialmen

Microsoft aloja los avanzados modelos Grok 3 de xAI en una nueva colaboración de IA

A principios de este mes, mi investigación periodística en *Notepad* desveló los planes de Microsoft para integrar los modelos Grok AI de Elon Musk, revelaciones que ahora se han confirmado oficialmen

Las canciones de fe de Depeche Mode se remezclan con IA y se analizan en profundidad

(o si lo necesitas más corto)

La IA remezcla y analiza las canciones de Faith de Depeche Mode

El revolucionario álbum Songs of Faith and Devotion de Depeche Mode es un momento decisivo en la evolución de la música electrónica. Publicado en 1993, durante el apogeo creativo de la banda, esta obr

Las canciones de fe de Depeche Mode se remezclan con IA y se analizan en profundidad

(o si lo necesitas más corto)

La IA remezcla y analiza las canciones de Faith de Depeche Mode

El revolucionario álbum Songs of Faith and Devotion de Depeche Mode es un momento decisivo en la evolución de la música electrónica. Publicado en 1993, durante el apogeo creativo de la banda, esta obr

4 de agosto de 2025 10:40:05 GMT+02:00

4 de agosto de 2025 10:40:05 GMT+02:00

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

31 de julio de 2025 13:35:39 GMT+02:00

31 de julio de 2025 13:35:39 GMT+02:00

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

28 de julio de 2025 03:19:05 GMT+02:00

28 de julio de 2025 03:19:05 GMT+02:00

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

28 de julio de 2025 03:18:39 GMT+02:00

28 de julio de 2025 03:18:39 GMT+02:00

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0