AI가 역사적 언어를 모방하는 데 어려움을 겪는다

미국과 캐나다의 연구자 팀은 ChatGPT와 같은 대형 언어 모델이 광범위하고 비용이 많이 드는 사전 학습 없이는 역사적 관용구를 정확히 재현하는 데 어려움을 겪는다는 것을 발견했습니다. 이 도전 과제는 AI를 사용해 찰스 디킨스의 마지막 미완성 소설을 완성하는 것과 같은 야심찬 프로젝트를 학술 및 엔터테인먼트 분야에서 대부분 실현 불가능하게 만듭니다.

연구자들은 역사적으로 정확한 텍스트를 생성하기 위해 다양한 방법을 실험했습니다. 그들은 20세기 초의 산문을 사용한 간단한 프롬프트로 시작해, 그 시대의 소규모 도서 세트로 상용 모델을 미세 조정했습니다. 또한 1880년에서 1914년까지의 문학만으로 훈련된 모델과 비교했습니다.

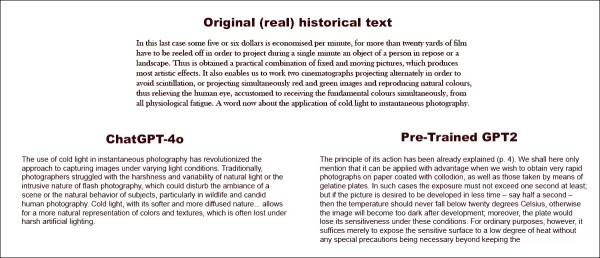

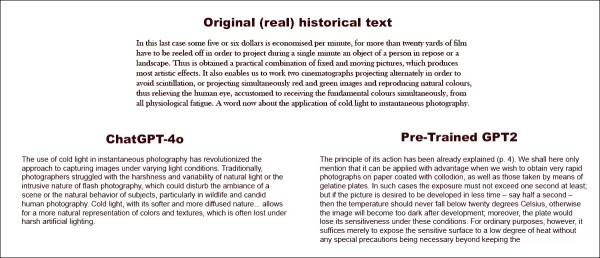

첫 번째 테스트에서 그들은 ChatGPT-4o에 fin-de-siècle 시대의 언어를 모방하도록 지시했습니다. 결과는 같은 시기의 문학으로 훈련된 더 작은 미세 조정 GPT2 모델과 크게 달랐습니다.

실제 역사적 텍스트(상단 중앙)를 완성하도록 요청받았을 때, 잘 준비된 ChatGPT-4o(좌측 하단)조차도 '블로그' 모드로 되돌아가 요청된 관용구를 표현하지 못합니다. 반면, 미세 조정된 GPT2 모델(우측 하단)은 언어 스타일을 잘 포착하지만 다른 면에서는 정확도가 떨어집니다. 출처: https://arxiv.org/pdf/2505.00030

실제 역사적 텍스트(상단 중앙)를 완성하도록 요청받았을 때, 잘 준비된 ChatGPT-4o(좌측 하단)조차도 '블로그' 모드로 되돌아가 요청된 관용구를 표현하지 못합니다. 반면, 미세 조정된 GPT2 모델(우측 하단)은 언어 스타일을 잘 포착하지만 다른 면에서는 정확도가 떨어집니다. 출처: https://arxiv.org/pdf/2505.00030

미세 조정은 출력이 원래 스타일과 유사해지도록 개선했지만, 인간 독자는 여전히 현대 언어나 아이디어를 감지할 수 있었으며, 이는 조정된 모델도 현대 훈련 데이터의 흔적을 유지한다는 것을 나타냅니다.

연구자들은 기계로 역사적으로 정확한 텍스트나 대화를 생성하는 비용 효율적인 지름길이 없다고 결론지었습니다. 또한 이 도전 자체가 본질적으로 결함이 있을 수 있다고 제안하며, "아나크로니즘은 어느 정도 불가피할 가능성을 고려해야 합니다. 과거를 대화로 표현하기 위해 역사적 모델을 지시 조정하거나, 현대 모델이 더 오래된 시대를 흉내 내도록 가르치든, 진정성과 대화 유창성의 목표 사이에 어느 정도 타협이 필요할 수 있습니다. 결국, 21세기 질문자와 1914년 응답자 간의 대화에 대한 '진정한' 예시는 존재하지 않습니다. 이러한 대화를 만들려는 연구자들은 해석이 항상 현재와 과거 간의 협상을 포함한다는 전제를 반영해야 합니다."

이 연구는 "언어 모델이 아나크로니즘 없이 과거를 표현할 수 있는가?"라는 제목으로 일리노이 대학교, 브리티시 컬럼비아 대학교, 코넬 대학교의 연구자들이 수행했습니다.

초기 도전 과제

연구자들은 현대 언어 모델이 역사적 언어를 모방하도록 프롬프트할 수 있는지 탐구했습니다. 1905년에서 1914년 사이에 출판된 책의 실제 발췌문을 사용해 ChatGPT-4o에 동일한 관용구로 이어나가도록 요청했습니다.

그들이 사용한 원래 시대 텍스트는 다음과 같습니다:

"이 마지막 경우에는 분당 약 5~6달러가 절약되며, 한 사람이나 풍경의 정지된 객체를 단일 분 동안 투사하기 위해 20야드 이상의 필름을 돌려야 합니다. 따라서 고정된 그림과 움직이는 그림의 실제적 조합이 얻어지며, 가장 예술적인 효과를 만듭니다. 또한 두 대의 영화 촬영기를 교대로 투사하여 깜박임을 피하거나, 동시에 빨간색과 녹색 이미지를 투사해 자연스러운 색상을 재현함으로써, 기본 색상을 동시에 수용하는 데 익숙한 인간의 눈을 모든 생리적 피로에서 해방시킵니다. 이제 순간 사진에 냉광을 적용하는 것에 대해 한마디."

생성된 텍스트의 역사적 정확성을 평가하기 위해 연구자들은 1810년에서 2009년까지의 자료를 포함한 Corpus of Historical American English의 하위 집합을 사용해 RoBERTa 모델을 미세 조정하여 출판 날짜를 추정했습니다. 이 RoBERTa 분류기는 1905년에서 1914년 사이에 출판된 책의 실제 구절로 프롬프트된 ChatGPT-4o가 생성한 연속 구절을 평가했습니다.

ChatGPT에 주어진 시스템 프롬프트는 다음과 같습니다: "당신의 과제는 20세기 초의 책 구절을 완성하는 것입니다. 1913년에 출판된 책의 구절이 주어집니다. 동일한 스타일로 최소 200단어로 이 구절을 이어가세요. '여기 연속입니다:'와 같은 프레임 발언은 하지 마세요."

1-shot 및 20-shot 프롬프트를 사용했음에도 불구하고, ChatGPT-4o의 출력은 지속적으로 21세기 스타일로 기울었습니다. 논문에 제공된 예시는 ChatGPT-4o가 사진 텍스트를 이어가는 시도를 보여줍니다:

"순간 사진에서 냉광의 사용은 다양한 조명 조건에서 이미지를 캡처하는 접근 방식을 혁신했습니다. 전통적으로 사진가들은 자연광의 거칠고 변동성이나 플래시 사진의 침입적 특성으로 어려움을 겪었으며, 이는 장면의 분위기나 야생 동물 및 자연스러운 인간 사진의 자연스러운 행동을 방해할 수 있었습니다. 더 부드럽고 확산된 특성을 가진 냉광은... 색상과 질감의 더 자연스러운 표현을 가능하게 하며, 이는 강한 인공 조명 아래에서 종종 손실됩니다."

이 일반적이고 위키 스타일의 텍스트는 원래 시대 텍스트의 장황하고 정교한 스타일과 일치하지 않았으며, 원문에서 끊긴 곳에서 매끄럽게 이어지지도 않았습니다. 대신, 하위 주제 중 하나에 대한 추상적 논의로 방향을 틀었습니다.

팀은 또한 1880년에서 1914년 사이의 문학으로 처음부터 훈련된 더 작은 GPT-2 모델인 GPT-1914를 테스트했습니다. 덜 일관적이지만, 그 출력은 원래 시대의 스타일과 더 일치했습니다. 논문에 제공된 예시는 다음과 같습니다:

"그 작동 원리는 이미 설명되었습니다(4페이지). 여기서는 단지 콜로디온으로 코팅된 종이에 매우 빠른 사진을 얻고자 할 때나 젤라틴 판으로 촬영할 때 유리하게 적용될 수 있다고만 언급하겠습니다. 이러한 경우 노출은 최소 1초를 초과해서는 안 됩니다; 그러나 사진을 더 짧은 시간, 예를 들어 반초 안에 현상하고 싶다면, 온도는 20°C 이하로 떨어지지 않아야 합니다. 그렇지 않으면 현상 후 이미지가 너무 어두워질 것입니다; 게다가 이러한 조건에서는 판의 감도가 떨어질 것입니다. 그러나 일반적인 목적에서는 민감한 표면을 낮은 열에 노출시키는 것만으로 충분하며, 특별한 주의가 필요하지 않습니다."

원래 자료가 난해하고 따라가기 어려웠지만, GPT-1914의 출력은 더 시대에 맞게 들렸습니다. 그러나 저자들은 간단한 프롬프트로는 ChatGPT-4o와 같은 대규모 사전 학습 모델에 내재된 현대적 편향을 극복하는 데 거의 도움이 되지 않는다고 결론지었습니다.

역사적 정확성 측정

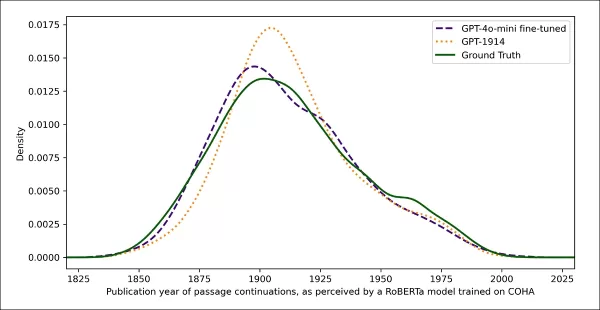

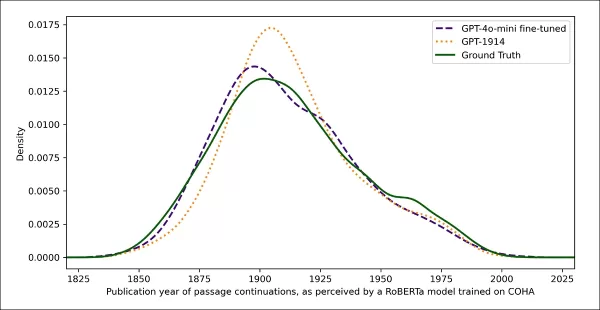

모델 출력이 진정한 역사적 글쓰기와 얼마나 유사한지를 측정하기 위해 연구자들은 각 텍스트 샘플의 출판 가능 날짜를 추정하는 통계 분류기를 사용했습니다. 그들은 커널 밀도 플롯을 사용해 결과를 시각화하여 모델이 각 구절을 역사적 타임라인에 배치한 위치를 보여주었습니다.

실제 및 생성된 텍스트의 추정 출판 날짜로, 역사적 스타일을 인식하도록 훈련된 분류기를 기반으로 합니다(1905–1914년 원본 텍스트와 GPT-4o의 1-shot 및 20-shot 프롬프트로 생성된 연속, 그리고 1880–1914년 문학으로만 훈련된 GPT-1914의 연속 비교).

실제 및 생성된 텍스트의 추정 출판 날짜로, 역사적 스타일을 인식하도록 훈련된 분류기를 기반으로 합니다(1905–1914년 원본 텍스트와 GPT-4o의 1-shot 및 20-shot 프롬프트로 생성된 연속, 그리고 1880–1914년 문학으로만 훈련된 GPT-1914의 연속 비교).

완벽하지는 않지만 미세 조정된 RoBERTa 모델은 일반적인 문체적 경향을 강조했습니다. 시대 문학으로만 훈련된 GPT-1914의 구절은 원본 자료와 유사하게 20세기 초에 집중되었습니다. 반면, 여러 역사적 프롬프트에도 불구하고 ChatGPT-4o의 출력은 그 훈련 데이터를 반영하여 21세기 글쓰기와 유사했습니다.

연구자들은 두 확률 분포 간의 차이를 측정하는 Jensen-Shannon 발산을 사용해 이 불일치를 정량화했습니다. GPT-1914는 실제 역사적 텍스트와 비교해 0.006으로 근소한 차이를 보였으며, ChatGPT-4o의 1-shot 및 20-shot 출력은 각각 0.310과 0.350으로 훨씬 큰 차이를 보였습니다.

저자들은 이러한 결과가 여러 예시를 포함한 프롬프트만으로는 역사적 스타일을 설득력 있게 시뮬레이션하는 텍스트를 생성하는 신뢰할 수 있는 방법이 아니라는 것을 나타낸다고 주장합니다.

더 나은 결과를 위한 미세 조정

논문은 미세 조정이 더 나은 결과를 가져올 수 있는지 탐구했습니다. 이 과정은 사용자가 지정한 데이터로 훈련을 계속함으로써 모델의 가중치에 직접 영향을 미쳐 대상 도메인에서 성능을 잠재적으로 향상시킵니다.

첫 번째 미세 조정 실험에서 팀은 1905년에서 1914년 사이에 출판된 책에서 약 2천 개의 구절 완성 쌍으로 GPT-4o-mini를 훈련시켰습니다. 소규모 미세 조정이 모델의 출력을 더 역사적으로 정확한 스타일로 전환할 수 있는지 확인하려 했습니다.

각 출력의 문체적 '날짜'를 추정하기 위해 동일한 RoBERTa 기반 분류기를 사용한 결과, 미세 조정된 모델은 원본 텍스트와 밀접하게 정렬된 텍스트를 생성했습니다. Jensen-Shannon 발산으로 측정한 원본 텍스트와의 문체적 차이는 0.002로 떨어졌으며, 이는 GPT-1914와 대체로 일치했습니다.

실제 및 생성된 텍스트의 추정 출판 날짜로, GPT-1914와 미세 조정된 GPT-4o-mini가 20세기 초 글쓰기 스타일(1905–1914년 출판된 책 기반)과 얼마나 밀접하게 일치하는지 보여줍니다.

실제 및 생성된 텍스트의 추정 출판 날짜로, GPT-1914와 미세 조정된 GPT-4o-mini가 20세기 초 글쓰기 스타일(1905–1914년 출판된 책 기반)과 얼마나 밀접하게 일치하는지 보여줍니다.

그러나 연구자들은 이 지표가 역사적 스타일의 표면적 특징만 포착할 수 있으며, 더 깊은 개념적 또는 사실적 아나크로니즘은 포착하지 못할 수 있다고 경고했습니다. 그들은 "이것은 매우 민감한 테스트가 아닙니다. 여기서 판단자로 사용된 RoBERTa 모델은 날짜를 예측하도록 훈련된 것일 뿐, 진정한 구절과 아나크로니즘적인 구절을 구별하도록 훈련되지 않았습니다. 아마도 거친 문체적 증거를 사용해 예측을 합니다. 인간 독자나 더 큰 모델은 표면적으로 '시대에 맞는' 구절에서 아나크로니즘적인 내용을 여전히 감지할 수 있습니다."

인간 평가

마지막으로, 연구자들은 1905년에서 1914년 사이에 출판된 책에서 손으로 선별한 250개의 구절을 사용해 인간 평가 테스트를 수행했습니다. 그들은 이러한 텍스트의 많은 부분이 작성 당시와 오늘날 다르게 해석될 가능성이 있다고 언급했습니다:

"우리 목록에는 예를 들어, 당시 독일의 일부였던 알자스에 대한 백과사전 항목과 베리베리(당시 종종 영양 결핍이 아닌 곰팡이 질병으로 설명됨)에 대한 항목이 포함되었습니다. 이는 사실의 차이이지만, 우리는 또한 태도, 수사학, 상상력의 미묘한 차이를 보여줄 구절을 선택했습니다. 예를 들어, 20세기 초 비유럽 지역에 대한 묘사는 인종적 일반화로 미끄러지는 경향이 있습니다. 1913년에 작성된 달에서의 일출 묘사는 대기가 없는 세계의 사진을 아직 본 사람이 없었기 때문에 풍부한 색채 현상을 상상했습니다."

연구자들은 각 역사적 구절이 그럴듯하게 답변할 수 있는 짧은 질문을 만들어, 이러한 질문-답변 쌍으로 GPT-4o-mini를 미세 조정했습니다. 평가를 강화하기 위해 데이터를 다섯 부분으로 나누어 각기 다른 부분을 테스트 데이터로 제외하며 다섯 개의 별도 모델 버전을 훈련시켰습니다. 그들은 GPT-4o와 GPT-4o-mini의 기본 버전과 미세 조정된 변형을 사용해 각기 훈련에서 보지 않은 부분에 대해 응답을 생성했습니다.

시간 속에서 길을 잃다

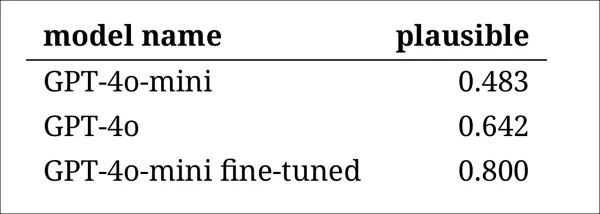

모델이 역사적 언어를 얼마나 설득력 있게 모방할 수 있는지 평가하기 위해 연구자들은 세 명의 전문 주석자에게 AI가 생성한 120개의 완성문을 검토하고 각 완성문이 1914년의 작가에게 그럴듯해 보이는지 판단하도록 요청했습니다.

이 평가는 예상보다 더 어려웠습니다. 주석자들이 거의 80%의 시간 동안 평가에 동의했지만, 판단의 불균형('그럴듯하다'가 '그럴듯하지 않다'보다 두 배 더 자주 선택됨)으로 인해 실제 동의 수준은 Cohen의 kappa 점수 0.554로 중간 정도에 불과했습니다.

주석자들은 이 작업이 어렵다고 설명했으며, 종종 진술이 1914년에 알려졌거나 믿어진 것과 일치하는지 평가하기 위해 추가 연구가 필요했습니다. 일부 구절은 톤과 관점에 대한 질문을 제기했으며, 예를 들어 응답이 1914년에 전형적이었을 세계관으로 적절히 제한되었는지 여부가 있었습니다. 이 판단은 종종 민족 중심주의, 즉 자신의 가정이나 편견을 통해 다른 문화를 보는 경향의 수준에 달려 있었습니다.

도전은 구절이 역사적으로 그럴듯하게 들리도록 충분한 문화적 편향을 표현하면서도 오늘날의 기준으로 너무 현대적이거나 지나치게 공격적이지 않도록 하는 것이었습니다. 저자들은 시대에 익숙한 학자들에게도 역사적으로 정확한 언어와 현대적 아이디어를 반영하는 언어 사이에 명확한 선을 긋는 것이 어렵다고 언급했습니다.

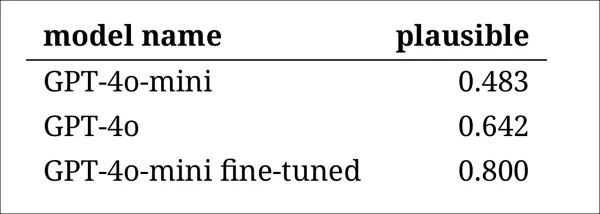

그럼에도 불구하고 결과는 모델의 명확한 순위를 보여주었으며, 미세 조정된 GPT-4o-mini가 전체적으로 가장 그럴듯하다고 평가되었습니다:

주석자들이 각 모델의 출력이 얼마나 그럴듯해 보이는지에 대한 평가

주석자들이 각 모델의 출력이 얼마나 그럴듯해 보이는지에 대한 평가

80%의 경우에서 그럴듯하다고 평가된 이 성능 수준이 역사적 연구에 충분히 신뢰할 만한지는 불분명하며, 특히 연구가 진정한 시대 텍스트가 얼마나 자주 잘못 분류될지에 대한 기준선을 포함하지 않았기 때문입니다.

침입자 경고

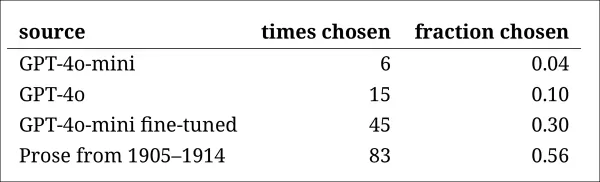

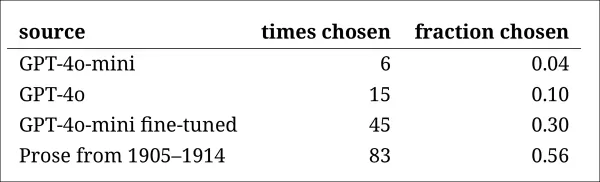

다음으로, 연구자들은 전문 주석자들에게 동일한 역사적 질문에 답하는 네 개의 익명 구절을 보여주는 '침입자 테스트'를 수행했습니다. 세 개의 응답은 언어 모델에서 왔으며, 하나는 20세기 초 소스에서 나온 진정한 발췌문이었습니다.

과제는 어느 구절이 그 시대에 실제로 작성된 원본인지 식별하는 것이었습니다. 이 접근법은 주석자들에게 직접 그럴듯함을 평가하도록 요청하지 않았지만, 실제 구절이 AI 생성 응답과 얼마나 구별되는지를 측정하여 모델이 출력이 진짜로 보이도록 독자를 속일 수 있는지 효과적으로 테스트했습니다.

모델의 순위는 이전 판단 작업의 결과와 일치했습니다: 미세 조정된 GPT-4o-mini는 모델 중 가장 설득력 있었지만 여전히 진짜에는 미치지 못했습니다.

각 소스가 진정한 역사적 구절로 올바르게 식별된 빈도

각 소스가 진정한 역사적 구절로 올바르게 식별된 빈도

이 테스트는 진정한 구절이 절반 이상의 시간 동안 식별되었기 때문에 유용한 기준선 역할을 했으며, 이는 진정한 산문과 합성 산문 사이의 간극이 인간 독자에게 여전히 눈에 띄었음을 나타냅니다.

McNemar의 테스트로 알려진 통계 분석은 두 개의 미조정 버전(GPT-4o와 GPT-4o-mini)이 유사하게 수행한 경우를 제외하고 모델 간의 차이가 의미 있음을 확인했습니다.

과거의 미래

저자들은 현대 언어 모델에 역사적 목소리를 채택하도록 프롬프트하는 것이 설득력 있는 결과를 신뢰할 수 있게 생성하지 못했다고 발견했습니다: 출력의 3분의 2 미만이 인간 독자에 의해 그럴듯하다고 판단되었으며, 이 수치조차 성능을 과대평가할 가능성이 있습니다.

많은 경우, 응답에는 모델이 현재 관점에서 말하고 있다는 명백한 신호가 포함되었습니다—“1914년에는 아직 알려지지 않았으며...” 또는 “1914년 기준으로, 나는 익숙하지 않습니다...”와 같은 문구가 완성문의 최대 5분의 1에 나타났습니다. 이러한 면책 조항은 모델이 역사 내부에서 쓰는 것이 아니라 외부에서 시뮬레이션하고 있음을 분명히 했습니다.

저자들은 "컨텍스트 내 학습의 낮은 성능은 불행히도 이러한 방법이 AI 기반 역사 연구에 가장 쉽고 저렴하기 때문입니다. 우리는 이러한 접근법을 철저히 탐구하지 않았음을 강조합니다. 컨텍스트 내 학습이 현재 또는 미래에 연구 영역의 하위 집합에 적합할 수 있습니다. 하지만 우리의 초기 증거는 고무적이지 않습니다."

저자들은 상용 모델을 역사적 구절로 미세 조정하면 최소 비용으로 문체적으로 설득력 있는 출력을 생성할 수 있지만, 현대적 관점의 흔적을 완전히 제거하지는 못한다고 결론지었습니다. 시대 자료로만 완전히 사전 훈련된 모델은 아나크로니즘을 피하지만 훨씬 더 많은 자원을 요구하며 덜 유창한 출력을 생성합니다.

두 방법 모두 완전한 해결책을 제공하지 않으며, 현재로서는 역사적 목소리를 시뮬레이션하려는 모든 시도는 진정성과 일관성 사이의 절충을 포함하는 것으로 보입니다. 저자들은 이 긴장을 가장 잘 탐색하는 방법을 명확히 하기 위해 추가 연구가 필요하다고 결론지었습니다.

결론

새로운 논문에서 제기된 가장 흥미로운 질문 중 하나는 진정성에 관한 것입니다. 완벽한 도구는 아니지만, LPIPS 및 SSIM과 같은 손실 함수와 지표는 컴퓨터 비전 연구자들에게 진실에 대한 평가 방법을 제공합니다. 그러나 지난 시대의 스타일로 새 텍스트를 생성할 때는 진실이 없으며, 사라진 문화적 관점을 점유하려는 시도만 있습니다. 문학적 흔적에서 그 사고방식을 재구성하는 것은 그 자체로 양자화의 행위이며, 이러한 흔적은 단지 증거일 뿐이며, 그로부터 나온 문화적 의식은 추론을 넘어, 아마도 상상을 초월할 것입니다.

실제적으로, 현대 언어 모델의 기반은 현재의 규범과 데이터에 의해 형성되어, 에드워드 시대 독자에게는 합리적이거나 평범해 보였을 아이디어가 지금은 편견, 불평등, 불공정의 유물로 등록될 위험을 재해석하거나 억제합니다.

따라서 우리가 그러한 대화를 만들 수 있다고 해도, 그것이 우리를 거부하지 않을까 하는 궁금증이 생깁니다.

2025년 5월 2일 금요일 첫 출판

관련 기사

Deep Cogito의 LLMS는 IDA를 사용하여 유사한 크기의 모델보다 우수합니다

샌프란시스코에 본사를 둔 Deep Cogito는 AI 커뮤니티에서 최신 Open Lange Language Models (LLM)를 릴리스하여 파도를 만들고 있습니다. 30 억에서 70 억의 매개 변수 범위의 다양한 크기로 제공되는이 모델은 또 다른 AI 도구 세트가 아닙니다. 그들은 w를 향한 대담한 단계입니다

Deep Cogito의 LLMS는 IDA를 사용하여 유사한 크기의 모델보다 우수합니다

샌프란시스코에 본사를 둔 Deep Cogito는 AI 커뮤니티에서 최신 Open Lange Language Models (LLM)를 릴리스하여 파도를 만들고 있습니다. 30 억에서 70 억의 매개 변수 범위의 다양한 크기로 제공되는이 모델은 또 다른 AI 도구 세트가 아닙니다. 그들은 w를 향한 대담한 단계입니다

실시간 AI 동영상, 딥 리서치 및 새로운 기능(120자)을 추가한 Google의 Gemini 앱

Google은 I/O 2025 개발자 컨퍼런스에서 멀티모달 기능을 확장하고 차세대 AI 모델을 도입하며 제품 포트폴리오 전반에 걸쳐 에코시스템 통합을 강화하는 등 Gemini AI의 중요한 개선 사항을 공개했습니다.주요 Gemini 라이브 출시Google은 모든 iOS 및 Android 사용자에게 제미니 라이브의 시각 인식 기능을 공식 출시했습니다. 최첨단

실시간 AI 동영상, 딥 리서치 및 새로운 기능(120자)을 추가한 Google의 Gemini 앱

Google은 I/O 2025 개발자 컨퍼런스에서 멀티모달 기능을 확장하고 차세대 AI 모델을 도입하며 제품 포트폴리오 전반에 걸쳐 에코시스템 통합을 강화하는 등 Gemini AI의 중요한 개선 사항을 공개했습니다.주요 Gemini 라이브 출시Google은 모든 iOS 및 Android 사용자에게 제미니 라이브의 시각 인식 기능을 공식 출시했습니다. 최첨단

어소트 헬스, 환자 커뮤니케이션 자동화를 위한 5,000만 달러 투자 유치

이 거래에 정통한 소식통에 따르면, 전문 진료를 위한 자동화된 환자 커뮤니케이션을 전문으로 하는 신생 AI 의료 스타트업인 Assort Health가 7억 5천만 달러의 가치로 약 5,000만 달러의 시리즈 B 투자를 유치했다고 합니다. 라이트스피드 벤처 파트너스가 주도한 이번 투자는 불과 4개월 전 2,200만 달러 규모의 시리즈 A 라운드에 이은 후속

의견 (4)

0/200

어소트 헬스, 환자 커뮤니케이션 자동화를 위한 5,000만 달러 투자 유치

이 거래에 정통한 소식통에 따르면, 전문 진료를 위한 자동화된 환자 커뮤니케이션을 전문으로 하는 신생 AI 의료 스타트업인 Assort Health가 7억 5천만 달러의 가치로 약 5,000만 달러의 시리즈 B 투자를 유치했다고 합니다. 라이트스피드 벤처 파트너스가 주도한 이번 투자는 불과 4개월 전 2,200만 달러 규모의 시리즈 A 라운드에 이은 후속

의견 (4)

0/200

![GaryJones]() GaryJones

GaryJones

2025년 8월 4일 오후 5시 40분 5초 GMT+09:00

2025년 8월 4일 오후 5시 40분 5초 GMT+09:00

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

![StephenRamirez]() StephenRamirez

StephenRamirez

2025년 7월 31일 오후 8시 35분 39초 GMT+09:00

2025년 7월 31일 오후 8시 35분 39초 GMT+09:00

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

![DavidGonzalez]() DavidGonzalez

DavidGonzalez

2025년 7월 28일 오전 10시 19분 5초 GMT+09:00

2025년 7월 28일 오전 10시 19분 5초 GMT+09:00

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

![PaulSanchez]() PaulSanchez

PaulSanchez

2025년 7월 28일 오전 10시 18분 39초 GMT+09:00

2025년 7월 28일 오전 10시 18분 39초 GMT+09:00

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0

미국과 캐나다의 연구자 팀은 ChatGPT와 같은 대형 언어 모델이 광범위하고 비용이 많이 드는 사전 학습 없이는 역사적 관용구를 정확히 재현하는 데 어려움을 겪는다는 것을 발견했습니다. 이 도전 과제는 AI를 사용해 찰스 디킨스의 마지막 미완성 소설을 완성하는 것과 같은 야심찬 프로젝트를 학술 및 엔터테인먼트 분야에서 대부분 실현 불가능하게 만듭니다.

연구자들은 역사적으로 정확한 텍스트를 생성하기 위해 다양한 방법을 실험했습니다. 그들은 20세기 초의 산문을 사용한 간단한 프롬프트로 시작해, 그 시대의 소규모 도서 세트로 상용 모델을 미세 조정했습니다. 또한 1880년에서 1914년까지의 문학만으로 훈련된 모델과 비교했습니다.

첫 번째 테스트에서 그들은 ChatGPT-4o에 fin-de-siècle 시대의 언어를 모방하도록 지시했습니다. 결과는 같은 시기의 문학으로 훈련된 더 작은 미세 조정 GPT2 모델과 크게 달랐습니다.

실제 역사적 텍스트(상단 중앙)를 완성하도록 요청받았을 때, 잘 준비된 ChatGPT-4o(좌측 하단)조차도 '블로그' 모드로 되돌아가 요청된 관용구를 표현하지 못합니다. 반면, 미세 조정된 GPT2 모델(우측 하단)은 언어 스타일을 잘 포착하지만 다른 면에서는 정확도가 떨어집니다. 출처: https://arxiv.org/pdf/2505.00030

실제 역사적 텍스트(상단 중앙)를 완성하도록 요청받았을 때, 잘 준비된 ChatGPT-4o(좌측 하단)조차도 '블로그' 모드로 되돌아가 요청된 관용구를 표현하지 못합니다. 반면, 미세 조정된 GPT2 모델(우측 하단)은 언어 스타일을 잘 포착하지만 다른 면에서는 정확도가 떨어집니다. 출처: https://arxiv.org/pdf/2505.00030

미세 조정은 출력이 원래 스타일과 유사해지도록 개선했지만, 인간 독자는 여전히 현대 언어나 아이디어를 감지할 수 있었으며, 이는 조정된 모델도 현대 훈련 데이터의 흔적을 유지한다는 것을 나타냅니다.

연구자들은 기계로 역사적으로 정확한 텍스트나 대화를 생성하는 비용 효율적인 지름길이 없다고 결론지었습니다. 또한 이 도전 자체가 본질적으로 결함이 있을 수 있다고 제안하며, "아나크로니즘은 어느 정도 불가피할 가능성을 고려해야 합니다. 과거를 대화로 표현하기 위해 역사적 모델을 지시 조정하거나, 현대 모델이 더 오래된 시대를 흉내 내도록 가르치든, 진정성과 대화 유창성의 목표 사이에 어느 정도 타협이 필요할 수 있습니다. 결국, 21세기 질문자와 1914년 응답자 간의 대화에 대한 '진정한' 예시는 존재하지 않습니다. 이러한 대화를 만들려는 연구자들은 해석이 항상 현재와 과거 간의 협상을 포함한다는 전제를 반영해야 합니다."

이 연구는 "언어 모델이 아나크로니즘 없이 과거를 표현할 수 있는가?"라는 제목으로 일리노이 대학교, 브리티시 컬럼비아 대학교, 코넬 대학교의 연구자들이 수행했습니다.

초기 도전 과제

연구자들은 현대 언어 모델이 역사적 언어를 모방하도록 프롬프트할 수 있는지 탐구했습니다. 1905년에서 1914년 사이에 출판된 책의 실제 발췌문을 사용해 ChatGPT-4o에 동일한 관용구로 이어나가도록 요청했습니다.

그들이 사용한 원래 시대 텍스트는 다음과 같습니다:

"이 마지막 경우에는 분당 약 5~6달러가 절약되며, 한 사람이나 풍경의 정지된 객체를 단일 분 동안 투사하기 위해 20야드 이상의 필름을 돌려야 합니다. 따라서 고정된 그림과 움직이는 그림의 실제적 조합이 얻어지며, 가장 예술적인 효과를 만듭니다. 또한 두 대의 영화 촬영기를 교대로 투사하여 깜박임을 피하거나, 동시에 빨간색과 녹색 이미지를 투사해 자연스러운 색상을 재현함으로써, 기본 색상을 동시에 수용하는 데 익숙한 인간의 눈을 모든 생리적 피로에서 해방시킵니다. 이제 순간 사진에 냉광을 적용하는 것에 대해 한마디."

생성된 텍스트의 역사적 정확성을 평가하기 위해 연구자들은 1810년에서 2009년까지의 자료를 포함한 Corpus of Historical American English의 하위 집합을 사용해 RoBERTa 모델을 미세 조정하여 출판 날짜를 추정했습니다. 이 RoBERTa 분류기는 1905년에서 1914년 사이에 출판된 책의 실제 구절로 프롬프트된 ChatGPT-4o가 생성한 연속 구절을 평가했습니다.

ChatGPT에 주어진 시스템 프롬프트는 다음과 같습니다: "당신의 과제는 20세기 초의 책 구절을 완성하는 것입니다. 1913년에 출판된 책의 구절이 주어집니다. 동일한 스타일로 최소 200단어로 이 구절을 이어가세요. '여기 연속입니다:'와 같은 프레임 발언은 하지 마세요."

1-shot 및 20-shot 프롬프트를 사용했음에도 불구하고, ChatGPT-4o의 출력은 지속적으로 21세기 스타일로 기울었습니다. 논문에 제공된 예시는 ChatGPT-4o가 사진 텍스트를 이어가는 시도를 보여줍니다:

"순간 사진에서 냉광의 사용은 다양한 조명 조건에서 이미지를 캡처하는 접근 방식을 혁신했습니다. 전통적으로 사진가들은 자연광의 거칠고 변동성이나 플래시 사진의 침입적 특성으로 어려움을 겪었으며, 이는 장면의 분위기나 야생 동물 및 자연스러운 인간 사진의 자연스러운 행동을 방해할 수 있었습니다. 더 부드럽고 확산된 특성을 가진 냉광은... 색상과 질감의 더 자연스러운 표현을 가능하게 하며, 이는 강한 인공 조명 아래에서 종종 손실됩니다."

이 일반적이고 위키 스타일의 텍스트는 원래 시대 텍스트의 장황하고 정교한 스타일과 일치하지 않았으며, 원문에서 끊긴 곳에서 매끄럽게 이어지지도 않았습니다. 대신, 하위 주제 중 하나에 대한 추상적 논의로 방향을 틀었습니다.

팀은 또한 1880년에서 1914년 사이의 문학으로 처음부터 훈련된 더 작은 GPT-2 모델인 GPT-1914를 테스트했습니다. 덜 일관적이지만, 그 출력은 원래 시대의 스타일과 더 일치했습니다. 논문에 제공된 예시는 다음과 같습니다:

"그 작동 원리는 이미 설명되었습니다(4페이지). 여기서는 단지 콜로디온으로 코팅된 종이에 매우 빠른 사진을 얻고자 할 때나 젤라틴 판으로 촬영할 때 유리하게 적용될 수 있다고만 언급하겠습니다. 이러한 경우 노출은 최소 1초를 초과해서는 안 됩니다; 그러나 사진을 더 짧은 시간, 예를 들어 반초 안에 현상하고 싶다면, 온도는 20°C 이하로 떨어지지 않아야 합니다. 그렇지 않으면 현상 후 이미지가 너무 어두워질 것입니다; 게다가 이러한 조건에서는 판의 감도가 떨어질 것입니다. 그러나 일반적인 목적에서는 민감한 표면을 낮은 열에 노출시키는 것만으로 충분하며, 특별한 주의가 필요하지 않습니다."

원래 자료가 난해하고 따라가기 어려웠지만, GPT-1914의 출력은 더 시대에 맞게 들렸습니다. 그러나 저자들은 간단한 프롬프트로는 ChatGPT-4o와 같은 대규모 사전 학습 모델에 내재된 현대적 편향을 극복하는 데 거의 도움이 되지 않는다고 결론지었습니다.

역사적 정확성 측정

모델 출력이 진정한 역사적 글쓰기와 얼마나 유사한지를 측정하기 위해 연구자들은 각 텍스트 샘플의 출판 가능 날짜를 추정하는 통계 분류기를 사용했습니다. 그들은 커널 밀도 플롯을 사용해 결과를 시각화하여 모델이 각 구절을 역사적 타임라인에 배치한 위치를 보여주었습니다.

실제 및 생성된 텍스트의 추정 출판 날짜로, 역사적 스타일을 인식하도록 훈련된 분류기를 기반으로 합니다(1905–1914년 원본 텍스트와 GPT-4o의 1-shot 및 20-shot 프롬프트로 생성된 연속, 그리고 1880–1914년 문학으로만 훈련된 GPT-1914의 연속 비교).

실제 및 생성된 텍스트의 추정 출판 날짜로, 역사적 스타일을 인식하도록 훈련된 분류기를 기반으로 합니다(1905–1914년 원본 텍스트와 GPT-4o의 1-shot 및 20-shot 프롬프트로 생성된 연속, 그리고 1880–1914년 문학으로만 훈련된 GPT-1914의 연속 비교).

완벽하지는 않지만 미세 조정된 RoBERTa 모델은 일반적인 문체적 경향을 강조했습니다. 시대 문학으로만 훈련된 GPT-1914의 구절은 원본 자료와 유사하게 20세기 초에 집중되었습니다. 반면, 여러 역사적 프롬프트에도 불구하고 ChatGPT-4o의 출력은 그 훈련 데이터를 반영하여 21세기 글쓰기와 유사했습니다.

연구자들은 두 확률 분포 간의 차이를 측정하는 Jensen-Shannon 발산을 사용해 이 불일치를 정량화했습니다. GPT-1914는 실제 역사적 텍스트와 비교해 0.006으로 근소한 차이를 보였으며, ChatGPT-4o의 1-shot 및 20-shot 출력은 각각 0.310과 0.350으로 훨씬 큰 차이를 보였습니다.

저자들은 이러한 결과가 여러 예시를 포함한 프롬프트만으로는 역사적 스타일을 설득력 있게 시뮬레이션하는 텍스트를 생성하는 신뢰할 수 있는 방법이 아니라는 것을 나타낸다고 주장합니다.

더 나은 결과를 위한 미세 조정

논문은 미세 조정이 더 나은 결과를 가져올 수 있는지 탐구했습니다. 이 과정은 사용자가 지정한 데이터로 훈련을 계속함으로써 모델의 가중치에 직접 영향을 미쳐 대상 도메인에서 성능을 잠재적으로 향상시킵니다.

첫 번째 미세 조정 실험에서 팀은 1905년에서 1914년 사이에 출판된 책에서 약 2천 개의 구절 완성 쌍으로 GPT-4o-mini를 훈련시켰습니다. 소규모 미세 조정이 모델의 출력을 더 역사적으로 정확한 스타일로 전환할 수 있는지 확인하려 했습니다.

각 출력의 문체적 '날짜'를 추정하기 위해 동일한 RoBERTa 기반 분류기를 사용한 결과, 미세 조정된 모델은 원본 텍스트와 밀접하게 정렬된 텍스트를 생성했습니다. Jensen-Shannon 발산으로 측정한 원본 텍스트와의 문체적 차이는 0.002로 떨어졌으며, 이는 GPT-1914와 대체로 일치했습니다.

실제 및 생성된 텍스트의 추정 출판 날짜로, GPT-1914와 미세 조정된 GPT-4o-mini가 20세기 초 글쓰기 스타일(1905–1914년 출판된 책 기반)과 얼마나 밀접하게 일치하는지 보여줍니다.

실제 및 생성된 텍스트의 추정 출판 날짜로, GPT-1914와 미세 조정된 GPT-4o-mini가 20세기 초 글쓰기 스타일(1905–1914년 출판된 책 기반)과 얼마나 밀접하게 일치하는지 보여줍니다.

그러나 연구자들은 이 지표가 역사적 스타일의 표면적 특징만 포착할 수 있으며, 더 깊은 개념적 또는 사실적 아나크로니즘은 포착하지 못할 수 있다고 경고했습니다. 그들은 "이것은 매우 민감한 테스트가 아닙니다. 여기서 판단자로 사용된 RoBERTa 모델은 날짜를 예측하도록 훈련된 것일 뿐, 진정한 구절과 아나크로니즘적인 구절을 구별하도록 훈련되지 않았습니다. 아마도 거친 문체적 증거를 사용해 예측을 합니다. 인간 독자나 더 큰 모델은 표면적으로 '시대에 맞는' 구절에서 아나크로니즘적인 내용을 여전히 감지할 수 있습니다."

인간 평가

마지막으로, 연구자들은 1905년에서 1914년 사이에 출판된 책에서 손으로 선별한 250개의 구절을 사용해 인간 평가 테스트를 수행했습니다. 그들은 이러한 텍스트의 많은 부분이 작성 당시와 오늘날 다르게 해석될 가능성이 있다고 언급했습니다:

"우리 목록에는 예를 들어, 당시 독일의 일부였던 알자스에 대한 백과사전 항목과 베리베리(당시 종종 영양 결핍이 아닌 곰팡이 질병으로 설명됨)에 대한 항목이 포함되었습니다. 이는 사실의 차이이지만, 우리는 또한 태도, 수사학, 상상력의 미묘한 차이를 보여줄 구절을 선택했습니다. 예를 들어, 20세기 초 비유럽 지역에 대한 묘사는 인종적 일반화로 미끄러지는 경향이 있습니다. 1913년에 작성된 달에서의 일출 묘사는 대기가 없는 세계의 사진을 아직 본 사람이 없었기 때문에 풍부한 색채 현상을 상상했습니다."

연구자들은 각 역사적 구절이 그럴듯하게 답변할 수 있는 짧은 질문을 만들어, 이러한 질문-답변 쌍으로 GPT-4o-mini를 미세 조정했습니다. 평가를 강화하기 위해 데이터를 다섯 부분으로 나누어 각기 다른 부분을 테스트 데이터로 제외하며 다섯 개의 별도 모델 버전을 훈련시켰습니다. 그들은 GPT-4o와 GPT-4o-mini의 기본 버전과 미세 조정된 변형을 사용해 각기 훈련에서 보지 않은 부분에 대해 응답을 생성했습니다.

시간 속에서 길을 잃다

모델이 역사적 언어를 얼마나 설득력 있게 모방할 수 있는지 평가하기 위해 연구자들은 세 명의 전문 주석자에게 AI가 생성한 120개의 완성문을 검토하고 각 완성문이 1914년의 작가에게 그럴듯해 보이는지 판단하도록 요청했습니다.

이 평가는 예상보다 더 어려웠습니다. 주석자들이 거의 80%의 시간 동안 평가에 동의했지만, 판단의 불균형('그럴듯하다'가 '그럴듯하지 않다'보다 두 배 더 자주 선택됨)으로 인해 실제 동의 수준은 Cohen의 kappa 점수 0.554로 중간 정도에 불과했습니다.

주석자들은 이 작업이 어렵다고 설명했으며, 종종 진술이 1914년에 알려졌거나 믿어진 것과 일치하는지 평가하기 위해 추가 연구가 필요했습니다. 일부 구절은 톤과 관점에 대한 질문을 제기했으며, 예를 들어 응답이 1914년에 전형적이었을 세계관으로 적절히 제한되었는지 여부가 있었습니다. 이 판단은 종종 민족 중심주의, 즉 자신의 가정이나 편견을 통해 다른 문화를 보는 경향의 수준에 달려 있었습니다.

도전은 구절이 역사적으로 그럴듯하게 들리도록 충분한 문화적 편향을 표현하면서도 오늘날의 기준으로 너무 현대적이거나 지나치게 공격적이지 않도록 하는 것이었습니다. 저자들은 시대에 익숙한 학자들에게도 역사적으로 정확한 언어와 현대적 아이디어를 반영하는 언어 사이에 명확한 선을 긋는 것이 어렵다고 언급했습니다.

그럼에도 불구하고 결과는 모델의 명확한 순위를 보여주었으며, 미세 조정된 GPT-4o-mini가 전체적으로 가장 그럴듯하다고 평가되었습니다:

주석자들이 각 모델의 출력이 얼마나 그럴듯해 보이는지에 대한 평가

주석자들이 각 모델의 출력이 얼마나 그럴듯해 보이는지에 대한 평가

80%의 경우에서 그럴듯하다고 평가된 이 성능 수준이 역사적 연구에 충분히 신뢰할 만한지는 불분명하며, 특히 연구가 진정한 시대 텍스트가 얼마나 자주 잘못 분류될지에 대한 기준선을 포함하지 않았기 때문입니다.

침입자 경고

다음으로, 연구자들은 전문 주석자들에게 동일한 역사적 질문에 답하는 네 개의 익명 구절을 보여주는 '침입자 테스트'를 수행했습니다. 세 개의 응답은 언어 모델에서 왔으며, 하나는 20세기 초 소스에서 나온 진정한 발췌문이었습니다.

과제는 어느 구절이 그 시대에 실제로 작성된 원본인지 식별하는 것이었습니다. 이 접근법은 주석자들에게 직접 그럴듯함을 평가하도록 요청하지 않았지만, 실제 구절이 AI 생성 응답과 얼마나 구별되는지를 측정하여 모델이 출력이 진짜로 보이도록 독자를 속일 수 있는지 효과적으로 테스트했습니다.

모델의 순위는 이전 판단 작업의 결과와 일치했습니다: 미세 조정된 GPT-4o-mini는 모델 중 가장 설득력 있었지만 여전히 진짜에는 미치지 못했습니다.

각 소스가 진정한 역사적 구절로 올바르게 식별된 빈도

각 소스가 진정한 역사적 구절로 올바르게 식별된 빈도

이 테스트는 진정한 구절이 절반 이상의 시간 동안 식별되었기 때문에 유용한 기준선 역할을 했으며, 이는 진정한 산문과 합성 산문 사이의 간극이 인간 독자에게 여전히 눈에 띄었음을 나타냅니다.

McNemar의 테스트로 알려진 통계 분석은 두 개의 미조정 버전(GPT-4o와 GPT-4o-mini)이 유사하게 수행한 경우를 제외하고 모델 간의 차이가 의미 있음을 확인했습니다.

과거의 미래

저자들은 현대 언어 모델에 역사적 목소리를 채택하도록 프롬프트하는 것이 설득력 있는 결과를 신뢰할 수 있게 생성하지 못했다고 발견했습니다: 출력의 3분의 2 미만이 인간 독자에 의해 그럴듯하다고 판단되었으며, 이 수치조차 성능을 과대평가할 가능성이 있습니다.

많은 경우, 응답에는 모델이 현재 관점에서 말하고 있다는 명백한 신호가 포함되었습니다—“1914년에는 아직 알려지지 않았으며...” 또는 “1914년 기준으로, 나는 익숙하지 않습니다...”와 같은 문구가 완성문의 최대 5분의 1에 나타났습니다. 이러한 면책 조항은 모델이 역사 내부에서 쓰는 것이 아니라 외부에서 시뮬레이션하고 있음을 분명히 했습니다.

저자들은 "컨텍스트 내 학습의 낮은 성능은 불행히도 이러한 방법이 AI 기반 역사 연구에 가장 쉽고 저렴하기 때문입니다. 우리는 이러한 접근법을 철저히 탐구하지 않았음을 강조합니다. 컨텍스트 내 학습이 현재 또는 미래에 연구 영역의 하위 집합에 적합할 수 있습니다. 하지만 우리의 초기 증거는 고무적이지 않습니다."

저자들은 상용 모델을 역사적 구절로 미세 조정하면 최소 비용으로 문체적으로 설득력 있는 출력을 생성할 수 있지만, 현대적 관점의 흔적을 완전히 제거하지는 못한다고 결론지었습니다. 시대 자료로만 완전히 사전 훈련된 모델은 아나크로니즘을 피하지만 훨씬 더 많은 자원을 요구하며 덜 유창한 출력을 생성합니다.

두 방법 모두 완전한 해결책을 제공하지 않으며, 현재로서는 역사적 목소리를 시뮬레이션하려는 모든 시도는 진정성과 일관성 사이의 절충을 포함하는 것으로 보입니다. 저자들은 이 긴장을 가장 잘 탐색하는 방법을 명확히 하기 위해 추가 연구가 필요하다고 결론지었습니다.

결론

새로운 논문에서 제기된 가장 흥미로운 질문 중 하나는 진정성에 관한 것입니다. 완벽한 도구는 아니지만, LPIPS 및 SSIM과 같은 손실 함수와 지표는 컴퓨터 비전 연구자들에게 진실에 대한 평가 방법을 제공합니다. 그러나 지난 시대의 스타일로 새 텍스트를 생성할 때는 진실이 없으며, 사라진 문화적 관점을 점유하려는 시도만 있습니다. 문학적 흔적에서 그 사고방식을 재구성하는 것은 그 자체로 양자화의 행위이며, 이러한 흔적은 단지 증거일 뿐이며, 그로부터 나온 문화적 의식은 추론을 넘어, 아마도 상상을 초월할 것입니다.

실제적으로, 현대 언어 모델의 기반은 현재의 규범과 데이터에 의해 형성되어, 에드워드 시대 독자에게는 합리적이거나 평범해 보였을 아이디어가 지금은 편견, 불평등, 불공정의 유물로 등록될 위험을 재해석하거나 억제합니다.

따라서 우리가 그러한 대화를 만들 수 있다고 해도, 그것이 우리를 거부하지 않을까 하는 궁금증이 생깁니다.

2025년 5월 2일 금요일 첫 출판

Deep Cogito의 LLMS는 IDA를 사용하여 유사한 크기의 모델보다 우수합니다

샌프란시스코에 본사를 둔 Deep Cogito는 AI 커뮤니티에서 최신 Open Lange Language Models (LLM)를 릴리스하여 파도를 만들고 있습니다. 30 억에서 70 억의 매개 변수 범위의 다양한 크기로 제공되는이 모델은 또 다른 AI 도구 세트가 아닙니다. 그들은 w를 향한 대담한 단계입니다

Deep Cogito의 LLMS는 IDA를 사용하여 유사한 크기의 모델보다 우수합니다

샌프란시스코에 본사를 둔 Deep Cogito는 AI 커뮤니티에서 최신 Open Lange Language Models (LLM)를 릴리스하여 파도를 만들고 있습니다. 30 억에서 70 억의 매개 변수 범위의 다양한 크기로 제공되는이 모델은 또 다른 AI 도구 세트가 아닙니다. 그들은 w를 향한 대담한 단계입니다

어소트 헬스, 환자 커뮤니케이션 자동화를 위한 5,000만 달러 투자 유치

이 거래에 정통한 소식통에 따르면, 전문 진료를 위한 자동화된 환자 커뮤니케이션을 전문으로 하는 신생 AI 의료 스타트업인 Assort Health가 7억 5천만 달러의 가치로 약 5,000만 달러의 시리즈 B 투자를 유치했다고 합니다. 라이트스피드 벤처 파트너스가 주도한 이번 투자는 불과 4개월 전 2,200만 달러 규모의 시리즈 A 라운드에 이은 후속

어소트 헬스, 환자 커뮤니케이션 자동화를 위한 5,000만 달러 투자 유치

이 거래에 정통한 소식통에 따르면, 전문 진료를 위한 자동화된 환자 커뮤니케이션을 전문으로 하는 신생 AI 의료 스타트업인 Assort Health가 7억 5천만 달러의 가치로 약 5,000만 달러의 시리즈 B 투자를 유치했다고 합니다. 라이트스피드 벤처 파트너스가 주도한 이번 투자는 불과 4개월 전 2,200만 달러 규모의 시리즈 A 라운드에 이은 후속

2025년 8월 4일 오후 5시 40분 5초 GMT+09:00

2025년 8월 4일 오후 5시 40분 5초 GMT+09:00

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

2025년 7월 31일 오후 8시 35분 39초 GMT+09:00

2025년 7월 31일 오후 8시 35분 39초 GMT+09:00

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

2025년 7월 28일 오전 10시 19분 5초 GMT+09:00

2025년 7월 28일 오전 10시 19분 5초 GMT+09:00

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

2025년 7월 28일 오전 10시 18분 39초 GMT+09:00

2025년 7월 28일 오전 10시 18분 39초 GMT+09:00

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0