KI hat Schwierigkeiten, historische Sprache nachzuahmen

Ein Team von Forschern aus den Vereinigten Staaten und Kanada hat festgestellt, dass große Sprachmodelle wie ChatGPT Schwierigkeiten haben, historische Redewendungen ohne umfangreiches und kostspieliges Pretraining genau nachzubilden. Diese Herausforderung macht ehrgeizige Projekte, wie die Verwendung von AI zur Vollendung des letzten unvollendeten Romans von Charles Dickens, für die meisten akademischen und unterhaltungsbezogenen Bemühungen unerreichbar.

Die Forscher experimentierten mit verschiedenen Methoden, um Texte zu generieren, die historisch authentisch klingen. Sie begannen mit einfachen Prompts, die Prosa aus dem frühen 20. Jahrhundert verwendeten, und gingen dazu über, ein kommerzielles Modell mit einer kleinen Auswahl von Büchern aus dieser Zeit zu optimieren. Sie verglichen diese Ergebnisse auch mit einem Modell, das ausschließlich mit Literatur von 1880 bis 1914 trainiert wurde.

In ihrem ersten Test wiesen sie ChatGPT-4o an, die Sprache der Fin-de-siècle-Periode nachzuahmen. Die Ergebnisse unterschieden sich erheblich von denen eines kleineren, optimierten GPT2-Modells, das mit Literatur aus derselben Zeit trainiert wurde.

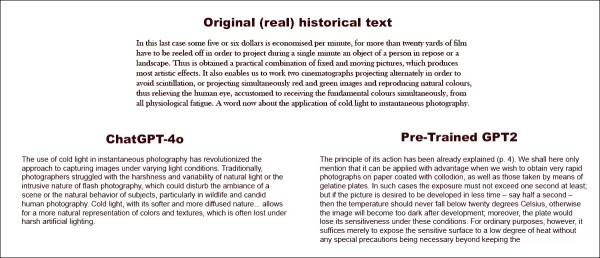

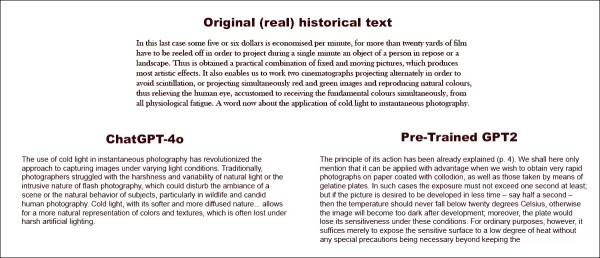

Aufgefordert, einen echten historischen Text (oben Mitte) zu vervollständigen, kann selbst ein gut vorbereitetes ChatGPT-4o (unten links) nicht verhindern, in den 'Blog'-Modus zurückzufallen und die gewünschte Redewendung nicht darzustellen. Im Gegensatz dazu erfasst das optimierte GPT2-Modell (unten rechts) den Sprachstil gut, ist aber in anderer Hinsicht nicht so genau. Quelle: https://arxiv.org/pdf/2505.00030

Aufgefordert, einen echten historischen Text (oben Mitte) zu vervollständigen, kann selbst ein gut vorbereitetes ChatGPT-4o (unten links) nicht verhindern, in den 'Blog'-Modus zurückzufallen und die gewünschte Redewendung nicht darzustellen. Im Gegensatz dazu erfasst das optimierte GPT2-Modell (unten rechts) den Sprachstil gut, ist aber in anderer Hinsicht nicht so genau. Quelle: https://arxiv.org/pdf/2505.00030

Obwohl die Optimierung die Ähnlichkeit des Outputs mit dem ursprünglichen Stil verbesserte, konnten menschliche Leser immer noch moderne Sprache oder Ideen erkennen, was darauf hindeutet, dass selbst angepasste Modelle Spuren ihrer zeitgenössischen Trainingsdaten behalten.

Die Forscher schlussfolgerten, dass es keine kostengünstigen Abkürzungen gibt, um historisch genaue Texte oder Dialoge mit Maschinen zu generieren. Sie schlugen auch vor, dass die Herausforderung selbst möglicherweise grundsätzlich fehlerhaft ist und erklärten: "Wir sollten auch die Möglichkeit in Betracht ziehen, dass Anachronismus in gewissem Maße unvermeidlich sein könnte. Ob wir die Vergangenheit durch das Optimieren historischer Modelle darstellen, damit sie Gespräche führen können, oder durch das Lehren zeitgenössischer Modelle, eine ältere Periode nachzuahmen, es könnte ein Kompromiss zwischen den Zielen der Authentizität und der Konversationsflüssigkeit notwendig sein. Es gibt schließlich keine 'authentischen' Beispiele für ein Gespräch zwischen einem Fragesteller des 21. Jahrhunderts und einem Antwortenden von 1914. Forscher, die versuchen, ein solches Gespräch zu erstellen, müssen über die Prämisse nachdenken, dass Interpretation immer eine Verhandlung zwischen Gegenwart und Vergangenheit beinhaltet."

Die Studie mit dem Titel "Können Sprachmodelle die Vergangenheit ohne Anachronismus darstellen?" wurde von Forschern der University of Illinois, der University of British Columbia und der Cornell University durchgeführt.

Anfängliche Herausforderungen

Die Forscher untersuchten zunächst, ob moderne Sprachmodelle dazu aufgefordert werden können, historische Sprache nachzuahmen. Sie verwendeten echte Auszüge aus Büchern, die zwischen 1905 und 1914 veröffentlicht wurden, und baten ChatGPT-4o, diese Passagen im selben Stil fortzusetzen.

Der ursprüngliche Text aus der Periode lautete:

"In diesem letzten Fall werden pro Minute etwa fünf oder sechs Dollar eingespart, da mehr als zwanzig Meter Film abgespult werden müssen, um während einer einzigen Minute ein Objekt einer Person in Ruhe oder eine Landschaft zu projizieren. So wird eine praktische Kombination aus festen und beweglichen Bildern erzielt, die höchst künstlerische Effekte erzeugt. Es ermöglicht uns auch, zwei Kinematographen abwechselnd zu projizieren, um Flimmern zu vermeiden, oder gleichzeitig rote und grüne Bilder zu projizieren und natürliche Farben wiederzugeben, wodurch das menschliche Auge, das gewohnt ist, die Grundfarben gleichzeitig zu empfangen, von aller physiologischen Ermüdung befreit wird. Ein Wort nun zur Anwendung von kaltem Licht auf die Sofortfotografie."

Um die historische Genauigkeit des generierten Textes zu bewerten, optimierten die Forscher ein RoBERTa-Modell, um Veröffentlichungsdaten zu schätzen, indem sie einen Teil des Corpus of Historical American English verwendeten, der Material von 1810 bis 2009 abdeckt. Dieser RoBERTa-Klassifikator bewertete Fortsetzungen, die von ChatGPT-4o produziert wurden, die mit echten Passagen aus Büchern von 1905 bis 1914 aufgefordert wurden.

Der Systemprompt an ChatGPT lautete: "Ihre Aufgabe ist es, Passagen aus Büchern des frühen 20. Jahrhunderts zu vervollständigen. Sie erhalten eine Passage aus einem Buch, das 1913 veröffentlicht wurde. Führen Sie diese Passage im selben Stil fort, für mindestens 200 Wörter. Geben Sie nur diese Fortsetzung an; machen Sie keine einleitenden Bemerkungen wie 'hier ist die Fortsetzung:'."

Trotz der Verwendung von One-Shot- und 20-Shot-Prompts neigten die Ausgaben von ChatGPT-4o durchgehend zu einem Stil des 21. Jahrhunderts. Ein im Paper angegebenes Beispiel zeigte den Versuch von ChatGPT-4o, den Fotografietext fortzusetzen:

"Die Verwendung von kaltem Licht in der Sofortfotografie hat den Ansatz zur Aufnahme von Bildern unter unterschiedlichen Lichtbedingungen revolutioniert. Traditionell hatten Fotografen mit der Härte und Variabilität des natürlichen Lichts oder der aufdringlichen Natur der Blitzfotografie zu kämpfen, die die Stimmung einer Szene oder das natürliche Verhalten von Motiven, insbesondere in der Tier- und Kandidatenfotografie, stören konnte. Kaltes Licht mit seiner weicheren und diffusen Natur... ermöglicht eine natürlichere Darstellung von Farben und Texturen, die unter hartem künstlichem Licht oft verloren geht."

Dieser generische, Wiki-ähnliche Text entsprach nicht dem ausführlichen und elaborierten Stil des ursprünglichen Textes aus der Periode und setzte auch nicht nahtlos dort fort, wo der Originaltext endete. Stattdessen driftete er in eine abstrakte Diskussion über eines der Unterthemen ab.

Das Team testete auch GPT-1914, ein kleineres GPT-2-Modell, das von Grund auf mit Literatur von 1880 bis 1914 trainiert wurde. Obwohl weniger kohärent, war seine Ausgabe stilistisch konsistenter mit der Quellenperiode. Ein im Paper angegebenes Beispiel war:

"Das Prinzip seiner Wirkung wurde bereits erklärt (S. 4). Wir erwähnen hier nur, dass es vorteilhaft angewendet werden kann, wenn wir sehr schnelle Fotografien auf mit Kollodium beschichtetem Papier sowie auf Gelatineplatten machen möchten. In solchen Fällen darf die Belichtung mindestens eine Sekunde nicht überschreiten; wenn jedoch das Bild in kürzerer Zeit entwickelt werden soll – sagen wir eine halbe Sekunde –, dann sollte die Temperatur niemals unter 20° C fallen, da das Bild sonst nach der Entwicklung zu dunkel wird; außerdem würde die Platte unter diesen Bedingungen ihre Empfindlichkeit verlieren. Für gewöhnliche Zwecke reicht es jedoch aus, die empfindliche Oberfläche einem geringen Maß an Wärme auszusetzen, ohne dass besondere Vorsichtsmaßnahmen erforderlich sind."

Während das Originalmaterial schwer verständlich und herausfordernd war, klang die Ausgabe von GPT-1914 authentischer für die Periode. Die Autoren schlussfolgerten jedoch, dass einfaches Prompting wenig dazu beiträgt, die inhärenten zeitgenössischen Vorurteile großer vortrainierter Modelle wie ChatGPT-4o zu überwinden.

Messung der historischen Genauigkeit

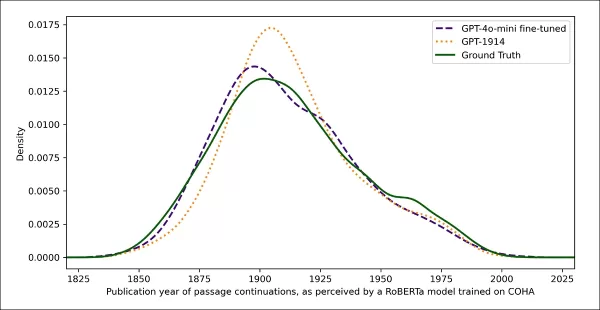

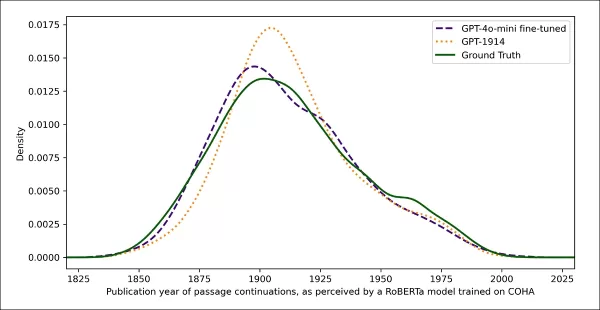

Um zu beurteilen, wie sehr die Modellausgaben authentischem historischem Schreiben ähnelten, verwendeten die Forscher einen statistischen Klassifikator, um das wahrscheinliche Veröffentlichungsdatum jeder Textprobe zu schätzen. Sie visualisierten die Ergebnisse mit einem Kerndichtediagramm, das zeigte, wo das Modell jede Passage auf einer historischen Zeitleiste platzierte.

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, basierend auf einem Klassifikator, der trainiert wurde, historischen Stil zu erkennen (Quellentexte von 1905–1914 im Vergleich zu Fortsetzungen von GPT‑4o mit One-Shot- und 20-Shot-Prompts und von GPT‑1914, das nur mit Literatur von 1880–1914 trainiert wurde).

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, basierend auf einem Klassifikator, der trainiert wurde, historischen Stil zu erkennen (Quellentexte von 1905–1914 im Vergleich zu Fortsetzungen von GPT‑4o mit One-Shot- und 20-Shot-Prompts und von GPT‑1914, das nur mit Literatur von 1880–1914 trainiert wurde).

Das optimierte RoBERTa-Modell, obwohl nicht perfekt, zeigte allgemeine stilistische Trends. Passagen von GPT-1914, die ausschließlich mit Literatur der Periode trainiert wurden, gruppierten sich um das frühe 20. Jahrhundert, ähnlich dem ursprünglichen Quellenmaterial. Im Gegensatz dazu ähnelten die Ausgaben von ChatGPT-4o, selbst mit mehreren historischen Prompts, dem Schreiben des 21. Jahrhunderts, was ihre Trainingsdaten widerspiegelt.

Die Forscher quantifizierten diese Diskrepanz mit der Jensen-Shannon-Divergenz, die den Unterschied zwischen zwei Wahrscheinlichkeitsverteilungen misst. GPT-1914 erreichte einen nahen Wert von 0,006 im Vergleich zu echtem historischem Text, während die One-Shot- und 20-Shot-Ausgaben von ChatGPT-4o viel größere Abstände von 0,310 bzw. 0,350 zeigten.

Die Autoren argumentieren, dass diese Ergebnisse darauf hindeuten, dass alleiniges Prompting, selbst mit mehreren Beispielen, keine zuverlässige Methode ist, um Texte zu erzeugen, die überzeugend einen historischen Stil simulieren.

Optimierung für bessere Ergebnisse

Das Paper untersuchte dann, ob Optimierung bessere Ergebnisse liefern könnte. Dieser Prozess beeinflusst direkt die Gewichte des Modells, indem das Training mit benutzerspezifischen Daten fortgesetzt wird, was die Leistung im Zielbereich potenziell verbessert.

In ihrem ersten Optimierungsexperiment trainierten die Forscher GPT-4o-mini mit etwa zweitausend Passage-Vervollständigungspaaren aus Büchern, die zwischen 1905 und 1914 veröffentlicht wurden. Sie wollten sehen, ob eine Optimierung in kleinerem Maßstab die Ausgaben des Modells hin zu einem historisch genaueren Stil verschieben könnte.

Mit demselben RoBERTa-basierten Klassifikator, um das stilistische 'Datum' jeder Ausgabe zu schätzen, stellten die Forscher fest, dass das optimierte Modell Texte produzierte, die eng mit der Grundwahrheit übereinstimmten. Die stilistische Divergenz von den Originaltexten, gemessen durch die Jensen-Shannon-Divergenz, sank auf 0,002, was im Allgemeinen mit GPT-1914 übereinstimmt.

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, die zeigen, wie eng GPT‑1914 und eine optimierte Version von GPT‑4o‑mini dem Stil des Schreibens des frühen 20. Jahrhunderts entsprechen (basierend auf Büchern, die zwischen 1905 und 1914 veröffentlicht wurden).

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, die zeigen, wie eng GPT‑1914 und eine optimierte Version von GPT‑4o‑mini dem Stil des Schreibens des frühen 20. Jahrhunderts entsprechen (basierend auf Büchern, die zwischen 1905 und 1914 veröffentlicht wurden).

Die Forscher warnten jedoch, dass diese Metrik möglicherweise nur oberflächliche Merkmale des historischen Stils erfasst, nicht aber tiefere konzeptionelle oder faktische Anachronismen. Sie stellten fest: "Dies ist kein sehr sensitiver Test. Das hier als Richter verwendete RoBERTa-Modell ist nur darauf trainiert, ein Datum vorherzusagen, nicht darauf, authentische Passagen von anachronistischen zu unterscheiden. Es verwendet wahrscheinlich grobe stilistische Beweise, um diese Vorhersage zu treffen. Menschliche Leser oder größere Modelle könnten immer noch anachronistische Inhalte in Passagen erkennen, die oberflächlich 'in der Periode' klingen."

Menschliche Bewertung

Schließlich führten die Forscher menschliche Bewertungstests mit 250 handverlesenen Passagen aus Büchern durch, die zwischen 1905 und 1914 veröffentlicht wurden. Sie stellten fest, dass viele dieser Texte heute wahrscheinlich anders interpretiert werden als zum Zeitpunkt ihrer Entstehung:

"Unsere Liste enthielt beispielsweise einen Enzyklopädieeintrag über Elsass (das damals Teil Deutschlands war) und einen über Beriberi (das damals oft als Pilzkrankheit erklärt wurde, anstatt als Ernährungsmangel). Während dies Unterschiede in Fakten sind, haben wir auch Passagen ausgewählt, die subtilere Unterschiede in Haltung, Rhetorik oder Vorstellungskraft zeigen würden. Zum Beispiel neigen Beschreibungen nichteuropäischer Orte im frühen 20. Jahrhundert dazu, in rassische Verallgemeinerungen abzurutschen. Eine Beschreibung des Sonnenaufgangs auf dem Mond, geschrieben 1913, stellt reiche chromatische Phänomene vor, weil noch niemand Fotos von einer Welt ohne Atmosphäre gesehen hatte."

Die Forscher erstellten kurze Fragen, die jede historische Passage plausibel beantworten könnte, und optimierten GPT-4o-mini auf diesen Frage-Antwort-Paaren. Um die Bewertung zu stärken, trainierten sie fünf separate Versionen des Modells, wobei sie jedes Mal einen anderen Teil der Daten für Tests zurückhielten. Anschließend erstellten sie Antworten mit den Standardversionen von GPT-4o und GPT-4o-mini sowie den optimierten Varianten, die jeweils auf dem Teil bewertet wurden, den sie während des Trainings nicht gesehen hatten.

In der Zeit verloren

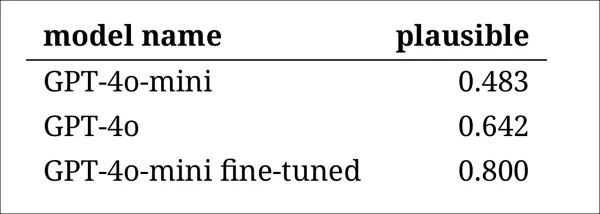

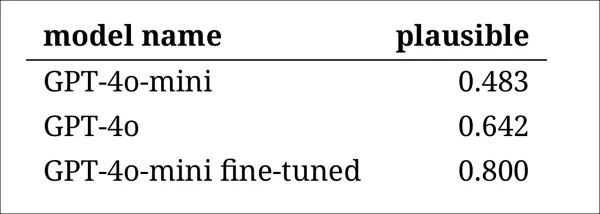

Um zu beurteilen, wie überzeugend die Modelle historische Sprache nachahmen konnten, baten die Forscher drei Experten-Annotatoren, 120 KI-generierte Vervollständigungen zu überprüfen und zu beurteilen, ob jede einzelne für einen Schriftsteller von 1914 plausibel erschien.

Diese Bewertung erwies sich als schwieriger als erwartet. Obwohl die Annotatoren in fast achtzig Prozent der Fälle übereinstimmten, bedeutete die Unausgewogenheit ihrer Urteile (wobei 'plausibel' doppelt so oft gewählt wurde wie 'nicht plausibel'), dass ihr tatsächlicher Übereinstimmungsgrad nur moderat war, gemessen an einem Cohen’s-Kappa-Wert von 0,554.

Die Bewerter beschrieben die Aufgabe als schwierig, da oft zusätzliche Recherchen erforderlich waren, um zu bewerten, ob eine Aussage mit dem übereinstimmte, was 1914 bekannt oder geglaubt wurde. Einige Passagen warfen Fragen zu Ton und Perspektive auf, etwa ob eine Antwort angemessen in ihrer Weltsicht eingeschränkt war, um das widerzuspiegeln, was 1914 typisch gewesen wäre. Dieses Urteil hing oft vom Grad des Ethnozentrismus ab, der Tendenz, andere Kulturen durch die Annahmen oder Vorurteile der eigenen Kultur zu betrachten.

Die Herausforderung bestand darin, zu entscheiden, ob eine Passage gerade genug kulturelle Voreingenommenheit ausdrückte, um historisch plausibel zu wirken, ohne zu modern oder nach heutigen Maßstäben zu offensichtlich anstößig zu klingen. Die Autoren stellten fest, dass es selbst für Gelehrte, die mit der Periode vertraut sind, schwierig war, eine klare Grenze zwischen Sprache zu ziehen, die historisch genau wirkte, und Sprache, die gegenwärtige Ideen widerspiegelte.

Dennoch zeigten die Ergebnisse eine klare Rangfolge der Modelle, wobei die optimierte Version von GPT-4o-mini insgesamt am plausibelsten beurteilt wurde:

Bewertungen der Annotatoren, wie plausibel die Ausgaben jedes Modells erschienen

Bewertungen der Annotatoren, wie plausibel die Ausgaben jedes Modells erschienen

Ob dieses Leistungsniveau, das in achtzig Prozent der Fälle als plausibel bewertet wurde, zuverlässig genug für historische Forschung ist, bleibt unklar, insbesondere da die Studie keinen Basiswert dafür enthielt, wie oft echte Texte aus der Periode falsch klassifiziert werden könnten.

Eindringlingsalarm

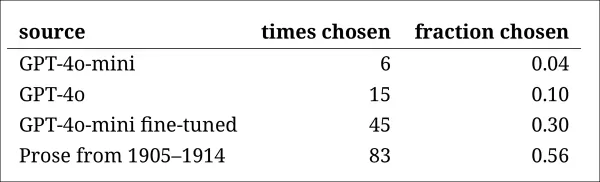

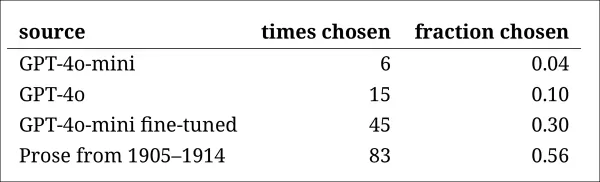

Als nächstes führten die Forscher einen 'Eindringlingstest' durch, bei dem Experten-Annotatoren vier anonyme Passagen gezeigt wurden, die dieselbe historische Frage beantworteten. Drei Antworten stammten von Sprachmodellen, während eine ein echter Auszug aus einer Quelle des frühen 20. Jahrhunderts war.

Die Aufgabe bestand darin, zu identifizieren, welche Passage die originale war, die tatsächlich in der Periode geschrieben wurde. Dieser Ansatz forderte die Annotatoren nicht direkt auf, die Plausibilität zu bewerten, sondern maß, wie oft die echte Passage aus den KI-generierten Antworten herausstach, was effektiv testete, ob die Modelle Leser täuschen konnten, ihre Ausgabe für authentisch zu halten.

Die Rangfolge der Modelle stimmte mit den Ergebnissen der vorherigen Beurteilungsaufgabe überein: Die optimierte Version von GPT-4o-mini war unter den Modellen die überzeugendste, blieb aber hinter dem Original zurück.

Die Häufigkeit, mit der jede Quelle korrekt als die authentische historische Passage identifiziert wurde.

Die Häufigkeit, mit der jede Quelle korrekt als die authentische historische Passage identifiziert wurde.

Dieser Test diente auch als nützliche Referenz, da die echte Passage in mehr als der Hälfte der Fälle identifiziert wurde, was darauf hindeutet, dass der Unterschied zwischen authentischer und synthetischer Prosa für menschliche Leser weiterhin spürbar blieb.

Eine statistische Analyse, bekannt als McNemar-Test, bestätigte, dass die Unterschiede zwischen den Modellen signifikant waren, außer im Fall der beiden nicht optimierten Versionen (GPT-4o und GPT-4o-mini), die ähnlich abschnitten.

Die Zukunft der Vergangenheit

Die Autoren stellten fest, dass das Auffordern moderner Sprachmodelle, eine historische Stimme anzunehmen, keine zuverlässig überzeugenden Ergebnisse lieferte: Weniger als zwei Drittel der Ausgaben wurden von menschlichen Lesern als plausibel beurteilt, und selbst diese Zahl übertreibt wahrscheinlich die Leistung.

In vielen Fällen enthielten die Antworten explizite Signale, dass das Modell aus einer heutigen Perspektive sprach – Phrasen wie "1914 ist es noch nicht bekannt, dass..." oder "stand 1914 bin ich nicht vertraut mit..." waren häufig genug, um in bis zu einem Fünftel der Vervollständigungen aufzutauchen. Solche Haftungsausschlüsse machten deutlich, dass das Modell die Geschichte von außen simulierte, anstatt aus ihr heraus zu schreiben.

Die Autoren erklärten: "Die schlechte Leistung des In-Context-Lernens ist bedauerlich, weil diese Methoden die einfachsten und kostengünstigsten für KI-basierte historische Forschung sind. Wir betonen, dass wir diese Ansätze nicht erschöpfend untersucht haben. Es könnte sich herausstellen, dass In-Context-Lernen – jetzt oder in der Zukunft – für eine Untergruppe von Forschungsbereichen ausreichend ist. Aber unsere anfänglichen Beweise sind nicht ermutigend."

Die Autoren schlussfolgerten, dass die Optimierung eines kommerziellen Modells mit historischen Passagen stilistisch überzeugende Ausgaben zu minimalen Kosten erzeugen kann, aber Spuren moderner Perspektiven nicht vollständig beseitigt. Das Pretraining eines Modells ausschließlich mit Material der Periode vermeidet Anachronismus, erfordert jedoch weitaus größere Ressourcen und führt zu weniger flüssigen Ausgaben.

Keine Methode bietet eine vollständige Lösung, und vorerst scheint jeder Versuch, historische Stimmen zu simulieren, einen Kompromiss zwischen Authentizität und Kohärenz zu erfordern. Die Autoren schließen, dass weitere Forschung erforderlich sein wird, um zu klären, wie man diese Spannung am besten navigieren kann.

Fazit

Eine der faszinierendsten Fragen, die das neue Paper aufwirft, ist die der Authentizität. Während sie keine perfekten Werkzeuge sind, bieten Verlustfunktionen und Metriken wie LPIPS und SSIM Forschern im Bereich der Computervision eine Methodik zur Bewertung gegenüber der Grundwahrheit. Beim Generieren neuer Texte im Stil einer vergangenen Ära gibt es jedoch keine Grundwahrheit – nur einen Versuch, eine verschwundene kulturelle Perspektive zu bewohnen. Der Versuch, diese Denkweise aus literarischen Spuren zu rekonstruieren, ist selbst ein Akt der Quantisierung, da diese Spuren lediglich Beweise sind, während das kulturelle Bewusstsein, aus dem sie hervorgehen, jenseits der Schlussfolgerung und wahrscheinlich jenseits der Vorstellungskraft bleibt.

Auf praktischer Ebene riskieren die Grundlagen moderner Sprachmodelle, die von gegenwärtigen Normen und Daten geprägt sind, Ideen zu reinterpretieren oder zu unterdrücken, die für einen Leser der Edwardianischen Ära vernünftig oder unauffällig erschienen wären, aber heute als Artefakte von Vorurteilen, Ungleichheit oder Ungerechtigkeit registriert werden.

Man fragt sich daher, selbst wenn wir ein solches Gespräch schaffen könnten, ob es uns nicht abstoßen würde.

Erstmals veröffentlicht am Freitag, 2. Mai 2025

Verwandter Artikel

Die LLMs von Deep Cogito übertreffen ähnliche Modelle mit ähnlicher Größe mit IDA

Deep Cogito, ein in San Francisco ansässiges Unternehmen, macht in der KI-Community Wellen mit der neuesten Veröffentlichung von Open Language Models (LLMs). Diese Modelle, die in verschiedenen Größen von 3 bis 70 Milliarden Parametern liegen, sind nicht nur ein weiterer Satz von KI -Tools. Sie sind ein mutiger Schritt in Richtung W.

Die LLMs von Deep Cogito übertreffen ähnliche Modelle mit ähnlicher Größe mit IDA

Deep Cogito, ein in San Francisco ansässiges Unternehmen, macht in der KI-Community Wellen mit der neuesten Veröffentlichung von Open Language Models (LLMs). Diese Modelle, die in verschiedenen Größen von 3 bis 70 Milliarden Parametern liegen, sind nicht nur ein weiterer Satz von KI -Tools. Sie sind ein mutiger Schritt in Richtung W.

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

Kommentare (4)

0/200

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

Kommentare (4)

0/200

![GaryJones]() GaryJones

GaryJones

4. August 2025 10:40:05 MESZ

4. August 2025 10:40:05 MESZ

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

![StephenRamirez]() StephenRamirez

StephenRamirez

31. Juli 2025 13:35:39 MESZ

31. Juli 2025 13:35:39 MESZ

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

![DavidGonzalez]() DavidGonzalez

DavidGonzalez

28. Juli 2025 03:19:05 MESZ

28. Juli 2025 03:19:05 MESZ

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

![PaulSanchez]() PaulSanchez

PaulSanchez

28. Juli 2025 03:18:39 MESZ

28. Juli 2025 03:18:39 MESZ

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0

Ein Team von Forschern aus den Vereinigten Staaten und Kanada hat festgestellt, dass große Sprachmodelle wie ChatGPT Schwierigkeiten haben, historische Redewendungen ohne umfangreiches und kostspieliges Pretraining genau nachzubilden. Diese Herausforderung macht ehrgeizige Projekte, wie die Verwendung von AI zur Vollendung des letzten unvollendeten Romans von Charles Dickens, für die meisten akademischen und unterhaltungsbezogenen Bemühungen unerreichbar.

Die Forscher experimentierten mit verschiedenen Methoden, um Texte zu generieren, die historisch authentisch klingen. Sie begannen mit einfachen Prompts, die Prosa aus dem frühen 20. Jahrhundert verwendeten, und gingen dazu über, ein kommerzielles Modell mit einer kleinen Auswahl von Büchern aus dieser Zeit zu optimieren. Sie verglichen diese Ergebnisse auch mit einem Modell, das ausschließlich mit Literatur von 1880 bis 1914 trainiert wurde.

In ihrem ersten Test wiesen sie ChatGPT-4o an, die Sprache der Fin-de-siècle-Periode nachzuahmen. Die Ergebnisse unterschieden sich erheblich von denen eines kleineren, optimierten GPT2-Modells, das mit Literatur aus derselben Zeit trainiert wurde.

Aufgefordert, einen echten historischen Text (oben Mitte) zu vervollständigen, kann selbst ein gut vorbereitetes ChatGPT-4o (unten links) nicht verhindern, in den 'Blog'-Modus zurückzufallen und die gewünschte Redewendung nicht darzustellen. Im Gegensatz dazu erfasst das optimierte GPT2-Modell (unten rechts) den Sprachstil gut, ist aber in anderer Hinsicht nicht so genau. Quelle: https://arxiv.org/pdf/2505.00030

Aufgefordert, einen echten historischen Text (oben Mitte) zu vervollständigen, kann selbst ein gut vorbereitetes ChatGPT-4o (unten links) nicht verhindern, in den 'Blog'-Modus zurückzufallen und die gewünschte Redewendung nicht darzustellen. Im Gegensatz dazu erfasst das optimierte GPT2-Modell (unten rechts) den Sprachstil gut, ist aber in anderer Hinsicht nicht so genau. Quelle: https://arxiv.org/pdf/2505.00030

Obwohl die Optimierung die Ähnlichkeit des Outputs mit dem ursprünglichen Stil verbesserte, konnten menschliche Leser immer noch moderne Sprache oder Ideen erkennen, was darauf hindeutet, dass selbst angepasste Modelle Spuren ihrer zeitgenössischen Trainingsdaten behalten.

Die Forscher schlussfolgerten, dass es keine kostengünstigen Abkürzungen gibt, um historisch genaue Texte oder Dialoge mit Maschinen zu generieren. Sie schlugen auch vor, dass die Herausforderung selbst möglicherweise grundsätzlich fehlerhaft ist und erklärten: "Wir sollten auch die Möglichkeit in Betracht ziehen, dass Anachronismus in gewissem Maße unvermeidlich sein könnte. Ob wir die Vergangenheit durch das Optimieren historischer Modelle darstellen, damit sie Gespräche führen können, oder durch das Lehren zeitgenössischer Modelle, eine ältere Periode nachzuahmen, es könnte ein Kompromiss zwischen den Zielen der Authentizität und der Konversationsflüssigkeit notwendig sein. Es gibt schließlich keine 'authentischen' Beispiele für ein Gespräch zwischen einem Fragesteller des 21. Jahrhunderts und einem Antwortenden von 1914. Forscher, die versuchen, ein solches Gespräch zu erstellen, müssen über die Prämisse nachdenken, dass Interpretation immer eine Verhandlung zwischen Gegenwart und Vergangenheit beinhaltet."

Die Studie mit dem Titel "Können Sprachmodelle die Vergangenheit ohne Anachronismus darstellen?" wurde von Forschern der University of Illinois, der University of British Columbia und der Cornell University durchgeführt.

Anfängliche Herausforderungen

Die Forscher untersuchten zunächst, ob moderne Sprachmodelle dazu aufgefordert werden können, historische Sprache nachzuahmen. Sie verwendeten echte Auszüge aus Büchern, die zwischen 1905 und 1914 veröffentlicht wurden, und baten ChatGPT-4o, diese Passagen im selben Stil fortzusetzen.

Der ursprüngliche Text aus der Periode lautete:

"In diesem letzten Fall werden pro Minute etwa fünf oder sechs Dollar eingespart, da mehr als zwanzig Meter Film abgespult werden müssen, um während einer einzigen Minute ein Objekt einer Person in Ruhe oder eine Landschaft zu projizieren. So wird eine praktische Kombination aus festen und beweglichen Bildern erzielt, die höchst künstlerische Effekte erzeugt. Es ermöglicht uns auch, zwei Kinematographen abwechselnd zu projizieren, um Flimmern zu vermeiden, oder gleichzeitig rote und grüne Bilder zu projizieren und natürliche Farben wiederzugeben, wodurch das menschliche Auge, das gewohnt ist, die Grundfarben gleichzeitig zu empfangen, von aller physiologischen Ermüdung befreit wird. Ein Wort nun zur Anwendung von kaltem Licht auf die Sofortfotografie."

Um die historische Genauigkeit des generierten Textes zu bewerten, optimierten die Forscher ein RoBERTa-Modell, um Veröffentlichungsdaten zu schätzen, indem sie einen Teil des Corpus of Historical American English verwendeten, der Material von 1810 bis 2009 abdeckt. Dieser RoBERTa-Klassifikator bewertete Fortsetzungen, die von ChatGPT-4o produziert wurden, die mit echten Passagen aus Büchern von 1905 bis 1914 aufgefordert wurden.

Der Systemprompt an ChatGPT lautete: "Ihre Aufgabe ist es, Passagen aus Büchern des frühen 20. Jahrhunderts zu vervollständigen. Sie erhalten eine Passage aus einem Buch, das 1913 veröffentlicht wurde. Führen Sie diese Passage im selben Stil fort, für mindestens 200 Wörter. Geben Sie nur diese Fortsetzung an; machen Sie keine einleitenden Bemerkungen wie 'hier ist die Fortsetzung:'."

Trotz der Verwendung von One-Shot- und 20-Shot-Prompts neigten die Ausgaben von ChatGPT-4o durchgehend zu einem Stil des 21. Jahrhunderts. Ein im Paper angegebenes Beispiel zeigte den Versuch von ChatGPT-4o, den Fotografietext fortzusetzen:

"Die Verwendung von kaltem Licht in der Sofortfotografie hat den Ansatz zur Aufnahme von Bildern unter unterschiedlichen Lichtbedingungen revolutioniert. Traditionell hatten Fotografen mit der Härte und Variabilität des natürlichen Lichts oder der aufdringlichen Natur der Blitzfotografie zu kämpfen, die die Stimmung einer Szene oder das natürliche Verhalten von Motiven, insbesondere in der Tier- und Kandidatenfotografie, stören konnte. Kaltes Licht mit seiner weicheren und diffusen Natur... ermöglicht eine natürlichere Darstellung von Farben und Texturen, die unter hartem künstlichem Licht oft verloren geht."

Dieser generische, Wiki-ähnliche Text entsprach nicht dem ausführlichen und elaborierten Stil des ursprünglichen Textes aus der Periode und setzte auch nicht nahtlos dort fort, wo der Originaltext endete. Stattdessen driftete er in eine abstrakte Diskussion über eines der Unterthemen ab.

Das Team testete auch GPT-1914, ein kleineres GPT-2-Modell, das von Grund auf mit Literatur von 1880 bis 1914 trainiert wurde. Obwohl weniger kohärent, war seine Ausgabe stilistisch konsistenter mit der Quellenperiode. Ein im Paper angegebenes Beispiel war:

"Das Prinzip seiner Wirkung wurde bereits erklärt (S. 4). Wir erwähnen hier nur, dass es vorteilhaft angewendet werden kann, wenn wir sehr schnelle Fotografien auf mit Kollodium beschichtetem Papier sowie auf Gelatineplatten machen möchten. In solchen Fällen darf die Belichtung mindestens eine Sekunde nicht überschreiten; wenn jedoch das Bild in kürzerer Zeit entwickelt werden soll – sagen wir eine halbe Sekunde –, dann sollte die Temperatur niemals unter 20° C fallen, da das Bild sonst nach der Entwicklung zu dunkel wird; außerdem würde die Platte unter diesen Bedingungen ihre Empfindlichkeit verlieren. Für gewöhnliche Zwecke reicht es jedoch aus, die empfindliche Oberfläche einem geringen Maß an Wärme auszusetzen, ohne dass besondere Vorsichtsmaßnahmen erforderlich sind."

Während das Originalmaterial schwer verständlich und herausfordernd war, klang die Ausgabe von GPT-1914 authentischer für die Periode. Die Autoren schlussfolgerten jedoch, dass einfaches Prompting wenig dazu beiträgt, die inhärenten zeitgenössischen Vorurteile großer vortrainierter Modelle wie ChatGPT-4o zu überwinden.

Messung der historischen Genauigkeit

Um zu beurteilen, wie sehr die Modellausgaben authentischem historischem Schreiben ähnelten, verwendeten die Forscher einen statistischen Klassifikator, um das wahrscheinliche Veröffentlichungsdatum jeder Textprobe zu schätzen. Sie visualisierten die Ergebnisse mit einem Kerndichtediagramm, das zeigte, wo das Modell jede Passage auf einer historischen Zeitleiste platzierte.

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, basierend auf einem Klassifikator, der trainiert wurde, historischen Stil zu erkennen (Quellentexte von 1905–1914 im Vergleich zu Fortsetzungen von GPT‑4o mit One-Shot- und 20-Shot-Prompts und von GPT‑1914, das nur mit Literatur von 1880–1914 trainiert wurde).

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, basierend auf einem Klassifikator, der trainiert wurde, historischen Stil zu erkennen (Quellentexte von 1905–1914 im Vergleich zu Fortsetzungen von GPT‑4o mit One-Shot- und 20-Shot-Prompts und von GPT‑1914, das nur mit Literatur von 1880–1914 trainiert wurde).

Das optimierte RoBERTa-Modell, obwohl nicht perfekt, zeigte allgemeine stilistische Trends. Passagen von GPT-1914, die ausschließlich mit Literatur der Periode trainiert wurden, gruppierten sich um das frühe 20. Jahrhundert, ähnlich dem ursprünglichen Quellenmaterial. Im Gegensatz dazu ähnelten die Ausgaben von ChatGPT-4o, selbst mit mehreren historischen Prompts, dem Schreiben des 21. Jahrhunderts, was ihre Trainingsdaten widerspiegelt.

Die Forscher quantifizierten diese Diskrepanz mit der Jensen-Shannon-Divergenz, die den Unterschied zwischen zwei Wahrscheinlichkeitsverteilungen misst. GPT-1914 erreichte einen nahen Wert von 0,006 im Vergleich zu echtem historischem Text, während die One-Shot- und 20-Shot-Ausgaben von ChatGPT-4o viel größere Abstände von 0,310 bzw. 0,350 zeigten.

Die Autoren argumentieren, dass diese Ergebnisse darauf hindeuten, dass alleiniges Prompting, selbst mit mehreren Beispielen, keine zuverlässige Methode ist, um Texte zu erzeugen, die überzeugend einen historischen Stil simulieren.

Optimierung für bessere Ergebnisse

Das Paper untersuchte dann, ob Optimierung bessere Ergebnisse liefern könnte. Dieser Prozess beeinflusst direkt die Gewichte des Modells, indem das Training mit benutzerspezifischen Daten fortgesetzt wird, was die Leistung im Zielbereich potenziell verbessert.

In ihrem ersten Optimierungsexperiment trainierten die Forscher GPT-4o-mini mit etwa zweitausend Passage-Vervollständigungspaaren aus Büchern, die zwischen 1905 und 1914 veröffentlicht wurden. Sie wollten sehen, ob eine Optimierung in kleinerem Maßstab die Ausgaben des Modells hin zu einem historisch genaueren Stil verschieben könnte.

Mit demselben RoBERTa-basierten Klassifikator, um das stilistische 'Datum' jeder Ausgabe zu schätzen, stellten die Forscher fest, dass das optimierte Modell Texte produzierte, die eng mit der Grundwahrheit übereinstimmten. Die stilistische Divergenz von den Originaltexten, gemessen durch die Jensen-Shannon-Divergenz, sank auf 0,002, was im Allgemeinen mit GPT-1914 übereinstimmt.

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, die zeigen, wie eng GPT‑1914 und eine optimierte Version von GPT‑4o‑mini dem Stil des Schreibens des frühen 20. Jahrhunderts entsprechen (basierend auf Büchern, die zwischen 1905 und 1914 veröffentlicht wurden).

Geschätzte Veröffentlichungsdaten für echte und generierte Texte, die zeigen, wie eng GPT‑1914 und eine optimierte Version von GPT‑4o‑mini dem Stil des Schreibens des frühen 20. Jahrhunderts entsprechen (basierend auf Büchern, die zwischen 1905 und 1914 veröffentlicht wurden).

Die Forscher warnten jedoch, dass diese Metrik möglicherweise nur oberflächliche Merkmale des historischen Stils erfasst, nicht aber tiefere konzeptionelle oder faktische Anachronismen. Sie stellten fest: "Dies ist kein sehr sensitiver Test. Das hier als Richter verwendete RoBERTa-Modell ist nur darauf trainiert, ein Datum vorherzusagen, nicht darauf, authentische Passagen von anachronistischen zu unterscheiden. Es verwendet wahrscheinlich grobe stilistische Beweise, um diese Vorhersage zu treffen. Menschliche Leser oder größere Modelle könnten immer noch anachronistische Inhalte in Passagen erkennen, die oberflächlich 'in der Periode' klingen."

Menschliche Bewertung

Schließlich führten die Forscher menschliche Bewertungstests mit 250 handverlesenen Passagen aus Büchern durch, die zwischen 1905 und 1914 veröffentlicht wurden. Sie stellten fest, dass viele dieser Texte heute wahrscheinlich anders interpretiert werden als zum Zeitpunkt ihrer Entstehung:

"Unsere Liste enthielt beispielsweise einen Enzyklopädieeintrag über Elsass (das damals Teil Deutschlands war) und einen über Beriberi (das damals oft als Pilzkrankheit erklärt wurde, anstatt als Ernährungsmangel). Während dies Unterschiede in Fakten sind, haben wir auch Passagen ausgewählt, die subtilere Unterschiede in Haltung, Rhetorik oder Vorstellungskraft zeigen würden. Zum Beispiel neigen Beschreibungen nichteuropäischer Orte im frühen 20. Jahrhundert dazu, in rassische Verallgemeinerungen abzurutschen. Eine Beschreibung des Sonnenaufgangs auf dem Mond, geschrieben 1913, stellt reiche chromatische Phänomene vor, weil noch niemand Fotos von einer Welt ohne Atmosphäre gesehen hatte."

Die Forscher erstellten kurze Fragen, die jede historische Passage plausibel beantworten könnte, und optimierten GPT-4o-mini auf diesen Frage-Antwort-Paaren. Um die Bewertung zu stärken, trainierten sie fünf separate Versionen des Modells, wobei sie jedes Mal einen anderen Teil der Daten für Tests zurückhielten. Anschließend erstellten sie Antworten mit den Standardversionen von GPT-4o und GPT-4o-mini sowie den optimierten Varianten, die jeweils auf dem Teil bewertet wurden, den sie während des Trainings nicht gesehen hatten.

In der Zeit verloren

Um zu beurteilen, wie überzeugend die Modelle historische Sprache nachahmen konnten, baten die Forscher drei Experten-Annotatoren, 120 KI-generierte Vervollständigungen zu überprüfen und zu beurteilen, ob jede einzelne für einen Schriftsteller von 1914 plausibel erschien.

Diese Bewertung erwies sich als schwieriger als erwartet. Obwohl die Annotatoren in fast achtzig Prozent der Fälle übereinstimmten, bedeutete die Unausgewogenheit ihrer Urteile (wobei 'plausibel' doppelt so oft gewählt wurde wie 'nicht plausibel'), dass ihr tatsächlicher Übereinstimmungsgrad nur moderat war, gemessen an einem Cohen’s-Kappa-Wert von 0,554.

Die Bewerter beschrieben die Aufgabe als schwierig, da oft zusätzliche Recherchen erforderlich waren, um zu bewerten, ob eine Aussage mit dem übereinstimmte, was 1914 bekannt oder geglaubt wurde. Einige Passagen warfen Fragen zu Ton und Perspektive auf, etwa ob eine Antwort angemessen in ihrer Weltsicht eingeschränkt war, um das widerzuspiegeln, was 1914 typisch gewesen wäre. Dieses Urteil hing oft vom Grad des Ethnozentrismus ab, der Tendenz, andere Kulturen durch die Annahmen oder Vorurteile der eigenen Kultur zu betrachten.

Die Herausforderung bestand darin, zu entscheiden, ob eine Passage gerade genug kulturelle Voreingenommenheit ausdrückte, um historisch plausibel zu wirken, ohne zu modern oder nach heutigen Maßstäben zu offensichtlich anstößig zu klingen. Die Autoren stellten fest, dass es selbst für Gelehrte, die mit der Periode vertraut sind, schwierig war, eine klare Grenze zwischen Sprache zu ziehen, die historisch genau wirkte, und Sprache, die gegenwärtige Ideen widerspiegelte.

Dennoch zeigten die Ergebnisse eine klare Rangfolge der Modelle, wobei die optimierte Version von GPT-4o-mini insgesamt am plausibelsten beurteilt wurde:

Bewertungen der Annotatoren, wie plausibel die Ausgaben jedes Modells erschienen

Bewertungen der Annotatoren, wie plausibel die Ausgaben jedes Modells erschienen

Ob dieses Leistungsniveau, das in achtzig Prozent der Fälle als plausibel bewertet wurde, zuverlässig genug für historische Forschung ist, bleibt unklar, insbesondere da die Studie keinen Basiswert dafür enthielt, wie oft echte Texte aus der Periode falsch klassifiziert werden könnten.

Eindringlingsalarm

Als nächstes führten die Forscher einen 'Eindringlingstest' durch, bei dem Experten-Annotatoren vier anonyme Passagen gezeigt wurden, die dieselbe historische Frage beantworteten. Drei Antworten stammten von Sprachmodellen, während eine ein echter Auszug aus einer Quelle des frühen 20. Jahrhunderts war.

Die Aufgabe bestand darin, zu identifizieren, welche Passage die originale war, die tatsächlich in der Periode geschrieben wurde. Dieser Ansatz forderte die Annotatoren nicht direkt auf, die Plausibilität zu bewerten, sondern maß, wie oft die echte Passage aus den KI-generierten Antworten herausstach, was effektiv testete, ob die Modelle Leser täuschen konnten, ihre Ausgabe für authentisch zu halten.

Die Rangfolge der Modelle stimmte mit den Ergebnissen der vorherigen Beurteilungsaufgabe überein: Die optimierte Version von GPT-4o-mini war unter den Modellen die überzeugendste, blieb aber hinter dem Original zurück.

Die Häufigkeit, mit der jede Quelle korrekt als die authentische historische Passage identifiziert wurde.

Die Häufigkeit, mit der jede Quelle korrekt als die authentische historische Passage identifiziert wurde.

Dieser Test diente auch als nützliche Referenz, da die echte Passage in mehr als der Hälfte der Fälle identifiziert wurde, was darauf hindeutet, dass der Unterschied zwischen authentischer und synthetischer Prosa für menschliche Leser weiterhin spürbar blieb.

Eine statistische Analyse, bekannt als McNemar-Test, bestätigte, dass die Unterschiede zwischen den Modellen signifikant waren, außer im Fall der beiden nicht optimierten Versionen (GPT-4o und GPT-4o-mini), die ähnlich abschnitten.

Die Zukunft der Vergangenheit

Die Autoren stellten fest, dass das Auffordern moderner Sprachmodelle, eine historische Stimme anzunehmen, keine zuverlässig überzeugenden Ergebnisse lieferte: Weniger als zwei Drittel der Ausgaben wurden von menschlichen Lesern als plausibel beurteilt, und selbst diese Zahl übertreibt wahrscheinlich die Leistung.

In vielen Fällen enthielten die Antworten explizite Signale, dass das Modell aus einer heutigen Perspektive sprach – Phrasen wie "1914 ist es noch nicht bekannt, dass..." oder "stand 1914 bin ich nicht vertraut mit..." waren häufig genug, um in bis zu einem Fünftel der Vervollständigungen aufzutauchen. Solche Haftungsausschlüsse machten deutlich, dass das Modell die Geschichte von außen simulierte, anstatt aus ihr heraus zu schreiben.

Die Autoren erklärten: "Die schlechte Leistung des In-Context-Lernens ist bedauerlich, weil diese Methoden die einfachsten und kostengünstigsten für KI-basierte historische Forschung sind. Wir betonen, dass wir diese Ansätze nicht erschöpfend untersucht haben. Es könnte sich herausstellen, dass In-Context-Lernen – jetzt oder in der Zukunft – für eine Untergruppe von Forschungsbereichen ausreichend ist. Aber unsere anfänglichen Beweise sind nicht ermutigend."

Die Autoren schlussfolgerten, dass die Optimierung eines kommerziellen Modells mit historischen Passagen stilistisch überzeugende Ausgaben zu minimalen Kosten erzeugen kann, aber Spuren moderner Perspektiven nicht vollständig beseitigt. Das Pretraining eines Modells ausschließlich mit Material der Periode vermeidet Anachronismus, erfordert jedoch weitaus größere Ressourcen und führt zu weniger flüssigen Ausgaben.

Keine Methode bietet eine vollständige Lösung, und vorerst scheint jeder Versuch, historische Stimmen zu simulieren, einen Kompromiss zwischen Authentizität und Kohärenz zu erfordern. Die Autoren schließen, dass weitere Forschung erforderlich sein wird, um zu klären, wie man diese Spannung am besten navigieren kann.

Fazit

Eine der faszinierendsten Fragen, die das neue Paper aufwirft, ist die der Authentizität. Während sie keine perfekten Werkzeuge sind, bieten Verlustfunktionen und Metriken wie LPIPS und SSIM Forschern im Bereich der Computervision eine Methodik zur Bewertung gegenüber der Grundwahrheit. Beim Generieren neuer Texte im Stil einer vergangenen Ära gibt es jedoch keine Grundwahrheit – nur einen Versuch, eine verschwundene kulturelle Perspektive zu bewohnen. Der Versuch, diese Denkweise aus literarischen Spuren zu rekonstruieren, ist selbst ein Akt der Quantisierung, da diese Spuren lediglich Beweise sind, während das kulturelle Bewusstsein, aus dem sie hervorgehen, jenseits der Schlussfolgerung und wahrscheinlich jenseits der Vorstellungskraft bleibt.

Auf praktischer Ebene riskieren die Grundlagen moderner Sprachmodelle, die von gegenwärtigen Normen und Daten geprägt sind, Ideen zu reinterpretieren oder zu unterdrücken, die für einen Leser der Edwardianischen Ära vernünftig oder unauffällig erschienen wären, aber heute als Artefakte von Vorurteilen, Ungleichheit oder Ungerechtigkeit registriert werden.

Man fragt sich daher, selbst wenn wir ein solches Gespräch schaffen könnten, ob es uns nicht abstoßen würde.

Erstmals veröffentlicht am Freitag, 2. Mai 2025

Die LLMs von Deep Cogito übertreffen ähnliche Modelle mit ähnlicher Größe mit IDA

Deep Cogito, ein in San Francisco ansässiges Unternehmen, macht in der KI-Community Wellen mit der neuesten Veröffentlichung von Open Language Models (LLMs). Diese Modelle, die in verschiedenen Größen von 3 bis 70 Milliarden Parametern liegen, sind nicht nur ein weiterer Satz von KI -Tools. Sie sind ein mutiger Schritt in Richtung W.

Die LLMs von Deep Cogito übertreffen ähnliche Modelle mit ähnlicher Größe mit IDA

Deep Cogito, ein in San Francisco ansässiges Unternehmen, macht in der KI-Community Wellen mit der neuesten Veröffentlichung von Open Language Models (LLMs). Diese Modelle, die in verschiedenen Größen von 3 bis 70 Milliarden Parametern liegen, sind nicht nur ein weiterer Satz von KI -Tools. Sie sind ein mutiger Schritt in Richtung W.

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Midjourney stellt hochmodernen AI-Video-Generator für kreative Inhalte vor

Midjourne's Durchbruch bei der KI-VideoerzeugungMidjourney hat sein erstes Tool zur Erzeugung von KI-Videos vorgestellt und damit seine bekannten Fähigkeiten zur Bilderstellung deutlich erweitert. Die

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

Google stoppt Pixel 10-Leaks durch frühzeitige offizielle Enthüllung des Smartphones

Google lockt seine Fans mit einem frühen Blick auf das kommende Pixel 10-Smartphone und zeigt das offizielle Design nur wenige Wochen vor dem geplanten Launch-Event am 20. August.Ein Werbevideo auf de

4. August 2025 10:40:05 MESZ

4. August 2025 10:40:05 MESZ

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

31. Juli 2025 13:35:39 MESZ

31. Juli 2025 13:35:39 MESZ

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

28. Juli 2025 03:19:05 MESZ

28. Juli 2025 03:19:05 MESZ

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

28. Juli 2025 03:18:39 MESZ

28. Juli 2025 03:18:39 MESZ

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0