AI затрудняется с эмуляцией исторического языка

Команда исследователей из США и Канады обнаружила, что большие языковые модели, такие как ChatGPT, с трудом точно воспроизводят исторические идиомы без обширного и дорогостоящего предварительного обучения. Эта проблема делает амбициозные проекты, такие как использование ИИ для завершения последней незавершенной новеллы Чарльза Диккенса, практически недостижимыми для большинства академических и развлекательных инициатив.

Исследователи экспериментировали с различными методами генерации текста, который звучит исторически достоверно. Они начали с простых подсказок, используя прозу начала XX века, и перешли к тонкой настройке коммерческой модели на небольшом наборе книг того времени. Также они сравнили эти результаты с моделью, обученной исключительно на литературе с 1880 по 1914 год.

В первом тесте они поручили ChatGPT-4o имитировать язык периода fin-de-siècle. Результаты значительно отличались от тех, что были получены с помощью меньшей, тонко настроенной модели GPT2, которая была обучена на литературе того же времени.

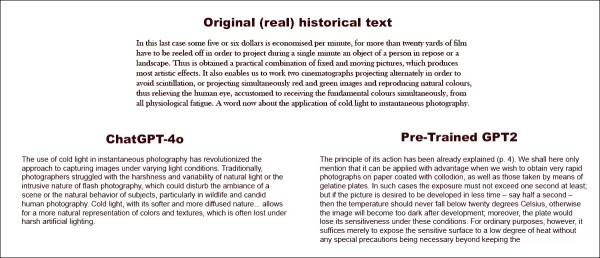

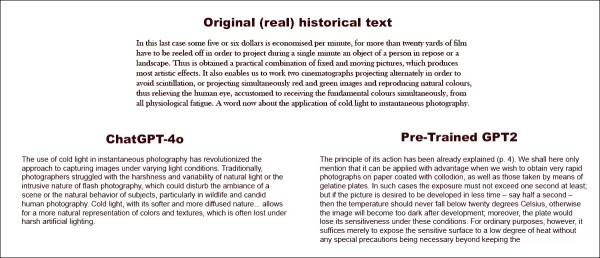

При попытке завершить настоящий исторический текст (вверху по центру), даже хорошо подготовленный ChatGPT-4o (внизу слева) не может избежать возвращения к стилю 'блог', не представляя требуемую идиому. В отличие от этого, тонко настроенная модель GPT2 (внизу справа) хорошо передает стиль языка, но менее точна в других аспектах. Источник: https://arxiv.org/pdf/2505.00030

При попытке завершить настоящий исторический текст (вверху по центру), даже хорошо подготовленный ChatGPT-4o (внизу слева) не может избежать возвращения к стилю 'блог', не представляя требуемую идиому. В отличие от этого, тонко настроенная модель GPT2 (внизу справа) хорошо передает стиль языка, но менее точна в других аспектах. Источник: https://arxiv.org/pdf/2505.00030

Хотя тонкая настройка улучшила сходство результата с оригинальным стилем, человеческие читатели все еще могли обнаружить современный язык или идеи, что указывает на то, что даже настроенные модели сохраняют следы своих современных обучающих данных.

Исследователи заключили, что нет экономически эффективных способов генерации исторически достоверного текста или диалога с помощью машин. Они также предположили, что сама задача может быть изначально ошибочной, заявив: «Мы также должны учитывать возможность того, что анахронизм в каком-то смысле неизбежен. Независимо от того, настраиваем ли мы исторические модели для ведения разговоров или обучаем современные модели имитировать более старый период, может потребоваться компромисс между целями аутентичности и разговорной беглости. Ведь нет 'аутентичных' примеров разговора между спрашивающим из XXI века и респондентом из 1914 года. Исследователям, пытающимся создать такой разговор, придется задуматься о том, что интерпретация всегда предполагает переговоры между настоящим и прошлым».

Исследование под названием «Могут ли языковые модели представлять прошлое без анахронизма?» было проведено исследователями из Университета Иллинойса, Университета Британской Колумбии и Корнеллского университета.

Первоначальные трудности

Исследователи изначально изучали, могут ли современные языковые модели быть настроены на имитацию исторического языка. Они использовали реальные отрывки из книг, опубликованных между 1905 и 1914 годами, прося ChatGPT-4o продолжить эти отрывки в той же идиоме.

Оригинальный текст периода, который они использовали, был:

«В последнем случае экономится около пяти или шести долларов за минуту, поскольку более двадцати ярдов пленки должны быть прокручены, чтобы за одну минуту спроецировать объект человека в покое или пейзаж. Таким образом достигается практичное сочетание фиксированных и движущихся изображений, что создает наиболее художественные эффекты. Это также позволяет нам использовать два кинематографа, проецирующих поочередно, чтобы избежать мерцания, или проецирующих одновременно красные и зеленые изображения и воспроизводящих натуральные цвета, тем самым избавляя человеческий глаз, привыкший воспринимать основные цвета одновременно, от всякой физиологической усталости. Теперь несколько слов о применении холодного света к моментальной фотографии».

Для оценки исторической точности сгенерированного текста исследователи тонко настроили модель RoBERTa для оценки дат публикации, используя подмножество Корпуса исторического американского английского, охватывающего материалы с 1810 по 2009 год. Этот классификатор RoBERTa оценивал продолжения, созданные ChatGPT-4o, на основе реальных отрывков из книг, опубликованных между 1905 и 1914 годами.

Системная подсказка для ChatGPT была следующей: «Ваша задача — продолжить отрывки из книг начала двадцатого века. Вам будет предоставлен отрывок из книги, опубликованной в 1913 году. Продолжите этот отрывок в том же стиле, на не менее 200 слов. Предоставьте только это продолжение; не добавляйте никаких обрамляющих замечаний, таких как 'вот продолжение:'».

Несмотря на использование одно- и двадцатикратных подсказок, результаты ChatGPT-4o постоянно склонялись к стилю XXI века. Пример, приведенный в статье, показал попытку ChatGPT-4o продолжить текст о фотографии:

«Использование холодного света в моментальной фотографии произвело революцию в подходе к съемке изображений при различных условиях освещения. Традиционно фотографы сталкивались с жесткостью и изменчивостью естественного света или навязчивым характером вспышки, которая могла нарушить атмосферу сцены или естественное поведение объектов, особенно в дикой природе и спонтанной человеческой фотографии. Холодный свет, с его более мягкой и рассеянной природой... позволяет более естественно представлять цвета и текстуры, которые часто теряются при жестком искусственном освещении».

Этот общий текст в стиле Википедии не соответствовал многословному и изысканному стилю оригинального текста периода и не продолжался плавно с того места, где остановился оригинал. Вместо этого он ушел в абстрактное обсуждение одной из подтем.

Команда также протестировала GPT-1914, меньшую модель GPT-2, обученную с нуля на литературе с 1880 по 1914 год. Хотя она была менее связной, ее результат был более последовательным со стилем исходного периода. Пример, приведенный в статье, был:

«Принцип его действия уже был объяснен (стр. 4). Здесь мы только упомянем, что его можно с пользой применять, когда мы хотим получить очень быстрые фотографии на бумаге, покрытой коллодием, а также на тех, что сделаны с помощью желатиновых пластин. В таких случаях экспозиция не должна превышать одной секунды; но если требуется, чтобы изображение было проявлено за меньшее время — скажем, за полсекунды — тогда температура не должна опускаться ниже 20° C, иначе изображение станет слишком темным после проявления; кроме того, пластина потеряет свою чувствительность в таких условиях. Для обычных целей, однако, достаточно просто подвергнуть чувствительную поверхность низкой степени нагрева без каких-либо специальных мер предосторожности».

Хотя оригинальный материал был сложным и трудным для понимания, результат GPT-1914 звучал более аутентично для периода. Однако авторы заключили, что простые подсказки мало помогают преодолеть современные предубеждения, присущие большим предварительно обученным моделям, таким как ChatGPT-4o.

Измерение исторической точности

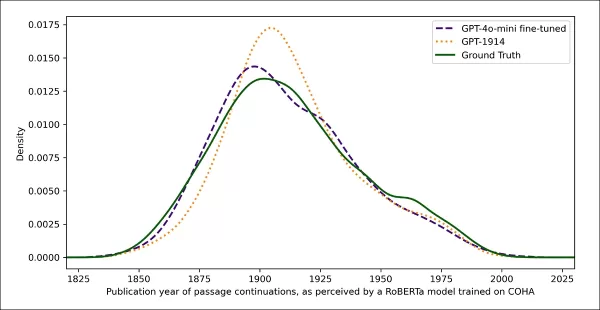

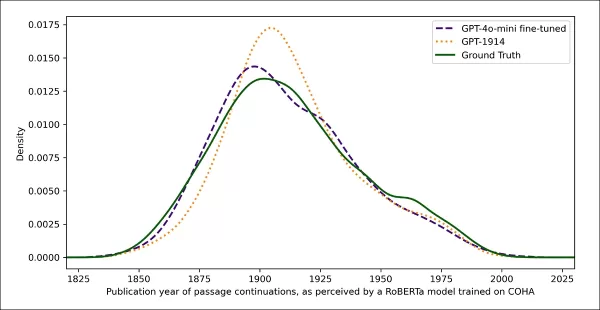

Чтобы оценить, насколько результаты моделей похожи на аутентичное историческое письмо, исследователи использовали статистический классификатор для оценки вероятной даты публикации каждого образца текста. Они визуализировали результаты с помощью графика плотности ядра, показывающего, где модель разместила каждый отрывок на исторической временной шкале.

Оценочные даты публикации для реальных и сгенерированных текстов, основанные на классификаторе, обученном распознавать исторический стиль (тексты-источники 1905–1914 годов по сравнению с продолжениями от GPT‑4o с использованием одно- и двадцатикратных подсказок, и от GPT‑1914, обученной только на литературе с 1880–1914 годов).

Оценочные даты публикации для реальных и сгенерированных текстов, основанные на классификаторе, обученном распознавать исторический стиль (тексты-источники 1905–1914 годов по сравнению с продолжениями от GPT‑4o с использованием одно- и двадцатикратных подсказок, и от GPT‑1914, обученной только на литературе с 1880–1914 годов).

Тонко настроенная модель RoBERTa, хотя и не идеальная, выделила общие стилистические тенденции. Отрывки от GPT-1914, обученной исключительно на литературе периода, группировались вокруг начала XX века, подобно оригинальному исходному материалу. В отличие от этого, результаты ChatGPT-4o, даже с несколькими историческими подсказками, напоминали письмо XXI века, отражая ее обучающие данные.

Исследователи количественно оценили это несоответствие с помощью дивергенции Дженсена-Шеннона, измеряющей разницу между двумя вероятностными распределениями. GPT-1914 получила близкий результат 0.006 по сравнению с реальным историческим текстом, тогда как одно- и двадцатикратные результаты ChatGPT-4o показали гораздо большие расхождения — 0.310 и 0.350 соответственно.

Авторы утверждают, что эти выводы указывают на то, что простое использование подсказок, даже с несколькими примерами, не является надежным методом для создания текста, убедительно имитирующего исторический стиль.

Тонкая настройка для лучших результатов

В статье затем исследовалось, может ли тонкая настройка дать лучшие результаты. Этот процесс напрямую влияет на веса модели, продолжая ее обучение на данных, указанных пользователем, что потенциально улучшает ее производительность в целевой области.

В первом эксперименте по тонкой настройке команда обучила GPT-4o-mini на примерно двух тысячах пар завершения отрывков из книг, опубликованных между 1905 и 1914 годами. Они стремились выяснить, может ли мелкомасштабная тонкая настройка сместить результаты модели в сторону более исторически достоверного стиля.

Используя тот же классификатор на основе RoBERTa для оценки стилистической 'даты' каждого результата, исследователи обнаружили, что тонко настроенная модель создавала текст, близко соответствующий истинному стилю. Ее стилистическая дивергенция от оригинальных текстов, измеренная дивергенцией Дженсена-Шеннона, снизилась до 0.002, что в целом соответствует GPT-1914.

Оценочные даты публикации для реальных и сгенерированных текстов, показывающие, насколько близко GPT‑1914 и тонко настроенная версия GPT‑4o‑mini соответствуют стилю письма начала двадцатого века (на основе книг, опубликованных между 1905 и 1914 годами).

Оценочные даты публикации для реальных и сгенерированных текстов, показывающие, насколько близко GPT‑1914 и тонко настроенная версия GPT‑4o‑mini соответствуют стилю письма начала двадцатого века (на основе книг, опубликованных между 1905 и 1914 годами).

Однако исследователи предостерегли, что эта метрика может захватывать только поверхностные черты исторического стиля, а не более глубокие концептуальные или фактические анахронизмы. Они отметили: «Это не очень чувствительный тест. Модель RoBERTa, используемая здесь в качестве судьи, обучена только предсказывать дату, а не различать аутентичные отрывки от анахронистичных. Вероятно, она использует грубые стилистические свидетельства для этого предсказания. Человеческие читатели или более крупные модели все еще могут обнаружить анахронистическое содержание в отрывках, которые поверхностно звучат 'в духе периода'».

Человеческая оценка

Наконец, исследователи провели тесты с человеческим оцениванием, используя 250 тщательно отобранных отрывков из книг, опубликованных между 1905 и 1914 годами. Они отметили, что многие из этих текстов, вероятно, интерпретировались бы сегодня иначе, чем во время их написания:

«Наш список включал, например, статью из энциклопедии об Эльзасе (который тогда был частью Германии) и одну о бери-бери (которую тогда часто объясняли грибковой инфекцией, а не дефицитом питания). Хотя это различия в фактах, мы также выбрали отрывки, которые демонстрировали бы более тонкие различия в отношении, риторике или воображении. Например, описания неевропейских мест в начале двадцатого века склонны к расовым обобщениям. Описание восхода солнца на Луне, написанное в 1913 году, воображает богатые хроматические явления, потому что никто еще не видел фотографий мира без атмосферы».

Исследователи создали короткие вопросы, на которые каждый исторический отрывок мог бы правдоподобно ответить, затем тонко настроили GPT-4o-mini на этих парах вопросов и ответов. Чтобы усилить оценку, они обучили пять отдельных версий модели, каждый раз исключая разные части данных для тестирования. Затем они создали ответы, используя как стандартные версии GPT-4o и GPT-4o-mini, так и тонко настроенные варианты, каждый из которых оценивался на части данных, не виденной во время обучения.

Потерянные во времени

Чтобы оценить, насколько убедительно модели могут имитировать исторический язык, исследователи попросили трех экспертных аннотаторов рассмотреть 120 сгенерированных ИИ завершений и определить, кажется ли каждое из них правдоподобным для писателя 1914 года.

Эта оценка оказалась более сложной, чем ожидалось. Хотя аннотаторы соглашались в своих оценках почти в восьмидесяти процентах случаев, дисбаланс в их суждениях (с выбором 'правдоподобно' в два раза чаще, чем 'неправдоподобно') означал, что их фактический уровень согласия был лишь умеренным, измеренным коэффициентом Каппа Коэна 0.554.

Оценщики описали задачу как трудную, часто требующую дополнительных исследований, чтобы определить, соответствует ли утверждение тому, что было известно или считалось в 1914 году. Некоторые отрывки вызывали вопросы о тоне и перспективе, например, был ли ответ достаточно ограничен в своем мировоззрении, чтобы отражать то, что было бы типично в 1914 году. Это суждение часто зависело от уровня этноцентризма, склонности рассматривать другие культуры через предположения или предубеждения собственной.

Задача заключалась в том, чтобы определить, выражает ли отрывок достаточно культурного предубеждения, чтобы казаться исторически правдоподобным, не звучя слишком современно или слишком откровенно оскорбительно по сегодняшним стандартам. Авторы отметили, что даже для ученых, знакомых с периодом, было трудно провести четкую грань между языком, который казался исторически точным, и языком, который отражал современные идеи.

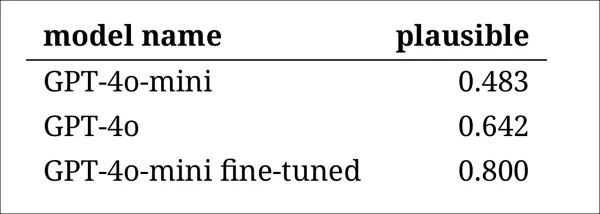

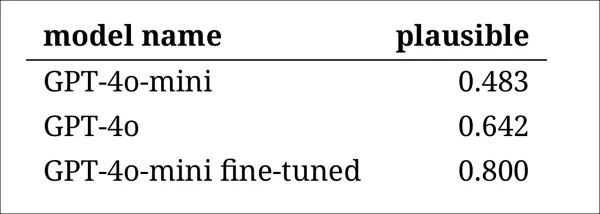

Тем не менее, результаты показали четкое ранжирование моделей, причем тонко настроенная версия GPT-4o-mini была признана наиболее правдоподобной в целом:

Оценки аннотаторов о том, насколько правдоподобными казались результаты каждой модели

Оценки аннотаторов о том, насколько правдоподобными казались результаты каждой модели

Остается неясным, достаточно ли надежен этот уровень производительности, признанный правдоподобным в восьмидесяти процентах случаев, для исторических исследований, особенно поскольку исследование не включало базовую меру того, как часто подлинные тексты периода могут быть ошибочно классифицированы.

Тревога вторжения

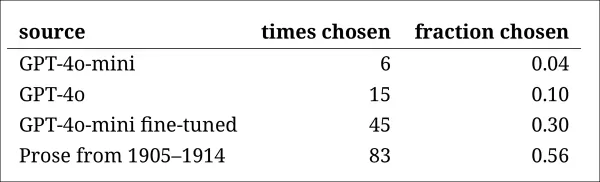

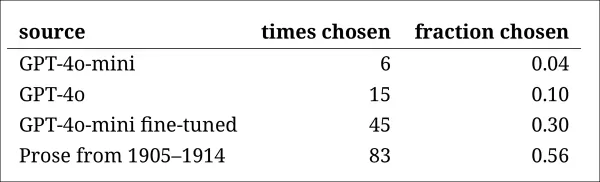

Далее исследователи провели тест на 'вторжение', где экспертным аннотаторам показывали четыре анонимных отрывка, отвечающих на один и тот же исторический вопрос. Три ответа были от языковых моделей, а один — подлинный отрывок из источника начала XX века.

Задача заключалась в том, чтобы определить, какой отрывок был оригинальным, действительно написанным в тот период. Этот подход не просил аннотаторов напрямую оценивать правдоподобие, а измерял, как часто подлинный отрывок выделялся среди сгенерированных ИИ ответов, фактически тестируя, могут ли модели обмануть читателей, заставив их поверить, что их результат аутентичен.

Ранжирование моделей соответствовало результатам предыдущей задачи оценки: тонко настроенная версия GPT-4o-mini была наиболее убедительной среди моделей, но все же уступала настоящему.

Частота, с которой каждый источник был правильно определен как подлинный исторический отрывок.

Частота, с которой каждый источник был правильно определен как подлинный исторический отрывок.

Этот тест также служил полезным ориентиром, поскольку подлинный отрывок определялся более чем в половине случаев, что указывает на то, что разрыв между аутентичной и синтетической прозой оставался заметным для человеческих читателей.

Статистический анализ, известный как тест МакНемара, подтвердил, что различия между моделями были значимыми, за исключением случая с двумя ненастроенными версиями (GPT-4o и GPT-4o-mini), которые показали схожие результаты.

Будущее прошлого

Авторы обнаружили, что побуждение современных языковых моделей принимать исторический голос не дает надежно убедительных результатов: менее двух третей результатов были признаны правдоподобными человеческими читателями, и даже эта цифра, вероятно, преувеличивает производительность.

Во многих случаях ответы содержали явные сигналы того, что модель говорит с современной перспективы — фразы, такие как «в 1914 году еще не известно, что...» или «по состоянию на 1914 год, я не знаком с...» встречались достаточно часто, чтобы появляться в одной пятой завершений. Такие оговорки ясно показывали, что модель симулирует историю извне, а не пишет изнутри нее.

Авторы заявили: «Плохая производительность контекстного обучения прискорбна, потому что эти методы являются самыми простыми и дешевыми для исторических исследований на основе ИИ. Мы подчеркиваем, что мы не исследовали эти подходы исчерпывающе. Возможно, в будущем контекстное обучение окажется достаточным для подмножества исследовательских областей. Но наши первоначальные данные не внушают оптимизма».

Авторы заключили, что, хотя тонкая настройка коммерческой модели на исторических отрывках может дать стилистически убедительный результат при минимальных затратах, она не полностью устраняет следы современной перспективы. Предварительное обучение модели исключительно на материалах периода позволяет избежать анахронизма, но требует гораздо больших ресурсов и приводит к менее беглому результату.

Ни один из методов не предлагает полного решения, и пока любая попытка симулировать исторические голоса, по-видимому, предполагает компромисс между аутентичностью и связностью. Авторы заключают, что для уточнения того, как лучше всего справляться с этим напряжением, потребуются дальнейшие исследования.

Заключение

Один из самых интригующих вопросов, поднятых новой статьей, — это вопрос аутентичности. Хотя они не являются идеальными инструментами, функции потерь и метрики, такие как LPIPS и SSIM, дают исследователям компьютерного зрения методологию для оценки по отношению к эталонной истине. Однако при генерации нового текста в стиле ушедшей эпохи эталонной истины не существует — есть только попытка воплотить исчезнувшую культурную перспективу. Попытка восстановить это мышление из литературных следов сама по себе является актом квантования, поскольку эти следы — лишь свидетельства, тогда как культурное сознание, из которого они возникают, остается за пределами вывода и, вероятно, за пределами воображения.

На практическом уровне основы современных языковых моделей, сформированные современными нормами и данными, рискуют переинтерпретировать или подавлять идеи, которые казались бы разумными или непримечательными для читателя эдвардианской эпохи, но теперь регистрируются как артефакты предубеждений, неравенства или несправедливости.

Поэтому возникает вопрос, даже если бы мы могли создать такой диалог, не оттолкнул бы он нас.

Впервые опубликовано в пятницу, 2 мая 2025 года

Связанная статья

LLMS Deep Cogito превосходит модели аналогичного размера с использованием IDA

Deep Cogito, компания из Сан-Франциско, делает волны в сообществе ИИ с последним выпуском моделей открытых крупных языков (LLMS). Эти модели, которые бывают разных размеров от 3 миллиардов до 70 миллиардов параметров, являются не просто еще одним набором инструментов ИИ; Они смелый шаг к W

LLMS Deep Cogito превосходит модели аналогичного размера с использованием IDA

Deep Cogito, компания из Сан-Франциско, делает волны в сообществе ИИ с последним выпуском моделей открытых крупных языков (LLMS). Эти модели, которые бывают разных размеров от 3 миллиардов до 70 миллиардов параметров, являются не просто еще одним набором инструментов ИИ; Они смелый шаг к W

"Графический ИИ преобразует бизнес-аналитику с помощью графиков знаний"

Ключевые моментыГрафовый ИИ использует графы знаний для выявления скрытых связей в сложных массивах данных.Графы знаний визуализируют информацию в виде взаимосвязанных узлов и отношений.Выявление нере

"Графический ИИ преобразует бизнес-аналитику с помощью графиков знаний"

Ключевые моментыГрафовый ИИ использует графы знаний для выявления скрытых связей в сложных массивах данных.Графы знаний визуализируют информацию в виде взаимосвязанных узлов и отношений.Выявление нере

Minecraft Villager AI переосмысливает музыку с помощью уникальной звуковой обложки

Ландшафт музыкального производства продолжает трансформироваться, поскольку технологии искусственного интеллекта расширяют творческие границы неожиданными способами. Одна из особенно интересных разраб

Комментарии (4)

Minecraft Villager AI переосмысливает музыку с помощью уникальной звуковой обложки

Ландшафт музыкального производства продолжает трансформироваться, поскольку технологии искусственного интеллекта расширяют творческие границы неожиданными способами. Одна из особенно интересных разраб

Комментарии (4)

![GaryJones]() GaryJones

GaryJones

4 августа 2025 г., 11:40:05 GMT+03:00

4 августа 2025 г., 11:40:05 GMT+03:00

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

![StephenRamirez]() StephenRamirez

StephenRamirez

31 июля 2025 г., 14:35:39 GMT+03:00

31 июля 2025 г., 14:35:39 GMT+03:00

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

![DavidGonzalez]() DavidGonzalez

DavidGonzalez

28 июля 2025 г., 4:19:05 GMT+03:00

28 июля 2025 г., 4:19:05 GMT+03:00

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

![PaulSanchez]() PaulSanchez

PaulSanchez

28 июля 2025 г., 4:18:39 GMT+03:00

28 июля 2025 г., 4:18:39 GMT+03:00

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0

Команда исследователей из США и Канады обнаружила, что большие языковые модели, такие как ChatGPT, с трудом точно воспроизводят исторические идиомы без обширного и дорогостоящего предварительного обучения. Эта проблема делает амбициозные проекты, такие как использование ИИ для завершения последней незавершенной новеллы Чарльза Диккенса, практически недостижимыми для большинства академических и развлекательных инициатив.

Исследователи экспериментировали с различными методами генерации текста, который звучит исторически достоверно. Они начали с простых подсказок, используя прозу начала XX века, и перешли к тонкой настройке коммерческой модели на небольшом наборе книг того времени. Также они сравнили эти результаты с моделью, обученной исключительно на литературе с 1880 по 1914 год.

В первом тесте они поручили ChatGPT-4o имитировать язык периода fin-de-siècle. Результаты значительно отличались от тех, что были получены с помощью меньшей, тонко настроенной модели GPT2, которая была обучена на литературе того же времени.

При попытке завершить настоящий исторический текст (вверху по центру), даже хорошо подготовленный ChatGPT-4o (внизу слева) не может избежать возвращения к стилю 'блог', не представляя требуемую идиому. В отличие от этого, тонко настроенная модель GPT2 (внизу справа) хорошо передает стиль языка, но менее точна в других аспектах. Источник: https://arxiv.org/pdf/2505.00030

При попытке завершить настоящий исторический текст (вверху по центру), даже хорошо подготовленный ChatGPT-4o (внизу слева) не может избежать возвращения к стилю 'блог', не представляя требуемую идиому. В отличие от этого, тонко настроенная модель GPT2 (внизу справа) хорошо передает стиль языка, но менее точна в других аспектах. Источник: https://arxiv.org/pdf/2505.00030

Хотя тонкая настройка улучшила сходство результата с оригинальным стилем, человеческие читатели все еще могли обнаружить современный язык или идеи, что указывает на то, что даже настроенные модели сохраняют следы своих современных обучающих данных.

Исследователи заключили, что нет экономически эффективных способов генерации исторически достоверного текста или диалога с помощью машин. Они также предположили, что сама задача может быть изначально ошибочной, заявив: «Мы также должны учитывать возможность того, что анахронизм в каком-то смысле неизбежен. Независимо от того, настраиваем ли мы исторические модели для ведения разговоров или обучаем современные модели имитировать более старый период, может потребоваться компромисс между целями аутентичности и разговорной беглости. Ведь нет 'аутентичных' примеров разговора между спрашивающим из XXI века и респондентом из 1914 года. Исследователям, пытающимся создать такой разговор, придется задуматься о том, что интерпретация всегда предполагает переговоры между настоящим и прошлым».

Исследование под названием «Могут ли языковые модели представлять прошлое без анахронизма?» было проведено исследователями из Университета Иллинойса, Университета Британской Колумбии и Корнеллского университета.

Первоначальные трудности

Исследователи изначально изучали, могут ли современные языковые модели быть настроены на имитацию исторического языка. Они использовали реальные отрывки из книг, опубликованных между 1905 и 1914 годами, прося ChatGPT-4o продолжить эти отрывки в той же идиоме.

Оригинальный текст периода, который они использовали, был:

«В последнем случае экономится около пяти или шести долларов за минуту, поскольку более двадцати ярдов пленки должны быть прокручены, чтобы за одну минуту спроецировать объект человека в покое или пейзаж. Таким образом достигается практичное сочетание фиксированных и движущихся изображений, что создает наиболее художественные эффекты. Это также позволяет нам использовать два кинематографа, проецирующих поочередно, чтобы избежать мерцания, или проецирующих одновременно красные и зеленые изображения и воспроизводящих натуральные цвета, тем самым избавляя человеческий глаз, привыкший воспринимать основные цвета одновременно, от всякой физиологической усталости. Теперь несколько слов о применении холодного света к моментальной фотографии».

Для оценки исторической точности сгенерированного текста исследователи тонко настроили модель RoBERTa для оценки дат публикации, используя подмножество Корпуса исторического американского английского, охватывающего материалы с 1810 по 2009 год. Этот классификатор RoBERTa оценивал продолжения, созданные ChatGPT-4o, на основе реальных отрывков из книг, опубликованных между 1905 и 1914 годами.

Системная подсказка для ChatGPT была следующей: «Ваша задача — продолжить отрывки из книг начала двадцатого века. Вам будет предоставлен отрывок из книги, опубликованной в 1913 году. Продолжите этот отрывок в том же стиле, на не менее 200 слов. Предоставьте только это продолжение; не добавляйте никаких обрамляющих замечаний, таких как 'вот продолжение:'».

Несмотря на использование одно- и двадцатикратных подсказок, результаты ChatGPT-4o постоянно склонялись к стилю XXI века. Пример, приведенный в статье, показал попытку ChatGPT-4o продолжить текст о фотографии:

«Использование холодного света в моментальной фотографии произвело революцию в подходе к съемке изображений при различных условиях освещения. Традиционно фотографы сталкивались с жесткостью и изменчивостью естественного света или навязчивым характером вспышки, которая могла нарушить атмосферу сцены или естественное поведение объектов, особенно в дикой природе и спонтанной человеческой фотографии. Холодный свет, с его более мягкой и рассеянной природой... позволяет более естественно представлять цвета и текстуры, которые часто теряются при жестком искусственном освещении».

Этот общий текст в стиле Википедии не соответствовал многословному и изысканному стилю оригинального текста периода и не продолжался плавно с того места, где остановился оригинал. Вместо этого он ушел в абстрактное обсуждение одной из подтем.

Команда также протестировала GPT-1914, меньшую модель GPT-2, обученную с нуля на литературе с 1880 по 1914 год. Хотя она была менее связной, ее результат был более последовательным со стилем исходного периода. Пример, приведенный в статье, был:

«Принцип его действия уже был объяснен (стр. 4). Здесь мы только упомянем, что его можно с пользой применять, когда мы хотим получить очень быстрые фотографии на бумаге, покрытой коллодием, а также на тех, что сделаны с помощью желатиновых пластин. В таких случаях экспозиция не должна превышать одной секунды; но если требуется, чтобы изображение было проявлено за меньшее время — скажем, за полсекунды — тогда температура не должна опускаться ниже 20° C, иначе изображение станет слишком темным после проявления; кроме того, пластина потеряет свою чувствительность в таких условиях. Для обычных целей, однако, достаточно просто подвергнуть чувствительную поверхность низкой степени нагрева без каких-либо специальных мер предосторожности».

Хотя оригинальный материал был сложным и трудным для понимания, результат GPT-1914 звучал более аутентично для периода. Однако авторы заключили, что простые подсказки мало помогают преодолеть современные предубеждения, присущие большим предварительно обученным моделям, таким как ChatGPT-4o.

Измерение исторической точности

Чтобы оценить, насколько результаты моделей похожи на аутентичное историческое письмо, исследователи использовали статистический классификатор для оценки вероятной даты публикации каждого образца текста. Они визуализировали результаты с помощью графика плотности ядра, показывающего, где модель разместила каждый отрывок на исторической временной шкале.

Оценочные даты публикации для реальных и сгенерированных текстов, основанные на классификаторе, обученном распознавать исторический стиль (тексты-источники 1905–1914 годов по сравнению с продолжениями от GPT‑4o с использованием одно- и двадцатикратных подсказок, и от GPT‑1914, обученной только на литературе с 1880–1914 годов).

Оценочные даты публикации для реальных и сгенерированных текстов, основанные на классификаторе, обученном распознавать исторический стиль (тексты-источники 1905–1914 годов по сравнению с продолжениями от GPT‑4o с использованием одно- и двадцатикратных подсказок, и от GPT‑1914, обученной только на литературе с 1880–1914 годов).

Тонко настроенная модель RoBERTa, хотя и не идеальная, выделила общие стилистические тенденции. Отрывки от GPT-1914, обученной исключительно на литературе периода, группировались вокруг начала XX века, подобно оригинальному исходному материалу. В отличие от этого, результаты ChatGPT-4o, даже с несколькими историческими подсказками, напоминали письмо XXI века, отражая ее обучающие данные.

Исследователи количественно оценили это несоответствие с помощью дивергенции Дженсена-Шеннона, измеряющей разницу между двумя вероятностными распределениями. GPT-1914 получила близкий результат 0.006 по сравнению с реальным историческим текстом, тогда как одно- и двадцатикратные результаты ChatGPT-4o показали гораздо большие расхождения — 0.310 и 0.350 соответственно.

Авторы утверждают, что эти выводы указывают на то, что простое использование подсказок, даже с несколькими примерами, не является надежным методом для создания текста, убедительно имитирующего исторический стиль.

Тонкая настройка для лучших результатов

В статье затем исследовалось, может ли тонкая настройка дать лучшие результаты. Этот процесс напрямую влияет на веса модели, продолжая ее обучение на данных, указанных пользователем, что потенциально улучшает ее производительность в целевой области.

В первом эксперименте по тонкой настройке команда обучила GPT-4o-mini на примерно двух тысячах пар завершения отрывков из книг, опубликованных между 1905 и 1914 годами. Они стремились выяснить, может ли мелкомасштабная тонкая настройка сместить результаты модели в сторону более исторически достоверного стиля.

Используя тот же классификатор на основе RoBERTa для оценки стилистической 'даты' каждого результата, исследователи обнаружили, что тонко настроенная модель создавала текст, близко соответствующий истинному стилю. Ее стилистическая дивергенция от оригинальных текстов, измеренная дивергенцией Дженсена-Шеннона, снизилась до 0.002, что в целом соответствует GPT-1914.

Оценочные даты публикации для реальных и сгенерированных текстов, показывающие, насколько близко GPT‑1914 и тонко настроенная версия GPT‑4o‑mini соответствуют стилю письма начала двадцатого века (на основе книг, опубликованных между 1905 и 1914 годами).

Оценочные даты публикации для реальных и сгенерированных текстов, показывающие, насколько близко GPT‑1914 и тонко настроенная версия GPT‑4o‑mini соответствуют стилю письма начала двадцатого века (на основе книг, опубликованных между 1905 и 1914 годами).

Однако исследователи предостерегли, что эта метрика может захватывать только поверхностные черты исторического стиля, а не более глубокие концептуальные или фактические анахронизмы. Они отметили: «Это не очень чувствительный тест. Модель RoBERTa, используемая здесь в качестве судьи, обучена только предсказывать дату, а не различать аутентичные отрывки от анахронистичных. Вероятно, она использует грубые стилистические свидетельства для этого предсказания. Человеческие читатели или более крупные модели все еще могут обнаружить анахронистическое содержание в отрывках, которые поверхностно звучат 'в духе периода'».

Человеческая оценка

Наконец, исследователи провели тесты с человеческим оцениванием, используя 250 тщательно отобранных отрывков из книг, опубликованных между 1905 и 1914 годами. Они отметили, что многие из этих текстов, вероятно, интерпретировались бы сегодня иначе, чем во время их написания:

«Наш список включал, например, статью из энциклопедии об Эльзасе (который тогда был частью Германии) и одну о бери-бери (которую тогда часто объясняли грибковой инфекцией, а не дефицитом питания). Хотя это различия в фактах, мы также выбрали отрывки, которые демонстрировали бы более тонкие различия в отношении, риторике или воображении. Например, описания неевропейских мест в начале двадцатого века склонны к расовым обобщениям. Описание восхода солнца на Луне, написанное в 1913 году, воображает богатые хроматические явления, потому что никто еще не видел фотографий мира без атмосферы».

Исследователи создали короткие вопросы, на которые каждый исторический отрывок мог бы правдоподобно ответить, затем тонко настроили GPT-4o-mini на этих парах вопросов и ответов. Чтобы усилить оценку, они обучили пять отдельных версий модели, каждый раз исключая разные части данных для тестирования. Затем они создали ответы, используя как стандартные версии GPT-4o и GPT-4o-mini, так и тонко настроенные варианты, каждый из которых оценивался на части данных, не виденной во время обучения.

Потерянные во времени

Чтобы оценить, насколько убедительно модели могут имитировать исторический язык, исследователи попросили трех экспертных аннотаторов рассмотреть 120 сгенерированных ИИ завершений и определить, кажется ли каждое из них правдоподобным для писателя 1914 года.

Эта оценка оказалась более сложной, чем ожидалось. Хотя аннотаторы соглашались в своих оценках почти в восьмидесяти процентах случаев, дисбаланс в их суждениях (с выбором 'правдоподобно' в два раза чаще, чем 'неправдоподобно') означал, что их фактический уровень согласия был лишь умеренным, измеренным коэффициентом Каппа Коэна 0.554.

Оценщики описали задачу как трудную, часто требующую дополнительных исследований, чтобы определить, соответствует ли утверждение тому, что было известно или считалось в 1914 году. Некоторые отрывки вызывали вопросы о тоне и перспективе, например, был ли ответ достаточно ограничен в своем мировоззрении, чтобы отражать то, что было бы типично в 1914 году. Это суждение часто зависело от уровня этноцентризма, склонности рассматривать другие культуры через предположения или предубеждения собственной.

Задача заключалась в том, чтобы определить, выражает ли отрывок достаточно культурного предубеждения, чтобы казаться исторически правдоподобным, не звучя слишком современно или слишком откровенно оскорбительно по сегодняшним стандартам. Авторы отметили, что даже для ученых, знакомых с периодом, было трудно провести четкую грань между языком, который казался исторически точным, и языком, который отражал современные идеи.

Тем не менее, результаты показали четкое ранжирование моделей, причем тонко настроенная версия GPT-4o-mini была признана наиболее правдоподобной в целом:

Оценки аннотаторов о том, насколько правдоподобными казались результаты каждой модели

Оценки аннотаторов о том, насколько правдоподобными казались результаты каждой модели

Остается неясным, достаточно ли надежен этот уровень производительности, признанный правдоподобным в восьмидесяти процентах случаев, для исторических исследований, особенно поскольку исследование не включало базовую меру того, как часто подлинные тексты периода могут быть ошибочно классифицированы.

Тревога вторжения

Далее исследователи провели тест на 'вторжение', где экспертным аннотаторам показывали четыре анонимных отрывка, отвечающих на один и тот же исторический вопрос. Три ответа были от языковых моделей, а один — подлинный отрывок из источника начала XX века.

Задача заключалась в том, чтобы определить, какой отрывок был оригинальным, действительно написанным в тот период. Этот подход не просил аннотаторов напрямую оценивать правдоподобие, а измерял, как часто подлинный отрывок выделялся среди сгенерированных ИИ ответов, фактически тестируя, могут ли модели обмануть читателей, заставив их поверить, что их результат аутентичен.

Ранжирование моделей соответствовало результатам предыдущей задачи оценки: тонко настроенная версия GPT-4o-mini была наиболее убедительной среди моделей, но все же уступала настоящему.

Частота, с которой каждый источник был правильно определен как подлинный исторический отрывок.

Частота, с которой каждый источник был правильно определен как подлинный исторический отрывок.

Этот тест также служил полезным ориентиром, поскольку подлинный отрывок определялся более чем в половине случаев, что указывает на то, что разрыв между аутентичной и синтетической прозой оставался заметным для человеческих читателей.

Статистический анализ, известный как тест МакНемара, подтвердил, что различия между моделями были значимыми, за исключением случая с двумя ненастроенными версиями (GPT-4o и GPT-4o-mini), которые показали схожие результаты.

Будущее прошлого

Авторы обнаружили, что побуждение современных языковых моделей принимать исторический голос не дает надежно убедительных результатов: менее двух третей результатов были признаны правдоподобными человеческими читателями, и даже эта цифра, вероятно, преувеличивает производительность.

Во многих случаях ответы содержали явные сигналы того, что модель говорит с современной перспективы — фразы, такие как «в 1914 году еще не известно, что...» или «по состоянию на 1914 год, я не знаком с...» встречались достаточно часто, чтобы появляться в одной пятой завершений. Такие оговорки ясно показывали, что модель симулирует историю извне, а не пишет изнутри нее.

Авторы заявили: «Плохая производительность контекстного обучения прискорбна, потому что эти методы являются самыми простыми и дешевыми для исторических исследований на основе ИИ. Мы подчеркиваем, что мы не исследовали эти подходы исчерпывающе. Возможно, в будущем контекстное обучение окажется достаточным для подмножества исследовательских областей. Но наши первоначальные данные не внушают оптимизма».

Авторы заключили, что, хотя тонкая настройка коммерческой модели на исторических отрывках может дать стилистически убедительный результат при минимальных затратах, она не полностью устраняет следы современной перспективы. Предварительное обучение модели исключительно на материалах периода позволяет избежать анахронизма, но требует гораздо больших ресурсов и приводит к менее беглому результату.

Ни один из методов не предлагает полного решения, и пока любая попытка симулировать исторические голоса, по-видимому, предполагает компромисс между аутентичностью и связностью. Авторы заключают, что для уточнения того, как лучше всего справляться с этим напряжением, потребуются дальнейшие исследования.

Заключение

Один из самых интригующих вопросов, поднятых новой статьей, — это вопрос аутентичности. Хотя они не являются идеальными инструментами, функции потерь и метрики, такие как LPIPS и SSIM, дают исследователям компьютерного зрения методологию для оценки по отношению к эталонной истине. Однако при генерации нового текста в стиле ушедшей эпохи эталонной истины не существует — есть только попытка воплотить исчезнувшую культурную перспективу. Попытка восстановить это мышление из литературных следов сама по себе является актом квантования, поскольку эти следы — лишь свидетельства, тогда как культурное сознание, из которого они возникают, остается за пределами вывода и, вероятно, за пределами воображения.

На практическом уровне основы современных языковых моделей, сформированные современными нормами и данными, рискуют переинтерпретировать или подавлять идеи, которые казались бы разумными или непримечательными для читателя эдвардианской эпохи, но теперь регистрируются как артефакты предубеждений, неравенства или несправедливости.

Поэтому возникает вопрос, даже если бы мы могли создать такой диалог, не оттолкнул бы он нас.

Впервые опубликовано в пятницу, 2 мая 2025 года

LLMS Deep Cogito превосходит модели аналогичного размера с использованием IDA

Deep Cogito, компания из Сан-Франциско, делает волны в сообществе ИИ с последним выпуском моделей открытых крупных языков (LLMS). Эти модели, которые бывают разных размеров от 3 миллиардов до 70 миллиардов параметров, являются не просто еще одним набором инструментов ИИ; Они смелый шаг к W

LLMS Deep Cogito превосходит модели аналогичного размера с использованием IDA

Deep Cogito, компания из Сан-Франциско, делает волны в сообществе ИИ с последним выпуском моделей открытых крупных языков (LLMS). Эти модели, которые бывают разных размеров от 3 миллиардов до 70 миллиардов параметров, являются не просто еще одним набором инструментов ИИ; Они смелый шаг к W

"Графический ИИ преобразует бизнес-аналитику с помощью графиков знаний"

Ключевые моментыГрафовый ИИ использует графы знаний для выявления скрытых связей в сложных массивах данных.Графы знаний визуализируют информацию в виде взаимосвязанных узлов и отношений.Выявление нере

"Графический ИИ преобразует бизнес-аналитику с помощью графиков знаний"

Ключевые моментыГрафовый ИИ использует графы знаний для выявления скрытых связей в сложных массивах данных.Графы знаний визуализируют информацию в виде взаимосвязанных узлов и отношений.Выявление нере

Minecraft Villager AI переосмысливает музыку с помощью уникальной звуковой обложки

Ландшафт музыкального производства продолжает трансформироваться, поскольку технологии искусственного интеллекта расширяют творческие границы неожиданными способами. Одна из особенно интересных разраб

Minecraft Villager AI переосмысливает музыку с помощью уникальной звуковой обложки

Ландшафт музыкального производства продолжает трансформироваться, поскольку технологии искусственного интеллекта расширяют творческие границы неожиданными способами. Одна из особенно интересных разраб

4 августа 2025 г., 11:40:05 GMT+03:00

4 августа 2025 г., 11:40:05 GMT+03:00

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

31 июля 2025 г., 14:35:39 GMT+03:00

31 июля 2025 г., 14:35:39 GMT+03:00

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

28 июля 2025 г., 4:19:05 GMT+03:00

28 июля 2025 г., 4:19:05 GMT+03:00

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

28 июля 2025 г., 4:18:39 GMT+03:00

28 июля 2025 г., 4:18:39 GMT+03:00

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0