'Erniedrigte' synthetische Gesichter können die Gesichtserkennungstechnologie verbessern

Forscher an der Michigan State University haben einen innovativen Ansatz entwickelt, um synthetische Gesichter für einen edlen Zweck zu nutzen – die Verbesserung der Genauigkeit von Bilderkennungssystemen. Anstatt zum Phänomen der Deepfakes beizutragen, sind diese synthetischen Gesichter darauf ausgelegt, die Unvollkommenheiten nachzuahmen, die in realen Videoüberwachungsaufnahmen vorkommen.

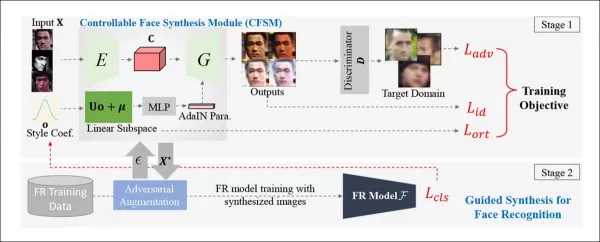

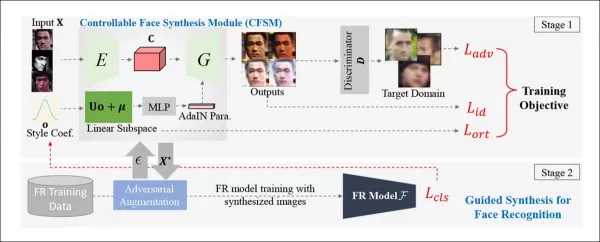

Das Team hat ein Kontrollierbares Gesichtssynthese-Modul (CFSM) entwickelt, das Gesichter in einem Stil regenerieren kann, der die typischen Mängel von CCTV-Systemen widerspiegelt, wie Gesichtsunschärfe, niedrige Auflösung und Sensorauschen. Dieser Ansatz unterscheidet sich von der Verwendung hochqualitativer Prominentenbilder aus populären Datensätzen, die die realen Herausforderungen von Gesichtserkennungssystemen nicht abbilden.

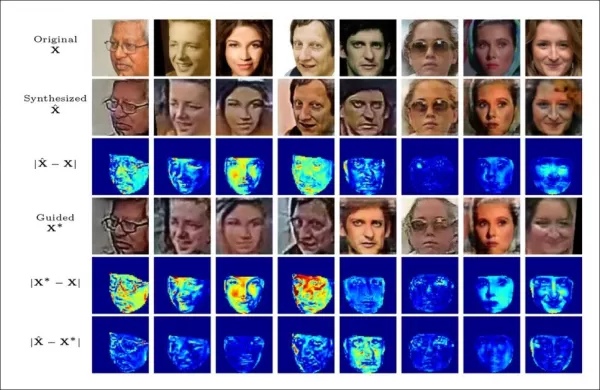

*Konzeptionelle Architektur für das Kontrollierbare Gesichtssynthese-Modul (CFSM).* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022.pdf

*Konzeptionelle Architektur für das Kontrollierbare Gesichtssynthese-Modul (CFSM).* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022.pdf

Im Gegensatz zu Deepfake-Systemen, die sich auf die Nachbildung von Kopfhaltungen und Ausdrücken konzentrieren, zielt CFSM darauf ab, alternative Ansichten zu generieren, die dem Stil des Zielerkennungssystems durch Stilübertragung entsprechen. Dieses Modul ist besonders nützlich, um sich an ältere Systeme anzupassen, die aufgrund von Kostenbeschränkungen wahrscheinlich nicht aufgerüstet werden, aber dennoch zu modernen Gesichtserkennungstechnologien beitragen müssen.

Bei der Erprobung von CFSM stellten die Forscher signifikante Verbesserungen bei Bilderkennungssystemen fest, die mit Daten niedriger Qualität arbeiten. Sie entdeckten auch einen unerwarteten Vorteil: die Fähigkeit, Zieldatensätze zu charakterisieren und zu vergleichen, was den Prozess der Leistungsbewertung und Erstellung maßgeschneiderter Datensätze für verschiedene CCTV-Systeme vereinfacht.

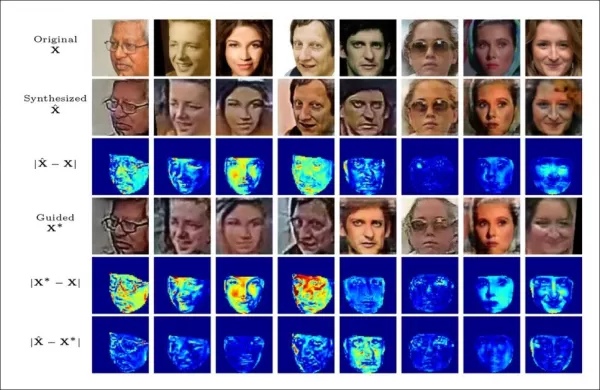

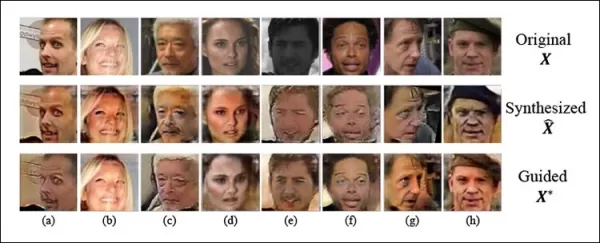

*Training der Gesichtserkennungsmodelle, um sich an die Einschränkungen der Zielsysteme anzupassen.* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022_supp.pdf

*Training der Gesichtserkennungsmodelle, um sich an die Einschränkungen der Zielsysteme anzupassen.* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022_supp.pdf

Die Methode kann auch auf bestehende Datensätze angewendet werden, um eine effektive Domänenanpassung durchzuführen und sie für die Gesichtserkennung geeigneter zu machen. Die Forschung, betitelt **Kontrollierte und geführte Gesichtssynthese für uneingeschränkte Gesichtserkennung**, wird teilweise vom US Office of the Director of National Intelligence (ODNI, bei IARPA) unterstützt und umfasst vier Forscher aus der Abteilung für Informatik und Ingenieurwissenschaften der MSU.

Gesichtserkennung bei niedriger Qualität: Ein wachsendes Forschungsfeld

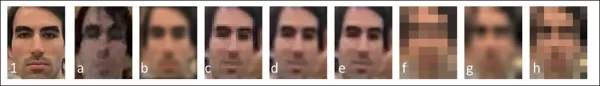

In den letzten Jahren hat die Gesichtserkennung bei niedriger Qualität (LQFR) als bedeutendes Studiengebiet an Bedeutung gewonnen. Viele ältere Videoüberwachungssysteme, die auf Langlebigkeit ausgelegt sind, sind veraltet und können aufgrund technischer Schulden nur schwer als effektive Datenquellen für maschinelles Lernen dienen.

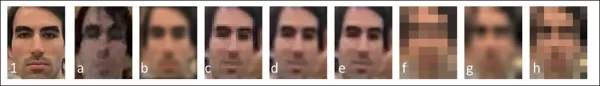

Unterschiedliche Stufen der Gesichtsauflösung bei einer Reihe historischer und neuerer Videoüberwachungssysteme. Quelle: https://arxiv.org/pdf/1805.11519.pdf

Unterschiedliche Stufen der Gesichtsauflösung bei einer Reihe historischer und neuerer Videoüberwachungssysteme. Quelle: https://arxiv.org/pdf/1805.11519.pdf

Glücklicherweise sind Diffusionsmodelle und andere rausbasierte Modelle gut geeignet, dieses Problem anzugehen. Viele der neuesten Bildsynthesesysteme beinhalten das Hochskalieren von Bildern niedriger Auflösung als Teil ihres Prozesses, was auch für neuronale Kompressionstechniken entscheidend ist.

Die Herausforderung bei der Gesichtserkennung besteht darin, die Genauigkeit mit möglichst wenigen aus Bildern niedriger Auflösung extrahierten Merkmalen zu maximieren. Dies ist nicht nur nützlich für die Identifizierung von Gesichtern bei niedriger Auflösung, sondern auch notwendig aufgrund von Einschränkungen der Bildgröße im latenten Raum der Trainingsmodelle.

In der Computer Vision beziehen sich 'Merkmale' auf unterscheidende Charakteristika eines beliebigen Bildes, nicht nur von Gesichtern. Mit Fortschritten bei Hochskalierungsalgorithmen wurden verschiedene Methoden vorgeschlagen, um Videoüberwachungsaufnahmen niedriger Auflösung zu verbessern, was sie potenziell für rechtliche Zwecke wie Tatortuntersuchungen nutzbar macht.

Es besteht jedoch das Risiko einer Fehlidentifikation, und idealerweise sollten Gesichtserkennungssysteme keine hochauflösenden Bilder benötigen, um genaue Identifikationen durchzuführen. Solche Transformationen sind kostspielig und werfen Fragen nach ihrer Gültigkeit und Legalität auf.

Die Notwendigkeit für mehr 'heruntergekommene' Prominente

Es wäre vorteilhafter, wenn Gesichtserkennungssysteme Merkmale direkt aus der Ausgabe älterer Systeme extrahieren könnten, ohne die Bilder transformieren zu müssen. Dies erfordert ein besseres Verständnis der Beziehung zwischen hochauflösenden Identitäten und den degradierten Bildern bestehender Überwachungssysteme.

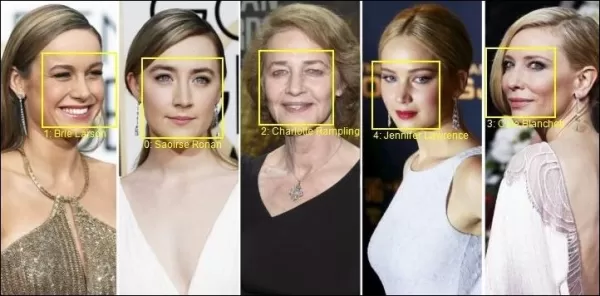

Das Problem liegt in den Standards: Datensätze wie MS-Celeb-1M und WebFace260M werden weitgehend verwendet, weil sie konsistente Benchmarks bieten. Die Autoren argumentieren jedoch, dass auf diesen Datensätzen trainierte Gesichtserkennungsalgorithmen nicht für die visuellen Domänen älterer Überwachungssysteme geeignet sind.

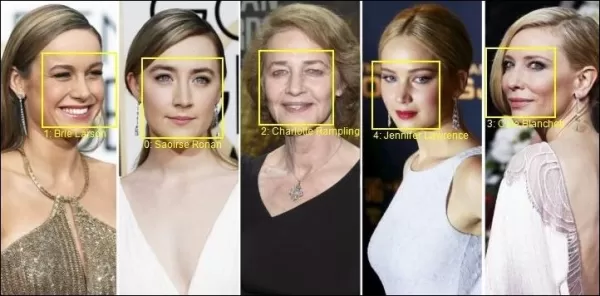

*Beispiele aus Microsofts populärem MS-Celeb1m-Datensatz.* Quelle: https://www.microsoft.com/en-us/research/project/ms-celeb-1m-challenge-recognizing-one-million-celebrities-real-world/

*Beispiele aus Microsofts populärem MS-Celeb1m-Datensatz.* Quelle: https://www.microsoft.com/en-us/research/project/ms-celeb-1m-challenge-recognizing-one-million-celebrities-real-world/

Das Papier hebt hervor, dass hochmoderne Gesichtserkennungsmodelle mit realen Überwachungsbildern aufgrund von Domänenverschiebungsproblemen Schwierigkeiten haben. Diese Modelle werden auf halb-eingeschränkten Datensätzen trainiert, die die in realen Szenarien vorkommenden Variationen wie Sensorauschen und Bewegungsunschärfe nicht abbilden.

Frühere Methoden haben versucht, die Ausgaben historischer oder kostengünstiger Überwachungssysteme anzugleichen, aber dies waren 'blinde' Erweiterungen. Im Gegensatz dazu nutzt CFSM direktes Feedback vom Zielsystem während des Trainings und passt sich durch Stilübertragung an diese Domäne an.

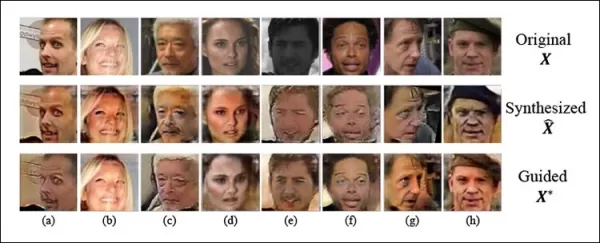

*Schauspielerin Natalie Portman, keine Unbekannte in den wenigen Datensätzen, die die Computer-Vision-Community dominieren, gehört zu den Identitäten in diesem Beispiel von CFSM, das eine stilangepasste Domänenanpassung basierend auf Feedback aus der Domäne des tatsächlichen Zielmodells durchführt.*

*Schauspielerin Natalie Portman, keine Unbekannte in den wenigen Datensätzen, die die Computer-Vision-Community dominieren, gehört zu den Identitäten in diesem Beispiel von CFSM, das eine stilangepasste Domänenanpassung basierend auf Feedback aus der Domäne des tatsächlichen Zielmodells durchführt.*

Die Architektur der Autoren verwendet die Fast Gradient Sign Method (FGSM), um Stile und Charakteristika aus der Ausgabe des Zielsystems zu importieren. Mit fortschreitendem Training wird der Bildgenerierungsteil der Pipeline dem Zielsystem treuer, was die Leistung und Verallgemeinerungsfähigkeit der Gesichtserkennung verbessert.

Tests und Ergebnisse

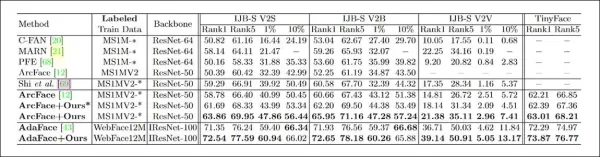

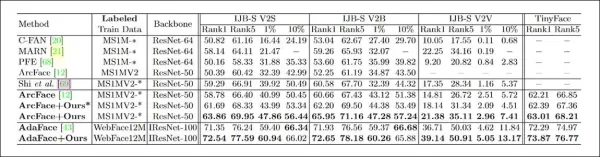

Die Forscher testeten CFSM unter Verwendung früherer Arbeiten der MSU als Vorlage und nutzten MS-Celeb-1m und MS1M-V2 als Trainingsdatensätze. Die Zieldaten waren der WiderFace-Datensatz der Chinese University of Hong Kong, der für die Gesichtserkennung in anspruchsvollen Situationen entwickelt wurde.

Das System wurde anhand von vier Gesichtserkennungs-Benchmarks bewertet: IJB-B, IJB-C, IJB-S und TinyFace. CFSM wurde mit etwa 10% der MS-Celeb-1m-Daten, rund 0,4 Millionen Bildern, für 125.000 Iterationen bei einer Batchgröße von 32 mit dem Adam-Optimierer und einer Lernrate von 1e-4 trainiert.

Das Zielgesichtserkennungsmodell verwendete ein modifiziertes ResNet-50 mit ArcFace-Verlustfunktion. Ein zusätzliches Modell wurde mit CFSM trainiert, um einen Vergleich zu ermöglichen, in den Ergebnissen als 'ArcFace' bezeichnet.

*Ergebnisse der Haupttests für CFSM. Höhere Zahlen sind besser.*

*Ergebnisse der Haupttests für CFSM. Höhere Zahlen sind besser.*

Die Ergebnisse zeigten, dass das durch CFSM verbesserte ArcFace-Modell alle Basislinien sowohl bei der Gesichtsidentifikation als auch bei der Verifikation übertraf und eine neue Spitzenleistung erreichte.

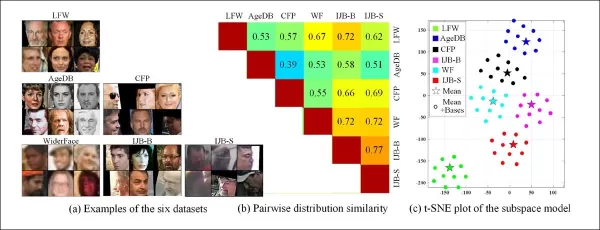

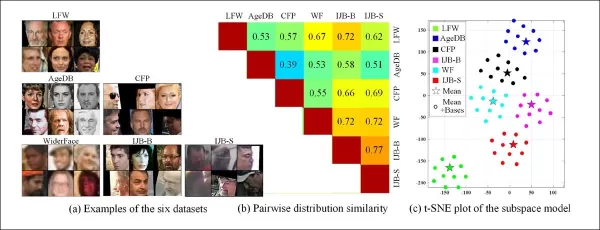

Die Fähigkeit, Domänen aus verschiedenen Charakteristika älterer Überwachungssysteme zu extrahieren, ermöglicht auch den Vergleich und die Bewertung der Verteilungsgleichheit zwischen diesen Systemen und stellt sie jeweils in Form eines visuellen Stils dar, der in zukünftigen Arbeiten genutzt werden kann.

*Beispiele aus verschiedenen Datensätzen zeigen klare Stilunterschiede.*

*Beispiele aus verschiedenen Datensätzen zeigen klare Stilunterschiede.*

Die Autoren stellten auch fest, dass CFSM zeigt, wie adversariale Manipulation genutzt werden kann, um die Erkennungsgenauigkeit bei visuellen Aufgaben zu erhöhen. Sie führten eine Datensatzähnlichkeitsmetrik basierend auf gelernten Stilbasen ein, die Stilunterschiede auf eine label- oder prädiktorunabhängige Weise erfasst.

Die Forschung unterstreicht das Potenzial kontrollierter und geführter Gesichtssynthesemodelle für uneingeschränkte Gesichtserkennung und liefert Einblicke in Datensatzunterschiede.

Verwandter Artikel

Google Cloud sorgt für Durchbrüche in der wissenschaftlichen Forschung und Entdeckung

Die digitale Revolution verändert die wissenschaftlichen Methoden durch nie dagewesene Berechnungsmöglichkeiten. Spitzentechnologien ergänzen heute sowohl theoretische Rahmenwerke als auch Laborexperi

Google Cloud sorgt für Durchbrüche in der wissenschaftlichen Forschung und Entdeckung

Die digitale Revolution verändert die wissenschaftlichen Methoden durch nie dagewesene Berechnungsmöglichkeiten. Spitzentechnologien ergänzen heute sowohl theoretische Rahmenwerke als auch Laborexperi

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

Ethik in der KI: Umgang mit Vorurteilen und Compliance-Herausforderungen bei der Automatisierung

In dem Maße, in dem die Automatisierung in allen Wirtschaftszweigen Einzug hält, werden ethische Überlegungen zu einer entscheidenden Priorität. Algorithmen, die Entscheidungen treffen, beeinflussen h

Kommentare (12)

0/200

Ethik in der KI: Umgang mit Vorurteilen und Compliance-Herausforderungen bei der Automatisierung

In dem Maße, in dem die Automatisierung in allen Wirtschaftszweigen Einzug hält, werden ethische Überlegungen zu einer entscheidenden Priorität. Algorithmen, die Entscheidungen treffen, beeinflussen h

Kommentare (12)

0/200

![MateoAdams]() MateoAdams

MateoAdams

16. September 2025 22:30:39 MESZ

16. September 2025 22:30:39 MESZ

실제 얼굴의 불완전함을 모방한 합성 이미지라니... 정말 흥미로운 접근이네요! 🤯 근데 이 기술이 악용되지 않을까 조금 걱정되기도 해요. 얼굴인식 시스템의 정확도를 높이는 건 좋지만, 동시에 보안 문제도 신경써야 할 것 같아요.

0

0

![TimothyEvans]() TimothyEvans

TimothyEvans

23. August 2025 15:01:18 MESZ

23. August 2025 15:01:18 MESZ

This is wild! Synthetic faces to boost facial recognition? I’m all for better tech, but I hope they keep an eye on privacy issues. 😎

0

0

![LarryWilliams]() LarryWilliams

LarryWilliams

27. April 2025 09:58:26 MESZ

27. April 2025 09:58:26 MESZ

C'est une initiative fascinante pour améliorer la reconnaissance faciale. Utiliser des visages synthétiques plutôt que de contribuer aux deepfakes est une bonne chose. J'espère qu'ils y arriveront bien. 😊🧐

0

0

![CharlesJohnson]() CharlesJohnson

CharlesJohnson

27. April 2025 09:57:41 MESZ

27. April 2025 09:57:41 MESZ

¡Qué genial usar caras sintéticas para mejorar el reconocimiento facial! Me encanta que la tecnología se use para algo bueno y no para deepfakes. Lo único es que podría ser más fácil de usar, pero de todos modos, ¡innovación de primera! 👌

0

0

![MatthewGonzalez]() MatthewGonzalez

MatthewGonzalez

26. April 2025 22:27:32 MESZ

26. April 2025 22:27:32 MESZ

Que ideia genial usar faces sintéticas para melhorar o reconhecimento facial! Adoro que a tecnologia esteja sendo usada para o bem, e não para deepfakes. A única coisa é que poderia ser mais fácil de usar, mas ainda assim, inovação top! 👍

0

0

![FrankSmith]() FrankSmith

FrankSmith

26. April 2025 18:19:01 MESZ

26. April 2025 18:19:01 MESZ

미시간 주립대 연구진이 하는 이 작업은 정말 멋져 보입니다. 인공 얼굴을 이용해 이미지 인식 기술을 개선하려는 목적 자체가 놀랍네요. 실용성 검증이 필요할 것 같아요. 😎💡

0

0

Forscher an der Michigan State University haben einen innovativen Ansatz entwickelt, um synthetische Gesichter für einen edlen Zweck zu nutzen – die Verbesserung der Genauigkeit von Bilderkennungssystemen. Anstatt zum Phänomen der Deepfakes beizutragen, sind diese synthetischen Gesichter darauf ausgelegt, die Unvollkommenheiten nachzuahmen, die in realen Videoüberwachungsaufnahmen vorkommen.

Das Team hat ein Kontrollierbares Gesichtssynthese-Modul (CFSM) entwickelt, das Gesichter in einem Stil regenerieren kann, der die typischen Mängel von CCTV-Systemen widerspiegelt, wie Gesichtsunschärfe, niedrige Auflösung und Sensorauschen. Dieser Ansatz unterscheidet sich von der Verwendung hochqualitativer Prominentenbilder aus populären Datensätzen, die die realen Herausforderungen von Gesichtserkennungssystemen nicht abbilden.

*Konzeptionelle Architektur für das Kontrollierbare Gesichtssynthese-Modul (CFSM).* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022.pdf

*Konzeptionelle Architektur für das Kontrollierbare Gesichtssynthese-Modul (CFSM).* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022.pdf

Im Gegensatz zu Deepfake-Systemen, die sich auf die Nachbildung von Kopfhaltungen und Ausdrücken konzentrieren, zielt CFSM darauf ab, alternative Ansichten zu generieren, die dem Stil des Zielerkennungssystems durch Stilübertragung entsprechen. Dieses Modul ist besonders nützlich, um sich an ältere Systeme anzupassen, die aufgrund von Kostenbeschränkungen wahrscheinlich nicht aufgerüstet werden, aber dennoch zu modernen Gesichtserkennungstechnologien beitragen müssen.

Bei der Erprobung von CFSM stellten die Forscher signifikante Verbesserungen bei Bilderkennungssystemen fest, die mit Daten niedriger Qualität arbeiten. Sie entdeckten auch einen unerwarteten Vorteil: die Fähigkeit, Zieldatensätze zu charakterisieren und zu vergleichen, was den Prozess der Leistungsbewertung und Erstellung maßgeschneiderter Datensätze für verschiedene CCTV-Systeme vereinfacht.

*Training der Gesichtserkennungsmodelle, um sich an die Einschränkungen der Zielsysteme anzupassen.* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022_supp.pdf

*Training der Gesichtserkennungsmodelle, um sich an die Einschränkungen der Zielsysteme anzupassen.* Quelle: http://cvlab.cse.msu.edu/pdfs/Liu_Kim_Jain_Liu_ECCV2022_supp.pdf

Die Methode kann auch auf bestehende Datensätze angewendet werden, um eine effektive Domänenanpassung durchzuführen und sie für die Gesichtserkennung geeigneter zu machen. Die Forschung, betitelt **Kontrollierte und geführte Gesichtssynthese für uneingeschränkte Gesichtserkennung**, wird teilweise vom US Office of the Director of National Intelligence (ODNI, bei IARPA) unterstützt und umfasst vier Forscher aus der Abteilung für Informatik und Ingenieurwissenschaften der MSU.

Gesichtserkennung bei niedriger Qualität: Ein wachsendes Forschungsfeld

In den letzten Jahren hat die Gesichtserkennung bei niedriger Qualität (LQFR) als bedeutendes Studiengebiet an Bedeutung gewonnen. Viele ältere Videoüberwachungssysteme, die auf Langlebigkeit ausgelegt sind, sind veraltet und können aufgrund technischer Schulden nur schwer als effektive Datenquellen für maschinelles Lernen dienen.

Unterschiedliche Stufen der Gesichtsauflösung bei einer Reihe historischer und neuerer Videoüberwachungssysteme. Quelle: https://arxiv.org/pdf/1805.11519.pdf

Unterschiedliche Stufen der Gesichtsauflösung bei einer Reihe historischer und neuerer Videoüberwachungssysteme. Quelle: https://arxiv.org/pdf/1805.11519.pdf

Glücklicherweise sind Diffusionsmodelle und andere rausbasierte Modelle gut geeignet, dieses Problem anzugehen. Viele der neuesten Bildsynthesesysteme beinhalten das Hochskalieren von Bildern niedriger Auflösung als Teil ihres Prozesses, was auch für neuronale Kompressionstechniken entscheidend ist.

Die Herausforderung bei der Gesichtserkennung besteht darin, die Genauigkeit mit möglichst wenigen aus Bildern niedriger Auflösung extrahierten Merkmalen zu maximieren. Dies ist nicht nur nützlich für die Identifizierung von Gesichtern bei niedriger Auflösung, sondern auch notwendig aufgrund von Einschränkungen der Bildgröße im latenten Raum der Trainingsmodelle.

In der Computer Vision beziehen sich 'Merkmale' auf unterscheidende Charakteristika eines beliebigen Bildes, nicht nur von Gesichtern. Mit Fortschritten bei Hochskalierungsalgorithmen wurden verschiedene Methoden vorgeschlagen, um Videoüberwachungsaufnahmen niedriger Auflösung zu verbessern, was sie potenziell für rechtliche Zwecke wie Tatortuntersuchungen nutzbar macht.

Es besteht jedoch das Risiko einer Fehlidentifikation, und idealerweise sollten Gesichtserkennungssysteme keine hochauflösenden Bilder benötigen, um genaue Identifikationen durchzuführen. Solche Transformationen sind kostspielig und werfen Fragen nach ihrer Gültigkeit und Legalität auf.

Die Notwendigkeit für mehr 'heruntergekommene' Prominente

Es wäre vorteilhafter, wenn Gesichtserkennungssysteme Merkmale direkt aus der Ausgabe älterer Systeme extrahieren könnten, ohne die Bilder transformieren zu müssen. Dies erfordert ein besseres Verständnis der Beziehung zwischen hochauflösenden Identitäten und den degradierten Bildern bestehender Überwachungssysteme.

Das Problem liegt in den Standards: Datensätze wie MS-Celeb-1M und WebFace260M werden weitgehend verwendet, weil sie konsistente Benchmarks bieten. Die Autoren argumentieren jedoch, dass auf diesen Datensätzen trainierte Gesichtserkennungsalgorithmen nicht für die visuellen Domänen älterer Überwachungssysteme geeignet sind.

*Beispiele aus Microsofts populärem MS-Celeb1m-Datensatz.* Quelle: https://www.microsoft.com/en-us/research/project/ms-celeb-1m-challenge-recognizing-one-million-celebrities-real-world/

*Beispiele aus Microsofts populärem MS-Celeb1m-Datensatz.* Quelle: https://www.microsoft.com/en-us/research/project/ms-celeb-1m-challenge-recognizing-one-million-celebrities-real-world/

Das Papier hebt hervor, dass hochmoderne Gesichtserkennungsmodelle mit realen Überwachungsbildern aufgrund von Domänenverschiebungsproblemen Schwierigkeiten haben. Diese Modelle werden auf halb-eingeschränkten Datensätzen trainiert, die die in realen Szenarien vorkommenden Variationen wie Sensorauschen und Bewegungsunschärfe nicht abbilden.

Frühere Methoden haben versucht, die Ausgaben historischer oder kostengünstiger Überwachungssysteme anzugleichen, aber dies waren 'blinde' Erweiterungen. Im Gegensatz dazu nutzt CFSM direktes Feedback vom Zielsystem während des Trainings und passt sich durch Stilübertragung an diese Domäne an.

*Schauspielerin Natalie Portman, keine Unbekannte in den wenigen Datensätzen, die die Computer-Vision-Community dominieren, gehört zu den Identitäten in diesem Beispiel von CFSM, das eine stilangepasste Domänenanpassung basierend auf Feedback aus der Domäne des tatsächlichen Zielmodells durchführt.*

*Schauspielerin Natalie Portman, keine Unbekannte in den wenigen Datensätzen, die die Computer-Vision-Community dominieren, gehört zu den Identitäten in diesem Beispiel von CFSM, das eine stilangepasste Domänenanpassung basierend auf Feedback aus der Domäne des tatsächlichen Zielmodells durchführt.*

Die Architektur der Autoren verwendet die Fast Gradient Sign Method (FGSM), um Stile und Charakteristika aus der Ausgabe des Zielsystems zu importieren. Mit fortschreitendem Training wird der Bildgenerierungsteil der Pipeline dem Zielsystem treuer, was die Leistung und Verallgemeinerungsfähigkeit der Gesichtserkennung verbessert.

Tests und Ergebnisse

Die Forscher testeten CFSM unter Verwendung früherer Arbeiten der MSU als Vorlage und nutzten MS-Celeb-1m und MS1M-V2 als Trainingsdatensätze. Die Zieldaten waren der WiderFace-Datensatz der Chinese University of Hong Kong, der für die Gesichtserkennung in anspruchsvollen Situationen entwickelt wurde.

Das System wurde anhand von vier Gesichtserkennungs-Benchmarks bewertet: IJB-B, IJB-C, IJB-S und TinyFace. CFSM wurde mit etwa 10% der MS-Celeb-1m-Daten, rund 0,4 Millionen Bildern, für 125.000 Iterationen bei einer Batchgröße von 32 mit dem Adam-Optimierer und einer Lernrate von 1e-4 trainiert.

Das Zielgesichtserkennungsmodell verwendete ein modifiziertes ResNet-50 mit ArcFace-Verlustfunktion. Ein zusätzliches Modell wurde mit CFSM trainiert, um einen Vergleich zu ermöglichen, in den Ergebnissen als 'ArcFace' bezeichnet.

*Ergebnisse der Haupttests für CFSM. Höhere Zahlen sind besser.*

*Ergebnisse der Haupttests für CFSM. Höhere Zahlen sind besser.*

Die Ergebnisse zeigten, dass das durch CFSM verbesserte ArcFace-Modell alle Basislinien sowohl bei der Gesichtsidentifikation als auch bei der Verifikation übertraf und eine neue Spitzenleistung erreichte.

Die Fähigkeit, Domänen aus verschiedenen Charakteristika älterer Überwachungssysteme zu extrahieren, ermöglicht auch den Vergleich und die Bewertung der Verteilungsgleichheit zwischen diesen Systemen und stellt sie jeweils in Form eines visuellen Stils dar, der in zukünftigen Arbeiten genutzt werden kann.

*Beispiele aus verschiedenen Datensätzen zeigen klare Stilunterschiede.*

*Beispiele aus verschiedenen Datensätzen zeigen klare Stilunterschiede.*

Die Autoren stellten auch fest, dass CFSM zeigt, wie adversariale Manipulation genutzt werden kann, um die Erkennungsgenauigkeit bei visuellen Aufgaben zu erhöhen. Sie führten eine Datensatzähnlichkeitsmetrik basierend auf gelernten Stilbasen ein, die Stilunterschiede auf eine label- oder prädiktorunabhängige Weise erfasst.

Die Forschung unterstreicht das Potenzial kontrollierter und geführter Gesichtssynthesemodelle für uneingeschränkte Gesichtserkennung und liefert Einblicke in Datensatzunterschiede.

Google Cloud sorgt für Durchbrüche in der wissenschaftlichen Forschung und Entdeckung

Die digitale Revolution verändert die wissenschaftlichen Methoden durch nie dagewesene Berechnungsmöglichkeiten. Spitzentechnologien ergänzen heute sowohl theoretische Rahmenwerke als auch Laborexperi

Google Cloud sorgt für Durchbrüche in der wissenschaftlichen Forschung und Entdeckung

Die digitale Revolution verändert die wissenschaftlichen Methoden durch nie dagewesene Berechnungsmöglichkeiten. Spitzentechnologien ergänzen heute sowohl theoretische Rahmenwerke als auch Laborexperi

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

16. September 2025 22:30:39 MESZ

16. September 2025 22:30:39 MESZ

실제 얼굴의 불완전함을 모방한 합성 이미지라니... 정말 흥미로운 접근이네요! 🤯 근데 이 기술이 악용되지 않을까 조금 걱정되기도 해요. 얼굴인식 시스템의 정확도를 높이는 건 좋지만, 동시에 보안 문제도 신경써야 할 것 같아요.

0

0

23. August 2025 15:01:18 MESZ

23. August 2025 15:01:18 MESZ

This is wild! Synthetic faces to boost facial recognition? I’m all for better tech, but I hope they keep an eye on privacy issues. 😎

0

0

27. April 2025 09:58:26 MESZ

27. April 2025 09:58:26 MESZ

C'est une initiative fascinante pour améliorer la reconnaissance faciale. Utiliser des visages synthétiques plutôt que de contribuer aux deepfakes est une bonne chose. J'espère qu'ils y arriveront bien. 😊🧐

0

0

27. April 2025 09:57:41 MESZ

27. April 2025 09:57:41 MESZ

¡Qué genial usar caras sintéticas para mejorar el reconocimiento facial! Me encanta que la tecnología se use para algo bueno y no para deepfakes. Lo único es que podría ser más fácil de usar, pero de todos modos, ¡innovación de primera! 👌

0

0

26. April 2025 22:27:32 MESZ

26. April 2025 22:27:32 MESZ

Que ideia genial usar faces sintéticas para melhorar o reconhecimento facial! Adoro que a tecnologia esteja sendo usada para o bem, e não para deepfakes. A única coisa é que poderia ser mais fácil de usar, mas ainda assim, inovação top! 👍

0

0

26. April 2025 18:19:01 MESZ

26. April 2025 18:19:01 MESZ

미시간 주립대 연구진이 하는 이 작업은 정말 멋져 보입니다. 인공 얼굴을 이용해 이미지 인식 기술을 개선하려는 목적 자체가 놀랍네요. 실용성 검증이 필요할 것 같아요. 😎💡

0

0