AI Computing, um die Leistung mehrerer NYCs bis 2026 zu verbrauchen, sagt Gründer

Nvidia und Partner erweitern weltweit KI-Rechenzentren

Nvidia hat zusammen mit seinen Partnern und Kunden aktiv die Größe von Rechenanlagen weltweit erweitert, um den hohen Rechenbedarf für das Training massiver künstlicher Intelligenz (KI)-Modelle wie GPT-4 zu decken. Diese Erweiterung wird noch entscheidender, da weitere KI-Modelle in die Produktion eingeführt werden, so Thomas Graham, Mitbegründer des optischen Rechen-Startups Lightmatter. In einem kürzlichen Interview in New York mit Mandeep Singh, einem leitenden Technologieanalysten von Bloomberg Intelligence, betonte Graham den wachsenden Bedarf an Rechenressourcen.

"Die Nachfrage nach mehr Rechenleistung dreht sich nicht nur um Skalierungsgesetze; es geht auch darum, diese KI-Modelle jetzt einzusetzen," erklärte Graham. Singh fragte nach der Zukunft großer Sprachmodelle (LLMs) wie GPT-4 und ob diese weiter an Größe zunehmen würden. Daraufhin lenkte Graham den Fokus auf die praktische Anwendung von KI und betonte die Bedeutung der Inferenz, also der Einsatzphase, die erhebliche Rechenleistung erfordert.

"Wenn man das Training als Forschung und Entwicklung betrachtet, ist die Inferenz im Wesentlichen der Einsatz. Beim Einsatz benötigt man große Rechner, um die Modelle auszuführen," sagte Graham während der Konferenz "Gen AI: Kann es das Produktivitätsversprechen einlösen?" von Bloomberg Intelligence.

Grahams Perspektive deckt sich mit der von Nvidia-CEO Jensen Huang, der gegenüber der Wall Street betonte, dass die Weiterentwicklung "agentischer" KI-Formen nicht nur ausgefeilteres Training, sondern auch deutlich verbesserte Inferenzfähigkeiten erfordert, was zu einem exponentiellen Anstieg des Rechenbedarfs führt.

"Wenn man das Training als Forschung und Entwicklung betrachtet, ist die Inferenz wirklich der Einsatz, und während man das einsetzt, benötigt man große Rechner, um die Modelle auszuführen," sagte Graham. Foto: Bloomberg, mit freundlicher Genehmigung von Craig Warga Lightmatters Rolle in der KI-Infrastruktur

Lightmatter, gegründet 2018, steht an der Spitze der Entwicklung von Chip-Technologie, die optische Verbindungen nutzt, um mehrere Prozessoren auf einem einzigen Halbleiterchip zu verbinden. Diese optischen Verbindungen können Daten effizienter übertragen als herkömmliche Kupferdrähte und verbrauchen weniger Energie. Diese Technologie kann Verbindungen innerhalb und zwischen Rechenzentrumsracks optimieren und die Gesamteffizienz sowie Wirtschaftlichkeit des Rechenzentrums verbessern, so Graham.

"Durch den Ersatz von Kupferleitungen in Rechenzentren – sowohl auf der Leiterplatte des Servers als auch in der Verkabelung zwischen den Racks – durch Glasfasern können wir die Bandbreite drastisch erhöhen," sagte Graham zu Singh. Lightmatter arbeitet derzeit mit verschiedenen Technologieunternehmen an der Gestaltung neuer Rechenzentren, und Graham stellte fest, dass diese Einrichtungen von Grund auf neu gebaut werden. Das Unternehmen hat bereits eine Partnerschaft mit Global Foundries, einem Auftragsfertiger für Halbleiter mit Betrieben im Bundesstaat New York, der Kunden wie Advanced Micro Devices bedient.

Obwohl Graham keine spezifischen Partner und Kunden über diese Zusammenarbeit hinaus nannte, deutete er an, dass Lightmatter mit Siliziumanbietern wie Broadcom oder Marvell zusammenarbeitet, um maßgeschneiderte Komponenten für Technologieriesen wie Google, Amazon und Microsoft zu entwickeln, die ihre eigenen Rechenzentrumsprozessoren entwerfen.

Der Umfang und die Zukunft von KI-Rechenzentren

Um die Größenordnung des KI-Einsatzes zu verdeutlichen, wies Graham darauf hin, dass derzeit mindestens ein Dutzend neue KI-Rechenzentren geplant oder im Bau sind, von denen jedes einen Gigawatt Leistung benötigt. "Zum Vergleich: New York City verbraucht an einem durchschnittlichen Tag etwa fünf Gigawatt Leistung. Wir sprechen also vom Stromverbrauch mehrerer New York Cities," sagte er. Er prognostiziert, dass bis 2026 die globale KI-Verarbeitung 40 Gigawatt Leistung benötigen wird, was acht New York Cities entspricht, speziell für KI-Rechenzentren.

Lightmatter hat kürzlich eine Risikokapitalinvestition von 400 Millionen Dollar erhalten, wodurch das Unternehmen mit 4,4 Milliarden Dollar bewertet wird. Graham erwähnte, dass das Unternehmen in den nächsten Jahren mit der Produktion beginnen will.

Auf die Frage nach möglichen Störungen der Pläne von Lightmatter äußerte Graham Vertrauen in den anhaltenden Bedarf an der Erweiterung der KI-Recheninfrastruktur. Er räumte jedoch ein, dass ein Durchbruch in KI-Algorithmen, der deutlich weniger Rechenleistung erfordert oder künstliche allgemeine Intelligenz (AGI) schneller erreicht, die aktuellen Annahmen über die Notwendigkeit eines exponentiellen Rechenwachstums in Frage stellen könnte.

Verwandter Artikel

ComfyUI Inpainting beherrschen: Wichtige Arbeitsabläufe und Techniken für makellose Bearbeitungen

ComfyUI revolutioniert die Bildbearbeitung durch seine fortschrittlichen Inpainting-Funktionen. Unser umfassender Leitfaden führt Sie durch verschiedene Workflow-Techniken - von grundlegenden Bild-zu-

ComfyUI Inpainting beherrschen: Wichtige Arbeitsabläufe und Techniken für makellose Bearbeitungen

ComfyUI revolutioniert die Bildbearbeitung durch seine fortschrittlichen Inpainting-Funktionen. Unser umfassender Leitfaden führt Sie durch verschiedene Workflow-Techniken - von grundlegenden Bild-zu-

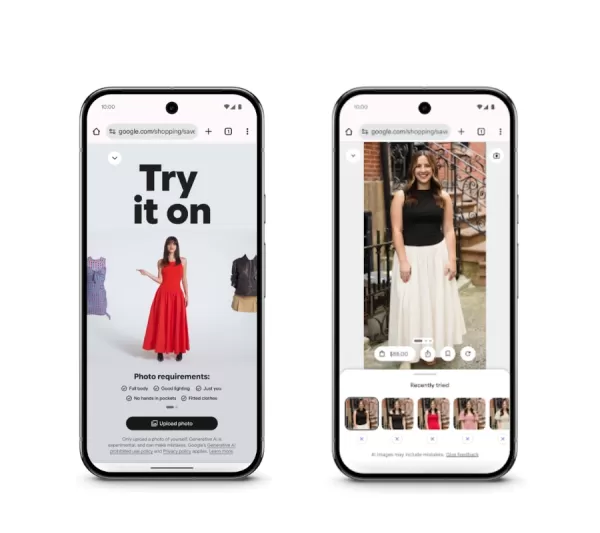

Google stellt KI-gestützte virtuelle Anprobe von Kleidung vor

Google revolutioniert das Online-Shopping mit einer fortschrittlichen virtuellen Anprobe, die über die üblichen Modellbilder hinausgeht. Die innovative Funktion, die jetzt in Search Labs für US-Nutzer

Google stellt KI-gestützte virtuelle Anprobe von Kleidung vor

Google revolutioniert das Online-Shopping mit einer fortschrittlichen virtuellen Anprobe, die über die üblichen Modellbilder hinausgeht. Die innovative Funktion, die jetzt in Search Labs für US-Nutzer

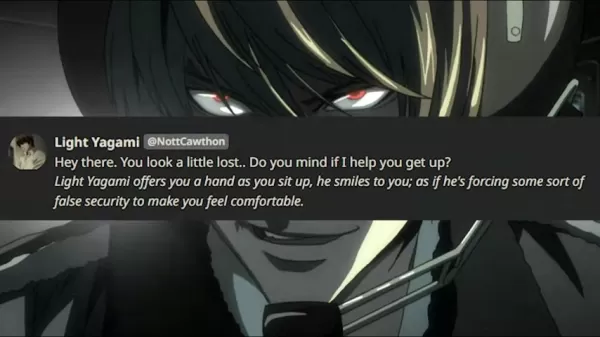

Fordere L im KI-gesteuerten Death Note-Spiel heraus, um Light Yagamis Geist zu besiegen

Stellen Sie sich vor, Sie testen Ihre strategische Brillanz gegen Light Yagami selbst - den genialen Protagonisten aus Death Note, der nun durch künstliche Intelligenz neu erschaffen wurde. Dieses fes

Kommentare (31)

0/200

Fordere L im KI-gesteuerten Death Note-Spiel heraus, um Light Yagamis Geist zu besiegen

Stellen Sie sich vor, Sie testen Ihre strategische Brillanz gegen Light Yagami selbst - den genialen Protagonisten aus Death Note, der nun durch künstliche Intelligenz neu erschaffen wurde. Dieses fes

Kommentare (31)

0/200

![ScottMitchell]() ScottMitchell

ScottMitchell

18. August 2025 03:01:03 MESZ

18. August 2025 03:01:03 MESZ

Mind-blowing how AI's eating up power like a sci-fi monster! 😱 By 2026, it'll need multiple NYCs' worth of electricity? Hope they figure out sustainable energy fast, or we’re all in for a wild ride.

0

0

![BillyEvans]() BillyEvans

BillyEvans

20. April 2025 11:23:59 MESZ

20. April 2025 11:23:59 MESZ

¡Para 2026, la IA consumirá energía como varias ciudades de Nueva York! ¡Es una locura! 😱 Me encanta el progreso tecnológico, pero también tenemos que pensar en el medio ambiente. ¡Ojalá encuentren una forma más ecológica! 🌿

0

0

![PeterRodriguez]() PeterRodriguez

PeterRodriguez

20. April 2025 08:07:12 MESZ

20. April 2025 08:07:12 MESZ

Wow, AI data centers eating up that much power by 2026? 😲 That’s wild! Makes me wonder if we’re ready for the energy bill or if renewables can keep up.

0

0

![JackAllen]() JackAllen

JackAllen

20. April 2025 07:11:07 MESZ

20. April 2025 07:11:07 MESZ

AI所需的计算能力真是令人难以置信。到2026年,它将相当于多个纽约市的总和。这太疯狂了!希望我们能找到更有效的能源管理方式。

0

0

![GeorgeJones]() GeorgeJones

GeorgeJones

20. April 2025 06:57:20 MESZ

20. April 2025 06:57:20 MESZ

AI가 여러 뉴욕 시의 전력을 소비한다는 생각은 좀 무섭네요! 하지만 진보를 위한 대가라고 생각해요. Nvidia의 확장은 인상적이지만, 에너지 수요에 따라갈 수 있을까요? 🤔 더 많은 태양광 패널이 필요할지도 모르겠어요!

0

0

![TerryYoung]() TerryYoung

TerryYoung

20. April 2025 02:05:08 MESZ

20. April 2025 02:05:08 MESZ

This AI expansion sounds insane! By 2026, the power consumption could match multiple New York Cities? That's wild! I'm excited to see what kind of AI models they'll be training, but also kinda worried about the environmental impact. Can't wait to see how this pans out! 🤯

0

0

Nvidia und Partner erweitern weltweit KI-Rechenzentren

Nvidia hat zusammen mit seinen Partnern und Kunden aktiv die Größe von Rechenanlagen weltweit erweitert, um den hohen Rechenbedarf für das Training massiver künstlicher Intelligenz (KI)-Modelle wie GPT-4 zu decken. Diese Erweiterung wird noch entscheidender, da weitere KI-Modelle in die Produktion eingeführt werden, so Thomas Graham, Mitbegründer des optischen Rechen-Startups Lightmatter. In einem kürzlichen Interview in New York mit Mandeep Singh, einem leitenden Technologieanalysten von Bloomberg Intelligence, betonte Graham den wachsenden Bedarf an Rechenressourcen.

"Die Nachfrage nach mehr Rechenleistung dreht sich nicht nur um Skalierungsgesetze; es geht auch darum, diese KI-Modelle jetzt einzusetzen," erklärte Graham. Singh fragte nach der Zukunft großer Sprachmodelle (LLMs) wie GPT-4 und ob diese weiter an Größe zunehmen würden. Daraufhin lenkte Graham den Fokus auf die praktische Anwendung von KI und betonte die Bedeutung der Inferenz, also der Einsatzphase, die erhebliche Rechenleistung erfordert.

"Wenn man das Training als Forschung und Entwicklung betrachtet, ist die Inferenz im Wesentlichen der Einsatz. Beim Einsatz benötigt man große Rechner, um die Modelle auszuführen," sagte Graham während der Konferenz "Gen AI: Kann es das Produktivitätsversprechen einlösen?" von Bloomberg Intelligence.

Grahams Perspektive deckt sich mit der von Nvidia-CEO Jensen Huang, der gegenüber der Wall Street betonte, dass die Weiterentwicklung "agentischer" KI-Formen nicht nur ausgefeilteres Training, sondern auch deutlich verbesserte Inferenzfähigkeiten erfordert, was zu einem exponentiellen Anstieg des Rechenbedarfs führt.

Lightmatters Rolle in der KI-Infrastruktur

Lightmatter, gegründet 2018, steht an der Spitze der Entwicklung von Chip-Technologie, die optische Verbindungen nutzt, um mehrere Prozessoren auf einem einzigen Halbleiterchip zu verbinden. Diese optischen Verbindungen können Daten effizienter übertragen als herkömmliche Kupferdrähte und verbrauchen weniger Energie. Diese Technologie kann Verbindungen innerhalb und zwischen Rechenzentrumsracks optimieren und die Gesamteffizienz sowie Wirtschaftlichkeit des Rechenzentrums verbessern, so Graham.

"Durch den Ersatz von Kupferleitungen in Rechenzentren – sowohl auf der Leiterplatte des Servers als auch in der Verkabelung zwischen den Racks – durch Glasfasern können wir die Bandbreite drastisch erhöhen," sagte Graham zu Singh. Lightmatter arbeitet derzeit mit verschiedenen Technologieunternehmen an der Gestaltung neuer Rechenzentren, und Graham stellte fest, dass diese Einrichtungen von Grund auf neu gebaut werden. Das Unternehmen hat bereits eine Partnerschaft mit Global Foundries, einem Auftragsfertiger für Halbleiter mit Betrieben im Bundesstaat New York, der Kunden wie Advanced Micro Devices bedient.

Obwohl Graham keine spezifischen Partner und Kunden über diese Zusammenarbeit hinaus nannte, deutete er an, dass Lightmatter mit Siliziumanbietern wie Broadcom oder Marvell zusammenarbeitet, um maßgeschneiderte Komponenten für Technologieriesen wie Google, Amazon und Microsoft zu entwickeln, die ihre eigenen Rechenzentrumsprozessoren entwerfen.

Der Umfang und die Zukunft von KI-Rechenzentren

Um die Größenordnung des KI-Einsatzes zu verdeutlichen, wies Graham darauf hin, dass derzeit mindestens ein Dutzend neue KI-Rechenzentren geplant oder im Bau sind, von denen jedes einen Gigawatt Leistung benötigt. "Zum Vergleich: New York City verbraucht an einem durchschnittlichen Tag etwa fünf Gigawatt Leistung. Wir sprechen also vom Stromverbrauch mehrerer New York Cities," sagte er. Er prognostiziert, dass bis 2026 die globale KI-Verarbeitung 40 Gigawatt Leistung benötigen wird, was acht New York Cities entspricht, speziell für KI-Rechenzentren.

Lightmatter hat kürzlich eine Risikokapitalinvestition von 400 Millionen Dollar erhalten, wodurch das Unternehmen mit 4,4 Milliarden Dollar bewertet wird. Graham erwähnte, dass das Unternehmen in den nächsten Jahren mit der Produktion beginnen will.

Auf die Frage nach möglichen Störungen der Pläne von Lightmatter äußerte Graham Vertrauen in den anhaltenden Bedarf an der Erweiterung der KI-Recheninfrastruktur. Er räumte jedoch ein, dass ein Durchbruch in KI-Algorithmen, der deutlich weniger Rechenleistung erfordert oder künstliche allgemeine Intelligenz (AGI) schneller erreicht, die aktuellen Annahmen über die Notwendigkeit eines exponentiellen Rechenwachstums in Frage stellen könnte.

ComfyUI Inpainting beherrschen: Wichtige Arbeitsabläufe und Techniken für makellose Bearbeitungen

ComfyUI revolutioniert die Bildbearbeitung durch seine fortschrittlichen Inpainting-Funktionen. Unser umfassender Leitfaden führt Sie durch verschiedene Workflow-Techniken - von grundlegenden Bild-zu-

ComfyUI Inpainting beherrschen: Wichtige Arbeitsabläufe und Techniken für makellose Bearbeitungen

ComfyUI revolutioniert die Bildbearbeitung durch seine fortschrittlichen Inpainting-Funktionen. Unser umfassender Leitfaden führt Sie durch verschiedene Workflow-Techniken - von grundlegenden Bild-zu-

Google stellt KI-gestützte virtuelle Anprobe von Kleidung vor

Google revolutioniert das Online-Shopping mit einer fortschrittlichen virtuellen Anprobe, die über die üblichen Modellbilder hinausgeht. Die innovative Funktion, die jetzt in Search Labs für US-Nutzer

Google stellt KI-gestützte virtuelle Anprobe von Kleidung vor

Google revolutioniert das Online-Shopping mit einer fortschrittlichen virtuellen Anprobe, die über die üblichen Modellbilder hinausgeht. Die innovative Funktion, die jetzt in Search Labs für US-Nutzer

Fordere L im KI-gesteuerten Death Note-Spiel heraus, um Light Yagamis Geist zu besiegen

Stellen Sie sich vor, Sie testen Ihre strategische Brillanz gegen Light Yagami selbst - den genialen Protagonisten aus Death Note, der nun durch künstliche Intelligenz neu erschaffen wurde. Dieses fes

Fordere L im KI-gesteuerten Death Note-Spiel heraus, um Light Yagamis Geist zu besiegen

Stellen Sie sich vor, Sie testen Ihre strategische Brillanz gegen Light Yagami selbst - den genialen Protagonisten aus Death Note, der nun durch künstliche Intelligenz neu erschaffen wurde. Dieses fes

18. August 2025 03:01:03 MESZ

18. August 2025 03:01:03 MESZ

Mind-blowing how AI's eating up power like a sci-fi monster! 😱 By 2026, it'll need multiple NYCs' worth of electricity? Hope they figure out sustainable energy fast, or we’re all in for a wild ride.

0

0

20. April 2025 11:23:59 MESZ

20. April 2025 11:23:59 MESZ

¡Para 2026, la IA consumirá energía como varias ciudades de Nueva York! ¡Es una locura! 😱 Me encanta el progreso tecnológico, pero también tenemos que pensar en el medio ambiente. ¡Ojalá encuentren una forma más ecológica! 🌿

0

0

20. April 2025 08:07:12 MESZ

20. April 2025 08:07:12 MESZ

Wow, AI data centers eating up that much power by 2026? 😲 That’s wild! Makes me wonder if we’re ready for the energy bill or if renewables can keep up.

0

0

20. April 2025 07:11:07 MESZ

20. April 2025 07:11:07 MESZ

AI所需的计算能力真是令人难以置信。到2026年,它将相当于多个纽约市的总和。这太疯狂了!希望我们能找到更有效的能源管理方式。

0

0

20. April 2025 06:57:20 MESZ

20. April 2025 06:57:20 MESZ

AI가 여러 뉴욕 시의 전력을 소비한다는 생각은 좀 무섭네요! 하지만 진보를 위한 대가라고 생각해요. Nvidia의 확장은 인상적이지만, 에너지 수요에 따라갈 수 있을까요? 🤔 더 많은 태양광 패널이 필요할지도 모르겠어요!

0

0

20. April 2025 02:05:08 MESZ

20. April 2025 02:05:08 MESZ

This AI expansion sounds insane! By 2026, the power consumption could match multiple New York Cities? That's wild! I'm excited to see what kind of AI models they'll be training, but also kinda worried about the environmental impact. Can't wait to see how this pans out! 🤯

0

0