Advertiser zielt in der Publikumsanalyse Eulen und Eidechsen aus

Die Online-Werbeindustrie investierte im Jahr 2023 erstaunliche 740,3 Milliarden USD in ihre Bemühungen, was deutlich macht, warum Unternehmen in diesem Bereich so stark an der Weiterentwicklung der Computer-Vision-Forschung interessiert sind. Sie konzentrieren sich besonders auf Technologien zur Gesichts- und Blickerkennung, wobei die Altersbestimmung eine zentrale Rolle in der demografischen Analyse spielt. Dies ist entscheidend für Werbetreibende, die bestimmte Altersgruppen ansprechen möchten.

Obwohl die Branche ihre Karten oft bedeckt hält, gibt sie gelegentlich Einblicke in ihre fortschrittlicheren proprietären Arbeiten durch veröffentlichte Studien. Diese Studien beziehen häufig Teilnehmer ein, die zugestimmt haben, an KI-gestützten Analysen teilzunehmen, die untersuchen, wie Betrachter mit Werbeanzeigen interagieren.

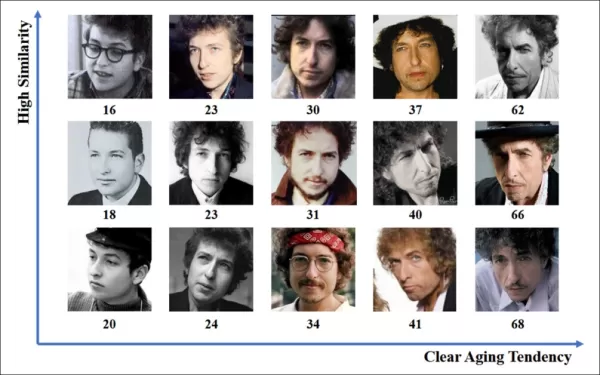

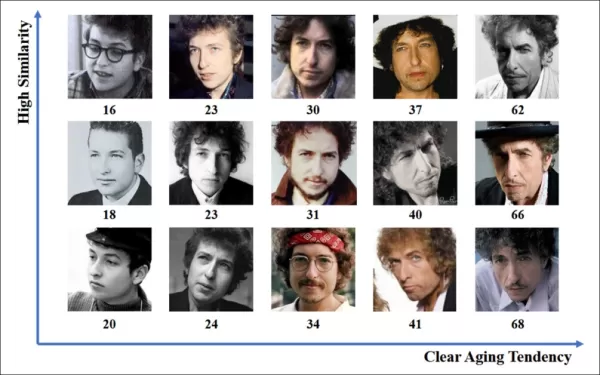

*Die Schätzung des Alters in einem realitätsnahen Werbekontext ist für Werbetreibende von Interesse, die eine bestimmte demografische Gruppe ansprechen möchten. In diesem experimentellen Beispiel der automatischen Gesichtsaltersbestimmung wird das Alter des Künstlers Bob Dylan über die Jahre hinweg verfolgt.* Quelle: https://arxiv.org/pdf/1906.03625

*Die Schätzung des Alters in einem realitätsnahen Werbekontext ist für Werbetreibende von Interesse, die eine bestimmte demografische Gruppe ansprechen möchten. In diesem experimentellen Beispiel der automatischen Gesichtsaltersbestimmung wird das Alter des Künstlers Bob Dylan über die Jahre hinweg verfolgt.* Quelle: https://arxiv.org/pdf/1906.03625

Eines der häufig verwendeten Werkzeuge in diesen Gesichtsschätzungssystemen ist Dlib's Histogram of Oriented Gradients (HoG), das bei der Analyse von Gesichtszügen hilft.

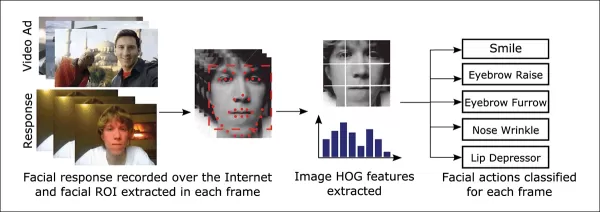

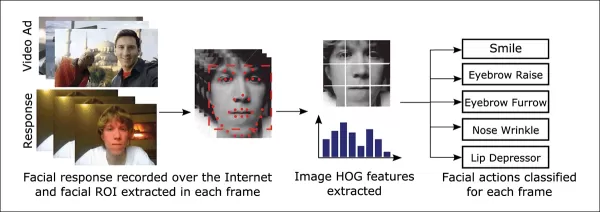

*Dlib's Histogram of Oriented Gradients (HoG) wird häufig in Gesichtsschätzungssystemen verwendet.* Quelle: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Dlib's Histogram of Oriented Gradients (HoG) wird häufig in Gesichtsschätzungssystemen verwendet.* Quelle: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

Tierischer Instinkt

Wenn es darum geht, das Engagement der Betrachter zu verstehen, ist die Werbeindustrie besonders daran interessiert, Fehlalarme zu identifizieren – Fälle, in denen das System die Handlungen eines Betrachters falsch interpretiert – und klare Kriterien dafür festzulegen, wann jemand nicht vollständig mit einer Anzeige beschäftigt ist. Dies ist besonders relevant für bildschirmbasierte Werbung, wo Studien sich auf zwei Hauptumgebungen konzentrieren: Desktop und Mobilgeräte, die jeweils maßgeschneiderte Tracking-Lösungen erfordern.

Werbetreibende kategorisieren die mangelnde Aufmerksamkeit der Betrachter oft in zwei Verhaltensweisen: „Eulenverhalten“ und „Echsenverhalten“. Wenn Sie Ihren Kopf von der Anzeige wegdrehen, handelt es sich um „Eulenverhalten“. Wenn Ihr Kopf still bleibt, aber Ihre Augen vom Bildschirm abweichen, ist das „Echsenverhalten“. Diese Verhaltensweisen sind entscheidend für Systeme, um sie bei der Erprobung neuer Anzeigen unter kontrollierten Bedingungen genau zu erfassen.

*Beispiele für „Eulen-“ und „Echsenverhalten“ bei einem Teilnehmer eines Werbeforschungsprojekts.* Quelle: https://arxiv.org/pdf/1508.04028

*Beispiele für „Eulen-“ und „Echsenverhalten“ bei einem Teilnehmer eines Werbeforschungsprojekts.* Quelle: https://arxiv.org/pdf/1508.04028

Ein kürzlich veröffentlichtes Papier von SmartEye's Affectiva-Akquisition geht diese Probleme direkt an. Es schlägt eine Architektur vor, die mehrere bestehende Frameworks kombiniert, um einen umfassenden Funktionssatz zur Erkennung der Betrachteraufmerksamkeit unter verschiedenen Bedingungen und Reaktionen zu erstellen. Dieses System kann erkennen, ob ein Betrachter gelangweilt, engagiert oder von den Inhalten abgelenkt ist, die der Werbetreibende im Fokus haben möchte.

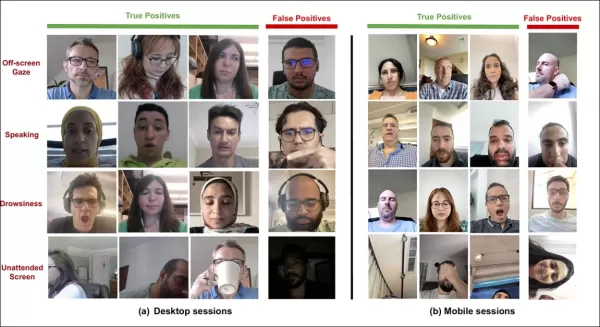

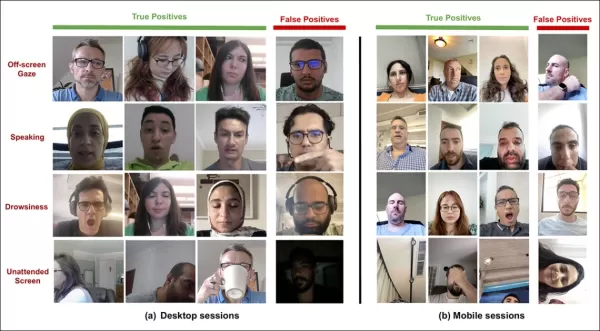

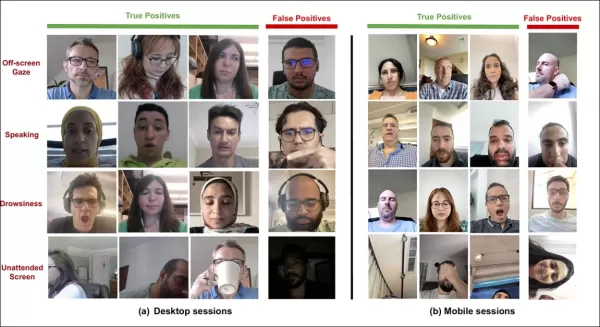

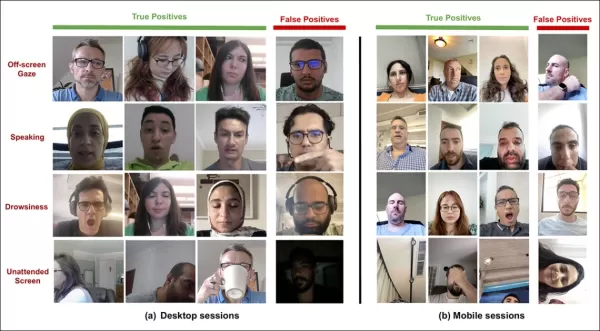

*Beispiele für echte und falsche Positivmeldungen, die vom neuen Aufmerksamkeitssystem für verschiedene Ablenkungssignale erkannt wurden, getrennt für Desktop- und Mobilgeräte dargestellt.* Quelle: https://arxiv.org/pdf/2504.06237

*Beispiele für echte und falsche Positivmeldungen, die vom neuen Aufmerksamkeitssystem für verschiedene Ablenkungssignale erkannt wurden, getrennt für Desktop- und Mobilgeräte dargestellt.* Quelle: https://arxiv.org/pdf/2504.06237

Die Autoren des Papiers heben hervor, dass die Forschung zur Überwachung der Aufmerksamkeit während Online-Werbung begrenzt ist und frühere Studien oft entscheidende Faktoren wie Gerätetyp, Kamerapositionierung und Bildschirmgröße übersehen haben. Ihre vorgeschlagene Architektur zielt darauf ab, diese Lücken zu schließen, indem sie verschiedene Ablenkungen wie Eulen- und Echsenverhalten, Sprechen, Schläfrigkeit und unbeaufsichtigte Bildschirme erkennt und gerätespezifische Merkmale integriert, um die Genauigkeit zu erhöhen.

Das Papier mit dem Titel „Überwachung der Betrachteraufmerksamkeit während Online-Werbung“ wurde von vier Forschern bei Affectiva verfasst.

Methode und Daten

Angesichts der geheimen Natur dieser Systeme vergleicht das Papier seinen Ansatz nicht direkt mit Konkurrenten, sondern präsentiert seine Ergebnisse durch Ablationsstudien. Es weicht vom typischen Format der Computer-Vision-Literatur ab, daher werden wir die Forschung so erkunden, wie sie präsentiert wird.

Die Autoren weisen darauf hin, dass nur wenige Studien die Aufmerksamkeitserkennung speziell im Kontext von Online-Werbung behandelt haben. Zum Beispiel bietet das AFFDEX SDK, das Echtzeit-Multigesichtserkennung ermöglicht, Aufmerksamkeit allein anhand der Kopfhaltung an, indem es Teilnehmer als unaufmerksam einstuft, wenn ihr Kopfwinkel eine bestimmte Schwelle überschreitet.

*Ein Beispiel aus dem AFFDEX SDK, einem Affectiva-System, das die Kopfhaltung als Indikator für Aufmerksamkeit verwendet.* Quelle: https://www.youtube.com/watch?v=c2CWb5jHmbY

*Ein Beispiel aus dem AFFDEX SDK, einem Affectiva-System, das die Kopfhaltung als Indikator für Aufmerksamkeit verwendet.* Quelle: https://www.youtube.com/watch?v=c2CWb5jHmbY

In einer Zusammenarbeit von 2019 mit dem Titel „Automatische Messung der visuellen Aufmerksamkeit für Videoinhalte mit Deep Learning“ wurde ein Datensatz von etwa 28.000 Teilnehmern für verschiedene unaufmerksame Verhaltensweisen annotiert, und ein CNN-LSTM-Modell wurde trainiert, um die Aufmerksamkeit anhand des Gesichtsaussehens über die Zeit hinweg zu erkennen.

*Aus dem Papier von 2019, ein Beispiel, das vorhergesagte Aufmerksamkeitszustände für einen Betrachter darstellt, der Videoinhalte ansieht.* Quelle: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*Aus dem Papier von 2019, ein Beispiel, das vorhergesagte Aufmerksamkeitszustände für einen Betrachter darstellt, der Videoinhalte ansieht.* Quelle: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

Jedoch berücksichtigten diese früheren Arbeiten keine gerätespezifischen Faktoren wie die Verwendung eines Desktop- oder Mobilgeräts, noch berücksichtigten sie Bildschirmgröße oder Kamerapositionierung. Das AFFDEX-System konzentrierte sich ausschließlich auf die Erkennung von Blickablenkung, während die Arbeit von 2019 versuchte, ein breiteres Spektrum an Verhaltensweisen zu erkennen, jedoch möglicherweise durch die Verwendung eines einzigen flachen CNN eingeschränkt war.

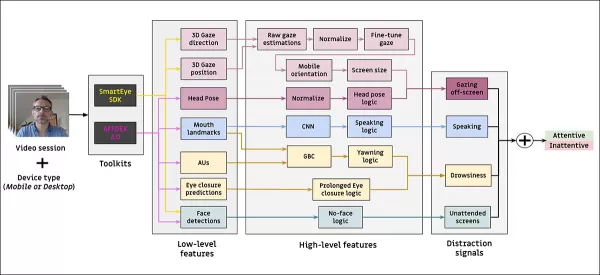

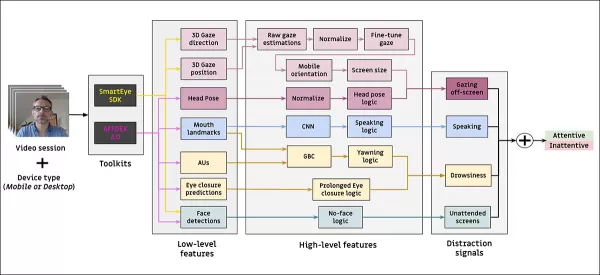

Die Autoren stellen fest, dass ein Großteil der bestehenden Forschung nicht für die Werbetestung optimiert ist, die einzigartige Anforderungen im Vergleich zu anderen Bereichen wie Fahren oder Bildung hat. Sie haben eine Architektur zur Erkennung der Betrachteraufmerksamkeit während Online-Werbung entwickelt, die zwei kommerzielle Toolkits nutzt: AFFDEX 2.0 und SmartEye SDK.

*Beispiele für Gesichtsanalysen aus AFFDEX 2.0.* Quelle: https://arxiv.org/pdf/2202.12059

*Beispiele für Gesichtsanalysen aus AFFDEX 2.0.* Quelle: https://arxiv.org/pdf/2202.12059

Diese Toolkits extrahieren niedrigstufige Merkmale wie Gesichtsausdrücke, Kopfhaltung und Blickrichtung, die dann verarbeitet werden, um höherstufige Indikatoren wie die Blickposition auf dem Bildschirm, Gähnen und Sprechen zu erzeugen. Das System identifiziert vier Arten von Ablenkungen: Blick abseits des Bildschirms, Schläfrigkeit, Sprechen und unbeaufsichtigte Bildschirme, wobei die Blickanalyse je nach Verwendung eines Desktop- oder Mobilgeräts angepasst wird.

Datensätze: Blick

Die Autoren verwendeten vier Datensätze, um ihr Aufmerksamkeitserkennungssystem zu betreiben und zu bewerten: drei konzentrierten sich auf Blickverhalten, Sprechen und Gähnen, und ein vierter wurde aus realen Werbetestsitzungen gezogen, die verschiedene Ablenkungstypen enthielten. Es wurden benutzerdefinierte Datensätze für jede Kategorie erstellt, die aus einem proprietären Repository mit Millionen von aufgezeichneten Sitzungen von Teilnehmern stammen, die Werbung in häuslicher oder arbeitsplatzbezogener Umgebung ansehen, mit informierter Zustimmung.

Um den Blick-Datensatz zu erstellen, folgten die Teilnehmer einem sich bewegenden Punkt über den Bildschirm und schauten dann in vier Richtungen weg. Dieser Prozess wurde dreimal wiederholt, um die Beziehung zwischen Erfassung und Abdeckung zu etablieren.

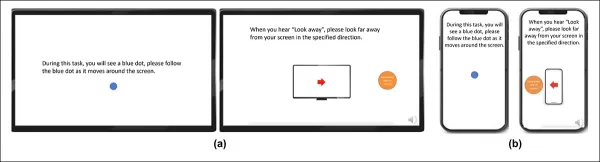

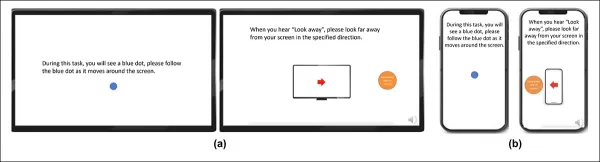

*Screenshots, die den Blickvideostimulus auf (a) Desktop- und (b) Mobilgeräten zeigen. Die ersten und dritten Frames zeigen Anweisungen, einem sich bewegenden Punkt zu folgen, während die zweiten und vierten die Teilnehmer auffordern, vom Bildschirm wegzusehen.*

*Screenshots, die den Blickvideostimulus auf (a) Desktop- und (b) Mobilgeräten zeigen. Die ersten und dritten Frames zeigen Anweisungen, einem sich bewegenden Punkt zu folgen, während die zweiten und vierten die Teilnehmer auffordern, vom Bildschirm wegzusehen.*

Die Abschnitte mit dem sich bewegenden Punkt wurden als aufmerksam gekennzeichnet, und die Abschnitte abseits des Bildschirms als unaufmerksam, wodurch ein gelabelter Datensatz mit sowohl positiven als auch negativen Beispielen erstellt wurde. Jedes Video dauerte etwa 160 Sekunden, mit separaten Versionen für Desktop- und Mobilplattformen. Insgesamt wurden 609 Videos gesammelt, aufgeteilt in 158 Trainingssamples und 451 für Tests.

Datensätze: Sprechen

In diesem Kontext wird Sprechen für länger als eine Sekunde als Zeichen von Unaufmerksamkeit betrachtet. Da die kontrollierte Umgebung keine Audioaufnahmen macht, wird Sprechen durch die Beobachtung der Bewegung geschätzter Gesichtsmerkmale abgeleitet. Die Autoren erstellten einen Datensatz basierend auf visuellem Input, aufgeteilt in zwei Teile: einen manuell von drei Annotatoren gelabelten und einen anderen, der automatisch basierend auf dem Sitzungstyp gelabelt wurde.

Datensätze: Gähnen

Vorhandene Gähnen-Datensätze waren für Werbetestszenarien nicht geeignet, daher verwendeten die Autoren 735 Videos aus ihrer internen Sammlung, die sich auf Sitzungen konzentrierten, die wahrscheinlich einen Kieferabfall von mehr als einer Sekunde enthielten. Jedes Video wurde manuell von drei Annotatoren als entweder aktives oder inaktives Gähnen gekennzeichnet, wobei nur 2,6 Prozent der Frames aktives Gähnen enthielten.

Datensätze: Ablenkung

Der Ablenkungsdatensatz wurde aus dem Werbetestrepository der Autoren gezogen, wo Teilnehmer echte Werbeanzeigen ohne zugewiesene Aufgaben ansahen. Insgesamt wurden 520 Sitzungen zufällig ausgewählt und manuell von drei Annotatoren als entweder aufmerksam oder unaufmerksam gekennzeichnet, wobei unaufmerksames Verhalten Blick abseits des Bildschirms, Sprechen, Schläfrigkeit und unbeaufsichtigte Bildschirme umfasste.

Aufmerksamkeitsmodelle

Das vorgeschlagene Aufmerksamkeitsmodell verarbeitet niedrigstufige visuelle Merkmale wie Gesichtsausdrücke, Kopfhaltung und Blickrichtung, die durch AFFDEX 2.0 und SmartEye SDK extrahiert werden. Diese werden in höherstufige Indikatoren umgewandelt, wobei jeder Ablenkungsfaktor von einem separaten binären Klassifikator behandelt wird, der auf seinem eigenen Datensatz für unabhängige Optimierung und Bewertung trainiert wird.

*Schema für das vorgeschlagene Überwachungssystem.*

*Schema für das vorgeschlagene Überwachungssystem.*

Das Blickmodell bestimmt, ob der Betrachter auf oder vom Bildschirm weg sieht, unter Verwendung normalisierter Blickkoordinaten, mit separater Kalibrierung für Desktop- und Mobilgeräte. Eine lineare Support Vector Machine (SVM) wird verwendet, um schnelle Blickverschiebungen zu glätten.

Um Sprechen ohne Audio zu erkennen, verwendet das System zugeschnittene Mundregionen und ein 3D-CNN, das sowohl auf konversationellen als auch auf nicht-konversationellen Videosegmenten trainiert wurde. Gähnen wird mithilfe von zugeschnittenen Ganzgesichtsbildern erkannt, mit einem 3D-CNN, das auf manuell gelabelten Frames trainiert wurde. Bildschirmverlassen wird durch das Fehlen eines Gesichts oder extreme Kopfhaltung identifiziert, mit Vorhersagen, die durch einen Entscheidungsbaum getroffen werden.

Der endgültige Aufmerksamkeitsstatus wird durch eine feste Regel bestimmt: Wenn ein Modul Unaufmerksamkeit erkennt, wird der Betrachter als unaufmerksam markiert, wobei die Sensitivität priorisiert und separat für Desktop- und Mobilkontexte abgestimmt wird.

Tests

Die Tests folgen einer ablativen Methode, bei der Komponenten entfernt werden und die Auswirkungen auf das Ergebnis notiert werden. Das Blickmodell identifizierte Verhalten abseits des Bildschirms durch drei Schlüsselschritte: Normalisierung roher Blickabschätzungen, Feinabstimmung des Outputs und Schätzung der Bildschirmgröße für Desktop-Geräte.

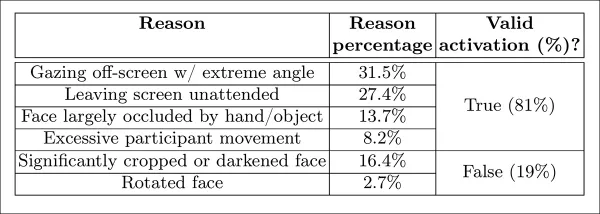

*Verschiedene Kategorien wahrgenommener Unaufmerksamkeit, die in der Studie identifiziert wurden.*

*Verschiedene Kategorien wahrgenommener Unaufmerksamkeit, die in der Studie identifiziert wurden.*

Die Leistung nahm ab, wenn ein Schritt ausgelassen wurde, wobei die Normalisierung besonders auf Desktops wertvoll war. Die Studie bewertete auch, wie visuelle Merkmale die Orientierung der mobilen Kamera vorhersagten, wobei die Kombination aus Gesichtsposition, Kopfhaltung und Blickrichtung einen Score von 0,91 erreichte.

*Ergebnisse, die die Leistung des vollständigen Blickmodells zeigen, neben Versionen mit einzelnen Verarbeitungsschritten entfernt.*

*Ergebnisse, die die Leistung des vollständigen Blickmodells zeigen, neben Versionen mit einzelnen Verarbeitungsschritten entfernt.*

Das Sprechmodell, trainiert auf vertikalem Lippenabstand, erreichte einen ROC-AUC von 0,97 auf dem manuell gelabelten Testset und 0,96 auf dem größeren automatisch gelabelten Datensatz. Das Gähnenmodell erreichte einen ROC-AUC von 96,6 Prozent allein mit dem Mundaspektverhältnis, verbesserte sich auf 97,5 Prozent, wenn es mit Aktionsvorhersagen von AFFDEX 2.0 kombiniert wurde.

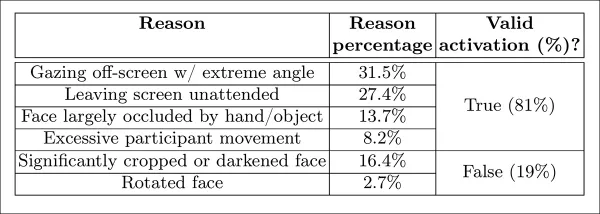

Das Modell für unbeaufsichtigte Bildschirme klassifizierte Momente als unaufmerksam, wenn sowohl AFFDEX 2.0 als auch SmartEye für mehr als eine Sekunde kein Gesicht erkannten. Nur 27 Prozent der „kein Gesicht“-Aktivierungen waren darauf zurückzuführen, dass Benutzer den Bildschirm physisch verließen.

*Verschiedene erhaltene Gründe, warum in bestimmten Fällen kein Gesicht gefunden wurde.*

*Verschiedene erhaltene Gründe, warum in bestimmten Fällen kein Gesicht gefunden wurde.*

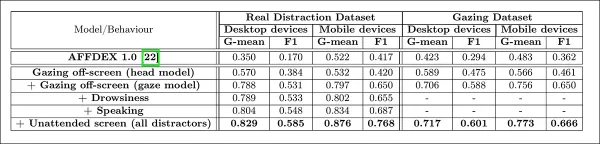

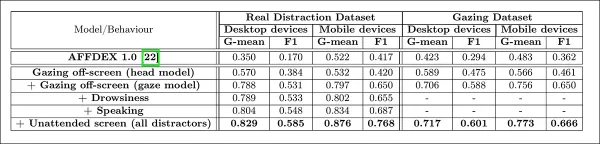

Die Autoren bewerteten, wie das Hinzufügen verschiedener Ablenkungssignale die Gesamtleistung ihres Aufmerksamkeitsmodells beeinflusste. Die Aufmerksamkeitserkennung verbesserte sich konsequent, je mehr Ablenkungstypen hinzugefügt wurden, wobei der Blick abseits des Bildschirms die stärkste Grundlage bot.

*Die Wirkung des Hinzufügens verschiedener Ablenkungssignale zur Architektur.*

*Die Wirkung des Hinzufügens verschiedener Ablenkungssignale zur Architektur.*

Die Autoren verglichen ihr Modell mit AFFDEX 1.0, einem früheren System, das in Werbetests verwendet wurde, und stellten fest, dass selbst die aktuelle kopfbasierte Blickerkennung von AFFDEX 1.0 bei beiden Gerätetypen übertraf.

*Beispielausgaben des Aufmerksamkeitsmodells für Desktop- und Mobilgeräte, wobei jede Zeile Beispiele für echte und falsche Positivmeldungen für verschiedene Ablenkungstypen zeigt.*

*Beispielausgaben des Aufmerksamkeitsmodells für Desktop- und Mobilgeräte, wobei jede Zeile Beispiele für echte und falsche Positivmeldungen für verschiedene Ablenkungstypen zeigt.*

Fazit

Die Ergebnisse stellen einen bedeutenden Fortschritt gegenüber früheren Arbeiten dar und bieten einen Einblick in den anhaltenden Drang der Branche, den inneren Zustand des Betrachters zu verstehen. Obwohl die Daten mit Zustimmung gesammelt wurden, weist die Methodik auf zukünftige Frameworks hin, die über strukturierte Marktforschungseinstellungen hinausgehen könnten. Dieses Fazit wird durch die geheime Natur dieser Forschung verstärkt, die von der Industrie streng gehütet wird.

Verwandter Artikel

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Meister Emerald Kaizo Nuzlocke: Ultimatives Überlebens- und Strategiehandbuch

Smaragd-Kaizo ist einer der beeindruckendsten Pokémon-ROM-Hacks, die je erdacht wurden. Auch wenn der Versuch eines Nuzlocke-Laufs die Herausforderung exponentiell erhöht, ist der Sieg durch sorgfälti

Kommentare (24)

0/200

Meister Emerald Kaizo Nuzlocke: Ultimatives Überlebens- und Strategiehandbuch

Smaragd-Kaizo ist einer der beeindruckendsten Pokémon-ROM-Hacks, die je erdacht wurden. Auch wenn der Versuch eines Nuzlocke-Laufs die Herausforderung exponentiell erhöht, ist der Sieg durch sorgfälti

Kommentare (24)

0/200

![JustinAnderson]() JustinAnderson

JustinAnderson

13. September 2025 06:30:43 MESZ

13. September 2025 06:30:43 MESZ

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

![MatthewSanchez]() MatthewSanchez

MatthewSanchez

20. August 2025 07:01:18 MESZ

20. August 2025 07:01:18 MESZ

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

![StephenGonzalez]() StephenGonzalez

StephenGonzalez

12. August 2025 19:01:00 MESZ

12. August 2025 19:01:00 MESZ

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

23. Juli 2025 07:31:54 MESZ

23. Juli 2025 07:31:54 MESZ

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

![EricLewis]() EricLewis

EricLewis

23. April 2025 15:03:59 MESZ

23. April 2025 15:03:59 MESZ

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

![JoseLewis]() JoseLewis

JoseLewis

22. April 2025 12:31:04 MESZ

22. April 2025 12:31:04 MESZ

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0

Die Online-Werbeindustrie investierte im Jahr 2023 erstaunliche 740,3 Milliarden USD in ihre Bemühungen, was deutlich macht, warum Unternehmen in diesem Bereich so stark an der Weiterentwicklung der Computer-Vision-Forschung interessiert sind. Sie konzentrieren sich besonders auf Technologien zur Gesichts- und Blickerkennung, wobei die Altersbestimmung eine zentrale Rolle in der demografischen Analyse spielt. Dies ist entscheidend für Werbetreibende, die bestimmte Altersgruppen ansprechen möchten.

Obwohl die Branche ihre Karten oft bedeckt hält, gibt sie gelegentlich Einblicke in ihre fortschrittlicheren proprietären Arbeiten durch veröffentlichte Studien. Diese Studien beziehen häufig Teilnehmer ein, die zugestimmt haben, an KI-gestützten Analysen teilzunehmen, die untersuchen, wie Betrachter mit Werbeanzeigen interagieren.

*Die Schätzung des Alters in einem realitätsnahen Werbekontext ist für Werbetreibende von Interesse, die eine bestimmte demografische Gruppe ansprechen möchten. In diesem experimentellen Beispiel der automatischen Gesichtsaltersbestimmung wird das Alter des Künstlers Bob Dylan über die Jahre hinweg verfolgt.* Quelle: https://arxiv.org/pdf/1906.03625

*Die Schätzung des Alters in einem realitätsnahen Werbekontext ist für Werbetreibende von Interesse, die eine bestimmte demografische Gruppe ansprechen möchten. In diesem experimentellen Beispiel der automatischen Gesichtsaltersbestimmung wird das Alter des Künstlers Bob Dylan über die Jahre hinweg verfolgt.* Quelle: https://arxiv.org/pdf/1906.03625

Eines der häufig verwendeten Werkzeuge in diesen Gesichtsschätzungssystemen ist Dlib's Histogram of Oriented Gradients (HoG), das bei der Analyse von Gesichtszügen hilft.

*Dlib's Histogram of Oriented Gradients (HoG) wird häufig in Gesichtsschätzungssystemen verwendet.* Quelle: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Dlib's Histogram of Oriented Gradients (HoG) wird häufig in Gesichtsschätzungssystemen verwendet.* Quelle: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

Tierischer Instinkt

Wenn es darum geht, das Engagement der Betrachter zu verstehen, ist die Werbeindustrie besonders daran interessiert, Fehlalarme zu identifizieren – Fälle, in denen das System die Handlungen eines Betrachters falsch interpretiert – und klare Kriterien dafür festzulegen, wann jemand nicht vollständig mit einer Anzeige beschäftigt ist. Dies ist besonders relevant für bildschirmbasierte Werbung, wo Studien sich auf zwei Hauptumgebungen konzentrieren: Desktop und Mobilgeräte, die jeweils maßgeschneiderte Tracking-Lösungen erfordern.

Werbetreibende kategorisieren die mangelnde Aufmerksamkeit der Betrachter oft in zwei Verhaltensweisen: „Eulenverhalten“ und „Echsenverhalten“. Wenn Sie Ihren Kopf von der Anzeige wegdrehen, handelt es sich um „Eulenverhalten“. Wenn Ihr Kopf still bleibt, aber Ihre Augen vom Bildschirm abweichen, ist das „Echsenverhalten“. Diese Verhaltensweisen sind entscheidend für Systeme, um sie bei der Erprobung neuer Anzeigen unter kontrollierten Bedingungen genau zu erfassen.

*Beispiele für „Eulen-“ und „Echsenverhalten“ bei einem Teilnehmer eines Werbeforschungsprojekts.* Quelle: https://arxiv.org/pdf/1508.04028

*Beispiele für „Eulen-“ und „Echsenverhalten“ bei einem Teilnehmer eines Werbeforschungsprojekts.* Quelle: https://arxiv.org/pdf/1508.04028

Ein kürzlich veröffentlichtes Papier von SmartEye's Affectiva-Akquisition geht diese Probleme direkt an. Es schlägt eine Architektur vor, die mehrere bestehende Frameworks kombiniert, um einen umfassenden Funktionssatz zur Erkennung der Betrachteraufmerksamkeit unter verschiedenen Bedingungen und Reaktionen zu erstellen. Dieses System kann erkennen, ob ein Betrachter gelangweilt, engagiert oder von den Inhalten abgelenkt ist, die der Werbetreibende im Fokus haben möchte.

*Beispiele für echte und falsche Positivmeldungen, die vom neuen Aufmerksamkeitssystem für verschiedene Ablenkungssignale erkannt wurden, getrennt für Desktop- und Mobilgeräte dargestellt.* Quelle: https://arxiv.org/pdf/2504.06237

*Beispiele für echte und falsche Positivmeldungen, die vom neuen Aufmerksamkeitssystem für verschiedene Ablenkungssignale erkannt wurden, getrennt für Desktop- und Mobilgeräte dargestellt.* Quelle: https://arxiv.org/pdf/2504.06237

Die Autoren des Papiers heben hervor, dass die Forschung zur Überwachung der Aufmerksamkeit während Online-Werbung begrenzt ist und frühere Studien oft entscheidende Faktoren wie Gerätetyp, Kamerapositionierung und Bildschirmgröße übersehen haben. Ihre vorgeschlagene Architektur zielt darauf ab, diese Lücken zu schließen, indem sie verschiedene Ablenkungen wie Eulen- und Echsenverhalten, Sprechen, Schläfrigkeit und unbeaufsichtigte Bildschirme erkennt und gerätespezifische Merkmale integriert, um die Genauigkeit zu erhöhen.

Das Papier mit dem Titel „Überwachung der Betrachteraufmerksamkeit während Online-Werbung“ wurde von vier Forschern bei Affectiva verfasst.

Methode und Daten

Angesichts der geheimen Natur dieser Systeme vergleicht das Papier seinen Ansatz nicht direkt mit Konkurrenten, sondern präsentiert seine Ergebnisse durch Ablationsstudien. Es weicht vom typischen Format der Computer-Vision-Literatur ab, daher werden wir die Forschung so erkunden, wie sie präsentiert wird.

Die Autoren weisen darauf hin, dass nur wenige Studien die Aufmerksamkeitserkennung speziell im Kontext von Online-Werbung behandelt haben. Zum Beispiel bietet das AFFDEX SDK, das Echtzeit-Multigesichtserkennung ermöglicht, Aufmerksamkeit allein anhand der Kopfhaltung an, indem es Teilnehmer als unaufmerksam einstuft, wenn ihr Kopfwinkel eine bestimmte Schwelle überschreitet.

*Ein Beispiel aus dem AFFDEX SDK, einem Affectiva-System, das die Kopfhaltung als Indikator für Aufmerksamkeit verwendet.* Quelle: https://www.youtube.com/watch?v=c2CWb5jHmbY

*Ein Beispiel aus dem AFFDEX SDK, einem Affectiva-System, das die Kopfhaltung als Indikator für Aufmerksamkeit verwendet.* Quelle: https://www.youtube.com/watch?v=c2CWb5jHmbY

In einer Zusammenarbeit von 2019 mit dem Titel „Automatische Messung der visuellen Aufmerksamkeit für Videoinhalte mit Deep Learning“ wurde ein Datensatz von etwa 28.000 Teilnehmern für verschiedene unaufmerksame Verhaltensweisen annotiert, und ein CNN-LSTM-Modell wurde trainiert, um die Aufmerksamkeit anhand des Gesichtsaussehens über die Zeit hinweg zu erkennen.

*Aus dem Papier von 2019, ein Beispiel, das vorhergesagte Aufmerksamkeitszustände für einen Betrachter darstellt, der Videoinhalte ansieht.* Quelle: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*Aus dem Papier von 2019, ein Beispiel, das vorhergesagte Aufmerksamkeitszustände für einen Betrachter darstellt, der Videoinhalte ansieht.* Quelle: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

Jedoch berücksichtigten diese früheren Arbeiten keine gerätespezifischen Faktoren wie die Verwendung eines Desktop- oder Mobilgeräts, noch berücksichtigten sie Bildschirmgröße oder Kamerapositionierung. Das AFFDEX-System konzentrierte sich ausschließlich auf die Erkennung von Blickablenkung, während die Arbeit von 2019 versuchte, ein breiteres Spektrum an Verhaltensweisen zu erkennen, jedoch möglicherweise durch die Verwendung eines einzigen flachen CNN eingeschränkt war.

Die Autoren stellen fest, dass ein Großteil der bestehenden Forschung nicht für die Werbetestung optimiert ist, die einzigartige Anforderungen im Vergleich zu anderen Bereichen wie Fahren oder Bildung hat. Sie haben eine Architektur zur Erkennung der Betrachteraufmerksamkeit während Online-Werbung entwickelt, die zwei kommerzielle Toolkits nutzt: AFFDEX 2.0 und SmartEye SDK.

*Beispiele für Gesichtsanalysen aus AFFDEX 2.0.* Quelle: https://arxiv.org/pdf/2202.12059

*Beispiele für Gesichtsanalysen aus AFFDEX 2.0.* Quelle: https://arxiv.org/pdf/2202.12059

Diese Toolkits extrahieren niedrigstufige Merkmale wie Gesichtsausdrücke, Kopfhaltung und Blickrichtung, die dann verarbeitet werden, um höherstufige Indikatoren wie die Blickposition auf dem Bildschirm, Gähnen und Sprechen zu erzeugen. Das System identifiziert vier Arten von Ablenkungen: Blick abseits des Bildschirms, Schläfrigkeit, Sprechen und unbeaufsichtigte Bildschirme, wobei die Blickanalyse je nach Verwendung eines Desktop- oder Mobilgeräts angepasst wird.

Datensätze: Blick

Die Autoren verwendeten vier Datensätze, um ihr Aufmerksamkeitserkennungssystem zu betreiben und zu bewerten: drei konzentrierten sich auf Blickverhalten, Sprechen und Gähnen, und ein vierter wurde aus realen Werbetestsitzungen gezogen, die verschiedene Ablenkungstypen enthielten. Es wurden benutzerdefinierte Datensätze für jede Kategorie erstellt, die aus einem proprietären Repository mit Millionen von aufgezeichneten Sitzungen von Teilnehmern stammen, die Werbung in häuslicher oder arbeitsplatzbezogener Umgebung ansehen, mit informierter Zustimmung.

Um den Blick-Datensatz zu erstellen, folgten die Teilnehmer einem sich bewegenden Punkt über den Bildschirm und schauten dann in vier Richtungen weg. Dieser Prozess wurde dreimal wiederholt, um die Beziehung zwischen Erfassung und Abdeckung zu etablieren.

*Screenshots, die den Blickvideostimulus auf (a) Desktop- und (b) Mobilgeräten zeigen. Die ersten und dritten Frames zeigen Anweisungen, einem sich bewegenden Punkt zu folgen, während die zweiten und vierten die Teilnehmer auffordern, vom Bildschirm wegzusehen.*

*Screenshots, die den Blickvideostimulus auf (a) Desktop- und (b) Mobilgeräten zeigen. Die ersten und dritten Frames zeigen Anweisungen, einem sich bewegenden Punkt zu folgen, während die zweiten und vierten die Teilnehmer auffordern, vom Bildschirm wegzusehen.*

Die Abschnitte mit dem sich bewegenden Punkt wurden als aufmerksam gekennzeichnet, und die Abschnitte abseits des Bildschirms als unaufmerksam, wodurch ein gelabelter Datensatz mit sowohl positiven als auch negativen Beispielen erstellt wurde. Jedes Video dauerte etwa 160 Sekunden, mit separaten Versionen für Desktop- und Mobilplattformen. Insgesamt wurden 609 Videos gesammelt, aufgeteilt in 158 Trainingssamples und 451 für Tests.

Datensätze: Sprechen

In diesem Kontext wird Sprechen für länger als eine Sekunde als Zeichen von Unaufmerksamkeit betrachtet. Da die kontrollierte Umgebung keine Audioaufnahmen macht, wird Sprechen durch die Beobachtung der Bewegung geschätzter Gesichtsmerkmale abgeleitet. Die Autoren erstellten einen Datensatz basierend auf visuellem Input, aufgeteilt in zwei Teile: einen manuell von drei Annotatoren gelabelten und einen anderen, der automatisch basierend auf dem Sitzungstyp gelabelt wurde.

Datensätze: Gähnen

Vorhandene Gähnen-Datensätze waren für Werbetestszenarien nicht geeignet, daher verwendeten die Autoren 735 Videos aus ihrer internen Sammlung, die sich auf Sitzungen konzentrierten, die wahrscheinlich einen Kieferabfall von mehr als einer Sekunde enthielten. Jedes Video wurde manuell von drei Annotatoren als entweder aktives oder inaktives Gähnen gekennzeichnet, wobei nur 2,6 Prozent der Frames aktives Gähnen enthielten.

Datensätze: Ablenkung

Der Ablenkungsdatensatz wurde aus dem Werbetestrepository der Autoren gezogen, wo Teilnehmer echte Werbeanzeigen ohne zugewiesene Aufgaben ansahen. Insgesamt wurden 520 Sitzungen zufällig ausgewählt und manuell von drei Annotatoren als entweder aufmerksam oder unaufmerksam gekennzeichnet, wobei unaufmerksames Verhalten Blick abseits des Bildschirms, Sprechen, Schläfrigkeit und unbeaufsichtigte Bildschirme umfasste.

Aufmerksamkeitsmodelle

Das vorgeschlagene Aufmerksamkeitsmodell verarbeitet niedrigstufige visuelle Merkmale wie Gesichtsausdrücke, Kopfhaltung und Blickrichtung, die durch AFFDEX 2.0 und SmartEye SDK extrahiert werden. Diese werden in höherstufige Indikatoren umgewandelt, wobei jeder Ablenkungsfaktor von einem separaten binären Klassifikator behandelt wird, der auf seinem eigenen Datensatz für unabhängige Optimierung und Bewertung trainiert wird.

*Schema für das vorgeschlagene Überwachungssystem.*

*Schema für das vorgeschlagene Überwachungssystem.*

Das Blickmodell bestimmt, ob der Betrachter auf oder vom Bildschirm weg sieht, unter Verwendung normalisierter Blickkoordinaten, mit separater Kalibrierung für Desktop- und Mobilgeräte. Eine lineare Support Vector Machine (SVM) wird verwendet, um schnelle Blickverschiebungen zu glätten.

Um Sprechen ohne Audio zu erkennen, verwendet das System zugeschnittene Mundregionen und ein 3D-CNN, das sowohl auf konversationellen als auch auf nicht-konversationellen Videosegmenten trainiert wurde. Gähnen wird mithilfe von zugeschnittenen Ganzgesichtsbildern erkannt, mit einem 3D-CNN, das auf manuell gelabelten Frames trainiert wurde. Bildschirmverlassen wird durch das Fehlen eines Gesichts oder extreme Kopfhaltung identifiziert, mit Vorhersagen, die durch einen Entscheidungsbaum getroffen werden.

Der endgültige Aufmerksamkeitsstatus wird durch eine feste Regel bestimmt: Wenn ein Modul Unaufmerksamkeit erkennt, wird der Betrachter als unaufmerksam markiert, wobei die Sensitivität priorisiert und separat für Desktop- und Mobilkontexte abgestimmt wird.

Tests

Die Tests folgen einer ablativen Methode, bei der Komponenten entfernt werden und die Auswirkungen auf das Ergebnis notiert werden. Das Blickmodell identifizierte Verhalten abseits des Bildschirms durch drei Schlüsselschritte: Normalisierung roher Blickabschätzungen, Feinabstimmung des Outputs und Schätzung der Bildschirmgröße für Desktop-Geräte.

*Verschiedene Kategorien wahrgenommener Unaufmerksamkeit, die in der Studie identifiziert wurden.*

*Verschiedene Kategorien wahrgenommener Unaufmerksamkeit, die in der Studie identifiziert wurden.*

Die Leistung nahm ab, wenn ein Schritt ausgelassen wurde, wobei die Normalisierung besonders auf Desktops wertvoll war. Die Studie bewertete auch, wie visuelle Merkmale die Orientierung der mobilen Kamera vorhersagten, wobei die Kombination aus Gesichtsposition, Kopfhaltung und Blickrichtung einen Score von 0,91 erreichte.

*Ergebnisse, die die Leistung des vollständigen Blickmodells zeigen, neben Versionen mit einzelnen Verarbeitungsschritten entfernt.*

*Ergebnisse, die die Leistung des vollständigen Blickmodells zeigen, neben Versionen mit einzelnen Verarbeitungsschritten entfernt.*

Das Sprechmodell, trainiert auf vertikalem Lippenabstand, erreichte einen ROC-AUC von 0,97 auf dem manuell gelabelten Testset und 0,96 auf dem größeren automatisch gelabelten Datensatz. Das Gähnenmodell erreichte einen ROC-AUC von 96,6 Prozent allein mit dem Mundaspektverhältnis, verbesserte sich auf 97,5 Prozent, wenn es mit Aktionsvorhersagen von AFFDEX 2.0 kombiniert wurde.

Das Modell für unbeaufsichtigte Bildschirme klassifizierte Momente als unaufmerksam, wenn sowohl AFFDEX 2.0 als auch SmartEye für mehr als eine Sekunde kein Gesicht erkannten. Nur 27 Prozent der „kein Gesicht“-Aktivierungen waren darauf zurückzuführen, dass Benutzer den Bildschirm physisch verließen.

*Verschiedene erhaltene Gründe, warum in bestimmten Fällen kein Gesicht gefunden wurde.*

*Verschiedene erhaltene Gründe, warum in bestimmten Fällen kein Gesicht gefunden wurde.*

Die Autoren bewerteten, wie das Hinzufügen verschiedener Ablenkungssignale die Gesamtleistung ihres Aufmerksamkeitsmodells beeinflusste. Die Aufmerksamkeitserkennung verbesserte sich konsequent, je mehr Ablenkungstypen hinzugefügt wurden, wobei der Blick abseits des Bildschirms die stärkste Grundlage bot.

*Die Wirkung des Hinzufügens verschiedener Ablenkungssignale zur Architektur.*

*Die Wirkung des Hinzufügens verschiedener Ablenkungssignale zur Architektur.*

Die Autoren verglichen ihr Modell mit AFFDEX 1.0, einem früheren System, das in Werbetests verwendet wurde, und stellten fest, dass selbst die aktuelle kopfbasierte Blickerkennung von AFFDEX 1.0 bei beiden Gerätetypen übertraf.

*Beispielausgaben des Aufmerksamkeitsmodells für Desktop- und Mobilgeräte, wobei jede Zeile Beispiele für echte und falsche Positivmeldungen für verschiedene Ablenkungstypen zeigt.*

*Beispielausgaben des Aufmerksamkeitsmodells für Desktop- und Mobilgeräte, wobei jede Zeile Beispiele für echte und falsche Positivmeldungen für verschiedene Ablenkungstypen zeigt.*

Fazit

Die Ergebnisse stellen einen bedeutenden Fortschritt gegenüber früheren Arbeiten dar und bieten einen Einblick in den anhaltenden Drang der Branche, den inneren Zustand des Betrachters zu verstehen. Obwohl die Daten mit Zustimmung gesammelt wurden, weist die Methodik auf zukünftige Frameworks hin, die über strukturierte Marktforschungseinstellungen hinausgehen könnten. Dieses Fazit wird durch die geheime Natur dieser Forschung verstärkt, die von der Industrie streng gehütet wird.

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Meister Emerald Kaizo Nuzlocke: Ultimatives Überlebens- und Strategiehandbuch

Smaragd-Kaizo ist einer der beeindruckendsten Pokémon-ROM-Hacks, die je erdacht wurden. Auch wenn der Versuch eines Nuzlocke-Laufs die Herausforderung exponentiell erhöht, ist der Sieg durch sorgfälti

Meister Emerald Kaizo Nuzlocke: Ultimatives Überlebens- und Strategiehandbuch

Smaragd-Kaizo ist einer der beeindruckendsten Pokémon-ROM-Hacks, die je erdacht wurden. Auch wenn der Versuch eines Nuzlocke-Laufs die Herausforderung exponentiell erhöht, ist der Sieg durch sorgfälti

13. September 2025 06:30:43 MESZ

13. September 2025 06:30:43 MESZ

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

20. August 2025 07:01:18 MESZ

20. August 2025 07:01:18 MESZ

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

12. August 2025 19:01:00 MESZ

12. August 2025 19:01:00 MESZ

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

23. Juli 2025 07:31:54 MESZ

23. Juli 2025 07:31:54 MESZ

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

23. April 2025 15:03:59 MESZ

23. April 2025 15:03:59 MESZ

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

22. April 2025 12:31:04 MESZ

22. April 2025 12:31:04 MESZ

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0