Рекламодец нацелен на «Совы и ящерицы» в анализе аудитории

Индустрия онлайн-рекламы вложила ошеломляющие $740,3 миллиарда долларов США в свои усилия в 2023 году, что ясно объясняет, почему компании в этой сфере так заинтересованы в продвижении исследований в области компьютерного зрения. Они особенно сосредоточены на технологиях распознавания лиц и направления взгляда, где оценка возраста играет ключевую роль в демографической аналитике. Это крайне важно для рекламодателей, стремящихся ориентироваться на определённые возрастные группы.

Хотя индустрия склонна держать свои карты при себе, она иногда делится отрывками о своих более продвинутых проприетарных разработках через опубликованные исследования. Эти исследования часто включают участников, согласившихся быть частью анализов, проводимых с использованием ИИ, которые направлены на понимание того, как зрители взаимодействуют с рекламой.

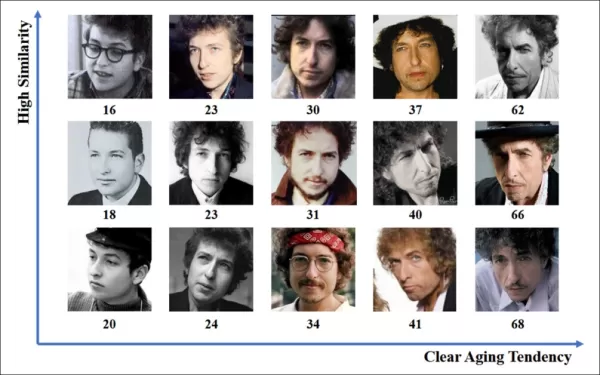

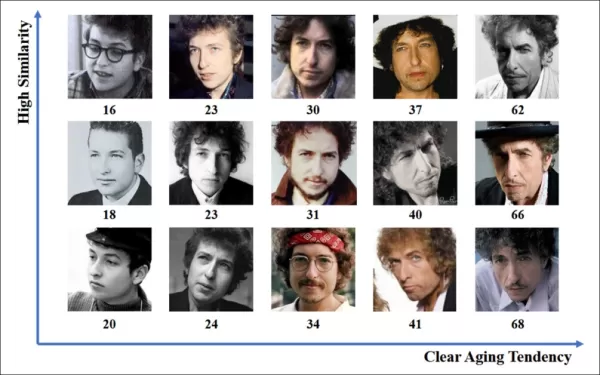

*Оценка возраста в контексте рекламы в реальных условиях представляет интерес для рекламодателей, которые могут ориентироваться на определённую демографическую группу. В этом экспериментальном примере автоматической оценки возраста по лицу отслеживается возраст исполнителя Боба Дилана на протяжении многих лет.* Источник: https://arxiv.org/pdf/1906.03625

*Оценка возраста в контексте рекламы в реальных условиях представляет интерес для рекламодателей, которые могут ориентироваться на определённую демографическую группу. В этом экспериментальном примере автоматической оценки возраста по лицу отслеживается возраст исполнителя Боба Дилана на протяжении многих лет.* Источник: https://arxiv.org/pdf/1906.03625

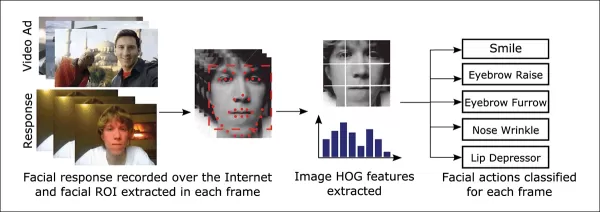

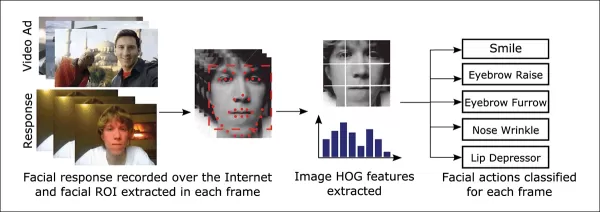

Одним из инструментов, часто используемых в этих системах оценки лиц, является гистограмма ориентированных градиентов (HoG) от Dlib, которая помогает в анализе черт лица.

*Гистограмма ориентированных градиентов (HoG) от Dlib часто используется в системах оценки лиц.* Источник: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Гистограмма ориентированных градиентов (HoG) от Dlib часто используется в системах оценки лиц.* Источник: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

Животные инстинкты

Когда речь заходит о понимании вовлечённости зрителей, рекламная индустрия особенно заинтересована в выявлении ложных срабатываний — случаев, когда система неверно интерпретирует действия зрителя — и установлении чётких критериев, когда кто-то не полностью вовлечён в просмотр рекламы. Это особенно актуально для экранной рекламы, где исследования сосредоточены на двух основных средах: настольных компьютерах и мобильных устройствах, каждая из которых требует адаптированных решений для отслеживания.

Рекламодатели часто классифицируют невовлечённость зрителей на два типа поведения: «поведение совы» и «поведение ящерицы». Если вы отворачиваетесь от рекламы, это «поведение совы». Если ваша голова остаётся неподвижной, но глаза блуждают за пределами экрана, это «поведение ящерицы». Эти типы поведения крайне важны для точного захвата системами при тестировании новых рекламных материалов в контролируемых условиях.

*Примеры поведения «совы» и «ящерицы» у субъекта исследовательского проекта в области рекламы.* Источник: https://arxiv.org/pdf/1508.04028

*Примеры поведения «совы» и «ящерицы» у субъекта исследовательского проекта в области рекламы.* Источник: https://arxiv.org/pdf/1508.04028

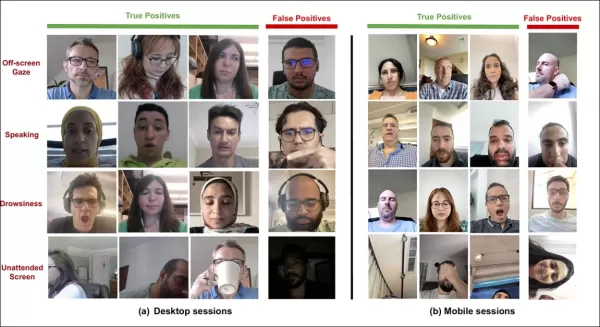

Недавняя статья, связанная с приобретением Affectiva компанией SmartEye, напрямую решает эти проблемы. Она предлагает архитектуру, которая объединяет несколько существующих фреймворков для создания всеобъемлющего набора функций для обнаружения внимания зрителей в различных условиях и реакциях. Эта система может определить, скучает ли зритель, вовлечён или отвлечён от контента, на который рекламодатель хочет, чтобы он сосредоточился.

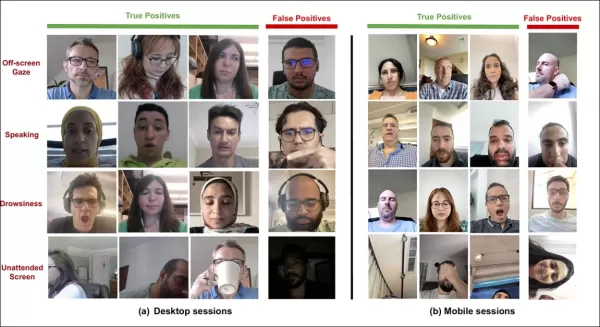

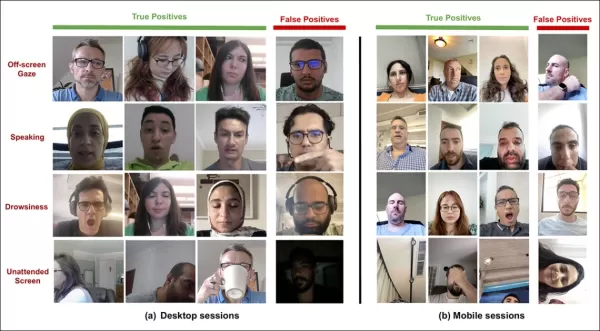

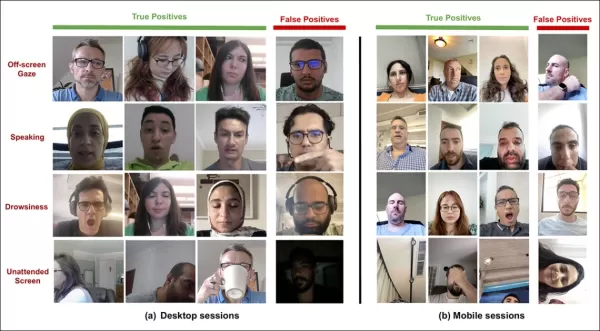

*Примеры истинных и ложных срабатываний, обнаруженных новой системой внимания для различных сигналов отвлечения, показанные отдельно для настольных и мобильных устройств.* Источник: https://arxiv.org/pdf/2504.06237

*Примеры истинных и ложных срабатываний, обнаруженных новой системой внимания для различных сигналов отвлечения, показанные отдельно для настольных и мобильных устройств.* Источник: https://arxiv.org/pdf/2504.06237

Авторы статьи подчёркивают ограниченность исследований по мониторингу внимания во время онлайн-рекламы и отмечают, что предыдущие исследования часто игнорировали ключевые факторы, такие как тип устройства, размещение камеры и размер экрана. Их предложенная архитектура направлена на устранение этих пробелов путём обнаружения различных отвлекающих факторов, включая поведение «совы» и «ящерицы», разговор, сонливость и оставленные без присмотра экраны, при этом интегрируя функции, специфичные для устройства, для повышения точности.

Статья, озаглавленная «Мониторинг внимания зрителей во время онлайн-рекламы», была написана четырьмя исследователями из Affectiva.

Методы и данные

Учитывая секретный характер этих систем, статья не проводит прямого сравнения своего подхода с конкурентами, но представляет свои выводы через исследования абляции. Она отклоняется от типичного формата литературы по компьютерному зрению, поэтому мы рассмотрим исследование так, как оно представлено.

Авторы указывают, что лишь немногие исследования специально рассматривали обнаружение внимания в контексте онлайн-рекламы. Например, AFFDEX SDK, предлагающий распознавание лиц в реальном времени, определяет внимание исключительно по положению головы, классифицируя участников как невнимательных, если угол наклона головы превышает определённый порог.

*Пример из AFFDEX SDK, системы Affectiva, которая полагается на положение головы как индикатор внимания.* Источник: https://www.youtube.com/watch?v=c2CWb5jHmbY

*Пример из AFFDEX SDK, системы Affectiva, которая полагается на положение головы как индикатор внимания.* Источник: https://www.youtube.com/watch?v=c2CWb5jHmbY

В сотрудничестве 2019 года, озаглавленном «Автоматическое измерение визуального внимания к видеоконтенту с использованием глубокого обучения», набор данных из примерно 28 000 участников был аннотирован для различных невнимательных поведений, и модель CNN-LSTM была обучена для обнаружения внимания по внешнему виду лица во времени.

*Из статьи 2019 года, пример, иллюстрирующий предсказанные состояния внимания зрителя, смотрящего видеоконтент.* Источник: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*Из статьи 2019 года, пример, иллюстрирующий предсказанные состояния внимания зрителя, смотрящего видеоконтент.* Источник: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

Однако эти более ранние усилия не учитывали факторы, специфичные для устройства, такие как использование настольного или мобильного устройства, а также размер экрана или размещение камеры. Система AFFDEX фокусировалась только на выявлении отклонения взгляда, в то время как работа 2019 года пыталась обнаружить более широкий набор поведений, но могла быть ограничена использованием одной неглубокой CNN.

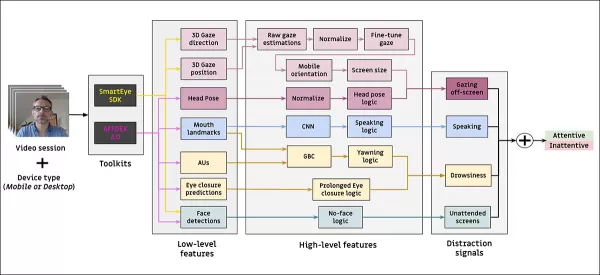

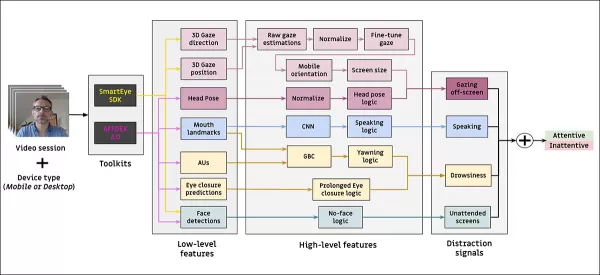

Авторы отмечают, что большая часть существующих исследований не оптимизирована для тестирования рекламы, которое имеет уникальные потребности по сравнению с другими областями, такими как вождение или образование. Они разработали архитектуру для обнаружения внимания зрителей во время онлайн-рекламы, используя два коммерческих инструментария: AFFDEX 2.0 и SmartEye SDK.

*Примеры анализа лиц из AFFDEX 2.0.* Источник: https://arxiv.org/pdf/2202.12059

*Примеры анализа лиц из AFFDEX 2.0.* Источник: https://arxiv.org/pdf/2202.12059

Эти инструментарии извлекают низкоуровневые признаки, такие как выражения лица, положение головы и направление взгляда, которые затем обрабатываются для получения высокоуровневых индикаторов, таких как положение взгляда на экране, зевание и разговор. Система определяет четыре типа отвлечений: взгляд за пределы экрана, сонливость, разговор и оставленные без присмотра экраны, адаптируя анализ взгляда в зависимости от того, использует ли зритель настольное или мобильное устройство.

Наборы данных: Взгляд

Авторы использовали четыре набора данных для поддержки и оценки своей системы обнаружения внимания: три набора, посвящённые поведению взгляда, разговору и зеванию, и четвёртый, полученный из реальных сессий тестирования рекламы, содержащий различные типы отвлечений. Специальные наборы данных были созданы для каждой категории, взяты из проприетарного репозитория, содержащего миллионы записанных сессий участников, смотрящих рекламу в домашних или рабочих условиях, с их информированного согласия.

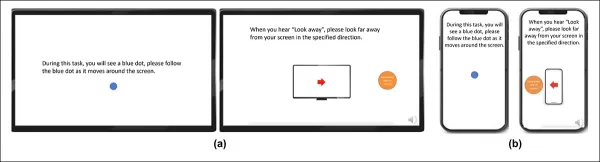

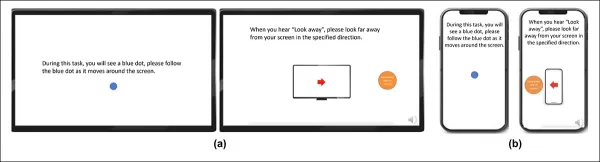

Для создания набора данных по взгляду участники следовали за движущейся точкой на экране, а затем отводили взгляд в четырёх направлениях. Этот процесс повторялся трижды для установления связи между захватом и охватом.

*Скриншоты, показывающие стимул видео взгляда на (a) настольных и (b) мобильных устройствах. Первый и третий кадры отображают инструкции следовать за движущейся точкой, в то время как второй и четвёртый побуждают участников отвести взгляд от экрана.*

*Скриншоты, показывающие стимул видео взгляда на (a) настольных и (b) мобильных устройствах. Первый и третий кадры отображают инструкции следовать за движущейся точкой, в то время как второй и четвёртый побуждают участников отвести взгляд от экрана.*

Сегменты с движущейся точкой были помечены как внимательные, а сегменты с отведённым взглядом — как невнимательные, создавая размеченный набор данных с примерами как положительных, так и отрицательных случаев. Каждое видео длилось около 160 секунд, с отдельными версиями для настольных и мобильных платформ. Всего было собрано 609 видео, разделённых на 158 обучающих образцов и 451 для тестирования.

Наборы данных: Разговор

В этом контексте разговор дольше одной секунды считается признаком невнимательности. Поскольку контролируемая среда не записывает звук, речь определяется по движению предполагаемых лицевых ориентиров. Авторы создали набор данных на основе визуального ввода, разделённый на две части: одна вручную размечена тремя аннотаторами, а другая автоматически размечена на основе типа сессии.

Наборы данных: Зевание

Существующие наборы данных по зеванию не были подходящими для сценариев тестирования рекламы, поэтому авторы использовали 735 видео из своей внутренней коллекции, сосредоточившись на сессиях, вероятно содержащих опущение челюсти дольше одной секунды. Каждое видео было вручную размечено тремя аннотаторами как показывающее активное или неактивное зевание, при этом только 2,6 процента кадров содержали активные зевки.

Наборы данных: Отвлечение

Набор данных по отвлечению был взят из репозитория тестирования рекламы авторов, где участники просматривали реальные рекламные объявления без назначенных задач. Всего было случайно выбрано 520 сессий и вручную размечено тремя аннотаторами как внимательные или невнимательные, при этом невнимательное поведение включало взгляд за пределы экрана, разговор, сонливость и оставленные без присмотра экраны.

Модели внимания

Предложенная модель внимания обрабатывает низкоуровневые визуальные признаки, такие как выражения лица, положение головы и направление взгляда, извлечённые с помощью AFFDEX 2.0 и SmartEye SDK. Они преобразуются в высокоуровневые индикаторы, при этом каждый отвлекающий фактор обрабатывается отдельным бинарным классификатором, обученным на своём собственном наборе данных для независимой оптимизации и оценки.

*Схема предложенной системы мониторинга.*

*Схема предложенной системы мониторинга.*

Модель взгляда определяет, смотрит ли зритель на экран или отводит взгляд, используя нормализованные координаты взгляда, с отдельной калибровкой для настольных и мобильных устройств. Линейная машина опорных векторов (SVM) используется для сглаживания быстрых изменений взгляда.

Для обнаружения разговора без звука система использует обрезанные области рта и 3D-CNN, обученную на сегментах видео с разговорами и без них. Зевание определяется с использованием обрезок полного лица, с 3D-CNN, обученной на вручную размеченных кадрах. Покинутость экрана идентифицируется по отсутствию лица или экстремальному положению головы, с предсказаниями, сделанными с помощью дерева решений.

Окончательный статус внимания определяется с использованием фиксированного правила: если любой модуль обнаруживает невнимательность, зритель помечается как невнимательный, с приоритетом на чувствительность и отдельной настройкой для контекстов настольных и мобильных устройств.

Тесты

Тесты следуют абляционному методу, при котором компоненты удаляются, и отмечается эффект на результат. Модель взгляда идентифицировала поведение вне экрана через три ключевых шага: нормализация необработанных оценок взгляда, тонкая настройка вывода и оценка размера экрана для настольных устройств.

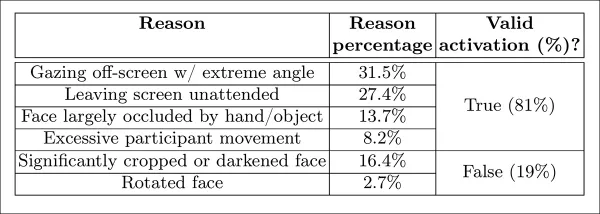

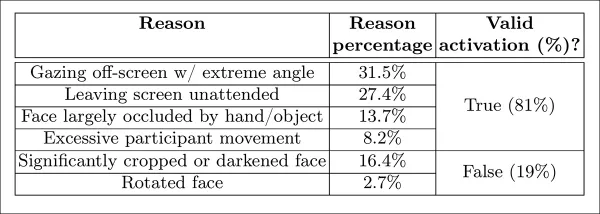

*Различные категории воспринимаемой невнимательности, выявленные в исследовании.*

*Различные категории воспринимаемой невнимательности, выявленные в исследовании.*

Производительность снижалась при пропуске любого шага, при этом нормализация оказалась особенно ценной на настольных компьютерах. Исследование также оценило, как визуальные признаки предсказывали ориентацию камеры мобильного устройства, при этом комбинация местоположения лица, положения головы и взгляда достигла показателя 0,91.

*Результаты, показывающие производительность полной модели взгляда, наряду с версиями, в которых отдельные этапы обработки были удалены.*

*Результаты, показывающие производительность полной модели взгляда, наряду с версиями, в которых отдельные этапы обработки были удалены.*

Модель разговора, обученная на вертикальном расстоянии губ, достигла ROC-AUC 0,97 на вручную размеченном тестовом наборе и 0,96 на более крупном автоматически размеченном наборе данных. Модель зевания достигла ROC-AUC 96,6 процента, используя только соотношение сторон рта, улучшившись до 97,5 процента при комбинации с предсказаниями активных единиц от AFFDEX 2.0.

Модель оставленных без присмотра экранов классифицировала моменты как невнимательные, когда и AFFDEX 2.0, и SmartEye не обнаруживали лицо более одной секунды. Только 27 процентов активаций «без лица» были вызваны физическим уходом пользователей от экрана.

*Различные полученные причины, почему лицо не было найдено в определённых случаях.*

*Различные полученные причины, почему лицо не было найдено в определённых случаях.*

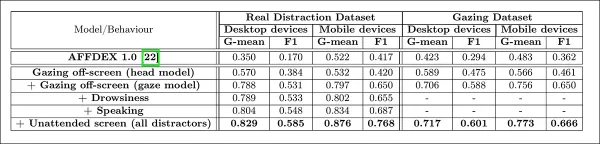

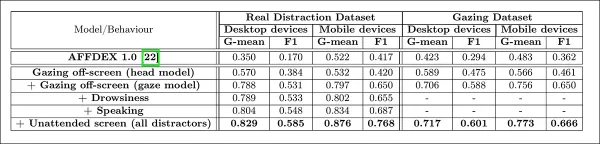

Авторы оценили, как добавление различных сигналов отвлечения влияло на общую производительность их модели внимания. Обнаружение внимания стабильно улучшалось по мере добавления большего числа типов отвлечений, при этом взгляд за пределы экрана обеспечивал наиболее сильную базовую линию.

*Эффект добавления различных сигналов отвлечения в архитектуру.*

*Эффект добавления различных сигналов отвлечения в архитектуру.*

Авторы сравнили свою модель с AFFDEX 1.0, предыдущей системой, использовавшейся в тестировании рекламы, и обнаружили, что даже текущая модель обнаружения взгляда на основе положения головы превзошла AFFDEX 1.0 на обоих типах устройств.

*Примеры выходных данных модели внимания на настольных и мобильных устройствах, где каждая строка представляет примеры истинных и ложных срабатываний для различных типов отвлечений.*

*Примеры выходных данных модели внимания на настольных и мобильных устройствах, где каждая строка представляет примеры истинных и ложных срабатываний для различных типов отвлечений.*

Заключение

Результаты представляют значительный прогресс по сравнению с предыдущими работами, давая представление о настойчивом стремлении индустрии понять внутреннее состояние зрителя. Хотя данные были собраны с согласия, методология указывает на будущие фреймворки, которые могут выйти за рамки структурированных настроек маркетинговых исследований. Этот вывод подтверждается секретным характером этого исследования, которое остаётся строго охраняемым в индустрии.

Связанная статья

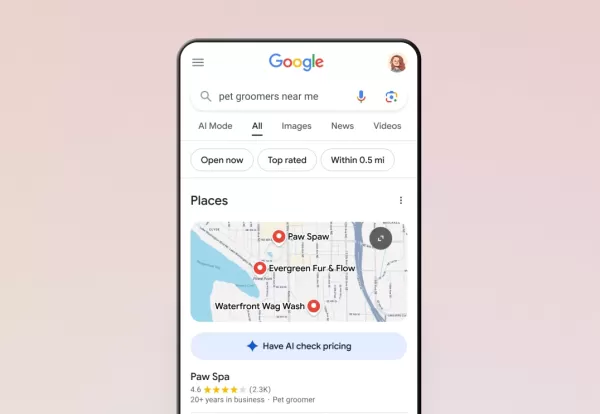

ИИ от Google теперь обрабатывает телефонные звонки за вас

Google расширил функцию искусственного интеллекта для всех пользователей США через Поиск, позволяя клиентам узнавать о ценах и наличии свободных мест в местных компаниях без телефонных разговоров. Эта

ИИ от Google теперь обрабатывает телефонные звонки за вас

Google расширил функцию искусственного интеллекта для всех пользователей США через Поиск, позволяя клиентам узнавать о ценах и наличии свободных мест в местных компаниях без телефонных разговоров. Эта

Трамп освобождает смартфоны, компьютеры и микросхемы от повышения тарифов

По данным агентства Bloomberg, администрация Трампа исключила смартфоны, компьютеры и различные электронные устройства из недавнего повышения тарифов, даже если они импортируются из Китая. Однако на э

Трамп освобождает смартфоны, компьютеры и микросхемы от повышения тарифов

По данным агентства Bloomberg, администрация Трампа исключила смартфоны, компьютеры и различные электронные устройства из недавнего повышения тарифов, даже если они импортируются из Китая. Однако на э

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

Комментарии (24)

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

Комментарии (24)

![JustinAnderson]() JustinAnderson

JustinAnderson

13 сентября 2025 г., 7:30:43 GMT+03:00

13 сентября 2025 г., 7:30:43 GMT+03:00

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

![MatthewSanchez]() MatthewSanchez

MatthewSanchez

20 августа 2025 г., 8:01:18 GMT+03:00

20 августа 2025 г., 8:01:18 GMT+03:00

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

![StephenGonzalez]() StephenGonzalez

StephenGonzalez

12 августа 2025 г., 20:01:00 GMT+03:00

12 августа 2025 г., 20:01:00 GMT+03:00

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

23 июля 2025 г., 8:31:54 GMT+03:00

23 июля 2025 г., 8:31:54 GMT+03:00

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

![EricLewis]() EricLewis

EricLewis

23 апреля 2025 г., 16:03:59 GMT+03:00

23 апреля 2025 г., 16:03:59 GMT+03:00

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

![JoseLewis]() JoseLewis

JoseLewis

22 апреля 2025 г., 13:31:04 GMT+03:00

22 апреля 2025 г., 13:31:04 GMT+03:00

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0

Индустрия онлайн-рекламы вложила ошеломляющие $740,3 миллиарда долларов США в свои усилия в 2023 году, что ясно объясняет, почему компании в этой сфере так заинтересованы в продвижении исследований в области компьютерного зрения. Они особенно сосредоточены на технологиях распознавания лиц и направления взгляда, где оценка возраста играет ключевую роль в демографической аналитике. Это крайне важно для рекламодателей, стремящихся ориентироваться на определённые возрастные группы.

Хотя индустрия склонна держать свои карты при себе, она иногда делится отрывками о своих более продвинутых проприетарных разработках через опубликованные исследования. Эти исследования часто включают участников, согласившихся быть частью анализов, проводимых с использованием ИИ, которые направлены на понимание того, как зрители взаимодействуют с рекламой.

*Оценка возраста в контексте рекламы в реальных условиях представляет интерес для рекламодателей, которые могут ориентироваться на определённую демографическую группу. В этом экспериментальном примере автоматической оценки возраста по лицу отслеживается возраст исполнителя Боба Дилана на протяжении многих лет.* Источник: https://arxiv.org/pdf/1906.03625

*Оценка возраста в контексте рекламы в реальных условиях представляет интерес для рекламодателей, которые могут ориентироваться на определённую демографическую группу. В этом экспериментальном примере автоматической оценки возраста по лицу отслеживается возраст исполнителя Боба Дилана на протяжении многих лет.* Источник: https://arxiv.org/pdf/1906.03625

Одним из инструментов, часто используемых в этих системах оценки лиц, является гистограмма ориентированных градиентов (HoG) от Dlib, которая помогает в анализе черт лица.

*Гистограмма ориентированных градиентов (HoG) от Dlib часто используется в системах оценки лиц.* Источник: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Гистограмма ориентированных градиентов (HoG) от Dlib часто используется в системах оценки лиц.* Источник: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

Животные инстинкты

Когда речь заходит о понимании вовлечённости зрителей, рекламная индустрия особенно заинтересована в выявлении ложных срабатываний — случаев, когда система неверно интерпретирует действия зрителя — и установлении чётких критериев, когда кто-то не полностью вовлечён в просмотр рекламы. Это особенно актуально для экранной рекламы, где исследования сосредоточены на двух основных средах: настольных компьютерах и мобильных устройствах, каждая из которых требует адаптированных решений для отслеживания.

Рекламодатели часто классифицируют невовлечённость зрителей на два типа поведения: «поведение совы» и «поведение ящерицы». Если вы отворачиваетесь от рекламы, это «поведение совы». Если ваша голова остаётся неподвижной, но глаза блуждают за пределами экрана, это «поведение ящерицы». Эти типы поведения крайне важны для точного захвата системами при тестировании новых рекламных материалов в контролируемых условиях.

*Примеры поведения «совы» и «ящерицы» у субъекта исследовательского проекта в области рекламы.* Источник: https://arxiv.org/pdf/1508.04028

*Примеры поведения «совы» и «ящерицы» у субъекта исследовательского проекта в области рекламы.* Источник: https://arxiv.org/pdf/1508.04028

Недавняя статья, связанная с приобретением Affectiva компанией SmartEye, напрямую решает эти проблемы. Она предлагает архитектуру, которая объединяет несколько существующих фреймворков для создания всеобъемлющего набора функций для обнаружения внимания зрителей в различных условиях и реакциях. Эта система может определить, скучает ли зритель, вовлечён или отвлечён от контента, на который рекламодатель хочет, чтобы он сосредоточился.

*Примеры истинных и ложных срабатываний, обнаруженных новой системой внимания для различных сигналов отвлечения, показанные отдельно для настольных и мобильных устройств.* Источник: https://arxiv.org/pdf/2504.06237

*Примеры истинных и ложных срабатываний, обнаруженных новой системой внимания для различных сигналов отвлечения, показанные отдельно для настольных и мобильных устройств.* Источник: https://arxiv.org/pdf/2504.06237

Авторы статьи подчёркивают ограниченность исследований по мониторингу внимания во время онлайн-рекламы и отмечают, что предыдущие исследования часто игнорировали ключевые факторы, такие как тип устройства, размещение камеры и размер экрана. Их предложенная архитектура направлена на устранение этих пробелов путём обнаружения различных отвлекающих факторов, включая поведение «совы» и «ящерицы», разговор, сонливость и оставленные без присмотра экраны, при этом интегрируя функции, специфичные для устройства, для повышения точности.

Статья, озаглавленная «Мониторинг внимания зрителей во время онлайн-рекламы», была написана четырьмя исследователями из Affectiva.

Методы и данные

Учитывая секретный характер этих систем, статья не проводит прямого сравнения своего подхода с конкурентами, но представляет свои выводы через исследования абляции. Она отклоняется от типичного формата литературы по компьютерному зрению, поэтому мы рассмотрим исследование так, как оно представлено.

Авторы указывают, что лишь немногие исследования специально рассматривали обнаружение внимания в контексте онлайн-рекламы. Например, AFFDEX SDK, предлагающий распознавание лиц в реальном времени, определяет внимание исключительно по положению головы, классифицируя участников как невнимательных, если угол наклона головы превышает определённый порог.

*Пример из AFFDEX SDK, системы Affectiva, которая полагается на положение головы как индикатор внимания.* Источник: https://www.youtube.com/watch?v=c2CWb5jHmbY

*Пример из AFFDEX SDK, системы Affectiva, которая полагается на положение головы как индикатор внимания.* Источник: https://www.youtube.com/watch?v=c2CWb5jHmbY

В сотрудничестве 2019 года, озаглавленном «Автоматическое измерение визуального внимания к видеоконтенту с использованием глубокого обучения», набор данных из примерно 28 000 участников был аннотирован для различных невнимательных поведений, и модель CNN-LSTM была обучена для обнаружения внимания по внешнему виду лица во времени.

*Из статьи 2019 года, пример, иллюстрирующий предсказанные состояния внимания зрителя, смотрящего видеоконтент.* Источник: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*Из статьи 2019 года, пример, иллюстрирующий предсказанные состояния внимания зрителя, смотрящего видеоконтент.* Источник: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

Однако эти более ранние усилия не учитывали факторы, специфичные для устройства, такие как использование настольного или мобильного устройства, а также размер экрана или размещение камеры. Система AFFDEX фокусировалась только на выявлении отклонения взгляда, в то время как работа 2019 года пыталась обнаружить более широкий набор поведений, но могла быть ограничена использованием одной неглубокой CNN.

Авторы отмечают, что большая часть существующих исследований не оптимизирована для тестирования рекламы, которое имеет уникальные потребности по сравнению с другими областями, такими как вождение или образование. Они разработали архитектуру для обнаружения внимания зрителей во время онлайн-рекламы, используя два коммерческих инструментария: AFFDEX 2.0 и SmartEye SDK.

*Примеры анализа лиц из AFFDEX 2.0.* Источник: https://arxiv.org/pdf/2202.12059

*Примеры анализа лиц из AFFDEX 2.0.* Источник: https://arxiv.org/pdf/2202.12059

Эти инструментарии извлекают низкоуровневые признаки, такие как выражения лица, положение головы и направление взгляда, которые затем обрабатываются для получения высокоуровневых индикаторов, таких как положение взгляда на экране, зевание и разговор. Система определяет четыре типа отвлечений: взгляд за пределы экрана, сонливость, разговор и оставленные без присмотра экраны, адаптируя анализ взгляда в зависимости от того, использует ли зритель настольное или мобильное устройство.

Наборы данных: Взгляд

Авторы использовали четыре набора данных для поддержки и оценки своей системы обнаружения внимания: три набора, посвящённые поведению взгляда, разговору и зеванию, и четвёртый, полученный из реальных сессий тестирования рекламы, содержащий различные типы отвлечений. Специальные наборы данных были созданы для каждой категории, взяты из проприетарного репозитория, содержащего миллионы записанных сессий участников, смотрящих рекламу в домашних или рабочих условиях, с их информированного согласия.

Для создания набора данных по взгляду участники следовали за движущейся точкой на экране, а затем отводили взгляд в четырёх направлениях. Этот процесс повторялся трижды для установления связи между захватом и охватом.

*Скриншоты, показывающие стимул видео взгляда на (a) настольных и (b) мобильных устройствах. Первый и третий кадры отображают инструкции следовать за движущейся точкой, в то время как второй и четвёртый побуждают участников отвести взгляд от экрана.*

*Скриншоты, показывающие стимул видео взгляда на (a) настольных и (b) мобильных устройствах. Первый и третий кадры отображают инструкции следовать за движущейся точкой, в то время как второй и четвёртый побуждают участников отвести взгляд от экрана.*

Сегменты с движущейся точкой были помечены как внимательные, а сегменты с отведённым взглядом — как невнимательные, создавая размеченный набор данных с примерами как положительных, так и отрицательных случаев. Каждое видео длилось около 160 секунд, с отдельными версиями для настольных и мобильных платформ. Всего было собрано 609 видео, разделённых на 158 обучающих образцов и 451 для тестирования.

Наборы данных: Разговор

В этом контексте разговор дольше одной секунды считается признаком невнимательности. Поскольку контролируемая среда не записывает звук, речь определяется по движению предполагаемых лицевых ориентиров. Авторы создали набор данных на основе визуального ввода, разделённый на две части: одна вручную размечена тремя аннотаторами, а другая автоматически размечена на основе типа сессии.

Наборы данных: Зевание

Существующие наборы данных по зеванию не были подходящими для сценариев тестирования рекламы, поэтому авторы использовали 735 видео из своей внутренней коллекции, сосредоточившись на сессиях, вероятно содержащих опущение челюсти дольше одной секунды. Каждое видео было вручную размечено тремя аннотаторами как показывающее активное или неактивное зевание, при этом только 2,6 процента кадров содержали активные зевки.

Наборы данных: Отвлечение

Набор данных по отвлечению был взят из репозитория тестирования рекламы авторов, где участники просматривали реальные рекламные объявления без назначенных задач. Всего было случайно выбрано 520 сессий и вручную размечено тремя аннотаторами как внимательные или невнимательные, при этом невнимательное поведение включало взгляд за пределы экрана, разговор, сонливость и оставленные без присмотра экраны.

Модели внимания

Предложенная модель внимания обрабатывает низкоуровневые визуальные признаки, такие как выражения лица, положение головы и направление взгляда, извлечённые с помощью AFFDEX 2.0 и SmartEye SDK. Они преобразуются в высокоуровневые индикаторы, при этом каждый отвлекающий фактор обрабатывается отдельным бинарным классификатором, обученным на своём собственном наборе данных для независимой оптимизации и оценки.

*Схема предложенной системы мониторинга.*

*Схема предложенной системы мониторинга.*

Модель взгляда определяет, смотрит ли зритель на экран или отводит взгляд, используя нормализованные координаты взгляда, с отдельной калибровкой для настольных и мобильных устройств. Линейная машина опорных векторов (SVM) используется для сглаживания быстрых изменений взгляда.

Для обнаружения разговора без звука система использует обрезанные области рта и 3D-CNN, обученную на сегментах видео с разговорами и без них. Зевание определяется с использованием обрезок полного лица, с 3D-CNN, обученной на вручную размеченных кадрах. Покинутость экрана идентифицируется по отсутствию лица или экстремальному положению головы, с предсказаниями, сделанными с помощью дерева решений.

Окончательный статус внимания определяется с использованием фиксированного правила: если любой модуль обнаруживает невнимательность, зритель помечается как невнимательный, с приоритетом на чувствительность и отдельной настройкой для контекстов настольных и мобильных устройств.

Тесты

Тесты следуют абляционному методу, при котором компоненты удаляются, и отмечается эффект на результат. Модель взгляда идентифицировала поведение вне экрана через три ключевых шага: нормализация необработанных оценок взгляда, тонкая настройка вывода и оценка размера экрана для настольных устройств.

*Различные категории воспринимаемой невнимательности, выявленные в исследовании.*

*Различные категории воспринимаемой невнимательности, выявленные в исследовании.*

Производительность снижалась при пропуске любого шага, при этом нормализация оказалась особенно ценной на настольных компьютерах. Исследование также оценило, как визуальные признаки предсказывали ориентацию камеры мобильного устройства, при этом комбинация местоположения лица, положения головы и взгляда достигла показателя 0,91.

*Результаты, показывающие производительность полной модели взгляда, наряду с версиями, в которых отдельные этапы обработки были удалены.*

*Результаты, показывающие производительность полной модели взгляда, наряду с версиями, в которых отдельные этапы обработки были удалены.*

Модель разговора, обученная на вертикальном расстоянии губ, достигла ROC-AUC 0,97 на вручную размеченном тестовом наборе и 0,96 на более крупном автоматически размеченном наборе данных. Модель зевания достигла ROC-AUC 96,6 процента, используя только соотношение сторон рта, улучшившись до 97,5 процента при комбинации с предсказаниями активных единиц от AFFDEX 2.0.

Модель оставленных без присмотра экранов классифицировала моменты как невнимательные, когда и AFFDEX 2.0, и SmartEye не обнаруживали лицо более одной секунды. Только 27 процентов активаций «без лица» были вызваны физическим уходом пользователей от экрана.

*Различные полученные причины, почему лицо не было найдено в определённых случаях.*

*Различные полученные причины, почему лицо не было найдено в определённых случаях.*

Авторы оценили, как добавление различных сигналов отвлечения влияло на общую производительность их модели внимания. Обнаружение внимания стабильно улучшалось по мере добавления большего числа типов отвлечений, при этом взгляд за пределы экрана обеспечивал наиболее сильную базовую линию.

*Эффект добавления различных сигналов отвлечения в архитектуру.*

*Эффект добавления различных сигналов отвлечения в архитектуру.*

Авторы сравнили свою модель с AFFDEX 1.0, предыдущей системой, использовавшейся в тестировании рекламы, и обнаружили, что даже текущая модель обнаружения взгляда на основе положения головы превзошла AFFDEX 1.0 на обоих типах устройств.

*Примеры выходных данных модели внимания на настольных и мобильных устройствах, где каждая строка представляет примеры истинных и ложных срабатываний для различных типов отвлечений.*

*Примеры выходных данных модели внимания на настольных и мобильных устройствах, где каждая строка представляет примеры истинных и ложных срабатываний для различных типов отвлечений.*

Заключение

Результаты представляют значительный прогресс по сравнению с предыдущими работами, давая представление о настойчивом стремлении индустрии понять внутреннее состояние зрителя. Хотя данные были собраны с согласия, методология указывает на будущие фреймворки, которые могут выйти за рамки структурированных настроек маркетинговых исследований. Этот вывод подтверждается секретным характером этого исследования, которое остаётся строго охраняемым в индустрии.

ИИ от Google теперь обрабатывает телефонные звонки за вас

Google расширил функцию искусственного интеллекта для всех пользователей США через Поиск, позволяя клиентам узнавать о ценах и наличии свободных мест в местных компаниях без телефонных разговоров. Эта

ИИ от Google теперь обрабатывает телефонные звонки за вас

Google расширил функцию искусственного интеллекта для всех пользователей США через Поиск, позволяя клиентам узнавать о ценах и наличии свободных мест в местных компаниях без телефонных разговоров. Эта

Трамп освобождает смартфоны, компьютеры и микросхемы от повышения тарифов

По данным агентства Bloomberg, администрация Трампа исключила смартфоны, компьютеры и различные электронные устройства из недавнего повышения тарифов, даже если они импортируются из Китая. Однако на э

Трамп освобождает смартфоны, компьютеры и микросхемы от повышения тарифов

По данным агентства Bloomberg, администрация Трампа исключила смартфоны, компьютеры и различные электронные устройства из недавнего повышения тарифов, даже если они импортируются из Китая. Однако на э

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

13 сентября 2025 г., 7:30:43 GMT+03:00

13 сентября 2025 г., 7:30:43 GMT+03:00

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

20 августа 2025 г., 8:01:18 GMT+03:00

20 августа 2025 г., 8:01:18 GMT+03:00

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

12 августа 2025 г., 20:01:00 GMT+03:00

12 августа 2025 г., 20:01:00 GMT+03:00

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

23 июля 2025 г., 8:31:54 GMT+03:00

23 июля 2025 г., 8:31:54 GMT+03:00

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

23 апреля 2025 г., 16:03:59 GMT+03:00

23 апреля 2025 г., 16:03:59 GMT+03:00

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

22 апреля 2025 г., 13:31:04 GMT+03:00

22 апреля 2025 г., 13:31:04 GMT+03:00

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0