廣告商的目標是“貓頭鷹和蜥蜴”

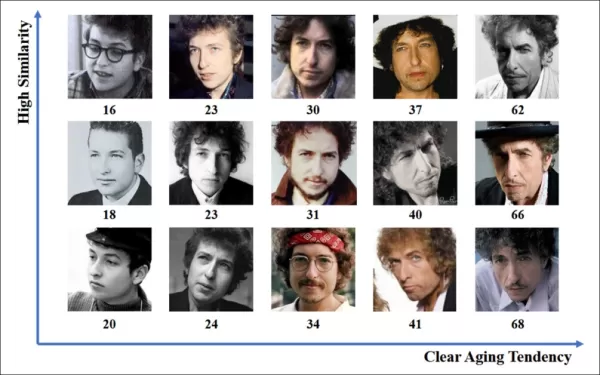

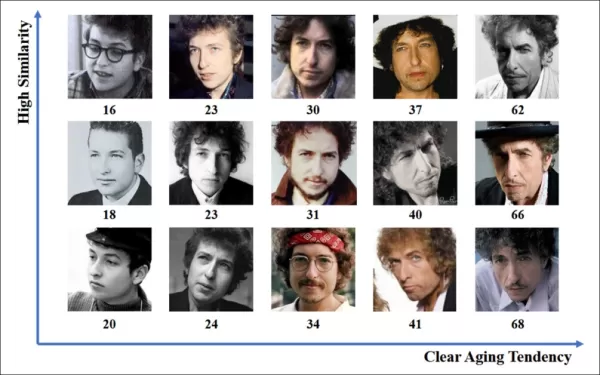

線上廣告產業在2023年投入驚人的7403億美元,顯而易見為何此領域的公司如此熱衷於推進電腦視覺研究。他們特別專注於臉部與眼部注視識別技術,其中年齡估計在人口統計分析中扮演關鍵角色。這對希望針對特定年齡群體的廣告商至關重要。

雖然該產業傾向於保密,但偶爾會透過公開的研究分享其較先進的專有工作片段。這些研究通常涉及同意參與AI驅動分析的參與者,旨在了解觀眾如何與廣告互動。

*在真實廣告情境中估計年齡對希望針對特定人口群體的廣告商具有吸引力。在此自動臉部年齡估計的實驗範例中,表演者Bob Dylan的年齡被追蹤多年。* 來源:https://arxiv.org/pdf/1906.03625

*在真實廣告情境中估計年齡對希望針對特定人口群體的廣告商具有吸引力。在此自動臉部年齡估計的實驗範例中,表演者Bob Dylan的年齡被追蹤多年。* 來源:https://arxiv.org/pdf/1906.03625

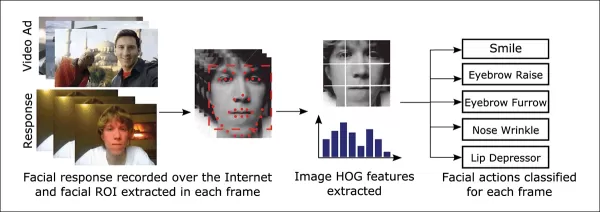

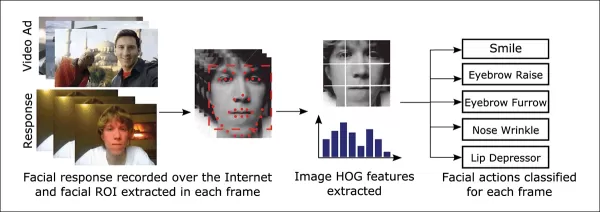

這些臉部估計系統中常用的工具之一是Dlib的Histogram of Oriented Gradients (HoG),有助於分析臉部特徵。

*Dlib的Histogram of Oriented Gradients (HoG)常被用於臉部估計系統。* 來源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Dlib的Histogram of Oriented Gradients (HoG)常被用於臉部估計系統。* 來源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

動物本能

在了解觀眾參與度方面,廣告產業特別關注識別誤判——系統誤解觀眾行為的情況——並建立明確的標準,以判斷何時觀眾未完全投入廣告。這在螢幕廣告中尤為重要,研究聚焦於兩種主要環境:桌面與行動裝置,每種環境需量身定制的追蹤解決方案。

廣告商常將觀眾的未投入行為分為兩類:「貓頭鷹行為」與「蜥蜴行為」。如果你轉頭離開廣告,那是「貓頭鷹行為」。如果頭部保持不動但眼睛離開螢幕,那是「蜥蜴行為」。這些行為對系統在受控條件下測試新廣告時的精確捕捉至關重要。

*廣告研究項目中受試者的「貓頭鷹」與「蜥蜴」行為範例。* 來源:https://arxiv.org/pdf/1508.04028

*廣告研究項目中受試者的「貓頭鷹」與「蜥蜴」行為範例。* 來源:https://arxiv.org/pdf/1508.04028

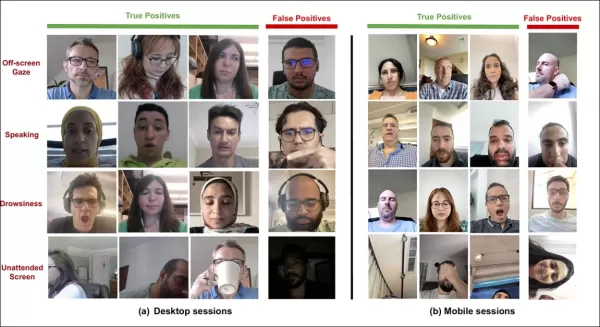

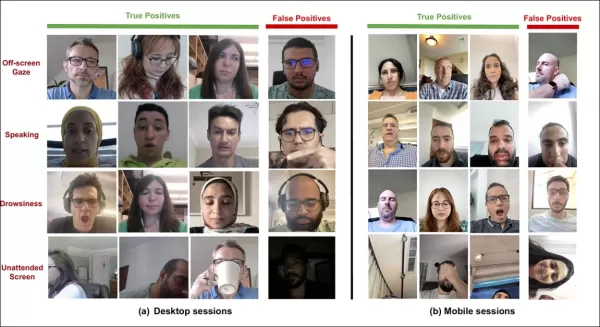

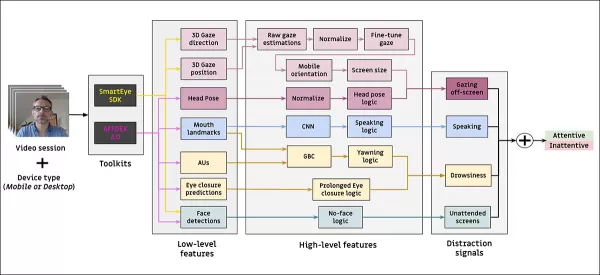

來自SmartEye收購Affectiva的近期論文正面解決這些問題。它提出了一個結合多個現有框架的架構,創建一個全面的特徵集,用於檢測不同條件與反應下的觀眾注意力。此系統能判斷觀眾是否感到無聊、投入或分心於廣告商希望他們專注的內容。

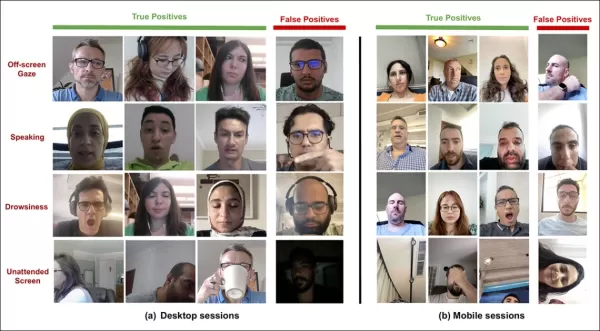

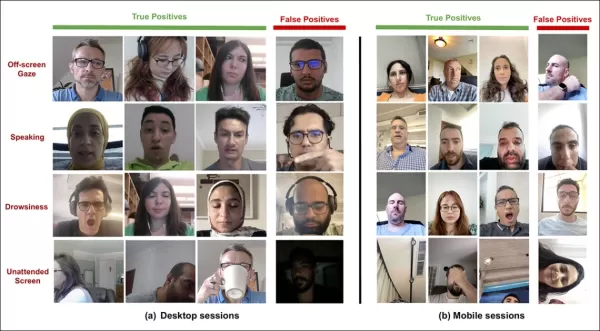

*新注意力系統檢測到的真陽性與假陽性範例,針對不同分心信號,分別展示於桌面與行動裝置。* 來源:https://arxiv.org/pdf/2504.06237

*新注意力系統檢測到的真陽性與假陽性範例,針對不同分心信號,分別展示於桌面與行動裝置。* 來源:https://arxiv.org/pdf/2504.06237

論文作者強調,關於線上廣告注意力監測的研究有限,先前研究常忽略設備類型、攝影機位置與螢幕尺寸等關鍵因素。他們提出的架構旨在解決這些差距,檢測包括貓頭鷹與蜥蜴行為、說話、嗜睡與無人看守螢幕等多種分心因素,同時整合設備特定特徵以提升準確性。

該論文題為「監測線上廣告中的觀眾注意力」,由Affectiva的四位研究者撰寫。

方法與數據

鑑於這些系統的保密性,論文未直接與競爭者比較其方法,而是透過消融研究呈現其發現。它偏離了電腦視覺文獻的典型格式,因此我們將按其呈現方式探索研究。

作者指出,僅有少數研究專門探討線上廣告情境中的注意力檢測。例如,AFFDEX SDK提供即時多臉識別,僅依據頭部姿勢推斷注意力,若參與者的頭部角度超過某閾值,則標記為不專注。

*來自AFFDEX SDK的範例,Affectiva系統以頭部姿勢作為注意力指標。* 來源:https://www.youtube.com/watch?v=c2CWb5jHmbY

*來自AFFDEX SDK的範例,Affectiva系統以頭部姿勢作為注意力指標。* 來源:https://www.youtube.com/watch?v=c2CWb5jHmbY

在2019年題為「使用深度學習自動測量視頻內容的視覺注意力」的合作中,約28,000名參與者的數據集被標註為各種不專注行為,並訓練了一個CNN-LSTM模型,以從臉部外觀隨時間檢測注意力。

*來自2019年論文的範例,展示觀眾觀看視頻內容時的預測注意力狀態。* 來源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*來自2019年論文的範例,展示觀眾觀看視頻內容時的預測注意力狀態。* 來源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

然而,這些早期努力未考慮設備特定因素,如參與者使用的是桌面還是行動裝置,也未考慮螢幕尺寸或攝影機位置。AFFDEX系統僅專注於識別視線轉移,而2019年的工作試圖檢測更廣泛的行為,但可能受限於使用單一淺層CNN。

作者指出,現有研究大多未針對廣告測試優化,廣告測試相較於駕駛或教育等其他領域有獨特需求。他們開發了一個用於檢測線上廣告中觀眾注意力的架構,利用兩個商業工具包:AFFDEX 2.0與SmartEye SDK。

*來自AFFDEX 2.0的臉部分析範例。* 來源:https://arxiv.org/pdf/2202.12059

*來自AFFDEX 2.0的臉部分析範例。* 來源:https://arxiv.org/pdf/2202.12059

這些工具包提取低層特徵,如臉部表情、頭部姿勢與視線方向,隨後處理為高層指標,如螢幕上的視線位置、打哈欠與說話。系統識別四類分心:螢幕外視線、嗜睡、說話與無人看守螢幕,根據觀眾使用桌面或行動裝置調整視線分析。

數據集:視線

作者使用了四個數據集來驅動與評估其注意力檢測系統:三個聚焦於視線行為、說話與打哈欠,第四個來自真實廣告測試場景,包含多種分心類型。每類別創建了自訂數據集,來源於擁有數百萬錄製場景的專有儲存庫,參與者在家中或工作場所觀看廣告,並已知情同意。

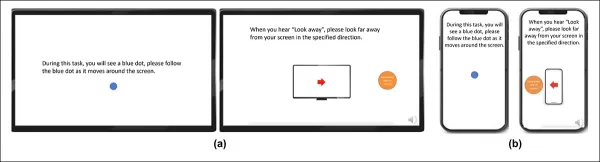

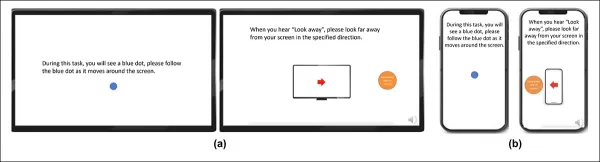

為構建視線數據集,參與者跟隨螢幕上的移動點,然後向四個方向看開。此過程重複三次,以建立捕捉與覆蓋的關係。

*螢幕截圖顯示(a)桌面與(b)行動裝置上的視線視頻刺激。第一與第三幀顯示跟隨移動點的指令,第二與第四幀提示參與者看向螢幕外。*

*螢幕截圖顯示(a)桌面與(b)行動裝置上的視線視頻刺激。第一與第三幀顯示跟隨移動點的指令,第二與第四幀提示參與者看向螢幕外。*

移動點片段標記為專注,螢幕外片段標記為不專注,創建包含正負例的標註數據集。每段視頻約160秒,桌面與行動平台各有不同版本。共收集609段視頻,分為158個訓練樣本與451個測試樣本。

數據集:說話

在此情境中,說話超過一秒被視為不專注的標誌。由於受控環境不錄音,語音透過觀察估計的臉部標誌運動推斷。作者基於視覺輸入創建數據集,分為兩部分:一部分由三名標註者手動標註,另一部分根據場景類型自動標註。

數據集:打哈欠

現有打哈欠數據集不適用於廣告測試場景,因此作者使用了內部收集的735段視頻,聚焦於可能包含超過一秒下巴張開的場景。每段視頻由三名標註者手動標註為活躍或非活躍打哈欠,僅2.6%的幀包含活躍打哈欠。

數據集:分心

分心數據集來自作者的廣告測試儲存庫,參與者觀看真實廣告,無指定任務。隨機選擇520個場景,由三名標註者手動標註為專注或不專注,不專注行為包括螢幕外視線、說話、嗜睡與無人看守螢幕。

注意力模型

提出的注意力模型處理低層視覺特徵,如臉部表情、頭部姿勢與視線方向,透過AFFDEX 2.0與SmartEye SDK提取。這些轉換為高層指標,每個分心因素由獨立優化與評估的二元分類器處理,訓練於各自的數據集。

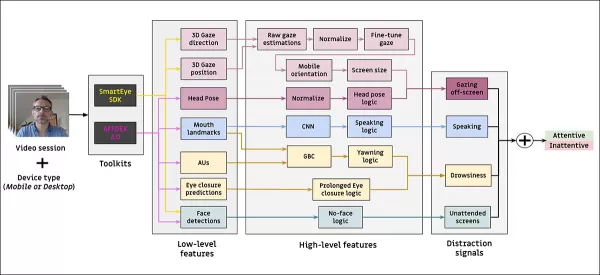

*提出的監測系統架構圖。*

*提出的監測系統架構圖。*

視線模型使用標準化視線坐標判斷觀眾是否注視或離開螢幕,桌面與行動裝置分別校準。線性支持向量機(SVM)用於平滑快速視線轉移。

在無音頻情況下檢測說話,系統使用裁剪的嘴部區域與3D-CNN,訓練於對話與非對話視頻片段。打哈欠使用全臉圖像裁剪檢測,3D-CNN訓練於手動標註幀。螢幕遺棄透過無臉或極端頭部姿勢識別,由決策樹預測。

最終注意力狀態使用固定規則確定:若任一模組檢測到不專注,觀眾標記為不專注,優先考慮敏感性,並分別為桌面與行動情境調校。

測試

測試採用消融方法,移除組件並記錄對結果的影響。視線模型透過三個關鍵步驟識別螢幕外行為:標準化原始視線估計、微調輸出與估計桌面設備的螢幕尺寸。

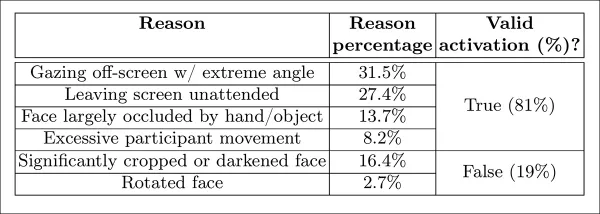

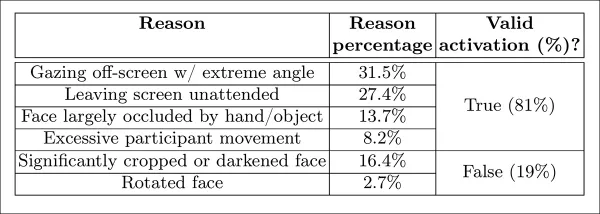

*研究中識別的不同感知不專注類別。*

*研究中識別的不同感知不專注類別。*

移除任一步驟均導致性能下降,標準化在桌面設備上尤為重要。研究還評估視覺特徵如何預測行動攝影機方向,結合臉部位置、頭部姿勢與眼部視線,達到0.91的得分。

*顯示完整視線模型性能的結果,以及移除個別處理步驟的版本。*

*顯示完整視線模型性能的結果,以及移除個別處理步驟的版本。*

說話模型基於垂直唇部距離訓練,在手動標註測試集上達到0.97的ROC-AUC,在較大的自動標註數據集上為0.96。打哈欠模型僅用嘴部縱橫比達到96.6%的ROC-AUC,結合AFFDEX 2.0的動作單元預測後提升至97.5%。

無人看守螢幕模型在AFFDEX 2.0與SmartEye超過一秒未檢測到臉部時,將時刻分類為不專注。僅27%的「無臉」啟動是由於用戶實際離開螢幕。

*在某些情況下未找到臉部的多種原因。*

*在某些情況下未找到臉部的多種原因。*

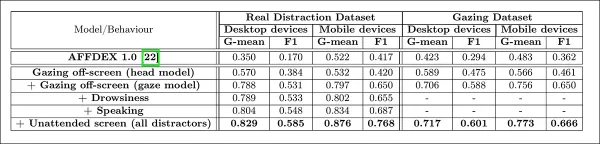

作者評估添加不同分心信號對注意力模型整體性能的影響。隨著更多分心類型加入,注意力檢測持續改善,螢幕外視線提供最強基準。

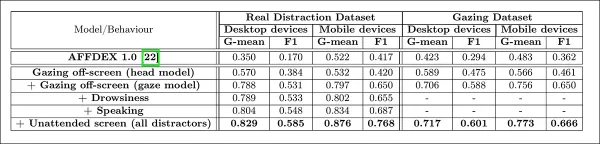

*將多種分心信號加入架構的影響。*

*將多種分心信號加入架構的影響。*

作者將其模型與AFFDEX 1.0(先前用於廣告測試的系統)比較,發現當前模型的頭部視線檢測在兩種設備類型上均超越AFFDEX 1.0。

*注意力模型在桌面與行動裝置上的樣本輸出,每行展示不同分心類型的真陽性與假陽性範例。*

*注意力模型在桌面與行動裝置上的樣本輸出,每行展示不同分心類型的真陽性與假陽性範例。*

結論

結果代表較先前工作的顯著進展,揭示了產業持續探索觀眾內在狀態的努力。雖然數據在知情同意下收集,但方法論指向未來可能超越結構化市場研究設定的框架。此結論因研究的保密性而得到強化,該研究仍由產業嚴密守護。

相關文章

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

AI 驅動的 YouTube 影片摘要器終極指南

在資訊豐富的數位環境中,AI 驅動的 YouTube 影片摘要器已成為有效率內容消費不可或缺的工具。本深入指南將探討如何使用尖端的 NLP 技術,特別是 Hugging Face 的 BART 模型結合 YouTube 的 Transcript API,建立精密的摘要工具。無論您是要開發生產力工具、增強可及性解決方案,或是創造教育資源,本指南都能提供您所需的一切,讓您能以文字與音訊輸出功能來實作專

評論 (24)

0/200

AI 驅動的 YouTube 影片摘要器終極指南

在資訊豐富的數位環境中,AI 驅動的 YouTube 影片摘要器已成為有效率內容消費不可或缺的工具。本深入指南將探討如何使用尖端的 NLP 技術,特別是 Hugging Face 的 BART 模型結合 YouTube 的 Transcript API,建立精密的摘要工具。無論您是要開發生產力工具、增強可及性解決方案,或是創造教育資源,本指南都能提供您所需的一切,讓您能以文字與音訊輸出功能來實作專

評論 (24)

0/200

![JustinAnderson]() JustinAnderson

JustinAnderson

2025-09-13 12:30:43

2025-09-13 12:30:43

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

![MatthewSanchez]() MatthewSanchez

MatthewSanchez

2025-08-20 13:01:18

2025-08-20 13:01:18

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

![StephenGonzalez]() StephenGonzalez

StephenGonzalez

2025-08-13 01:01:00

2025-08-13 01:01:00

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

2025-07-23 13:31:54

2025-07-23 13:31:54

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

![EricLewis]() EricLewis

EricLewis

2025-04-23 21:03:59

2025-04-23 21:03:59

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

![JoseLewis]() JoseLewis

JoseLewis

2025-04-22 18:31:04

2025-04-22 18:31:04

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0

線上廣告產業在2023年投入驚人的7403億美元,顯而易見為何此領域的公司如此熱衷於推進電腦視覺研究。他們特別專注於臉部與眼部注視識別技術,其中年齡估計在人口統計分析中扮演關鍵角色。這對希望針對特定年齡群體的廣告商至關重要。

雖然該產業傾向於保密,但偶爾會透過公開的研究分享其較先進的專有工作片段。這些研究通常涉及同意參與AI驅動分析的參與者,旨在了解觀眾如何與廣告互動。

*在真實廣告情境中估計年齡對希望針對特定人口群體的廣告商具有吸引力。在此自動臉部年齡估計的實驗範例中,表演者Bob Dylan的年齡被追蹤多年。* 來源:https://arxiv.org/pdf/1906.03625

*在真實廣告情境中估計年齡對希望針對特定人口群體的廣告商具有吸引力。在此自動臉部年齡估計的實驗範例中,表演者Bob Dylan的年齡被追蹤多年。* 來源:https://arxiv.org/pdf/1906.03625

這些臉部估計系統中常用的工具之一是Dlib的Histogram of Oriented Gradients (HoG),有助於分析臉部特徵。

*Dlib的Histogram of Oriented Gradients (HoG)常被用於臉部估計系統。* 來源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Dlib的Histogram of Oriented Gradients (HoG)常被用於臉部估計系統。* 來源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

動物本能

在了解觀眾參與度方面,廣告產業特別關注識別誤判——系統誤解觀眾行為的情況——並建立明確的標準,以判斷何時觀眾未完全投入廣告。這在螢幕廣告中尤為重要,研究聚焦於兩種主要環境:桌面與行動裝置,每種環境需量身定制的追蹤解決方案。

廣告商常將觀眾的未投入行為分為兩類:「貓頭鷹行為」與「蜥蜴行為」。如果你轉頭離開廣告,那是「貓頭鷹行為」。如果頭部保持不動但眼睛離開螢幕,那是「蜥蜴行為」。這些行為對系統在受控條件下測試新廣告時的精確捕捉至關重要。

*廣告研究項目中受試者的「貓頭鷹」與「蜥蜴」行為範例。* 來源:https://arxiv.org/pdf/1508.04028

*廣告研究項目中受試者的「貓頭鷹」與「蜥蜴」行為範例。* 來源:https://arxiv.org/pdf/1508.04028

來自SmartEye收購Affectiva的近期論文正面解決這些問題。它提出了一個結合多個現有框架的架構,創建一個全面的特徵集,用於檢測不同條件與反應下的觀眾注意力。此系統能判斷觀眾是否感到無聊、投入或分心於廣告商希望他們專注的內容。

*新注意力系統檢測到的真陽性與假陽性範例,針對不同分心信號,分別展示於桌面與行動裝置。* 來源:https://arxiv.org/pdf/2504.06237

*新注意力系統檢測到的真陽性與假陽性範例,針對不同分心信號,分別展示於桌面與行動裝置。* 來源:https://arxiv.org/pdf/2504.06237

論文作者強調,關於線上廣告注意力監測的研究有限,先前研究常忽略設備類型、攝影機位置與螢幕尺寸等關鍵因素。他們提出的架構旨在解決這些差距,檢測包括貓頭鷹與蜥蜴行為、說話、嗜睡與無人看守螢幕等多種分心因素,同時整合設備特定特徵以提升準確性。

該論文題為「監測線上廣告中的觀眾注意力」,由Affectiva的四位研究者撰寫。

方法與數據

鑑於這些系統的保密性,論文未直接與競爭者比較其方法,而是透過消融研究呈現其發現。它偏離了電腦視覺文獻的典型格式,因此我們將按其呈現方式探索研究。

作者指出,僅有少數研究專門探討線上廣告情境中的注意力檢測。例如,AFFDEX SDK提供即時多臉識別,僅依據頭部姿勢推斷注意力,若參與者的頭部角度超過某閾值,則標記為不專注。

*來自AFFDEX SDK的範例,Affectiva系統以頭部姿勢作為注意力指標。* 來源:https://www.youtube.com/watch?v=c2CWb5jHmbY

*來自AFFDEX SDK的範例,Affectiva系統以頭部姿勢作為注意力指標。* 來源:https://www.youtube.com/watch?v=c2CWb5jHmbY

在2019年題為「使用深度學習自動測量視頻內容的視覺注意力」的合作中,約28,000名參與者的數據集被標註為各種不專注行為,並訓練了一個CNN-LSTM模型,以從臉部外觀隨時間檢測注意力。

*來自2019年論文的範例,展示觀眾觀看視頻內容時的預測注意力狀態。* 來源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*來自2019年論文的範例,展示觀眾觀看視頻內容時的預測注意力狀態。* 來源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

然而,這些早期努力未考慮設備特定因素,如參與者使用的是桌面還是行動裝置,也未考慮螢幕尺寸或攝影機位置。AFFDEX系統僅專注於識別視線轉移,而2019年的工作試圖檢測更廣泛的行為,但可能受限於使用單一淺層CNN。

作者指出,現有研究大多未針對廣告測試優化,廣告測試相較於駕駛或教育等其他領域有獨特需求。他們開發了一個用於檢測線上廣告中觀眾注意力的架構,利用兩個商業工具包:AFFDEX 2.0與SmartEye SDK。

*來自AFFDEX 2.0的臉部分析範例。* 來源:https://arxiv.org/pdf/2202.12059

*來自AFFDEX 2.0的臉部分析範例。* 來源:https://arxiv.org/pdf/2202.12059

這些工具包提取低層特徵,如臉部表情、頭部姿勢與視線方向,隨後處理為高層指標,如螢幕上的視線位置、打哈欠與說話。系統識別四類分心:螢幕外視線、嗜睡、說話與無人看守螢幕,根據觀眾使用桌面或行動裝置調整視線分析。

數據集:視線

作者使用了四個數據集來驅動與評估其注意力檢測系統:三個聚焦於視線行為、說話與打哈欠,第四個來自真實廣告測試場景,包含多種分心類型。每類別創建了自訂數據集,來源於擁有數百萬錄製場景的專有儲存庫,參與者在家中或工作場所觀看廣告,並已知情同意。

為構建視線數據集,參與者跟隨螢幕上的移動點,然後向四個方向看開。此過程重複三次,以建立捕捉與覆蓋的關係。

*螢幕截圖顯示(a)桌面與(b)行動裝置上的視線視頻刺激。第一與第三幀顯示跟隨移動點的指令,第二與第四幀提示參與者看向螢幕外。*

*螢幕截圖顯示(a)桌面與(b)行動裝置上的視線視頻刺激。第一與第三幀顯示跟隨移動點的指令,第二與第四幀提示參與者看向螢幕外。*

移動點片段標記為專注,螢幕外片段標記為不專注,創建包含正負例的標註數據集。每段視頻約160秒,桌面與行動平台各有不同版本。共收集609段視頻,分為158個訓練樣本與451個測試樣本。

數據集:說話

在此情境中,說話超過一秒被視為不專注的標誌。由於受控環境不錄音,語音透過觀察估計的臉部標誌運動推斷。作者基於視覺輸入創建數據集,分為兩部分:一部分由三名標註者手動標註,另一部分根據場景類型自動標註。

數據集:打哈欠

現有打哈欠數據集不適用於廣告測試場景,因此作者使用了內部收集的735段視頻,聚焦於可能包含超過一秒下巴張開的場景。每段視頻由三名標註者手動標註為活躍或非活躍打哈欠,僅2.6%的幀包含活躍打哈欠。

數據集:分心

分心數據集來自作者的廣告測試儲存庫,參與者觀看真實廣告,無指定任務。隨機選擇520個場景,由三名標註者手動標註為專注或不專注,不專注行為包括螢幕外視線、說話、嗜睡與無人看守螢幕。

注意力模型

提出的注意力模型處理低層視覺特徵,如臉部表情、頭部姿勢與視線方向,透過AFFDEX 2.0與SmartEye SDK提取。這些轉換為高層指標,每個分心因素由獨立優化與評估的二元分類器處理,訓練於各自的數據集。

*提出的監測系統架構圖。*

*提出的監測系統架構圖。*

視線模型使用標準化視線坐標判斷觀眾是否注視或離開螢幕,桌面與行動裝置分別校準。線性支持向量機(SVM)用於平滑快速視線轉移。

在無音頻情況下檢測說話,系統使用裁剪的嘴部區域與3D-CNN,訓練於對話與非對話視頻片段。打哈欠使用全臉圖像裁剪檢測,3D-CNN訓練於手動標註幀。螢幕遺棄透過無臉或極端頭部姿勢識別,由決策樹預測。

最終注意力狀態使用固定規則確定:若任一模組檢測到不專注,觀眾標記為不專注,優先考慮敏感性,並分別為桌面與行動情境調校。

測試

測試採用消融方法,移除組件並記錄對結果的影響。視線模型透過三個關鍵步驟識別螢幕外行為:標準化原始視線估計、微調輸出與估計桌面設備的螢幕尺寸。

*研究中識別的不同感知不專注類別。*

*研究中識別的不同感知不專注類別。*

移除任一步驟均導致性能下降,標準化在桌面設備上尤為重要。研究還評估視覺特徵如何預測行動攝影機方向,結合臉部位置、頭部姿勢與眼部視線,達到0.91的得分。

*顯示完整視線模型性能的結果,以及移除個別處理步驟的版本。*

*顯示完整視線模型性能的結果,以及移除個別處理步驟的版本。*

說話模型基於垂直唇部距離訓練,在手動標註測試集上達到0.97的ROC-AUC,在較大的自動標註數據集上為0.96。打哈欠模型僅用嘴部縱橫比達到96.6%的ROC-AUC,結合AFFDEX 2.0的動作單元預測後提升至97.5%。

無人看守螢幕模型在AFFDEX 2.0與SmartEye超過一秒未檢測到臉部時,將時刻分類為不專注。僅27%的「無臉」啟動是由於用戶實際離開螢幕。

*在某些情況下未找到臉部的多種原因。*

*在某些情況下未找到臉部的多種原因。*

作者評估添加不同分心信號對注意力模型整體性能的影響。隨著更多分心類型加入,注意力檢測持續改善,螢幕外視線提供最強基準。

*將多種分心信號加入架構的影響。*

*將多種分心信號加入架構的影響。*

作者將其模型與AFFDEX 1.0(先前用於廣告測試的系統)比較,發現當前模型的頭部視線檢測在兩種設備類型上均超越AFFDEX 1.0。

*注意力模型在桌面與行動裝置上的樣本輸出,每行展示不同分心類型的真陽性與假陽性範例。*

*注意力模型在桌面與行動裝置上的樣本輸出,每行展示不同分心類型的真陽性與假陽性範例。*

結論

結果代表較先前工作的顯著進展,揭示了產業持續探索觀眾內在狀態的努力。雖然數據在知情同意下收集,但方法論指向未來可能超越結構化市場研究設定的框架。此結論因研究的保密性而得到強化,該研究仍由產業嚴密守護。

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

AI Powered Cover Letters:期刊投稿專家指南

在現今競爭激烈的學術出版環境中,撰寫一封有效的求職信對您的稿件能否被接受起著舉足輕重的作用。探索像 ChatGPT 之類的人工智能工具如何簡化這項重要任務,幫助您撰寫出精緻、專業的求職信,吸引期刊編輯的注意。我們的全面指南揭示了逐步優化您的投稿包並最大化出版成功率的策略。重點必要的研究準備:彙整所有稿件細節和期刊規格。AI 輔助撰稿:使用 ChatGPT 生成初始求職信模板。個人客製化:完善 AI

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

美國將因社交媒體法規制裁外國官員

美國站出來反對全球數位內容法規美國國務院本周針對歐洲的數位治理政策發出尖銳的外交譴責,顯示在網路平台控制權上的緊張關係正不斷升級。國務卿 Marco Rubio 公布了一項新的簽證限制政策,針對參與美國認為影響美國數位空間的過度審查的外國官員。新簽證限制說明根據週三公佈的政策,美國將拒絕被判定為正在執行影響美國受保護言論的海外內容規定的外國公民入境。Rubio 強調兩項主要的違法行為:

AI 驅動的 YouTube 影片摘要器終極指南

在資訊豐富的數位環境中,AI 驅動的 YouTube 影片摘要器已成為有效率內容消費不可或缺的工具。本深入指南將探討如何使用尖端的 NLP 技術,特別是 Hugging Face 的 BART 模型結合 YouTube 的 Transcript API,建立精密的摘要工具。無論您是要開發生產力工具、增強可及性解決方案,或是創造教育資源,本指南都能提供您所需的一切,讓您能以文字與音訊輸出功能來實作專

AI 驅動的 YouTube 影片摘要器終極指南

在資訊豐富的數位環境中,AI 驅動的 YouTube 影片摘要器已成為有效率內容消費不可或缺的工具。本深入指南將探討如何使用尖端的 NLP 技術,特別是 Hugging Face 的 BART 模型結合 YouTube 的 Transcript API,建立精密的摘要工具。無論您是要開發生產力工具、增強可及性解決方案,或是創造教育資源,本指南都能提供您所需的一切,讓您能以文字與音訊輸出功能來實作專

2025-09-13 12:30:43

2025-09-13 12:30:43

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

2025-08-20 13:01:18

2025-08-20 13:01:18

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

2025-08-13 01:01:00

2025-08-13 01:01:00

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

2025-07-23 13:31:54

2025-07-23 13:31:54

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

2025-04-23 21:03:59

2025-04-23 21:03:59

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

2025-04-22 18:31:04

2025-04-22 18:31:04

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0