広告主は、観客分析で「フクロウとトカゲ」をターゲットにします

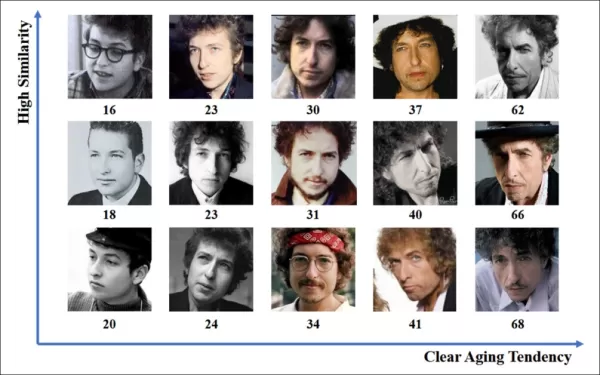

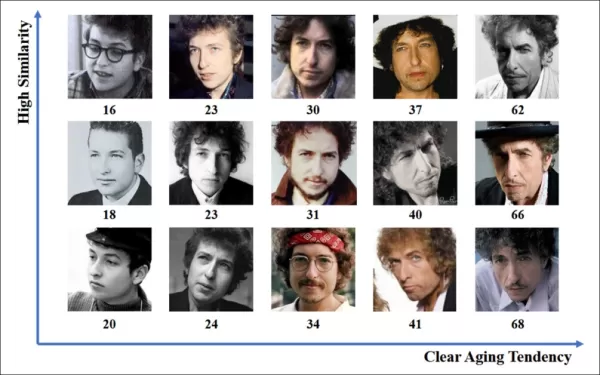

オンライン広告業界は、2023年にその取り組みに驚異的な7403億米ドルを投じ、なぜこの分野の企業がコンピュータービジョンの研究を進めることに熱心なのかを明確に示しています。彼らは特に顔や視線認識技術に焦点を当てており、年齢推定が人口統計分析において重要な役割を果たしています。これは、特定の年齢層をターゲットにする広告主にとって極めて重要です。

この業界は通常、情報を公開しない傾向にありますが、時折、公開された研究を通じてより高度な独自の成果を垣間見せることがあります。これらの研究は、AI駆動の分析に参加することに同意した参加者を対象に、視聴者が広告とどのように関わるかを理解することを目的としています。

*広告の文脈での年齢推定は、特定の人口層をターゲットにする広告主にとって関心の的です。この自動顔年齢推定の実験例では、パフォーマーのボブ・ディランの年齢が年月を追って追跡されています。* 出典: https://arxiv.org/pdf/1906.03625

*広告の文脈での年齢推定は、特定の人口層をターゲットにする広告主にとって関心の的です。この自動顔年齢推定の実験例では、パフォーマーのボブ・ディランの年齢が年月を追って追跡されています。* 出典: https://arxiv.org/pdf/1906.03625

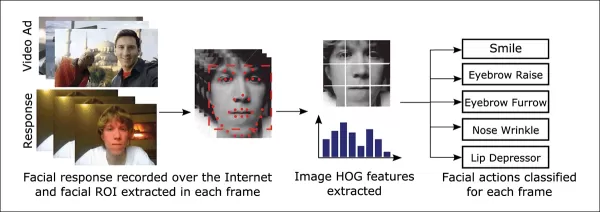

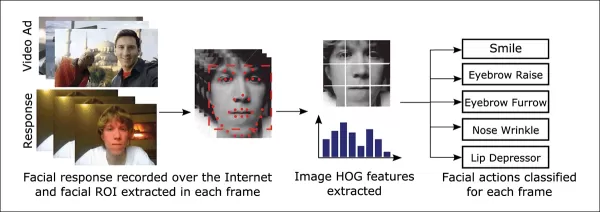

これらの顔推定システムでよく使用されるツールの一つが、DlibのHistogram of Oriented Gradients(HoG)で、顔の特徴を分析するのに役立ちます。

*DlibのHistogram of Oriented Gradients(HoG)は、顔推定システムでよく使用されます。* 出典: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*DlibのHistogram of Oriented Gradients(HoG)は、顔推定システムでよく使用されます。* 出典: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

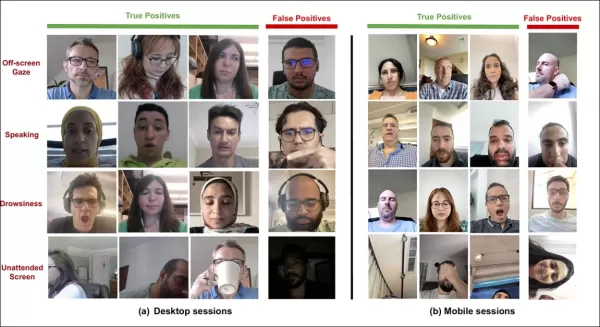

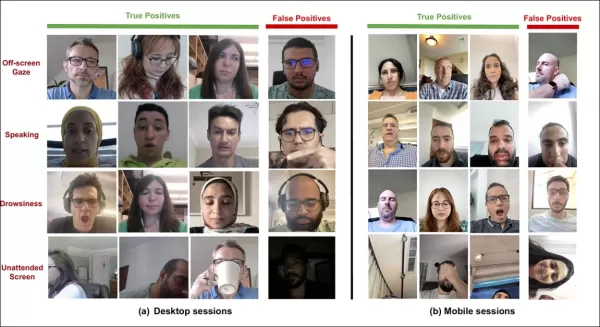

動物の本能

視聴者のエンゲージメントを理解する際、広告業界は特に偽陽性—システムが視聴者の行動を誤って解釈するケース—を特定し、視聴者が広告に完全に関与していない場合の明確な基準を確立することに興味を持っています。これは、画面ベースの広告で特に重要であり、研究は主にデスクトップとモバイルの2つの環境に焦点を当て、それぞれに特化した追跡ソリューションが必要です。

広告主は、視聴者の非エンゲージメント行動を「フクロウ行動」と「トカゲ行動」の2つに分類することがよくあります。広告から頭をそらすのが「フクロウ行動」、頭は動かず目だけが画面から離れるのが「トカゲ行動」です。これらの行動は、制御された条件下で新しい広告をテストする際に、システムが正確に捉えることが重要です。

*広告研究プロジェクトの被験者における「フクロウ」と「トカゲ」行動の例。* 出典: https://arxiv.org/pdf/1508.04028

*広告研究プロジェクトの被験者における「フクロウ」と「トカゲ」行動の例。* 出典: https://arxiv.org/pdf/1508.04028

SmartEyeのAffectiva買収による最近の論文は、これらの問題に直接取り組んでいます。さまざまな条件や反応で視聴者の注意を検出するための包括的な機能セットを作成するために、既存の複数のフレームワークを組み合わせたアーキテクチャを提案しています。このシステムは、視聴者が退屈しているか、関与しているか、広告主が注目してほしいコンテンツから気が散っているかを判断できます。

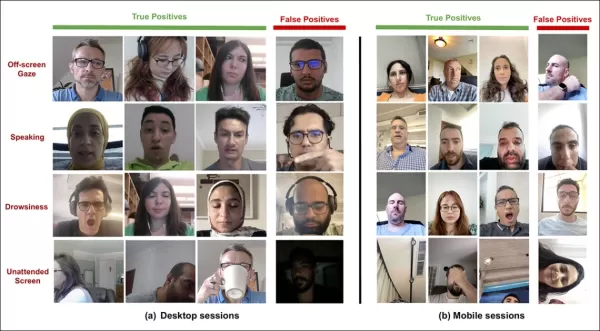

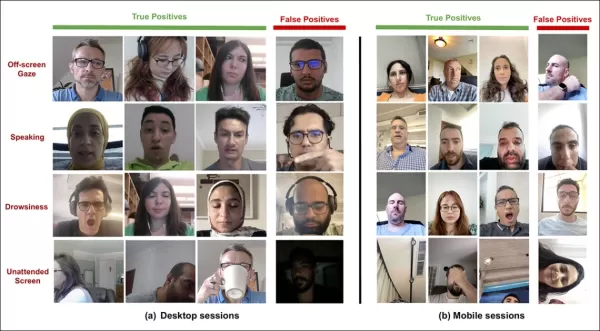

*新しい注意システムによって検出されたさまざまな気晴らし信号の真陽性と偽陽性の例を、デスクトップとモバイルデバイスで別々に示しています。* 出典: https://arxiv.org/pdf/2504.06237

*新しい注意システムによって検出されたさまざまな気晴らし信号の真陽性と偽陽性の例を、デスクトップとモバイルデバイスで別々に示しています。* 出典: https://arxiv.org/pdf/2504.06237

論文の著者は、オンライン広告中の注意監視に関する研究が限られていることを強調し、従来の研究ではデバイス種別、カメラ配置、画面サイズなどの重要な要因がしばしば見落とされていたと指摘しています。彼らの提案するアーキテクチャは、フクロウ行動やトカゲ行動、会話、眠気、無人画面などのさまざまな気晴らし要因を検出し、デバイス固有の機能を統合して精度を向上させることで、これらのギャップに対処することを目指しています。

この論文は、「オンライン広告中の視聴者注意の監視」と題され、Affectivaの4人の研究者によって執筆されました。

方法とデータ

これらのシステムの秘密主義的な性質を考慮すると、論文は競合他社との直接比較は行わず、アブレーション研究を通じてその結果を提示しています。コンピュータービジョン文献の典型的な形式から逸脱しているため、提示された研究をそのまま探ります。

著者は、オンライン広告の文脈で注意検出に特に対処した研究はわずかしかないと指摘しています。たとえば、AFFDEX SDKはリアルタイムの複数顔認識を提供し、頭の姿勢のみから注意を推測し、頭の角度が一定の閾値を超えると参加者を非注意とラベル付けします。

*AFFDEX SDKの例。Affectivaのシステムで、頭の姿勢を注意の指標として使用しています。* 出典: https://www.youtube.com/watch?v=c2CWb5jHmbY

*AFFDEX SDKの例。Affectivaのシステムで、頭の姿勢を注意の指標として使用しています。* 出典: https://www.youtube.com/watch?v=c2CWb5jHmbY

2019年のコラボレーション「ビデオコンテンツへの視覚的注意の自動測定」では、約28,000人の参加者のデータセットがさまざまな非注意行動について注釈付けされ、顔の外観から時間をかけて注意を検出するためにCNN-LSTMモデルが訓練されました。

*2019年の論文からの例。ビデオコンテンツを視聴する視聴者の予測された注意状態を示しています。* 出典: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*2019年の論文からの例。ビデオコンテンツを視聴する視聴者の予測された注意状態を示しています。* 出典: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

しかし、これらの初期の取り組みでは、参加者がデスクトップまたはモバイルデバイスを使用しているか、画面サイズやカメラ配置などのデバイス固有の要因は考慮されていませんでした。AFFDEXシステムは視線逸脱の特定に焦点を当て、2019年の研究はより広範な行動セットの検出を試みましたが、単一の浅いCNNの使用により制限されていた可能性があります。

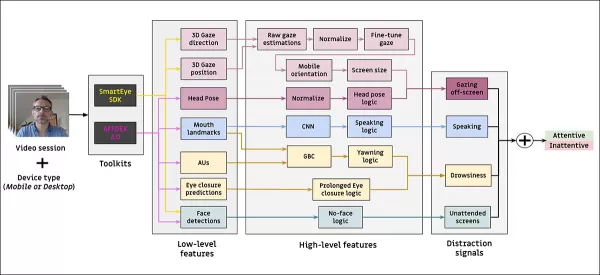

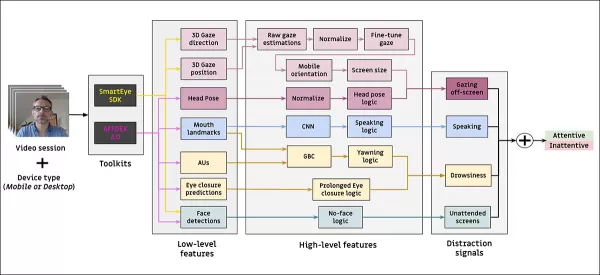

著者は、既存の研究の多くが広告テストに最適化されておらず、運転や教育などの他の領域とは異なる独自のニーズがあると指摘しています。彼らは、AFFDEX 2.0とSmartEye SDKの2つの商用ツールキットを活用して、オンライン広告中の視聴者注意を検出するアーキテクチャを開発しました。

*AFFDEX 2.0からの顔分析の例。* 出典: https://arxiv.org/pdf/2202.12059

*AFFDEX 2.0からの顔分析の例。* 出典: https://arxiv.org/pdf/2202.12059

これらのツールキットは、顔の表情、頭の姿勢、視線方向などの低レベル特徴を抽出し、それらを画面上の視線位置、あくび、会話などの高レベル指標に変換します。システムは、画面外の視線、眠気、会話、無人画面の4種類の気晴らしを特定し、視聴者がデスクトップまたはモバイルデバイスを使用しているかに基づいて視線分析を調整します。

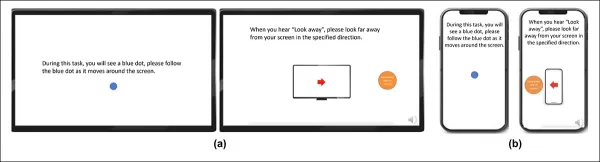

データセット:視線

著者は、視線行動、会話、あくびに焦点を当てた3つのデータセットと、さまざまな気晴らしタイプを含む実際の広告テストセッションから抽出した4つ目のデータセットを使用して、注意検出システムを強化し評価しました。各カテゴリ向けにカスタムデータセットが作成され、参加者が家庭や職場環境で広告を視聴する数百万の記録セッションを含む独自のリポジトリから取得され、インフォームドコンセントが得られています。

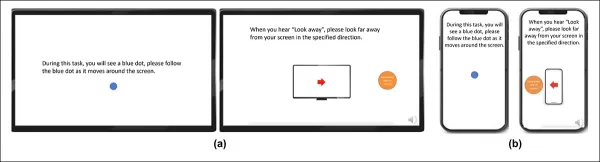

視線データセットを構築するために、参加者は画面上を移動する点に従い、その後4つの方向に視線を外しました。このプロセスは、キャプチャとカバレッジの関係を確立するために3回繰り返されました。

*(a) デスクトップおよび (b) モバイルデバイスでの視線ビデオ刺激のスクリーンショット。1番目と3番目のフレームは移動する点を追う指示を表示し、2番目と4番目のフレームは画面から視線を外すよう促します。*

*(a) デスクトップおよび (b) モバイルデバイスでの視線ビデオ刺激のスクリーンショット。1番目と3番目のフレームは移動する点を追う指示を表示し、2番目と4番目のフレームは画面から視線を外すよう促します。*

移動する点のセグメントは注意ありとラベル付けされ、画面外のセグメントは注意なしとラベル付けされ、肯定的および否定的な例のラベル付きデータセットが作成されました。各ビデオは約160秒続き、デスクトップとモバイルプラットフォーム用に別々のバージョンが用意されました。合計609本のビデオが収集され、158本がトレーニングサンプル、451本がテスト用に分割されました。

データセット:会話

この文脈では、1秒以上話すことは注意不足の兆候と見なされます。制御された環境では音声が記録されないため、推定された顔のランドマークの動きを観察して会話が推測されます。著者は、視覚入力に基づいてデータセットを作成し、3人の注釈者による手動ラベル付けと、セッションタイプに基づく自動ラベル付けの2つに分けました。

データセット:あくび

既存のあくびデータセットは広告テストシナリオに適していなかったため、著者は内部コレクションから735本のビデオを使用し、1秒以上続くあごの開きが含まれる可能性が高いセッションに焦点を当てました。各ビデオは、3人の注釈者によって活動的または非活動的なあくびとして手動でラベル付けされ、活動的あくびを含むフレームはわずか2.6%でした。

データセット:気晴らし

気晴らしデータセットは、著者の広告テストリポジトリから取得され、参加者が実際の広告をタスクなしで視聴しました。合計520セッションがランダムに選択され、3人の注釈者によって注意ありまたは注意なしとして手動でラベル付けされ、注意なしの行動には画面外の視線、会話、眠気、無人画面が含まれます。

注意モデル

提案された注意モデルは、AFFDEX 2.0とSmartEye SDKを通じて抽出された顔の表情、頭の姿勢、視線方向などの低レベル視覚特徴を処理します。これらは高レベル指標に変換され、各気晴らし要因は独立した最適化と評価のために独自のデータセットで訓練された個別のバイナリ分類器によって処理されます。

*提案された監視システムのスキーマ。*

*提案された監視システムのスキーマ。*

視線モデルは、視聴者が画面を見ているか離れているかを正規化された視線座標を使用して判断し、デスクトップとモバイルデバイスで個別に調整されます。線形サポートベクターマシン(SVM)が急速な視線移動を滑らかにするために使用されます。

音声なしで会話を検出するために、システムは口の領域を切り取り、会話および非会話のビデオセグメントで訓練された3D-CNNを使用します。あくびは、フルフェイスの画像切り取りを使用し、手動でラベル付けされたフレームで訓練された3D-CNNで検出されます。画面放棄は、顔の不在または極端な頭の姿勢を通じて特定され、意思決定ツリーによって予測されます。

最終的な注意状態は、任意のモジュールが注意不足を検出した場合に視聴者を注意不足としてマークする固定ルールを使用して決定され、感度を優先し、デスクトップとモバイルのコンテキストで個別に調整されます。

テスト

テストはアブレーション方式に従い、コンポーネントを削除してその結果への影響を記録します。視線モデルは、3つの主要なステップを通じて画面外の行動を特定しました:生の視線推定の正規化、出力の微調整、デスクトップデバイスの画面サイズの推定。

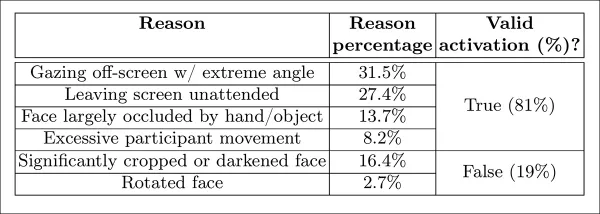

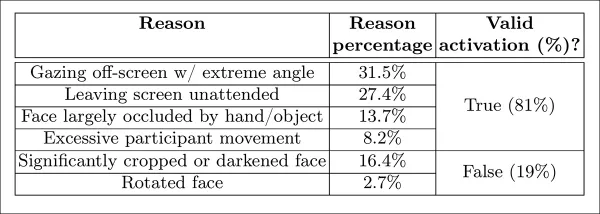

*研究で特定された知覚された注意不足のさまざまなカテゴリ。*

*研究で特定された知覚された注意不足のさまざまなカテゴリ。*

いずれかのステップを省略するとパフォーマンスが低下し、特にデスクトップでの正規化が特に価値があることが証明されました。研究はまた、顔の位置、頭の姿勢、視線を組み合わせた視覚的特徴がモバイルカメラの向きを予測する方法を評価し、0.91のスコアに達しました。

*完全な視線モデルのパフォーマンスを示す結果と、個々の処理ステップを削除したバージョンの結果。*

*完全な視線モデルのパフォーマンスを示す結果と、個々の処理ステップを削除したバージョンの結果。*

垂直唇距離で訓練された会話モデルは、手動でラベル付けされたテストセットでROC-AUC 0.97、より大きな自動ラベル付けデータセットで0.96を達成しました。あくびモデルは、口のアスペクト比のみでROC-AUC 96.6%に達し、AFFDEX 2.0のアクションユニット予測と組み合わせると97.5%に改善されました。

無人画面モデルは、AFFDEX 2.0とSmartEyeが1秒以上顔を検出できなかった場合に瞬間を注意不足として分類しました。「顔なし」のアクティベーションの27%のみがユーザーが物理的に画面を離れたことによるものでした。

*特定のケースで顔が見つからなかった多様な取得理由。*

*特定のケースで顔が見つからなかった多様な取得理由。*

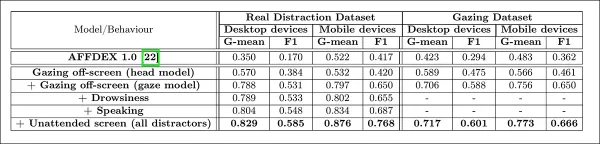

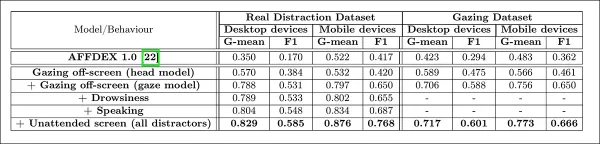

著者は、さまざまな気晴らし信号を追加することで注意モデルの全体的なパフォーマンスにどのように影響するかを評価しました。注意検出は、気晴らしタイプを追加するにつれて一貫して改善し、画面外の視線が最も強力なベースラインを提供しました。

*アーキテクチャに多様な気晴らし信号を追加する効果。*

*アーキテクチャに多様な気晴らし信号を追加する効果。*

著者は、彼らのモデルを広告テストで使用されていた以前のシステムAFFDEX 1.0と比較し、現在のモデルの頭部ベースの視線検出が両方のデバイス種別でAFFDEX 1.0を上回ることを発見しました。

*デスクトップおよびモバイルデバイスでの注意モデルのサンプル出力。各行はさまざまな気晴らしタイプの真陽性と偽陽性の例を示しています。*

*デスクトップおよびモバイルデバイスでの注意モデルのサンプル出力。各行はさまざまな気晴らしタイプの真陽性と偽陽性の例を示しています。*

結論

結果は、視聴者の内部状態を理解しようとする業界の持続的な推進力を垣間見せ、従来の研究に対する有意な進歩を表しています。データは同意を得て収集されましたが、この方法論は、構造化された市場調査の設定を超えて拡張される可能性のある将来のフレームワークを示しています。この結論は、業界によって厳重に守られているこの研究の秘密主義的な性質によって強化されます。

関連記事

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

AIを駆使したカバーレター:ジャーナル投稿のためのエキスパートガイド

競争の激しい今日の学術出版環境では、効果的なカバーレターを作成することが、原稿の採否を決定的に左右します。ChatGPTのようなAIを搭載したツールが、この重要なタスクをいかに効率化し、ジャーナル編集者の目を引く洗練されたプロフェッショナルなレターを作成できるかをご覧ください。ChatGPTの包括的なガイドでは、投稿パッケージを最適化し、出版を最大限に成功させるための戦略をステップごとに紹介してい

AIを駆使したカバーレター:ジャーナル投稿のためのエキスパートガイド

競争の激しい今日の学術出版環境では、効果的なカバーレターを作成することが、原稿の採否を決定的に左右します。ChatGPTのようなAIを搭載したツールが、この重要なタスクをいかに効率化し、ジャーナル編集者の目を引く洗練されたプロフェッショナルなレターを作成できるかをご覧ください。ChatGPTの包括的なガイドでは、投稿パッケージを最適化し、出版を最大限に成功させるための戦略をステップごとに紹介してい

米国、ソーシャルメディア規制をめぐり外国公務員を制裁へ

米国、世界のデジタルコンテンツ規制に対抗国務省は今週、ヨーロッパのデジタル・ガバナンス政策を標的に鋭い外交的非難を行い、オンライン・プラットフォームの支配をめぐる緊張の高まりを示唆した。マルコ・ルビオ長官は、米国が米国のデジタル空間に影響を及ぼす検閲の行き過ぎとみなすものに関与する外国政府関係者を対象とした、新しいビザ制限政策を発表した。新しいビザ制限の説明水曜日に発表された政策では、米

コメント (24)

0/200

米国、ソーシャルメディア規制をめぐり外国公務員を制裁へ

米国、世界のデジタルコンテンツ規制に対抗国務省は今週、ヨーロッパのデジタル・ガバナンス政策を標的に鋭い外交的非難を行い、オンライン・プラットフォームの支配をめぐる緊張の高まりを示唆した。マルコ・ルビオ長官は、米国が米国のデジタル空間に影響を及ぼす検閲の行き過ぎとみなすものに関与する外国政府関係者を対象とした、新しいビザ制限政策を発表した。新しいビザ制限の説明水曜日に発表された政策では、米

コメント (24)

0/200

![JustinAnderson]() JustinAnderson

JustinAnderson

2025年9月13日 13:30:43 JST

2025年9月13日 13:30:43 JST

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

![MatthewSanchez]() MatthewSanchez

MatthewSanchez

2025年8月20日 14:01:18 JST

2025年8月20日 14:01:18 JST

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

![StephenGonzalez]() StephenGonzalez

StephenGonzalez

2025年8月13日 2:01:00 JST

2025年8月13日 2:01:00 JST

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

2025年7月23日 14:31:54 JST

2025年7月23日 14:31:54 JST

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

![EricLewis]() EricLewis

EricLewis

2025年4月23日 22:03:59 JST

2025年4月23日 22:03:59 JST

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

![JoseLewis]() JoseLewis

JoseLewis

2025年4月22日 19:31:04 JST

2025年4月22日 19:31:04 JST

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0

オンライン広告業界は、2023年にその取り組みに驚異的な7403億米ドルを投じ、なぜこの分野の企業がコンピュータービジョンの研究を進めることに熱心なのかを明確に示しています。彼らは特に顔や視線認識技術に焦点を当てており、年齢推定が人口統計分析において重要な役割を果たしています。これは、特定の年齢層をターゲットにする広告主にとって極めて重要です。

この業界は通常、情報を公開しない傾向にありますが、時折、公開された研究を通じてより高度な独自の成果を垣間見せることがあります。これらの研究は、AI駆動の分析に参加することに同意した参加者を対象に、視聴者が広告とどのように関わるかを理解することを目的としています。

*広告の文脈での年齢推定は、特定の人口層をターゲットにする広告主にとって関心の的です。この自動顔年齢推定の実験例では、パフォーマーのボブ・ディランの年齢が年月を追って追跡されています。* 出典: https://arxiv.org/pdf/1906.03625

*広告の文脈での年齢推定は、特定の人口層をターゲットにする広告主にとって関心の的です。この自動顔年齢推定の実験例では、パフォーマーのボブ・ディランの年齢が年月を追って追跡されています。* 出典: https://arxiv.org/pdf/1906.03625

これらの顔推定システムでよく使用されるツールの一つが、DlibのHistogram of Oriented Gradients(HoG)で、顔の特徴を分析するのに役立ちます。

*DlibのHistogram of Oriented Gradients(HoG)は、顔推定システムでよく使用されます。* 出典: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*DlibのHistogram of Oriented Gradients(HoG)は、顔推定システムでよく使用されます。* 出典: https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

動物の本能

視聴者のエンゲージメントを理解する際、広告業界は特に偽陽性—システムが視聴者の行動を誤って解釈するケース—を特定し、視聴者が広告に完全に関与していない場合の明確な基準を確立することに興味を持っています。これは、画面ベースの広告で特に重要であり、研究は主にデスクトップとモバイルの2つの環境に焦点を当て、それぞれに特化した追跡ソリューションが必要です。

広告主は、視聴者の非エンゲージメント行動を「フクロウ行動」と「トカゲ行動」の2つに分類することがよくあります。広告から頭をそらすのが「フクロウ行動」、頭は動かず目だけが画面から離れるのが「トカゲ行動」です。これらの行動は、制御された条件下で新しい広告をテストする際に、システムが正確に捉えることが重要です。

*広告研究プロジェクトの被験者における「フクロウ」と「トカゲ」行動の例。* 出典: https://arxiv.org/pdf/1508.04028

*広告研究プロジェクトの被験者における「フクロウ」と「トカゲ」行動の例。* 出典: https://arxiv.org/pdf/1508.04028

SmartEyeのAffectiva買収による最近の論文は、これらの問題に直接取り組んでいます。さまざまな条件や反応で視聴者の注意を検出するための包括的な機能セットを作成するために、既存の複数のフレームワークを組み合わせたアーキテクチャを提案しています。このシステムは、視聴者が退屈しているか、関与しているか、広告主が注目してほしいコンテンツから気が散っているかを判断できます。

*新しい注意システムによって検出されたさまざまな気晴らし信号の真陽性と偽陽性の例を、デスクトップとモバイルデバイスで別々に示しています。* 出典: https://arxiv.org/pdf/2504.06237

*新しい注意システムによって検出されたさまざまな気晴らし信号の真陽性と偽陽性の例を、デスクトップとモバイルデバイスで別々に示しています。* 出典: https://arxiv.org/pdf/2504.06237

論文の著者は、オンライン広告中の注意監視に関する研究が限られていることを強調し、従来の研究ではデバイス種別、カメラ配置、画面サイズなどの重要な要因がしばしば見落とされていたと指摘しています。彼らの提案するアーキテクチャは、フクロウ行動やトカゲ行動、会話、眠気、無人画面などのさまざまな気晴らし要因を検出し、デバイス固有の機能を統合して精度を向上させることで、これらのギャップに対処することを目指しています。

この論文は、「オンライン広告中の視聴者注意の監視」と題され、Affectivaの4人の研究者によって執筆されました。

方法とデータ

これらのシステムの秘密主義的な性質を考慮すると、論文は競合他社との直接比較は行わず、アブレーション研究を通じてその結果を提示しています。コンピュータービジョン文献の典型的な形式から逸脱しているため、提示された研究をそのまま探ります。

著者は、オンライン広告の文脈で注意検出に特に対処した研究はわずかしかないと指摘しています。たとえば、AFFDEX SDKはリアルタイムの複数顔認識を提供し、頭の姿勢のみから注意を推測し、頭の角度が一定の閾値を超えると参加者を非注意とラベル付けします。

*AFFDEX SDKの例。Affectivaのシステムで、頭の姿勢を注意の指標として使用しています。* 出典: https://www.youtube.com/watch?v=c2CWb5jHmbY

*AFFDEX SDKの例。Affectivaのシステムで、頭の姿勢を注意の指標として使用しています。* 出典: https://www.youtube.com/watch?v=c2CWb5jHmbY

2019年のコラボレーション「ビデオコンテンツへの視覚的注意の自動測定」では、約28,000人の参加者のデータセットがさまざまな非注意行動について注釈付けされ、顔の外観から時間をかけて注意を検出するためにCNN-LSTMモデルが訓練されました。

*2019年の論文からの例。ビデオコンテンツを視聴する視聴者の予測された注意状態を示しています。* 出典: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*2019年の論文からの例。ビデオコンテンツを視聴する視聴者の予測された注意状態を示しています。* 出典: https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

しかし、これらの初期の取り組みでは、参加者がデスクトップまたはモバイルデバイスを使用しているか、画面サイズやカメラ配置などのデバイス固有の要因は考慮されていませんでした。AFFDEXシステムは視線逸脱の特定に焦点を当て、2019年の研究はより広範な行動セットの検出を試みましたが、単一の浅いCNNの使用により制限されていた可能性があります。

著者は、既存の研究の多くが広告テストに最適化されておらず、運転や教育などの他の領域とは異なる独自のニーズがあると指摘しています。彼らは、AFFDEX 2.0とSmartEye SDKの2つの商用ツールキットを活用して、オンライン広告中の視聴者注意を検出するアーキテクチャを開発しました。

*AFFDEX 2.0からの顔分析の例。* 出典: https://arxiv.org/pdf/2202.12059

*AFFDEX 2.0からの顔分析の例。* 出典: https://arxiv.org/pdf/2202.12059

これらのツールキットは、顔の表情、頭の姿勢、視線方向などの低レベル特徴を抽出し、それらを画面上の視線位置、あくび、会話などの高レベル指標に変換します。システムは、画面外の視線、眠気、会話、無人画面の4種類の気晴らしを特定し、視聴者がデスクトップまたはモバイルデバイスを使用しているかに基づいて視線分析を調整します。

データセット:視線

著者は、視線行動、会話、あくびに焦点を当てた3つのデータセットと、さまざまな気晴らしタイプを含む実際の広告テストセッションから抽出した4つ目のデータセットを使用して、注意検出システムを強化し評価しました。各カテゴリ向けにカスタムデータセットが作成され、参加者が家庭や職場環境で広告を視聴する数百万の記録セッションを含む独自のリポジトリから取得され、インフォームドコンセントが得られています。

視線データセットを構築するために、参加者は画面上を移動する点に従い、その後4つの方向に視線を外しました。このプロセスは、キャプチャとカバレッジの関係を確立するために3回繰り返されました。

*(a) デスクトップおよび (b) モバイルデバイスでの視線ビデオ刺激のスクリーンショット。1番目と3番目のフレームは移動する点を追う指示を表示し、2番目と4番目のフレームは画面から視線を外すよう促します。*

*(a) デスクトップおよび (b) モバイルデバイスでの視線ビデオ刺激のスクリーンショット。1番目と3番目のフレームは移動する点を追う指示を表示し、2番目と4番目のフレームは画面から視線を外すよう促します。*

移動する点のセグメントは注意ありとラベル付けされ、画面外のセグメントは注意なしとラベル付けされ、肯定的および否定的な例のラベル付きデータセットが作成されました。各ビデオは約160秒続き、デスクトップとモバイルプラットフォーム用に別々のバージョンが用意されました。合計609本のビデオが収集され、158本がトレーニングサンプル、451本がテスト用に分割されました。

データセット:会話

この文脈では、1秒以上話すことは注意不足の兆候と見なされます。制御された環境では音声が記録されないため、推定された顔のランドマークの動きを観察して会話が推測されます。著者は、視覚入力に基づいてデータセットを作成し、3人の注釈者による手動ラベル付けと、セッションタイプに基づく自動ラベル付けの2つに分けました。

データセット:あくび

既存のあくびデータセットは広告テストシナリオに適していなかったため、著者は内部コレクションから735本のビデオを使用し、1秒以上続くあごの開きが含まれる可能性が高いセッションに焦点を当てました。各ビデオは、3人の注釈者によって活動的または非活動的なあくびとして手動でラベル付けされ、活動的あくびを含むフレームはわずか2.6%でした。

データセット:気晴らし

気晴らしデータセットは、著者の広告テストリポジトリから取得され、参加者が実際の広告をタスクなしで視聴しました。合計520セッションがランダムに選択され、3人の注釈者によって注意ありまたは注意なしとして手動でラベル付けされ、注意なしの行動には画面外の視線、会話、眠気、無人画面が含まれます。

注意モデル

提案された注意モデルは、AFFDEX 2.0とSmartEye SDKを通じて抽出された顔の表情、頭の姿勢、視線方向などの低レベル視覚特徴を処理します。これらは高レベル指標に変換され、各気晴らし要因は独立した最適化と評価のために独自のデータセットで訓練された個別のバイナリ分類器によって処理されます。

*提案された監視システムのスキーマ。*

*提案された監視システムのスキーマ。*

視線モデルは、視聴者が画面を見ているか離れているかを正規化された視線座標を使用して判断し、デスクトップとモバイルデバイスで個別に調整されます。線形サポートベクターマシン(SVM)が急速な視線移動を滑らかにするために使用されます。

音声なしで会話を検出するために、システムは口の領域を切り取り、会話および非会話のビデオセグメントで訓練された3D-CNNを使用します。あくびは、フルフェイスの画像切り取りを使用し、手動でラベル付けされたフレームで訓練された3D-CNNで検出されます。画面放棄は、顔の不在または極端な頭の姿勢を通じて特定され、意思決定ツリーによって予測されます。

最終的な注意状態は、任意のモジュールが注意不足を検出した場合に視聴者を注意不足としてマークする固定ルールを使用して決定され、感度を優先し、デスクトップとモバイルのコンテキストで個別に調整されます。

テスト

テストはアブレーション方式に従い、コンポーネントを削除してその結果への影響を記録します。視線モデルは、3つの主要なステップを通じて画面外の行動を特定しました:生の視線推定の正規化、出力の微調整、デスクトップデバイスの画面サイズの推定。

*研究で特定された知覚された注意不足のさまざまなカテゴリ。*

*研究で特定された知覚された注意不足のさまざまなカテゴリ。*

いずれかのステップを省略するとパフォーマンスが低下し、特にデスクトップでの正規化が特に価値があることが証明されました。研究はまた、顔の位置、頭の姿勢、視線を組み合わせた視覚的特徴がモバイルカメラの向きを予測する方法を評価し、0.91のスコアに達しました。

*完全な視線モデルのパフォーマンスを示す結果と、個々の処理ステップを削除したバージョンの結果。*

*完全な視線モデルのパフォーマンスを示す結果と、個々の処理ステップを削除したバージョンの結果。*

垂直唇距離で訓練された会話モデルは、手動でラベル付けされたテストセットでROC-AUC 0.97、より大きな自動ラベル付けデータセットで0.96を達成しました。あくびモデルは、口のアスペクト比のみでROC-AUC 96.6%に達し、AFFDEX 2.0のアクションユニット予測と組み合わせると97.5%に改善されました。

無人画面モデルは、AFFDEX 2.0とSmartEyeが1秒以上顔を検出できなかった場合に瞬間を注意不足として分類しました。「顔なし」のアクティベーションの27%のみがユーザーが物理的に画面を離れたことによるものでした。

*特定のケースで顔が見つからなかった多様な取得理由。*

*特定のケースで顔が見つからなかった多様な取得理由。*

著者は、さまざまな気晴らし信号を追加することで注意モデルの全体的なパフォーマンスにどのように影響するかを評価しました。注意検出は、気晴らしタイプを追加するにつれて一貫して改善し、画面外の視線が最も強力なベースラインを提供しました。

*アーキテクチャに多様な気晴らし信号を追加する効果。*

*アーキテクチャに多様な気晴らし信号を追加する効果。*

著者は、彼らのモデルを広告テストで使用されていた以前のシステムAFFDEX 1.0と比較し、現在のモデルの頭部ベースの視線検出が両方のデバイス種別でAFFDEX 1.0を上回ることを発見しました。

*デスクトップおよびモバイルデバイスでの注意モデルのサンプル出力。各行はさまざまな気晴らしタイプの真陽性と偽陽性の例を示しています。*

*デスクトップおよびモバイルデバイスでの注意モデルのサンプル出力。各行はさまざまな気晴らしタイプの真陽性と偽陽性の例を示しています。*

結論

結果は、視聴者の内部状態を理解しようとする業界の持続的な推進力を垣間見せ、従来の研究に対する有意な進歩を表しています。データは同意を得て収集されましたが、この方法論は、構造化された市場調査の設定を超えて拡張される可能性のある将来のフレームワークを示しています。この結論は、業界によって厳重に守られているこの研究の秘密主義的な性質によって強化されます。

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

マスターエメラルド 海賊ヌズロッケ究極のサバイバル&ストラテジーガイド

Emerald Kaizoは、これまでに考案されたポケモンのROMハックの中で最も手強いものの1つである。Nuzlockeの実行を試みることは飛躍的に挑戦を増加させるが、綿密な計画と戦略的な実行によって勝利は達成可能である。この決定版ガイドでは、ハードコア・ヌズロッケのルールでエメラルドのかいぞくを制覇するために必要なツール、実戦で試された戦術、綿密なAI分析が紹介されている。ポケモンマスターの究

AIを駆使したカバーレター:ジャーナル投稿のためのエキスパートガイド

競争の激しい今日の学術出版環境では、効果的なカバーレターを作成することが、原稿の採否を決定的に左右します。ChatGPTのようなAIを搭載したツールが、この重要なタスクをいかに効率化し、ジャーナル編集者の目を引く洗練されたプロフェッショナルなレターを作成できるかをご覧ください。ChatGPTの包括的なガイドでは、投稿パッケージを最適化し、出版を最大限に成功させるための戦略をステップごとに紹介してい

AIを駆使したカバーレター:ジャーナル投稿のためのエキスパートガイド

競争の激しい今日の学術出版環境では、効果的なカバーレターを作成することが、原稿の採否を決定的に左右します。ChatGPTのようなAIを搭載したツールが、この重要なタスクをいかに効率化し、ジャーナル編集者の目を引く洗練されたプロフェッショナルなレターを作成できるかをご覧ください。ChatGPTの包括的なガイドでは、投稿パッケージを最適化し、出版を最大限に成功させるための戦略をステップごとに紹介してい

米国、ソーシャルメディア規制をめぐり外国公務員を制裁へ

米国、世界のデジタルコンテンツ規制に対抗国務省は今週、ヨーロッパのデジタル・ガバナンス政策を標的に鋭い外交的非難を行い、オンライン・プラットフォームの支配をめぐる緊張の高まりを示唆した。マルコ・ルビオ長官は、米国が米国のデジタル空間に影響を及ぼす検閲の行き過ぎとみなすものに関与する外国政府関係者を対象とした、新しいビザ制限政策を発表した。新しいビザ制限の説明水曜日に発表された政策では、米

米国、ソーシャルメディア規制をめぐり外国公務員を制裁へ

米国、世界のデジタルコンテンツ規制に対抗国務省は今週、ヨーロッパのデジタル・ガバナンス政策を標的に鋭い外交的非難を行い、オンライン・プラットフォームの支配をめぐる緊張の高まりを示唆した。マルコ・ルビオ長官は、米国が米国のデジタル空間に影響を及ぼす検閲の行き過ぎとみなすものに関与する外国政府関係者を対象とした、新しいビザ制限政策を発表した。新しいビザ制限の説明水曜日に発表された政策では、米

2025年9月13日 13:30:43 JST

2025年9月13日 13:30:43 JST

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

2025年8月20日 14:01:18 JST

2025年8月20日 14:01:18 JST

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

2025年8月13日 2:01:00 JST

2025年8月13日 2:01:00 JST

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

2025年7月23日 14:31:54 JST

2025年7月23日 14:31:54 JST

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

2025年4月23日 22:03:59 JST

2025年4月23日 22:03:59 JST

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

2025年4月22日 19:31:04 JST

2025年4月22日 19:31:04 JST

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0