广告商的目标是“猫头鹰和蜥蜴”

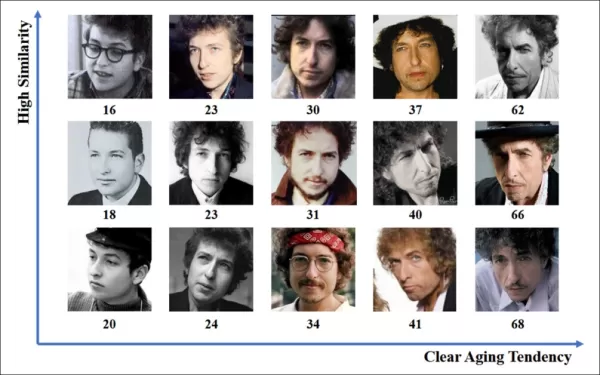

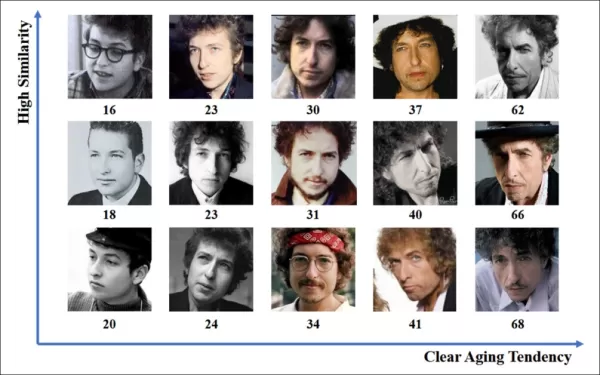

在线广告行业在2023年投入了惊人的7403亿美元用于其工作,这清楚地表明了该领域公司为何如此热衷于推进计算机视觉研究。他们尤其关注面部和眼部注视识别技术,其中年龄估计在人口统计分析中起着关键作用。这对于希望针对特定年龄群体的广告商至关重要。

尽管该行业倾向于保守其秘密,但偶尔会通过发表的研究分享其更先进的专有工作的片段。这些研究通常涉及同意参与AI驱动分析的参与者,旨在了解观众如何与广告互动。

*在野外广告环境中估计年龄对针对特定人口群体的广告商具有吸引力。在这个自动面部年龄估计的实验示例中,追踪了表演者Bob Dylan多年来年龄的变化。* 来源:https://arxiv.org/pdf/1906.03625

*在野外广告环境中估计年龄对针对特定人口群体的广告商具有吸引力。在这个自动面部年龄估计的实验示例中,追踪了表演者Bob Dylan多年来年龄的变化。* 来源:https://arxiv.org/pdf/1906.03625

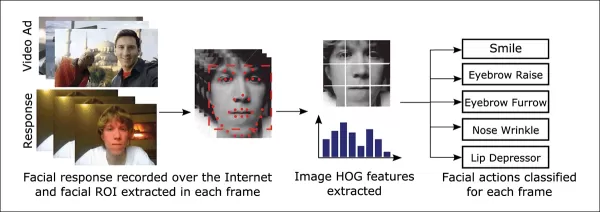

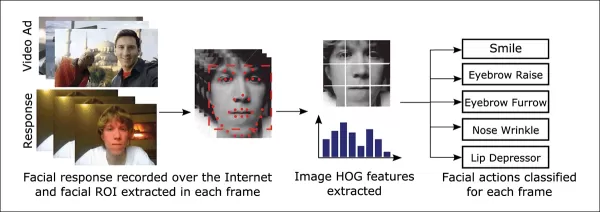

这些面部估计系统中经常使用的一种工具是Dlib的定向梯度直方图(HoG),它有助于分析面部特征。

*Dlib的定向梯度直方图(HoG)常用于面部估计系统。* 来源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Dlib的定向梯度直方图(HoG)常用于面部估计系统。* 来源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

动物本能

在理解观众参与度方面,广告行业尤其关注识别误报——即系统误解观众行为的情况——并建立明确的准则来判断某人未完全参与广告。这在基于屏幕的广告中尤为重要,研究聚焦于两种主要环境:桌面和移动设备,每种环境都需要定制的跟踪解决方案。

广告商通常将观众的不参与行为分为两种:“猫头鹰行为”和“蜥蜴行为”。如果你将头转向远离广告,这是“猫头鹰行为”。如果你的头部保持不动但眼睛离开屏幕,这是“蜥蜴行为”。这些行为对于系统在受控条件下测试新广告时准确捕捉至关重要。

*广告研究项目中受试者的“猫头鹰”和“蜥蜴”行为示例。* 来源:https://arxiv.org/pdf/1508.04028

*广告研究项目中受试者的“猫头鹰”和“蜥蜴”行为示例。* 来源:https://arxiv.org/pdf/1508.04028

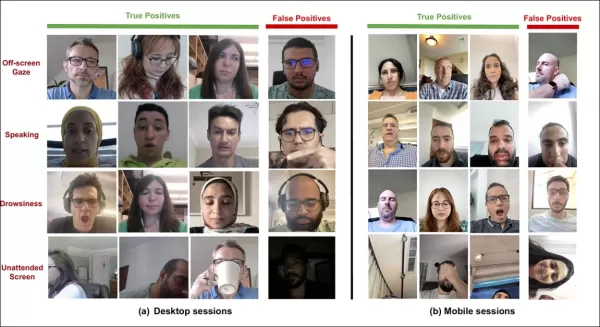

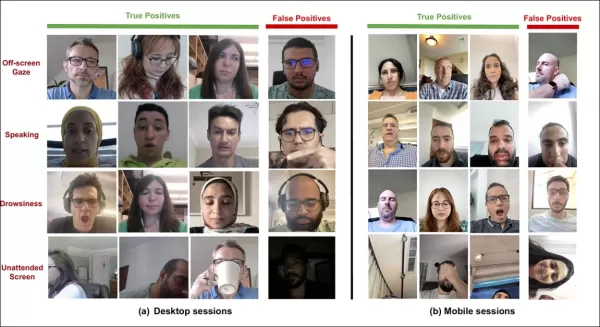

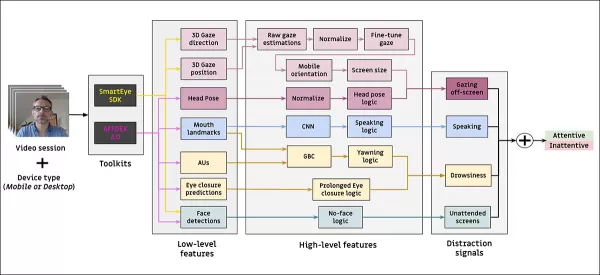

SmartEye收购Affectiva后的一篇近期论文直接应对了这些问题。它提出了一种架构,结合了多个现有框架,创建了一个全面的特征集,用于检测不同条件和反应下的观众注意力。这个系统可以判断观众是感到无聊、参与还是从广告商希望他们关注的广告内容中分心。

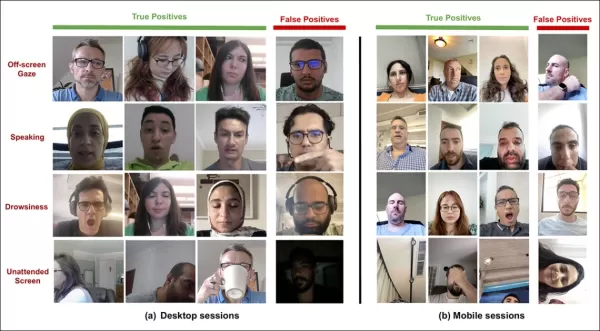

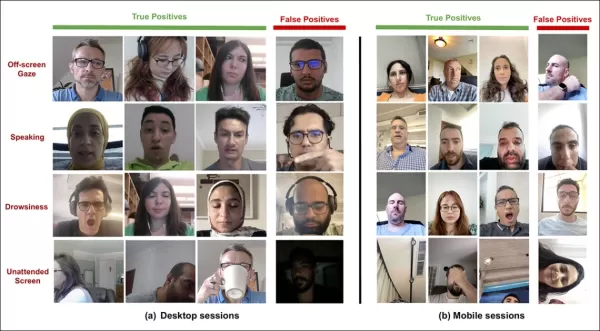

*新注意力系统检测到的各种分心信号的真阳性和假阳性示例,分别针对桌面和移动设备显示。* 来源:https://arxiv.org/pdf/2504.06237

*新注意力系统检测到的各种分心信号的真阳性和假阳性示例,分别针对桌面和移动设备显示。* 来源:https://arxiv.org/pdf/2504.06237

论文作者强调,关于在线广告期间监控注意力的研究非常有限,以前的研究常常忽略了设备类型、摄像头位置和屏幕尺寸等关键因素。他们提出的架构旨在通过检测包括猫头鹰和蜥蜴行为、说话、困倦和无人看守屏幕在内的各种分心因素,结合特定于设备的特征以提高准确性。

该论文题为“监控在线广告期间的观众注意力”,由Affectiva的四位研究人员撰写。

方法与数据

鉴于这些系统的保密性质,该论文并未直接将其方法与竞争对手进行比较,而是通过消融研究展示其发现。它偏离了计算机视觉文献的典型格式,因此我们将按照其呈现方式探索研究。

作者指出,只有少数研究专门针对在线广告背景下的注意力检测。例如,AFFDEX SDK提供实时多面部识别,仅通过头部姿势推断注意力,如果参与者的头部角度超过某个阈值,则标记为不专心。

*来自AFFDEX SDK的示例,Affectiva系统依赖头部姿势作为注意力的指标。* 来源:https://www.youtube.com/watch?v=c2CWb5jHmbY

*来自AFFDEX SDK的示例,Affectiva系统依赖头部姿势作为注意力的指标。* 来源:https://www.youtube.com/watch?v=c2CWb5jHmbY

在2019年题为“使用深度学习自动测量视频内容的视觉注意力”的合作中,约28,000名参与者的数据集被标注为各种不专心行为,并训练了一个CNN-LSTM模型,以从面部外观随时间变化检测注意力。

*来自2019年论文的示例,展示了观看视频内容的观众的预测注意力状态。* 来源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*来自2019年论文的示例,展示了观看视频内容的观众的预测注意力状态。* 来源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

然而,这些早期努力未考虑设备特定因素,如参与者使用的是桌面还是移动设备,也未考虑屏幕尺寸或摄像头位置。AFFDEX系统仅专注于识别视线偏离,而2019年的工作尝试检测更广泛的行为,但可能因使用单一浅层CNN而受限。

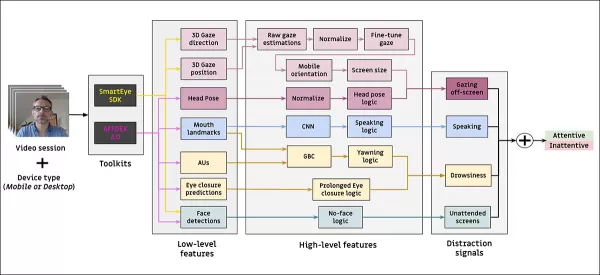

作者指出,现有研究大多未针对广告测试优化,与驾驶或教育等其他领域相比,广告测试有独特需求。他们开发了一种架构,用于在在线广告期间检测观众注意力,利用了两个商业工具包:AFFDEX 2.0和SmartEye SDK。

*来自AFFDEX 2.0的面部分析示例。* 来源:https://arxiv.org/pdf/2202.12059

*来自AFFDEX 2.0的面部分析示例。* 来源:https://arxiv.org/pdf/2202.12059

这些工具包提取低级特征,如面部表情、头部姿势和视线方向,然后处理为更高级的指标,如屏幕上的注视位置、打哈欠和说话。系统识别四种分心类型:屏幕外注视、困倦、说话和无人看守屏幕,根据观众使用的是桌面还是移动设备调整视线分析。

数据集:视线

作者使用了四个数据集来支持和评估其注意力检测系统:三个专注于视线行为、说话和打哈欠,第四个来自包含各种分心类型的现实世界广告测试会话。每个类别都创建了自定义数据集,来源于包含数百万记录的专有存储库,记录了参与者在家中或工作场所观看广告的会话,并获得知情同意。

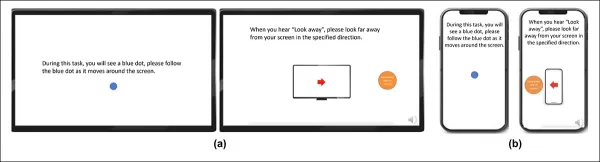

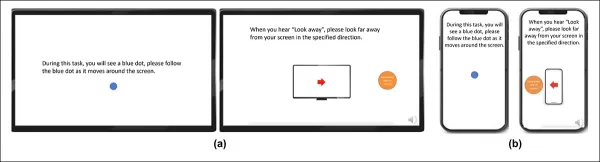

为构建视线数据集,参与者跟随屏幕上的移动点,然后向四个方向看去。这个过程重复三次,以建立捕获和覆盖之间的关系。

*屏幕截图显示了(a)桌面和(b)移动设备上的视线视频刺激。第一和第三帧显示跟随移动点的指令,第二和第四帧提示参与者看向屏幕外。*

*屏幕截图显示了(a)桌面和(b)移动设备上的视线视频刺激。第一和第三帧显示跟随移动点的指令,第二和第四帧提示参与者看向屏幕外。*

移动点段被标记为专心,屏幕外段被标记为不专心,创建了一个包含正例和负例的标记数据集。每个视频约160秒,桌面和移动平台有单独版本。共收集了609个视频,分为158个训练样本和451个测试样本。

数据集:说话

在此背景下,持续说话超过一秒被视为不专心的标志。由于受控环境不记录音频,语音通过观察估计的面部标志运动来推断。作者基于视觉输入创建了数据集,分为两部分:一部分由三名标注者手动标记,另一部分根据会话类型自动标记。

数据集:打哈欠

现有的打哈欠数据集不适合广告测试场景,因此作者使用了内部集合中的735个视频,重点是可能包含超过一秒的下巴张开的会话。每个视频由三名标注者手动标记为活跃或非活跃打哈欠,仅2.6%的帧包含活跃打哈欠。

数据集:分心

分心数据集来自作者的广告测试存储库,参与者观看实际广告,无指定任务。随机选择了520个会话,由三名标注者手动标记为专心或不专心,不专心行为包括屏幕外注视、说话、困倦和无人看守屏幕。

注意力模型

提出的注意力模型处理低级视觉特征,如面部表情、头部姿势和视线方向,通过AFFDEX 2.0和SmartEye SDK提取。这些特征被转换为高级指标,每个分心因素由单独的二元分类器处理,在其自己的数据集上进行独立优化和评估。

*拟议监控系统的架构图。*

*拟议监控系统的架构图。*

视线模型使用标准化视线坐标确定观众是看屏幕还是看别处,桌面和移动设备分别校准。使用线性支持向量机(SVM)平滑快速视线移动。

在没有音频的情况下检测说话,系统使用裁剪的嘴部区域和3D-CNN,训练于对话和非对话视频段。打哈欠使用全脸图像裁剪检测,3D-CNN在手动标记的帧上训练。屏幕无人看守通过面部缺失或极端头部姿势识别,由决策树进行预测。

最终注意力状态使用固定规则确定:如果任何模块检测到不专心,观众被标记为不专心,优先考虑敏感性,并分别针对桌面和移动环境调整。

测试

测试采用消融方法,移除组件并记录对结果的影响。视线模型通过三个关键步骤识别屏幕外行为:标准化原始视线估计、微调输出和估计桌面设备的屏幕尺寸。

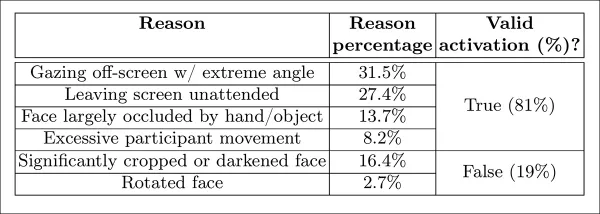

*研究中识别的感知不专心的不同类别。*

*研究中识别的感知不专心的不同类别。*

当任何步骤被省略时,性能下降,标准化在桌面设备上尤为重要。研究还评估了视觉特征如何预测移动摄像头方向,面部位置、头部姿势和眼部注视的组合达到0.91的得分。

*显示完整视线模型性能的结果,以及移除单个处理步骤的版本。*

*显示完整视线模型性能的结果,以及移除单个处理步骤的版本。*

基于垂直唇部距离训练的说话模型,在手动标记测试集上达到0.97的ROC-AUC,在更大的自动标记数据集上达到0.96。打哈欠模型仅使用嘴部宽高比达到96.6%的ROC-AUC,结合AFFDEX 2.0的动作单元预测后提高到97.5%。

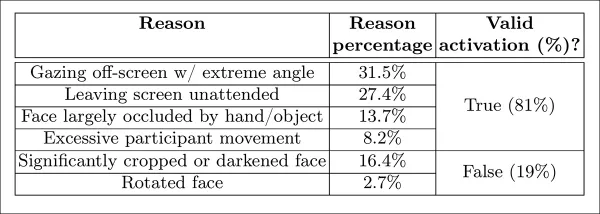

无人看守屏幕模型在AFFDEX 2.0和SmartEye超过一秒未检测到面部时,将时刻分类为不专心。只有27%的“无面部”激活是由于用户实际离开屏幕。

*在某些情况下未找到面部的各种原因。*

*在某些情况下未找到面部的各种原因。*

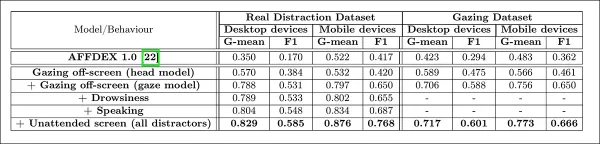

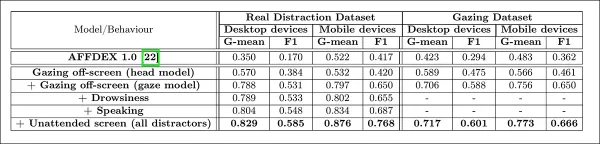

作者评估了添加不同分心信号对整体注意力模型性能的影响。随着更多分心类型的添加,注意力检测持续改善,屏幕外注视提供了最强的基线。

*向架构添加不同分心信号的效果。*

*向架构添加不同分心信号的效果。*

作者将他们的模型与用于广告测试的早期系统AFFDEX 1.0进行比较,发现即使当前模型的基于头部的视线检测在两种设备类型上也优于AFFDEX 1.0。

*注意力模型在桌面和移动设备上的样本输出,每行展示不同分心类型的真阳性和假阳性示例。*

*注意力模型在桌面和移动设备上的样本输出,每行展示不同分心类型的真阳性和假阳性示例。*

结论

结果代表了相较于先前工作的显著进步,提供了行业持续努力理解观众内心状态的一瞥。尽管数据是在知情同意下收集的,但该方法指向了可能超越结构化市场研究环境的未来框架。这一结论因研究的保密性质而得到强化,该研究仍被行业严格保密。

相关文章

人工智能驱动的求职信:期刊投稿专家指南

在当今竞争激烈的学术出版环境中,撰写一封有效的求职信是稿件能否被录用的关键。了解像 ChatGPT 这样的人工智能工具如何简化这一重要任务,帮助您撰写出精美、专业的信件,吸引期刊编辑的注意。我们的综合指南将逐步揭示优化投稿包、最大限度地提高发表成功率的策略。要点必要的研究准备:整理所有稿件细节和期刊规范。人工智能辅助起草:使用 ChatGPT 生成最初的求职信模板。个性化定制:完善人工智能输出,以

人工智能驱动的求职信:期刊投稿专家指南

在当今竞争激烈的学术出版环境中,撰写一封有效的求职信是稿件能否被录用的关键。了解像 ChatGPT 这样的人工智能工具如何简化这一重要任务,帮助您撰写出精美、专业的信件,吸引期刊编辑的注意。我们的综合指南将逐步揭示优化投稿包、最大限度地提高发表成功率的策略。要点必要的研究准备:整理所有稿件细节和期刊规范。人工智能辅助起草:使用 ChatGPT 生成最初的求职信模板。个性化定制:完善人工智能输出,以

美国将因社交媒体法规制裁外国官员

美国站出来反对全球数字内容法规美国国务院本周针对欧洲的数字治理政策发出了尖锐的外交斥责,表明在网络平台控制权问题上的紧张局势正在升级。国务卿马可-卢比奥(Marco Rubio)公布了一项新的签证限制政策,该政策针对的是参与美国认为影响美国数字空间的过度审查的外国官员。新签证限制解释根据周三宣布的政策,美国将拒绝被认定正在执行影响美国受保护言论的海外内容法规的外国公民入境。卢比奥强调了两

美国将因社交媒体法规制裁外国官员

美国站出来反对全球数字内容法规美国国务院本周针对欧洲的数字治理政策发出了尖锐的外交斥责,表明在网络平台控制权问题上的紧张局势正在升级。国务卿马可-卢比奥(Marco Rubio)公布了一项新的签证限制政策,该政策针对的是参与美国认为影响美国数字空间的过度审查的外国官员。新签证限制解释根据周三宣布的政策,美国将拒绝被认定正在执行影响美国受保护言论的海外内容法规的外国公民入境。卢比奥强调了两

人工智能驱动的 YouTube 视频摘要器终极指南

在我们信息丰富的数字环境中,人工智能驱动的 YouTube 视频摘要器已成为高效内容消费不可或缺的工具。本深度指南探讨了如何利用最先进的 NLP 技术(特别是来自 Hugging Face 的 BART 模型与 YouTube 的 Transcript API 相结合)构建复杂的摘要工具。无论您是要开发生产力工具、增强可访问性解决方案,还是要创建教育资源,本指南都能为您提供实现专业级摘要所需的一切

评论 (24)

0/200

人工智能驱动的 YouTube 视频摘要器终极指南

在我们信息丰富的数字环境中,人工智能驱动的 YouTube 视频摘要器已成为高效内容消费不可或缺的工具。本深度指南探讨了如何利用最先进的 NLP 技术(特别是来自 Hugging Face 的 BART 模型与 YouTube 的 Transcript API 相结合)构建复杂的摘要工具。无论您是要开发生产力工具、增强可访问性解决方案,还是要创建教育资源,本指南都能为您提供实现专业级摘要所需的一切

评论 (24)

0/200

![JustinAnderson]() JustinAnderson

JustinAnderson

2025-09-13 12:30:43

2025-09-13 12:30:43

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

![MatthewSanchez]() MatthewSanchez

MatthewSanchez

2025-08-20 13:01:18

2025-08-20 13:01:18

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

![StephenGonzalez]() StephenGonzalez

StephenGonzalez

2025-08-13 01:01:00

2025-08-13 01:01:00

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

2025-07-23 13:31:54

2025-07-23 13:31:54

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

![EricLewis]() EricLewis

EricLewis

2025-04-23 21:03:59

2025-04-23 21:03:59

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

![JoseLewis]() JoseLewis

JoseLewis

2025-04-22 18:31:04

2025-04-22 18:31:04

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0

在线广告行业在2023年投入了惊人的7403亿美元用于其工作,这清楚地表明了该领域公司为何如此热衷于推进计算机视觉研究。他们尤其关注面部和眼部注视识别技术,其中年龄估计在人口统计分析中起着关键作用。这对于希望针对特定年龄群体的广告商至关重要。

尽管该行业倾向于保守其秘密,但偶尔会通过发表的研究分享其更先进的专有工作的片段。这些研究通常涉及同意参与AI驱动分析的参与者,旨在了解观众如何与广告互动。

*在野外广告环境中估计年龄对针对特定人口群体的广告商具有吸引力。在这个自动面部年龄估计的实验示例中,追踪了表演者Bob Dylan多年来年龄的变化。* 来源:https://arxiv.org/pdf/1906.03625

*在野外广告环境中估计年龄对针对特定人口群体的广告商具有吸引力。在这个自动面部年龄估计的实验示例中,追踪了表演者Bob Dylan多年来年龄的变化。* 来源:https://arxiv.org/pdf/1906.03625

这些面部估计系统中经常使用的一种工具是Dlib的定向梯度直方图(HoG),它有助于分析面部特征。

*Dlib的定向梯度直方图(HoG)常用于面部估计系统。* 来源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

*Dlib的定向梯度直方图(HoG)常用于面部估计系统。* 来源:https://www.computer.org/csdl/journal/ta/2017/02/07475863/13rRUNvyarN

动物本能

在理解观众参与度方面,广告行业尤其关注识别误报——即系统误解观众行为的情况——并建立明确的准则来判断某人未完全参与广告。这在基于屏幕的广告中尤为重要,研究聚焦于两种主要环境:桌面和移动设备,每种环境都需要定制的跟踪解决方案。

广告商通常将观众的不参与行为分为两种:“猫头鹰行为”和“蜥蜴行为”。如果你将头转向远离广告,这是“猫头鹰行为”。如果你的头部保持不动但眼睛离开屏幕,这是“蜥蜴行为”。这些行为对于系统在受控条件下测试新广告时准确捕捉至关重要。

*广告研究项目中受试者的“猫头鹰”和“蜥蜴”行为示例。* 来源:https://arxiv.org/pdf/1508.04028

*广告研究项目中受试者的“猫头鹰”和“蜥蜴”行为示例。* 来源:https://arxiv.org/pdf/1508.04028

SmartEye收购Affectiva后的一篇近期论文直接应对了这些问题。它提出了一种架构,结合了多个现有框架,创建了一个全面的特征集,用于检测不同条件和反应下的观众注意力。这个系统可以判断观众是感到无聊、参与还是从广告商希望他们关注的广告内容中分心。

*新注意力系统检测到的各种分心信号的真阳性和假阳性示例,分别针对桌面和移动设备显示。* 来源:https://arxiv.org/pdf/2504.06237

*新注意力系统检测到的各种分心信号的真阳性和假阳性示例,分别针对桌面和移动设备显示。* 来源:https://arxiv.org/pdf/2504.06237

论文作者强调,关于在线广告期间监控注意力的研究非常有限,以前的研究常常忽略了设备类型、摄像头位置和屏幕尺寸等关键因素。他们提出的架构旨在通过检测包括猫头鹰和蜥蜴行为、说话、困倦和无人看守屏幕在内的各种分心因素,结合特定于设备的特征以提高准确性。

该论文题为“监控在线广告期间的观众注意力”,由Affectiva的四位研究人员撰写。

方法与数据

鉴于这些系统的保密性质,该论文并未直接将其方法与竞争对手进行比较,而是通过消融研究展示其发现。它偏离了计算机视觉文献的典型格式,因此我们将按照其呈现方式探索研究。

作者指出,只有少数研究专门针对在线广告背景下的注意力检测。例如,AFFDEX SDK提供实时多面部识别,仅通过头部姿势推断注意力,如果参与者的头部角度超过某个阈值,则标记为不专心。

*来自AFFDEX SDK的示例,Affectiva系统依赖头部姿势作为注意力的指标。* 来源:https://www.youtube.com/watch?v=c2CWb5jHmbY

*来自AFFDEX SDK的示例,Affectiva系统依赖头部姿势作为注意力的指标。* 来源:https://www.youtube.com/watch?v=c2CWb5jHmbY

在2019年题为“使用深度学习自动测量视频内容的视觉注意力”的合作中,约28,000名参与者的数据集被标注为各种不专心行为,并训练了一个CNN-LSTM模型,以从面部外观随时间变化检测注意力。

*来自2019年论文的示例,展示了观看视频内容的观众的预测注意力状态。* 来源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

*来自2019年论文的示例,展示了观看视频内容的观众的预测注意力状态。* 来源:https://www.jeffcohn.net/wp-content/uploads/2019/07/Attention-13.pdf.pdf

然而,这些早期努力未考虑设备特定因素,如参与者使用的是桌面还是移动设备,也未考虑屏幕尺寸或摄像头位置。AFFDEX系统仅专注于识别视线偏离,而2019年的工作尝试检测更广泛的行为,但可能因使用单一浅层CNN而受限。

作者指出,现有研究大多未针对广告测试优化,与驾驶或教育等其他领域相比,广告测试有独特需求。他们开发了一种架构,用于在在线广告期间检测观众注意力,利用了两个商业工具包:AFFDEX 2.0和SmartEye SDK。

*来自AFFDEX 2.0的面部分析示例。* 来源:https://arxiv.org/pdf/2202.12059

*来自AFFDEX 2.0的面部分析示例。* 来源:https://arxiv.org/pdf/2202.12059

这些工具包提取低级特征,如面部表情、头部姿势和视线方向,然后处理为更高级的指标,如屏幕上的注视位置、打哈欠和说话。系统识别四种分心类型:屏幕外注视、困倦、说话和无人看守屏幕,根据观众使用的是桌面还是移动设备调整视线分析。

数据集:视线

作者使用了四个数据集来支持和评估其注意力检测系统:三个专注于视线行为、说话和打哈欠,第四个来自包含各种分心类型的现实世界广告测试会话。每个类别都创建了自定义数据集,来源于包含数百万记录的专有存储库,记录了参与者在家中或工作场所观看广告的会话,并获得知情同意。

为构建视线数据集,参与者跟随屏幕上的移动点,然后向四个方向看去。这个过程重复三次,以建立捕获和覆盖之间的关系。

*屏幕截图显示了(a)桌面和(b)移动设备上的视线视频刺激。第一和第三帧显示跟随移动点的指令,第二和第四帧提示参与者看向屏幕外。*

*屏幕截图显示了(a)桌面和(b)移动设备上的视线视频刺激。第一和第三帧显示跟随移动点的指令,第二和第四帧提示参与者看向屏幕外。*

移动点段被标记为专心,屏幕外段被标记为不专心,创建了一个包含正例和负例的标记数据集。每个视频约160秒,桌面和移动平台有单独版本。共收集了609个视频,分为158个训练样本和451个测试样本。

数据集:说话

在此背景下,持续说话超过一秒被视为不专心的标志。由于受控环境不记录音频,语音通过观察估计的面部标志运动来推断。作者基于视觉输入创建了数据集,分为两部分:一部分由三名标注者手动标记,另一部分根据会话类型自动标记。

数据集:打哈欠

现有的打哈欠数据集不适合广告测试场景,因此作者使用了内部集合中的735个视频,重点是可能包含超过一秒的下巴张开的会话。每个视频由三名标注者手动标记为活跃或非活跃打哈欠,仅2.6%的帧包含活跃打哈欠。

数据集:分心

分心数据集来自作者的广告测试存储库,参与者观看实际广告,无指定任务。随机选择了520个会话,由三名标注者手动标记为专心或不专心,不专心行为包括屏幕外注视、说话、困倦和无人看守屏幕。

注意力模型

提出的注意力模型处理低级视觉特征,如面部表情、头部姿势和视线方向,通过AFFDEX 2.0和SmartEye SDK提取。这些特征被转换为高级指标,每个分心因素由单独的二元分类器处理,在其自己的数据集上进行独立优化和评估。

*拟议监控系统的架构图。*

*拟议监控系统的架构图。*

视线模型使用标准化视线坐标确定观众是看屏幕还是看别处,桌面和移动设备分别校准。使用线性支持向量机(SVM)平滑快速视线移动。

在没有音频的情况下检测说话,系统使用裁剪的嘴部区域和3D-CNN,训练于对话和非对话视频段。打哈欠使用全脸图像裁剪检测,3D-CNN在手动标记的帧上训练。屏幕无人看守通过面部缺失或极端头部姿势识别,由决策树进行预测。

最终注意力状态使用固定规则确定:如果任何模块检测到不专心,观众被标记为不专心,优先考虑敏感性,并分别针对桌面和移动环境调整。

测试

测试采用消融方法,移除组件并记录对结果的影响。视线模型通过三个关键步骤识别屏幕外行为:标准化原始视线估计、微调输出和估计桌面设备的屏幕尺寸。

*研究中识别的感知不专心的不同类别。*

*研究中识别的感知不专心的不同类别。*

当任何步骤被省略时,性能下降,标准化在桌面设备上尤为重要。研究还评估了视觉特征如何预测移动摄像头方向,面部位置、头部姿势和眼部注视的组合达到0.91的得分。

*显示完整视线模型性能的结果,以及移除单个处理步骤的版本。*

*显示完整视线模型性能的结果,以及移除单个处理步骤的版本。*

基于垂直唇部距离训练的说话模型,在手动标记测试集上达到0.97的ROC-AUC,在更大的自动标记数据集上达到0.96。打哈欠模型仅使用嘴部宽高比达到96.6%的ROC-AUC,结合AFFDEX 2.0的动作单元预测后提高到97.5%。

无人看守屏幕模型在AFFDEX 2.0和SmartEye超过一秒未检测到面部时,将时刻分类为不专心。只有27%的“无面部”激活是由于用户实际离开屏幕。

*在某些情况下未找到面部的各种原因。*

*在某些情况下未找到面部的各种原因。*

作者评估了添加不同分心信号对整体注意力模型性能的影响。随着更多分心类型的添加,注意力检测持续改善,屏幕外注视提供了最强的基线。

*向架构添加不同分心信号的效果。*

*向架构添加不同分心信号的效果。*

作者将他们的模型与用于广告测试的早期系统AFFDEX 1.0进行比较,发现即使当前模型的基于头部的视线检测在两种设备类型上也优于AFFDEX 1.0。

*注意力模型在桌面和移动设备上的样本输出,每行展示不同分心类型的真阳性和假阳性示例。*

*注意力模型在桌面和移动设备上的样本输出,每行展示不同分心类型的真阳性和假阳性示例。*

结论

结果代表了相较于先前工作的显著进步,提供了行业持续努力理解观众内心状态的一瞥。尽管数据是在知情同意下收集的,但该方法指向了可能超越结构化市场研究环境的未来框架。这一结论因研究的保密性质而得到强化,该研究仍被行业严格保密。

人工智能驱动的求职信:期刊投稿专家指南

在当今竞争激烈的学术出版环境中,撰写一封有效的求职信是稿件能否被录用的关键。了解像 ChatGPT 这样的人工智能工具如何简化这一重要任务,帮助您撰写出精美、专业的信件,吸引期刊编辑的注意。我们的综合指南将逐步揭示优化投稿包、最大限度地提高发表成功率的策略。要点必要的研究准备:整理所有稿件细节和期刊规范。人工智能辅助起草:使用 ChatGPT 生成最初的求职信模板。个性化定制:完善人工智能输出,以

人工智能驱动的求职信:期刊投稿专家指南

在当今竞争激烈的学术出版环境中,撰写一封有效的求职信是稿件能否被录用的关键。了解像 ChatGPT 这样的人工智能工具如何简化这一重要任务,帮助您撰写出精美、专业的信件,吸引期刊编辑的注意。我们的综合指南将逐步揭示优化投稿包、最大限度地提高发表成功率的策略。要点必要的研究准备:整理所有稿件细节和期刊规范。人工智能辅助起草:使用 ChatGPT 生成最初的求职信模板。个性化定制:完善人工智能输出,以

美国将因社交媒体法规制裁外国官员

美国站出来反对全球数字内容法规美国国务院本周针对欧洲的数字治理政策发出了尖锐的外交斥责,表明在网络平台控制权问题上的紧张局势正在升级。国务卿马可-卢比奥(Marco Rubio)公布了一项新的签证限制政策,该政策针对的是参与美国认为影响美国数字空间的过度审查的外国官员。新签证限制解释根据周三宣布的政策,美国将拒绝被认定正在执行影响美国受保护言论的海外内容法规的外国公民入境。卢比奥强调了两

美国将因社交媒体法规制裁外国官员

美国站出来反对全球数字内容法规美国国务院本周针对欧洲的数字治理政策发出了尖锐的外交斥责,表明在网络平台控制权问题上的紧张局势正在升级。国务卿马可-卢比奥(Marco Rubio)公布了一项新的签证限制政策,该政策针对的是参与美国认为影响美国数字空间的过度审查的外国官员。新签证限制解释根据周三宣布的政策,美国将拒绝被认定正在执行影响美国受保护言论的海外内容法规的外国公民入境。卢比奥强调了两

人工智能驱动的 YouTube 视频摘要器终极指南

在我们信息丰富的数字环境中,人工智能驱动的 YouTube 视频摘要器已成为高效内容消费不可或缺的工具。本深度指南探讨了如何利用最先进的 NLP 技术(特别是来自 Hugging Face 的 BART 模型与 YouTube 的 Transcript API 相结合)构建复杂的摘要工具。无论您是要开发生产力工具、增强可访问性解决方案,还是要创建教育资源,本指南都能为您提供实现专业级摘要所需的一切

人工智能驱动的 YouTube 视频摘要器终极指南

在我们信息丰富的数字环境中,人工智能驱动的 YouTube 视频摘要器已成为高效内容消费不可或缺的工具。本深度指南探讨了如何利用最先进的 NLP 技术(特别是来自 Hugging Face 的 BART 模型与 YouTube 的 Transcript API 相结合)构建复杂的摘要工具。无论您是要开发生产力工具、增强可访问性解决方案,还是要创建教育资源,本指南都能为您提供实现专业级摘要所需的一切

2025-09-13 12:30:43

2025-09-13 12:30:43

¡Qué locura que los anunciantes estén agrupando a la gente como 'búhos y lagartijas'! 🦉🦎 Me pregunto qué otros animales raros usan para segmentar audiencias... ¿Habrá categorías como 'armadillos nocturnos' o 'gatos dormilones'? Al final terminaremos siendo etiquetados como mascotas virtuales 😂

0

0

2025-08-20 13:01:18

2025-08-20 13:01:18

Whoa, $740.3 billion on ads in 2023? That’s wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you. 😬 Are we all just owls and lizards to these companies now?

0

0

2025-08-13 01:01:00

2025-08-13 01:01:00

This article's wild! $740B on ads in 2023? No wonder they're obsessed with eye-gaze tech. Kinda creepy how they track faces to guess ages, though—Big Brother vibes! 😬

0

0

2025-07-23 13:31:54

2025-07-23 13:31:54

Whoa, $740B on ads? That's wild! Eye-gaze tech sounds cool but kinda creepy—imagine ads staring back at you! 😆 Curious how accurate their age guesses are.

0

0

2025-04-23 21:03:59

2025-04-23 21:03:59

Esta herramienta para segmentar 'búhos y lagartos' en el análisis de audiencia es un poco rara pero genial. Es increíble cómo usan el reconocimiento facial y de mirada para segmentar grupos específicos. Es un poco escalofriante, pero tengo que admitir que es efectiva. Tal vez puedan usarla para segmentar otros animales también, como 'unicornios'? 😂

0

0

2025-04-22 18:31:04

2025-04-22 18:31:04

This tool for targeting 'Owls and Lizards' in audience analysis is kinda weird but cool! It's amazing how they use facial and eye-gaze recognition to target specific groups. It's a bit creepy, but I gotta admit, it's effective. Maybe they could use it to target other animals too, like 'unicorns'? 😂

0

0