人工智能視頻生成朝著完全控制

像Hunyuan和Wan 2.1這樣的視頻基礎模型已取得顯著進展,但在電影和電視製作中所需的精細控制方面,特別是在視覺效果(VFX)領域,常常表現不足。在專業VFX工作室中,這些模型與早期的基於圖像的模型,如Stable Diffusion、Kandinsky和Flux,結合一系列專為滿足特定創意需求而設計的工具一起使用。當導演要求進行微調,例如說「這看起來很棒,但可以再稍微[n]一點嗎?」,僅僅聲稱模型缺乏精確調整的能力是不夠的。

相反,AI VFX團隊會結合傳統CGI和合成技術,以及自定義開發的工作流程,進一步推動視頻合成的邊界。這種方法類似於使用像Chrome這樣的預設網頁瀏覽器;它開箱即用,但要真正滿足你的需求,你需要安裝一些插件。

控制狂熱者

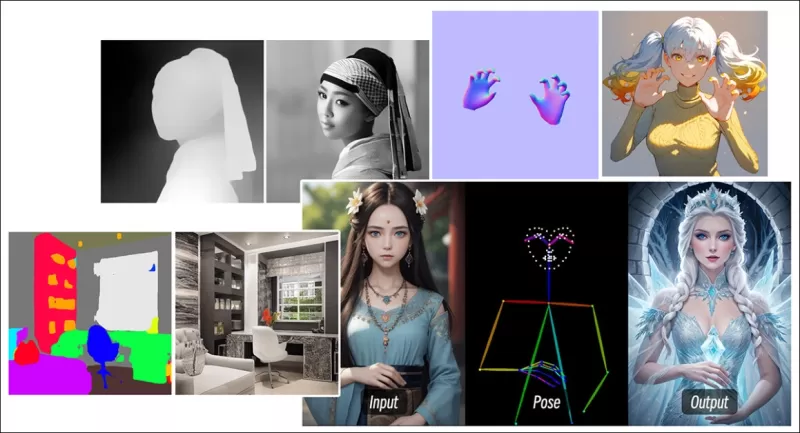

在基於擴散的圖像合成領域中,最關鍵的第三方系統之一是ControlNet。這項技術為生成模型引入結構化控制,允許用戶通過額外的輸入(如邊緣圖、深度圖或姿態信息)來引導圖像或視頻生成。

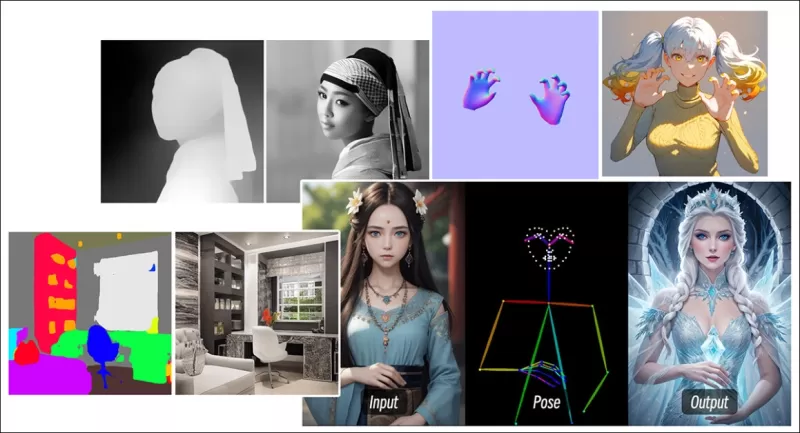

*ControlNet的多種方法允許深度>圖像(頂行)、語義分割>圖像(左下)以及人類和動物的姿態引導圖像生成(左下)。*

*ControlNet的多種方法允許深度>圖像(頂行)、語義分割>圖像(左下)以及人類和動物的姿態引導圖像生成(左下)。*

ControlNet不僅依賴文本提示;它使用獨立的神經網絡分支或適配器來處理這些條件信號,同時保持基礎模型的生成能力。這使得高度定制的輸出能夠與用戶規格緊密對齊,對於需要精確控制構圖、結構或運動的應用來說極其寶貴。

*通過引導姿態,ControlNet可以獲得多種精確的輸出類型。* 來源:https://arxiv.org/pdf/2302.05543

*通過引導姿態,ControlNet可以獲得多種精確的輸出類型。* 來源:https://arxiv.org/pdf/2302.05543

然而,這些基於適配器的系統,通過外部操作一組內部聚焦的神經過程,存在幾個缺點。適配器是獨立訓練的,當多個適配器組合時可能導致分支衝突,通常會導致生成質量下降。它們還引入了參數冗餘,每個適配器都需要額外的計算資源和內存,使得擴展效率低下。此外,儘管適配器靈活,但與專為多條件生成完全微調的模型相比,它們的結果往往不夠理想。這些問題可能使基於適配器的方法在需要無縫整合多個控制信號的任務中效果不佳。

理想情況下,ControlNet的功能應以模組化方式原生整合到模型中,允許未來創新,如同時生成視頻/音頻或原生唇部同步功能。目前,每個額外功能要麼成為後期製作任務,要麼是必須在基礎模型敏感權重中導航的非原生程序。

FullDiT

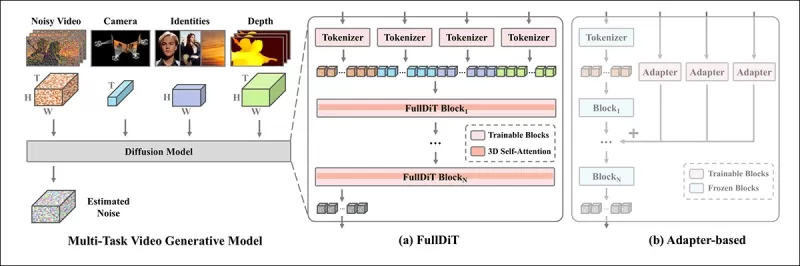

來自中國的新方法FullDiT,將ControlNet風格的功能直接整合到生成視頻模型的訓練過程中,而不是將其視為事後補充。

*來自新論文:FullDiT方法可以將身份強加、深度和攝影機運動融入原生生成,並能同時調用這些功能的任意組合。* 來源:https://arxiv.org/pdf/2503.19907

*來自新論文:FullDiT方法可以將身份強加、深度和攝影機運動融入原生生成,並能同時調用這些功能的任意組合。* 來源:https://arxiv.org/pdf/2503.19907

FullDiT,如論文《FullDiT:具有完全注意力的多任務視頻生成基礎模型》中所述,將多任務條件(如身份轉移、深度映射和攝影機運動)整合到訓練好的生成視頻模型的核心中。作者開發了一個原型模型及相關視頻片段,可在項目網站上查看。

**點擊播放。僅使用原生訓練基礎模型的ControlNet風格用戶強加示例。** 來源:https://fulldit.github.io/

作者將FullDiT作為原生文本到視頻(T2V)和圖像到視頻(I2V)模型的概念驗證,這些模型為用戶提供比僅圖像或文本提示更多的控制。由於不存在類似模型,研究人員創建了一個名為**FullBench**的新基準,用於評估多任務視頻,聲稱在他們設計的測試中達到最先進的性能。然而,由作者自行設計的FullBench的客觀性尚未經過測試,其1,400個案例的數據集可能對於更廣泛的結論來說過於有限。

FullDiT架構最引人注目的方面是其整合新型控制的潛力。作者指出:

**‘在這項工作中,我們僅探索了攝影機、身份和深度信息的控制條件。我們尚未進一步研究其他條件和模態,如音頻、語音、點雲、物體邊界框、光流等。雖然FullDiT的設計可以以最小的架構修改無縫整合其他模態,但如何快速且成本效益高地適應現有模型以應對新條件和模態仍是一個值得進一步探索的重要問題。’**

雖然FullDiT代表了多任務視頻生成的一步進展,但它建立在現有架構之上,而不是引入全新範式。儘管如此,它作為唯一具有原生整合ControlNet風格功能的視頻基礎模型脫穎而出,其架構設計也能適應未來的創新。

**點擊播放。來自項目網站的用戶控制攝影機運動示例。**

該論文由來自快手科技和香港中文大學的九位研究人員撰寫,題為**FullDiT:具有完全注意力的多任務視頻生成基礎模型**。項目頁面和新基準數據可在Hugging Face上獲取。

方法

FullDiT的統一注意力機制旨在通過捕捉條件間的空間和時間關係來增強跨模態表示學習。

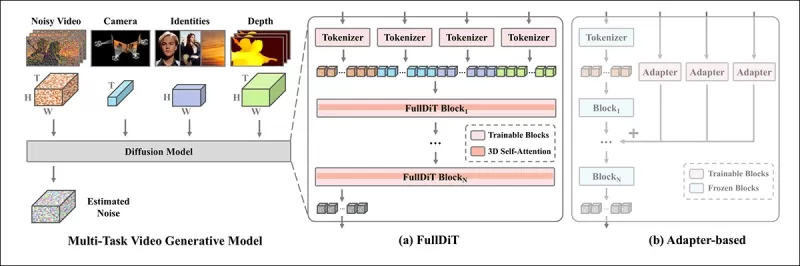

*根據新論文,FullDiT通過完全自注意力整合多個輸入條件,將其轉換為統一序列。相比之下,基於適配器的模型(上方最左側)為每個輸入使用獨立模組,導致冗餘、衝突和較弱的性能。*

*根據新論文,FullDiT通過完全自注意力整合多個輸入條件,將其轉換為統一序列。相比之下,基於適配器的模型(上方最左側)為每個輸入使用獨立模組,導致冗餘、衝突和較弱的性能。*

與分別處理每個輸入流的基於適配器設置不同,FullDiT的共享注意力結構避免了分支衝突並減少了參數開銷。作者聲稱該架構可以擴展到新型輸入類型而無需重大重新設計,且模型結構顯示出對訓練中未見過的條件組合的泛化跡象,例如將攝影機運動與角色身份連結。

**點擊播放。來自項目網站的身份生成示例。**

在FullDiT的架構中,所有條件輸入(如文本、攝影機運動、身份和深度)首先被轉換為統一的標記格式。這些標記隨後被拼接成一個長序列,通過一組變換器層使用完全自注意力進行處理。這種方法遵循了Open-Sora Plan和Movie Gen等先前工作的做法。

這種設計使模型能夠聯合學習所有條件的時間和空間關係。每個變換器塊對整個序列進行操作,實現模態間的動態交互,而無需依賴每個輸入的獨立模組。該架構設計為可擴展,使得未來無需重大結構更改即可輕鬆整合額外的控制信號。

三者之力

FullDiT將每個控制信號轉換為標準化標記格式,以便所有條件可以在統一的注意力框架中一起處理。對於攝影機運動,模型為每幀編碼一系列外在參數(如位置和方向)。這些參數帶有時間戳並投影到嵌入向量中,反映信號的時間特性。

身份信息因其本質上是空間而非時間的而被不同處理。模型使用身份圖,指示每個幀的哪些部分存在哪些角色。這些圖被分成小塊,每個小塊投影到一個捕捉空間身份線索的嵌入中,使模型能夠將幀的特定區域與特定實體關聯。

深度是一個時空信號,模型通過將深度視頻分成跨越空間和時間的3D小塊來處理。這些小塊隨後以保留其跨幀結構的方式嵌入。

一旦嵌入,所有這些條件標記(攝影機、身份和深度)被拼接成一個長序列,使FullDiT能夠使用完全自注意力一起處理它們。這種共享表示使模型能夠學習跨模態和跨時間的交互,而無需依賴獨立的處理流。

數據與測試

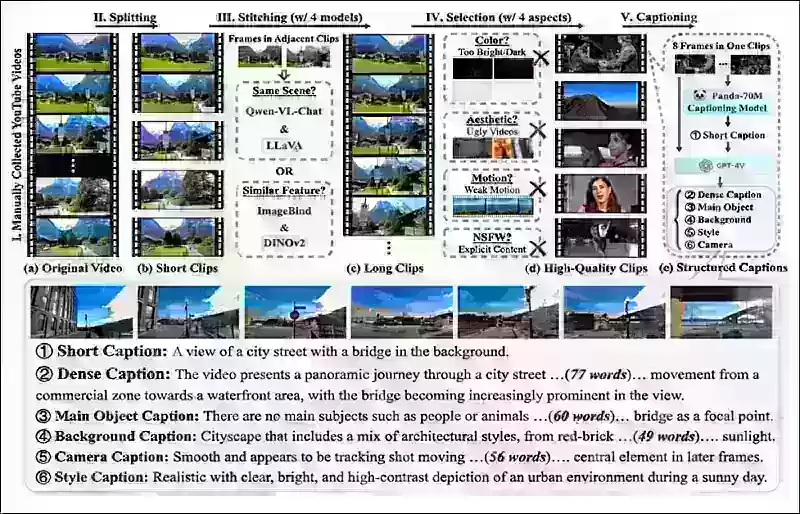

FullDiT的訓練方法依賴於為每種條件類型量身定制的選擇性註釋數據集,而非要求所有條件同時存在。

對於文本條件,該計劃遵循MiraData項目中概述的結構化標籤方法。

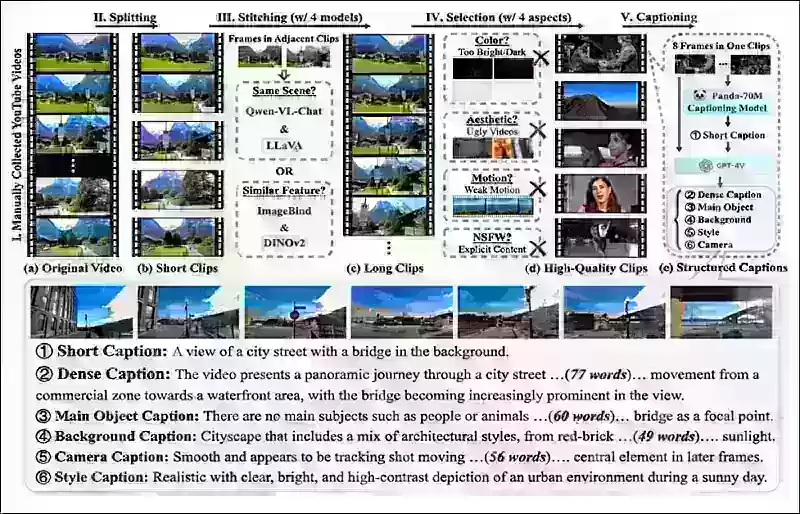

*來自MiraData項目的視頻收集和註釋流程。* 來源:https://arxiv.org/pdf/2407.06358

*來自MiraData項目的視頻收集和註釋流程。* 來源:https://arxiv.org/pdf/2407.06358

對於攝影機運動,RealEstate10K數據集是主要數據來源,因其高質量的攝影機參數真值註釋。然而,作者觀察到僅在像RealEstate10K這樣的靜態場景攝影機數據集上訓練,傾向於減少生成視頻中的動態物體和人類運動。為了解決這個問題,他們使用包含更多動態攝影機運動的內部數據集進行了額外的微調。

身份註釋使用為ConceptMaster項目開發的流程生成,該流程允許高效過濾和提取細粒度的身份信息。

*ConceptMaster框架旨在解決身份解耦問題,同時保留自定義視頻中的概念忠實度。* 來源:https://arxiv.org/pdf/2501.04698

*ConceptMaster框架旨在解決身份解耦問題,同時保留自定義視頻中的概念忠實度。* 來源:https://arxiv.org/pdf/2501.04698

深度註釋從Panda-70M數據集使用Depth Anything獲得。

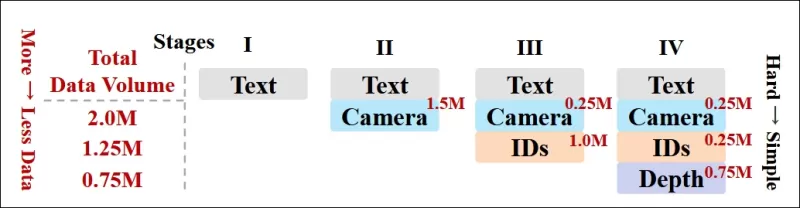

通過數據排序優化

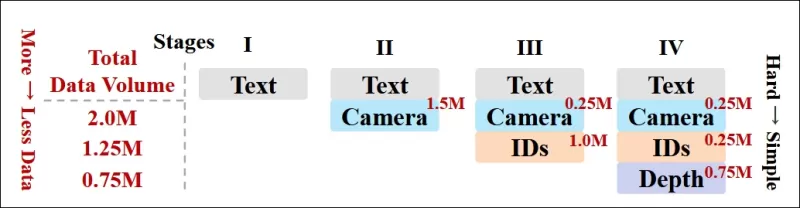

作者還實施了漸進式訓練計劃,在訓練早期引入更具挑戰性的條件,以確保模型在添加較簡單任務之前獲得穩健的表示。訓練順序從文本到攝影機條件,然後是身份,最後是深度,較簡單的任務通常在後期引入並使用較少的示例。

作者強調了以這種方式安排工作量的價值:

**‘在預訓練階段,我們注意到更具挑戰性的任務需要更長的訓練時間,並應在學習過程中較早引入。這些具挑戰性的任務涉及與輸出視頻顯著不同的複雜數據分佈,要求模型具備足夠的能力來準確捕捉和表示它們。’**

**‘相反,過早引入較簡單的任務可能導致模型優先學習它們,因為它們提供更即時的優化反饋,這會阻礙更具挑戰性任務的收斂。’**

*研究人員採用的數據訓練順序示意圖,紅色表示更大的數據量。*

*研究人員採用的數據訓練順序示意圖,紅色表示更大的數據量。*

在初始預訓練後,最終的微調階段進一步完善了模型,以提高視覺質量和運動動態。此後,訓練遵循標準擴散框架:向視頻潛在變量添加噪聲,模型學習預測並移除噪聲,使用嵌入的條件標記作為指導。

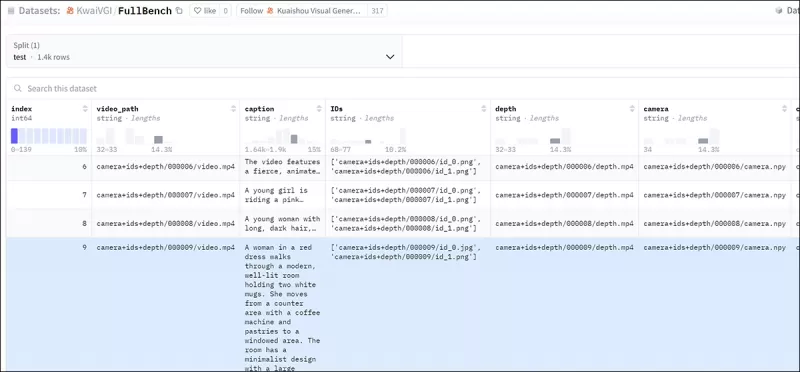

為了有效評估FullDiT並與現有方法進行公平比較,在沒有其他合適基準的情況下,作者引入了**FullBench**,一個包含1,400個獨特測試案例的精選基準套件。

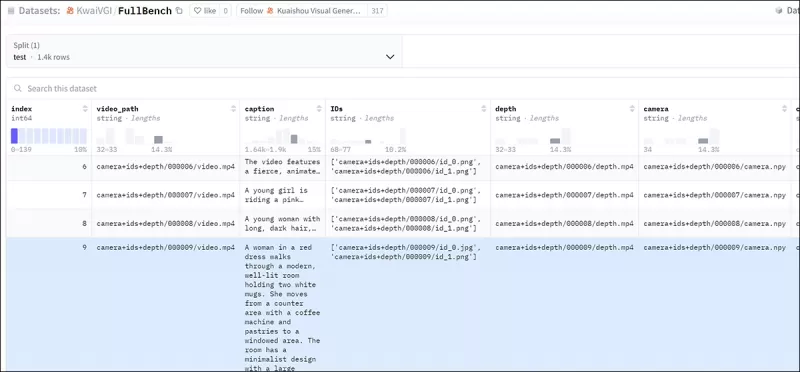

*新FullBench基準的數據瀏覽器實例。* 來源:https://huggingface.co/datasets/KwaiVGI/FullBench

*新FullBench基準的數據瀏覽器實例。* 來源:https://huggingface.co/datasets/KwaiVGI/FullBench

每個數據點為各種條件信號提供真值註釋,包括攝影機運動、身份和深度。

指標

作者使用十個指標評估FullDiT,涵蓋五個主要性能方面:文本對齊、攝影機控制、身份相似性、深度準確性和一般視頻質量。

文本對齊使用CLIP相似性測量,攝影機控制通過旋轉誤差(RotErr)、平移誤差(TransErr)和攝影機運動一致性(CamMC)進行評估,遵循CameraCtrl項目中的CamI2V方法。

身份相似性使用DINO-I和CLIP-I進行評估,深度控制準確性使用平均絕對誤差(MAE)進行量化。

視頻質量使用MiraData的三個指標進行判斷:平滑度的幀級CLIP相似性;動態的光流基運動距離;以及視覺吸引力的LAION-Aesthetic分數。

訓練

作者使用一個內部(未公開)文本到視頻擴散模型訓練FullDiT,該模型包含大約十億個參數。他們有意選擇了適中的參數規模,以保持與先前方法的比較公平性並確保可重現性。

由於訓練視頻的長度和分辨率不同,作者通過調整和填充視頻到統一分辨率、每個序列採樣77幀,並使用應用注意力和損失掩碼來優化訓練效果,從而標準化每個批次。

使用Adam優化器,學習率為1×10−5,在64個NVIDIA H800 GPU集群上進行訓練,總計5,120GB的VRAM(考慮到在愛好者合成社區中,RTX 3090上的24GB仍被認為是豪華標準)。

模型訓練約32,000步,每個視頻最多包含三個身份,以及20幀攝影機條件和21幀深度條件,均從總計77幀中均勻採樣。

對於推理,模型以384×672像素的分辨率生成視頻(大約5秒,15幀每秒),使用50個擴散推理步驟和無分類器指導尺度為5。

先前方法

對於攝影機到視頻評估,作者將FullDiT與MotionCtrl、CameraCtrl和CamI2V進行比較,所有模型均使用RealEstate10k數據集訓練,以確保一致性和公平性。

在身份條件生成中,由於沒有可比較的開源多身份模型,該模型與1B參數的ConceptMaster模型進行基準比較,使用相同的訓練數據和架構。

對於深度到視頻任務,與Ctrl-Adapter和ControlVideo進行比較。

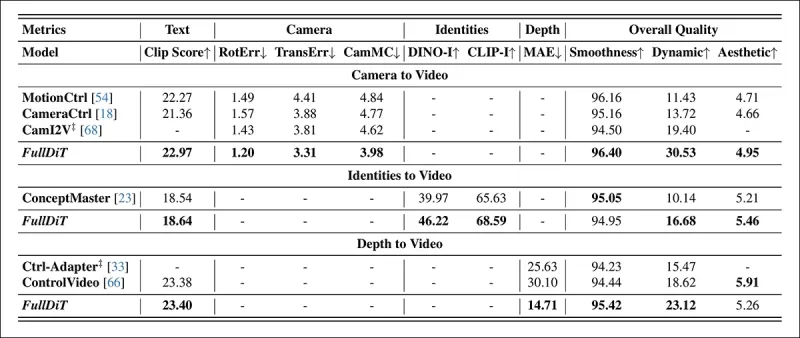

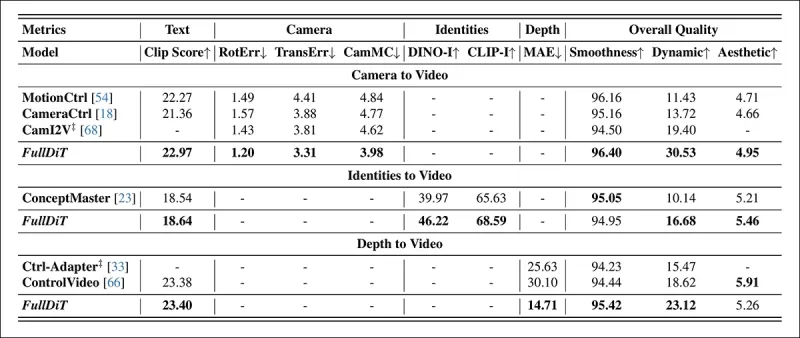

*單任務視頻生成的定量結果。FullDiT與MotionCtrl、CameraCtrl和CamI2V進行攝影機到視頻生成比較;與ConceptMaster(1B參數版本)進行身份到視頻比較;與Ctrl-Adapter和ControlVideo進行深度到視頻比較。所有模型均使用其默認設置進行評估。為保持一致性,從每種方法中均勻採樣16幀,與先前模型的輸出長度匹配。*

*單任務視頻生成的定量結果。FullDiT與MotionCtrl、CameraCtrl和CamI2V進行攝影機到視頻生成比較;與ConceptMaster(1B參數版本)進行身份到視頻比較;與Ctrl-Adapter和ControlVideo進行深度到視頻比較。所有模型均使用其默認設置進行評估。為保持一致性,從每種方法中均勻採樣16幀,與先前模型的輸出長度匹配。*

結果表明,儘管FullDiT同時處理多個條件信號,但在與文本、攝影機運動、身份和深度控制相關的指標中實現了最先進的性能。

在總體質量指標中,該系統通常優於其他方法,儘管其平滑度略低於ConceptMaster。作者評論道:

**‘FullDiT的平滑度略低於ConceptMaster,因為平滑度的計算基於相鄰幀之間的CLIP相似性。由於FullDiT表現出比ConceptMaster顯著更大的動態性,相鄰幀之間的較大變化影響了平滑度指標。’**

**‘對於美學分數,由於評分模型偏好繪畫風格的圖像,而ControlVideo通常生成這種風格的視頻,因此在美學方面獲得高分。’**

關於定性比較,參考FullDiT項目網站的樣本視頻可能更可取,因為PDF示例不可避免是靜態的(而且也太大,無法在此完全重現)。

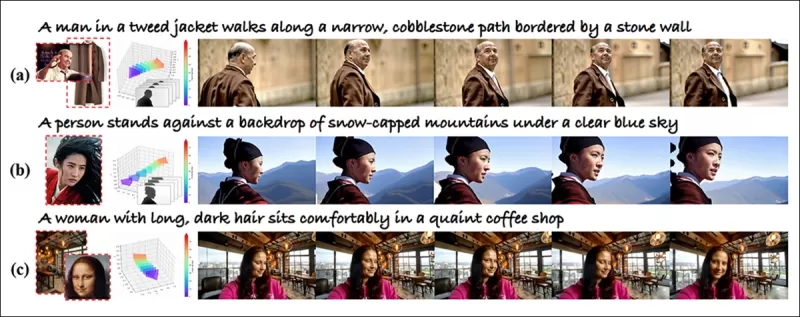

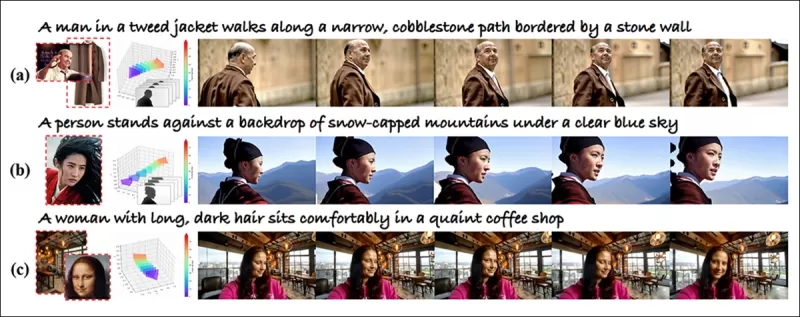

*PDF中重現的定性結果的第一部分。請參閱源論文以獲取額外示例,這些示例過於廣泛,無法在此重現。*

*PDF中重現的定性結果的第一部分。請參閱源論文以獲取額外示例,這些示例過於廣泛,無法在此重現。*

作者評論道:

**‘FullDiT展示了卓越的身份保留能力,並生成比[ConceptMaster]具有更好動態性和視覺質量的視頻。由於ConceptMaster和FullDiT在同一骨架上訓練,這突顯了使用完全注意力進行條件注入的有效性。’**

**‘…[其他]結果展示了FullDiT與現有深度到視頻和攝影機到視頻方法相比的優越可控性和生成質量。’**

*PDF中FullDiT多信號輸出的示例部分。請參閱源論文和項目網站以獲取額外示例。*

*PDF中FullDiT多信號輸出的示例部分。請參閱源論文和項目網站以獲取額外示例。*

結論

FullDiT代表了朝向更全面的視頻基礎模型的激動人心的一步,但問題仍然在於對ControlNet風格功能的需求是否足以證明其大規模實現的合理性,特別是對於開源項目。這些項目在沒有商業支持的情況下很難獲得所需的龐大GPU處理能力。

主要挑戰在於使用像Depth和Pose這樣的系統通常需要對像ComfyUI這樣複雜的用戶界面有非平凡的熟悉度。因此,這種功能性開源模型最有可能由缺乏資源或動機私下策劃和訓練此類模型的小型VFX公司開發。

另一方面,API驅動的“租用AI”系統可能有充分的動機開發更簡單、更用戶友好的解釋方法,適用於具有直接訓練輔助控制系統的模型。

**點擊播放。使用FullDiT對視頻生成施加的深度+文本控制。**

*作者未指定任何已知基礎模型(如SDXL等)。*

**首次發布於2025年3月27日,星期四**

相關文章

騰訊推出HunyuanCustom用於單圖像視頻定制

本文探討騰訊推出的HunyuanCustom,一款多模態視頻生成模型。隨附研究論文的廣泛範圍及項目頁面提供的示例視頻挑戰,需更廣泛的概述,因格式和處理要求限制了大量視頻內容的再現以提高清晰度。請注意,論文中將基於API的生成系統Kling稱為“Keling”。為保持一致性,本文全程使用“Kling”。 騰訊推出其Hunyuan Video模型的進階版本,名為HunyuanCustom。據

騰訊推出HunyuanCustom用於單圖像視頻定制

本文探討騰訊推出的HunyuanCustom,一款多模態視頻生成模型。隨附研究論文的廣泛範圍及項目頁面提供的示例視頻挑戰,需更廣泛的概述,因格式和處理要求限制了大量視頻內容的再現以提高清晰度。請注意,論文中將基於API的生成系統Kling稱為“Keling”。為保持一致性,本文全程使用“Kling”。 騰訊推出其Hunyuan Video模型的進階版本,名為HunyuanCustom。據

在真實視頻內容中揭示微妙而有影響力的AI修改

2019年,當時的美國眾議院議長南希·佩洛西(Nancy Pelosi)的欺騙性視頻廣泛流傳。該視頻被編輯為使她顯得陶醉,這引起了人們對操縱媒體如何誤導公眾多麼容易被誤解的視頻。儘管它很簡單,但這一事件突出了T

在真實視頻內容中揭示微妙而有影響力的AI修改

2019年,當時的美國眾議院議長南希·佩洛西(Nancy Pelosi)的欺騙性視頻廣泛流傳。該視頻被編輯為使她顯得陶醉,這引起了人們對操縱媒體如何誤導公眾多麼容易被誤解的視頻。儘管它很簡單,但這一事件突出了T

Openai計劃將Sora的視頻生成器帶到Chatgpt

OpenAI計劃將其AI視頻生成工具Sora集成到其受歡迎的消費者聊天機器人Chatgpt中。公司領導人在最近的一次不和諧辦公時間會議上揭示了這一點。目前,只有通過OpenAI於12月啟動的專用Web應用程序才能訪問Sora,允許用戶

評論 (2)

0/200

Openai計劃將Sora的視頻生成器帶到Chatgpt

OpenAI計劃將其AI視頻生成工具Sora集成到其受歡迎的消費者聊天機器人Chatgpt中。公司領導人在最近的一次不和諧辦公時間會議上揭示了這一點。目前,只有通過OpenAI於12月啟動的專用Web應用程序才能訪問Sora,允許用戶

評論 (2)

0/200

![CharlesMartinez]() CharlesMartinez

CharlesMartinez

2025-09-04 00:30:37

2025-09-04 00:30:37

Finalmente os vídeos gerados por IA estão evoluindo para algo útil! Mas ainda parece que falta muito pra substituir os efeitos manuais de grandes produções... será que um dia chegaremos lá? 🎥

0

0

![DonaldLee]() DonaldLee

DonaldLee

2025-07-28 09:20:02

2025-07-28 09:20:02

The idea of AI taking over VFX in films is wild! I mean, total control over video generation? That’s some sci-fi stuff coming to life. But I wonder if these models like Hunyuan can really nail the tiny details directors obsess over. Exciting times! 🎥

0

0

像Hunyuan和Wan 2.1這樣的視頻基礎模型已取得顯著進展,但在電影和電視製作中所需的精細控制方面,特別是在視覺效果(VFX)領域,常常表現不足。在專業VFX工作室中,這些模型與早期的基於圖像的模型,如Stable Diffusion、Kandinsky和Flux,結合一系列專為滿足特定創意需求而設計的工具一起使用。當導演要求進行微調,例如說「這看起來很棒,但可以再稍微[n]一點嗎?」,僅僅聲稱模型缺乏精確調整的能力是不夠的。

相反,AI VFX團隊會結合傳統CGI和合成技術,以及自定義開發的工作流程,進一步推動視頻合成的邊界。這種方法類似於使用像Chrome這樣的預設網頁瀏覽器;它開箱即用,但要真正滿足你的需求,你需要安裝一些插件。

控制狂熱者

在基於擴散的圖像合成領域中,最關鍵的第三方系統之一是ControlNet。這項技術為生成模型引入結構化控制,允許用戶通過額外的輸入(如邊緣圖、深度圖或姿態信息)來引導圖像或視頻生成。

*ControlNet的多種方法允許深度>圖像(頂行)、語義分割>圖像(左下)以及人類和動物的姿態引導圖像生成(左下)。*

*ControlNet的多種方法允許深度>圖像(頂行)、語義分割>圖像(左下)以及人類和動物的姿態引導圖像生成(左下)。*

ControlNet不僅依賴文本提示;它使用獨立的神經網絡分支或適配器來處理這些條件信號,同時保持基礎模型的生成能力。這使得高度定制的輸出能夠與用戶規格緊密對齊,對於需要精確控制構圖、結構或運動的應用來說極其寶貴。

*通過引導姿態,ControlNet可以獲得多種精確的輸出類型。* 來源:https://arxiv.org/pdf/2302.05543

*通過引導姿態,ControlNet可以獲得多種精確的輸出類型。* 來源:https://arxiv.org/pdf/2302.05543

然而,這些基於適配器的系統,通過外部操作一組內部聚焦的神經過程,存在幾個缺點。適配器是獨立訓練的,當多個適配器組合時可能導致分支衝突,通常會導致生成質量下降。它們還引入了參數冗餘,每個適配器都需要額外的計算資源和內存,使得擴展效率低下。此外,儘管適配器靈活,但與專為多條件生成完全微調的模型相比,它們的結果往往不夠理想。這些問題可能使基於適配器的方法在需要無縫整合多個控制信號的任務中效果不佳。

理想情況下,ControlNet的功能應以模組化方式原生整合到模型中,允許未來創新,如同時生成視頻/音頻或原生唇部同步功能。目前,每個額外功能要麼成為後期製作任務,要麼是必須在基礎模型敏感權重中導航的非原生程序。

FullDiT

來自中國的新方法FullDiT,將ControlNet風格的功能直接整合到生成視頻模型的訓練過程中,而不是將其視為事後補充。

*來自新論文:FullDiT方法可以將身份強加、深度和攝影機運動融入原生生成,並能同時調用這些功能的任意組合。* 來源:https://arxiv.org/pdf/2503.19907

*來自新論文:FullDiT方法可以將身份強加、深度和攝影機運動融入原生生成,並能同時調用這些功能的任意組合。* 來源:https://arxiv.org/pdf/2503.19907

FullDiT,如論文《FullDiT:具有完全注意力的多任務視頻生成基礎模型》中所述,將多任務條件(如身份轉移、深度映射和攝影機運動)整合到訓練好的生成視頻模型的核心中。作者開發了一個原型模型及相關視頻片段,可在項目網站上查看。

**點擊播放。僅使用原生訓練基礎模型的ControlNet風格用戶強加示例。** 來源:https://fulldit.github.io/

作者將FullDiT作為原生文本到視頻(T2V)和圖像到視頻(I2V)模型的概念驗證,這些模型為用戶提供比僅圖像或文本提示更多的控制。由於不存在類似模型,研究人員創建了一個名為**FullBench**的新基準,用於評估多任務視頻,聲稱在他們設計的測試中達到最先進的性能。然而,由作者自行設計的FullBench的客觀性尚未經過測試,其1,400個案例的數據集可能對於更廣泛的結論來說過於有限。

FullDiT架構最引人注目的方面是其整合新型控制的潛力。作者指出:

**‘在這項工作中,我們僅探索了攝影機、身份和深度信息的控制條件。我們尚未進一步研究其他條件和模態,如音頻、語音、點雲、物體邊界框、光流等。雖然FullDiT的設計可以以最小的架構修改無縫整合其他模態,但如何快速且成本效益高地適應現有模型以應對新條件和模態仍是一個值得進一步探索的重要問題。’**

雖然FullDiT代表了多任務視頻生成的一步進展,但它建立在現有架構之上,而不是引入全新範式。儘管如此,它作為唯一具有原生整合ControlNet風格功能的視頻基礎模型脫穎而出,其架構設計也能適應未來的創新。

**點擊播放。來自項目網站的用戶控制攝影機運動示例。**

該論文由來自快手科技和香港中文大學的九位研究人員撰寫,題為**FullDiT:具有完全注意力的多任務視頻生成基礎模型**。項目頁面和新基準數據可在Hugging Face上獲取。

方法

FullDiT的統一注意力機制旨在通過捕捉條件間的空間和時間關係來增強跨模態表示學習。

*根據新論文,FullDiT通過完全自注意力整合多個輸入條件,將其轉換為統一序列。相比之下,基於適配器的模型(上方最左側)為每個輸入使用獨立模組,導致冗餘、衝突和較弱的性能。*

*根據新論文,FullDiT通過完全自注意力整合多個輸入條件,將其轉換為統一序列。相比之下,基於適配器的模型(上方最左側)為每個輸入使用獨立模組,導致冗餘、衝突和較弱的性能。*

與分別處理每個輸入流的基於適配器設置不同,FullDiT的共享注意力結構避免了分支衝突並減少了參數開銷。作者聲稱該架構可以擴展到新型輸入類型而無需重大重新設計,且模型結構顯示出對訓練中未見過的條件組合的泛化跡象,例如將攝影機運動與角色身份連結。

**點擊播放。來自項目網站的身份生成示例。**

在FullDiT的架構中,所有條件輸入(如文本、攝影機運動、身份和深度)首先被轉換為統一的標記格式。這些標記隨後被拼接成一個長序列,通過一組變換器層使用完全自注意力進行處理。這種方法遵循了Open-Sora Plan和Movie Gen等先前工作的做法。

這種設計使模型能夠聯合學習所有條件的時間和空間關係。每個變換器塊對整個序列進行操作,實現模態間的動態交互,而無需依賴每個輸入的獨立模組。該架構設計為可擴展,使得未來無需重大結構更改即可輕鬆整合額外的控制信號。

三者之力

FullDiT將每個控制信號轉換為標準化標記格式,以便所有條件可以在統一的注意力框架中一起處理。對於攝影機運動,模型為每幀編碼一系列外在參數(如位置和方向)。這些參數帶有時間戳並投影到嵌入向量中,反映信號的時間特性。

身份信息因其本質上是空間而非時間的而被不同處理。模型使用身份圖,指示每個幀的哪些部分存在哪些角色。這些圖被分成小塊,每個小塊投影到一個捕捉空間身份線索的嵌入中,使模型能夠將幀的特定區域與特定實體關聯。

深度是一個時空信號,模型通過將深度視頻分成跨越空間和時間的3D小塊來處理。這些小塊隨後以保留其跨幀結構的方式嵌入。

一旦嵌入,所有這些條件標記(攝影機、身份和深度)被拼接成一個長序列,使FullDiT能夠使用完全自注意力一起處理它們。這種共享表示使模型能夠學習跨模態和跨時間的交互,而無需依賴獨立的處理流。

數據與測試

FullDiT的訓練方法依賴於為每種條件類型量身定制的選擇性註釋數據集,而非要求所有條件同時存在。

對於文本條件,該計劃遵循MiraData項目中概述的結構化標籤方法。

*來自MiraData項目的視頻收集和註釋流程。* 來源:https://arxiv.org/pdf/2407.06358

*來自MiraData項目的視頻收集和註釋流程。* 來源:https://arxiv.org/pdf/2407.06358

對於攝影機運動,RealEstate10K數據集是主要數據來源,因其高質量的攝影機參數真值註釋。然而,作者觀察到僅在像RealEstate10K這樣的靜態場景攝影機數據集上訓練,傾向於減少生成視頻中的動態物體和人類運動。為了解決這個問題,他們使用包含更多動態攝影機運動的內部數據集進行了額外的微調。

身份註釋使用為ConceptMaster項目開發的流程生成,該流程允許高效過濾和提取細粒度的身份信息。

*ConceptMaster框架旨在解決身份解耦問題,同時保留自定義視頻中的概念忠實度。* 來源:https://arxiv.org/pdf/2501.04698

*ConceptMaster框架旨在解決身份解耦問題,同時保留自定義視頻中的概念忠實度。* 來源:https://arxiv.org/pdf/2501.04698

深度註釋從Panda-70M數據集使用Depth Anything獲得。

通過數據排序優化

作者還實施了漸進式訓練計劃,在訓練早期引入更具挑戰性的條件,以確保模型在添加較簡單任務之前獲得穩健的表示。訓練順序從文本到攝影機條件,然後是身份,最後是深度,較簡單的任務通常在後期引入並使用較少的示例。

作者強調了以這種方式安排工作量的價值:

**‘在預訓練階段,我們注意到更具挑戰性的任務需要更長的訓練時間,並應在學習過程中較早引入。這些具挑戰性的任務涉及與輸出視頻顯著不同的複雜數據分佈,要求模型具備足夠的能力來準確捕捉和表示它們。’**

**‘相反,過早引入較簡單的任務可能導致模型優先學習它們,因為它們提供更即時的優化反饋,這會阻礙更具挑戰性任務的收斂。’**

*研究人員採用的數據訓練順序示意圖,紅色表示更大的數據量。*

*研究人員採用的數據訓練順序示意圖,紅色表示更大的數據量。*

在初始預訓練後,最終的微調階段進一步完善了模型,以提高視覺質量和運動動態。此後,訓練遵循標準擴散框架:向視頻潛在變量添加噪聲,模型學習預測並移除噪聲,使用嵌入的條件標記作為指導。

為了有效評估FullDiT並與現有方法進行公平比較,在沒有其他合適基準的情況下,作者引入了**FullBench**,一個包含1,400個獨特測試案例的精選基準套件。

*新FullBench基準的數據瀏覽器實例。* 來源:https://huggingface.co/datasets/KwaiVGI/FullBench

*新FullBench基準的數據瀏覽器實例。* 來源:https://huggingface.co/datasets/KwaiVGI/FullBench

每個數據點為各種條件信號提供真值註釋,包括攝影機運動、身份和深度。

指標

作者使用十個指標評估FullDiT,涵蓋五個主要性能方面:文本對齊、攝影機控制、身份相似性、深度準確性和一般視頻質量。

文本對齊使用CLIP相似性測量,攝影機控制通過旋轉誤差(RotErr)、平移誤差(TransErr)和攝影機運動一致性(CamMC)進行評估,遵循CameraCtrl項目中的CamI2V方法。

身份相似性使用DINO-I和CLIP-I進行評估,深度控制準確性使用平均絕對誤差(MAE)進行量化。

視頻質量使用MiraData的三個指標進行判斷:平滑度的幀級CLIP相似性;動態的光流基運動距離;以及視覺吸引力的LAION-Aesthetic分數。

訓練

作者使用一個內部(未公開)文本到視頻擴散模型訓練FullDiT,該模型包含大約十億個參數。他們有意選擇了適中的參數規模,以保持與先前方法的比較公平性並確保可重現性。

由於訓練視頻的長度和分辨率不同,作者通過調整和填充視頻到統一分辨率、每個序列採樣77幀,並使用應用注意力和損失掩碼來優化訓練效果,從而標準化每個批次。

使用Adam優化器,學習率為1×10−5,在64個NVIDIA H800 GPU集群上進行訓練,總計5,120GB的VRAM(考慮到在愛好者合成社區中,RTX 3090上的24GB仍被認為是豪華標準)。

模型訓練約32,000步,每個視頻最多包含三個身份,以及20幀攝影機條件和21幀深度條件,均從總計77幀中均勻採樣。

對於推理,模型以384×672像素的分辨率生成視頻(大約5秒,15幀每秒),使用50個擴散推理步驟和無分類器指導尺度為5。

先前方法

對於攝影機到視頻評估,作者將FullDiT與MotionCtrl、CameraCtrl和CamI2V進行比較,所有模型均使用RealEstate10k數據集訓練,以確保一致性和公平性。

在身份條件生成中,由於沒有可比較的開源多身份模型,該模型與1B參數的ConceptMaster模型進行基準比較,使用相同的訓練數據和架構。

對於深度到視頻任務,與Ctrl-Adapter和ControlVideo進行比較。

*單任務視頻生成的定量結果。FullDiT與MotionCtrl、CameraCtrl和CamI2V進行攝影機到視頻生成比較;與ConceptMaster(1B參數版本)進行身份到視頻比較;與Ctrl-Adapter和ControlVideo進行深度到視頻比較。所有模型均使用其默認設置進行評估。為保持一致性,從每種方法中均勻採樣16幀,與先前模型的輸出長度匹配。*

*單任務視頻生成的定量結果。FullDiT與MotionCtrl、CameraCtrl和CamI2V進行攝影機到視頻生成比較;與ConceptMaster(1B參數版本)進行身份到視頻比較;與Ctrl-Adapter和ControlVideo進行深度到視頻比較。所有模型均使用其默認設置進行評估。為保持一致性,從每種方法中均勻採樣16幀,與先前模型的輸出長度匹配。*

結果表明,儘管FullDiT同時處理多個條件信號,但在與文本、攝影機運動、身份和深度控制相關的指標中實現了最先進的性能。

在總體質量指標中,該系統通常優於其他方法,儘管其平滑度略低於ConceptMaster。作者評論道:

**‘FullDiT的平滑度略低於ConceptMaster,因為平滑度的計算基於相鄰幀之間的CLIP相似性。由於FullDiT表現出比ConceptMaster顯著更大的動態性,相鄰幀之間的較大變化影響了平滑度指標。’**

**‘對於美學分數,由於評分模型偏好繪畫風格的圖像,而ControlVideo通常生成這種風格的視頻,因此在美學方面獲得高分。’**

關於定性比較,參考FullDiT項目網站的樣本視頻可能更可取,因為PDF示例不可避免是靜態的(而且也太大,無法在此完全重現)。

*PDF中重現的定性結果的第一部分。請參閱源論文以獲取額外示例,這些示例過於廣泛,無法在此重現。*

*PDF中重現的定性結果的第一部分。請參閱源論文以獲取額外示例,這些示例過於廣泛,無法在此重現。*

作者評論道:

**‘FullDiT展示了卓越的身份保留能力,並生成比[ConceptMaster]具有更好動態性和視覺質量的視頻。由於ConceptMaster和FullDiT在同一骨架上訓練,這突顯了使用完全注意力進行條件注入的有效性。’**

**‘…[其他]結果展示了FullDiT與現有深度到視頻和攝影機到視頻方法相比的優越可控性和生成質量。’**

*PDF中FullDiT多信號輸出的示例部分。請參閱源論文和項目網站以獲取額外示例。*

*PDF中FullDiT多信號輸出的示例部分。請參閱源論文和項目網站以獲取額外示例。*

結論

FullDiT代表了朝向更全面的視頻基礎模型的激動人心的一步,但問題仍然在於對ControlNet風格功能的需求是否足以證明其大規模實現的合理性,特別是對於開源項目。這些項目在沒有商業支持的情況下很難獲得所需的龐大GPU處理能力。

主要挑戰在於使用像Depth和Pose這樣的系統通常需要對像ComfyUI這樣複雜的用戶界面有非平凡的熟悉度。因此,這種功能性開源模型最有可能由缺乏資源或動機私下策劃和訓練此類模型的小型VFX公司開發。

另一方面,API驅動的“租用AI”系統可能有充分的動機開發更簡單、更用戶友好的解釋方法,適用於具有直接訓練輔助控制系統的模型。

**點擊播放。使用FullDiT對視頻生成施加的深度+文本控制。**

*作者未指定任何已知基礎模型(如SDXL等)。*

**首次發布於2025年3月27日,星期四**

騰訊推出HunyuanCustom用於單圖像視頻定制

本文探討騰訊推出的HunyuanCustom,一款多模態視頻生成模型。隨附研究論文的廣泛範圍及項目頁面提供的示例視頻挑戰,需更廣泛的概述,因格式和處理要求限制了大量視頻內容的再現以提高清晰度。請注意,論文中將基於API的生成系統Kling稱為“Keling”。為保持一致性,本文全程使用“Kling”。 騰訊推出其Hunyuan Video模型的進階版本,名為HunyuanCustom。據

騰訊推出HunyuanCustom用於單圖像視頻定制

本文探討騰訊推出的HunyuanCustom,一款多模態視頻生成模型。隨附研究論文的廣泛範圍及項目頁面提供的示例視頻挑戰,需更廣泛的概述,因格式和處理要求限制了大量視頻內容的再現以提高清晰度。請注意,論文中將基於API的生成系統Kling稱為“Keling”。為保持一致性,本文全程使用“Kling”。 騰訊推出其Hunyuan Video模型的進階版本,名為HunyuanCustom。據

在真實視頻內容中揭示微妙而有影響力的AI修改

2019年,當時的美國眾議院議長南希·佩洛西(Nancy Pelosi)的欺騙性視頻廣泛流傳。該視頻被編輯為使她顯得陶醉,這引起了人們對操縱媒體如何誤導公眾多麼容易被誤解的視頻。儘管它很簡單,但這一事件突出了T

在真實視頻內容中揭示微妙而有影響力的AI修改

2019年,當時的美國眾議院議長南希·佩洛西(Nancy Pelosi)的欺騙性視頻廣泛流傳。該視頻被編輯為使她顯得陶醉,這引起了人們對操縱媒體如何誤導公眾多麼容易被誤解的視頻。儘管它很簡單,但這一事件突出了T

Openai計劃將Sora的視頻生成器帶到Chatgpt

OpenAI計劃將其AI視頻生成工具Sora集成到其受歡迎的消費者聊天機器人Chatgpt中。公司領導人在最近的一次不和諧辦公時間會議上揭示了這一點。目前,只有通過OpenAI於12月啟動的專用Web應用程序才能訪問Sora,允許用戶

Openai計劃將Sora的視頻生成器帶到Chatgpt

OpenAI計劃將其AI視頻生成工具Sora集成到其受歡迎的消費者聊天機器人Chatgpt中。公司領導人在最近的一次不和諧辦公時間會議上揭示了這一點。目前,只有通過OpenAI於12月啟動的專用Web應用程序才能訪問Sora,允許用戶

2025-09-04 00:30:37

2025-09-04 00:30:37

Finalmente os vídeos gerados por IA estão evoluindo para algo útil! Mas ainda parece que falta muito pra substituir os efeitos manuais de grandes produções... será que um dia chegaremos lá? 🎥

0

0

2025-07-28 09:20:02

2025-07-28 09:20:02

The idea of AI taking over VFX in films is wild! I mean, total control over video generation? That’s some sci-fi stuff coming to life. But I wonder if these models like Hunyuan can really nail the tiny details directors obsess over. Exciting times! 🎥

0

0