本物のビデオコンテンツにおける微妙でありながら影響力のあるAIの変更を発表する

2019年、ナンシー・ペロシ当時の米国下院議長の偽装ビデオが広く拡散しました。このビデオは、彼女が酔っているように見えるよう編集されており、メディアが簡単に操作され、国民を誤解させる可能性があることを明確に示しました。この単純な事件は、基本的な音声ビジュアル編集でも潜在的な損害を引き起こす可能性があることを浮き彫りにしました。

当時、ディープフェイクの状況は、主に2017年後半から存在していたオートエンコーダベースの顔交換技術によって支配されていました。これらの初期システムは、ペロシのビデオで見られた微妙な変更を行うのに苦労し、より明らかな顔の交換に焦点を当てていました。

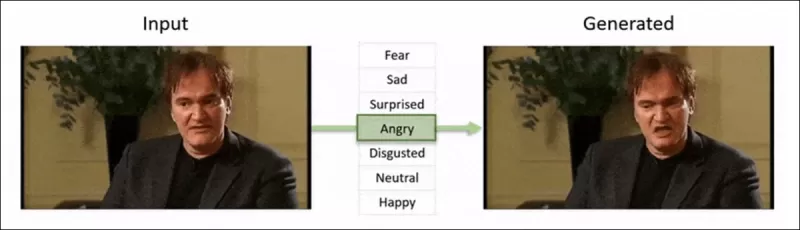

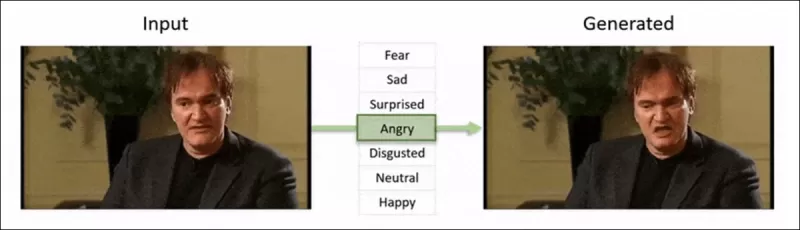

2022年の「Neural Emotion Director」フレームワークは、有名な顔の雰囲気を変えます。 出典: https://www.youtube.com/watch?v=Li6W8pRDMJQ

2022年の「Neural Emotion Director」フレームワークは、有名な顔の雰囲気を変えます。 出典: https://www.youtube.com/watch?v=Li6W8pRDMJQ

現在に早送りすると、映画やテレビ業界はますますAI駆動のポストプロダクション編集を模索しています。このトレンドは、AIが以前は達成できなかった完璧主義を可能にするため、関心と批判の両方を引き起こしています。これに対応して、研究コミュニティは、Diffusion Video Autoencoders、Stitch it in Time、ChatFace、MagicFace、DISCOなどの顔のキャプチャの「ローカル編集」に焦点を当てたさまざまなプロジェクトを開発しました。

2025年1月のプロジェクトMagicFaceによる表情編集。 出典: https://arxiv.org/pdf/2501.02260

2025年1月のプロジェクトMagicFaceによる表情編集。 出典: https://arxiv.org/pdf/2501.02260

新しい顔、新しい課題

しかし、これらの微妙な編集を作成する技術は、検出する能力よりもはるかに速く進化しています。ほとんどのディープフェイク検出方法は、古い技術やデータセットに焦点を当てており、時代遅れです。それが、インドの研究者による最近のブレークスルーまででした。

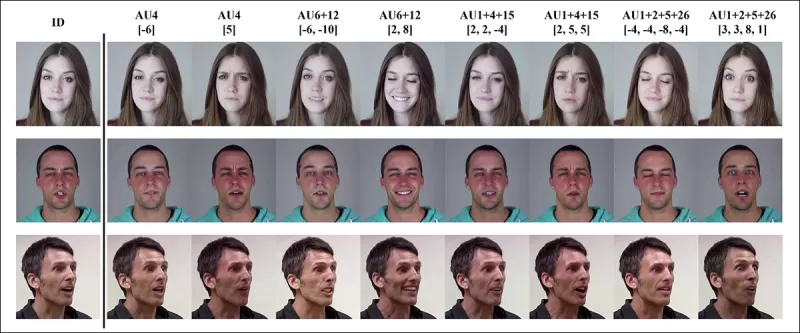

ディープフェイクの微妙なローカル編集の検出:実際のビデオが、眉毛の上げ下げ、性別特徴の変更、嫌悪感への表情の変化(ここでは1フレームで示されています)などの微妙な変更を加えて偽物を作成するために改変されます。 出典: https://arxiv.org/pdf/2503.22121

ディープフェイクの微妙なローカル編集の検出:実際のビデオが、眉毛の上げ下げ、性別特徴の変更、嫌悪感への表情の変化(ここでは1フレームで示されています)などの微妙な変更を加えて偽物を作成するために改変されます。 出典: https://arxiv.org/pdf/2503.22121

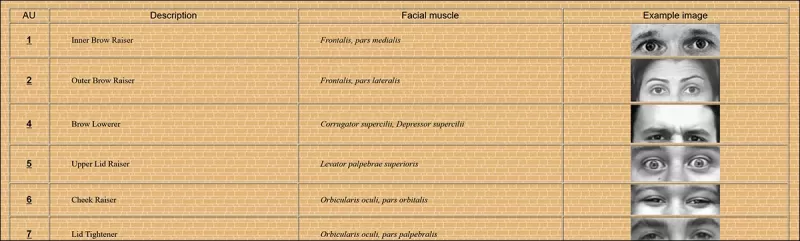

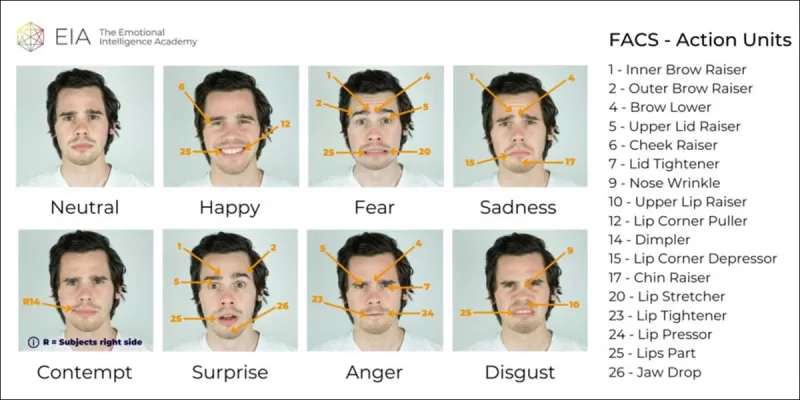

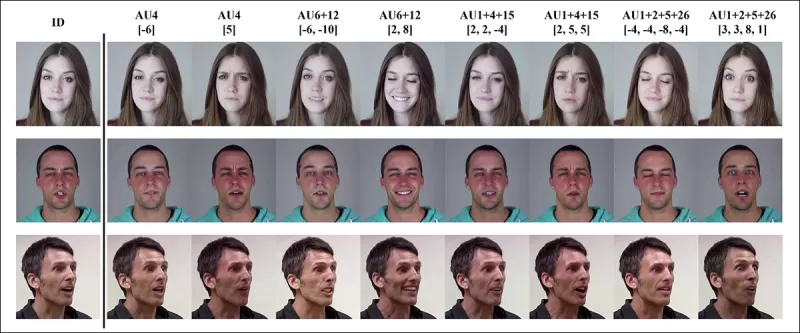

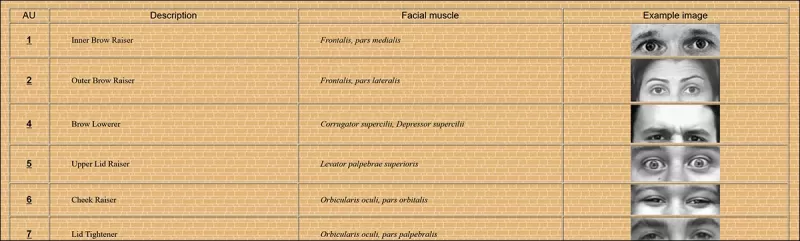

この新しい研究は、しばしば見過ごされる微妙な局所的な顔の操作の検出を対象としています。広範な不一致やアイデンティティの不一致を探す代わりに、この方法は、わずかな表情の変化や特定の顔の特徴に対する小さな編集のような細かい詳細に焦点を当てます。これは、顔の表情を64の可変領域に分解するFacial Action Coding System(FACS)を活用しています。

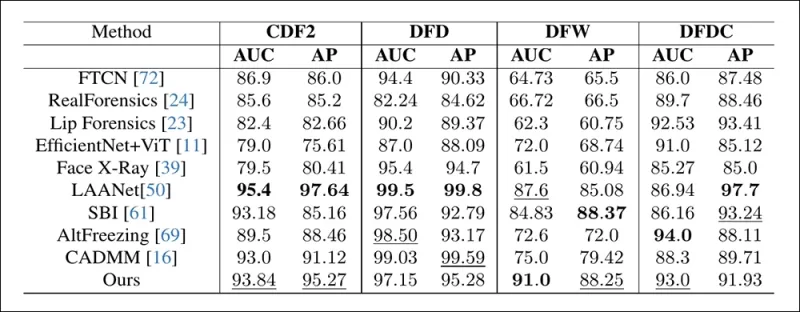

FACSの64の表情構成要素の一部。 出典: https://www.cs.cmu.edu/~face/facs.htm

FACSの64の表情構成要素の一部。 出典: https://www.cs.cmu.edu/~face/facs.htm

研究者たちは、さまざまな最近の編集方法に対してアプローチをテストし、古いデータセットや新しい攻撃ベクトルでも既存のソリューションを一貫して上回ることを確認しました。

「マスクドオートエンコーダ(MAE)を通じて学習されたビデオ表現をAUベースの特徴を使用してガイドすることで、微妙な顔の編集を検出するために重要なローカライズされた変更を効果的に捉えます。」

「このアプローチにより、顔中心のビデオにおけるローカライズされた編集とより広範な変更の両方をエンコードする統一された潜在表現を構築でき、ディープフェイク検出のための包括的かつ適応可能なソリューションを提供します。」

この論文は、アクションユニットガイド付きビデオ表現を使用したローカライズされたディープフェイク操作の検出というタイトルで、インド工科大学マドラス校の研究者によって執筆されました。

方法

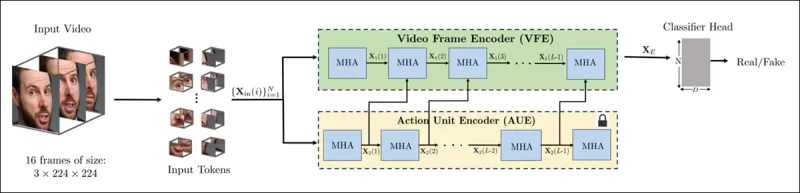

この方法は、ビデオ内で顔を検出し、顔を中心に均等に配置されたフレームをサンプリングすることから始まります。これらのフレームは、局所的な空間的および時間的詳細を捉える小さな3Dパッチに分解されます。

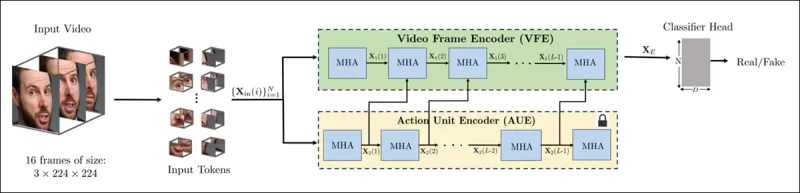

新しい方法のスキーマ。入力ビデオは顔検出で処理され、均等に配置された顔中心のフレームが抽出され、「チューブ状」のパッチに分割され、2つの事前学習されたプレテキストタスクからの潜在表現を融合するエンコーダに通されます。結果のベクトルは、ビデオが本物か偽物かを判断する分類器によって使用されます。

新しい方法のスキーマ。入力ビデオは顔検出で処理され、均等に配置された顔中心のフレームが抽出され、「チューブ状」のパッチに分割され、2つの事前学習されたプレテキストタスクからの潜在表現を融合するエンコーダに通されます。結果のベクトルは、ビデオが本物か偽物かを判断する分類器によって使用されます。

各パッチには、連続する数フレームの小さなピクセルウィンドウが含まれており、モデルが短期的な動きや表情の変化を学習できるようにします。これらのパッチは埋め込みおよび位置エンコーディングされ、本物と偽物のビデオを区別するように設計されたエンコーダに供給されます。

微妙な操作の検出の課題は、クロスアテンションメカニズムを通じて2種類の学習された表現を組み合わせるエンコーダを使用することで対処され、より敏感で一般化可能な特徴空間の作成を目指します。

プレテキストタスク

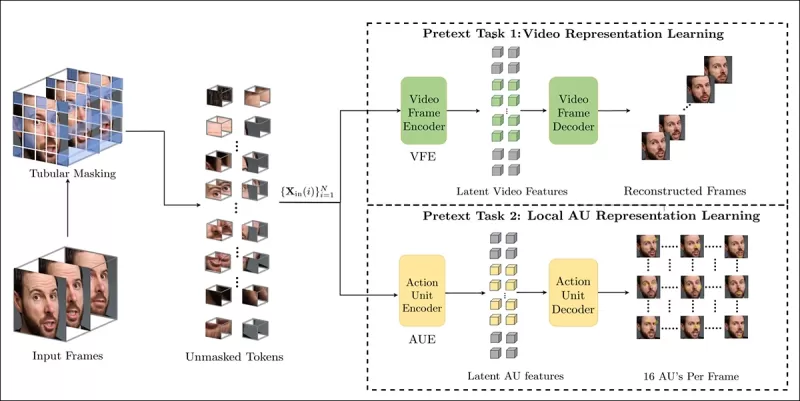

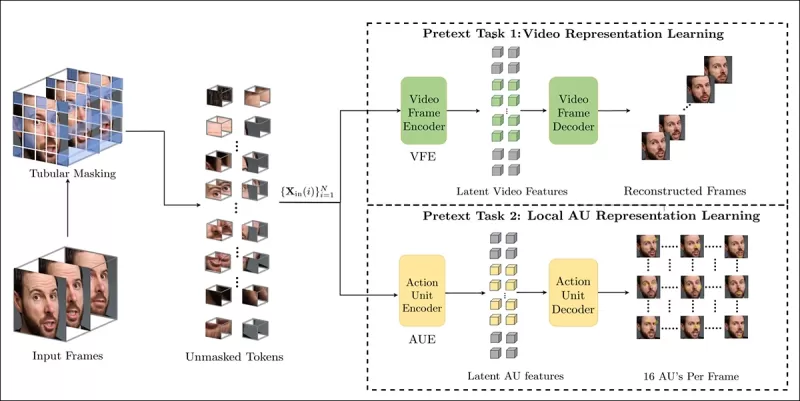

最初の表現は、マスクされたオートエンコーディングタスクでトレーニングされたエンコーダから得られます。ビデオの3Dパッチのほとんどを隠すことで、エンコーダは欠けている部分を再構築することを学習し、顔の動きなどの重要な時空間パターンを捉えます。

プレテキストタスクのトレーニングは、ビデオ入力の一部をマスクし、エンコーダ-デコーダ設定を使用して、元のフレームまたはフレームごとのアクションユニットマップを再構築します(タスクによる)。

プレテキストタスクのトレーニングは、ビデオ入力の一部をマスクし、エンコーダ-デコーダ設定を使用して、元のフレームまたはフレームごとのアクションユニットマップを再構築します(タスクによる)。

しかし、これだけでは細かい編集を検出するのに十分ではありません。研究者たちは、微妙なディープフェイク編集が頻繁に発生する局所的な筋肉活動に焦点を当てるよう促す、顔のアクションユニット(AU)を検出するためにトレーニングされた2番目のエンコーダを導入しました。

顔のアクションユニット(FAUs、またはAUs)のさらなる例。 出典: https://www.eiagroup.com/the-facial-action-coding-system/

顔のアクションユニット(FAUs、またはAUs)のさらなる例。 出典: https://www.eiagroup.com/the-facial-action-coding-system/

事前トレーニング後、両方のエンコーダの出力はクロスアテンションを使用して結合され、AUベースの特徴が空間-時間的特徴に対する注意をガイドします。これにより、広範な動きのコンテキストと局所的な表情の詳細の両方を捉える融合された潜在表現が生成され、最終的な分類タスクに使用されます。

データとテスト

実装

このシステムは、FaceXZoo PyTorchベースの顔検出フレームワークを使用して実装され、各ビデオクリップから16の顔中心のフレームを抽出しました。プレテキストタスクは、35,000の高品質な顔ビデオを含むCelebV-HQデータセットでトレーニングされました。

出典論文から、新しいプロジェクトで使用されたCelebV-HQデータセットの例。 出典: https://arxiv.org/pdf/2207.12393

出典論文から、新しいプロジェクトで使用されたCelebV-HQデータセットの例。 出典: https://arxiv.org/pdf/2207.12393

データの半分は過学習を防ぐためにマスクされました。マスクされたフレーム再構築タスクでは、モデルはL1ロスを使用して欠落領域を予測するようにトレーニングされました。2番目のタスクでは、16の顔のアクションユニットのマップを生成するようにトレーニングされ、L1ロスによって監督されました。

事前トレーニング後、エンコーダは融合され、FaceForensics++データセットを使用してディープフェイク検出のために微調整されました。このデータセットには、本物と操作されたビデオの両方が含まれています。

FaceForensics++データセットは、2017年以来ディープフェイク検出の基盤でしたが、最新の顔合成技術に関しては現在かなり時代遅れです。 出典: https://www.youtube.com/watch?v=x2g48Q2I2ZQ

FaceForensics++データセットは、2017年以来ディープフェイク検出の基盤でしたが、最新の顔合成技術に関しては現在かなり時代遅れです。 出典: https://www.youtube.com/watch?v=x2g48Q2I2ZQ

クラスの不均衡に対処するために、著者はFocal Lossを使用して、トレーニング中に難しい例を強調しました。すべてのトレーニングは、VideoMAEから事前トレーニングされたチェックポイントを使用して、24GbのVRAMを備えた単一のRTX 4090 GPUで実施されました。

テスト

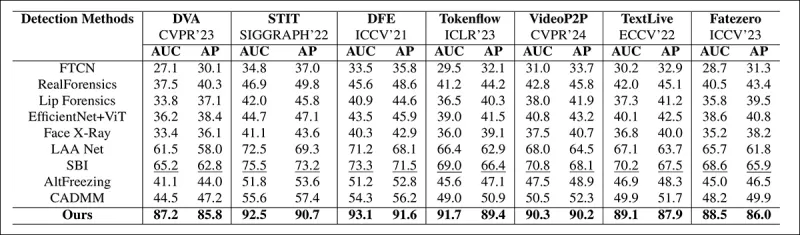

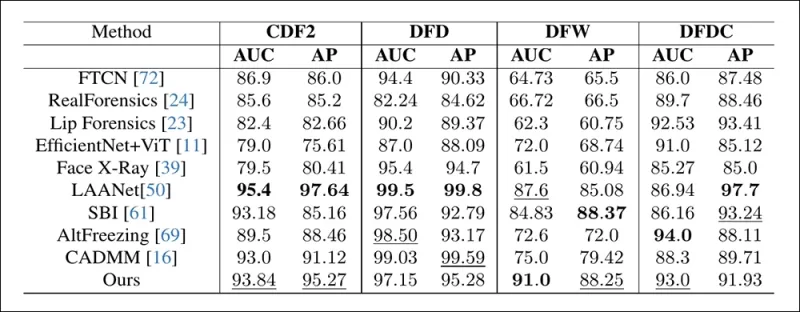

この方法は、局所的に編集されたディープフェイクに焦点を当て、さまざまなディープフェイク検出技術に対して評価されました。テストには、さまざまな編集方法と古いディープフェイクデータセットが含まれ、Area Under Curve(AUC)、Average Precision、Mean F1 Scoreなどの指標を使用しました。

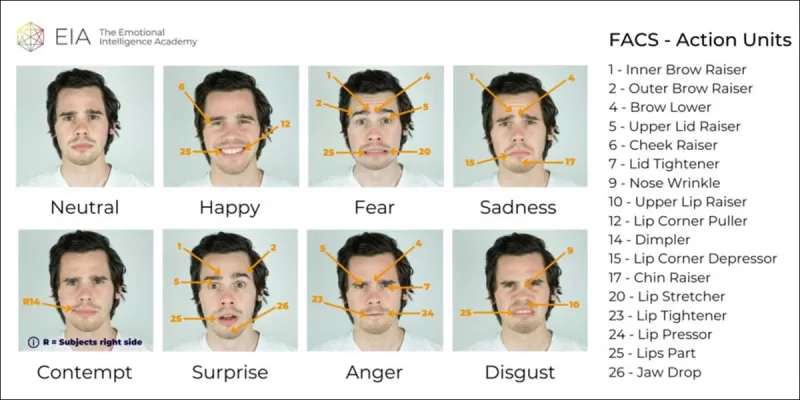

論文から:最近の局所的なディープフェイクに関する比較では、提案された方法が他のすべての方法を上回り、AUCと平均精度で次に優れたアプローチよりも15〜20パーセントの向上を示しました。

論文から:最近の局所的なディープフェイクに関する比較では、提案された方法が他のすべての方法を上回り、AUCと平均精度で次に優れたアプローチよりも15〜20パーセントの向上を示しました。

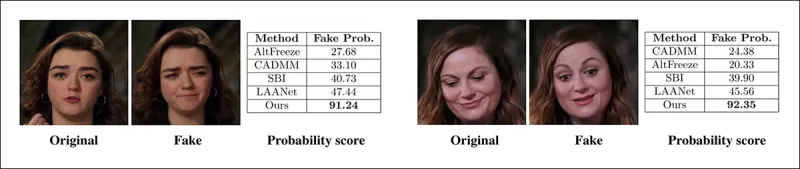

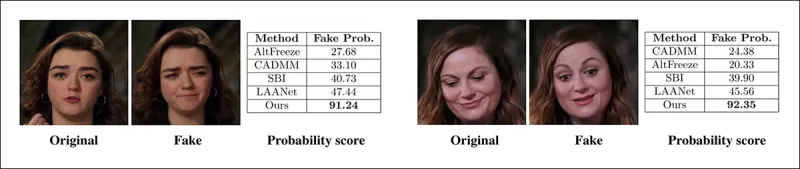

著者は、局所的に操作されたビデオの視覚的比較を提供し、提案された方法の微妙な編集に対する優れた感度を示しました。

実際のビデオが3つの異なる局所的な操作を使用して改変され、オリジナルに視覚的に似た偽物が生成されました。ここでは、各方法の平均偽物検出スコアとともに代表的なフレームが示されています。既存の検出器はこれらの微妙な編集に苦労しましたが、提案されたモデルは一貫して高い偽物確率を割り当て、局所的な変更に対する高い感度を示しました。

実際のビデオが3つの異なる局所的な操作を使用して改変され、オリジナルに視覚的に似た偽物が生成されました。ここでは、各方法の平均偽物検出スコアとともに代表的なフレームが示されています。既存の検出器はこれらの微妙な編集に苦労しましたが、提案されたモデルは一貫して高い偽物確率を割り当て、局所的な変更に対する高い感度を示しました。

研究者たちは、既存の最先端の検出方法が最新のディープフェイク生成技術に苦労している一方で、彼らの方法は高いAUCと平均精度スコアを達成し、堅牢な一般化を示したと述べました。

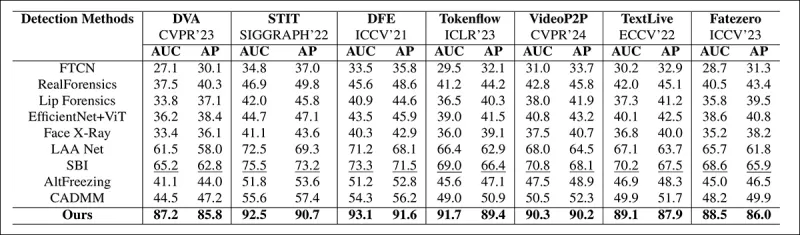

従来のディープフェイクデータセットでのパフォーマンスは、提案された方法が主要なアプローチと競争力があり、さまざまな操作タイプにわたる強い一般化を示していることを示しています。

従来のディープフェイクデータセットでのパフォーマンスは、提案された方法が主要なアプローチと競争力があり、さまざまな操作タイプにわたる強い一般化を示していることを示しています。

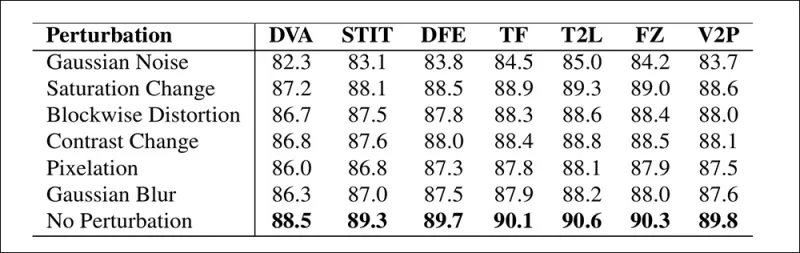

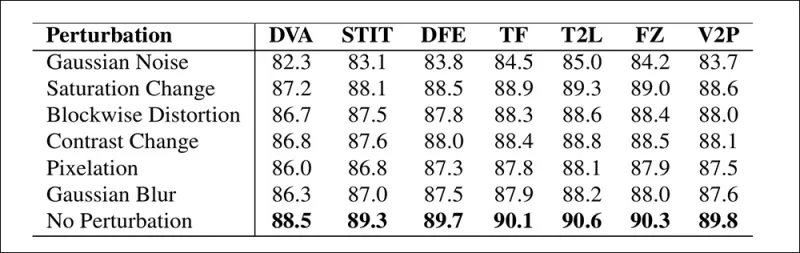

著者はまた、現実の条件下でのモデルの信頼性をテストし、彩度の調整、ガウスぼかし、ピクセル化などの一般的なビデオ歪みに対して耐性があることを確認しました。

異なるビデオ歪み下での検出精度の変化の図。新しい方法はほとんどの場合で耐性を示し、AUCのわずかな低下にとどまりました。最も顕著な低下はガウスノイズが導入された場合に発生しました。

異なるビデオ歪み下での検出精度の変化の図。新しい方法はほとんどの場合で耐性を示し、AUCのわずかな低下にとどまりました。最も顕著な低下はガウスノイズが導入された場合に発生しました。

結論

一般の人々はディープフェイクをアイデンティティの交換と考えることが多いですが、AI操作の現実はより微妙で、潜在的により危険です。この新しい研究で議論されたローカル編集の種類は、別の注目すべき事件が起こるまで一般の注目を集めないかもしれません。しかし、俳優のニク・ケイジが指摘したように、ポストプロダクション編集がパフォーマンスを変更する可能性は、誰もが認識すべき懸念です。私たちは顔の表情のわずかな変化にも自然に敏感であり、コンテキストはそれらの影響を劇的に変えることができます。

最初に公開されたのは2025年4月2日水曜日

関連記事

TencentがHunyuanCustomを発表、単一画像でのビデオカスタマイズが可能

この記事では、Tencentが発表したマルチモーダルビデオ生成モデルであるHunyuanCustomのリリースについて探ります。付随する研究論文の広範な内容とプロジェクトページに提供されたサンプルビデオの課題により、フォーマットと処理の要件により広範な概要が必要であり、広範なビデオコンテンツの再現は限定的です。なお、論文ではAPIベースの生成システムKlingを「Keling」と記載しています。一

TencentがHunyuanCustomを発表、単一画像でのビデオカスタマイズが可能

この記事では、Tencentが発表したマルチモーダルビデオ生成モデルであるHunyuanCustomのリリースについて探ります。付随する研究論文の広範な内容とプロジェクトページに提供されたサンプルビデオの課題により、フォーマットと処理の要件により広範な概要が必要であり、広範なビデオコンテンツの再現は限定的です。なお、論文ではAPIベースの生成システムKlingを「Keling」と記載しています。一

Civitaiは、MasterCardとVisaからの圧力の中で深海規制を強化します

インターネット上で最も顕著なAIモデルリポジトリの1つであるCivitaiは、最近、特に有名人のLorasに関して、NSFWコンテンツに関するポリシーに大きな変更を加えました。これらの変更は、支払いファシリテーターのマスターカードとビザからの圧力によって拍車がかかりました。有名人のロラ、それはあなたです

Civitaiは、MasterCardとVisaからの圧力の中で深海規制を強化します

インターネット上で最も顕著なAIモデルリポジトリの1つであるCivitaiは、最近、特に有名人のLorasに関して、NSFWコンテンツに関するポリシーに大きな変更を加えました。これらの変更は、支払いファシリテーターのマスターカードとビザからの圧力によって拍車がかかりました。有名人のロラ、それはあなたです

GoogleはAIを利用して、詐欺の疑いのために3900万を超える広告アカウントを一時停止します

Googleは水曜日に、2024年にプラットフォームで驚異的な3920万の広告主アカウントを停止することにより、広告詐欺との大きな一歩を踏み出したと発表しました。

コメント (43)

0/200

GoogleはAIを利用して、詐欺の疑いのために3900万を超える広告アカウントを一時停止します

Googleは水曜日に、2024年にプラットフォームで驚異的な3920万の広告主アカウントを停止することにより、広告詐欺との大きな一歩を踏み出したと発表しました。

コメント (43)

0/200

![WilliamCarter]() WilliamCarter

WilliamCarter

2025年8月20日 6:01:13 JST

2025年8月20日 6:01:13 JST

That Pelosi video from 2019 is wild! It’s scary how a few tweaks can make someone look totally drunk. AI’s power to mess with videos is both cool and creepy—makes you wonder what’s real anymore. 😬

0

0

![JuanMartínez]() JuanMartínez

JuanMartínez

2025年8月20日 2:01:10 JST

2025年8月20日 2:01:10 JST

This Pelosi video incident is wild! 🤯 It’s scary how a few tweaks can make someone look totally out of it. Makes me wonder how much of what we see online is real anymore. AI’s cool, but this kind of stuff could mess with trust big time.

0

0

![RyanPerez]() RyanPerez

RyanPerez

2025年7月29日 21:25:16 JST

2025年7月29日 21:25:16 JST

That Pelosi video from 2019 is wild! It’s scary how a few tweaks can make someone look totally out of it. AI’s power to mess with reality is no joke—makes you wonder what’s real anymore. 🫣

0

0

![MarkRoberts]() MarkRoberts

MarkRoberts

2025年4月24日 11:24:54 JST

2025年4月24日 11:24:54 JST

Este herramienta de IA me mostró lo fácil que es manipular videos. El incidente de Nancy Pelosi fue un recordatorio impactante. Es aterrador pensar en cuántas noticias falsas pueden existir. Ahora estoy más atento a lo que creo en línea. ¡Cuidado, amigos! 👀

0

0

![RobertMartin]() RobertMartin

RobertMartin

2025年4月21日 5:42:51 JST

2025年4月21日 5:42:51 JST

このAIツールは、ビデオを操作するのがどれほど簡単かを教えてくれました。ナンシー・ペロシの事件は衝撃的でした。偽ニュースがどれだけあるかと思うと恐ろしいです。オンラインで何を信じるかについて、今はもっと注意しています。みなさんも気をつけてくださいね!👀

0

0

![PaulMartínez]() PaulMartínez

PaulMartínez

2025年4月19日 19:25:50 JST

2025年4月19日 19:25:50 JST

Dieses KI-Tool hat mir gezeigt, wie einfach es ist, Videos zu manipulieren! Der Vorfall mit Nancy Pelosi war ein Weckruf. Es ist beängstigend, wie viele gefälschte Nachrichten es geben könnte. Ich bin jetzt vorsichtiger mit dem, was ich online glaube. Seid wachsam, Leute! 👀

0

0

2019年、ナンシー・ペロシ当時の米国下院議長の偽装ビデオが広く拡散しました。このビデオは、彼女が酔っているように見えるよう編集されており、メディアが簡単に操作され、国民を誤解させる可能性があることを明確に示しました。この単純な事件は、基本的な音声ビジュアル編集でも潜在的な損害を引き起こす可能性があることを浮き彫りにしました。

当時、ディープフェイクの状況は、主に2017年後半から存在していたオートエンコーダベースの顔交換技術によって支配されていました。これらの初期システムは、ペロシのビデオで見られた微妙な変更を行うのに苦労し、より明らかな顔の交換に焦点を当てていました。

2022年の「Neural Emotion Director」フレームワークは、有名な顔の雰囲気を変えます。 出典: https://www.youtube.com/watch?v=Li6W8pRDMJQ

2022年の「Neural Emotion Director」フレームワークは、有名な顔の雰囲気を変えます。 出典: https://www.youtube.com/watch?v=Li6W8pRDMJQ

現在に早送りすると、映画やテレビ業界はますますAI駆動のポストプロダクション編集を模索しています。このトレンドは、AIが以前は達成できなかった完璧主義を可能にするため、関心と批判の両方を引き起こしています。これに対応して、研究コミュニティは、Diffusion Video Autoencoders、Stitch it in Time、ChatFace、MagicFace、DISCOなどの顔のキャプチャの「ローカル編集」に焦点を当てたさまざまなプロジェクトを開発しました。

2025年1月のプロジェクトMagicFaceによる表情編集。 出典: https://arxiv.org/pdf/2501.02260

2025年1月のプロジェクトMagicFaceによる表情編集。 出典: https://arxiv.org/pdf/2501.02260

新しい顔、新しい課題

しかし、これらの微妙な編集を作成する技術は、検出する能力よりもはるかに速く進化しています。ほとんどのディープフェイク検出方法は、古い技術やデータセットに焦点を当てており、時代遅れです。それが、インドの研究者による最近のブレークスルーまででした。

ディープフェイクの微妙なローカル編集の検出:実際のビデオが、眉毛の上げ下げ、性別特徴の変更、嫌悪感への表情の変化(ここでは1フレームで示されています)などの微妙な変更を加えて偽物を作成するために改変されます。 出典: https://arxiv.org/pdf/2503.22121

ディープフェイクの微妙なローカル編集の検出:実際のビデオが、眉毛の上げ下げ、性別特徴の変更、嫌悪感への表情の変化(ここでは1フレームで示されています)などの微妙な変更を加えて偽物を作成するために改変されます。 出典: https://arxiv.org/pdf/2503.22121

この新しい研究は、しばしば見過ごされる微妙な局所的な顔の操作の検出を対象としています。広範な不一致やアイデンティティの不一致を探す代わりに、この方法は、わずかな表情の変化や特定の顔の特徴に対する小さな編集のような細かい詳細に焦点を当てます。これは、顔の表情を64の可変領域に分解するFacial Action Coding System(FACS)を活用しています。

FACSの64の表情構成要素の一部。 出典: https://www.cs.cmu.edu/~face/facs.htm

FACSの64の表情構成要素の一部。 出典: https://www.cs.cmu.edu/~face/facs.htm

研究者たちは、さまざまな最近の編集方法に対してアプローチをテストし、古いデータセットや新しい攻撃ベクトルでも既存のソリューションを一貫して上回ることを確認しました。

「マスクドオートエンコーダ(MAE)を通じて学習されたビデオ表現をAUベースの特徴を使用してガイドすることで、微妙な顔の編集を検出するために重要なローカライズされた変更を効果的に捉えます。」

「このアプローチにより、顔中心のビデオにおけるローカライズされた編集とより広範な変更の両方をエンコードする統一された潜在表現を構築でき、ディープフェイク検出のための包括的かつ適応可能なソリューションを提供します。」

この論文は、アクションユニットガイド付きビデオ表現を使用したローカライズされたディープフェイク操作の検出というタイトルで、インド工科大学マドラス校の研究者によって執筆されました。

方法

この方法は、ビデオ内で顔を検出し、顔を中心に均等に配置されたフレームをサンプリングすることから始まります。これらのフレームは、局所的な空間的および時間的詳細を捉える小さな3Dパッチに分解されます。

新しい方法のスキーマ。入力ビデオは顔検出で処理され、均等に配置された顔中心のフレームが抽出され、「チューブ状」のパッチに分割され、2つの事前学習されたプレテキストタスクからの潜在表現を融合するエンコーダに通されます。結果のベクトルは、ビデオが本物か偽物かを判断する分類器によって使用されます。

新しい方法のスキーマ。入力ビデオは顔検出で処理され、均等に配置された顔中心のフレームが抽出され、「チューブ状」のパッチに分割され、2つの事前学習されたプレテキストタスクからの潜在表現を融合するエンコーダに通されます。結果のベクトルは、ビデオが本物か偽物かを判断する分類器によって使用されます。

各パッチには、連続する数フレームの小さなピクセルウィンドウが含まれており、モデルが短期的な動きや表情の変化を学習できるようにします。これらのパッチは埋め込みおよび位置エンコーディングされ、本物と偽物のビデオを区別するように設計されたエンコーダに供給されます。

微妙な操作の検出の課題は、クロスアテンションメカニズムを通じて2種類の学習された表現を組み合わせるエンコーダを使用することで対処され、より敏感で一般化可能な特徴空間の作成を目指します。

プレテキストタスク

最初の表現は、マスクされたオートエンコーディングタスクでトレーニングされたエンコーダから得られます。ビデオの3Dパッチのほとんどを隠すことで、エンコーダは欠けている部分を再構築することを学習し、顔の動きなどの重要な時空間パターンを捉えます。

プレテキストタスクのトレーニングは、ビデオ入力の一部をマスクし、エンコーダ-デコーダ設定を使用して、元のフレームまたはフレームごとのアクションユニットマップを再構築します(タスクによる)。

プレテキストタスクのトレーニングは、ビデオ入力の一部をマスクし、エンコーダ-デコーダ設定を使用して、元のフレームまたはフレームごとのアクションユニットマップを再構築します(タスクによる)。

しかし、これだけでは細かい編集を検出するのに十分ではありません。研究者たちは、微妙なディープフェイク編集が頻繁に発生する局所的な筋肉活動に焦点を当てるよう促す、顔のアクションユニット(AU)を検出するためにトレーニングされた2番目のエンコーダを導入しました。

顔のアクションユニット(FAUs、またはAUs)のさらなる例。 出典: https://www.eiagroup.com/the-facial-action-coding-system/

顔のアクションユニット(FAUs、またはAUs)のさらなる例。 出典: https://www.eiagroup.com/the-facial-action-coding-system/

事前トレーニング後、両方のエンコーダの出力はクロスアテンションを使用して結合され、AUベースの特徴が空間-時間的特徴に対する注意をガイドします。これにより、広範な動きのコンテキストと局所的な表情の詳細の両方を捉える融合された潜在表現が生成され、最終的な分類タスクに使用されます。

データとテスト

実装

このシステムは、FaceXZoo PyTorchベースの顔検出フレームワークを使用して実装され、各ビデオクリップから16の顔中心のフレームを抽出しました。プレテキストタスクは、35,000の高品質な顔ビデオを含むCelebV-HQデータセットでトレーニングされました。

出典論文から、新しいプロジェクトで使用されたCelebV-HQデータセットの例。 出典: https://arxiv.org/pdf/2207.12393

出典論文から、新しいプロジェクトで使用されたCelebV-HQデータセットの例。 出典: https://arxiv.org/pdf/2207.12393

データの半分は過学習を防ぐためにマスクされました。マスクされたフレーム再構築タスクでは、モデルはL1ロスを使用して欠落領域を予測するようにトレーニングされました。2番目のタスクでは、16の顔のアクションユニットのマップを生成するようにトレーニングされ、L1ロスによって監督されました。

事前トレーニング後、エンコーダは融合され、FaceForensics++データセットを使用してディープフェイク検出のために微調整されました。このデータセットには、本物と操作されたビデオの両方が含まれています。

FaceForensics++データセットは、2017年以来ディープフェイク検出の基盤でしたが、最新の顔合成技術に関しては現在かなり時代遅れです。 出典: https://www.youtube.com/watch?v=x2g48Q2I2ZQ

FaceForensics++データセットは、2017年以来ディープフェイク検出の基盤でしたが、最新の顔合成技術に関しては現在かなり時代遅れです。 出典: https://www.youtube.com/watch?v=x2g48Q2I2ZQ

クラスの不均衡に対処するために、著者はFocal Lossを使用して、トレーニング中に難しい例を強調しました。すべてのトレーニングは、VideoMAEから事前トレーニングされたチェックポイントを使用して、24GbのVRAMを備えた単一のRTX 4090 GPUで実施されました。

テスト

この方法は、局所的に編集されたディープフェイクに焦点を当て、さまざまなディープフェイク検出技術に対して評価されました。テストには、さまざまな編集方法と古いディープフェイクデータセットが含まれ、Area Under Curve(AUC)、Average Precision、Mean F1 Scoreなどの指標を使用しました。

論文から:最近の局所的なディープフェイクに関する比較では、提案された方法が他のすべての方法を上回り、AUCと平均精度で次に優れたアプローチよりも15〜20パーセントの向上を示しました。

論文から:最近の局所的なディープフェイクに関する比較では、提案された方法が他のすべての方法を上回り、AUCと平均精度で次に優れたアプローチよりも15〜20パーセントの向上を示しました。

著者は、局所的に操作されたビデオの視覚的比較を提供し、提案された方法の微妙な編集に対する優れた感度を示しました。

実際のビデオが3つの異なる局所的な操作を使用して改変され、オリジナルに視覚的に似た偽物が生成されました。ここでは、各方法の平均偽物検出スコアとともに代表的なフレームが示されています。既存の検出器はこれらの微妙な編集に苦労しましたが、提案されたモデルは一貫して高い偽物確率を割り当て、局所的な変更に対する高い感度を示しました。

実際のビデオが3つの異なる局所的な操作を使用して改変され、オリジナルに視覚的に似た偽物が生成されました。ここでは、各方法の平均偽物検出スコアとともに代表的なフレームが示されています。既存の検出器はこれらの微妙な編集に苦労しましたが、提案されたモデルは一貫して高い偽物確率を割り当て、局所的な変更に対する高い感度を示しました。

研究者たちは、既存の最先端の検出方法が最新のディープフェイク生成技術に苦労している一方で、彼らの方法は高いAUCと平均精度スコアを達成し、堅牢な一般化を示したと述べました。

従来のディープフェイクデータセットでのパフォーマンスは、提案された方法が主要なアプローチと競争力があり、さまざまな操作タイプにわたる強い一般化を示していることを示しています。

従来のディープフェイクデータセットでのパフォーマンスは、提案された方法が主要なアプローチと競争力があり、さまざまな操作タイプにわたる強い一般化を示していることを示しています。

著者はまた、現実の条件下でのモデルの信頼性をテストし、彩度の調整、ガウスぼかし、ピクセル化などの一般的なビデオ歪みに対して耐性があることを確認しました。

異なるビデオ歪み下での検出精度の変化の図。新しい方法はほとんどの場合で耐性を示し、AUCのわずかな低下にとどまりました。最も顕著な低下はガウスノイズが導入された場合に発生しました。

異なるビデオ歪み下での検出精度の変化の図。新しい方法はほとんどの場合で耐性を示し、AUCのわずかな低下にとどまりました。最も顕著な低下はガウスノイズが導入された場合に発生しました。

結論

一般の人々はディープフェイクをアイデンティティの交換と考えることが多いですが、AI操作の現実はより微妙で、潜在的により危険です。この新しい研究で議論されたローカル編集の種類は、別の注目すべき事件が起こるまで一般の注目を集めないかもしれません。しかし、俳優のニク・ケイジが指摘したように、ポストプロダクション編集がパフォーマンスを変更する可能性は、誰もが認識すべき懸念です。私たちは顔の表情のわずかな変化にも自然に敏感であり、コンテキストはそれらの影響を劇的に変えることができます。

最初に公開されたのは2025年4月2日水曜日

TencentがHunyuanCustomを発表、単一画像でのビデオカスタマイズが可能

この記事では、Tencentが発表したマルチモーダルビデオ生成モデルであるHunyuanCustomのリリースについて探ります。付随する研究論文の広範な内容とプロジェクトページに提供されたサンプルビデオの課題により、フォーマットと処理の要件により広範な概要が必要であり、広範なビデオコンテンツの再現は限定的です。なお、論文ではAPIベースの生成システムKlingを「Keling」と記載しています。一

TencentがHunyuanCustomを発表、単一画像でのビデオカスタマイズが可能

この記事では、Tencentが発表したマルチモーダルビデオ生成モデルであるHunyuanCustomのリリースについて探ります。付随する研究論文の広範な内容とプロジェクトページに提供されたサンプルビデオの課題により、フォーマットと処理の要件により広範な概要が必要であり、広範なビデオコンテンツの再現は限定的です。なお、論文ではAPIベースの生成システムKlingを「Keling」と記載しています。一

GoogleはAIを利用して、詐欺の疑いのために3900万を超える広告アカウントを一時停止します

Googleは水曜日に、2024年にプラットフォームで驚異的な3920万の広告主アカウントを停止することにより、広告詐欺との大きな一歩を踏み出したと発表しました。

GoogleはAIを利用して、詐欺の疑いのために3900万を超える広告アカウントを一時停止します

Googleは水曜日に、2024年にプラットフォームで驚異的な3920万の広告主アカウントを停止することにより、広告詐欺との大きな一歩を踏み出したと発表しました。

2025年8月20日 6:01:13 JST

2025年8月20日 6:01:13 JST

That Pelosi video from 2019 is wild! It’s scary how a few tweaks can make someone look totally drunk. AI’s power to mess with videos is both cool and creepy—makes you wonder what’s real anymore. 😬

0

0

2025年8月20日 2:01:10 JST

2025年8月20日 2:01:10 JST

This Pelosi video incident is wild! 🤯 It’s scary how a few tweaks can make someone look totally out of it. Makes me wonder how much of what we see online is real anymore. AI’s cool, but this kind of stuff could mess with trust big time.

0

0

2025年7月29日 21:25:16 JST

2025年7月29日 21:25:16 JST

That Pelosi video from 2019 is wild! It’s scary how a few tweaks can make someone look totally out of it. AI’s power to mess with reality is no joke—makes you wonder what’s real anymore. 🫣

0

0

2025年4月24日 11:24:54 JST

2025年4月24日 11:24:54 JST

Este herramienta de IA me mostró lo fácil que es manipular videos. El incidente de Nancy Pelosi fue un recordatorio impactante. Es aterrador pensar en cuántas noticias falsas pueden existir. Ahora estoy más atento a lo que creo en línea. ¡Cuidado, amigos! 👀

0

0

2025年4月21日 5:42:51 JST

2025年4月21日 5:42:51 JST

このAIツールは、ビデオを操作するのがどれほど簡単かを教えてくれました。ナンシー・ペロシの事件は衝撃的でした。偽ニュースがどれだけあるかと思うと恐ろしいです。オンラインで何を信じるかについて、今はもっと注意しています。みなさんも気をつけてくださいね!👀

0

0

2025年4月19日 19:25:50 JST

2025年4月19日 19:25:50 JST

Dieses KI-Tool hat mir gezeigt, wie einfach es ist, Videos zu manipulieren! Der Vorfall mit Nancy Pelosi war ein Weckruf. Es ist beängstigend, wie viele gefälschte Nachrichten es geben könnte. Ich bin jetzt vorsichtiger mit dem, was ich online glaube. Seid wachsam, Leute! 👀

0

0