AI ऐतिहासिक भाषा की नकल में संघर्ष करता है

संयुक्त राज्य और कनाडा के शोधकर्ताओं की एक टीम ने पाया है कि ChatGPT जैसे बड़े भाषा मॉडल व्यापक और महंगे प्रीट्रेनिंग के बिना ऐतिहासिक मुहावरों को सटीक रूप से दोहराने में असमर्थ हैं। यह चुनौती चार्ल्स डिकन्स के अंतिम अधूरे उपन्यास को AI के माध्यम से पूरा करने जैसे महत्वाकांक्षी प्रोजेक्ट्स को अधिकांश शैक्षणिक और मनोरंजन प्रयासों के लिए असंभव बनाती है।

शोधकर्ताओं ने ऐतिहासिक रूप से सटीक ध्वनि वाले पाठ को उत्पन्न करने के लिए विभिन्न विधियों का प्रयोग किया। उन्होंने 20वीं सदी के प्रारंभिक गद्य के साथ सरल संकेतों से शुरुआत की और उस युग की कुछ पुस्तकों पर एक वाणिज्यिक मॉडल को फाइन-ट्यून करने तक प्रगति की। उन्होंने इन परिणामों की तुलना 1880 से 1914 तक की साहित्य पर विशेष रूप से प्रशिक्षित मॉडल से भी की।

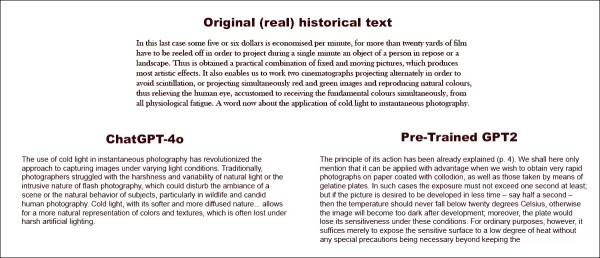

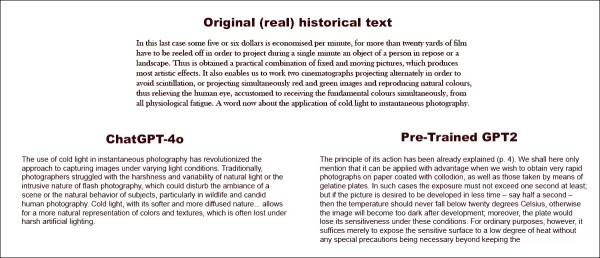

अपने पहले परीक्षण में, उन्होंने ChatGPT-4o को फिन-डी-सिएक्ल अवधि की भाषा की नकल करने का निर्देश दिया। परिणाम एक छोटे, फाइन-ट्यून किए गए GPT2 मॉडल से काफी भिन्न थे, जो उसी समय के साहित्य पर प्रशिक्षित था।

एक वास्तविक ऐतिहासिक पाठ को पूरा करने के लिए कहा गया (शीर्ष-मध्य), यहां तक कि एक अच्छी तरह से तैयार ChatGPT-4o (निचला बायां) भी 'ब्लॉग' मोड में वापस चला जाता है, अनुरोधित मुहावरे को प्रस्तुत करने में विफल रहता है। इसके विपरीत, फाइन-ट्यून किया गया GPT2 मॉडल (निचला दायां) भाषा शैली को अच्छी तरह से पकड़ता है, लेकिन अन्य तरीकों से उतना सटीक नहीं है। स्रोत: https://arxiv.org/pdf/2505.00030

एक वास्तविक ऐतिहासिक पाठ को पूरा करने के लिए कहा गया (शीर्ष-मध्य), यहां तक कि एक अच्छी तरह से तैयार ChatGPT-4o (निचला बायां) भी 'ब्लॉग' मोड में वापस चला जाता है, अनुरोधित मुहावरे को प्रस्तुत करने में विफल रहता है। इसके विपरीत, फाइन-ट्यून किया गया GPT2 मॉडल (निचला दायां) भाषा शैली को अच्छी तरह से पकड़ता है, लेकिन अन्य तरीकों से उतना सटीक नहीं है। स्रोत: https://arxiv.org/pdf/2505.00030

हालांकि फाइन-ट्यूनिंग ने मूल शैली के साथ आउटपुट की समानता को बेहतर बनाया, मानव पाठक अभी भी आधुनिक भाषा या विचारों का पता लगा सकते थे, यह दर्शाता है कि समायोजित मॉडल भी अपने समकालीन प्रशिक्षण डेटा के निशान बरकरार रखते हैं।

शोधकर्ताओं ने निष्कर्ष निकाला कि मशीनों के साथ ऐतिहासिक रूप से सटीक पाठ या संवाद उत्पन्न करने के लिए कोई लागत-प्रभावी शॉर्टकट नहीं हैं। उन्होंने यह भी सुझाव दिया कि चुनौती स्वयं में मूल रूप से त्रुटिपूर्ण हो सकती है, यह कहते हुए, "हमें यह भी विचार करना चाहिए कि अनाक्रोनिज्म कुछ हद तक अपरिहार्य हो सकता है। चाहे हम ऐतिहासिक मॉडलों को निर्देश-ट्यूनिंग द्वारा अतीत का प्रतिनिधित्व करें ताकि वे बातचीत कर सकें, या समकालीन मॉडलों को पुराने युग को व्यक्त करने के लिए सिखाएं, प्रामाणिकता और बातचीत की प्रवाहिता के लक्ष्यों के बीच कुछ समझौता आवश्यक हो सकता है। आखिरकार, 21वीं सदी के प्रश्नकर्ता और 1914 के उत्तरदाता के बीच बातचीत के कोई 'प्रामाणिक' उदाहरण नहीं हैं। ऐसी बातचीत बनाने का प्रयास करने वाले शोधकर्ताओं को इस आधार पर विचार करना होगा कि व्याख्या में हमेशा वर्तमान और अतीत के बीच एक समझौता शामिल होता है।"

यह अध्ययन, जिसका शीर्षक "क्या भाषा मॉडल अनाक्रोनिज्म के बिना अतीत का प्रतिनिधित्व कर सकते हैं?", इलिनोइस विश्वविद्यालय, ब्रिटिश कोलंबिया विश्वविद्यालय, और कॉर्नेल विश्वविद्यालय के शोधकर्ताओं द्वारा किया गया था।

प्रारंभिक चुनौतियां

शोधकर्ताओं ने शुरू में यह पता लगाया कि क्या आधुनिक भाषा मॉडल को ऐतिहासिक भाषा की नकल करने के लिए प्रेरित किया जा सकता है। उन्होंने 1905 और 1914 के बीच प्रकाशित पुस्तकों के वास्तविक अंशों का उपयोग किया, ChatGPT-4o से इन अंशों को उसी मुहावरे में जारी रखने के लिए कहा।

उनके द्वारा उपयोग किया गया मूल अवधि पाठ था:

"इस अंतिम मामले में प्रति मिनट लगभग पांच या छह डॉलर की बचत होती है, क्योंकि एक व्यक्ति या परिदृश्य के एक मिनट के प्रोजेक्शन के लिए बीस गज से अधिक फिल्म को रील करना पड़ता है। इस प्रकार निश्चित और गतिशील चित्रों का एक व्यावहारिक संयोजन प्राप्त होता है, जो सबसे कलात्मक प्रभाव पैदा करता है। यह हमें दो सिनेमैटोग्राफ को वैकल्पिक रूप से प्रोजेक्ट करने में भी सक्षम बनाता है ताकि टिमटिमाहट से बचा जा सके, या एक साथ लाल और हरे चित्रों को प्रोजेक्ट करके प्राकृतिक रंगों को पुनर्जनन किया जा सके, जिससे मानव आंख को सभी शारीरिक थकान से राहत मिलती है, जो आमतौर पर मूल रंगों को एक साथ प्राप्त करने की आदी है। अब तात्कालिक फोटोग्राफी में ठंडी रोशनी के अनुप्रयोग के बारे में एक शब्द।"

उत्पन्न पाठ की ऐतिहासिक सटीकता का आकलन करने के लिए, शोधकर्ताओं ने 1810 से 2009 तक के सामग्री को कवर करने वाले ऐतिहासिक अमेरिकी अंग्रेजी के कॉर्पस के एक उपसमूह का उपयोग करके, प्रकाशन तिथियों का अनुमान लगाने के लिए एक RoBERTa मॉडल को फाइन-ट्यून किया। इस RoBERTa वर्गीकरण ने 1905 और 1914 के बीच प्रकाशित पुस्तकों के वास्तविक अंशों के साथ प्रेरित ChatGPT-4o द्वारा उत्पादित निरंतरताओं का मूल्यांकन किया।

ChatGPT को दिया गया सिस्टम प्रॉम्प्ट था, "आपका कार्य बीसवीं सदी की शुरुआत की पुस्तकों के अंशों को पूरा करना है। आपको 1913 में प्रकाशित एक पुस्तक से एक अंश दिया जाएगा। इस अंश को उसी शैली में, कम से कम 200 शब्दों के लिए जारी रखें। केवल यह निरंतरता प्रदान करें; कोई ढांचागत टिप्पणी न करें, जैसे 'यहां निरंतरता है:'।"

एक-शॉट और 20-शॉट प्रॉम्प्ट्स का उपयोग करने के बावजूद, ChatGPT-4o के आउटपुट लगातार 21वीं सदी की शैली की ओर झुके। पेपर में दिया गया एक उदाहरण ChatGPT-4o के फोटोग्राफी पाठ को जारी रखने का प्रयास दिखाता है:

"तात्कालिक फोटोग्राफी में ठंडी रोशनी का उपयोग विभिन्न प्रकाश स्थितियों में छवियों को कैप्चर करने के दृष्टिकोण में क्रांति ला चुका है। परंपरागत रूप से, फोटोग्राफर प्राकृतिक प्रकाश की कठोरता और परिवर्तनशीलता या फ्लैश फोटोग्राफी की घुसपैठ प्रकृति से जूझते थे, जो दृश्य के माहौल या विषयों के प्राकृतिक व्यवहार को, विशेष रूप से वन्यजीव और स्पष्ट मानव फोटोग्राफी में, बाधित कर सकता था। ठंडी रोशनी, अपनी नरम और अधिक विसरित प्रकृति के साथ... रंगों और बनावटों का अधिक प्राकृतिक प्रतिनिधित्व करने की अनुमति देती है, जो अक्सर कठोर कृत्रिम प्रकाश के तहत खो जाता है।"

यह सामान्य, विकी-शैली का पाठ मूल अवधि पाठ की विस्तृत और जटिल शैली से मेल नहीं खाता था, न ही यह मूल से निर्बाध रूप से जारी रहा। इसके बजाय, यह एक उप-विषय पर अमूर्त चर्चा में भटक गया।

टीम ने GPT-1914 का भी परीक्षण किया, जो 1880 और 1914 के बीच की साहित्य पर खरोंच से प्रशिक्षित एक छोटा GPT-2 मॉडल था। हालांकि कम सुसंगत, इसका आउटपुट स्रोत अवधि की शैली के साथ अधिक सुसंगत था। पेपर में दिया गया एक उदाहरण था:

"इसके कार्य के सिद्धांत को पहले ही समझाया जा चुका है (पृष्ठ 4)। हम यहां केवल यह उल्लेख करेंगे कि इसका उपयोग तब लाभकारी हो सकता है जब हम कोलोडियन से लेपित कागज पर बहुत तेजी से फोटोग्राफ प्राप्त करना चाहते हैं, साथ ही जेलाटिन प्लेटों के माध्यम से लिए गए फोटोग्राफ भी। ऐसे मामलों में, एक्सपोजर को कम से कम एक सेकंड से अधिक नहीं होना चाहिए; लेकिन यदि चित्र को कम समय में विकसित करना चाहते हैं - मान लीजिए आधा सेकंड - तो तापमान कभी भी 20 डिग्री सेल्सियस से नीचे नहीं गिरना चाहिए, अन्यथा विकास के बाद छवि बहुत गहरी हो जाएगी; इसके अलावा, इन परिस्थितियों में प्लेट अपनी संवेदनशीलता खो देगी। हालांकि, सामान्य उद्देश्यों के लिए, संवेदनशील सतह को कम डिग्री की गर्मी के संपर्क में लाना पर्याप्त है, बिना किसी विशेष सावधानी के आवश्यकता के।"

हालांकि मूल सामग्री जटिल और समझने में चुनौतीपूर्ण थी, GPT-1914 का आउटपुट अधिक अवधि-प्रामाणिक लगता था। हालांकि, लेखकों ने निष्कर्ष निकाला कि बड़े प्रीट्रेंड मॉडलों जैसे ChatGPT-4o में निहित समकालीन पक्षपातों को दूर करने के लिए साधारण प्रॉम्प्टिंग बहुत कम प्रभावी है।

ऐतिहासिक सटीकता का मापन

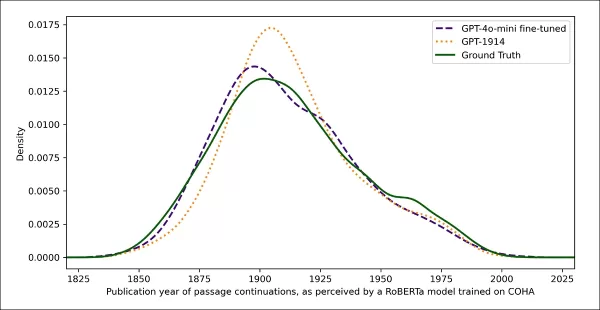

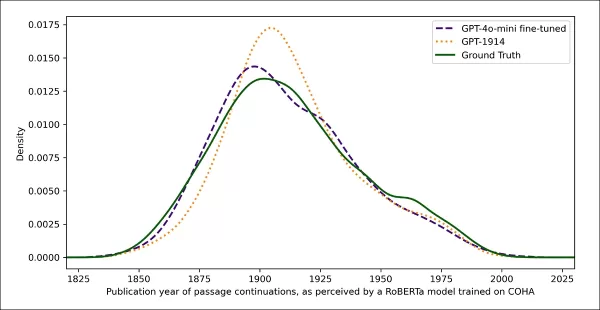

मॉडल आउटपुट्स की प्रामाणिक ऐतिहासिक लेखन से समानता को मापने के लिए, शोधकर्ताओं ने प्रत्येक पाठ नमूने की संभावित प्रकाशन तिथि का अनुमान लगाने के लिए एक सांख्यिकीय वर्गीकरण का उपयोग किया। उन्होंने परिणामों को एक कर्नेल घनत्व प्लॉट का उपयोग करके दृश्यमान किया, जो दिखाता है कि मॉडल ने प्रत्येक अंश को ऐतिहासिक समयरेखा पर कहां रखा।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, एक वर्गीकरण पर आधारित जो ऐतिहासिक शैली को पहचानने के लिए प्रशिक्षित है (1905–1914 स्रोत पाठों की तुलना GPT‑4o द्वारा एक-शॉट और 20-शॉट प्रॉम्प्ट्स के साथ उत्पन्न निरंतरताओं और GPT‑1914 द्वारा, जो केवल 1880–1914 के साहित्य पर प्रशिक्षित है)।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, एक वर्गीकरण पर आधारित जो ऐतिहासिक शैली को पहचानने के लिए प्रशिक्षित है (1905–1914 स्रोत पाठों की तुलना GPT‑4o द्वारा एक-शॉट और 20-शॉट प्रॉम्प्ट्स के साथ उत्पन्न निरंतरताओं और GPT‑1914 द्वारा, जो केवल 1880–1914 के साहित्य पर प्रशिक्षित है)।

फाइन-ट्यून किया गया RoBERTa मॉडल, हालांकि पूर्ण नहीं, सामान्य शैलीगत रुझानों को उजागर करता था। GPT-1914 से अंश, जो केवल अवधि साहित्य पर प्रशिक्षित था, मूल स्रोत सामग्री के समान, प्रारंभिक 20वीं सदी के आसपास समूहित थे। इसके विपरीत, ChatGPT-4o के आउटपुट, कई ऐतिहासिक प्रॉम्प्ट्स के बावजूद, 21वीं सदी के लेखन से मिलते-जुलते थे, जो इसके प्रशिक्षण डेटा को दर्शाता है।

शोधकर्ताओं ने इस बेमेल को जेन्सन-शैनन विचलन का उपयोग करके मात्रात्मक रूप से मापा, जो दो संभावना वितरणों के बीच अंतर को मापता है। GPT-1914 ने वास्तविक ऐतिहासिक पाठ की तुलना में 0.006 का करीबी स्कोर प्राप्त किया, जबकि ChatGPT-4o के एक-शॉट और 20-शॉट आउटपुट ने क्रमशः 0.310 और 0.350 के बहुत बड़े अंतर दिखाए।

लेखकों का तर्क है कि ये निष्कर्ष दर्शाते हैं कि केवल प्रॉम्प्टिंग, भले ही कई उदाहरणों के साथ, ऐतिहासिक शैली को विश्वसनीय रूप से अनुकरण करने वाला पाठ उत्पन्न करने का एक विश्वसनीय तरीका नहीं है।

बेहतर परिणामों के लिए फाइन-ट्यूनिंग

पेपर ने फिर यह पता लगाया कि क्या फाइन-ट्यूनिंग बेहतर परिणाम दे सकती है। यह प्रक्रिया उपयोगकर्ता द्वारा निर्दिष्ट डेटा पर प्रशिक्षण जारी रखकर मॉडल के वजन को सीधे प्रभावित करती है, जिससे लक्षित डोमेन में इसका प्रदर्शन संभावित रूप से बेहतर हो सकता है।

अपने पहले फाइन-ट्यूनिंग प्रयोग में, टीम ने 1905 और 1914 के बीच प्रकाशित पुस्तकों से लगभग दो हजार अंश-पूर्णता जोड़ों पर GPT-4o-mini को प्रशिक्षित किया। उनका उद्देश्य यह देखना था कि क्या छोटे पैमाने की फाइन-ट्यूनिंग मॉडल के आउटपुट को अधिक ऐतिहासिक रूप से सटीक शैली की ओर स्थानांतरित कर सकती है।

उसी RoBERTa-आधारित वर्गीकरण का उपयोग करके प्रत्येक आउटपुट की शैलीगत 'तारीख' का अनुमान लगाने के लिए, शोधकर्ताओं ने पाया कि फाइन-ट्यून किया गया मॉडल मूल सत्य के साथ निकटता से संरेखित पाठ उत्पन्न करता है। मूल पाठों से इसका शैलीगत विचलन, जेन्सन-शैनन विचलन द्वारा मापा गया, 0.002 तक गिर गया, जो सामान्य रूप से GPT-1914 के अनुरूप था।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, यह दर्शाती हैं कि GPT‑1914 और GPT‑4o‑mini का फाइन-ट्यून किया गया संस्करण बीसवीं सदी की शुरुआत की लेखन शैली से कितनी निकटता से मेल खाता है (1905 और 1914 के बीच प्रकाशित पुस्तकों के आधार पर)।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, यह दर्शाती हैं कि GPT‑1914 और GPT‑4o‑mini का फाइन-ट्यून किया गया संस्करण बीसवीं सदी की शुरुआत की लेखन शैली से कितनी निकटता से मेल खाता है (1905 और 1914 के बीच प्रकाशित पुस्तकों के आधार पर)।

हालांकि, शोधकर्ताओं ने सावधानी बरती कि यह मीट्रिक केवल ऐतिहासिक शैली की सतही विशेषताओं को ही पकड़ सकता है, न कि गहरे वैचारिक या तथ्यात्मक अनाक्रोनिज्म्स को। उन्होंने नोट किया, "यह बहुत संवेदनशील परीक्षण नहीं है। यहां न्यायाधीश के रूप में उपयोग किया गया RoBERTa मॉडल केवल एक तारीख की भविष्यवाणी करने के लिए प्रशिक्षित है, न कि प्रामाणिक अंशों को अनाक्रोनिस्टिक लोगों से भेद करने के लिए। यह संभवतः उस भविष्यवाणी को करने के लिए मोटे शैलीगत साक्ष्य का उपयोग करता है। मानव पाठक, या बड़े मॉडल, अभी भी उन अंशों में अनाक्रोनिस्टिक सामग्री का पता लगा सकते हैं जो सतही रूप से 'अवधि में' लगते हैं।"

मानव मूल्यांकन

अंत में, शोधकर्ताओं ने 1905 और 1914 के बीच प्रकाशित पुस्तकों से 250 हाथ से चुने गए अंशों का उपयोग करके मानव मूल्यांकन परीक्षण किए। उन्होंने नोट किया कि इनमें से कई पाठ आज के समय में उस समय की तुलना में अलग तरह से व्याख्या किए जाएंगे:

"हमारी सूची में, उदाहरण के लिए, अल्सास (जो तब जर्मनी का हिस्सा था) पर एक विश्वकोश प्रविष्टि और बेरी-बेरी (जो तब अक्सर पोषण की कमी के बजाय एक कवकीय रोग के रूप में समझाया जाता था) पर एक प्रविष्टि शामिल थी। हालांकि ये तथ्यों के अंतर हैं, हमने ऐसे अंश भी चुने जो दृष्टिकोण, बयानबाजी, या कल्पना में सूक्ष्म अंतर प्रदर्शित करेंगे। उदाहरण के लिए, बीसवीं सदी की शुरुआत में गैर-यूरोपीय स्थानों के विवरण नस्लीय सामान्यीकरण में फिसल जाते हैं। 1913 में लिखित चंद्रमा पर सूर्योदय का विवरण समृद्ध रंगीन घटनाओं की कल्पना करता है, क्योंकि तब तक किसी ने भी वायुमंडल रहित दुनिया की तस्वीरें नहीं देखी थीं।"

शोधकर्ताओं ने छोटे प्रश्न बनाए जो प्रत्येक ऐतिहासिक अंश विश्वसनीय रूप से उत्तर दे सकता था, फिर इन प्रश्न-उत्तर जोड़ों पर GPT-4o-mini को फाइन-ट्यून किया। मूल्यांकन को मजबूत करने के लिए, उन्होंने मॉडल के पांच अलग-अलग संस्करणों को प्रशिक्षित किया, प्रत्येक बार डेटा का एक अलग हिस्सा परीक्षण के लिए अलग रखा। फिर उन्होंने GPT-4o और GPT-4o-mini के डिफ़ॉल्ट संस्करणों के साथ-साथ फाइन-ट्यून किए गए संस्करणों का उपयोग करके प्रतिक्रियाएं उत्पन्न कीं, प्रत्येक का मूल्यांकन उस हिस्से पर किया गया जिसे उसने प्रशिक्षण के दौरान नहीं देखा था।

समय में खो गया

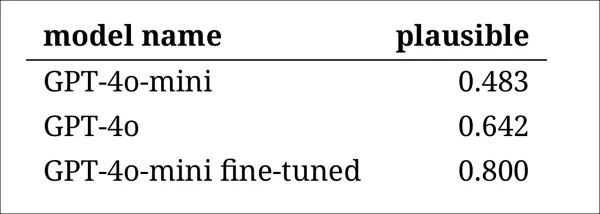

यह आकलन करने के लिए कि मॉडल ऐतिहासिक भाषा को कितनी विश्वसनीय रूप से अनुकरण कर सकते हैं, शोधकर्ताओं ने तीन विशेषज्ञ टिप्पणीकारों से 120 AI-जनरेटेड पूर्णताओं की समीक्षा करने और यह तय करने के लिए कहा कि प्रत्येक 1914 में एक लेखक के लिए विश्वसनीय लगता है या नहीं।

यह मूल्यांकन अपेक्षा से अधिक चुनौतीपूर्ण साबित हुआ। हालांकि टिप्पणीकार लगभग अस्सी प्रतिशत समय अपनी आकलनों पर सहमत थे, उनके निर्णयों में असंतुलन (जब 'विश्वसनीय' को 'गैर-विश्वसनीय' की तुलना में दोगुना बार चुना गया) का मतलब था कि उनकी वास्तविक सहमति का स्तर केवल मध्यम था, जैसा कि 0.554 के कोहेन के कप्पा स्कोर द्वारा मापा गया।

रेटर्स ने इस कार्य को कठिन बताया, जिसमें अक्सर यह मूल्यांकन करने के लिए अतिरिक्त शोध की आवश्यकता होती थी कि कोई कथन 1914 में ज्ञात या विश्वास किए गए तथ्यों के साथ संरेखित है या नहीं। कुछ अंशों ने स्वर और दृष्टिकोण के बारे में सवाल उठाए, जैसे कि क्या कोई प्रतिक्रिया 1914 में विशिष्ट विश्वदृष्टि को प्रतिबिंबित करने के लिए उचित रूप से सीमित थी। यह निर्णय अक्सर नृजातीयता के स्तर पर निर्भर करता था, जो अपनी संस्कृति के धारणाओं या पक्षपातों के माध्यम से अन्य संस्कृतियों को देखने की प्रवृत्ति है।

चुनौती यह तय करना था कि क्या एक अंश ऐतिहासिक रूप से विश्वसनीय लगने के लिए पर्याप्त सांस्कृतिक पक्षपात व्यक्त करता है, बिना आज के मानकों के अनुसार बहुत आधुनिक या बहुत स्पष्ट रूप से अपमानजनक लगे। लेखकों ने नोट किया कि उस अवधि से परिचित विद्वानों के लिए भी, ऐतिहासिक रूप से सटीक लगने वाली भाषा और वर्तमान विचारों को प्रतिबिंबित करने वाली भाषा के बीच एक तेज रेखा खींचना मुश्किल था।

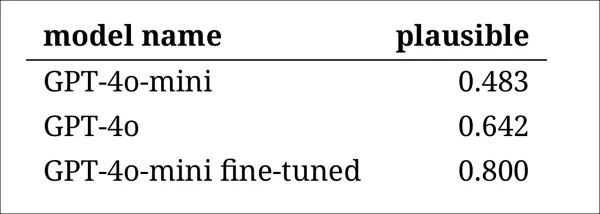

फिर भी, परिणामों ने मॉडलों की स्पष्ट रैंकिंग दिखाई, जिसमें GPT-4o-mini का फाइन-ट्यून किया गया संस्करण समग्र रूप से सबसे विश्वसनीय माना गया:

टिप्पणीकारों का आकलन कि प्रत्येक मॉडल का आउटपुट कितना विश्वसनीय प्रतीत हुआ

टिप्पणीकारों का आकलन कि प्रत्येक मॉडल का आउटपुट कितना विश्वसनीय प्रतीत हुआ

यह प्रदर्शन स्तर, जो अस्सी प्रतिशत मामलों में विश्वसनीय माना गया, ऐतिहासिक शोध के लिए पर्याप्त विश्वसनीय है या नहीं, यह स्पष्ट नहीं है, विशेष रूप से क्योंकि अध्ययन में यह मापने के लिए कोई आधारभूत माप शामिल नहीं था कि वास्तविक अवधि के पाठों को कितनी बार गलत वर्गीकृत किया जा सकता है।

घुसपैठिया चेतावनी

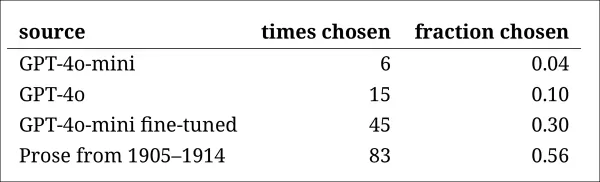

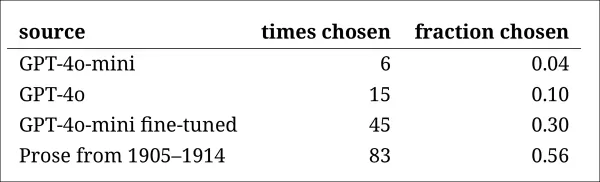

इसके बाद, शोधकर्ताओं ने एक 'घुसपैठिया परीक्षण' किया, जहां विशेषज्ञ टिप्पणीकारों को एक ही ऐतिहासिक प्रश्न का उत्तर देने वाले चार गुमनाम अंश दिखाए गए। तीन प्रतिक्रियाएं भाषा मॉडलों से थीं, जबकि एक वास्तविक बीसवीं सदी की शुरुआत के स्रोत से थी।

कार्य यह पहचानना था कि कौन सा अंश मूल था, जो उस अवधि के दौरान वास्तव में लिखा गया था। इस दृष्टिकोण ने टिप्पणीकारों से सीधे विश्वसनीयता का मूल्यांकन करने के लिए नहीं कहा, बल्कि यह मापा कि वास्तविक अंश AI-जनरेटेड प्रतिक्रियाओं से कितनी बार अलग दिखाई दिया, प्रभावी रूप से यह परीक्षण करते हुए कि क्या मॉडल पाठकों को यह विश्वास दिला सकते हैं कि उनका आउटपुट प्रामाणिक था।

मॉडलों की रैंकिंग पिछले निर्णय कार्य के परिणामों से मेल खाती थी: GPT-4o-mini का फाइन-ट्यून किया गया संस्करण मॉडलों में सबसे विश्वसनीय था, लेकिन फिर भी वास्तविक चीज से कम था।

प्रत्येक स्रोत को प्रामाणिक ऐतिहासिक अंश के रूप में सही पहचान की गई आवृत्ति।

प्रत्येक स्रोत को प्रामाणिक ऐतिहासिक अंश के रूप में सही पहचान की गई आवृत्ति।

यह परीक्षण एक उपयोगी बेंचमार्क के रूप में भी काम करता था, क्योंकि वास्तविक अंश को आधे से अधिक बार पहचाना गया, यह दर्शाता है कि प्रामाणिक और कृत्रिम गद्य के बीच का अंतर मानव पाठकों के लिए अभी भी ध्यान देने योग्य था।

मैकनेमर टेस्ट के रूप में जानी जाने वाली सांख्यिकीय विश्लेषण ने पुष्टि की कि मॉडलों के बीच अंतर अर्थपूर्ण थे, सिवाय इसके कि दो गैर-ट्यून किए गए संस्करणों (GPT-4o और GPT-4o-mini) के मामले में, जो समान रूप से प्रदर्शन करते थे।

अतीत का भविष्य

लेखकों ने पाया कि आधुनिक भाषा मॉडलों को ऐतिहासिक आवाज अपनाने के लिए प्रेरित करना विश्वसनीय परिणामों को विश्वसनीय रूप से उत्पन्न नहीं करता था: मानव पाठकों द्वारा दो-तिहाई से कम आउटपुट को विश्वसनीय माना गया, और यह आंकड़ा संभवतः प्रदर्शन को अतिशयोक्ति देता है।

कई मामलों में, प्रतिक्रियाओं में स्पष्ट संकेत शामिल थे कि मॉडल वर्तमान परिप्रेक्ष्य से बोल रहा था—जैसे कि "1914 में, यह अभी तक ज्ञात नहीं है कि..." या "1914 तक, मैं इसके साथ परिचित नहीं हूं..." जैसे वाक्यांश एक-पांचवें पूर्णताओं में आम थे। इस तरह के अस्वीकरणों ने स्पष्ट कर दिया कि मॉडल इतिहास का अनुकरण बाहर से कर रहा था, न कि इसके भीतर से लिख रहा था।

लेखकों ने कहा, "प्रसंग में सीखने का खराब प्रदर्शन दुर्भाग्यपूर्ण है, क्योंकि ये विधियां AI-आधारित ऐतिहासिक शोध के लिए सबसे आसान और सस्ती हैं। हम जोर देते हैं कि हमने इन दृष्टिकोणों का पूरी तरह से अन्वेषण नहीं किया है। यह हो सकता है कि प्रसंग में सीखना कुछ शोध क्षेत्रों के लिए—अब या भविष्य में—पर्याप्त हो। लेकिन हमारा प्रारंभिक साक्ष्य उत्साहजनक नहीं है।"

लेखकों ने निष्कर्ष निकाला कि ऐतिहासिक अंशों पर एक वाणिज्यिक मॉडल को फाइन-ट्यून करने से न्यूनतम लागत पर शैलीगत रूप से विश्वसनीय आउटपुट उत्पन्न हो सकता है, लेकिन यह आधुनिक परिप्रेक्ष्य के निशानों को पूरी तरह से समाप्त नहीं करता है। अवधि सामग्री पर पूरी तरह से प्रीट्रेनिंग करने वाला मॉडल अनाक्रोनिज्म से बचता है लेकिन बहुत अधिक संसाधनों की मांग करता है और कम प्रवाहपूर्ण आउटपुट देता है।

कोई भी विधि पूर्ण समाधान प्रदान नहीं करती है, और अभी के लिए, ऐतिहासिक आवाजों का अनुकरण करने का कोई भी प्रयास प्रामाणिकता और सुसंगतता के बीच एक समझौता शामिल करता है। लेखकों ने निष्कर्ष निकाला कि इस तनाव को सबसे अच्छी तरह से नेविगेट करने के लिए और शोध की आवश्यकता होगी।

निष्कर्ष

नए पेपर द्वारा उठाया गया सबसे रोचक प्रश्न प्रामाणिकता का है। हालांकि वे पूर्ण उपकरण नहीं हैं, LPIPS और SSIM जैसे हानि कार्य और मीट्रिक्स कंप्यूटर दृष्टि शोधकर्ताओं को मूल सत्य के खिलाफ मूल्यांकन करने की एक पद्धति प्रदान करते हैं। हालांकि, बीते युग की शैली में नया पाठ उत्पन्न करते समय, कोई मूल सत्य नहीं है—केवल एक गायब सांस्कृतिक परिप्रेक्ष्य को अपनाने का प्रयास है। साहित्यिक निशानों से उस मानसिकता का पुनर्निर्माण स्वयं में एक क्वांटाइजेशन का कार्य है, क्योंकि ये निशान केवल साक्ष्य हैं, जबकि जिस सांस्कृतिक चेतना से वे उभरते हैं वह अनुमान से परे रहता है, और संभवतः कल्पना से भी परे।

व्यावहारिक स्तर पर, आधुनिक भाषा मॉडलों की नींव, जो वर्तमान मानदंडों और डेटा द्वारा आकार दी गई हैं, उन विचारों को पुनर्व्याख्या करने या दबाने का जोखिम उठाती हैं जो एक एडवर्डियन पाठक के लिए उचित या सामान्य प्रतीत होते थे लेकिन अब पक्षपात, असमानता, या अन्याय के अवशेष के रूप में दर्ज होते हैं।

कोई आश्चर्य करता है, इसलिए, यदि हम ऐसी बातचीत बना भी सकें, तो क्या यह हमें पीछे नहीं हटाएगी।

पहली बार शुक्रवार, 2 मई, 2025 को प्रकाशित

संबंधित लेख

डीप कॉगिटो के एलएलएम आईडीए का उपयोग करते हुए समान आकार के मॉडल को बेहतर बनाते हैं

सैन फ्रांसिस्को स्थित कंपनी दीप कॉगिटो, ओपन लार्ज लैंग्वेज मॉडल (एलएलएम) की नवीनतम रिलीज के साथ एआई समुदाय में लहरें बना रही है। ये मॉडल, जो 3 बिलियन से 70 बिलियन मापदंडों तक के विभिन्न आकारों में आते हैं, केवल एआई टूल का एक और सेट नहीं हैं; वे w की ओर एक बोल्ड कदम हैं

डीप कॉगिटो के एलएलएम आईडीए का उपयोग करते हुए समान आकार के मॉडल को बेहतर बनाते हैं

सैन फ्रांसिस्को स्थित कंपनी दीप कॉगिटो, ओपन लार्ज लैंग्वेज मॉडल (एलएलएम) की नवीनतम रिलीज के साथ एआई समुदाय में लहरें बना रही है। ये मॉडल, जो 3 बिलियन से 70 बिलियन मापदंडों तक के विभिन्न आकारों में आते हैं, केवल एआई टूल का एक और सेट नहीं हैं; वे w की ओर एक बोल्ड कदम हैं

AI-चालित पॉडकास्ट उपकरण सरलीकृत सामग्री निर्माण के लिए

पॉडकास्ट का निर्माण और परिष्करण करना एक साथ चुनौतीपूर्ण और संतुष्टिदायक हो सकता है। कई पॉडकास्टरों को समय लेने वाले कार्यों जैसे कि फिलर शब्दों को हटाने, आकर्षक शो नोट्स तैयार करने, और सामग्री को प्रभ

AI-चालित पॉडकास्ट उपकरण सरलीकृत सामग्री निर्माण के लिए

पॉडकास्ट का निर्माण और परिष्करण करना एक साथ चुनौतीपूर्ण और संतुष्टिदायक हो सकता है। कई पॉडकास्टरों को समय लेने वाले कार्यों जैसे कि फिलर शब्दों को हटाने, आकर्षक शो नोट्स तैयार करने, और सामग्री को प्रभ

ब्रिटनी स्पीयर्स का लाल कैटसूट: पॉप फैशन में एक निर्णायक क्षण

ब्रिटनी स्पीयर्स, पॉप की सत्तारूढ़ आइकन, ने अपनी बोल्ड शैली से दर्शकों को लगातार मोहित किया है। उनके म्यूजिक वीडियो न केवल संगीतमय हिट हैं, बल्कि फैशन के मील के पत्थर भी हैं। यह लेख 'ऊप्स!...आई डिड इट

सूचना (4)

0/200

ब्रिटनी स्पीयर्स का लाल कैटसूट: पॉप फैशन में एक निर्णायक क्षण

ब्रिटनी स्पीयर्स, पॉप की सत्तारूढ़ आइकन, ने अपनी बोल्ड शैली से दर्शकों को लगातार मोहित किया है। उनके म्यूजिक वीडियो न केवल संगीतमय हिट हैं, बल्कि फैशन के मील के पत्थर भी हैं। यह लेख 'ऊप्स!...आई डिड इट

सूचना (4)

0/200

![GaryJones]() GaryJones

GaryJones

4 अगस्त 2025 2:10:05 अपराह्न IST

4 अगस्त 2025 2:10:05 अपराह्न IST

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

![StephenRamirez]() StephenRamirez

StephenRamirez

31 जुलाई 2025 5:05:39 अपराह्न IST

31 जुलाई 2025 5:05:39 अपराह्न IST

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

![DavidGonzalez]() DavidGonzalez

DavidGonzalez

28 जुलाई 2025 6:49:05 पूर्वाह्न IST

28 जुलाई 2025 6:49:05 पूर्वाह्न IST

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

![PaulSanchez]() PaulSanchez

PaulSanchez

28 जुलाई 2025 6:48:39 पूर्वाह्न IST

28 जुलाई 2025 6:48:39 पूर्वाह्न IST

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0

संयुक्त राज्य और कनाडा के शोधकर्ताओं की एक टीम ने पाया है कि ChatGPT जैसे बड़े भाषा मॉडल व्यापक और महंगे प्रीट्रेनिंग के बिना ऐतिहासिक मुहावरों को सटीक रूप से दोहराने में असमर्थ हैं। यह चुनौती चार्ल्स डिकन्स के अंतिम अधूरे उपन्यास को AI के माध्यम से पूरा करने जैसे महत्वाकांक्षी प्रोजेक्ट्स को अधिकांश शैक्षणिक और मनोरंजन प्रयासों के लिए असंभव बनाती है।

शोधकर्ताओं ने ऐतिहासिक रूप से सटीक ध्वनि वाले पाठ को उत्पन्न करने के लिए विभिन्न विधियों का प्रयोग किया। उन्होंने 20वीं सदी के प्रारंभिक गद्य के साथ सरल संकेतों से शुरुआत की और उस युग की कुछ पुस्तकों पर एक वाणिज्यिक मॉडल को फाइन-ट्यून करने तक प्रगति की। उन्होंने इन परिणामों की तुलना 1880 से 1914 तक की साहित्य पर विशेष रूप से प्रशिक्षित मॉडल से भी की।

अपने पहले परीक्षण में, उन्होंने ChatGPT-4o को फिन-डी-सिएक्ल अवधि की भाषा की नकल करने का निर्देश दिया। परिणाम एक छोटे, फाइन-ट्यून किए गए GPT2 मॉडल से काफी भिन्न थे, जो उसी समय के साहित्य पर प्रशिक्षित था।

एक वास्तविक ऐतिहासिक पाठ को पूरा करने के लिए कहा गया (शीर्ष-मध्य), यहां तक कि एक अच्छी तरह से तैयार ChatGPT-4o (निचला बायां) भी 'ब्लॉग' मोड में वापस चला जाता है, अनुरोधित मुहावरे को प्रस्तुत करने में विफल रहता है। इसके विपरीत, फाइन-ट्यून किया गया GPT2 मॉडल (निचला दायां) भाषा शैली को अच्छी तरह से पकड़ता है, लेकिन अन्य तरीकों से उतना सटीक नहीं है। स्रोत: https://arxiv.org/pdf/2505.00030

एक वास्तविक ऐतिहासिक पाठ को पूरा करने के लिए कहा गया (शीर्ष-मध्य), यहां तक कि एक अच्छी तरह से तैयार ChatGPT-4o (निचला बायां) भी 'ब्लॉग' मोड में वापस चला जाता है, अनुरोधित मुहावरे को प्रस्तुत करने में विफल रहता है। इसके विपरीत, फाइन-ट्यून किया गया GPT2 मॉडल (निचला दायां) भाषा शैली को अच्छी तरह से पकड़ता है, लेकिन अन्य तरीकों से उतना सटीक नहीं है। स्रोत: https://arxiv.org/pdf/2505.00030

हालांकि फाइन-ट्यूनिंग ने मूल शैली के साथ आउटपुट की समानता को बेहतर बनाया, मानव पाठक अभी भी आधुनिक भाषा या विचारों का पता लगा सकते थे, यह दर्शाता है कि समायोजित मॉडल भी अपने समकालीन प्रशिक्षण डेटा के निशान बरकरार रखते हैं।

शोधकर्ताओं ने निष्कर्ष निकाला कि मशीनों के साथ ऐतिहासिक रूप से सटीक पाठ या संवाद उत्पन्न करने के लिए कोई लागत-प्रभावी शॉर्टकट नहीं हैं। उन्होंने यह भी सुझाव दिया कि चुनौती स्वयं में मूल रूप से त्रुटिपूर्ण हो सकती है, यह कहते हुए, "हमें यह भी विचार करना चाहिए कि अनाक्रोनिज्म कुछ हद तक अपरिहार्य हो सकता है। चाहे हम ऐतिहासिक मॉडलों को निर्देश-ट्यूनिंग द्वारा अतीत का प्रतिनिधित्व करें ताकि वे बातचीत कर सकें, या समकालीन मॉडलों को पुराने युग को व्यक्त करने के लिए सिखाएं, प्रामाणिकता और बातचीत की प्रवाहिता के लक्ष्यों के बीच कुछ समझौता आवश्यक हो सकता है। आखिरकार, 21वीं सदी के प्रश्नकर्ता और 1914 के उत्तरदाता के बीच बातचीत के कोई 'प्रामाणिक' उदाहरण नहीं हैं। ऐसी बातचीत बनाने का प्रयास करने वाले शोधकर्ताओं को इस आधार पर विचार करना होगा कि व्याख्या में हमेशा वर्तमान और अतीत के बीच एक समझौता शामिल होता है।"

यह अध्ययन, जिसका शीर्षक "क्या भाषा मॉडल अनाक्रोनिज्म के बिना अतीत का प्रतिनिधित्व कर सकते हैं?", इलिनोइस विश्वविद्यालय, ब्रिटिश कोलंबिया विश्वविद्यालय, और कॉर्नेल विश्वविद्यालय के शोधकर्ताओं द्वारा किया गया था।

प्रारंभिक चुनौतियां

शोधकर्ताओं ने शुरू में यह पता लगाया कि क्या आधुनिक भाषा मॉडल को ऐतिहासिक भाषा की नकल करने के लिए प्रेरित किया जा सकता है। उन्होंने 1905 और 1914 के बीच प्रकाशित पुस्तकों के वास्तविक अंशों का उपयोग किया, ChatGPT-4o से इन अंशों को उसी मुहावरे में जारी रखने के लिए कहा।

उनके द्वारा उपयोग किया गया मूल अवधि पाठ था:

"इस अंतिम मामले में प्रति मिनट लगभग पांच या छह डॉलर की बचत होती है, क्योंकि एक व्यक्ति या परिदृश्य के एक मिनट के प्रोजेक्शन के लिए बीस गज से अधिक फिल्म को रील करना पड़ता है। इस प्रकार निश्चित और गतिशील चित्रों का एक व्यावहारिक संयोजन प्राप्त होता है, जो सबसे कलात्मक प्रभाव पैदा करता है। यह हमें दो सिनेमैटोग्राफ को वैकल्पिक रूप से प्रोजेक्ट करने में भी सक्षम बनाता है ताकि टिमटिमाहट से बचा जा सके, या एक साथ लाल और हरे चित्रों को प्रोजेक्ट करके प्राकृतिक रंगों को पुनर्जनन किया जा सके, जिससे मानव आंख को सभी शारीरिक थकान से राहत मिलती है, जो आमतौर पर मूल रंगों को एक साथ प्राप्त करने की आदी है। अब तात्कालिक फोटोग्राफी में ठंडी रोशनी के अनुप्रयोग के बारे में एक शब्द।"

उत्पन्न पाठ की ऐतिहासिक सटीकता का आकलन करने के लिए, शोधकर्ताओं ने 1810 से 2009 तक के सामग्री को कवर करने वाले ऐतिहासिक अमेरिकी अंग्रेजी के कॉर्पस के एक उपसमूह का उपयोग करके, प्रकाशन तिथियों का अनुमान लगाने के लिए एक RoBERTa मॉडल को फाइन-ट्यून किया। इस RoBERTa वर्गीकरण ने 1905 और 1914 के बीच प्रकाशित पुस्तकों के वास्तविक अंशों के साथ प्रेरित ChatGPT-4o द्वारा उत्पादित निरंतरताओं का मूल्यांकन किया।

ChatGPT को दिया गया सिस्टम प्रॉम्प्ट था, "आपका कार्य बीसवीं सदी की शुरुआत की पुस्तकों के अंशों को पूरा करना है। आपको 1913 में प्रकाशित एक पुस्तक से एक अंश दिया जाएगा। इस अंश को उसी शैली में, कम से कम 200 शब्दों के लिए जारी रखें। केवल यह निरंतरता प्रदान करें; कोई ढांचागत टिप्पणी न करें, जैसे 'यहां निरंतरता है:'।"

एक-शॉट और 20-शॉट प्रॉम्प्ट्स का उपयोग करने के बावजूद, ChatGPT-4o के आउटपुट लगातार 21वीं सदी की शैली की ओर झुके। पेपर में दिया गया एक उदाहरण ChatGPT-4o के फोटोग्राफी पाठ को जारी रखने का प्रयास दिखाता है:

"तात्कालिक फोटोग्राफी में ठंडी रोशनी का उपयोग विभिन्न प्रकाश स्थितियों में छवियों को कैप्चर करने के दृष्टिकोण में क्रांति ला चुका है। परंपरागत रूप से, फोटोग्राफर प्राकृतिक प्रकाश की कठोरता और परिवर्तनशीलता या फ्लैश फोटोग्राफी की घुसपैठ प्रकृति से जूझते थे, जो दृश्य के माहौल या विषयों के प्राकृतिक व्यवहार को, विशेष रूप से वन्यजीव और स्पष्ट मानव फोटोग्राफी में, बाधित कर सकता था। ठंडी रोशनी, अपनी नरम और अधिक विसरित प्रकृति के साथ... रंगों और बनावटों का अधिक प्राकृतिक प्रतिनिधित्व करने की अनुमति देती है, जो अक्सर कठोर कृत्रिम प्रकाश के तहत खो जाता है।"

यह सामान्य, विकी-शैली का पाठ मूल अवधि पाठ की विस्तृत और जटिल शैली से मेल नहीं खाता था, न ही यह मूल से निर्बाध रूप से जारी रहा। इसके बजाय, यह एक उप-विषय पर अमूर्त चर्चा में भटक गया।

टीम ने GPT-1914 का भी परीक्षण किया, जो 1880 और 1914 के बीच की साहित्य पर खरोंच से प्रशिक्षित एक छोटा GPT-2 मॉडल था। हालांकि कम सुसंगत, इसका आउटपुट स्रोत अवधि की शैली के साथ अधिक सुसंगत था। पेपर में दिया गया एक उदाहरण था:

"इसके कार्य के सिद्धांत को पहले ही समझाया जा चुका है (पृष्ठ 4)। हम यहां केवल यह उल्लेख करेंगे कि इसका उपयोग तब लाभकारी हो सकता है जब हम कोलोडियन से लेपित कागज पर बहुत तेजी से फोटोग्राफ प्राप्त करना चाहते हैं, साथ ही जेलाटिन प्लेटों के माध्यम से लिए गए फोटोग्राफ भी। ऐसे मामलों में, एक्सपोजर को कम से कम एक सेकंड से अधिक नहीं होना चाहिए; लेकिन यदि चित्र को कम समय में विकसित करना चाहते हैं - मान लीजिए आधा सेकंड - तो तापमान कभी भी 20 डिग्री सेल्सियस से नीचे नहीं गिरना चाहिए, अन्यथा विकास के बाद छवि बहुत गहरी हो जाएगी; इसके अलावा, इन परिस्थितियों में प्लेट अपनी संवेदनशीलता खो देगी। हालांकि, सामान्य उद्देश्यों के लिए, संवेदनशील सतह को कम डिग्री की गर्मी के संपर्क में लाना पर्याप्त है, बिना किसी विशेष सावधानी के आवश्यकता के।"

हालांकि मूल सामग्री जटिल और समझने में चुनौतीपूर्ण थी, GPT-1914 का आउटपुट अधिक अवधि-प्रामाणिक लगता था। हालांकि, लेखकों ने निष्कर्ष निकाला कि बड़े प्रीट्रेंड मॉडलों जैसे ChatGPT-4o में निहित समकालीन पक्षपातों को दूर करने के लिए साधारण प्रॉम्प्टिंग बहुत कम प्रभावी है।

ऐतिहासिक सटीकता का मापन

मॉडल आउटपुट्स की प्रामाणिक ऐतिहासिक लेखन से समानता को मापने के लिए, शोधकर्ताओं ने प्रत्येक पाठ नमूने की संभावित प्रकाशन तिथि का अनुमान लगाने के लिए एक सांख्यिकीय वर्गीकरण का उपयोग किया। उन्होंने परिणामों को एक कर्नेल घनत्व प्लॉट का उपयोग करके दृश्यमान किया, जो दिखाता है कि मॉडल ने प्रत्येक अंश को ऐतिहासिक समयरेखा पर कहां रखा।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, एक वर्गीकरण पर आधारित जो ऐतिहासिक शैली को पहचानने के लिए प्रशिक्षित है (1905–1914 स्रोत पाठों की तुलना GPT‑4o द्वारा एक-शॉट और 20-शॉट प्रॉम्प्ट्स के साथ उत्पन्न निरंतरताओं और GPT‑1914 द्वारा, जो केवल 1880–1914 के साहित्य पर प्रशिक्षित है)।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, एक वर्गीकरण पर आधारित जो ऐतिहासिक शैली को पहचानने के लिए प्रशिक्षित है (1905–1914 स्रोत पाठों की तुलना GPT‑4o द्वारा एक-शॉट और 20-शॉट प्रॉम्प्ट्स के साथ उत्पन्न निरंतरताओं और GPT‑1914 द्वारा, जो केवल 1880–1914 के साहित्य पर प्रशिक्षित है)।

फाइन-ट्यून किया गया RoBERTa मॉडल, हालांकि पूर्ण नहीं, सामान्य शैलीगत रुझानों को उजागर करता था। GPT-1914 से अंश, जो केवल अवधि साहित्य पर प्रशिक्षित था, मूल स्रोत सामग्री के समान, प्रारंभिक 20वीं सदी के आसपास समूहित थे। इसके विपरीत, ChatGPT-4o के आउटपुट, कई ऐतिहासिक प्रॉम्प्ट्स के बावजूद, 21वीं सदी के लेखन से मिलते-जुलते थे, जो इसके प्रशिक्षण डेटा को दर्शाता है।

शोधकर्ताओं ने इस बेमेल को जेन्सन-शैनन विचलन का उपयोग करके मात्रात्मक रूप से मापा, जो दो संभावना वितरणों के बीच अंतर को मापता है। GPT-1914 ने वास्तविक ऐतिहासिक पाठ की तुलना में 0.006 का करीबी स्कोर प्राप्त किया, जबकि ChatGPT-4o के एक-शॉट और 20-शॉट आउटपुट ने क्रमशः 0.310 और 0.350 के बहुत बड़े अंतर दिखाए।

लेखकों का तर्क है कि ये निष्कर्ष दर्शाते हैं कि केवल प्रॉम्प्टिंग, भले ही कई उदाहरणों के साथ, ऐतिहासिक शैली को विश्वसनीय रूप से अनुकरण करने वाला पाठ उत्पन्न करने का एक विश्वसनीय तरीका नहीं है।

बेहतर परिणामों के लिए फाइन-ट्यूनिंग

पेपर ने फिर यह पता लगाया कि क्या फाइन-ट्यूनिंग बेहतर परिणाम दे सकती है। यह प्रक्रिया उपयोगकर्ता द्वारा निर्दिष्ट डेटा पर प्रशिक्षण जारी रखकर मॉडल के वजन को सीधे प्रभावित करती है, जिससे लक्षित डोमेन में इसका प्रदर्शन संभावित रूप से बेहतर हो सकता है।

अपने पहले फाइन-ट्यूनिंग प्रयोग में, टीम ने 1905 और 1914 के बीच प्रकाशित पुस्तकों से लगभग दो हजार अंश-पूर्णता जोड़ों पर GPT-4o-mini को प्रशिक्षित किया। उनका उद्देश्य यह देखना था कि क्या छोटे पैमाने की फाइन-ट्यूनिंग मॉडल के आउटपुट को अधिक ऐतिहासिक रूप से सटीक शैली की ओर स्थानांतरित कर सकती है।

उसी RoBERTa-आधारित वर्गीकरण का उपयोग करके प्रत्येक आउटपुट की शैलीगत 'तारीख' का अनुमान लगाने के लिए, शोधकर्ताओं ने पाया कि फाइन-ट्यून किया गया मॉडल मूल सत्य के साथ निकटता से संरेखित पाठ उत्पन्न करता है। मूल पाठों से इसका शैलीगत विचलन, जेन्सन-शैनन विचलन द्वारा मापा गया, 0.002 तक गिर गया, जो सामान्य रूप से GPT-1914 के अनुरूप था।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, यह दर्शाती हैं कि GPT‑1914 और GPT‑4o‑mini का फाइन-ट्यून किया गया संस्करण बीसवीं सदी की शुरुआत की लेखन शैली से कितनी निकटता से मेल खाता है (1905 और 1914 के बीच प्रकाशित पुस्तकों के आधार पर)।

वास्तविक और उत्पन्न पाठ के लिए अनुमानित प्रकाशन तिथियां, यह दर्शाती हैं कि GPT‑1914 और GPT‑4o‑mini का फाइन-ट्यून किया गया संस्करण बीसवीं सदी की शुरुआत की लेखन शैली से कितनी निकटता से मेल खाता है (1905 और 1914 के बीच प्रकाशित पुस्तकों के आधार पर)।

हालांकि, शोधकर्ताओं ने सावधानी बरती कि यह मीट्रिक केवल ऐतिहासिक शैली की सतही विशेषताओं को ही पकड़ सकता है, न कि गहरे वैचारिक या तथ्यात्मक अनाक्रोनिज्म्स को। उन्होंने नोट किया, "यह बहुत संवेदनशील परीक्षण नहीं है। यहां न्यायाधीश के रूप में उपयोग किया गया RoBERTa मॉडल केवल एक तारीख की भविष्यवाणी करने के लिए प्रशिक्षित है, न कि प्रामाणिक अंशों को अनाक्रोनिस्टिक लोगों से भेद करने के लिए। यह संभवतः उस भविष्यवाणी को करने के लिए मोटे शैलीगत साक्ष्य का उपयोग करता है। मानव पाठक, या बड़े मॉडल, अभी भी उन अंशों में अनाक्रोनिस्टिक सामग्री का पता लगा सकते हैं जो सतही रूप से 'अवधि में' लगते हैं।"

मानव मूल्यांकन

अंत में, शोधकर्ताओं ने 1905 और 1914 के बीच प्रकाशित पुस्तकों से 250 हाथ से चुने गए अंशों का उपयोग करके मानव मूल्यांकन परीक्षण किए। उन्होंने नोट किया कि इनमें से कई पाठ आज के समय में उस समय की तुलना में अलग तरह से व्याख्या किए जाएंगे:

"हमारी सूची में, उदाहरण के लिए, अल्सास (जो तब जर्मनी का हिस्सा था) पर एक विश्वकोश प्रविष्टि और बेरी-बेरी (जो तब अक्सर पोषण की कमी के बजाय एक कवकीय रोग के रूप में समझाया जाता था) पर एक प्रविष्टि शामिल थी। हालांकि ये तथ्यों के अंतर हैं, हमने ऐसे अंश भी चुने जो दृष्टिकोण, बयानबाजी, या कल्पना में सूक्ष्म अंतर प्रदर्शित करेंगे। उदाहरण के लिए, बीसवीं सदी की शुरुआत में गैर-यूरोपीय स्थानों के विवरण नस्लीय सामान्यीकरण में फिसल जाते हैं। 1913 में लिखित चंद्रमा पर सूर्योदय का विवरण समृद्ध रंगीन घटनाओं की कल्पना करता है, क्योंकि तब तक किसी ने भी वायुमंडल रहित दुनिया की तस्वीरें नहीं देखी थीं।"

शोधकर्ताओं ने छोटे प्रश्न बनाए जो प्रत्येक ऐतिहासिक अंश विश्वसनीय रूप से उत्तर दे सकता था, फिर इन प्रश्न-उत्तर जोड़ों पर GPT-4o-mini को फाइन-ट्यून किया। मूल्यांकन को मजबूत करने के लिए, उन्होंने मॉडल के पांच अलग-अलग संस्करणों को प्रशिक्षित किया, प्रत्येक बार डेटा का एक अलग हिस्सा परीक्षण के लिए अलग रखा। फिर उन्होंने GPT-4o और GPT-4o-mini के डिफ़ॉल्ट संस्करणों के साथ-साथ फाइन-ट्यून किए गए संस्करणों का उपयोग करके प्रतिक्रियाएं उत्पन्न कीं, प्रत्येक का मूल्यांकन उस हिस्से पर किया गया जिसे उसने प्रशिक्षण के दौरान नहीं देखा था।

समय में खो गया

यह आकलन करने के लिए कि मॉडल ऐतिहासिक भाषा को कितनी विश्वसनीय रूप से अनुकरण कर सकते हैं, शोधकर्ताओं ने तीन विशेषज्ञ टिप्पणीकारों से 120 AI-जनरेटेड पूर्णताओं की समीक्षा करने और यह तय करने के लिए कहा कि प्रत्येक 1914 में एक लेखक के लिए विश्वसनीय लगता है या नहीं।

यह मूल्यांकन अपेक्षा से अधिक चुनौतीपूर्ण साबित हुआ। हालांकि टिप्पणीकार लगभग अस्सी प्रतिशत समय अपनी आकलनों पर सहमत थे, उनके निर्णयों में असंतुलन (जब 'विश्वसनीय' को 'गैर-विश्वसनीय' की तुलना में दोगुना बार चुना गया) का मतलब था कि उनकी वास्तविक सहमति का स्तर केवल मध्यम था, जैसा कि 0.554 के कोहेन के कप्पा स्कोर द्वारा मापा गया।

रेटर्स ने इस कार्य को कठिन बताया, जिसमें अक्सर यह मूल्यांकन करने के लिए अतिरिक्त शोध की आवश्यकता होती थी कि कोई कथन 1914 में ज्ञात या विश्वास किए गए तथ्यों के साथ संरेखित है या नहीं। कुछ अंशों ने स्वर और दृष्टिकोण के बारे में सवाल उठाए, जैसे कि क्या कोई प्रतिक्रिया 1914 में विशिष्ट विश्वदृष्टि को प्रतिबिंबित करने के लिए उचित रूप से सीमित थी। यह निर्णय अक्सर नृजातीयता के स्तर पर निर्भर करता था, जो अपनी संस्कृति के धारणाओं या पक्षपातों के माध्यम से अन्य संस्कृतियों को देखने की प्रवृत्ति है।

चुनौती यह तय करना था कि क्या एक अंश ऐतिहासिक रूप से विश्वसनीय लगने के लिए पर्याप्त सांस्कृतिक पक्षपात व्यक्त करता है, बिना आज के मानकों के अनुसार बहुत आधुनिक या बहुत स्पष्ट रूप से अपमानजनक लगे। लेखकों ने नोट किया कि उस अवधि से परिचित विद्वानों के लिए भी, ऐतिहासिक रूप से सटीक लगने वाली भाषा और वर्तमान विचारों को प्रतिबिंबित करने वाली भाषा के बीच एक तेज रेखा खींचना मुश्किल था।

फिर भी, परिणामों ने मॉडलों की स्पष्ट रैंकिंग दिखाई, जिसमें GPT-4o-mini का फाइन-ट्यून किया गया संस्करण समग्र रूप से सबसे विश्वसनीय माना गया:

टिप्पणीकारों का आकलन कि प्रत्येक मॉडल का आउटपुट कितना विश्वसनीय प्रतीत हुआ

टिप्पणीकारों का आकलन कि प्रत्येक मॉडल का आउटपुट कितना विश्वसनीय प्रतीत हुआ

यह प्रदर्शन स्तर, जो अस्सी प्रतिशत मामलों में विश्वसनीय माना गया, ऐतिहासिक शोध के लिए पर्याप्त विश्वसनीय है या नहीं, यह स्पष्ट नहीं है, विशेष रूप से क्योंकि अध्ययन में यह मापने के लिए कोई आधारभूत माप शामिल नहीं था कि वास्तविक अवधि के पाठों को कितनी बार गलत वर्गीकृत किया जा सकता है।

घुसपैठिया चेतावनी

इसके बाद, शोधकर्ताओं ने एक 'घुसपैठिया परीक्षण' किया, जहां विशेषज्ञ टिप्पणीकारों को एक ही ऐतिहासिक प्रश्न का उत्तर देने वाले चार गुमनाम अंश दिखाए गए। तीन प्रतिक्रियाएं भाषा मॉडलों से थीं, जबकि एक वास्तविक बीसवीं सदी की शुरुआत के स्रोत से थी।

कार्य यह पहचानना था कि कौन सा अंश मूल था, जो उस अवधि के दौरान वास्तव में लिखा गया था। इस दृष्टिकोण ने टिप्पणीकारों से सीधे विश्वसनीयता का मूल्यांकन करने के लिए नहीं कहा, बल्कि यह मापा कि वास्तविक अंश AI-जनरेटेड प्रतिक्रियाओं से कितनी बार अलग दिखाई दिया, प्रभावी रूप से यह परीक्षण करते हुए कि क्या मॉडल पाठकों को यह विश्वास दिला सकते हैं कि उनका आउटपुट प्रामाणिक था।

मॉडलों की रैंकिंग पिछले निर्णय कार्य के परिणामों से मेल खाती थी: GPT-4o-mini का फाइन-ट्यून किया गया संस्करण मॉडलों में सबसे विश्वसनीय था, लेकिन फिर भी वास्तविक चीज से कम था।

प्रत्येक स्रोत को प्रामाणिक ऐतिहासिक अंश के रूप में सही पहचान की गई आवृत्ति।

प्रत्येक स्रोत को प्रामाणिक ऐतिहासिक अंश के रूप में सही पहचान की गई आवृत्ति।

यह परीक्षण एक उपयोगी बेंचमार्क के रूप में भी काम करता था, क्योंकि वास्तविक अंश को आधे से अधिक बार पहचाना गया, यह दर्शाता है कि प्रामाणिक और कृत्रिम गद्य के बीच का अंतर मानव पाठकों के लिए अभी भी ध्यान देने योग्य था।

मैकनेमर टेस्ट के रूप में जानी जाने वाली सांख्यिकीय विश्लेषण ने पुष्टि की कि मॉडलों के बीच अंतर अर्थपूर्ण थे, सिवाय इसके कि दो गैर-ट्यून किए गए संस्करणों (GPT-4o और GPT-4o-mini) के मामले में, जो समान रूप से प्रदर्शन करते थे।

अतीत का भविष्य

लेखकों ने पाया कि आधुनिक भाषा मॉडलों को ऐतिहासिक आवाज अपनाने के लिए प्रेरित करना विश्वसनीय परिणामों को विश्वसनीय रूप से उत्पन्न नहीं करता था: मानव पाठकों द्वारा दो-तिहाई से कम आउटपुट को विश्वसनीय माना गया, और यह आंकड़ा संभवतः प्रदर्शन को अतिशयोक्ति देता है।

कई मामलों में, प्रतिक्रियाओं में स्पष्ट संकेत शामिल थे कि मॉडल वर्तमान परिप्रेक्ष्य से बोल रहा था—जैसे कि "1914 में, यह अभी तक ज्ञात नहीं है कि..." या "1914 तक, मैं इसके साथ परिचित नहीं हूं..." जैसे वाक्यांश एक-पांचवें पूर्णताओं में आम थे। इस तरह के अस्वीकरणों ने स्पष्ट कर दिया कि मॉडल इतिहास का अनुकरण बाहर से कर रहा था, न कि इसके भीतर से लिख रहा था।

लेखकों ने कहा, "प्रसंग में सीखने का खराब प्रदर्शन दुर्भाग्यपूर्ण है, क्योंकि ये विधियां AI-आधारित ऐतिहासिक शोध के लिए सबसे आसान और सस्ती हैं। हम जोर देते हैं कि हमने इन दृष्टिकोणों का पूरी तरह से अन्वेषण नहीं किया है। यह हो सकता है कि प्रसंग में सीखना कुछ शोध क्षेत्रों के लिए—अब या भविष्य में—पर्याप्त हो। लेकिन हमारा प्रारंभिक साक्ष्य उत्साहजनक नहीं है।"

लेखकों ने निष्कर्ष निकाला कि ऐतिहासिक अंशों पर एक वाणिज्यिक मॉडल को फाइन-ट्यून करने से न्यूनतम लागत पर शैलीगत रूप से विश्वसनीय आउटपुट उत्पन्न हो सकता है, लेकिन यह आधुनिक परिप्रेक्ष्य के निशानों को पूरी तरह से समाप्त नहीं करता है। अवधि सामग्री पर पूरी तरह से प्रीट्रेनिंग करने वाला मॉडल अनाक्रोनिज्म से बचता है लेकिन बहुत अधिक संसाधनों की मांग करता है और कम प्रवाहपूर्ण आउटपुट देता है।

कोई भी विधि पूर्ण समाधान प्रदान नहीं करती है, और अभी के लिए, ऐतिहासिक आवाजों का अनुकरण करने का कोई भी प्रयास प्रामाणिकता और सुसंगतता के बीच एक समझौता शामिल करता है। लेखकों ने निष्कर्ष निकाला कि इस तनाव को सबसे अच्छी तरह से नेविगेट करने के लिए और शोध की आवश्यकता होगी।

निष्कर्ष

नए पेपर द्वारा उठाया गया सबसे रोचक प्रश्न प्रामाणिकता का है। हालांकि वे पूर्ण उपकरण नहीं हैं, LPIPS और SSIM जैसे हानि कार्य और मीट्रिक्स कंप्यूटर दृष्टि शोधकर्ताओं को मूल सत्य के खिलाफ मूल्यांकन करने की एक पद्धति प्रदान करते हैं। हालांकि, बीते युग की शैली में नया पाठ उत्पन्न करते समय, कोई मूल सत्य नहीं है—केवल एक गायब सांस्कृतिक परिप्रेक्ष्य को अपनाने का प्रयास है। साहित्यिक निशानों से उस मानसिकता का पुनर्निर्माण स्वयं में एक क्वांटाइजेशन का कार्य है, क्योंकि ये निशान केवल साक्ष्य हैं, जबकि जिस सांस्कृतिक चेतना से वे उभरते हैं वह अनुमान से परे रहता है, और संभवतः कल्पना से भी परे।

व्यावहारिक स्तर पर, आधुनिक भाषा मॉडलों की नींव, जो वर्तमान मानदंडों और डेटा द्वारा आकार दी गई हैं, उन विचारों को पुनर्व्याख्या करने या दबाने का जोखिम उठाती हैं जो एक एडवर्डियन पाठक के लिए उचित या सामान्य प्रतीत होते थे लेकिन अब पक्षपात, असमानता, या अन्याय के अवशेष के रूप में दर्ज होते हैं।

कोई आश्चर्य करता है, इसलिए, यदि हम ऐसी बातचीत बना भी सकें, तो क्या यह हमें पीछे नहीं हटाएगी।

पहली बार शुक्रवार, 2 मई, 2025 को प्रकाशित

डीप कॉगिटो के एलएलएम आईडीए का उपयोग करते हुए समान आकार के मॉडल को बेहतर बनाते हैं

सैन फ्रांसिस्को स्थित कंपनी दीप कॉगिटो, ओपन लार्ज लैंग्वेज मॉडल (एलएलएम) की नवीनतम रिलीज के साथ एआई समुदाय में लहरें बना रही है। ये मॉडल, जो 3 बिलियन से 70 बिलियन मापदंडों तक के विभिन्न आकारों में आते हैं, केवल एआई टूल का एक और सेट नहीं हैं; वे w की ओर एक बोल्ड कदम हैं

डीप कॉगिटो के एलएलएम आईडीए का उपयोग करते हुए समान आकार के मॉडल को बेहतर बनाते हैं

सैन फ्रांसिस्को स्थित कंपनी दीप कॉगिटो, ओपन लार्ज लैंग्वेज मॉडल (एलएलएम) की नवीनतम रिलीज के साथ एआई समुदाय में लहरें बना रही है। ये मॉडल, जो 3 बिलियन से 70 बिलियन मापदंडों तक के विभिन्न आकारों में आते हैं, केवल एआई टूल का एक और सेट नहीं हैं; वे w की ओर एक बोल्ड कदम हैं

AI-चालित पॉडकास्ट उपकरण सरलीकृत सामग्री निर्माण के लिए

पॉडकास्ट का निर्माण और परिष्करण करना एक साथ चुनौतीपूर्ण और संतुष्टिदायक हो सकता है। कई पॉडकास्टरों को समय लेने वाले कार्यों जैसे कि फिलर शब्दों को हटाने, आकर्षक शो नोट्स तैयार करने, और सामग्री को प्रभ

AI-चालित पॉडकास्ट उपकरण सरलीकृत सामग्री निर्माण के लिए

पॉडकास्ट का निर्माण और परिष्करण करना एक साथ चुनौतीपूर्ण और संतुष्टिदायक हो सकता है। कई पॉडकास्टरों को समय लेने वाले कार्यों जैसे कि फिलर शब्दों को हटाने, आकर्षक शो नोट्स तैयार करने, और सामग्री को प्रभ

ब्रिटनी स्पीयर्स का लाल कैटसूट: पॉप फैशन में एक निर्णायक क्षण

ब्रिटनी स्पीयर्स, पॉप की सत्तारूढ़ आइकन, ने अपनी बोल्ड शैली से दर्शकों को लगातार मोहित किया है। उनके म्यूजिक वीडियो न केवल संगीतमय हिट हैं, बल्कि फैशन के मील के पत्थर भी हैं। यह लेख 'ऊप्स!...आई डिड इट

ब्रिटनी स्पीयर्स का लाल कैटसूट: पॉप फैशन में एक निर्णायक क्षण

ब्रिटनी स्पीयर्स, पॉप की सत्तारूढ़ आइकन, ने अपनी बोल्ड शैली से दर्शकों को लगातार मोहित किया है। उनके म्यूजिक वीडियो न केवल संगीतमय हिट हैं, बल्कि फैशन के मील के पत्थर भी हैं। यह लेख 'ऊप्स!...आई डिड इट

4 अगस्त 2025 2:10:05 अपराह्न IST

4 अगस्त 2025 2:10:05 अपराह्न IST

Fascinating read! I never thought about how tricky it must be for AI to nail old-timey language. Makes me wonder if we’ll ever see a bot write like Dickens without a ton of extra work. 🧐

0

0

31 जुलाई 2025 5:05:39 अपराह्न IST

31 जुलाई 2025 5:05:39 अपराह्न IST

I never thought AI would trip over old-timey phrases like this! Dickens’ unfinished novel is cool, but maybe we should let some mysteries stay unsolved. 🕰️

0

0

28 जुलाई 2025 6:49:05 पूर्वाह्न IST

28 जुलाई 2025 6:49:05 पूर्वाह्न IST

I find it fascinating that AI can't quite nail those old-timey phrases from Dickens' era. It’s like trying to teach a robot to talk like Shakespeare—cool idea, but super tricky! 🧠

0

0

28 जुलाई 2025 6:48:39 पूर्वाह्न IST

28 जुलाई 2025 6:48:39 पूर्वाह्न IST

It's wild to think AI can't nail old-timey lingo like Dickens' without a ton of prep work. Kinda makes you wonder if we're overhyping these models or if history's just too tricky for code to crack. 🤔

0

0