Étude: les modèles OpenAI ont mémorisé le contenu protégé par le droit d'auteur

Une étude récente suggère qu'OpenAI a peut-être effectivement utilisé du matériel protégé par des droits d'auteur pour entraîner certains de ses modèles d'IA, ajoutant du carburant aux batailles juridiques en cours auxquelles l'entreprise est confrontée. Des auteurs, des programmeurs et d'autres créateurs de contenu ont accusé OpenAI d'utiliser leurs œuvres — telles que des livres et du code — sans permission pour développer ses modèles d'IA. Alors qu'OpenAI s'est défendu en invoquant l'usage équitable, les plaignants soutiennent que la loi sur le droit d'auteur aux États-Unis ne prévoit pas d'exception pour les données d'entraînement.

L'étude, une collaboration entre des chercheurs de l'Université de Washington, de l'Université de Copenhague et de Stanford, introduit une nouvelle technique pour détecter les données d'entraînement "mémorisées" dans les modèles accessibles via une API, comme ceux d'OpenAI. Les modèles d'IA apprennent essentiellement à partir de grandes quantités de données pour reconnaître des motifs, ce qui leur permet de créer des essais, des images, et plus encore. Bien que la plupart des sorties ne soient pas des copies directes des données d'entraînement, certaines le sont inévitablement en raison du processus d'apprentissage. Par exemple, les modèles d'images ont été connus pour reproduire des captures d'écran de films, tandis que les modèles de langage ont été surpris en train de plagier essentiellement des articles de presse.

La méthode décrite dans l'étude se concentre sur les mots à "forte surprise" — des mots qui sont inhabituels dans un contexte donné. Par exemple, dans la phrase "Jack et moi sommes restés parfaitement immobiles avec le radar bourdonnant," "radar" serait un mot à forte surprise car il est moins attendu que des mots comme "moteur" ou "radio" pour précéder "bourdonnant."

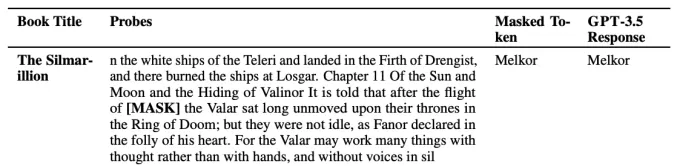

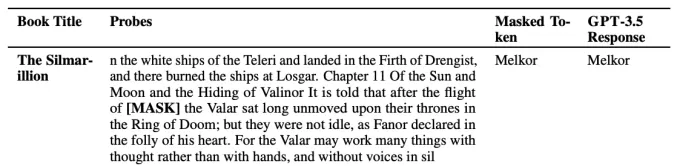

Les chercheurs ont testé plusieurs modèles d'OpenAI, y compris GPT-4 et GPT-3.5, en supprimant les mots à forte surprise d'extraits de livres de fiction et d'articles du New York Times et en demandant aux modèles de prédire ces mots manquants. Si les modèles devinaient correctement les mots, cela suggérait qu'ils avaient mémorisé le texte pendant l'entraînement.

Un exemple de faire "deviner" un mot à forte surprise par un modèle. Crédits image : OpenAI Les résultats ont indiqué que GPT-4 avait probablement mémorisé des parties de livres de fiction populaires, y compris ceux du dataset BookMIA de livres électroniques protégés par des droits d'auteur. Il semblait également avoir mémorisé certains articles du New York Times, bien que moins fréquemment.Abhilasha Ravichander, doctorante à l'Université de Washington et co-auteure de l'étude, a souligné à TechCrunch que ces résultats mettent en lumière les "données controversées" qui pourraient avoir été utilisées pour entraîner ces modèles. "Pour avoir des modèles de langage de grande échelle fiables, nous devons avoir des modèles que nous pouvons sonder, auditer et examiner scientifiquement," a déclaré Ravichander. "Notre travail vise à fournir un outil pour sonder les grands modèles de langage, mais il y a un réel besoin de plus grande transparence des données dans tout l'écosystème."

OpenAI a plaidé pour des règles plus souples sur l'utilisation des données protégées par des droits d'auteur pour développer des modèles d'IA. Bien que l'entreprise ait certains accords de licence de contenu et propose des options de retrait pour les détenteurs de droits d'auteur, elle a fait pression sur divers gouvernements pour établir des règles d'"usage équitable" spécifiquement pour l'entraînement d'IA.

Article connexe

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

commentaires (32)

0/200

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

commentaires (32)

0/200

![WilliamGonzalez]() WilliamGonzalez

WilliamGonzalez

25 août 2025 11:01:06 UTC+02:00

25 août 2025 11:01:06 UTC+02:00

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

![GregoryBaker]() GregoryBaker

GregoryBaker

23 août 2025 13:01:18 UTC+02:00

23 août 2025 13:01:18 UTC+02:00

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

![JohnGarcia]() JohnGarcia

JohnGarcia

23 avril 2025 17:10:14 UTC+02:00

23 avril 2025 17:10:14 UTC+02:00

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

22 avril 2025 02:12:42 UTC+02:00

22 avril 2025 02:12:42 UTC+02:00

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

![WillLopez]() WillLopez

WillLopez

21 avril 2025 13:49:05 UTC+02:00

21 avril 2025 13:49:05 UTC+02:00

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

![WillMitchell]() WillMitchell

WillMitchell

21 avril 2025 05:30:11 UTC+02:00

21 avril 2025 05:30:11 UTC+02:00

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0

Une étude récente suggère qu'OpenAI a peut-être effectivement utilisé du matériel protégé par des droits d'auteur pour entraîner certains de ses modèles d'IA, ajoutant du carburant aux batailles juridiques en cours auxquelles l'entreprise est confrontée. Des auteurs, des programmeurs et d'autres créateurs de contenu ont accusé OpenAI d'utiliser leurs œuvres — telles que des livres et du code — sans permission pour développer ses modèles d'IA. Alors qu'OpenAI s'est défendu en invoquant l'usage équitable, les plaignants soutiennent que la loi sur le droit d'auteur aux États-Unis ne prévoit pas d'exception pour les données d'entraînement.

L'étude, une collaboration entre des chercheurs de l'Université de Washington, de l'Université de Copenhague et de Stanford, introduit une nouvelle technique pour détecter les données d'entraînement "mémorisées" dans les modèles accessibles via une API, comme ceux d'OpenAI. Les modèles d'IA apprennent essentiellement à partir de grandes quantités de données pour reconnaître des motifs, ce qui leur permet de créer des essais, des images, et plus encore. Bien que la plupart des sorties ne soient pas des copies directes des données d'entraînement, certaines le sont inévitablement en raison du processus d'apprentissage. Par exemple, les modèles d'images ont été connus pour reproduire des captures d'écran de films, tandis que les modèles de langage ont été surpris en train de plagier essentiellement des articles de presse.

La méthode décrite dans l'étude se concentre sur les mots à "forte surprise" — des mots qui sont inhabituels dans un contexte donné. Par exemple, dans la phrase "Jack et moi sommes restés parfaitement immobiles avec le radar bourdonnant," "radar" serait un mot à forte surprise car il est moins attendu que des mots comme "moteur" ou "radio" pour précéder "bourdonnant."

Les chercheurs ont testé plusieurs modèles d'OpenAI, y compris GPT-4 et GPT-3.5, en supprimant les mots à forte surprise d'extraits de livres de fiction et d'articles du New York Times et en demandant aux modèles de prédire ces mots manquants. Si les modèles devinaient correctement les mots, cela suggérait qu'ils avaient mémorisé le texte pendant l'entraînement.

Abhilasha Ravichander, doctorante à l'Université de Washington et co-auteure de l'étude, a souligné à TechCrunch que ces résultats mettent en lumière les "données controversées" qui pourraient avoir été utilisées pour entraîner ces modèles. "Pour avoir des modèles de langage de grande échelle fiables, nous devons avoir des modèles que nous pouvons sonder, auditer et examiner scientifiquement," a déclaré Ravichander. "Notre travail vise à fournir un outil pour sonder les grands modèles de langage, mais il y a un réel besoin de plus grande transparence des données dans tout l'écosystème."

OpenAI a plaidé pour des règles plus souples sur l'utilisation des données protégées par des droits d'auteur pour développer des modèles d'IA. Bien que l'entreprise ait certains accords de licence de contenu et propose des options de retrait pour les détenteurs de droits d'auteur, elle a fait pression sur divers gouvernements pour établir des règles d'"usage équitable" spécifiquement pour l'entraînement d'IA.

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Un organisme à but non lucratif s'appuie sur des agents d'intelligence artificielle pour stimuler la collecte de fonds à des fins caritatives

Alors que les grandes entreprises technologiques promeuvent les "agents" d'IA comme des stimulants de la productivité pour les entreprises, une organisation à but non lucratif démontre leur potentiel

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

Les plus grands laboratoires d'IA avertissent que l'humanité est en train de perdre le contrôle de la compréhension des systèmes d'IA

Dans une démonstration d'unité sans précédent, des chercheurs d'OpenAI, de Google DeepMind, d'Anthropic et de Meta ont mis de côté leurs divergences pour lancer un avertissement collectif sur le dével

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

ChatGPT ajoute l'intégration de Google Drive et Dropbox pour l'accès aux fichiers

ChatGPT améliore la productivité avec de nouvelles fonctionnalités d'entrepriseOpenAI a dévoilé deux nouvelles fonctionnalités puissantes qui transforment ChatGPT en un outil de productivité complet

25 août 2025 11:01:06 UTC+02:00

25 août 2025 11:01:06 UTC+02:00

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

23 août 2025 13:01:18 UTC+02:00

23 août 2025 13:01:18 UTC+02:00

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

23 avril 2025 17:10:14 UTC+02:00

23 avril 2025 17:10:14 UTC+02:00

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

22 avril 2025 02:12:42 UTC+02:00

22 avril 2025 02:12:42 UTC+02:00

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

21 avril 2025 13:49:05 UTC+02:00

21 avril 2025 13:49:05 UTC+02:00

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

21 avril 2025 05:30:11 UTC+02:00

21 avril 2025 05:30:11 UTC+02:00

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0