Estudo: Modelos OpenAI memorizou conteúdo protegido por direitos autorais

Um estudo recente sugere que a OpenAI pode ter de fato usado material protegido por direitos autorais para treinar alguns de seus modelos de IA, adicionando combustível às batalhas legais em curso que a empresa enfrenta. Autores, programadores e outros criadores de conteúdo acusaram a OpenAI de usar suas obras — como livros e códigos — sem permissão para desenvolver seus modelos de IA. Embora a OpenAI tenha se defendido alegando uso justo, os demandantes argumentam que a lei de direitos autorais dos EUA não prevê uma exceção para dados de treinamento.

O estudo, uma colaboração entre pesquisadores da Universidade de Washington, da Universidade de Copenhague e de Stanford, apresenta uma nova técnica para detectar dados de treinamento “memorizados” em modelos acessados por meio de uma API, como os da OpenAI. Modelos de IA essencialmente aprendem a partir de vastas quantidades de dados para reconhecer padrões, permitindo-lhes criar ensaios, imagens e muito mais. Embora a maioria dos resultados não sejam cópias diretas dos dados de treinamento, alguns inevitavelmente o são devido ao processo de aprendizado. Por exemplo, modelos de imagem já foram conhecidos por reproduzir capturas de tela de filmes, enquanto modelos de linguagem foram pegos essencialmente plagiando artigos de notícias.

O método descrito no estudo foca em palavras de “alta surpresa” — palavras que são incomuns em um determinado contexto. Por exemplo, na frase “Jack e eu sentamos perfeitamente imóveis com o radar zumbindo”, “radar” seria uma palavra de alta surpresa porque é menos esperado do que palavras como “motor” ou “rádio” para preceder “zumbindo”.

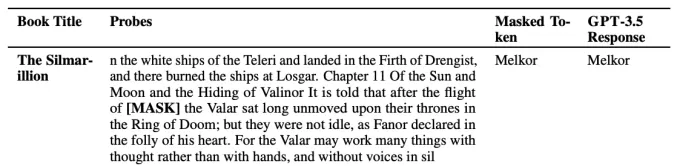

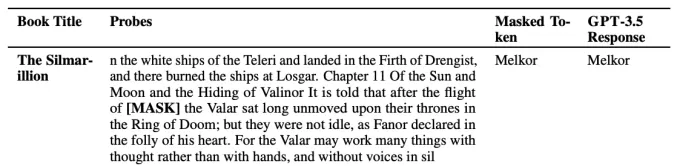

Os pesquisadores testaram vários modelos da OpenAI, incluindo GPT-4 e GPT-3.5, removendo palavras de alta surpresa de trechos de livros de ficção e artigos do New York Times e pedindo aos modelos que previssem essas palavras ausentes. Se os modelos adivinhassem as palavras com precisão, isso sugeria que eles haviam memorizado o texto durante o treinamento.

Um exemplo de um modelo “adivinhando” uma palavra de alta surpresa. Créditos da imagem: OpenAI Os resultados indicaram que o GPT-4 provavelmente memorizou partes de livros de ficção populares, incluindo aqueles no conjunto de dados BookMIA de ebooks protegidos por direitos autorais. Também pareceu ter memorizado alguns artigos do New York Times, embora com uma frequência menor.Abhilasha Ravichander, estudante de doutorado na Universidade de Washington e coautora do estudo, enfatizou ao TechCrunch que essas descobertas destacam os “dados controversos” que podem ter sido usados para treinar esses modelos. “Para termos modelos de linguagem de grande escala que sejam confiáveis, precisamos de modelos que possamos sondar, auditar e examinar cientificamente”, afirmou Ravichander. “Nosso trabalho visa fornecer uma ferramenta para sondar modelos de linguagem de grande escala, mas há uma necessidade real de maior transparência de dados em todo o ecossistema.”

A OpenAI tem pressionado por regras mais flexíveis sobre o uso de dados protegidos por direitos autorais para desenvolver modelos de IA. Embora a empresa tenha alguns acordos de licenciamento de conteúdo e ofereça opções de exclusão para detentores de direitos autorais, ela tem feito lobby em vários governos para estabelecer regras de “uso justo” especificamente para treinamento de IA.

Artigo relacionado

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

Comentários (32)

0/200

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

Comentários (32)

0/200

![WilliamGonzalez]() WilliamGonzalez

WilliamGonzalez

25 de Agosto de 2025 à6 10:01:06 WEST

25 de Agosto de 2025 à6 10:01:06 WEST

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

![GregoryBaker]() GregoryBaker

GregoryBaker

23 de Agosto de 2025 à18 12:01:18 WEST

23 de Agosto de 2025 à18 12:01:18 WEST

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

![JohnGarcia]() JohnGarcia

JohnGarcia

23 de Abril de 2025 à14 16:10:14 WEST

23 de Abril de 2025 à14 16:10:14 WEST

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

22 de Abril de 2025 à42 01:12:42 WEST

22 de Abril de 2025 à42 01:12:42 WEST

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

![WillLopez]() WillLopez

WillLopez

21 de Abril de 2025 à5 12:49:05 WEST

21 de Abril de 2025 à5 12:49:05 WEST

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

![WillMitchell]() WillMitchell

WillMitchell

21 de Abril de 2025 à11 04:30:11 WEST

21 de Abril de 2025 à11 04:30:11 WEST

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0

Um estudo recente sugere que a OpenAI pode ter de fato usado material protegido por direitos autorais para treinar alguns de seus modelos de IA, adicionando combustível às batalhas legais em curso que a empresa enfrenta. Autores, programadores e outros criadores de conteúdo acusaram a OpenAI de usar suas obras — como livros e códigos — sem permissão para desenvolver seus modelos de IA. Embora a OpenAI tenha se defendido alegando uso justo, os demandantes argumentam que a lei de direitos autorais dos EUA não prevê uma exceção para dados de treinamento.

O estudo, uma colaboração entre pesquisadores da Universidade de Washington, da Universidade de Copenhague e de Stanford, apresenta uma nova técnica para detectar dados de treinamento “memorizados” em modelos acessados por meio de uma API, como os da OpenAI. Modelos de IA essencialmente aprendem a partir de vastas quantidades de dados para reconhecer padrões, permitindo-lhes criar ensaios, imagens e muito mais. Embora a maioria dos resultados não sejam cópias diretas dos dados de treinamento, alguns inevitavelmente o são devido ao processo de aprendizado. Por exemplo, modelos de imagem já foram conhecidos por reproduzir capturas de tela de filmes, enquanto modelos de linguagem foram pegos essencialmente plagiando artigos de notícias.

O método descrito no estudo foca em palavras de “alta surpresa” — palavras que são incomuns em um determinado contexto. Por exemplo, na frase “Jack e eu sentamos perfeitamente imóveis com o radar zumbindo”, “radar” seria uma palavra de alta surpresa porque é menos esperado do que palavras como “motor” ou “rádio” para preceder “zumbindo”.

Os pesquisadores testaram vários modelos da OpenAI, incluindo GPT-4 e GPT-3.5, removendo palavras de alta surpresa de trechos de livros de ficção e artigos do New York Times e pedindo aos modelos que previssem essas palavras ausentes. Se os modelos adivinhassem as palavras com precisão, isso sugeria que eles haviam memorizado o texto durante o treinamento.

Abhilasha Ravichander, estudante de doutorado na Universidade de Washington e coautora do estudo, enfatizou ao TechCrunch que essas descobertas destacam os “dados controversos” que podem ter sido usados para treinar esses modelos. “Para termos modelos de linguagem de grande escala que sejam confiáveis, precisamos de modelos que possamos sondar, auditar e examinar cientificamente”, afirmou Ravichander. “Nosso trabalho visa fornecer uma ferramenta para sondar modelos de linguagem de grande escala, mas há uma necessidade real de maior transparência de dados em todo o ecossistema.”

A OpenAI tem pressionado por regras mais flexíveis sobre o uso de dados protegidos por direitos autorais para desenvolver modelos de IA. Embora a empresa tenha alguns acordos de licenciamento de conteúdo e ofereça opções de exclusão para detentores de direitos autorais, ela tem feito lobby em vários governos para estabelecer regras de “uso justo” especificamente para treinamento de IA.

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Organização sem fins lucrativos utiliza agentes de IA para aumentar os esforços de arrecadação de fundos para instituições de caridade

Enquanto as grandes corporações de tecnologia promovem "agentes" de IA como impulsionadores de produtividade para as empresas, uma organização sem fins lucrativos está demonstrando seu potencial para

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

Os principais laboratórios de IA alertam que a humanidade está perdendo o controle sobre a compreensão dos sistemas de IA

Em uma demonstração de união sem precedentes, pesquisadores da OpenAI, Google DeepMind, Anthropic e Meta deixaram de lado as diferenças competitivas para emitir um alerta coletivo sobre o desenvolvime

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

ChatGPT adiciona integração com Google Drive e Dropbox para acesso a arquivos

ChatGPT aumenta a produtividade com novos recursos empresariaisA OpenAI revelou dois novos recursos poderosos que transformam o ChatGPT em uma ferramenta abrangente de produtividade empresarial: doc

25 de Agosto de 2025 à6 10:01:06 WEST

25 de Agosto de 2025 à6 10:01:06 WEST

This is wild! OpenAI might’ve gobbled up copyrighted stuff to train their models? I’m not shocked, but it’s kinda shady. Hope those authors and coders get some justice! 😤

0

0

23 de Agosto de 2025 à18 12:01:18 WEST

23 de Agosto de 2025 à18 12:01:18 WEST

This is wild! OpenAI might've trained their models on copyrighted stuff? 😳 I wonder how many books and code snippets got swept up in that data vacuum. Ethics in AI is such a messy topic right now.

0

0

23 de Abril de 2025 à14 16:10:14 WEST

23 de Abril de 2025 à14 16:10:14 WEST

Me sorprendió un poco que OpenAI podría haber usado material con derechos de autor para entrenar sus modelos. Es un poco decepcionante, pero supongo que es el salvaje oeste allá en el mundo de la IA. 🤔 ¿Quizás deberían ser más cuidadosos la próxima vez?

0

0

22 de Abril de 2025 à42 01:12:42 WEST

22 de Abril de 2025 à42 01:12:42 WEST

OpenAIが著作権付きの資料を使ってAIを訓練しているという研究は本当に驚きですね!クリエイターにとっては残念ですが、AIの訓練方法について知るのは面白いです。もっと透明性が必要かもしれませんね?🤔

0

0

21 de Abril de 2025 à5 12:49:05 WEST

21 de Abril de 2025 à5 12:49:05 WEST

오픈AI가 저작권 있는 자료를 사용해 AI를 훈련했다는 연구는 정말 충격적이에요! 창작자들에게는 안타까운 일이지만, AI가 어떻게 훈련되는지 아는 건 흥미로워요. 오픈AI가 더 투명해져야 할까요? 🤔

0

0

21 de Abril de 2025 à11 04:30:11 WEST

21 de Abril de 2025 à11 04:30:11 WEST

Este estudio sobre los modelos de OpenAI usando contenido con derechos de autor es bastante aterrador! 😱 Está genial que la IA se esté volviendo más inteligente, pero usar libros y códigos sin permiso no parece correcto. ¡Espero que lo resuelvan pronto! 🤞

0

0